ホームページ >テクノロジー周辺機器 >AI >GPT-3 と安定拡散は連携して、モデルが当事者 A の画像レタッチのニーズを理解できるように支援します。

GPT-3 と安定拡散は連携して、モデルが当事者 A の画像レタッチのニーズを理解できるように支援します。

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-12 14:55:031243ブラウズ

普及モデルの人気の後、多くの人は、より効果的なプロンプトを使用して必要な画像を生成する方法に焦点を当ててきました。いくつかの AI 絵画モデルの継続的な試みの中で、人々は AI に絵を上手に描くためのキーワード エクスペリエンスを要約しています:

つまり、正しい AI スキルを習得すれば、描画の品質向上の効果は非常に明らかです (参照: 「 「バスケットボールをするアルパカ」の描画方法? 誰かが 13 ドルを費やしてフォース DALL・E 2 あなたの本当のスキルを見せてください 》)。

さらに、一部の研究者は別の方向、つまり、ほんの数語で絵画を望み通りに変える方法に取り組んでいます。

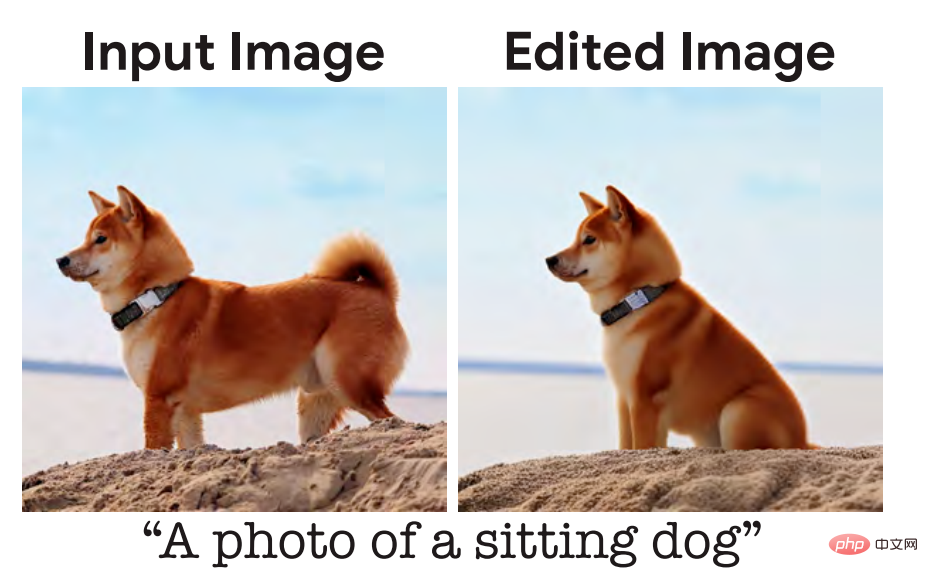

少し前に、Google Research およびその他の機関からの 調査について報告しました 。画像をどのように見せたいかを指定するだけで、基本的に希望どおりの処理が実行され、たとえば座っている子犬の写実的な画像が生成されます。

ここでモデルに与えられた入力説明は「座る犬」ですが、人々の日常のコミュニケーション習慣によれば、最も自然な説明は「この犬を座らせてください」であるはずです。研究者の中には、これは最適化されるべき問題であり、モデルは人間の言語習慣により沿ったものであるべきだと考える人もいます。

最近、カリフォルニア大学バークレー校の研究チームは、人間の指示に基づいて画像を編集する新しい方法を提案しました。 InstructPix2Pix: 入力画像と、モデルに何をすべきかを指示するテキストの説明が与えられると、モデル 説明の指示に従って画像を編集する能力。

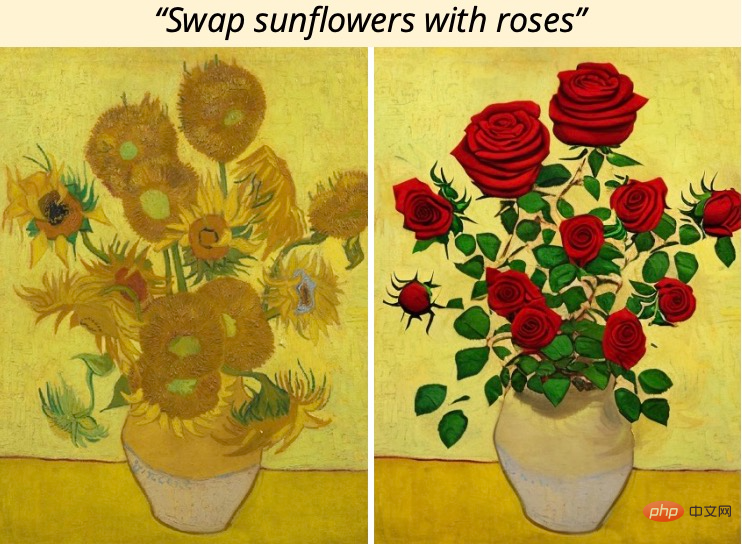

論文アドレス: https://arxiv.org/pdf/2211.09800.pdf ##たとえば、絵の中のひまわりをバラに変更するには、モデルに「ひまわりをバラに変更して」と直接言うだけです:

トレーニング データを取得するために、この研究では、言語モデル (GPT-3) とテキストから画像への生成モデル (安定拡散) という 2 つの大規模な事前トレーニング済みモデルを組み合わせて、大規模なペアごとのトレーニング データセットを生成します。画像編集例です。研究者らは、この大規模なデータセットで新しいモデル InstructPix2Pix をトレーニングし、実際の画像と推論時にユーザーが作成した命令に一般化しました。

トレーニング データを取得するために、この研究では、言語モデル (GPT-3) とテキストから画像への生成モデル (安定拡散) という 2 つの大規模な事前トレーニング済みモデルを組み合わせて、大規模なペアごとのトレーニング データセットを生成します。画像編集例です。研究者らは、この大規模なデータセットで新しいモデル InstructPix2Pix をトレーニングし、実際の画像と推論時にユーザーが作成した命令に一般化しました。

InstructPix2Pix は、入力画像と画像を編集するためのテキスト命令が与えられると、編集済み画像を生成する条件付き拡散モデルです。モデルは、フォワード パスで直接画像編集を実行し、追加のサンプル画像、入出力画像の完全な説明、各サンプルの微調整を必要としないため、モデルはわずか数秒で画像を迅速に編集できます。

InstructPix2Pix は完全に合成例 (つまり、GPT-3 によって生成されたテキストの説明と安定拡散によって生成された画像) でトレーニングされていますが、モデルは任意の実際のサンプルでのトレーニングの精度を達成します。画像と人間が書いたテキストへのゼロショット一般化。モックアップは、オブジェクトの置換や画像スタイルの変更など、直感的な画像編集をサポートします。

方法の概要

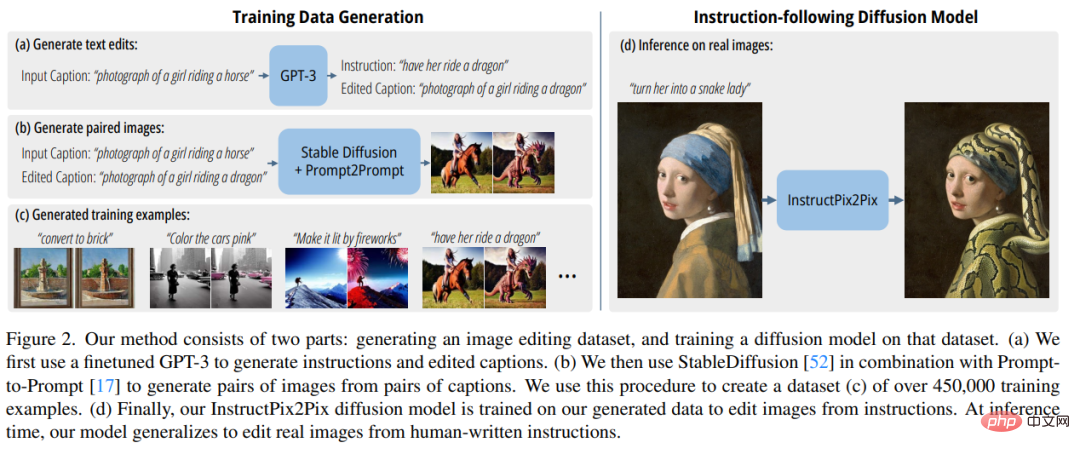

研究者らは、命令ベースの画像編集を教師あり学習問題として扱いました。まず、テキスト編集命令と編集前後の画像を含むペアのトレーニング データセットを生成しました (図 2a- c) そして、この生成されたデータセットで画像編集拡散モデルをトレーニングしました (図 2d)。モデルは生成された画像と編集命令を使用してトレーニングされていますが、人間が作成した任意の命令を使用して実際の画像を編集することができます。以下の図 2 は、この方法の概要です。

マルチモーダル トレーニング データ セットを生成します

データ セット生成段階では、研究者らは大規模言語モデル (GPT-3) とテキストから画像へのモデル (安定拡散) の機能を組み合わせて、テキスト編集命令と対応する画像を含むマルチモーダル トレーニング データ セットを生成しました。編集前と編集後。このプロセスは次の手順で構成されます。

- GPT-3 を微調整してテキスト編集のコレクションを生成します。画像を説明するプロンプトが表示され、変更を説明するテキストを生成します。作成するコマンドと、変更された画像を説明するプロンプト (図 2a);

- テキストから画像へのモデルを使用して、2 つのテキスト プロンプト (編集前と編集後) を変換します。対応するペア画像に変換します (図 2b)。

InstructPix2Pix

研究者らは、生成されたトレーニング データを使用して、条件付き拡散モデルをトレーニングしました。安定拡散モデルでは、書面による指示に基づいて画像を編集できます。

拡散モデルは、データ分布の一部 (高密度データの方向を指す) を推定する一連のノイズ除去オートエンコーダーを通じて、データ サンプルの生成方法を学習します。潜在拡散は、エンコーダー とデコーダー # を備えた事前学習済み変分オートエンコーダーの潜在空間で動作することによって改善されます。 拡散モデルの効率と品質。

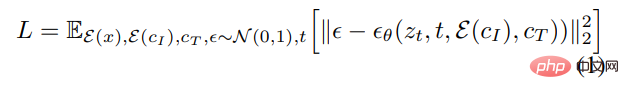

画像 x の場合、拡散プロセスによりエンコードされた潜在 にノイズが追加され、ノイズの多い潜在 z_t が生成されます。レベルはタイムステップ t∈T とともに増加します。画像条件付け C_I とテキスト命令条件付け C_T を考慮して、ノイズを含む潜在 z_t に追加されるノイズを予測するネットワーク を学習します。研究者らは、次の潜在的な拡散目標を最小限に抑えました:

以前の研究 (Wang et al.) では、画像翻訳 (画像翻訳) タスクについては、特にペアごとのトレーニング データが限られている場合、大規模な画像拡散モデルを微調整する方が、最初からトレーニングするよりも優れています。したがって、新しい研究では、著者らは事前トレーニングされた安定拡散チェックポイントを使用してモデルの重みを初期化し、その強力なテキストから画像への生成機能を利用しています。

画像調整をサポートするために、研究者らは追加の入力チャネルを最初の畳み込み層に追加し、z_t と  を接続しました。拡散モデルの利用可能なすべての重みは事前トレーニングされたチェックポイントから初期化されますが、新しく追加された入力チャネルで動作する重みはゼロに初期化されます。著者はここで、テキスト編集命令 c_T を入力として取らずに、もともとキャプションに使用されていたのと同じテキスト調整メカニズムを再利用します。

を接続しました。拡散モデルの利用可能なすべての重みは事前トレーニングされたチェックポイントから初期化されますが、新しく追加された入力チャネルで動作する重みはゼロに初期化されます。著者はここで、テキスト編集命令 c_T を入力として取らずに、もともとキャプションに使用されていたのと同じテキスト調整メカニズムを再利用します。

実験結果

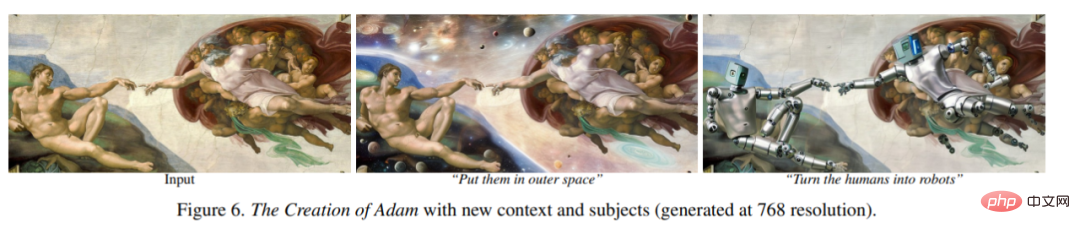

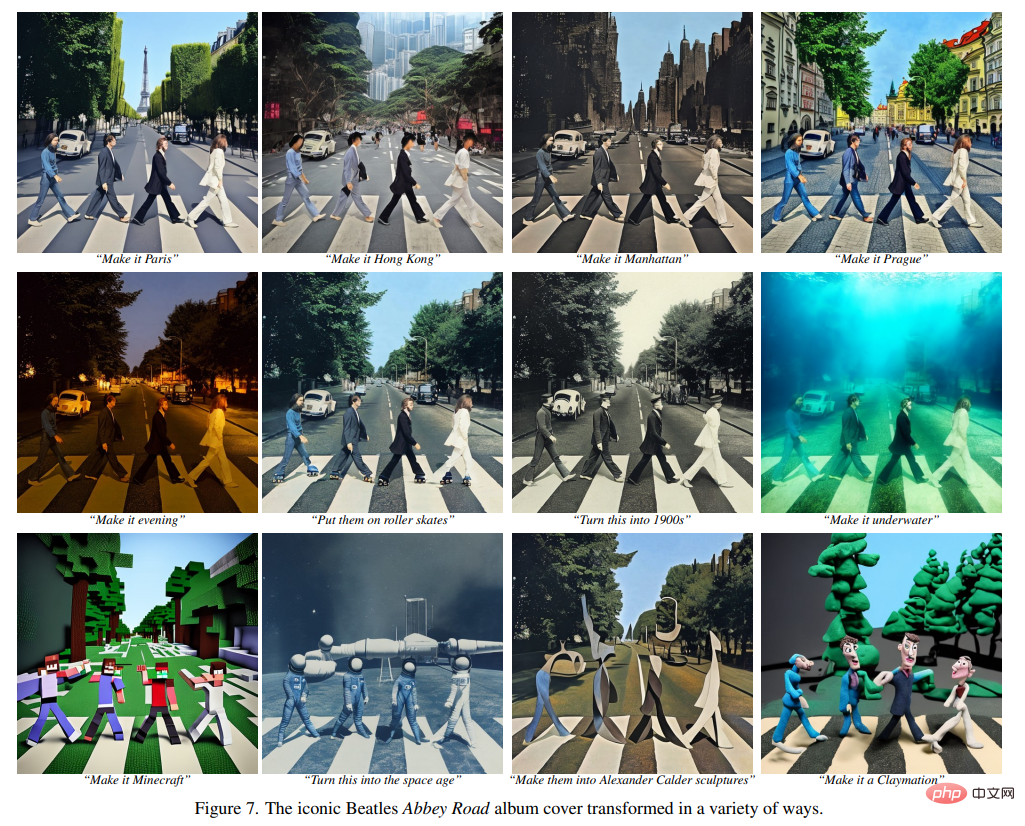

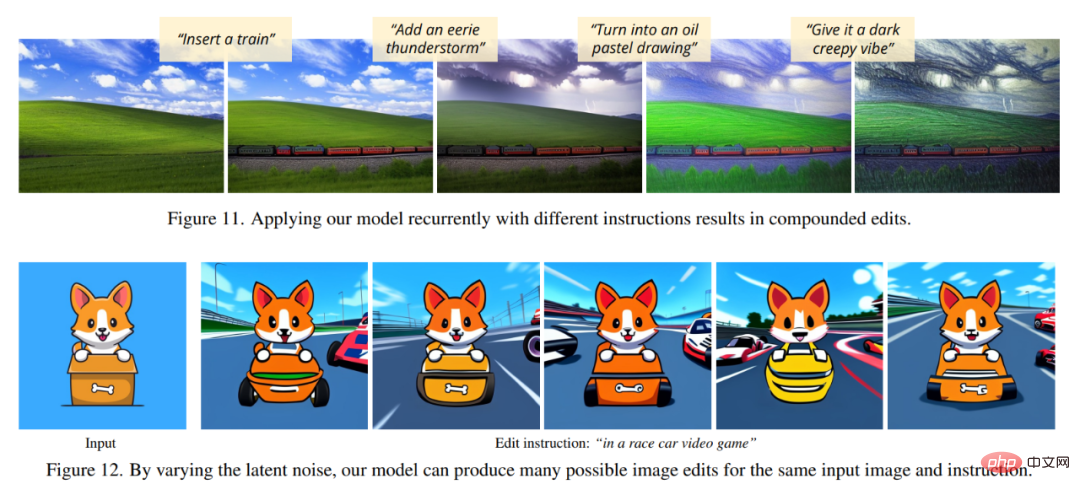

次の図では、著者らは新しいモデルの画像編集結果を示しています。これらの結果は、実際の写真とアートワークの異なるセットに対するものです。新しいモデルは、オブジェクトの置き換え、季節や天候の変更、背景の置き換え、マテリアルのプロパティの変更、アート メディアの変換など、多くの難しい編集を正常に実行します。

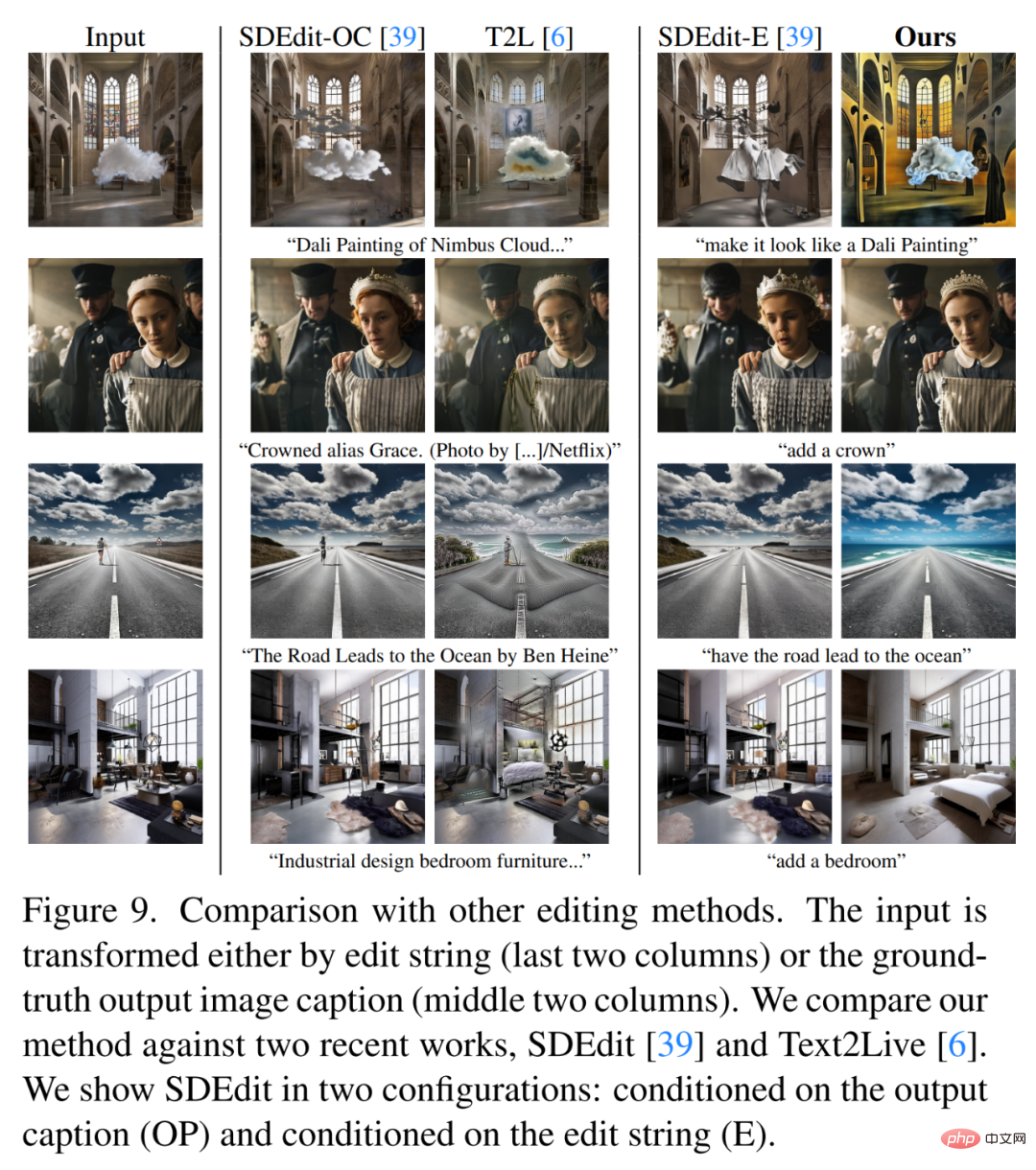

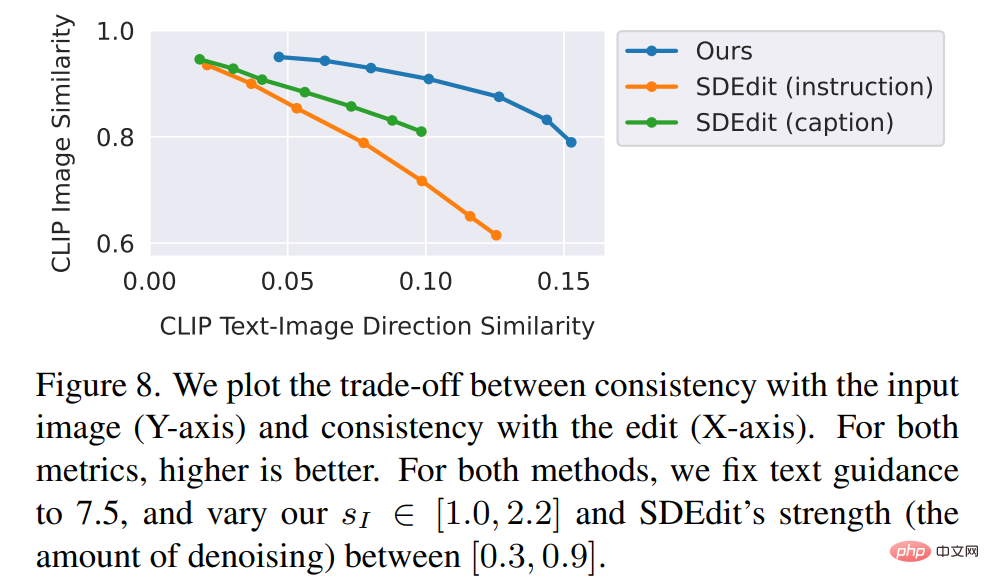

研究者らは、新しい方法を最近のいくつかの方法と比較しました。 SDEdit、Text2Live などのテクノロジーを比較します。新しいモデルは画像編集の指示に従いますが、ベースライン方法を含む他の方法では画像の説明やレイヤーの編集が必要です。したがって、比較する場合、作成者は編集指示の代わりに、後者に対して「編集済み」テキスト注釈を提供します。著者らはまた、画像の一貫性と編集品質を測定する 2 つの指標を使用して、新しい方法と SDEdit を定量的に比較しています。最後に、著者らは、生成されたトレーニング データのサイズと品質がモデルのパフォーマンスにおけるアブレーション結果にどのような影響を与えるかを示しています。

以上がGPT-3 と安定拡散は連携して、モデルが当事者 A の画像レタッチのニーズを理解できるように支援します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。