視覚と聴覚は、人間のコミュニケーションや場面の理解において重要です。人間の知覚能力を模倣するために、視聴覚モダリティを探求することを目的とした視聴覚学習が近年急成長している分野となっています。この記事は、最新の視聴覚学習『視聴覚コンテキストでの学習:「新しい視点」のレビュー、分析、解釈』のレビューです。

このレビューは、まず視聴覚モダリティの認知科学的基礎を分析し、次に最近の視聴覚学習研究 (約 300 の関連文書) を体系的に分析して要約します。最後に、現在の視覚学習分野を概観するために、このレビューは、視覚的場面理解の観点から近年の視覚学習の進歩を再検討し、この分野の潜在的な発展の方向性を探ります。

##arXiv リンク: https://arxiv.org/abs/2208.09579

プロジェクトのホームページ: https://gewu-lab.github.io/audio-visual-learning/

awesome-list リンク: https ://gewu-lab.github.io/awesome-audiovisual-learning/

#1はじめに

視覚情報と聴覚情報は人間が外界を認識するための主要な情報源。人間の脳は、異種のマルチモーダル情報を統合することによって、周囲環境の全体的な認識を取得します。たとえば、複数の話者がいるカクテル パーティーのシーンでは、唇の形状の変化を使用して、対象の話者の受け取った音声を強調することができます。したがって、人間のような機械の知覚能力を探求するには、視覚と聴覚の学習が不可欠です。他のモダリティと比較して、視聴覚モダリティの特徴は次のとおりです。

1) 認知基盤。 最も広く研究されている 2 つの感覚として、視覚と聴覚の統合は人間の神経系全体で見られます。人間の知覚におけるこれら 2 つの感覚の重要性は、視聴覚データに基づく機械知覚研究の認知基盤を提供する一方で、神経系における視覚と聴覚の相互作用と統合は、視覚学習を促進するための基礎。

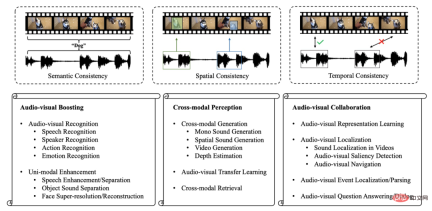

2) 多重一貫性。 私たちの日常生活において、視覚と聴覚は密接に関係しています。図 1 に示すように、犬の鳴き声とその外観の両方から、犬を「犬」の概念と関連付けることができます (意味の一貫性 )。同時に、聞こえた音や視覚を利用して、犬の正確な空間的位置を判断することができます (空間的一貫性)。そして、犬の吠え声を聞くと、私たちは通常、同時に犬を視覚的に見ることができます (タイミングの一貫性)。視覚と聴覚の間の複数の一貫性は、視聴覚学習に関する研究の基礎です。

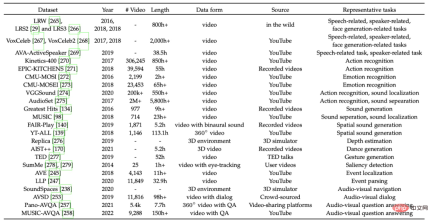

3) 豊富なデータのサポート。 モバイル端末とインターネットの急速な発展により、公共プラットフォームでビデオを共有する人がますます増え、ビデオ収集のコストが削減されました。これらの豊富な公開ビデオは、データ取得の障壁を軽減し、視聴覚学習のためのデータ サポートを提供します。

視聴覚モダリティのこれらの特徴は、当然のことながら視聴覚学習分野の誕生につながりました。近年、この分野は活発な発展を遂げており、研究者は、従来のシングルモーダルなタスクに新たなモダリティを導入するだけでは満足せず、新たな問題や課題の探索と解決に取り組み始めています。しかし、既存の視聴覚学習の取り組みはタスク指向であることがよくあります。これらの作品では、特定の視聴覚タスクに焦点を当てています。視聴覚学習分野の発展を系統的にレビューし、分析する包括的な研究はまだ不足しています。したがって、この記事では視聴覚学習の現在の分野を要約し、その潜在的な発展の方向性をさらに考察します。

視覚学習と音声学習と人間の知覚能力との間には密接な関係があるため、この記事ではまず視覚と聴覚のモダリティの認知基盤を要約し、次にこれに基づいて既存の音声を分割します。 3 つのカテゴリーに分類された視覚学習の研究:

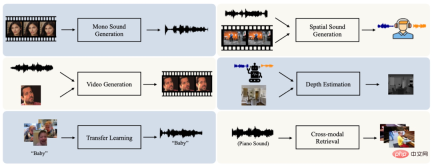

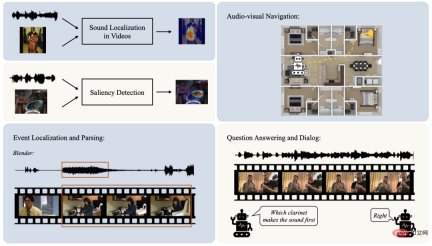

1) オーディオビジュアルブースト。 ビジュアルデータとオーディオデータにはそれぞれ長い研究の歴史があり、幅広い用途があります。これらの単一モード法は非常に効果的な結果を達成していますが、関心のあるオブジェクトの部分的な情報のみを利用し、単一モード法のパフォーマンスは制限されており、単一モードのノイズの影響を受けやすいです。したがって、研究者は、これらのオーディオまたはビジュアルタスクに追加のモダリティを導入します。これにより、補完的な情報を統合することでモデルの効果が向上するだけでなく、モデルの堅牢性も促進されます。 2) クロスモーダルな認識。 人間は、音を聞くと関連する絵を連想したり、絵を見るとそれに対応する音を考えることができるのは、視覚情報と聴覚情報が一致しているからです。この一貫性により、マシンがクロスモーダルの知識を転送したり、1 つのモダリティからの情報に基づいて別のモダリティの対応するデータを生成したりするための基盤が提供されます。したがって、多くの研究がクロスモーダル知覚能力の探索に注がれ、顕著な結果を達成しています。 3) 視聴覚コラボレーション。 異なるモダリティからの信号を融合することに加えて、人間の脳の皮質領域ではモダリティ間のより高いレベルの相互作用が行われ、より深いシーンの理解を実現します。したがって、人間のような知覚能力を実現するには、オーディオ モダリティとビデオ モダリティの間のコラボレーションを探求する必要があります。この目標を達成するために、近年の多くの研究で、より困難なシーン理解の問題が提案されており、広く注目を集めています。 #図 1: 視覚と視覚の一貫性と視覚と視覚の学習領域の概要 ##オーディオとビデオのモダリティ間のセマンティクス、スペース、タイミングの一貫性により、上記のオーディオとビデオの研究に実現可能性がもたらされます。したがって、この記事では、最近のオーディオビジュアル研究を要約した後、オーディオビジュアルの複数の一貫性を分析します。さらに、この記事では、視聴覚シーンの理解という新しい視点から、視聴覚学習分野の進歩をもう一度レビューします。 視覚と聴覚は、人間の情景を理解するための 2 つの中心的な感覚です。この章では、視覚と聴覚の神経経路と、認知神経科学における視覚と聴覚のモダリティの統合について要約し、その後の視覚と聴覚の学習分野における研究の議論の基礎を築きます。 視覚は最も広く研究されている感覚であり、視覚が人間の知覚を支配していると信じている人さえいます。同様に、視覚の神経経路も比較的複雑です。物体からの反射光には視覚情報が含まれており、網膜にある多数の光受容体 (約 2 億 6,000 万個) が活性化されます。光受容体の出力は神経節細胞 (約 200 万個) に送られます。このプロセスにより、視覚情報が圧縮されます。そして、視覚情報は外側膝状核の細胞によって処理された後、最終的に大脳皮質の視覚関連領域に到達します。視覚皮質は、視覚ニューロンが優先性を持つ機能的に異なる領域の集合です。たとえば、V4 と V5 のニューロンは、それぞれ色と動きに敏感です。 視覚に加えて、聴覚も周囲の環境を観察するための重要な感覚です。それは人間に危険を避けるよう思い出させるだけでなく(例えば、野生の獣の鳴き声を聞くと人間は積極的に行動するなど)、人間同士のコミュニケーションの基礎でもあります。音波は鼓膜上で神経信号に変換されます。次に、聴覚情報は脳幹の下丘と蝸牛核に伝えられます。視床の内側膝状核による処理の後、音は最終的に一次聴覚野で符号化されます。脳は聴覚情報を取得し、それに含まれる周波数や音色などの音響的な手がかりを使用して、音源の正体を判断します。同時に、両耳間の強さと聴覚のタイミングの違いが音の位置を知る手がかりとなり、これをバイノーラル効果と呼びます。実際には、人間の知覚は複数の感覚、特に聴覚と視覚を組み合わせることができ、これをマルチチャネル知覚と呼びます。 各感覚は、周囲の環境に関する固有の情報を提供します。複数の感覚によって受け取られる情報は異なりますが、結果として得られる環境の表現は、別々の感覚ではなく、統一された経験になります。 代表的な例はマクガーク効果です。異なる意味を持つ視覚信号と聴覚信号が単一の意味情報を取得します。これらの現象は、人間の知覚において、複数の感覚からの信号が統合されることが多いことを示しています。その中で、聴覚と視覚の神経経路の交差点では、人間の 2 つの重要な感覚からの情報が結合され、知覚の感度と正確性が促進され、たとえば、音に関連する視覚情報は聴覚空間の検索効率を向上させることができます。 複数の感覚情報を組み合わせたこれらの知覚現象は、認知神経科学の分野で人々の注目を集めています。人間の神経系においてよく研究されている多チャネル感覚領域は上丘です。上丘の多くのニューロンは多感覚特性を備えており、視覚、聴覚、さらには触覚からの情報によっても活性化されます。この多感覚反応は、多くの場合、単一の反応よりも強力です。皮質の上側頭溝も代表的な領域です。 サルでの研究に基づくと、サルは視覚、聴覚、体性感覚を含む複数の感覚とつながっていることが観察されています。さらに、頭頂葉、前頭葉、海馬などの脳領域でも、同様のマルチチャネル知覚現象が見られます。マルチチャネル知覚現象の研究に基づいて、いくつかの重要な発見を観察できます: 1) マルチモーダル強化。 上で述べたように、多くのニューロンは複数の感覚の融合信号に反応することができ、単一の感覚の刺激が弱い場合、この増強された反応は単一モダリティ反応よりも信頼性が高くなります。 #2) クロスモーダル可塑性。 この現象は、感覚の剥奪が、それに対応する皮質領域の発達に影響を与える可能性があることを意味します。たとえば、聴覚障害者の聴覚関連皮質が視覚刺激によって活性化される可能性があります。 3) マルチモーダル コラボレーション。 皮質領域では、さまざまな感覚からの信号がより複雑に統合されています。研究者らは、大脳皮質には、多感覚情報を共同して統合して意識と認知を構築する能力を備えたモジュールがあることを発見しました。 人間の認知に触発されて、研究者たちは人間のような視覚および聴覚の知覚能力を実現する方法を研究し始めており、近年、視覚および聴覚の研究が徐々に増えています。 各モダリティ自体には学習に比較的十分な情報があり、すでに多くの単一ベースのモーダル データが存在しますが、しかし、シングルモーダル データはローカル情報のみを提供し、シングルモーダル ノイズの影響を受けやすくなります (たとえば、視覚情報は照明や視野角などの要因の影響を受けます)。したがって、人間の認知におけるマルチモーダルな改善現象に触発されて、一部の研究者は、タスクのパフォーマンスを向上させるために、元のシングルモーダル タスクに追加の視覚 (または音声) データを導入します。関連するタスクを特定と強化の 2 つの部分に分けます。 シングルモーダル認識タスクは、音声ベースの音声認識や視覚ベースの動作認識など、これまでに広く研究されてきました。しかし、シングルモーダルデータは物事の情報の一部しか観測していないため、シングルモーダルノイズの影響を受けやすくなります。したがって、マルチモーダルデータを統合してモデルの機能と堅牢性を促進する視聴覚認識タスクが近年注目を集めており、音声認識、話者認識、動作認識、感情認識などの多くの側面をカバーしています。 オーディオ モダリティとビデオ モダリティの一貫性により、マルチモーダル認識タスクの基礎が提供されるだけでなく、あるモダリティを使用して別のモダリティの信号を強化することも可能になります。たとえば、複数の話者が視覚的に分離されるため、話者に関する視覚情報を音声の分離に利用できます。さらに、音声情報は、不明瞭または欠落している話者の顔情報を再構築するための性別や年齢などの識別情報を提供できます。これらの現象は、研究者に、音声強調、音源分離、顔の超再構成など、ノイズ除去や強調のために他のモダリティからの情報を使用するよう促しました。 #図 2: ビデオとオーディオの改善タスク 認知神経科学におけるクロスモーダル可塑性の現象と視聴覚モダリティ間の一貫性により、オーディオの学習と構築を目的としたクロスモーダル知覚の研究が促進されています。視覚モダリティとの関連付けにより、クロスモーダル生成、転送、検索などのタスクが作成されます。 人間には、既知のモダリティの導きの下で、別のモダリティに対応する情報を予測する能力があります。例えば、音を聞かなくても、唇の動きという視覚情報だけで、その人が何を言っているのかを大まかに推測することができます。オーディオと視覚の間の意味的、空間的、および時間的な一貫性により、機械が人間のようなクロスモーダル生成機能を持つ可能性が得られます。クロスモーダル生成タスクは現在、シングルチャネルオーディオ生成、ステレオ生成、ビデオ/画像生成、深度推定などの多くの側面をカバーしています。 クロスモーダル生成に加えて、オーディオとビデオ間の意味的一貫性は、一方のモダリティでの学習が、もう一方のモダリティからの意味論的情報によって支援されることが期待されることを示しています。これは、オーディオビジュアル転送タスクの目標でもあります。さらに、オーディオとビデオの意味上の一貫性により、クロスモーダルな情報検索タスクの開発も促進されます。 #図 3: クロスモーダル知覚関連のタスク 人間の脳は、受け取ったシーンの視聴覚情報を統合して、相互に協力し補完し合うことで、シーンを理解する能力を向上させます。したがって、機械は、単にマルチモーダルな情報を融合したり予測したりするのではなく、視聴覚のコラボレーションを探求することで人間のような知覚を追求する必要があります。この目的を達成するために、研究者たちは、視覚および音声のコンポーネント分析や視覚および音声の推論など、視覚および音声学習の分野にさまざまな新しい課題を導入してきました。 オーディオビジュアルコラボレーションの初期段階では、人間による注釈なしでオーディオビジュアルモダリティから表現を効果的に抽出する方法が重要なトピックです。これは、高品質の表現がさまざまな下流タスクに貢献できるためです。視聴覚データの場合、それらの間の意味論的、空間的、時間的一貫性により、自己教師付きの方法で視聴覚表現を学習するための自然な信号が提供されます。 表現学習に加えて、オーディオ モダリティとビデオ モダリティ間のコラボレーションは、主にシーンの理解に焦点を当てています。研究者の中には、音源定位、視覚および音声顕著性検出、視覚および音声ナビゲーションなどを含む、シーン内の視覚および音声コンポーネントの分析および位置特定に焦点を当てている人もいます。このようなタスクは、視覚モダリティと音声モダリティの間のきめ細かい接続を確立します。 さらに、多くのオーディオビジュアルタスクでは、ビデオ全体のオーディオビジュアルコンテンツが常に時間的に一致している、つまり各ビデオの各瞬間が一致していると想定することがよくあります。 、画像と音声は一致しています。しかし実際には、この仮定が常に成立するとは限りません。たとえば、「バスケットボールをしている」サンプルでは、カメラは講堂など、「バスケットボールをしている」というラベルとはまったく関係のないシーンを撮影することがあります。したがって、シーン内の視覚および音声コンポーネントを時系列でさらに剥離するために、視覚および音声イベントの位置特定や分析などのタスクが提案されています。 人間は、視聴覚シーンにおいて知覚を超えた推論を行うことができます。上記のオーディオビジュアルコラボレーションタスクは、オーディオビジュアルシーンの詳細な理解を徐々に達成していますが、オーディオビジュアルコンポーネントの推論分析は実行していません。最近、視覚学習の分野の発展に伴い、一部の研究者は視覚的質問応答や対話課題などの視覚的推論にさらに注目し始めています。これらのタスクは、視聴覚シーンについてクロスモーダル時空間推論を実行し、シーン関連の質問に答え、または観察された視聴覚シーンについての対話を生成することを目的としています。 #図 4: ビデオとオーディオのコラボレーションに関連するタスク このセクションでは、視聴覚学習の分野におけるいくつかの代表的なデータセットを要約し、説明します。 まず、視覚と音声のモダリティは、興味のあるものをさまざまな視点から描写します。したがって、視聴覚データの意味論は意味論的に一貫していると考えられます。視覚学習では、ほとんどのタスクにおいて意味の一貫性が重要な役割を果たします。この一貫性により、たとえば、視覚情報と音声情報を組み合わせて、視覚と音声の認識を向上させたり、単一モダリティを強化したりすることが可能になります。さらに、視聴覚モダリティ間の意味的一貫性も、クロスモーダル検索と転移学習において重要な役割を果たします。 第 2 に、視覚と音声の両方が、音を発するオブジェクトの正確な空間位置を決定するのに役立ちます。この空間対応には幅広い応用範囲があります。たとえば、音源定位タスクでは、この一貫性を使用して、入力音声によって導かれる音を発するオブジェクトの視覚的な位置を決定します。ステレオの場合、バイノーラル オーディオに基づいて視覚的な奥行き情報を推定したり、視覚情報を補助として使用してステレオ オーディオを生成したりできます。 最後に、ビジュアル コンテンツとそれが生成するサウンドは、多くの場合、時間的に一貫しています。この一貫性は、視聴覚認識や生成タスクにおけるマルチモーダル情報の融合や予測など、ほとんどの視聴覚学習研究でも広く活用されています。 実際には、これらのさまざまなオーディオとビジュアルの一貫性は単独ではなく、オーディオとビジュアルのシーンで一緒に現れることがよくあります。したがって、関連するタスクで共同で利用されることがよくあります。意味的一貫性と時間的一貫性の組み合わせが最も一般的なケースです。 単純なシナリオでは、同じタイムスタンプを持つオーディオ クリップとビデオ クリップは、セマンティクスとタイミングの両方で一貫していると見なされます。ただし、この強力な仮定は失敗する可能性があります。たとえば、同じタイムスタンプのビデオ画像と背景音は意味的に一貫していません。これらの誤検知はトレーニングの妨げになります。 最近、研究者は、シーンの理解の質を向上させるために、これらの状況に焦点を当て始めています。さらに、意味的一貫性と空間的一貫性の組み合わせも一般的です。たとえば、ビデオ内の音源定位を成功させるには、入力音に基づいて対応する視覚的空間位置を探索するための意味的一貫性に依存します。さらに、視聴覚ナビゲーション タスクの初期段階では、音声ターゲットは安定した繰り返し音を生成します。空間的な一貫性は満たされていますが、ビジュアルとオーディオの意味内容には相関関係がありません。その後、音声と発話位置の意味的一貫性が導入され、視聴覚ナビゲーションの品質が向上します。 一般に、視覚および音声モダリティの意味論的、空間的および時間的一貫性は、視覚および音声学習の研究に確実なサポートを提供します。これらの一貫性の分析と活用は、既存の視聴覚タスクのパフォーマンスを向上させるだけでなく、視聴覚シーンのより深い理解にも貢献します。 この記事では、視聴覚モダリティの認知基盤を要約し、人間のマルチチャンネル知覚の現象を分析します。現在の視聴覚学習研究は、視聴覚ブースティング、クロスモーダル知覚、視聴覚コラボレーションの 3 つのカテゴリに分類されています。視聴覚学習の分野における現在の発展をよりマクロな観点からレビューするために、この記事では視聴覚シーンの理解に関する新しい視点をさらに提案しています。 1) 基本的なシーンの理解 (Basic Scene Understanding)。 視聴覚強化とクロスモーダル知覚のタスクは、多くの場合、一貫した視聴覚情報の融合または予測に焦点を当てます。これらのタスクの中核は、オーディオビジュアルシーンの基本的な理解 (たとえば、入力ビデオのアクション分類) またはクロスモーダル情報の予測 (たとえば、サイレントビデオに基づいて対応するオーディオの生成) です。シーン ビデオには、これらの基本的なシーン理解タスクの範囲を超えた、さまざまなビジュアルおよびオーディオ コンポーネントが含まれることがよくあります。 #2) きめ細かいシーンの理解。 上で述べたように、オーディオビジュアル シーンには通常、さまざまなモダリティの豊富なコンポーネントが含まれています。したがって、研究者たちは、ターゲットコンポーネントを剥がすためのいくつかのタスクを提案しました。たとえば、音源位置特定タスクは、音声を発生する対象物体が位置する視覚内の領域をマークすることを目的としています。視聴覚イベントの位置特定および分析タスクは、時系列でターゲットの可聴イベントまたは可視イベントを決定します。これらのタスクにより、オーディオとビジュアルのコンポーネントが分離され、オーディオとビジュアルのシーンが分離され、その結果、前の段階と比べてシーンをより詳細に理解できるようになります。 3) 因果関係の場面の理解。 視聴覚シーンでは、人間は周囲の興味のあるものを認識するだけでなく、それらの間の相互作用を推測することもできます。この段階でのシーン理解の目標は、人間のような知覚の追求に近いものになります。現在、この段階では少数のミッションのみが検討されています。視聴覚質疑応答や対話課題が代表的な作品である。これらのタスクは、ビデオ内の視覚コンポーネントと音声コンポーネントの関連性を調査し、時空間推論を実行しようとします。 一般に、これら 3 つの段階の探索は均等ではありません。基本的なシーンの理解から因果的相互作用のシーンの理解に至るまで、関連する研究の多様性と豊かさは徐々に減少しており、特に因果的相互作用のシーンの理解はまだ初期段階にあります。これは、視聴覚学習の潜在的な開発方向性を示唆しています: 1) タスクの統合。 オーディオビジュアル分野の研究のほとんどはタスク指向です。これらの個々のタスクは、オーディオビジュアル シーンの特定の側面のみをシミュレートし、学習します。ただし、視聴覚シーンの理解と認識は、単独で行われるわけではありません。たとえば、音源定位タスクは視覚内の音関連オブジェクトを強調しますが、イベント定位タスクと解析タスクは対象イベントを時間的に特定します。 2 つのタスクは、視聴覚シーンの洗練された理解を促進するために統合されることが期待されています。複数の視聴覚学習タスクの統合は、将来的に検討する価値のある方向性です。 #2) 因果関係の相互作用シナリオについての深い理解。 現時点では、推論を伴う場面理解に関する研究の多様性はまだ限られています。視聴覚的な質問応答や対話を含む既存のタスクは、主にビデオ内のイベントに基づいて対話を行うことに重点を置いています。プレビューされたシーンに基づいて次に発生する可能性のあるオーディオまたはビジュアルイベントを予測するなど、より深い種類の推論については、今後さらなる研究が必要です。 記事の内容をよりわかりやすく表現するために、このレビューには継続的に更新されるプロジェクトのホームページも用意されており、さまざまな視聴覚タスクの目標と開発状況が写真で表示されます。 、ビデオなど。読者が視聴覚学習の分野をすぐに理解できるようにします。

2 視覚および聴覚認知の基礎

3 ビジュアルおよびビデオの改善

4 クロスモーダル知覚

5 視覚と視覚のコラボレーション

6 代表的なデータセット

#7 トレンドと新しい視点

7.1 意味論的、空間的、時間的な一貫性 #視聴覚モダリティは異質なデータ形式を持っていますが、その内部一貫性は意味論的、空間的、時間的側面をカバーし、視聴覚研究の基礎を築きます。 7.2 シーン理解に関する新しい視点

以上が視聴覚の観点からマルチモーダル学習の過去と未来を見つめるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

踊りましょう:私たちの人間のニューラルネットを微調整するための構造化された動きApr 27, 2025 am 11:09 AM

踊りましょう:私たちの人間のニューラルネットを微調整するための構造化された動きApr 27, 2025 am 11:09 AM科学者は、彼らの機能を理解するために、人間とより単純なニューラルネットワーク(C. elegansのものと同様)を広く研究してきました。 ただし、重要な疑問が生じます。新しいAIと一緒に効果的に作業するために独自のニューラルネットワークをどのように適応させるのか

新しいGoogleリークは、Gemini AIのサブスクリプションの変更を明らかにしますApr 27, 2025 am 11:08 AM

新しいGoogleリークは、Gemini AIのサブスクリプションの変更を明らかにしますApr 27, 2025 am 11:08 AMGoogleのGemini Advanced:Horizonの新しいサブスクリプションティア 現在、Gemini Advancedにアクセスするには、1か月あたり19.99ドルのGoogle One AIプレミアムプランが必要です。 ただし、Android Authorityのレポートは、今後の変更を示唆しています。 最新のGoogle p

データ分析の加速がAIの隠されたボトルネックをどのように解決しているかApr 27, 2025 am 11:07 AM

データ分析の加速がAIの隠されたボトルネックをどのように解決しているかApr 27, 2025 am 11:07 AM高度なAI機能を取り巻く誇大宣伝にもかかわらず、エンタープライズAIの展開内に大きな課題が潜んでいます:データ処理ボトルネック。 CEOがAIの進歩を祝う間、エンジニアはクエリの遅い時間、過負荷のパイプライン、

MarkitDown MCPは、任意のドキュメントをマークダウンに変換できます!Apr 27, 2025 am 09:47 AM

MarkitDown MCPは、任意のドキュメントをマークダウンに変換できます!Apr 27, 2025 am 09:47 AMドキュメントの取り扱いは、AIプロジェクトでファイルを開くだけでなく、カオスを明確に変えることです。 PDF、PowerPoint、Wordなどのドキュメントは、あらゆる形状とサイズでワークフローをフラッシュします。構造化された取得

建物のエージェントにGoogle ADKを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:42 AM

建物のエージェントにGoogle ADKを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:42 AMGoogleのエージェント開発キット(ADK)のパワーを活用して、実際の機能を備えたインテリジェントエージェントを作成します。このチュートリアルは、ADKを使用して会話エージェントを構築し、GeminiやGPTなどのさまざまな言語モデルをサポートすることをガイドします。 w

効果的な問題解決のためにLLMを介したSLMの使用 - 分析VidhyaApr 27, 2025 am 09:27 AM

効果的な問題解決のためにLLMを介したSLMの使用 - 分析VidhyaApr 27, 2025 am 09:27 AMまとめ: Small Language Model(SLM)は、効率のために設計されています。それらは、リソース不足、リアルタイム、プライバシーに敏感な環境の大手言語モデル(LLM)よりも優れています。 特にドメインの特異性、制御可能性、解釈可能性が一般的な知識や創造性よりも重要である場合、フォーカスベースのタスクに最適です。 SLMはLLMSの代替品ではありませんが、精度、速度、費用対効果が重要な場合に理想的です。 テクノロジーは、より少ないリソースでより多くを達成するのに役立ちます。それは常にドライバーではなく、プロモーターでした。蒸気エンジンの時代からインターネットバブル時代まで、テクノロジーの力は、問題の解決に役立つ範囲にあります。人工知能(AI)および最近では生成AIも例外ではありません

コンピュータービジョンタスクにGoogle Geminiモデルを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:26 AM

コンピュータービジョンタスクにGoogle Geminiモデルを使用する方法は? - 分析VidhyaApr 27, 2025 am 09:26 AMコンピュータービジョンのためのGoogleGeminiの力を活用:包括的なガイド 大手AIチャットボットであるGoogle Geminiは、その機能を会話を超えて拡張して、強力なコンピュータービジョン機能を網羅しています。 このガイドの利用方法については、

Gemini 2.0 Flash vs O4-Mini:GoogleはOpenaiよりもうまくやることができますか?Apr 27, 2025 am 09:20 AM

Gemini 2.0 Flash vs O4-Mini:GoogleはOpenaiよりもうまくやることができますか?Apr 27, 2025 am 09:20 AM2025年のAIランドスケープは、GoogleのGemini 2.0 FlashとOpenaiのO4-Miniの到着とともに感動的です。 数週間離れたこれらの最先端のモデルは、同等の高度な機能と印象的なベンチマークスコアを誇っています。この詳細な比較

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

ドリームウィーバー CS6

ビジュアル Web 開発ツール

WebStorm Mac版

便利なJavaScript開発ツール

DVWA

Damn Vulnerable Web App (DVWA) は、非常に脆弱な PHP/MySQL Web アプリケーションです。その主な目的は、セキュリティ専門家が法的環境でスキルとツールをテストするのに役立ち、Web 開発者が Web アプリケーションを保護するプロセスをより深く理解できるようにし、教師/生徒が教室環境で Web アプリケーションを教え/学習できるようにすることです。安全。 DVWA の目標は、シンプルでわかりやすいインターフェイスを通じて、さまざまな難易度で最も一般的な Web 脆弱性のいくつかを実践することです。このソフトウェアは、

ホットトピック

7760

7760 15

15 1644

1644 14

14 1399

1399 52

52 1293

1293 25

25 1234

1234 29

29