大規模な言語モデルの開発により、その機能を利用してロボットが複雑な命令を理解し、より高度なタスクを完了できるように導くことができるでしょうか?そして、この過程で私たちはどのような課題に直面するのでしょうか?最近、Zhiyuan Community は Google の研究科学者である Xia Fei 博士を招待し、「言語と視覚に基づく身体的推論」に関するレポートを発表し、この新興分野におけるチームの最先端の研究について詳しく説明しました。

著者について: Xia Fei は現在、ロボット工学チームの研究員として働いています。 Google Brainの。彼の主な研究方向は、構造化されていない複雑な環境へのロボットの応用です。代表作にGibsonEnv、iGibson、SayCanなど。彼の研究は『WIRED』、ワシントン・ポスト、ニューヨーク・タイムズ、その他のメディアで報じられています。 Xia Fei 博士はスタンフォード大学を卒業し、シルビオ・サバレーゼ氏とレオニダス・ギバス氏に師事しました。彼は、CVPR、CoRL、IROS、ICRA、Neurips、RA-L、Nature Communications などの会議や雑誌に多くの論文を発表しています。彼の最近の研究の方向性は、インテリジェント エージェントの意思決定プロセスに基盤モデル (Foundation Model) を使用することです。彼のチームは最近、PaLM-SayCan モデルを提案しました。

01背景

ロボットの機械学習は近年大きな成果を上げています進歩は見られましたが、比較的大きな問題がまだ残っています。機械学習のトレーニングには大量のデータが必要ですが、ロボットによって生成されるデータは非常に高価であり、ロボット自体も損失の可能性があります。

#人間は子供の頃、遊びを通じて物理世界と関わり、多くの物理法則を学びます。これに触発されて、ロボットも環境と対話してこの物理情報を取得し、さまざまなタスクを完了できるでしょうか?機械学習をロボットに適用するには、シミュレーション環境に大きく依存します。

これに関して、Xia Fei 博士と彼の同僚は、Gibson Env (環境) や iGibson などの研究を提案しています。視覚環境、後者 その他は物理シミュレーションに焦点を当てています。現実世界を3次元スキャンして再構成し、ニューラルネットワークを通じて視覚信号をレンダリングすることでシミュレーション環境を構築し、さまざまなロボットが物理シミュレーションを実行し、時間センサーからアクチュエーターに至るまでの制御を学習できるようにします。 iGibson 環境では、ロボットは食器洗い機の使い方を学ぶなど、環境とのより豊かな相互作用を学習できます。

## Xia Fei 博士は、上記の研究がインターネット AI から身体型 AI への変革を表していると信じています。これまでの AI トレーニングは、主にインターネット タスクである ImageNet や MS COCO などのデータセットに基づいていました。身体化された AI では、AI の認識とアクションが閉ループを形成する必要があります。AI は認識された結果に基づいて次のアクションを決定する必要があります。 Xia Fei の博士論文「身体化された知覚とロボット学習のための大規模シミュレーション」は、学習、知覚、推論のための大規模なロボット シミュレーションに関するものです。

#近年、人工知能の分野では基本モデルが急速に発展しています。研究者の中には、シミュレーション環境に依存する代わりに、基本モデルから情報を抽出してロボットの意思決定を支援できると考えている人もいます。 Xia Fei 博士は、この新しい方向性を「意思決定のための基礎モデル」と呼び、彼と彼のチームは PaLM-SayCan などの研究を提案しました。 02

PaLM-SayCan: 言語モデルでロボットをガイドしましょう1. なぜそうなるのかロボットは複雑で長距離のタスクを扱うのが難しいですか?

PaLM-SayCan チームには 45 人の著者がいます。これは、Google Robotics チームと Everyday Robots の共同プロジェクトであり、次のことを目的としています。機械学習を使用してロボットの分野を変更し、ロボットにデータを提供して機械学習の機能を向上させます。研究は、構造化されていない複雑な環境と、ロボットを日常生活でより便利にするという 2 つの問題に焦点を当てています。 人々はすでに Siri や Alexa のようなパーソナル アシスタントを持っていますが、ロボット工学の分野にはそのような存在はありません。 Xia 博士は次の例を挙げました。飲み物をこぼしたとき、私たちはロボットに状況を説明して助けを求めたいと考えます。または、運動後に疲れている場合は、飲み物や軽食を提供してもらいます。研究では、ロボットがこれらのタスクを理解して実行できるようになることを期待しています。 現在の問題は、ロボットが長時間または長距離の作業を行うことが依然として難しく、複雑な作業を必要とする作業をロボットが実行できないことです。計画性、常識、理論性、その理由は 2 つの側面があります。 1 つ目は、ロボット工学の分野では優れたユーザー インタラクション インターフェイスが不足していることです。従来のロボットがピック アンド プレイス タスクを実行する場合、通常はゴール コンディショニングまたはワンホット コンディショニング手法を使用します。 ゴールコンディショニングでは、ロボットに目標が何であるかを伝え、初期条件を目標条件に変更するタスクをロボットに実行させる必要があります。これには、まずロボットに、目標が何であるかを示す必要があります。タスクの条件は完了後になります。 また、ワンホット コンディショニングでは、ロボットが完了できるすべてのタスクに適したワンホット コーディングを使用します ( 100 個のタスクなど)には 0 から 99 までの番号が付けられます。実行する必要があるたびにロボットに番号が提供され、ロボットはどのタスクを完了する必要があるかを認識します。ただし、ワンホット条件の問題は、ユーザーが各タスクに対応するエンコーディングを覚えておく必要があり、ワンホット エンコーディングではタスク間の依存関係情報 (目標に対応するタスク エンコーディング シーケンスの完了など) が取得できないことです。 )。 結果として、現在の ロボットは、通常は掴んだり置いたりする近距離タスクのみを実行できます。そしてロボット自体は可動ではなく静止しています。 さらに、環境も研究室などのシーンに限定されており、人間がいないことがよくあります。 これらの問題を解決するために、チームは基本モデルの使用を考えました。言語モデルは、目標条件付けを置き換え、言語を通じてタスクを明確かつ明確に記述することができます。同時に、言語には、ロボットの学習に役立つ、レシピの最初のステップ、2 番目のステップなどのタスク ステップ間の依存関係情報も含まれています。さらに、言語は長期的なタスクを定義し、模倣学習方法の限界を解決することもできます。 ロボットで大規模なモデルを使用すると、いくつかの課題に直面する可能性があります。最も重要なことは、ロボットの出力を対象とした言語を決定することです。大規模なモデルは人間の自然言語に基づいてトレーニングされており、それが出力するタスクはロボットには不可能な可能性があります。また、言語モデルはロボットのデータに基づいてトレーニングされていないため、ロボットの機能の範囲がわかりません。 2 つ目はグラウンディングの問題で、大きなモデルは物理世界を個人的に経験しておらず、具体化された情報が不足しています。 3 つ目は、大型モデルの誘導下でのロボット自体の安全性と解釈可能性です。言語モデルのバイアスは、物理システムとの関連付けによって増幅され、現実世界に影響を与える可能性があります。 信頼性の例として、人間のユーザーが Google の LaMDA モデルと通信するとき、ユーザーがモデルに「好きな島」と尋ねると、モデルはギリシャのクレタ島と答え、また答えることもできます。いくつかの理由。しかし、AIが与えるべき結果は「どの島にも行ったことがないので、どの島が一番好きかわからない」であるため、この結果は信憑性がありません。言語モデルの問題は、現実世界と対話しておらず、統計ルールに基づいて最も可能性の高い次の文のみを出力することです。 #言語モデルがロボットで使用される場合、モデルが異なれば結果も異なりますが、その一部はロボットにタスクを実行させるのに役に立ちません。たとえば、ユーザーがロボットに「こぼした飲み物を掃除して」と頼んだ場合、GPT-3 は「掃除機を使ってもいいよ」と言うかもしれません。掃除機では液体を掃除できないため、この結果は完全に正しいわけではありません。 LaMDA モデルの場合、LaMDA は「清掃業者を見つけるのを手伝ってほしいですか?」と言うかもしれません。この答えは正常ですが、そうではありません。 LaMDA は対話素材を微調整し、その目的機能は対話の長さをできるだけ長くすることであり、タスクの完了を支援することではないため、便利です。 FLANモデルだと「ごめんなさい、そんなつもりはありませんでした」とユーザーの意図を理解できず、会話なのか?まだ問題を解決する必要がありますか?したがって、ロボット上で大規模な言語モデルを使用するには一連の問題が発生します。 PaLM-SayCan は、これらの課題の解決に取り組んでいます。 1 つ目は、Few-shot Prompting (少数ショット学習) を通じて、大きなモデルがロボットの言語を話せるようにすることです。たとえば、「コーヒーを食器棚に持ってくる」、「オレンジをください」などのタスクを作成し、対応するステップ (1 ~ 5 や 1 ~ 3 など) を示します。次に、ユーザーはモデルに「テーブルの上にリンゴを置きなさい」という指示を与えます。前のステップのプロンプトが表示された後、モデルは適切なタスク ステップを独自に見つけて組み合わせ、タスクをステップごとに完了するための計画を生成します。 ##大規模なモデルを操作するには、主に 2 つの方法があることに注意してください。1 つは入力に基づいて次のトークンを生成する生成インターフェイスであり、もう 1 つは特定のトークンの尤度関数を計算するスコアリング インターフェイスです。 PaLM-SayCan はスコアリング方式を使用するため、言語モデルがより安定し、望ましい結果を出力しやすくなります。リンゴを配置するタスクでは、モデルはさまざまなステップをスコアリングし、適切な結果を選択します。 解決する必要がある別の問題があります。言語モデルがタスク ステップを生成するとき、ロボットが現在何ができるかを認識していません。ロボットの前にリンゴがない場合、ロボットはリンゴを置くタスクを完了できません。したがって、これには、現在の環境と状態でロボットがどのようなタスクを実行できるかを言語モデルに知らせる必要があります。ここでは、ロボット アフォーダンス と呼ばれる新しい概念を導入する必要があります。これは、この研究の核心でもあります。 ##アフォーダンスを中国語に訳すとアフォーダンスといい、アメリカの心理学者ジェームス・Jの名前です。ギブソンが提唱した概念です。 1977 年頃、 は、現在の状態の環境でエージェントが実行できるタスクとして定義され、エージェントのアフォーダンスを表します。 アフォーダンスは教師あり学習を使用して取得できますが、これには大量のデータとラベル付けが必要です。 これに関して、チームは強化学習手法を採用し、ポリシーの価値関数を使用してアフォーダンスを近似しました。たとえば、環境内のさまざまな物を掴むようにロボットを訓練します。訓練後、ロボットに部屋を探索させます。ロボットが目の前にある物を見つけると、その物を拾う価値関数が非常に高くなり、その結果、利用可能なアイテム、性的予測。 アフォーダンスと言語モデルを組み合わせると、PaLM-SayCan アルゴリズムが得られます。上の図に示すように、左側は言語モデルで、ユーザーの指示に従ってロボットが完了できるタスクをスコア化し、サブタスクを完了することがタスク全体の完了に役立つ確率を計算します。右側は値関数で、現在の状態で各タスクが完了する確率を表します。 2 つの積は、ロボットがタスク全体に寄与するサブタスクを正常に完了する確率を表します。 Apple の例では、現在の状態ではロボットの前にリンゴがありません。このタスクを完了するには、まずリンゴを見つける必要があるため、リンゴを見つけるアフォーダンス スコアは比較的高く、リンゴを掴むスコアが低い。リンゴを見つけた後、リンゴをつかむためのアフォーダンス スコアが増加し、リンゴをつかむタスクが実行されます。このプロセスは、タスク全体が完了するまで繰り返されます。 #PaLM-SayCan に加えて、Xia 博士と同僚は他の関連研究も完了しました。プロンプトに関して、チームは、言語モデルにより多くの推論機能を与えるために、思考連鎖プロンプティング (問題解決のアイデアとして理解できます) を提案しました。 標準のプロンプト モードでは、質問テンプレートをデザインし、回答を提供します。モデルは推論中に答えを出力しますが、モデルによって与えられた答えが間違っている場合があります。したがって、思考連鎖プロンプトの目標は、問題を提供しながらモデルに説明を提供することです。これにより、モデルの結果が大幅に向上し、一部のタスクでは人間のレベルを超えることさえあります。 #モデルは、否定的な文を処理するときにエラーが発生する傾向があります。 たとえば、人間のユーザーが「リンゴではなく果物をください」と提案します。質問と実行可能オプションの両方にリンゴが含まれるため、モデルはリンゴを提供する傾向があります。 Chain of Thought Prompting を使用すると、いくつかの説明を提供できます。たとえば、モデルは「ユーザーは果物を望んでいますが、リンゴは望んでいません。バナナはリンゴではなく果物です。私はユーザーにバナナを与えることができます。」を出力します。 思考連鎖プロンプトは、より微妙な否定的な要件も解決できます。たとえば、ユーザーがカフェインに対するアレルギーを表明し、ロボットに飲み物を持ってくるように頼みます。アレルギーも否定の微妙な形であり、従来の方法を使用すると、ロボットは (アレルギーが表す否定を理解せずに) カフェイン入りの飲み物に手を伸ばす可能性があります。思考の連鎖プロンプトにより、アレルギーなどを説明し、推論効果を高めることができます。 大規模なモデルを使用してロボットの意思決定を行い、環境相互作用の組み合わせも研究の重要な方向性です。研究チームは、言語モデルが環境の変化に基づいて過去の決定を見直し、環境によって引き起こされた誤った指示や事故から回復できるようにすることを目的とした、Inner Monologue の作業を提案しました。 ## たとえば、人間が家に帰って、選択した鍵ではドアを開けることができないことがわかった場合、人は選択するでしょう。別のキーを試すか、回転方向を変更してください。これが具体化しているのは、環境からのフィードバックに基づいてエラーを修正し、新しいアクションを更新することです。 Inner Monologue はこのように機能します。例えば、ロボットがコーラを掴んでいる間にコーラが落ちてしまうと、その後のタスクが完了できなくなるため、タスクが正常に完了したかどうかを検知し、意思決定プロセスにフィードバックを加え、新たな判断を下すにはインナー・モノローグが必要となります。フィードバック情報の決定です。

04 Q&A A: 大きな予測モデルを微調整する必要はありません。すでに多くの予測モデルが含まれています。決定情報。たとえば、1,750 億個のパラメーターを備えた GPT-3 や、すでに十分なミッション計画とシーケンス情報が含まれている PaLM を使用できます。 Q: Inner Monologue に取り組むとき、エージェントも率先して質問をすることになりますか?これはどのように吸収されたのでしょうか? #A: 言語モデルと Prompt メソッドを使用します。ロボットがタスクを完了すると、 「そして尋ねる」と「そして続ける」の 2 つのオプションが表示されます。質問するか続行するかは、文脈の意味論に曖昧さがあるかどうかによって決まります。 Q: ロボットはアイテム (引き出しの中のポテトチップスなど) がどこにあるのかをどのようにして知るのでしょうか?今後、ロボットの能力が徐々に上がってきた場合、探索時の探索空間が大きくなりすぎることはないでしょうか? #A: アイテムの保管場所に関するロボットの知識は現在ハードコーディングされており、そうではありません。自動プロセス。ただし、大規模な言語モデルには、アイテムがどこにあるかなど、特定の意味論的な知識も含まれています。この意味論的な知識により、検索スペースを削減できます。同時に、アイテムが見つかる確率に基づいて探索することもできます。現在、Xia Fei のチームは、この問題を解決するための新しい研究を発表しており、その中心となるアイデアは、自然言語のインデックス付きシーン表現を確立することです。参考サイト nlmap-saycan.github.io ##Q: また、最近登場した階層型強化学習複雑なタスクの計画にインスピレーションを与えるでしょうか? PaLM-SayCan は、基礎となるスキルと上位レベルのタスクを備えた階層型強化学習に似ています。計画は階層的な手法であると言えますが、階層的な強化学習ではありません。私は個人的にこの階層化されたアプローチを好みます。タスクを計画するときに、必ずしもすべての詳細な手順を実行する必要はなく、時間の無駄だからです。ミッション計画は大量のインターネット データを使用してトレーニングできますが、基礎となるスキルには物理データが必要なため、環境と対話して学習する必要があります。 Q: PaLM-SayCan を実際にロボットに使用する場合、未解決の根本的な問題はありますか?毎日の乳母の代わりとして使えるとしたら、実現までどれくらいかかりますか? #A: まだ解決されていない根本的な問題がいくつかあります。単純なエンジニアリングの問題です。原理的には、ロボットの根本的な動作制御と把持が大きな課題であり、未だに100%の把持を成功させることができていないことが大きな課題となっています。 #もちろん、移動が制限されている人々にすでにある程度の価値を提供できます。しかし、本当に商用製品となるかというと、まだ不可能であり、ミッション成功率は90%程度で商用要件を満たしていない。 #Q: ロボット計画の成功率はトレーニング データ セットによって制限されますか? A: ロボットの計画能力はトレーニング コーパスによって制限されます。 「ゴミを捨てなさい」などの指示をコーパス内で見つけるのは簡単です。しかし、「ロボットの2本指の爪を右に10センチ動かす」といったコーパスはインターネット上に残さないため、コーパスにはほとんど存在しません。これには粒度の高い情報の問題が関係しており、現時点ではコーパスの制限により、ロボットは粗粒度のタスクしか実行できません。 一方、詳細な計画自体は言語モデルによって実行されるべきではありません。言語モデルには物理的な情報が多すぎて使用できない可能性が高いためです。人間の言語で説明されています。 1 つのアイデアは、模倣学習 (BC-Z の研究を参照) またはコード生成 (チームの最新の研究 https://code-as-policies.github.io/ を参照) を使用して、きめの細かい操作を実装できるということです。大型モデルのより大きな役割は、ユーザーの対話型インターフェイスとして機能し、人間がロボットに与えた指示を解釈し、それらをマシンが実行できるステップに分解することです。 #さらに、この言語は、物理的な計画を必要とせずに、高レベルの意味論的な計画を実行できます。きめの細かい計画タスクを達成したい場合は、やはり模倣学習または強化学習に頼る必要があります。

#2. 言語モデルはロボットに使用されます: ロボットの言語を「話す」にはどうすればよいでしょうか?

3. 言語モデルと現実世界の間のギャップを埋める: ロボットに環境のアフォーダンスを探索させます

さらに具体化されたインテリジェンス作業: モデル推論能力の向上、環境フィードバックを使用して閉ループを形成する

#1.思考の連鎖を促す: 複雑な常識を理解する

2.内なる独白: エラーを修正し、正しい実行トラックに戻る

もう 1 つのケースは、言語モデルによる歴史情報の推論です。多くの場合、人間は考えを変えたり、指示を複数回変更した後、ロボットに「ただのタスク」を完了するように依頼します。ここでは、「単なるタスク」が指定されていないため、モデルは履歴を遡って以前のタスクが何であったかを確認する必要があります。 Inner Monologue は現在、英語に加えて中国語やその他の言語でも利用できます。他の分野での実験の後、チームは、この環境フィードバック手法により、非常に複雑で閉ループの計画タスクを完了できることを発見しました。

もう 1 つのケースは、言語モデルによる歴史情報の推論です。多くの場合、人間は考えを変えたり、指示を複数回変更した後、ロボットに「ただのタスク」を完了するように依頼します。ここでは、「単なるタスク」が指定されていないため、モデルは履歴を遡って以前のタスクが何であったかを確認する必要があります。 Inner Monologue は現在、英語に加えて中国語やその他の言語でも利用できます。他の分野での実験の後、チームは、この環境フィードバック手法により、非常に複雑で閉ループの計画タスクを完了できることを発見しました。

Q: PaLM-SayCan の大規模言語モデルは最初からトレーニングされたものですか?まだモデルのみを使用しています。

以上がGoogle の科学者が個人的に語る: 身体化された推論を実装するにはどうすればよいですか?大きなモデルにロボットの言語を「話させる」の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

このGoogle Deepmindロボットは、2028年のオリンピックでプレイしますか?Apr 15, 2025 am 10:16 AM

このGoogle Deepmindロボットは、2028年のオリンピックでプレイしますか?Apr 15, 2025 am 10:16 AMGoogle Deepmind's Table Tennis Robot:スポーツとロボット工学の新しい時代 パリ2024年のオリンピックは終わったかもしれませんが、Google Deepmindのおかげで、スポーツとロボット工学の新しい時代が夜明けです。 彼らの画期的な研究(「「人間レベルの競争を達成する」

Gemini Flash1.5モデルで食品ビジョンWebAppを構築するApr 15, 2025 am 10:15 AM

Gemini Flash1.5モデルで食品ビジョンWebAppを構築するApr 15, 2025 am 10:15 AMGemini Flash 1.5による効率とスケーラビリティのロック解除:Flask Food Vision WebApp 急速に進化するAIの状況では、効率とスケーラビリティが最重要です。 開発者は、コストとレイテンシを最小限に抑える高性能モデルをますます求めています

LlamainDexを使用してAIエージェントを実装しますApr 15, 2025 am 10:11 AM

LlamainDexを使用してAIエージェントを実装しますApr 15, 2025 am 10:11 AMllamaindexを使用してAIエージェントのパワーを活用:ステップバイステップガイド 迅速な計算であろうと最新の市場ニュースを取得するかどうかにかかわらず、リクエストを理解し、完璧に実行するパーソナルアシスタントを想像してください。この記事で探求します

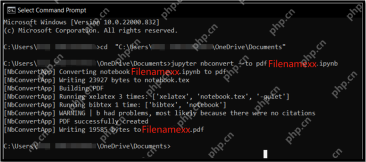

.ipynbファイルをPDF-分析vidhyaに変換する5つの方法Apr 15, 2025 am 10:06 AM

.ipynbファイルをPDF-分析vidhyaに変換する5つの方法Apr 15, 2025 am 10:06 AMJupyter Notebook(.ipynb)ファイルは、データ分析、科学的コンピューティング、およびインタラクティブエンコーディングで広く使用されています。これらのノートブックは、他のデータサイエンティストとコードを開発および共有するのに最適ですが、PDFなどのより一般的に読みやすい形式に変換する必要がある場合があります。このガイドでは、.ipynbファイルをPDFに変換するさまざまな方法、およびヒント、ベストプラクティス、およびトラブルシューティングの提案をご覧ください。 目次 .ipynbをPDFに変換する理由 .ipynbファイルをPDFに変換する方法 JupyterノートブックUIを使用します nbconveを使用します

LLMの量子化とユースケースに関する包括的なガイドApr 15, 2025 am 10:02 AM

LLMの量子化とユースケースに関する包括的なガイドApr 15, 2025 am 10:02 AM導入 大規模な言語モデル(LLM)は自然言語処理に革命をもたらしていますが、その計り知れないサイズと計算の要求は展開を制限しています。 モデルを縮小し、計算コストを削減する手法である量子化は、重要なソルーです

Pythonを使用したSeleniumの包括的なガイドApr 15, 2025 am 09:57 AM

Pythonを使用したSeleniumの包括的なガイドApr 15, 2025 am 09:57 AM導入 このガイドでは、Webオートメーションとテスト用のセレンとPythonの強力な組み合わせを探ります。 Seleniumはブラウザの相互作用を自動化し、大規模なWebアプリケーションのテスト効率を大幅に改善します。 このチュートリアルはoに焦点を当てています

相互作用用語を理解するためのガイドApr 15, 2025 am 09:56 AM

相互作用用語を理解するためのガイドApr 15, 2025 am 09:56 AM導入 相互作用項は、従属変数内の2つ以上の独立変数の効果をキャプチャするために、回帰モデリングに組み込まれています。時々、それはコントロール間の単純な関係だけではありません

Swiggy's Hermes:AIソリューションシームレスなデータ駆動型決定Apr 15, 2025 am 09:50 AM

Swiggy's Hermes:AIソリューションシームレスなデータ駆動型決定Apr 15, 2025 am 09:50 AMSwiggy's Hermes:生成AIを使用したデータアクセスに革命をもたらす 今日のデータ駆動型の風景では、インドの大手食品配達サービスであるSwiggyは、革新的なツールであるHermesを通じて生成AIの力を活用しています。 DAを加速するように設計されています

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

ドリームウィーバー CS6

ビジュアル Web 開発ツール

DVWA

Damn Vulnerable Web App (DVWA) は、非常に脆弱な PHP/MySQL Web アプリケーションです。その主な目的は、セキュリティ専門家が法的環境でスキルとツールをテストするのに役立ち、Web 開発者が Web アプリケーションを保護するプロセスをより深く理解できるようにし、教師/生徒が教室環境で Web アプリケーションを教え/学習できるようにすることです。安全。 DVWA の目標は、シンプルでわかりやすいインターフェイスを通じて、さまざまな難易度で最も一般的な Web 脆弱性のいくつかを実践することです。このソフトウェアは、