ホームページ >テクノロジー周辺機器 >AI >脳にヒントを得た AI モデル: 活性化学習、困難な逆伝播

脳にヒントを得た AI モデル: 活性化学習、困難な逆伝播

- 王林転載

- 2023-04-12 11:10:161319ブラウズ

バックプロパゲーション技術は深層学習の中核であり、視覚、音声、自然言語処理、ゲーム、生物学的予測などの多くの分野で AI の成功を推進します。バックプロパゲーションの動作メカニズムは、ニューラルネットワーク接続の重みに対する予測誤差の勾配を逆に計算し、各層の重みを微調整することで予測誤差を低減することです。バックプロパゲーションは非常に効率的であり、人工知能の現在の成功の鍵ですが、かなりの数の研究者がバックプロパゲーションの学習方法が脳の働きと一致するとは考えていません。

ディープ ラーニング テクノロジーの発展に伴い、ラベル データやコンピューティング能力への過度の依存、一連の対立的なセキュリティ問題など、バックプロパゲーションのいくつかの欠点に誰もが徐々に気づくようになりました。特定のタスクなどにのみ使用でき、大規模なモデルの開発にも懸念が生じています。

たとえば、バックプロパゲーションの提案書の著者の 1 人であり、深層学習の先駆者であるヒントンは、何度もこう述べています。バックプロパゲーションを行って最初からやり直す [2] ", "私の現在の考えでは、ディープラーニングの現在の動作方法であるバックプロパゲーションは脳の動作とは完全に異なり、脳は異なる方法で勾配を取得します [3]", "私は脳が「局所的な小さな目的関数がたくさんあり、エンドツーエンドのシステムチェーンではなく、目的関数はトレーニングを通じて最適化される[3]」を使用していると考えています。

チューリング賞受賞者でもある LeCun 氏は、「現在の深層学習モデルは将来のインテリジェント システムに不可欠な部分である可能性がありますが、必要な部分が欠けていると思います。それは必要だが十分ではないと考えている[4]。」彼の長年のライバルであるニューヨーク大学教授のゲイリー・マーカス氏は、以前にも同じことが言われていたと述べ、「一般的な人工知能を実現したいのであれば、ディープラーニングは他のテクノロジーによって補完されなければならない[4]」と述べた。

1 脳のインスピレーション

最初からやり直すには?人工知能技術の発展は間違いなくインスピレーションの理解と切り離せないものです。脳の。私たちは脳の動作メカニズムを完全に理解するにはまだ程遠いですが、その核心は外部情報に基づいてニューロン間の接続の重みを調整する方法ですが、それでも脳についてある程度の予備的な理解を得ることができ、それが新しいモデルの設計にインスピレーションを与える可能性があります。 。

まず第一に、脳の学習プロセスはヘブの法則と密接に関係しています。つまり、同時に活性化されるニューロン間の結合の重みが強化されるため、これは神経科学の最も重要な基本ルールであると言われており、多くの生物学的実験によって検証されています。

第二に、脳の学習は主に教師なし学習に基づいており、少数のサンプルから豊富な局所表現と表現間の相関関係を取得でき、フィードバック信号も学習に含まれます。プロセスでより重要な役割を果たします。さらに、脳は一般的なタスクをサポートする学習システムです。脳によって学習される機能は、特定のタスクとは相対的に反対である必要があります。合理的な目標は、脳がさまざまな入力信号の統計的分布と、異なる入力信号間の差異をよく学習できることです。内容と間のつながり。

最近、山東大学の研究者である周宏超氏は、arXiv に「ローカル競争による活性化学習」という記事を投稿し、脳にヒントを得た と呼ばれる AI モデルを提案しました。アクティベーションラーニング(アクティベーションラーニング)。その核心は、ネットワーク出力の活性化強度が入力の相対確率を反映できるように、多層ニューラル ネットワークを構築することです。

このモデルは逆伝播法を完全に放棄し、基本的なヘビアン則(脳に近い手法)を改良することから始め、新しいセットを作成します。ニューラル ネットワークの学習および推論手法が確立されており、小規模サンプルの学習実験ではバックプロパゲーションよりも大幅に優れたパフォーマンスを達成でき、画像の生成モデルとしても使用できます。この研究は、生物からインスピレーションを得た学習方法の可能性がはるかに過小評価されている可能性があることを示唆しています。

紙のリンク: https://arxiv.org/pdf/2209.13400.pdf ##2 ローカル競争のルールの学習

ヘビアン学習は、バックプロパゲーションが出現する前はニューラル ネットワーク学習研究の中核的な方向性であり、一連の学習システムが機能するきっかけとなってきましたが、最終的には成功しました。広く使用される方法にはならなかった。

考えられる理由の 1 つは、人々がヘブ則の一部のメカニズム、特にニューロン間の競合メカニズムを十分に理解していないことですが、競合はニューラル ネットワークの特徴学習と重み調整のプロセスで非常に重要な役割を果たしています。役割。

直観的に理解すると、各ニューロンが活性化を目指して全力を尽くして競合し、同時に、異なるニューロンによって表される特性を同じように異なるものにするためにある種の抑制が存在する場合、ということになります。可能であれば、ニューラル ネットワークは、最も有用な情報を次の層に転送するためにアプローチします (これは社会経済学と似ていますか? 大きな社会的グループの各個人が収入を最大化し、グループが十分に大きい場合、特定のルールの下で、グループ全体が最大化される傾向があり、そのとき各個人は異なる行動を示します。

実際、脳には多数の抑制性ニューロンが存在し、ニューロン間の競合と抑制が脳の学習プロセスにおいて重要な役割を果たしています。バックプロパゲーションの最初の著者であるルーメルハート(認知科学分野の最高賞はルーメルハート賞)がこの考えの推進者であり、バックプロパゲーションを提案(1985年)すると同時に、競争学習と呼ばれる手法も提案しました。モデル [5] の核心は、各層のニューロンをいくつかのクラスターに分割することであり、各クラスター内の最も強いニューロンのみがアクティブ化され (勝者総取りと呼ばれます)、ヘビアン ルールを通じてトレーニングされます。しかし、それに比べて、実際のアプリケーションではバックプロパゲーションの方がネットワークトレーニング効率が高いことが示されており、それ以来ほとんどの AI 研究者の注目を集め、ディープラーニングの出現と成功を促進しています。

しかし、一部の研究者は依然として生物学にヒントを得た学習方法の可能性を信じています。2019 年、クロトフとホップフィールド (そう、ホップフィールド ネットワークの提案者) は勝者総取りの法則を実証しました。 Hebbian 学習と組み合わせると、バックプロパゲーションに匹敵するパフォーマンスを達成できる可能性があります [6]。しかし、勝者総取りルールは 1 つのニューロンのみを活性化することを許可するため、ニューラル ネットワークの学習能力と表現能力もある程度制限されます。

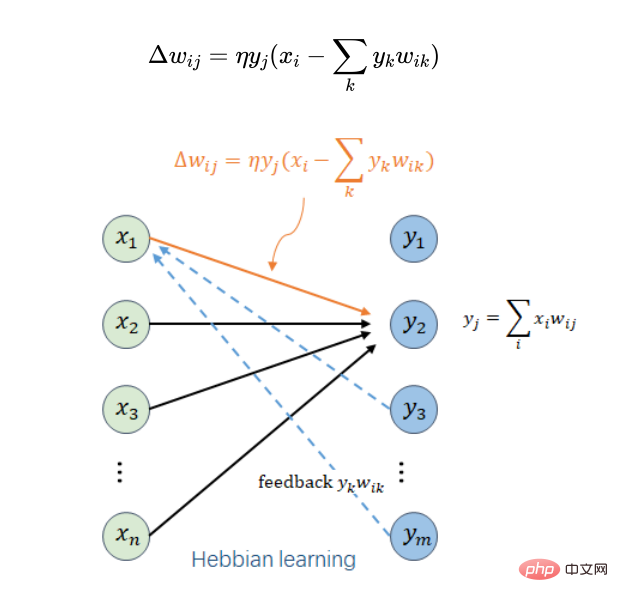

この研究の研究者は、ヘビアン学習ルールに競争メカニズムを直接導入し、簡潔な局所学習ルールを取得しました。

ここで、ニューロン i がその上の層のニューロン j の入力であると仮定します。 はニューロン i とニューロン j の間の接続の重みです。

はニューロン i とニューロン j の間の接続の重みです。 は特定のトレーニング サンプルでの重みの調整量、

は特定のトレーニング サンプルでの重みの調整量、 はニューロン i の出力とニューロン j の入力、

はニューロン i の出力とニューロン j の入力、 はニューロンj の合計加重入力 (またはニューロン j の出力)、

はニューロンj の合計加重入力 (またはニューロン j の出力)、 はより小さい学習率、

はより小さい学習率、 はニューロン j と同じ層にあるすべてのニューロンを走査します。 。

はニューロン j と同じ層にあるすべてのニューロンを走査します。 。  だけを考慮すると、これは最も独創的なヘブ規則です。ここで重要なのは、同じレイヤーからの出力フィードバック項目

だけを考慮すると、これは最も独創的なヘブ規則です。ここで重要なのは、同じレイヤーからの出力フィードバック項目  の導入です。これは 2 つの役割を果たします: 1 つ目は、すべての重みが無限に増加せず、学習プロセスが収束することを保証すること、2 つ目は、特徴表現を改善するために、この層内のニューロン j と他のニューロンとの間に競合を導入することです。

の導入です。これは 2 つの役割を果たします: 1 つ目は、すべての重みが無限に増加せず、学習プロセスが収束することを保証すること、2 つ目は、特徴表現を改善するために、この層内のニューロン j と他のニューロンとの間に競合を導入することです。

上記の局所学習ルールを数学的に分析することによって (学習率が十分に小さく、学習ステップの数が十分に大きいと仮定して)、いくつかの興味深い結論を得ることができます。

(1) 各層の  が与えられると、入力 ## は

が与えられると、入力 ## は  を通じて再構築できます。

を通じて再構築できます。  #再構築エラーをできるだけ小さくします。このレイヤーごとの再構成機能により、敵対的攻撃に対するモデルのセキュリティが向上し、一部のオブジェクト画像に敵対的ノイズが追加されて他のオブジェクトとして認識されるのを防ぐことができます。

#再構築エラーをできるだけ小さくします。このレイヤーごとの再構成機能により、敵対的攻撃に対するモデルのセキュリティが向上し、一部のオブジェクト画像に敵対的ノイズが追加されて他のオブジェクトとして認識されるのを防ぐことができます。

(2) 局所学習ルールに基づく各層の特徴抽出は、主成分分析 (PCA) と類似点があり、再構成損失は同じですが、主成分とは異なります。違いは、ローカル学習ルールによって取得されるコンポーネントが直交している必要がないことです。主成分分析は各層の主な情報を抽出するため、これは非常に合理的なことですが、主成分に対応するニューロンが故障するとネットワーク全体のパフォーマンスに影響を及ぼし、ローカル学習ルールはこの問題を確実に解決します。 . 性的な問題。

(3) 各層の接続重みの二乗の合計は、その層のニューロンの数を超えない傾向があり、ネットワーク学習プロセスの収束が保証されます。

(4) 各層の出力強度 (出力の二乗和) は、層の入力強度 (出力の二乗和) より大きくならない傾向があります。入力)、およびほぼ典型的な入力の場合、出力強度は一般に高くなるため、入力確率は出力強度で近似できます。この結論は、提案される活性化学習モデルにとって非常に重要な点です。

3 活性化学習

上記のローカル学習ルールに基づいて、多層ニューラル ネットワークを層ごとにボトムアップでトレーニングして、教師なし特徴の自動抽出を実現できます。 。トレーニング済みのネットワークは、認識、翻訳などのさまざまな教師あり学習タスクの事前トレーニング モデルとして使用して、学習タスクの精度を向上させることができます。ここでのさまざまな教師あり学習タスクは依然として逆伝播モデルのトレーニングに基づいており、教師なし事前トレーニング モデルは微調整されています。

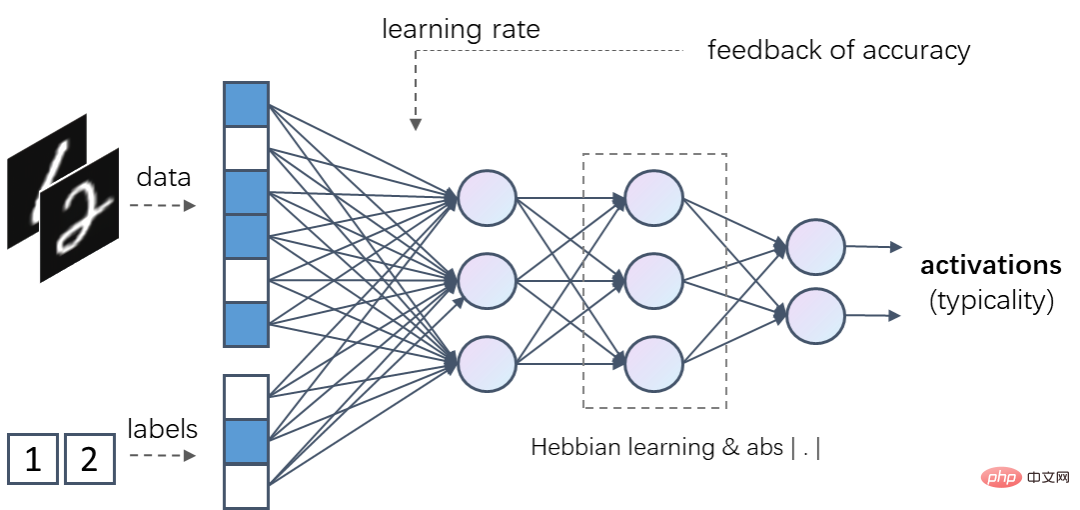

しかし、さらに興味深いのは、上記のローカル学習ルールに基づいて、活性化学習 (Activation Learning) と呼ばれる、バックプロパゲーションをまったく使用しない新しい AI モデルを構築できることです。中心となるのは、ローカルの教師なしトレーニングを使用して、ネットワーク全体の出力強度 (出力の二乗和) を有効にして、入力サンプルの相対確率を推定できるようにすることです。つまり、入力サンプルが頻繁に見られるほど、より強力な確率が得られます。通常、出力強度は になります。

#活性化学習では、入力サンプルは正規化後に多層ニューラル ネットワークに供給されます。各層には、ローカル学習ルールを通じてトレーニングできる線形変換が含まれています。各層の非線形活性化関数は、入力強度 (二乗和) と出力強度が変化しないことを保証する必要があります。たとえば、絶対値関数  を活性化関数として使用できます。ネットワークの出力強度は、活性化関数が減衰したり強化したりした後に変化することはなく、ネットワーク全体の最終的な出力強度は入力サンプルの相対確率を反映する可能性があります。

を活性化関数として使用できます。ネットワークの出力強度は、活性化関数が減衰したり強化したりした後に変化することはなく、ネットワーク全体の最終的な出力強度は入力サンプルの相対確率を反映する可能性があります。

非線形活性化関数がローカル学習ルールに追加される場合、つまり  がニューロン j の出力を表す場合、活性化関数は必要ありません。入力と出力の強度を変更しない必要がある場合は、RELU などの他の非線形関数をアクティベーション関数として使用できます。活性化学習の推論プロセスは、ネットワークの最終的な出力強度が最大になるように、入力の既知の部分に基づいて欠落部分を推定することです。

がニューロン j の出力を表す場合、活性化関数は必要ありません。入力と出力の強度を変更しない必要がある場合は、RELU などの他の非線形関数をアクティベーション関数として使用できます。活性化学習の推論プロセスは、ネットワークの最終的な出力強度が最大になるように、入力の既知の部分に基づいて欠落部分を推定することです。

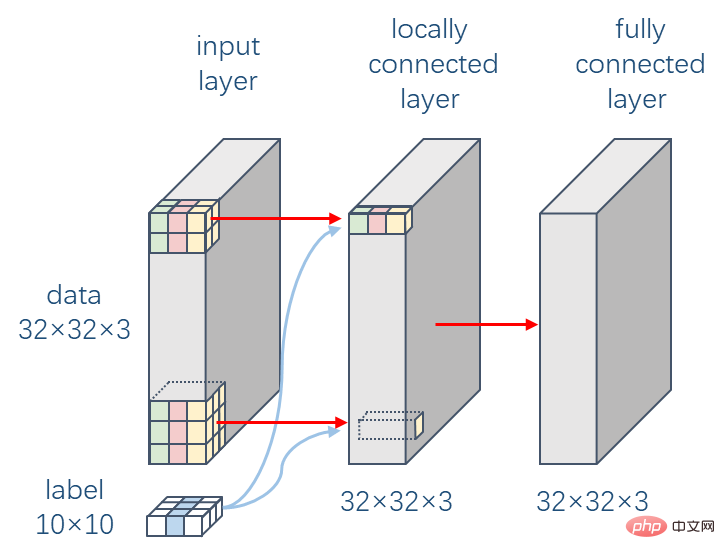

たとえば、活性化学習ネットワークは、データとラベル (ワンホット エンコーディングなど) を同時に入力として受け取ることができます。このようなトレーニング済みネットワークの場合、データと正しいラベル入力が与えられた場合、その出力活性化強度は通常、このデータと誤ったラベルの出力活性化強度よりも高くなります。

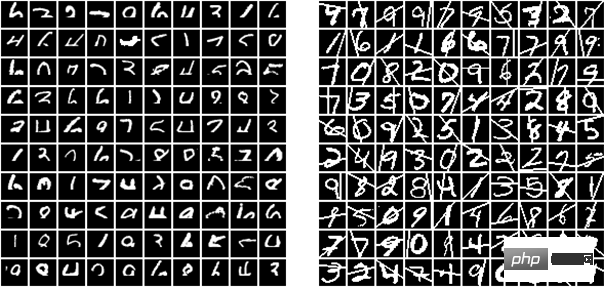

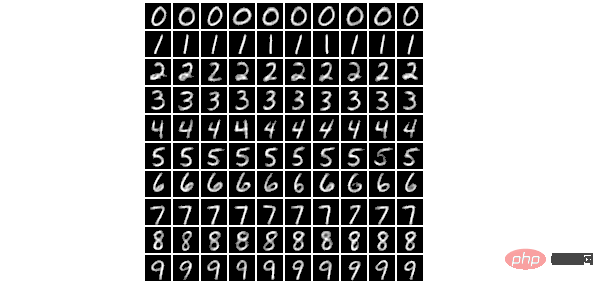

このような活性化学習モデルは、判別モデルとしても生成モデルとしても使用できます。識別モデルとして使用する場合は、指定されたデータから欠落しているカテゴリを推論し、生成モデルとして使用する場合は、一定量のランダム性と組み合わせた指定されたカテゴリから推論します。さらに、誤認サンプルに対してより高い全体学習率を与えるなどの認識フィードバック情報を導入すると、判別モデルの学習効果が向上することが実験により判明した。

4 小規模サンプルの分類と画像生成

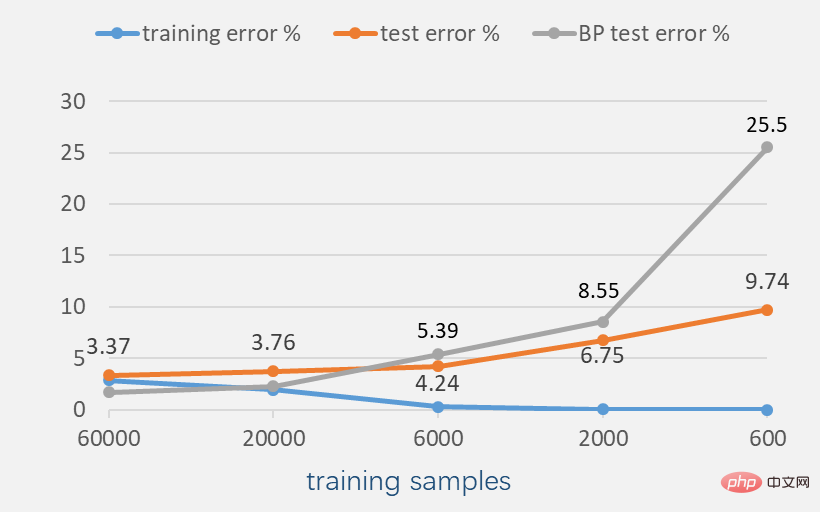

MNIST データセット (白黒の手書き数字画像) の実験により、トレーニングがサンプル 多くの場合、バックプロパゲーションの精度は活性化学習の精度よりも高くなります。たとえば、同様の複雑さのニューラル ネットワークに基づく 60,000 のトレーニング サンプルの場合、バックプロパゲーションでは約 1.62% のエラー率を達成できますが、活性化学習では約 3.37% のエラー率しか達成できません (認識からのフィードバックの場合)。結果が紹介されています (学習を活性化するには、エラー率を 2.28% に減らすことができます)。

しかし、トレーニング サンプルの数が減ると、活性化学習のパフォーマンスが向上する可能性があります。たとえば、トレーニング サンプルが 6000 個の場合、活性化学習の誤り率は既にバックプロパゲーションのエラー率よりも低くなりますが、トレーニング サンプルが 600 個の場合、バックプロパゲーションの認識エラー率は 25.5% にも達します。しかし、活性化学習のエラー率はわずか 9.74% であり、これも教師なしの事前トレーニング済みモデルと組み合わせた方法 (エラー率は約 20.3%) よりも大幅に低くなります。

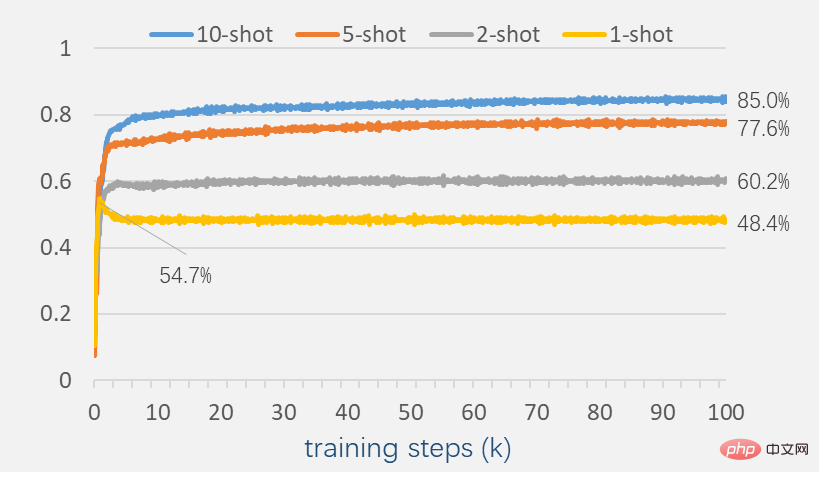

少数のサンプルで活性化学習のパフォーマンスを調査するには、引き続きサンプル数を少数のサンプルに減らします。現時点では、活性化学習はまだ一定の認識能力を示しています。

各カテゴリに 2 つのサンプルがある場合、認識精度は 60.2% に達し、各カテゴリに 10 個のサンプルがある場合、認識精度は 85.0% に達します。注目すべき現象は、各カテゴリに少なくとも 2 つのサンプルがある場合、トレーニング プロセス全体を通じてテストの精度が低下しないことです。これは、バックプロパゲーションに基づく多くのモデルとは異なり、一面から見ると、活性化学習の汎化能力が優れている可能性があることを反映しています。

#訓練された活性化学習ネットワークが与えられた場合、認識される画像に特定の干渉を追加してみます。以下の図に示すように、画像のピクセルの一定の割合をカバーするか、ランダムな線を追加します。トレーニングプロセス中にモデルはこれらの乱れた画像に遭遇していませんが、活性化学習は依然として一定の認識能力を示しています。たとえば、画像の 1/3 が覆われている場合 (下部)、活性化学習は約 7.5% の認識誤り率を達成できます。

#ここで実験したニューラル ネットワークは 2 つの層で構成されています。最初の層はローカル接続層で、畳み込みカーネル サイズ 9 で畳み込まれます。これらの層は同じ接続構造を持っていますが、各位置には独自の重みパラメータがあります。2 番目の層は完全に接続された層で、各層のノードの数は ,

#ここで実験したニューラル ネットワークは 2 つの層で構成されています。最初の層はローカル接続層で、畳み込みカーネル サイズ 9 で畳み込まれます。これらの層は同じ接続構造を持っていますが、各位置には独自の重みパラメータがあります。2 番目の層は完全に接続された層で、各層のノードの数は ,

と同じ次元です。入力画像は一貫しています。  実験により、ローカル接続により学習プロセスがより安定し、学習パフォーマンスがある程度向上することが示されています。この 2 層のニューラル ネットワークに基づき、認識結果からのフィードバックと組み合わせることで、活性化学習は CIFAR-10 で 41.59% のエラー率を達成できます。

実験により、ローカル接続により学習プロセスがより安定し、学習パフォーマンスがある程度向上することが示されています。この 2 層のニューラル ネットワークに基づき、認識結果からのフィードバックと組み合わせることで、活性化学習は CIFAR-10 で 41.59% のエラー率を達成できます。

生物学にインスピレーションを得たモデルの以前のベンチマークは、Krotov と Hopfield によって確立され、49.25% のエラー率を報告しました。彼らは 2 層のニューラル ネットワークを使用し、最初の層には 2,000 個のノードが含まれ、生物学にヒントを得た方法によって教師なしでトレーニングされ、2 番目の出力層は逆伝播によって監視されます。比較のために、同じネットワークがバックプロパゲーションを通じて完全にトレーニングされた場合、44.74% のエラー率を達成できますが、活性化学習ではバックプロパゲーションをまったく使用せず、より良い結果が得られます。ランダムクロッピングを含むデータ拡張を使用し、第 1 層のノード数を  # に増加すると、活性化学習の認識誤り率は 37.52% に削減できます。

# に増加すると、活性化学習の認識誤り率は 37.52% に削減できます。

5 一般的なタスクに向けて

ほとんどの深層学習モデルが特定のタスクにのみ適用されるのはなぜですか?その理由の 1 つは、サンプルを人為的にデータとラベルに分割し、データをモデルの入力として使用し、ラベルを出力監視情報として使用するためであり、これにより、モデルは予測に役立つ特徴のみを保持する傾向が強くなります。他のタスクに役立つ機能。活性化学習は目に見えるあらゆる情報を入力として学習サンプルの確率や統計分布、各部分間の相関関係を学習することができ、その情報は関連するすべての学習タスクに利用できるため、一般的なタスクのモデルとみなすことができます。 。

実際、私たちが物体を見て、他の人がそれが何であるかを教えてくれるとき、脳がその音声信号を出力ラベルとして確実に使用するかどうかを定義することは困難です。入力としての視覚信号; 少なくともこの学習は双方向であるべきであり、つまり、このオブジェクトを見ると、それが何であるかを考え、それが何であるかを与えられた場合、このオブジェクトがどのように見えるかについても考えることになります。

活性化学習は、マルチモーダル学習にも使用できます。たとえば、所与のトレーニング サンプルに画像およびテキスト モダリティが含まれる場合、画像とテキストの間の関連付けが確立される可能性があり、所与のトレーニング サンプルにテキストおよびサウンド モダリティが含まれる場合、テキストとサウンドの間の関連付けが確立される場合があります。活性化学習は連想記憶モデルになる可能性があり、さまざまな種類の関連コンテンツ間の関連付けを確立し、伝播を通じて関連コンテンツをクエリまたはアクティブ化します。一般に、この連想記憶能力は人間の知性において非常に重要な役割を果たしていると考えられています。ただし、ローカル入力データのトレーニングの問題と壊滅的な忘却の問題は、ここでもまだ解決する必要があります。

活性化学習の研究には、新しい AI モデルであることに加えて、他の価値もあります。たとえば、光ニューラル ネットワークやメモリスタ ニューラル ネットワークなどの物理実装に基づくニューラル ネットワーク システムのオンチップ トレーニングをより簡単にサポートでき、基本的な物理コンポーネントやシステムの精度によるシステム全体の計算精度の低下を回避できます。プログラミングノイズ。また、生物学的実験と組み合わせることで、局所的なトレーニング規則に特定の生物学的説明があるかどうかなど、脳の動作メカニズムをより深く理解するよう促すこともできます。研究者の周紅潮氏は、「ほとんどの複雑なシステムは単純な数学的規則によって支配されていると私は信じています。脳は非常に素晴らしいシステムです。最終的には、私たちの目標はより賢い機械を設計することです。」と述べています。

以上が脳にヒントを得た AI モデル: 活性化学習、困難な逆伝播の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。