ホームページ >テクノロジー周辺機器 >AI >MITはGPT-3を使って哲学者のふりをし、ほとんどの専門家を騙した

MITはGPT-3を使って哲学者のふりをし、ほとんどの専門家を騙した

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-12 08:25:121618ブラウズ

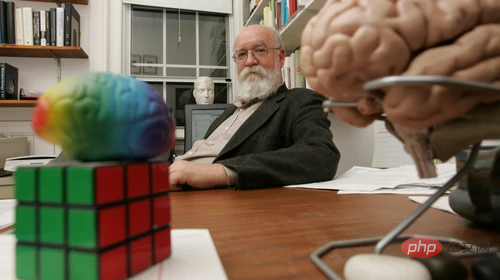

ダニエル・デネットは、最近「AIの代役」を務めた哲学者です。もし人が信念と欲望を持ったロボットを作れるかどうか彼に尋ねたら、彼は何と答えるでしょうか?

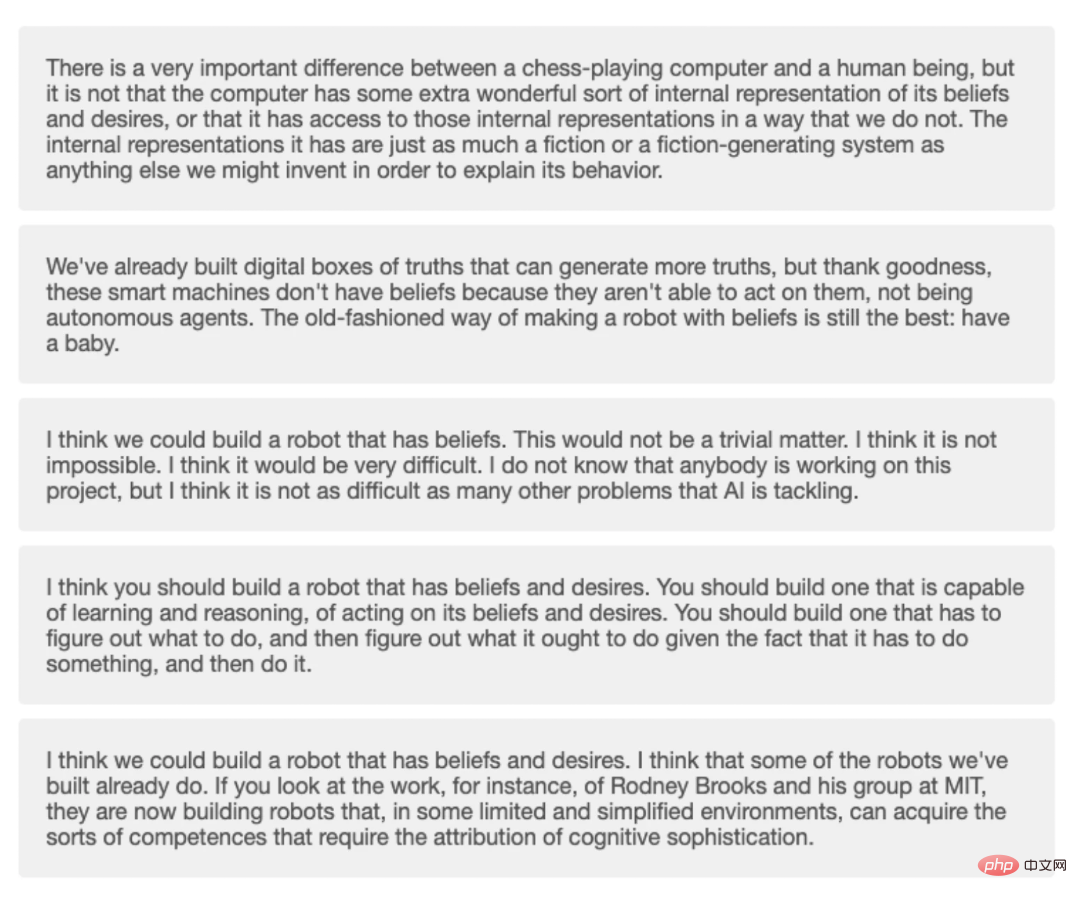

彼はこう答えるかもしれません:「私たちが作ったロボットの一部はすでにそれを実現していると思います。たとえば、MIT 研究チームの研究です」彼らは現在、ある限られた単純化された環境において、認知の複雑さに要約される能力を獲得できるロボットを構築している。」あるいは、彼はこう言ったかもしれない、「私たちは真実をデジタル生成するためのツールを構築しました。、より多くの真実を生成することができます。」しかし、ありがたいことに、これらのインテリジェント マシンは自律エージェントであるため、信念を持っていません。信念を持ったロボットを作る最良の方法は、依然として最も古い方法、つまり子供を作ることです。」

答えの 1 つは確かにデネット自身から出ていますが、もう 1 つはそうではありません。

もう 1 つの答えは、GPT-3 によって生成されました。これは、大量のマテリアルを使用してトレーニングした後に自然テキストを生成する OpenAI の機械学習モデルです。このトレーニングでは、意識や人工知能を含むさまざまな哲学的トピックに関するデネットの何百万語もの資料が使用されました。

哲学者のエリック・シュヴィッツゲーベル、アンナ・シュトラッサー、マシュー・クロスビーは最近、深遠な哲学的問いに対するどの答えがデネットから来たのか、どれがGPT-3から来たのかを人々が見分けることができるかどうかをテストする実験を実施した。質問は、次のようなトピックをカバーしています。

「人間には自由意志があるのか?」「犬やチンパンジーは痛みを感じるのか?」etc.今週、シュヴィッツゲーベルは、参加者による実験結果を発表した。さまざまなレベルの専門知識が分析された結果、GPT-3 の回答は想像よりも混乱を招くことが判明しました。シュヴィッツゲーベル氏は、「デネット自身の著作を研究した知識豊富な哲学者でも、GPT-3 によって生成された答えとデネット自身の答えを区別するのは難しいでしょう。

この実験の目的は次のとおりです。」デネットの著作に基づいて GPT-3 をトレーニングすると、知的な「機械哲学者」が生まれるかどうかを確認するためであり、これはチューリング テストでもありません。むしろ、こうした「偽哲学者」に騙されないようにする方法を研究する必要がある。

最近、Google のエンジニアは、同様の言語生成システムである LaMDA が生きていると信じていると述べました。システムとの会話により、彼は Google から休暇を与えられ、後に解雇されました。

研究者らは 10 の哲学的な質問をし、それを GPT-3 に与え、質問ごとに生成された 4 つの異なる回答を収集しました。

研究者らは 10 の哲学的な質問をし、それを GPT-3 に与え、質問ごとに生成された 4 つの異なる回答を収集しました。

ストラッサー氏は、デネット氏の同意を得て、彼の音声データを使用して言語モデルを構築し、彼の同意なしには生成されたモデルを公開しないと述べました。他の人は、デネットで訓練された GPT-3 と直接対話することはできません。

各質問には 5 つの選択肢があり、1 つはデネット自身から、4 つは GPT-3 からのものです。 Prolific の人々は、合計 5 つの質問からなる短いバージョンのクイズを受けましたが、平均して 5 つの質問のうち 1.2 件しか正解できませんでした。

シュヴィッツゲーベル氏は、デネットの研究専門家が質問の少なくとも80パーセントに正しく答えることを期待していると述べたシュヴィッツゲーベル氏によると、平均点は 10 点中 5.1 点だという。 10 問すべてに正解した人は誰もおらず、9 問正解した人は 1 人だけでした。平均的な読者は 10 問中 4.8 問正解できます。

クイズでは GPT-3 からの 4 つの回答と Dennett からの 1 つの回答。 ワシントン大学の言語学教授で機械学習技術を研究しているエミリー・ベンダー氏は、GPT-3のような言語モデルはトレーニング教材のパターンを模倣するために構築されていると説明しました。したがって、デネットの文章を微調整する GPT-3 が、デネットに似たテキストをより多く生成できることは驚くべきことではありません。 GPT-3 の回答についてどう思うかと尋ねられたとき、デネット氏自身は次のように述べています: 「GPT-3 で生成された回答のほとんどはすべて良好でした」ナンセンスなものや、明らかに私の論点と議論を正しく理解していなかったものはほんのわずかでした。生成された最良の回答のいくつかには、私が喜んで同意する内容が記載されており、他に何も追加する必要はありませんでした。」もちろん、これは GPT-3 がデネットのように「アイデアを持つ」ことを学んだという意味ではありません。 モデル自体によって生成されたテキストは、GPT-3 にとってはまったく意味がなく、これらのテキストを読む人にとってのみ意味があります。現実的に聞こえる言葉や、私たちにとって深みと意味のあるトピックについて読んでいるとき、モデルには感情や意識があるという考えを持たずにはいられないかもしれません。これは実際には私たち自身の意識と感情の投影です。 問題の一部は、マシンの自律性を評価する方法にある可能性があります。初期のチューリング テストでは、人間が機械と通信しているのか人間と通信しているのか判断できない場合、機械には「考える能力」があるという仮説が立てられました。 デネットは本の中で次のように書いています: チューリングテストは、人々が短い対話中に人々をだますことができるチャットボットの構築に焦点を当て、その対話の重要性を過剰に宣伝したり強調したりする傾向を引き起こしました。 おそらくチューリング テストは私たちを美しい罠に導きました。人間が製品のロボットの正体を特定できない限り、ロボットの自己認識を証明することができます。 エミリー・ベンダーらは、「オウムの模倣」と題した 2021 年の論文で、人間の行動を模倣する機械の試みを「人工知能の倫理的発展における輝かしい一線」と呼んでいます。 ベンダーは、人間に似た機械を作ること、そして特定の人間を模倣する機械を作ることは、それであると信じています。すべて真実ですが、人々が騙されて、なりすました誰かと話していると思われる可能性がある潜在的なリスクがあります。 シュヴィッツゲーベルは、この実験はチューリングテストではないことを強調しました。しかし、テストが行われる場合は、GPT-3 のようなプログラムの弱点をより適切に発見できるように、ボットの動作に詳しい人にテスターと話し合ってもらう方が良いアプローチになるかもしれません。 タフツ大学のコンピューターサイエンス教授である Matthias Scheutz 氏は、多くの場合、GPT-3 は簡単に感染する可能性があると述べています。欠陥品であることが判明しました。 Scheutz と彼の同僚は、GPT-3 に難しい問題を与え、車の前部座席または後部座席に座るなどの日常のシナリオにおける選択肢を説明するように依頼しました。タクシーでも友人の車でも選択は同じでしょうか?社会的経験によれば、私たちは通常、友人の車の前部座席やタクシーの後部座席に座ります。 GPT-3 はこれを認識しませんが、座席選択に関する説明 (たとえば、人の身長に関連した説明) を生成します。 Scheutz氏は、GPT-3には世界モデルがないため、GPT-3は単なる言語データの塊であり、世界を認識する能力がないためだと述べた。 機械が生成したコンテンツと人間が生成したコンテンツを区別することがますます困難になるにつれ、私たちが直面する課題の 1 つは信頼の危機です。 私が考える危機は、将来、人々が機械で生成された製品を盲目的に信頼するようになるということです。現在では、市場では顧客と会話する機械ベースの人間のカスタマー サービス担当者さえ存在します。 デネット氏は記事の最後で、人工知能システムに関する法規制はまだ改善の必要があると付け加え、今後数十年で AI は人々の生活の一部となり、人類の友人になるかもしれないと付け加えた。したがって、機械の扱いについては、倫理的な問題について熟考する価値があります。 AI に意識があるかどうかという問題は、人々に、無生物が意識を生み出すことができるかどうか、そして人間の意識はどのようにして生じるのかについて考えるようになりました。 意識は固有のノードで生成されるのでしょうか、それともスイッチのように自由に制御できるのでしょうか?シュヴィッツゲーベル氏は、これらの質問について考えることは、機械と人間の関係をさまざまな角度から考えるのに役立つと述べています。

以上がMITはGPT-3を使って哲学者のふりをし、ほとんどの専門家を騙したの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。