ホームページ >テクノロジー周辺機器 >AI >ChatGPT はこれからどこへ向かうのでしょうか? LeCun の新作: 次世代「強化された言語モデル」の包括的なレビュー

ChatGPT はこれからどこへ向かうのでしょうか? LeCun の新作: 次世代「強化された言語モデル」の包括的なレビュー

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-11 23:58:011227ブラウズ

ChatGPT は言語モデルの火付け役となり、NLP 実践者は今後の研究の方向性を振り返り、まとめています。

最近のチューリング賞受賞者のヤン・ルカン氏は、「強化された言語モデル」に関するレビューの執筆に参加し、「言語を組み合わせた作品」をレビューしました。推論スキルとツールを使用する能力を備えたモデルを開発し、この新しい研究方向には、解釈可能性、一貫性、スケーラビリティの問題など、従来の言語モデルの限界に対処できる可能性があると結論付けています。

論文リンク: https://arxiv.org/abs/2302.07842

強化された言語モデルでは、推論とは、複雑なタスクをより単純なサブタスクに分解することを意味します。ツールには、外部モジュール (コード インタプリタ、計算機など) の呼び出しが含まれます。LM はヒューリスティックを使用してメソッドでこれらの拡張機能を利用できます。個別に、または組み合わせて、または実証学習を通じて。

標準の欠落トークン予測目標に従いながら、強化された LM は、ノンパラメトリックなさまざまな外部モジュールを使用してコンテキスト処理機能を拡張でき、純粋な言語モデリングに限定されません。拡張言語モデル (ALM、拡張言語モデル) と呼ぶことができます。

欠落トークンの予測ターゲットにより、ALM は推論、ツールの使用、さらには行動 (アクション) を学習できると同時に、標準的な自然言語タスクを実行したり、複数のベンチマークで実行したりすることもできます。データセット ほとんどの通常の LM よりも多くのデータセット。

強化された言語モデル

大規模言語モデル (LLM) は、自然言語処理の大幅な進歩を推進し、徐々に何百万ものユーザーが使用する製品の技術的中核になってきました。コーディング アシスタント Copilot、Google 検索エンジン、最近リリースされた ChatGPT が含まれます。

記憶と構成性機能を組み合わせることで、LLM は、言語理解や条件付きおよび無条件のテキスト生成などのさまざまなタスクを前例のないパフォーマンス レベルで実行できるようになり、より幅広い人々にサービスを提供できるようになります。実践的な道を切り開いた。

ただし、LLM の現在の開発には依然として多くの制限があり、より広範なアプリケーション シナリオへの展開が妨げられています。

たとえば、LLM は、事実ではないものの、一見合理的であるように見える予測 (幻覚とも呼ばれます) を提供することがよくあります。算術問題や推論の連鎖など、多くのエラーは実際には完全に回避可能です。小さなエラーが発生しました。

さらに、LLM の画期的な機能の多くは、トレーニング可能なパラメーターの数によって測定されるように、規模に応じて現れるようであり、以前の研究者は、モデルが一定のレベルに達すると、スケールが大きいため、LLM はいくつかの大きなベンチタスクを数回のプロンプトで完了できます。

最近、大規模モデルの機能の一部を保持しながら小規模な LM をトレーニングする取り組みが行われてきましたが、現在の LLM の規模とデータの需要により、トレーニングとメンテナンスには法外な額になっています。それは現実的ではありません。大規模なモデルの継続的な学習は未解決の研究課題のままです。

メタ研究者は、これらの問題は LLM の基本的な欠陥に起因すると考えています。トレーニング プロセスにはパラメーター モデルと限られたコンテキスト (通常、前後に n 個の単語) が与えられ、統計的な処理が実行されます。言語モデリング。

ソフトウェアとハードウェアの発展により、コンテキスト サイズ n は近年増加していますが、ほとんどのモデルは依然として比較的小さなコンテキスト サイズを使用しているため、巨大なサイズのモデルが格納されます。存在しないということは、コンテキストに関する知識にとって必要な条件であり、下流のタスクを実行する場合にも重要です。

したがって、上記の純粋に統計的な言語モデリングのパラダイムからわずかに逸脱した方法でこれらの問題を解決する研究傾向が高まっています。

たとえば、LLM のコンテキスト サイズの制限の問題を、「関連する外部ファイルから抽出された情報」からの関連性の計算を追加することで回避する取り組みがあります。データベースから特定のコンテキストでそのような文書を取得するための取得モジュールを LM に装備することにより、より少ないパラメータでありながら、大規模な LM の機能の一部と一致させることができます。

結果のモデルは外部データ ソースをクエリできるため、ノンパラメトリックになることに注意してください。より一般的には、LM は推論戦略を通じてコンテキストを改善し、答えを生成する前により関連性の高いコンテキストを生成し、より多くの計算を通じてパフォーマンスを向上させることもできます。

もう 1 つの戦略は、LM が外部ツールを利用して、LM の重み付けに含まれていない重要な欠落情報で現在のコンテキストを強化できるようにすることです。これらの研究のほとんどは、前述の LM の欠点を軽減することを目的としていますが、より体系的に推論とツールを使用して LM を強化すれば、大幅に強力なエージェントが得られる可能性があると考えるのは簡単です。

研究者は、これらのモデルを 拡張言語モデル (ALM) と総称しています。

この傾向が加速するにつれて、多数のモデルを追跡して理解することが困難になり、ALM の作業の分類と、さまざまな目的で使用される技術用語の定義が必要になります。

推論

ALM のコンテキストでは、推論とは、複雑な可能性のあるタスクをより単純なサブタスクに分解することです。 LM は自分で、またはツールを使用してより簡単に解決できます。

サブタスクを分解するには、再帰や反復など、現在さまざまな方法があります。ある意味、この推論は、LeCun の 2022 年の論文「Towards Autonomous Machine Intelligence」計画で定義されている「Route」に似ています。 」。

論文リンク: https://openreview.net/pdf?id=BZ5a1r-kVsf

この調査では、推論とは、少数の例を使用して段階的に推論するなど、LM の推論能力を向上させるためのさまざまな戦略を指します。 LM が実際に推論しているのか、それとも欠落しているトークンを正しく予測する可能性を高めるためのより大きなコンテキストを単に生成しているのかはまだ完全には理解されていません。

現在のテクノロジーの状況を考えると、推論という言葉は使いすぎているかもしれませんが、この用語はすでにコミュニティ内で広く使用されています。 ALM のコンテキストでは、推論のより実用的な定義は、プロンプトに対する答えに到達する前に、モデルにより多くの計算ステップを与えることです。

#ツール ツール##ALM の場合、ツールは外部モジュールであり、通常は次のように呼び出されます。ルールまたは特別なトークンの場合、その出力は ALM コンテキストに含まれます。

ツールは、外部情報を収集したり、仮想世界または物理世界 (通常は ALM によって感知される) に影響を与えるために使用できます。たとえば、ファイル取得ツールをツールとして使用できます。外部情報を取得するため、またはロボットアームを使用して外部の影響を感知するため。

ツールはトレーニング時または推論時に呼び出すことができます。より一般的には、モデルは API の呼び出し方法の学習など、ツールとの対話方法を学習する必要があります。

Act

ALM の場合、仮想世界または物理世界に影響を与えるツールを呼び出し、その状況を観察します。結果は、通常、ALM の現在のコンテキストに取り込まれます。

この調査で紹介された研究の一部は、Web の検索や、LM を介したロボット アームの操作について説明しています。用語の若干の誤用により、ALM によるツールの呼び出しは、外部の世界に影響を及ぼさない場合でも、アクションとして表現されることがあります。

#なぜ推論とツールを同時に議論するのでしょうか?

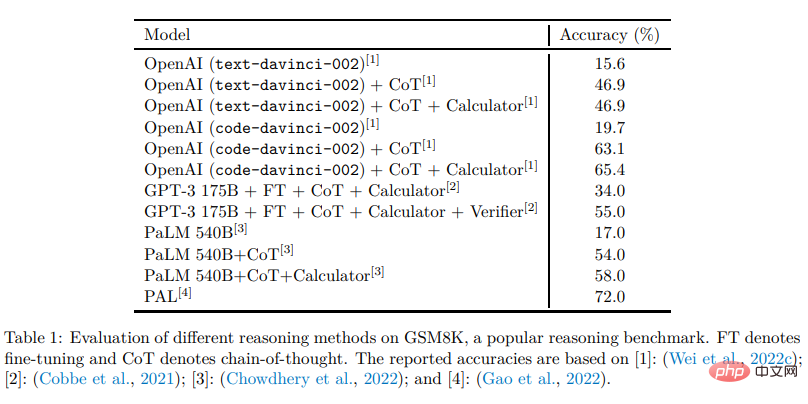

LM における推論とツールの組み合わせにより、ヒューリスティックを使用せずに、つまりより優れた一般化機能を使用して、広範囲の複雑なタスクを解決できるようになります。

通常、推論により、LM は特定の問題を潜在的により単純なサブタスクに分解することが容易になり、ツールは各ステップを正しく完了するのに役立ちます (数学的演算から結果を取得するなど)。

言い換えると、推論は LM がさまざまなツールを組み合わせて複雑なタスクを解決する方法であり、ツールは推論の失敗を回避し、効果的に分解するための方法です。

どちらも他方からメリットを得ることができ、推論とツールを同じモジュールに配置できます。方法は異なりますが、どちらも LM のコンテキストを強化して欠落トークンをより適切に予測することで機能するためです。 。

#なぜツールとアクションを同時に議論するのでしょうか?

##追加情報を収集し、仮想世界または物理世界に影響を与えるツールは、同じ方法で LM から呼び出すことができます。たとえば、数学演算を解くために Python コードを出力する LM と、ロボット アームを操作するために Python コードを出力する LM の間には、ほとんど違いがないようです。このレビューで取り上げた作品の中には、すでに仮想世界や物理世界に影響を与えるLMを使用しているものもあり、この観点から見ると、LMは自律エージェントとして行動する可能性があり、LMの方向に重要な進歩が期待できると言えます。 分類方法研究者はレビューで紹介した作品を上記の3つの次元に分解し、それぞれ紹介します。最後に、他の次元での関連作業について話し合います。読者は、これらのテクニックの多くが元々 LM 以外の文脈で紹介されたものであることを覚えておく必要があり、必要に応じて、可能であれば言及されている論文や関連研究の紹介を参照してください。最後に、このレビューは LLM に焦点を当てていますが、関連するすべての研究が大規模なモデルを採用しているわけではなく、LM の正確さを目的としています。

以上がChatGPT はこれからどこへ向かうのでしょうか? LeCun の新作: 次世代「強化された言語モデル」の包括的なレビューの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。