ホームページ >テクノロジー周辺機器 >AI >欧州の人工知能法案が間もなく提出され、世界の技術規制に影響を与える可能性がある

欧州の人工知能法案が間もなく提出され、世界の技術規制に影響を与える可能性がある

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-11 22:40:141391ブラウズ

人工知能法案は、人工知能の開発方法、企業が人工知能を何に使用できるか、準拠しない場合の法的影響など、人工知能の使用に関する共通の規制および法的枠組みを作成することを目的としています。要求事項。この法案は、人工知能を導入する前に特定の状況で承認を取得すること、リスクが高すぎるとみなされる人工知能の特定の使用を禁止すること、人工知能の他の高リスク使用の公開リストの作成を企業に義務付ける可能性がある。

欧州委員会は、この法律に関する公式報告書の中で、この法律は広範なレベルで、EU を信頼できる人工知能のパラダイムに変えることを目指していると述べました。このパラダイムでは、「民主的価値観、人権、法の支配を尊重しながら、AIが法的、倫理的、技術的に強力であることが要求される」。

提案されている人工知能の規制枠組みには次の目的があります:

1. EU 市場で展開および使用される人工知能システムが安全であることを確認し、既存の法的基本的権利と EU の価値観を尊重する。

2. AI への投資とイノベーションを促進するための法的確実性を確保する;

3. AI システムに適用される基本的権利とセキュリティに関する既存法のガバナンスと効果的な執行を強化する;

4.合法的で安全かつ信頼できる人工知能アプリケーションの統一市場の開発を促進し、市場の断片化を防ぎます。

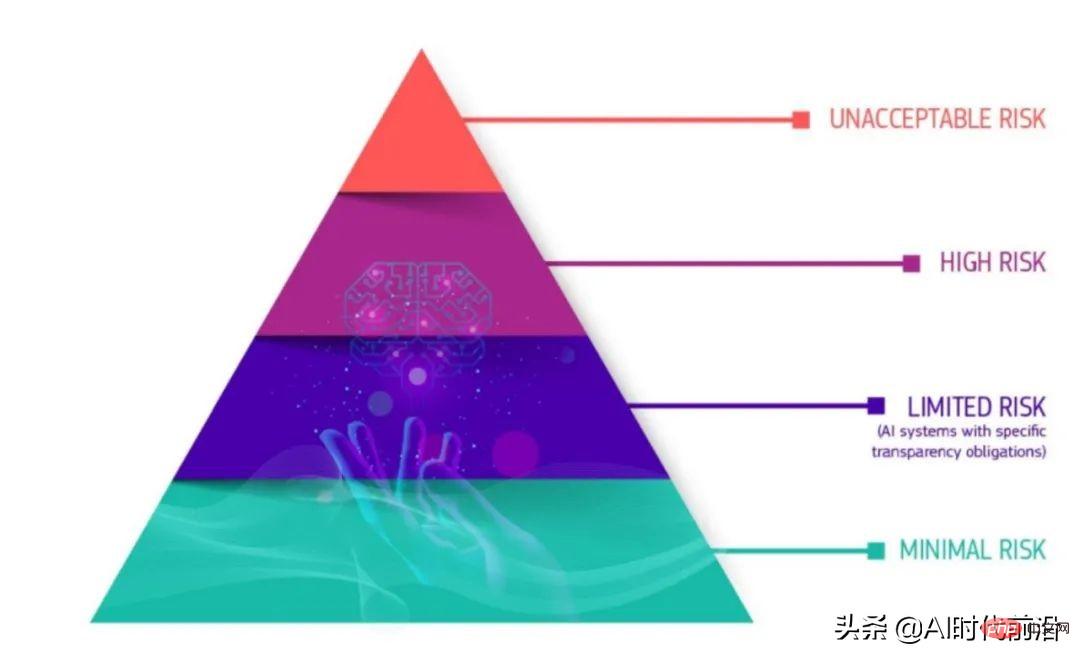

新しい法律の多くの詳細はまだ宙に浮いているが、鍵となるのは人工知能の定義だが、中核となる要素は将来のAI製品を4つのセキュリティレベルに分ける「製品セキュリティフレームワーク」とみられる。カテゴリ、あらゆる業界に適用可能。

スタンフォード・ウィーン大西洋横断技術法フォーラムのマルリッツ・コップ氏がまとめた新法に関する2021年の欧州委員会報告書によると、「臨界度ピラミッド」の最下位が最もリスクの低いシステムだという。このカテゴリに分類される AI アプリケーションは、リスクの高いシステムが通過する必要がある透明性要件に準拠する必要はありません。 「限定的リスク」のカテゴリーでは、チャットボットなどの AI システムに対する透明性要件がいくつかあります。

——欧州連合の新しい AI 法案では、AI プログラムを下から上に、低リスク、限定的リスク、高リスク、許容できないリスクの 4 つのカテゴリに分類しています。

透明性に対する厳格な要件がある高リスク AI カテゴリでは、監督がより厳格になります。序文によると、高リスクのカテゴリには、次のような AI アプリケーションが含まれます。 ##個人教育、キャリア達成のための教育や職業訓練に影響 (テストのスコアなど);

- 製品の安全コンポーネント (ロボット支援手術など);

- 雇用、従業員管理、自営業 (履歴書、履歴書分類ソフトウェアなど);

- 重要な民間および公共サービス (信用スコアリングなど);

- 法執行機関の使用例 (証拠評価など);

- 入国管理、国境管理 (パスポートの真正性評価を含む);

- 公正かつ民主的なプロセス (特定の事実セットに対する法律の適用など);

- 監視システム (たとえば、生体認証監視と顔認識)。

- 塔の最上部にある 4 番目のカテゴリは、「許容できないリスク」を伴う人工知能システムです。これらのアプリはリスクが多すぎるため、基本的に違法です。このようなアプリケーションの例には、行動や人々、または「特に脆弱なグループ」を操作するシステム、ソーシャル スコアリング、リアルタイムおよびリモートの生体認証システムなどがあります。

- 高リスクのカテゴリは、透明性とコンプライアンスを確保するための多くの企業の取り組みの焦点となる可能性があります。 EUの人工知能法案は、高リスクのカテゴリーに分類されるAI製品やサービスを発売する前に4つのステップを踏むよう企業に勧告する。

包括的で学際的なチームが監督する AI 影響評価と行動規範を使用して、できれば最初は社内で高リスク AI システムを開発します。

高リスクの人工知能システムは、適合性評価と承認を受け、ライフサイクル全体を通じて EU AI 法の要件に準拠し続ける必要があります。システム外部の一部の組織が適合性評価監査に関与する場合があります。この動的なプロセスにより、ベンチマーク、モニタリング、検証が保証されます。さらに、高リスク AI の動的システムの場合は、ステップ 2 を繰り返す必要があります。

- 独立した高リスク AI システムの登録は、専用の EU データベースで行われます。

- 適合宣言書に署名し、高リスク AI システムには CE マークを付ける必要があります。

以上が欧州の人工知能法案が間もなく提出され、世界の技術規制に影響を与える可能性があるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。