基本的に、上記の 3 つの機能は大規模な事前トレーニングから得られます。つまり、3,000 億語のコーパス (トレーニング コーパスの 60%) 上で 1,750 億個のパラメータを持つモデルを事前トレーニングします。 2016 年から 2019 年にかけて、C4 の 22% は WebText2 から来ており、16% は Books から来ており、3% は Wikipedia から来ています)。で:######

- 言語生成の能力は、言語モデリング (言語モデリング) のトレーニング目標から得られます。

- 世界の知識は、3,000 億語のトレーニング コーパスから得られます (他に存在する可能性はありません)。

- モデルの 1,750 億個のパラメーターは知識を保存するためのものであり、これは Liang et al. (2022) の論文によってさらに証明されています。彼らは、知識集約型タスクのパフォーマンスはモデルのサイズに密接に関係していると結論付けました。

- 文脈学習能力の源と、文脈学習が一般化できる理由を追跡することは依然として困難です。直感的には、この機能は、トレーニング中に同じバッチ内に連続して配置される同じタスクからのデータ ポイントから得られる可能性があります。しかし、なぜ言語モデルの事前トレーニングが文脈学習を促すのか、また文脈学習が微調整とは大きく異なる動作をする理由については、ほとんど研究が行われていません。

気になるのは初代GPT-3の強さです。

実際には、オリジナルの GPT-3 (OpenAI API では davinci と呼ばれます) が「強い」のか「弱い」のかを判断するのは困難です。

一方で、特定のクエリに合理的に応答し、多くのデータセットで適切なパフォーマンスを達成します;

一方では、多くのタスクでは、T5 のような小型モデルよりもパフォーマンスが悪くなります (元の論文を参照)。

今日 (2022 年 12 月) の ChatGPT 標準では、第 1 世代の GPT-3 が「インテリジェント」であると言うのは困難です。 Meta のオープンソース OPT モデルは、オリジナルの GPT-3 を複製しようとしていますが、その機能は今日の標準とは著しく対照的です。 OPT をテストした多くの人も、現在の text-davinci-002 と比較すると、このモデルは確かに「それほど良くない」と考えています。

それにもかかわらず、OPT は、オリジナルの GPT-3 を近似したオープンソースとして十分に優れたものである可能性があります (OPT の論文とスタンフォード大学の HELM 評価によると)。

第一世代 GPT-3 は一見弱いように見えますが、その後の実験により、第一世代 GPT-3 には非常に強力な可能性があることが証明されました。これらの可能性は、後にコード トレーニング、命令チューニング、ヒューマン フィードバックによる強化学習 (RLHF) によって解き放たれ、最終的な本体は非常に強力な創発機能を実証しました。

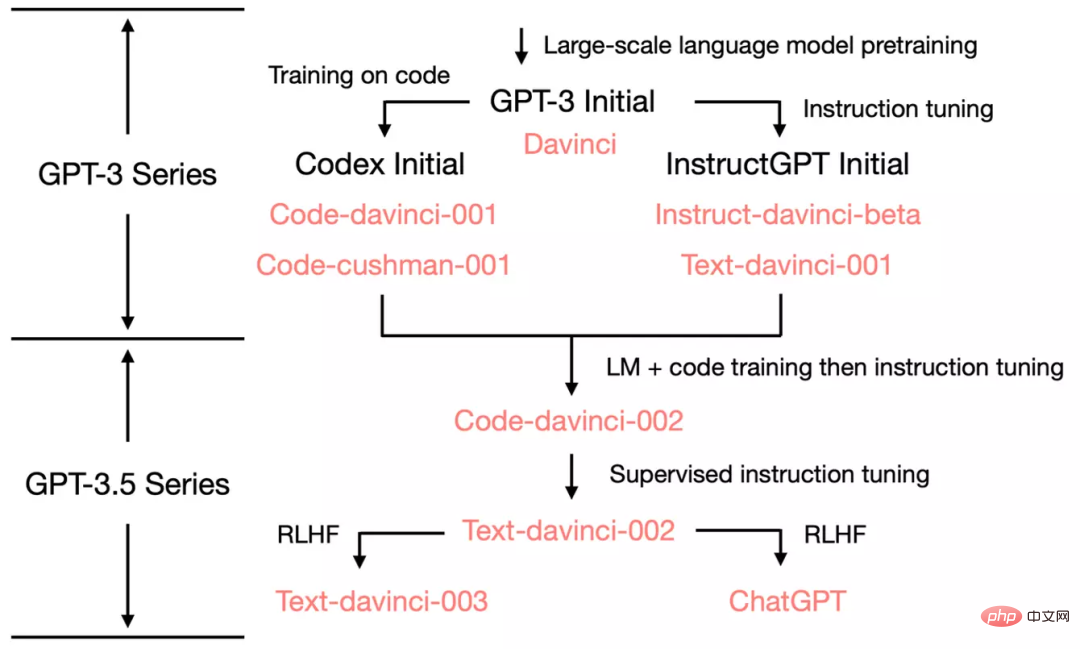

2. GPT-3 の 2020 バージョンから ChatGPT の 2022 バージョンへ

OpenAI がどのように発展したかを示すために、オリジナルの GPT-3 から始めます。 ChatGPT を見てみましょう GPT-3.5 の進化ツリーを見てみましょう:

2020 年 7 月に、OpenAI は davinci の第一世代 GPT をリリースしました。 -3紙のモデルインデックスを搭載して以来、進化を続けています。

2021 年 7 月に、Codex 論文がリリースされました。この論文では、初期の Codex が (おそらく内部の) 120 億パラメータの GPT-3 バリアントに基づいて微調整されました。この 120 億パラメータ モデルは、後に OpenAI API の code-cushman-001 に進化しました。

2022 年 3 月に、OpenAI は命令チューニングに関する論文をリリースしました。その教師あり命令チューニング部分は、davinci-instruct-beta および text-davinci-001 に対応します。

2022 年 4 月から 7 月にかけて、OpenAI は Code-davinci-002 モデル (Codex とも呼ばれる) のベータ テストを開始しました。次に、code-davinci-002、text-davinci-003、および ChatGPT はすべて、code-davinci-002 からの命令を微調整することによって取得されます。詳細については、OpenAI のモデル インデックスのドキュメントを参照してください。

Codex はコードのみのモデルのように聞こえますが、code-davinci-002 はおそらく自然言語にとって最も強力な GPT-3.5 バリアントです (text-davinci-002 および -003 よりも優れています)。 )。 code-davinci-002 はテキストとコードの両方でトレーニングされ、指示 (以下で説明) に基づいて適応された可能性があります。

次に、2022 年 5 月から 6 月にリリースされた text-davinci-002 は、code-davinci-002 に基づいた教師あり命令調整モデルです。 text-davinci-002 の命令を微調整すると、モデルのコンテキスト学習能力は低下する可能性がありますが、モデルのゼロショット能力は強化されます (後述)。

次に、2022 年 11 月にリリースされた text-davinci-003 と ChatGPT があり、これらはヒューマン フィードバックに基づく強化学習 (ヒューマン フィードバックからの強化学習による命令チューニング) モデルのバージョンです。2 つの異なるバリエーションです。

text-davinci-003 は、text-davinci-002 で失われた部分的なコンテキスト学習機能の一部を復元します (ただし、それでも code-davinci-002 より劣ります)。 (微調整中に言語モデリングが混合されました)、ゼロサンプル機能がさらに改善されました (RLHF のおかげで)。一方、ChatGPT は、会話履歴をモデル化する機能のために、ほぼすべてのコンテキスト学習機能を犠牲にしているようです。

全体として、code-davinci-002 より前の 2020 年から 2021 年にかけて、OpenAI はコード トレーニングと命令の微調整を通じて GPT-3 を強化することに多大な労力を投資してきました。 code-davinci-002 が完成するまでに、すべての機能がすでに備わっていました。その後の命令の微調整では、教師ありバージョンまたは強化学習バージョンのどちらを使用しても、次のことが行われる可能性があります (これについては後で詳しく説明します):

- 命令の微調整新しい機能 (既存のすべての機能) がモデルに挿入されます。コマンドナッジの役割は、これらの能力のロックを解除/アクティブ化することです。これは主に、命令微調整のデータ量が事前トレーニング データ量よりも数桁少ないためです (基本的な機能は事前トレーニングによって注入されます)。

- コマンドの微調整により、GPT-3.5 をさまざまなスキル ツリーに区別します。 text-davinci-003 のように文脈学習に優れたものもあれば、ChatGPT のように会話に優れたものもあります。

-

命令を微調整すると、人間による調整のためのパフォーマンスが犠牲になります。 OpenAI の作成者は、命令の微調整に関する論文の中でこれを「調整税」と呼んでいます。

多くの論文では、code-davinci-002 がベンチマークで最高のパフォーマンスを達成すると報告しています (ただし、モデルは必ずしも人間の期待と一致するとは限りません)。 code-davinci-002 の命令を微調整した後、モデルは、次のような、人間の期待により沿った (またはモデルが人間と一致した) フィードバックを生成できます。 ゼロサンプルの質問と回答、安全で公平なメッセージの生成対話応答、およびモデルの知識の範囲を超えた拒否が問題です。

3. Code-Davinci-002 と Text-Davinci-002、コードをトレーニングし、命令を微調整します

code-davinci- 002 text-davinci-002 より前には、davinci-instruct-beta と text-davinci-001 という 2 つの中間モデルがありました。どちらも上記の 2-002 モデルよりも多くの点で劣っています (たとえば、text-davinci-001 の連鎖思考推論能力は強力ではありません)。

そこで、このセクションでは -002 モデルに焦点を当てます。

3.1 複雑な推論能力と新しいタスクに一般化する能力の源

code-davinci-002 と text-davinci-002、この 2 つに焦点を当てます。兄弟は GPT3.5 モデルの最初のバージョンで、1 つはコード用、もう 1 つはテキスト用です。これらは、元の GPT-3 とは異なる 3 つの重要な機能を備えています:

- 人間のコマンドに応答します:以前の GPT-3 の出力は次のとおりでした。主にトレーニングセットの一般的な文。このモデルは、指示/手がかりの言葉に対して、(関連性はあるが役に立たない文ではなく) より合理的な回答を生成するようになりました。

- 目に見えないタスクへの一般化: モデルの調整に使用される命令の数が一定の規模を超えると、モデルはこれまでに見たことのないタスクを自動的に実行できます。新しいコマンドに対して有効な回答を生成することもできます。ユーザーは常に新しい質問をし、モデルはそれらに答えることができる必要があるため、この機能はオンライン展開にとって非常に重要です。

- コード生成とコード理解: モデルはコードでトレーニングされているため、この機能は明らかです。

- 複雑な推論に思考連鎖を使用する: 第一世代 GPT3 のモデルには、思考連鎖推論機能がほとんど、またはまったくありませんでした。 code-davinci-002 と text-davinci-002 は、十分に強力な思考連鎖推論機能を備えた 2 つのモデルです。

- #思考連鎖推論は、創発的な能力を解放し、スケーリングの法則を超越するための鍵となる可能性があるため、重要です。

これらの能力はどこから来たのでしょうか?

以前のモデルと比較した場合、主な違いは命令の微調整とコード トレーニングの 2 つです。具体的には: ######

- 人間のコマンドに応答する能力は、コマンドの微調整の直接的な成果です。

- 目に見えない命令に応答する一般化能力は、命令の数が一定のレベルを超えると自動的に現れます。T0、Flan、および FlanPaLM の論文はこれをさらに証明しています。

- #複雑な推論に思考連鎖を使用する能力は、コーディング トレーニングの魔法の副産物である可能性があります。 これに関して、いくつかの裏付けとして次の事実があります:

- 元の GPT-3 はコードを書くように訓練されておらず、思考することもできませんでした。鎖。

- text-davinci-001 モデルは、指示によって微調整されていますが、思考連鎖に関する論文の最初のバージョンでは、他の思考連鎖について推論する能力が非常に弱いと報告されています。 ——つまり、指示は微調整されています 思考連鎖が存在する理由ではないかもしれませんが、モデルが思考連鎖推論を実行できる最も可能性の高い理由はコード トレーニングです。

- PaLM には 5% のコード トレーニング データがあり、思考連鎖を行うことができます。

- Codex 論文のコードデータ量は 159G で、これは第 1 世代 GPT-3 の学習データ 5,700 億の約 28% に相当します。 code-davinci-002 とその後続の亜種は、思考連鎖推論を行うことができます。

- HELM テストでは、Liang et al. (2022) がさまざまなモデルの大規模評価を実施しました。彼らは、コードでトレーニングされたモデルが、120 億のパラメーター code-cushman-001 を含む強力な言語推論機能を備えていることを発見しました。

- AI2 に関する私たちの取り組みでは、複雑な思考連鎖を備えた場合、code-davinci-002 が現在、GSM8K などの重要な数学的ベンチマークで最高のパフォーマンスを発揮するモデルであることも示しています。

- 直観的には、手続き指向プログラミングは人間がタスクを段階的に解決するプロセスに非常に似ており、オブジェクト指向プログラミングは人間が複雑なタスクを段階的に解決するプロセスに似ています。単純なタスクに分割するプロセスも同様です。

- 上記の観察はすべて、コードと推論能力/思考連鎖の間の相関関係ですが、必ずしも因果関係があるわけではありません。この相関関係は興味深いものですが、現時点では研究すべき未解決の問題です。現時点では、コードが思考連鎖や複雑な推論の原因であるという決定的な証拠はありません。

-

さらに、ピーター・リュー氏が指摘したように、コード トレーニングのもう 1 つの副産物として考えられるのは、長距離依存関係です。「言語における次の単語の予測は通常、非常にローカルであり、コードは通常、長い依存関係では、左括弧と右括弧の一致や、離れた関数定義の参照などが行われます。 ここでさらに付け加えたいのは、オブジェクト指向プログラミングにおけるクラス継承により、コードはコーディング階層を確立するモデルの機能にも寄与する可能性があるということです。この仮説の検証は今後の作業に委ねます。

細部の違いにも注意してください:

- #text-davinci-002 は code-davinci-002 と同じです

##Code-davinci- 002 基本モデル text-davinci-002 は、命令微調整 code-davinci-002 の成果です (OpenAI ドキュメントを参照)。これは、次のデータに基づいて微調整されます: (1) 人間が注釈を付けた指示と期待される出力、(2) 人間のアノテーターが選択したモデル出力。

- 001 モデル (code-cushman-001 および text-davinci-001) vs. 002 モデル (code-davinci-002 および text-davinci-) 002)

001 モデルは主に純粋なコード/純粋なテキスト タスク用です。002 モデルは、コード トレーニングと命令の微調整、コードと任意の機能を深く統合します。テキストで十分です。

この段階で、命令の微調整とコード トレーニングの重要な役割を特定しました。重要な問題は、コードのトレーニングと命令の微調整の影響をさらに分析する方法です。

具体的には: 上記の 3 つの能力はオリジナルの GPT-3 にすでに存在しており、指示とコード トレーニングを通じてのみトリガー/ロック解除されますか?それとも、これらの機能はオリジナルの GPT-3 には存在せず、命令とコードのトレーニングによって導入されたのでしょうか?

答えがすでにオリジナルの GPT-3 にある場合、これらの機能も OPT にあるはずです。したがって、これらの機能を再現するには、命令とコードを通じて OPT を直接調整できる可能性があります。

ただし、code-davinci-002 はオリジナルの GPT-3 davinci に基づいておらず、オリジナルの GPT-3 よりも大きなモデルに基づいている可能性があります。この場合、OPT を調整しても再現できない可能性があります。

研究コミュニティは、OpenAI が code-davinci-002 のベース モデルとしてどのような種類のモデルをトレーニングしたのかをさらに明確にする必要があります。

次の仮説と証拠があります:- code-davinci-002 のベース モデルは、第一世代 GPT-3 davinci モデルではない可能性があります。

- 元の GPT-3 はデータセット C4 2016-2019 でトレーニングされましたが、code-davinci-002 トレーニング セットは 2021 まで拡張されました終わったばかりです。したがって、code-davinci-002 は 2019 ~ 2021 バージョンの C4 でトレーニングされている可能性があります。

- オリジナルの GPT-3 には 2048 ワードのコンテキスト ウィンドウがありました。 code-davinci-002 のコンテキスト ウィンドウは 8192 です。 GPT シリーズは絶対位置埋め込みを使用します。トレーニングなしで絶対位置埋め込みを直接外挿することは困難であり、モデルのパフォーマンスに重大な損害を与えます (Press et al., 2022 を参照)。 code-davinci-002 がオリジナルの GPT-3 に基づいている場合、OpenAI はコンテキスト ウィンドウをどのように拡張しますか?

- 一方、ベース モデルがオリジナルの GPT-3 であっても、後でトレーニングされたモデルであっても、指示に従う能力とゼロ-ショットの一般化は、ベース モデルにすでに存在しており、(挿入されるのではなく) コマンドの調整によって後でロック解除される可能性があります。

- これは主に、OpenAI の論文で報告されている命令データのサイズがわずか 77K であり、以前のデータよりも数桁小さいためです。 -トレーニングデータ。

- 他の命令微調整に関する論文では、データ セット サイズがモデルのパフォーマンスに及ぼすコントラストをさらに証明しています。たとえば、Chung et al. (2022) の研究では、命令微調整Flan-PaLM の は事前トレーニングのみであり、0.4% と計算されます。一般に、指導データはトレーニング前のデータよりも大幅に少なくなります。

- # ただし、モデルの複雑な推論機能は、トレーニング前の段階でコード データの挿入を通じて行われる場合があります。

- #コード データ セットのサイズは、上記の命令微調整の場合とは異なります。ここでのコード データの量は、トレーニング データのかなりの部分を占めるのに十分な量です (たとえば、PaLM にはコード トレーニング データの 8% があります)

- 前述のように、コードの前に-davinci-002 モデル text-davinci-001 は、おそらくコード データで微調整されていないため、思考チェーンの論文の最初のバージョンで報告されているように、推論/思考チェーンの機能が非常に貧弱で、場合によっては、パラメータ サイズ code-cushman-001 悪くありません。

- おそらく、コード トレーニングと命令の微調整の効果を区別する最良の方法は、code-cushman-001、T5、および FlanT5 を比較することです。 。

- 両者は同様のモデル サイズ (110 億と 120 億) と同様のトレーニング データ セット (C4) を持っているため、最大の違いはトレーニングしたかどうかです。コードについて/命令の微調整は行いましたか?

- 現時点ではそのような比較はありません。これについては今後の研究に委ねます。

4. text-davinci-003 と ChatGPT、ヒューマン フィードバックからの強化学習 (RLHF) の力

は現在段階中 (2022 年 12 月)、 text-davinci-002、text-davinci-003、ChatGPT の間には厳密な統計的比較はほとんどありません。主な理由は次のとおりです。

#text-davinci-003 と ChatGPT が以下より小さい執筆時点で生後1か月。

したがって、これらのモデル間の比較は、研究コミュニティの集合的な経験に基づいています (統計的にはそれほど厳密ではありません)。しかし、私たちは、予備的な記述的比較によってモデルのメカニズムを解明できると信じています。

最初に、text-davinci-002、text-davinci-003、ChatGPT 間の次の比較に注目します。

3 つすべてモデルはコマンドに応じて微調整されています。

これは、ほとんどの新しいモデルの動作が RLHF の影響によるものであることを意味します。 それでは、RLHF トリガーの機能を見てみましょう:

- 有益な回答: text-davinci-003 の生成は通常、 text-davinci-002 長いです。 ChatGPT の応答はより長いため、より簡潔な応答を得るには、ユーザーは明示的に「一文で答えてください」と尋ねる必要があります。これは RLHF から直接派生したものです。

- 公正な応答: ChatGPT は通常、政治的な出来事など、複数の主体の利益が関係する出来事に対して、非常にバランスのとれた回答を返します。こちらもRLHFの製品です。

- 不適切な拒否の問題: これは、コンテンツ フィルターと、RLHF によってトリガーされるモデル自体の機能の組み合わせであり、フィルターは一部をフィルターしてからモデルを除外します。一部を拒否します。

- 知識の範囲外の質問を拒否します: たとえば、2021 年 6 月以降に発生した新しいイベントを拒否します (それ以降はデータに含まれないため)。訓練を受けています)。これは RLHF の最も驚くべき部分で、どの問題が知識の範囲内にあり、どの問題が知識の範囲外であるかをモデルが暗黙的に区別できるようになります。

注目に値する 2 つの点があります:

- すべての機能はモデルに固有のものであり、RLHF 経由で注入されるものではありません。 RLHF が行うことは、新たな能力をトリガー/アンロックすることです。この議論は主にデータ サイズの比較から来ています。事前トレーニングされたデータの量と比較して、RLHF が消費する計算能力/データははるかに少なくなります。

- モデルは、ルールを記述することによってではなく、RLHF を通じてロックを解除することによって、何がわからないかを知っています。 RLHF の本来の目的は人間の期待を複雑にする応答をモデルに生成させることであり、モデルが何を知らないかをモデルに知らせることよりも、モデルに安全な文を生成させることであったため、これは非常に驚くべき発見です。

舞台裏で何が起こっているのか:

- ChatGPT: コンテキストを学習する能力を犠牲にして、会話履歴をモデル化する能力。 ChatGPT は text-davinci-003 ほどコンテキスト プレゼンテーションの影響を強く受けないようであるため、これは経験的な観察です。

- text-davinci-003: text-davinci-002 によって犠牲になったコンテキスト学習能力を回復し、ゼロサンプル能力を向上させます。 instructGPT の論文によると、これは (RLHF 自体ではなく) 言語モデリングの目的と混合された強化学習の調整段階から来ています。

5. 現段階での GPT-3.5 の進化プロセスの概要

これまでのところ、私たちは GPT-3.5 で登場したすべての機能を注意深く検討してきました。次の表は、進化の経路をまとめたものです:

結論は次のとおりです:

- 言語生成能力、基本的な世界知識、文脈学習はすべて事前トレーニング (davinci) から得られます。

- 大量の知識を保存できる機能は、1,750 億個のパラメーターによってもたらされます。

- 指示に従い、新しいタスクに一般化する能力は、指示学習 (Davinci-instruct-beta) の指示の数を増やすことで得られます。

- 複雑な推論を実行する能力は、コード トレーニング (code-davinci-002) によって得られると考えられます。

- 中立的、客観的、安全で有益な回答を生成する能力は、人間との調整から生まれます。具体的には:

- 教師あり学習バージョンの場合、結果のモデルは text-davinci-002 になります。

- 強化学習版(RLHF)の場合、取得されるモデルはtext-davinci-003となります。

- 教師ありであろうと RLHF であろうと、モデルのパフォーマンスは多くのタスクで code-davinci-002 を超えることはできません。このアライメントによるパフォーマンス低下の現象は、アライメント タックスと呼ばれます。

- #対話能力も RLHF (ChatGPT) から来ています。具体的には、次のことと引き換えにコンテキスト学習の能力が犠牲になります。

# モデルの会話履歴。

-

ダイアログの情報量を増やします。

-

モデルの知識の範囲外の質問は拒否してください。

-

6. GPT-3.5 で現在できないこと

GPT-3.5 は自然言語処理研究における重要なステップですが、すべてが完全に含まれているわけではありません。多くの研究者 (AI2 を含む) によって想定されている望ましい特性。 GPT-3.5 にはない重要なプロパティをいくつか以下に示します:

-

モデルの信念をリアルタイムで書き換えます: モデルが何かについての信念を表現するとき、その信念が間違っている場合、それを修正するのに苦労する可能性があります:

- 私が最近遭遇した例は次のとおりです。ChatGPT は、3599 = 59 * 61 を認めているにもかかわらず、3599 が素数であると主張します。また、この Reddit の最も速く泳ぐ海洋哺乳類の例もご覧ください。

- ただし、モデルの信念にはさまざまなレベルの強さがあるようです。一例として、ダース・ベイダー (スター・ウォーズ映画のキャラクター) が 2020 年の選挙で勝ったと伝えたとしても、モデルは依然として現在の米国大統領がバイデンであると考えるでしょう。しかし、選挙の年を 2024 年に変更すると、大統領はダース・ベイダーであり、2026 年に大統領になると考えられます。

-

形式推論: GPT-3.5 シリーズは、数学や一次論理などの厳密に形式的なシステムでは推論できません:

- #自然言語処理の文献では、「推論」という言葉の定義が明確でないことがよくあります。しかし、曖昧さの観点から見てみると、たとえば、いくつかの質問は (a) 非常に曖昧で根拠がありません; (b) 多少の論理はありますが、場所によっては曖昧である可能性もあります; ( c) 非常に厳密であり、曖昧さがあってはなりません。

- その後、モデルは (b) あいまいさのあるタイプの推論をうまく実行できます。例は次のとおりです:

- Generate豆腐麺の作り方。豆腐パフを作るときは、塩味にするか甘くするかなど、多少曖昧な工程が多くても大丈夫です。全体的な手順がおおよそ正しければ、豆腐は食べられます。

- 数学の定理を証明するためのアイデア。証明のアイデアは言語で表現された非公式な段階的な解決策であり、各ステップの厳密な導出はあまり具体的である必要はありません。証明のアイデアは数学の指導でよく使用されます。教師が全体的な手順を大まかに正確に示している限り、生徒はそれを大まかに理解できます。そして教師は特定の証明の詳細を生徒に宿題として課し、答えは省略されます。

- GPT-3.5 タイプ (c) の推論は不可能です (推論は曖昧さを許容できません)。

- #例は厳密な数学的証明であり、中間ステップをスキップしたり、ぼやけたり、間違ったりすることができないことが必要です。

- しかし、この種の厳密な推論を言語モデルによって行うべきか、それとも記号システムによって行うべきかについては、まだ議論の余地があります。一例として、GPT に 3 桁の加算を実行させる代わりに、Python を呼び出すだけです。

- インターネットからの検索: GPT-3.5 シリーズは (一時的に) インターネットを直接検索できません。

- #しかし、2021 年 12 月に公開された WebGPT 論文があり、GPT が検索エンジンを呼び出すことができるようになりました。そのため、検索機能は OpenAI 内でテストされました。

- ここで区別する必要がある点は、GPT-3.5 の 2 つの重要だが異なる機能は知識と推論であるということです。一般的に言えば、知識部分を外部の検索システムにオフロードして、言語モデルが推論のみに焦点を当てられるようにできれば素晴らしいでしょう。

- #モデルの内部知識は、常にある時点で遮断されるからです。モデルには、最新の質問に答えるために常に最新の知識が必要です。

- 1,750 億のパラメータが知識を保存するために頻繁に使用されていることを説明したことを思い出してください。知識をモデルの外にオフロードできれば、モデルのパラメーターを大幅に削減でき、最終的には携帯電話でも実行できるようになります (突飛なアイデアですが、ChatGPT は十分に SF です。将来がどうなるかは誰にも分かりません)。

7. 結論

このブログ投稿では、GPT-3.5 シリーズのさまざまな機能を注意深く調査し、そのすべての新機能の起源を追跡しました。能力のソース。

元の GPT-3 モデルは、事前トレーニングを通じて生成機能、世界の知識、コンテキスト内学習を獲得しました。その後、命令チューニングのモデル ブランチを通じて、命令に従い、目に見えないタスクに一般化する能力を獲得しました。コードによってトレーニングされたブランチ モデルはコードを理解する能力を獲得し、コード トレーニングの副産物として、モデルは潜在的に複雑な推論を実行する能力も獲得します。

これら 2 つのブランチを組み合わせると、code-davinci-002 は、すべての優れた機能を備えた最強の GPT-3.5 モデルのように見えます。次に、教師あり命令チューニングと RLHF を通じて、人間による調整、つまり調整税と引き換えにモデルの機能が犠牲になります。 RLHF を使用すると、モデルは知識範囲外の質問を拒否しながら、より有益で偏りのない回答を生成できます。

この記事が GPT 評価の明確な全体像を提供し、言語モデル、命令チューニング、コード チューニングに関する議論のきっかけになれば幸いです。最も重要なことは、この記事がオープンソース コミュニティ内で GPT-3.5 を再現するためのロードマップとして機能することを願っています。

FAQ

- この記事の記述は仮説に近いものですか、それとも結論に近いものですか?

- #コード トレーニングから複雑な推論を行う能力は、私たちが信じがちな思い込みです。

- 目に見えないタスクを一般化する能力は大規模な指導学習から得られる、というのが少なくとも 4 つの論文の結論です。

- GPT-3.5 は 1,750 億パラメータの GPT-3 ではなく、他の大規模な基本モデルに由来しているというのが経験に基づいた推測です。

- これらの機能はすべてすでに存在しており、教師あり学習であろうと強化学習であろうと、これらの機能を注入するのではなく、命令のチューニングを通じてこれらの機能を解放することが強く想定されています。それ。その主な理由は、命令チューニング データの量が事前トレーニング データの量よりも数桁少ないためです。

- 結論 = これらの主張の正当性を裏付ける多くの証拠; 仮説 = 肯定的な証拠だが十分強力ではない; 経験に基づいた推測 = 確かな証拠はないが、いくつかの要素はその方向を示している

- OPT や BLOOM などの他のモデルがそれほど強力ではないのはなぜですか?

- OPT はおそらくトレーニング プロセスが不安定すぎるためです。

- BLOOMの状況は不明です。