この会社は第 4 次産業革命を引き起こす可能性のある製品を製造していますが、なぜ自社の製品がこれほど人気があるのか困惑しています。

実際にはベルサイユではありません。

最近、MIT Technology Review は ChatGPT の開発者数名にインタビューし、この人気の AI 製品の背後にあるストーリーを詳しく調べました。

あまりにも暑いので、防御策がまったくありません

OpenAI が 2022 年 11 月下旬にひっそりと ChatGPT を立ち上げたとき、このスタートアップは大きな期待を持っていませんでした。

OpenAI の従業員は、自分たちのモデルが一流のモデルになるとは夢にも思っていませんでした。

ChatGPT は一夜にして大ヒットとなり、大規模言語モデルに対する世界的なゴールド ラッシュを引き起こしたかに見えましたが、OpenAI にはまったく準備ができておらず、急いで自分のトップに追いつくことしかできませんでした。フローモデルの足跡をたどり、ビジネスチャンスを掴んでみませんか。

OpenAI でポリシーに取り組む Sandhini Agarwal 氏は、OpenAI 内では ChatGPT は常に「研究プレビュー」、つまり 2 年前のテクノロジーのより完全なバージョンとみなされてきたと述べました。さらに、同社は公開フィードバックを通じてモデルの欠陥の一部を解決しようとしている。

このような「プレビュー」製品が、偶然のデビュー後に人気になるとは誰が予想したでしょうか。

この点に関して、OpenAI の科学者は非常に混乱しており、また、外の世界からの花や拍手についても非常に意識しています。

「これを根本的な大きな進歩として誇張したくありません」と、ChatGPT の開発に参加した OpenAI 科学者のリアム フェダス氏は述べています。

ChatGPT チーム メンバーのうち、5 名が 2023 年の AI 2000 グローバル人工知能奨学生に選ばれました

この目的を達成するために、MIT Technology Review 記者の Will Douglas Heaven が、OpenAI の共同創設者である John Schulman 氏、開発者の Agarwal 氏と Fedus 氏、そして調整チームのリーダーである Jan Leike 氏にインタビューしました。

ChatGPT がなぜこれほど人気があるのかさえ理解できません

創設者の John Schulman 氏は、ChatGPT がリリースされてから数日後に、ツイッターを閲覧してください。 Twitter フィードが ChatGPT のスクリーンショットで埋め尽くされるという異常な時期がありました。

彼は、これがユーザーにとって非常に直感的な製品であり、一部のファンが付くだろうと考えていましたが、これほど主流になるとは予想していませんでした。

Jan Leike 氏は、すべてが突然すぎて、誰もが驚き、ChatGPT の爆発的なペースについていくのに苦労したと述べました。人気急上昇の原動力は何かと興味津々だったが、裏で誰かがいるのだろうか?結局のところ、OpenAI 自体は ChatGPT がなぜこれほど人気があるのか理解できません。

## Liam Fedus 氏は、ChatGPT が最初の汎用チャットボットではないため、彼らがなぜそれほど驚いたかを説明しています。すでに試しているので、リアム・フェダスはチャンスは大きくないと考えている。しかし、プライベート ベータ版は彼に自信を与えました。おそらく、この A はユーザーに本当に気に入ってもらえるものであると考えています。

Sandhini Agarwal 氏は、ChatGPT の即座の成功は誰もが驚いたと結論付けました。これらのモデルに関しては多くの研究が行われてきたため、社外の一般の人々にとってそれらがどれほど素晴らしいものであるかを私たちは忘れてしまいます。

実際、ChatGPT 内のテクノロジーのほとんどは新しいものではありません。これは、ChatGPT の数か月前に OpenAI がリリースした GPT-3.5 の微調整バージョンです。 GPT-3.5自体は2020年に登場したGPT-3のアップデート版です。

ChatGPT チームは、これまでの 7 つの主要な技術研究開発に参加しています

Web サイトのOpenAI は、これらのモデルをアプリケーション プログラミング インターフェイスまたは API の形式で提供し、他の開発者はモデルを独自のコードに簡単に挿入できます。

2022 年 1 月、OpenAI は、GPT-3.5 の以前の微調整バージョンである InstructGPT もリリースしました。ただし、これらの技術は一般には宣伝されていません。

微調整プロセス

Liam Fedus の紹介によると、ChatGPT モデルは InstructGPT と同じ言語モデルから微調整されています。微調整を使用する方法も同様です。研究者らは会話データを追加し、トレーニング プロセスにいくつかの調整を加えました。したがって、彼らはこれを根本的な大きな進歩として誇張したくないのです。

ChatGPT で大きな役割を果たすのは会話データであることがわかりました。

標準的なベンチマークの評価によると、実際には両モデルの元々の技術力に大きな違いはありませんが、ChatGPT の最大の違いは入手と使用が容易であることです。 。

Jan Leike 氏は、ChatGPT は、ある意味、OpenAI が以前から持っていた AI システムのバージョンとして理解できると説明しました。 ChatGPT はそれ以上の能力はありません。 ChatGPT が登場する前に、同じ基本モデルが 1 年近く API で使用されていました。

研究者らの改善は、ある意味、人間がそれを使ってやりたいことにより沿ったものになると要約できます。ユーザーと会話し、チャット インターフェイスであり、簡単にアクセスできます。これにより、意図の推測が容易になり、ユーザーは目的を達成するために何度も実験することができます。

その秘密はヒューマン フィードバック強化学習 (RLHF) テクノロジーです。これは InstructGPT のトレーニング方法に非常によく似ており、人間のユーザーが実際に好むものを教えます。

Jan Leike 氏は、大勢の人々に ChatGPT のプロンプトと応答を読んでもらい、次に 2 つの応答から選択して、全員がどの応答がより良いと考えるかを確認するよう依頼したと述べました。次に、このすべてのデータが 1 つのトレーニング セッションに結合されます。

そのほとんどは、InstructGPT で行ったことと同じです。それが役立つことを願うように、それが真実であることを望むように、それが悪質でないことを望むように。

詳細もいくつかあります。たとえば、ユーザーのクエリが不明瞭な場合は、フォローアップの質問をしてクエリを絞り込む必要があります。また、それが人工知能システムであり、それが持っていないアイデンティティを仮定したり、持っていない機能があると主張したりすべきではないことも明確にする必要があります。ユーザーが、実行することを想定されていないタスクの実行を要求した場合、明示的に拒否する必要があります。

つまり、人間の評価者が信頼性など、モデルをランク付けするためのさまざまな基準のリストが存在します。しかし、AI が人間のふりをしないなど、特定の慣行を好むこともあります。

リリースの準備一般に、ChatGPT は OpenAI がすでに使用しているテクノロジーを使用しているため、このモデルを一般にリリースする準備をする際、チームは何も行いませんでした。なにか特別なもの。彼らの見解では、以前のモデルに設定された標準で十分であり、GPT-3.5 は十分に安全でした。

ChatGPT の人間の好みのトレーニングでは、拒否行動を自ら学習し、多くのリクエストを拒否しました。

OpenAI は、ChatGPT のために何人かの「シンガー」をセットアップしました。社内の全員が座って、モデルを打破しようとしました。外部のグループも同様の活動を行っています。信頼できる初期ユーザーもフィードバックを提供します。

Sandhini Agarwal 氏は、GPT-3.5 が望ましくない出力を生成することは確かにわかったと述べましたが、これらは GPT-3.5 も生成するものでした。したがって、リスクだけを見れば、ChatGPT は「研究プレビュー」としては十分です。

John Schulman 氏は、システムが 100% 完璧になるまで待ってからリリースすることは不可能とも述べています。彼らは数か月間初期バージョンのベータ テストを行っており、ベータ テスターは ChatGPT に非常に感銘を受けています。

ChatGPT は物事を捏造するのが好きすぎるため、OpenAI が最も懸念しているのは実際には事実の問題です。しかし、これらの問題は InstructGPT やその他の大規模な言語モデルにも存在するため、研究者の目から見ると、事実性やその他のセキュリティ問題に関して ChatGPT がそれらのモデルよりも優れている限り、それで十分です。

リリース前の限定的な評価に基づいて、ChatGPT が他のモデルよりも現実的で安全であることが確認できたため、OpenAI はリリースを継続することを決定しました。

リリース後のフィードバック

ChatGPT のリリース後、OpenAI はユーザーがそれをどのように使用するかを観察してきました。

大規模な言語モデルが数千万人のユーザーの手に渡るのは史上初めてです。

ユーザーも夢中になって、ChatGPT の限界とバグがどこにあるのかをテストしたいと考えています。

ChaatGPT の人気により、バイアスの問題やプロンプトによって引き起こされる問題など、多くの問題も発生しています。

Jan Leike 氏は、Twitter で広まったもののいくつかは、実際には OpenAI によって静かに処理されていると述べました。

たとえば、脱獄の問題は間違いなく解決する必要があります。ユーザーは、紆余曲折を経てモデルに悪いことを言わせようとするのが好きですが、これは OpenAI の想定内であり、唯一の方法でもあります。

ジェイルブレイクが発見されると、OpenAI はこれらの条件をトレーニング データとテスト データに追加し、すべてのデータが将来のモデルに組み込まれます。

Jan Leike 氏は、より優れたモデルがあるたびに、それを取り出してテストしたくなると述べました。

彼らは、標的を絞った敵対的トレーニングによって脱獄の状況を大幅に改善できると非常に楽観的です。これらの問題が完全になくなるかどうかは不明ですが、多くの脱獄が困難になる可能性があると彼らは考えています。

システムが「正式にデビュー」するとき、実際に何が起こるかをすべて予測することは困難です。

そのため、ユーザーがシステムを何に使用しているかを監視し、何が起こったかを確認し、それに対応することだけに集中できます。

現在、Microsoft は Bing Chat を開始しました。多くの人は、これが OpenAI の未発表の公式 GPT-4 バージョンであると考えています。

この前提のもと、サンディニ・アガルワル氏は、彼らが現在直面している状況は半年前よりも間違いなくはるかに高くなっているが、それでも1年後のレベルよりは低いと述べた。

これらのモデルが使用されるコンテキストは非常に重要です。

Google や Microsoft のような大企業の場合、たとえ 1 つでも真実ではないことがあれば、それ自体が検索エンジンであるため、それは大きな問題になります。

Google の 23 人目の従業員で Gmail を設立した Paul Buchheit 氏は、Google について悲観的です。

検索エンジンの大規模な言語モデルとしての Google については、単なる遊びのためのチャットボットとはまったく異なります。 OpenAI の研究者はまた、さまざまな用途の間を移動して、ユーザーにとって本当に役立つものを作成する方法を見つけ出すために懸命に取り組んでいます。

John Schulman 氏は、OpenAI が ChatGPT の政治問題に対する人々の関心を過小評価していたことを認めました。この目的を達成するために、彼らはトレーニング データを収集する際に、この分野の問題を軽減するために、より適切な決定を下したいと考えています。

Jan Leike 氏は、彼自身の観点から、ChatGPT は失敗することが多いと述べました。解決すべき問題は山ほどありますが、OpenAI はそれらを解決していません。これについて彼は率直に認めた。

言語モデルはしばらく前から存在していますが、まだ初期段階にあります。

次に、OpenAI はさらに多くのことを行う必要があります。

以上が本当はベルサイユじゃないんです! ChatGPT は成功しすぎているが、OpenAI ですら理解できないの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

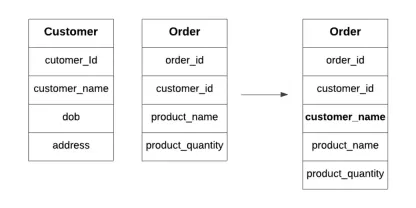

データベースの非正規化とは何ですか?Apr 12, 2025 am 11:10 AM

データベースの非正規化とは何ですか?Apr 12, 2025 am 11:10 AM導入 毎秒数が重要な忙しいカフェを走らせることを想像してみてください。個別の在庫リストと注文リストを常にチェックする代わりに、すべての重要な詳細を1つの読みやすいボードに統合します。これはデノマリザに似ています

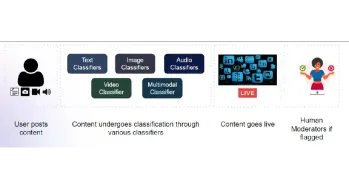

コンテンツモデレートのためのマルチモーダルモデルの構築Apr 12, 2025 am 10:51 AM

コンテンツモデレートのためのマルチモーダルモデルの構築Apr 12, 2025 am 10:51 AM導入 攻撃的な投稿がポップアップ表示されないときに、お気に入りのソーシャルメディアプラットフォームをスクロールしていると想像してください。レポートボタンを押す前に、それはなくなりました。それはコンテンツモデラティです

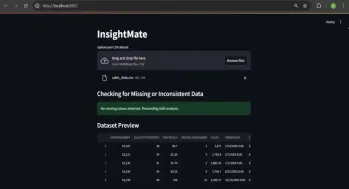

Insightmateでデータの洞察を自動化しますApr 12, 2025 am 10:44 AM

Insightmateでデータの洞察を自動化しますApr 12, 2025 am 10:44 AM導入 今日のデータが多い世界では、巨大なデータセットの処理はかなり圧倒される可能性があります。それが洞察客の出番です。それはあなたのデータを簡単にするように設計されています。データセットをアップロードするだけで、Instanが表示されます

ベクトルストリーミング:錆を使用したメモリ効率の高いインデックスApr 12, 2025 am 10:42 AM

ベクトルストリーミング:錆を使用したメモリ効率の高いインデックスApr 12, 2025 am 10:42 AM導入 埋め込みのベクトルストリーミングが導入されています。これは、大規模なドキュメントの埋め込みを最適化するように設計されています。 Rustの並行性を使用して非同期チャンクと埋め込みを可能にすると、メモリの使用が減少し、

レプリットエージェントとは何ですか? |入門ガイド - 分析VidhyaApr 12, 2025 am 10:40 AM

レプリットエージェントとは何ですか? |入門ガイド - 分析VidhyaApr 12, 2025 am 10:40 AM導入 会話と同じように簡単にアプリを開発することを想像してください。セットアップする複雑な開発環境はなく、構成ファイルを調べる必要はありません。コンセプトを貴重なアプリに変換する

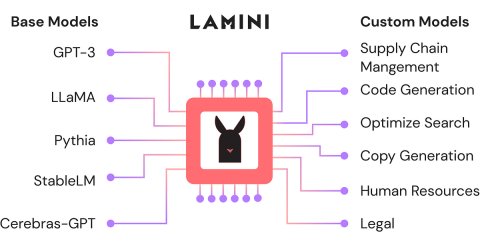

ラミニを使用してオープンソースLLMを微調整します。分析vidhyaApr 12, 2025 am 10:20 AM

ラミニを使用してオープンソースLLMを微調整します。分析vidhyaApr 12, 2025 am 10:20 AM最近、大規模な言語モデルとAIの台頭により、自然言語処理における無数の進歩が見られました。テキスト、コード、画像/ビデオ生成などのドメインのモデルは、人間のような推論とPをアーカイブしています

PythonのOpenCVとRoboflowによる性別検出-AnalyticsVidhyaApr 12, 2025 am 10:19 AM

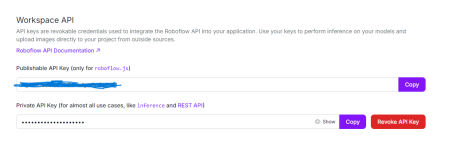

PythonのOpenCVとRoboflowによる性別検出-AnalyticsVidhyaApr 12, 2025 am 10:19 AM導入 顔の画像からの性別検出は、コンピュータービジョンの多くの魅力的なアプリケーションの1つです。このプロジェクトでは、OpenCVを対立する場所と性別分類のためにRoboflow APIを組み合わせて、

広告コンテンツのパーソナライズにおける生成AIの役割は何ですか?Apr 12, 2025 am 10:18 AM

広告コンテンツのパーソナライズにおける生成AIの役割は何ですか?Apr 12, 2025 am 10:18 AM導入 広告の世界は、物々交換システムの概念以来進化の下にありました。広告主は、製品を私たちの注意を引くための創造的な方法を見つけました。現在の年齢では、消費者はBRを期待しています

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

SecLists

SecLists は、セキュリティ テスターの究極の相棒です。これは、セキュリティ評価中に頻繁に使用されるさまざまな種類のリストを 1 か所にまとめたものです。 SecLists は、セキュリティ テスターが必要とする可能性のあるすべてのリストを便利に提供することで、セキュリティ テストをより効率的かつ生産的にするのに役立ちます。リストの種類には、ユーザー名、パスワード、URL、ファジング ペイロード、機密データ パターン、Web シェルなどが含まれます。テスターはこのリポジトリを新しいテスト マシンにプルするだけで、必要なあらゆる種類のリストにアクセスできるようになります。

DVWA

Damn Vulnerable Web App (DVWA) は、非常に脆弱な PHP/MySQL Web アプリケーションです。その主な目的は、セキュリティ専門家が法的環境でスキルとツールをテストするのに役立ち、Web 開発者が Web アプリケーションを保護するプロセスをより深く理解できるようにし、教師/生徒が教室環境で Web アプリケーションを教え/学習できるようにすることです。安全。 DVWA の目標は、シンプルでわかりやすいインターフェイスを通じて、さまざまな難易度で最も一般的な Web 脆弱性のいくつかを実践することです。このソフトウェアは、

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません