ホームページ >テクノロジー周辺機器 >AI >AI論文の「引用変換率の高さ」ランキングを発表:1位OpenAI、2位Megvii、9位Google

AI論文の「引用変換率の高さ」ランキングを発表:1位OpenAI、2位Megvii、9位Google

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-11 21:01:011836ブラウズ

この問題を明確にするために、アメリカのゼータ アルファ プラットフォームは、2020 年から 2022 年の間に世界で最も引用された AI 論文の上位 100 件を数えたところ、非常に興味深い結果が得られました。

例:

「人気スター」OpenAI は、最も多く引用された論文を持つ機関の中で 9 位にランクされています。

しかし、最も多くの論文を発表した機関のリストにはその名前はまったく見つかりません。

別の例として、業界の Google Meta と Microsoft は、あらゆるデータにおいて常に最高の地位を占めていますが、一般に、学術界が業界に遅れを取っているわけではありません。

さらに、「中国の AI 研究成果の量と質は米国を超える可能性がある」という以前の見解は、この報告書で覆されたようです -

さらに具体的なデータ, 一つずつ見ていきましょう。

中国が 2 位、OpenAI と DeepMind が品質で勝利

具体的な分析の前に、Zeta Alpha はまず、2020 年から 2022 年まで毎年最も引用された論文を数えました。それらは次のとおりです。

2022:

1. AlphaFold タンパク質構造データベース: 高精度モデルによるタンパク質配列空間の構造範囲の大幅な拡大

引用数: 1372

機関: DeepMind

トピック: AlphaFold を使用してタンパク質構造データベースの範囲を拡大する

2. ColabFold: タンパク質のフォールディングをすべての人が利用できるようにする

引用数: 1162

施設: 複数の共同研究によって完成

トピック: オープンソースの効率的なタンパク質フォールディング モデル

3. CLIP 潜在を使用した階層的テキスト条件付き画像生成

引用数: 718

機関: OpenAI

トピック: DALL·E 2

4、2020 年代の ConvNet

引用数: 690

機関: Meta および UC Berkeley

トピック: Transformer ブームにおける CNN の近代化の成功

5. PaLM: パスウェイによる言語モデリングのスケーリング

引用数: 452

機関: Google

トピック: Google の 540B の大規模言語モデル、新しい MLOps パラダイム、そのモデルを含む実装プロセス

2021

1. AlphaFoldによる高精度なタンパク質構造予測

引用数: 8965

機関: DeepMind

トピック: AlphaFold、巨大深層学習を使用したタンパク質構造予測のブレークスルー

2. Swin Transformer: Shifted Windows を使用した階層型ビジョン トランスフォーマー

引用数: 4810

機関: Microsoft

件名: ViT 強力なバリアント

3、自然言語監視から転送可能なビジュアル モデルを学習する

引用数: 3204

機関: OpenAI

トピック: CLIP

4、危険性について確率的オウムの数: 言語モデルは大きすぎる可能性がありますか?

引用数: 1266

機関: ワシントン DC、米国、AI の黒人、The Aether

トピック: 成長に関する有名な意見書言語モデルの傾向には批判的であり、その限界と危険性を強調してください

5. 自己教師ありビジョントランスフォーマーにおける新たな特性

引用数: 1219

機関: Meta

トピック: DINO、イメージの自己監視がトランスフォーマーにおけるある種のプロトオブジェクト セグメンテーションにどのようにつながるかを明らかに

2020:

1. 画像は 16x16 ワードの価値があります: 画像認識のためのトランスフォーマー規模

引用数: 11914

機関: Google

トピック: 通常の Transformer がコンピュータ ビジョンの分野でどのようにうまく機能するかを示した最初の研究

2. 言語モデルはフューショット学習者です

引用数: 8070

機関: OpenAI

トピック: GPT-3

3、YOLOv4: オブジェクト検出の最適な速度と精度

引用数: 8014

機関: 「中央研究院」、台湾、中国

トピック: YOLOv4

4、統一されたテキストからテキストへの変換による転移学習の限界の探索Text Transformer

引用数: 5906

機関: Google

主題: Transformer の転移学習の厳密な研究により、有名な T5

5、Bootstrap your own latent: A が生まれました。自己教師あり学習への新しいアプローチ

引用数: 2873

機関: DeepMind および Imperial College

トピック: 否定は表現学習に必要ではないことを示す

私はあなたを信じます「Familiar Faces」からたくさんのことを見つけることができます。

次に、ゼータ アルファは、過去 3 年間に引用度の高い論文の背後にある情報の分析を実施しました。

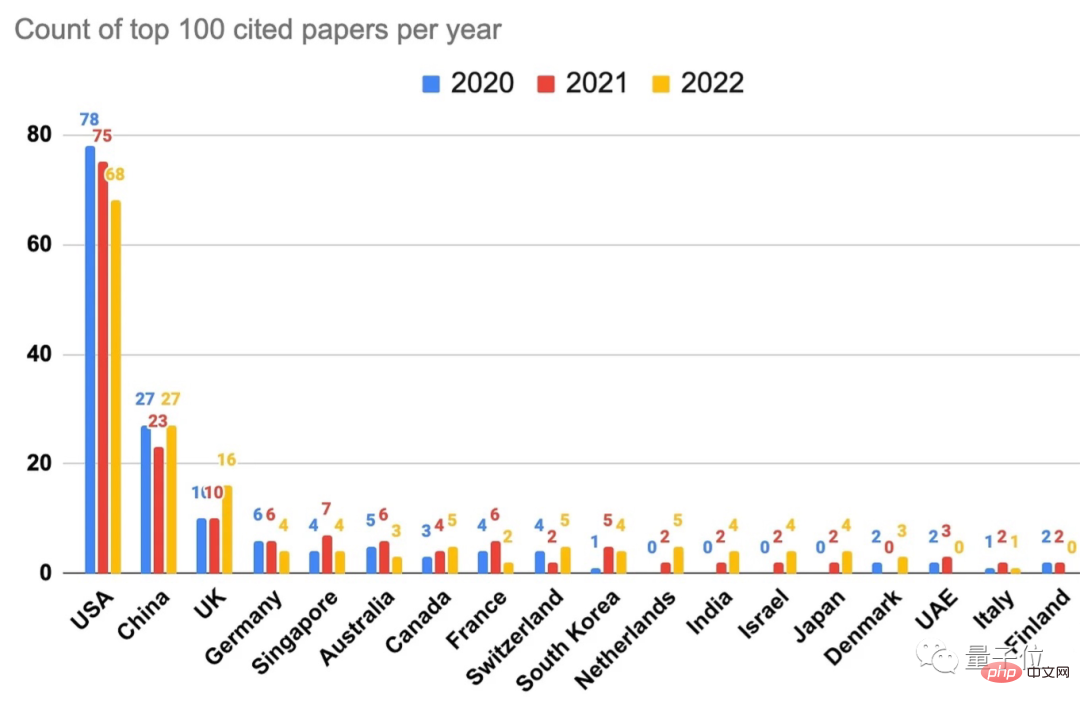

1つ目は、「毎年最も引用数の多い論文トップ100」の国(地域)です。

米国が最も強く、中国との差は比較的明らかであることがわかります。

したがって、ゼータ・アルファも、少なくともこのデータに基づいて、「中国はAI研究において米国を超えるかもしれない」という以前の発言は真実ではないと考えています。

さらに、シンガポールとオーストラリアのランキングもそれぞれ 5 位と 6 位で、まったく予想外でした。

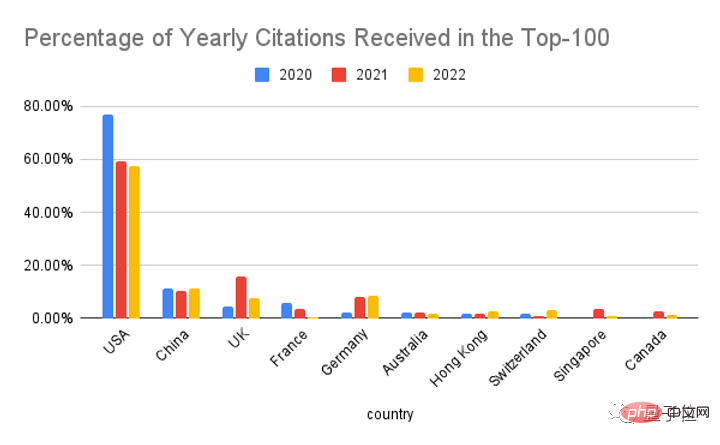

「米国の優位性を正しく評価するために」ゼータ アルファは別の統計手法を変更し、上位 100 件の引用の割合を計算しました。

# もちろん、米国は依然として 1 位ですが、過去 3 年間でそのシェアが低下していることがわかります。

英国は中国と米国を除けば最大の競争相手ですが、2022 年の英国の傑出した業績は、実際には主に DeepMind によるものでした (69% を占める)。

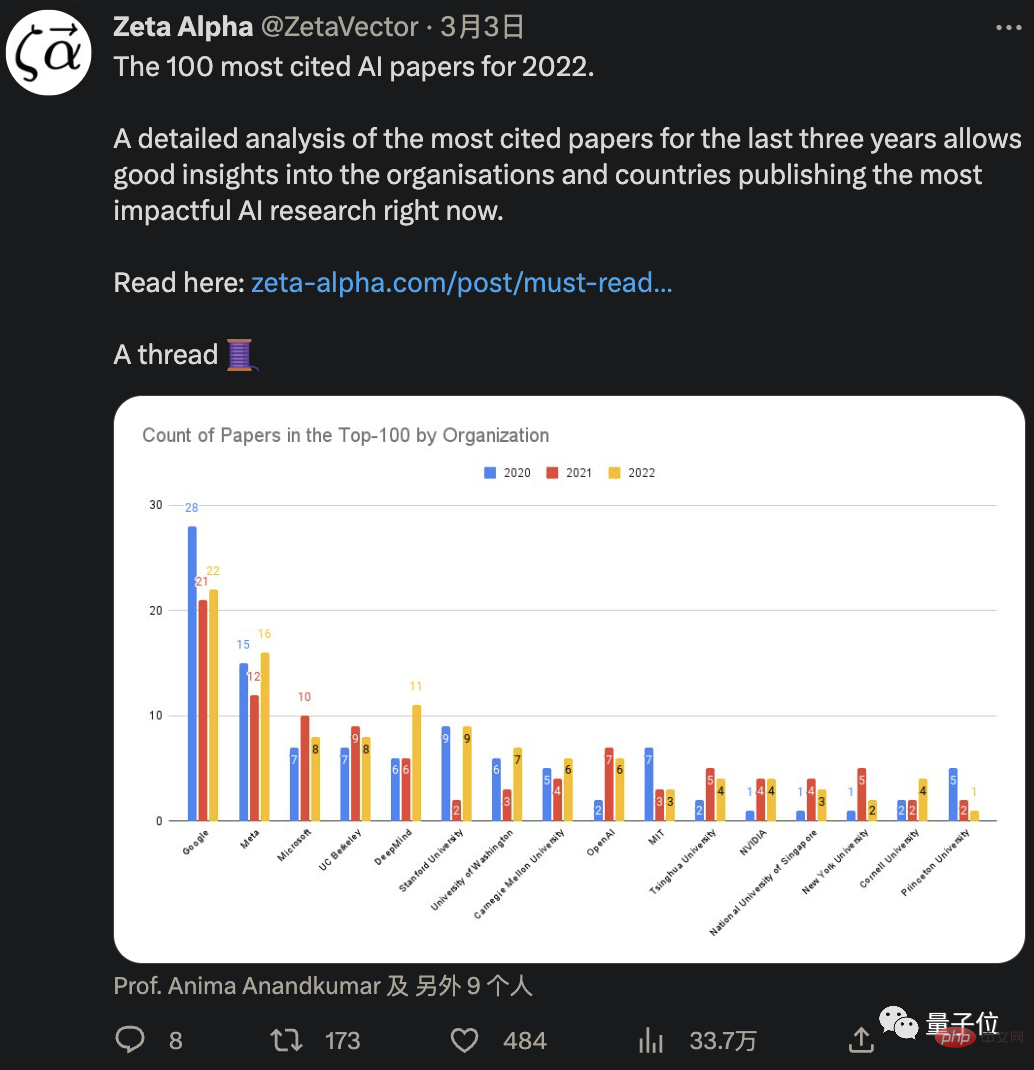

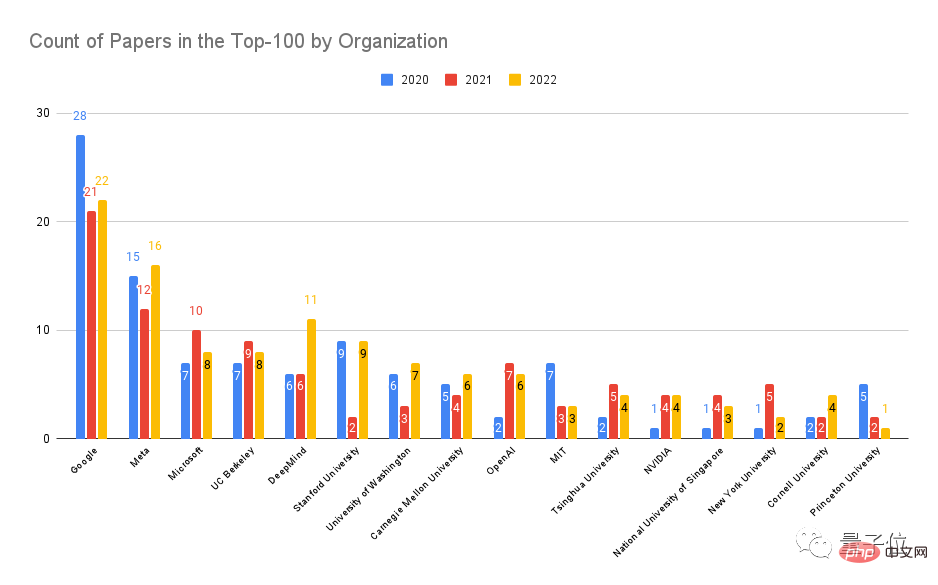

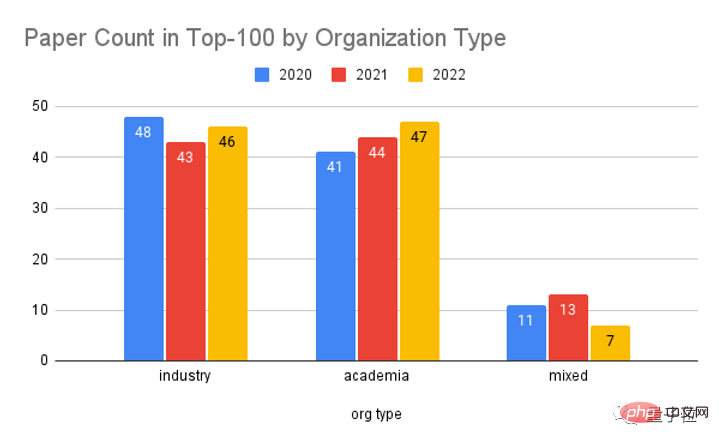

以下は、組織または機関ごとに最も多く引用された上位 100 人のランキングです。

当然のことながら、Google と Meta Microsoft がトップ 3 にランクされ、続いて UC Berkeley、DeepMind、Stanford が続きました。

OpenAI も 9 位とかなり良いランキングを獲得しました。 10位はMIT、11位は清華大学です。

トップ3の出場者はいずれも産業界の出身ですが、大学の種類だけで分けてみると、学術界の実績と実績はほぼ同じです。

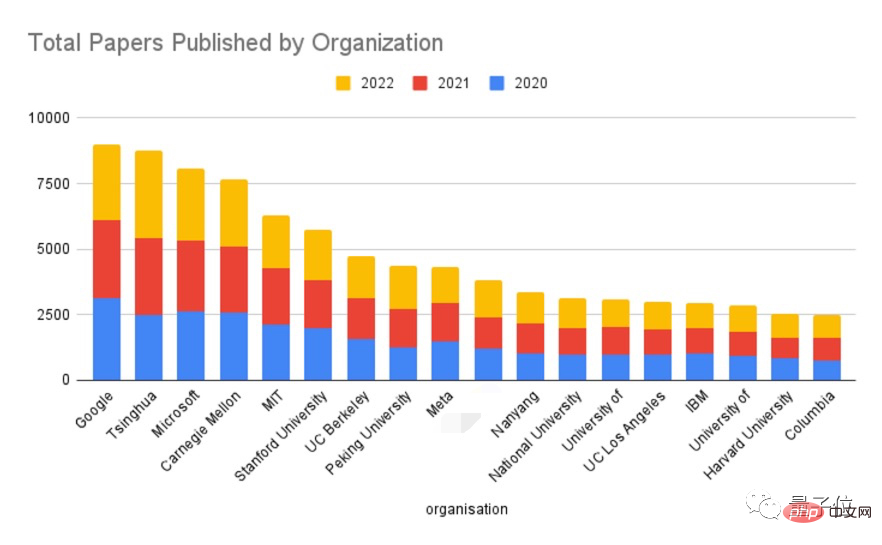

続いて、各組織または機関が過去 3 年間に発表した論文の総数のランキングが続きます。

上司は依然として Google です。 2位は清華大学であり、次にマイクロソフト、CMU、MIT、スタンフォード、カリフォルニア大学バークレー校、北京大学(8位)、メタ...

トップであることがわかります。 10 は学界に所属しており、国の広い範囲を占める機関や組織があります。

私たちは長い間検索しましたが、OpenAI と DeepMind の名前は見つかりませんでした -

明らかに、彼らは論文の数が少なく、主に品質に依存して勝っていました。

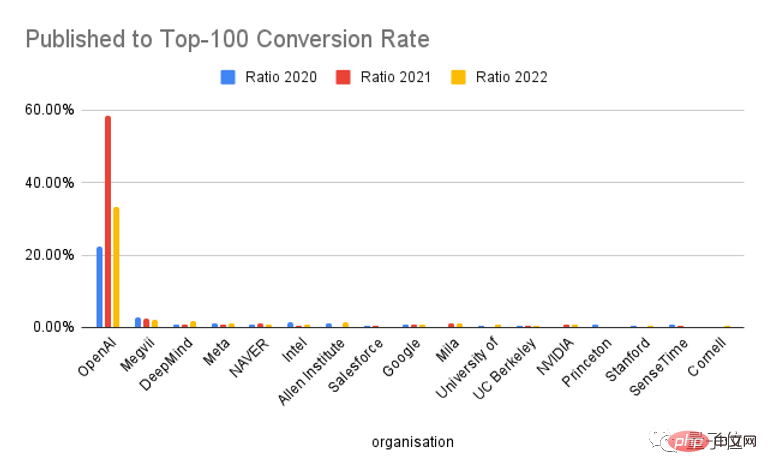

この推測を検証するために、Zeta Alpha は引用度の高い論文の変換率のランキングも作成しました。

予想通り、OpenAI が優勝し、DeepMind が 3 位になりました。

もちろん、Meta も良いです。第 4 に、LeCun も「名乗り出て発言する」ために出てきました:

私たち Meta は、量よりも質に本当に注意を払っています。

# 対照的に、引用数は多いものの出版数も多い Google は 9 位にとどまり、かろうじてトップ 10 圏外でした。

このほか、2位も注目です――メグヴィです。

や国内のSenseTimeもリストに載っています。

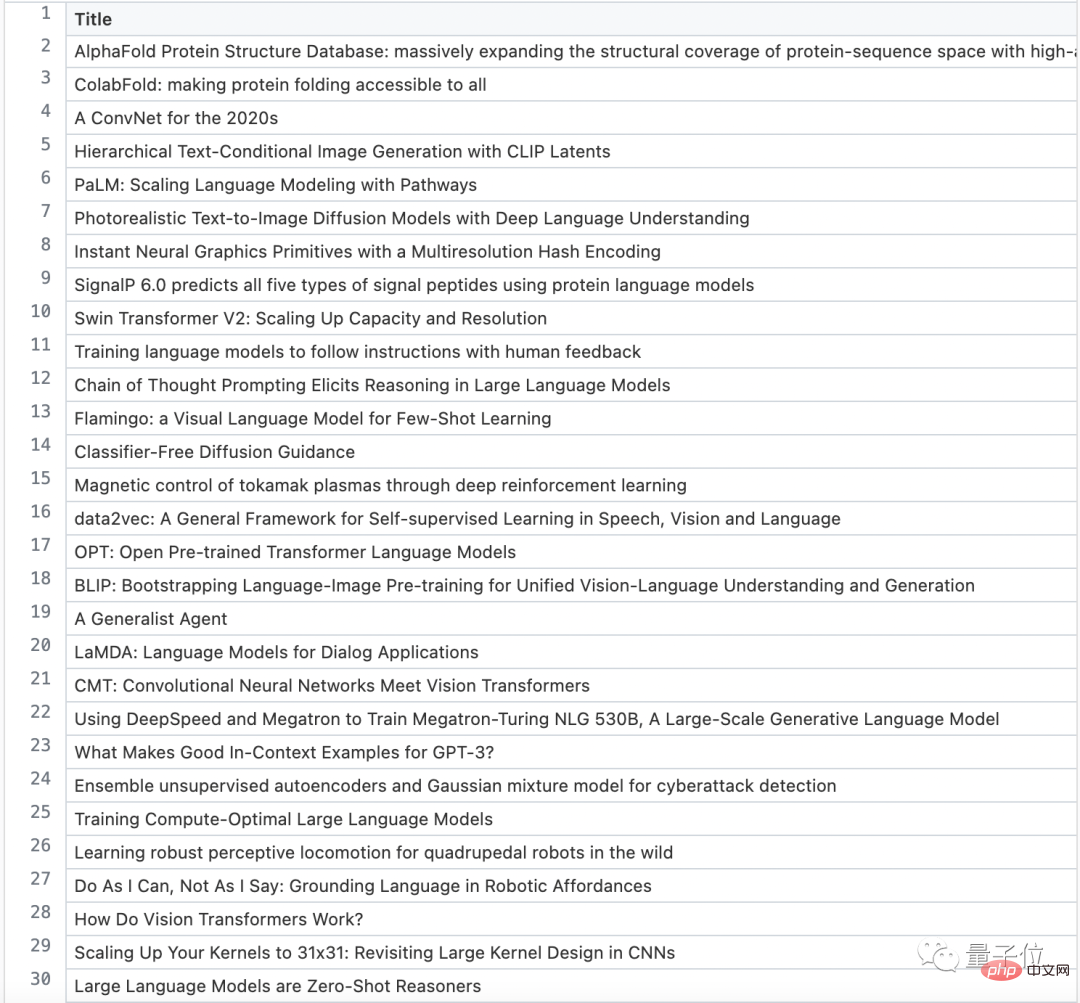

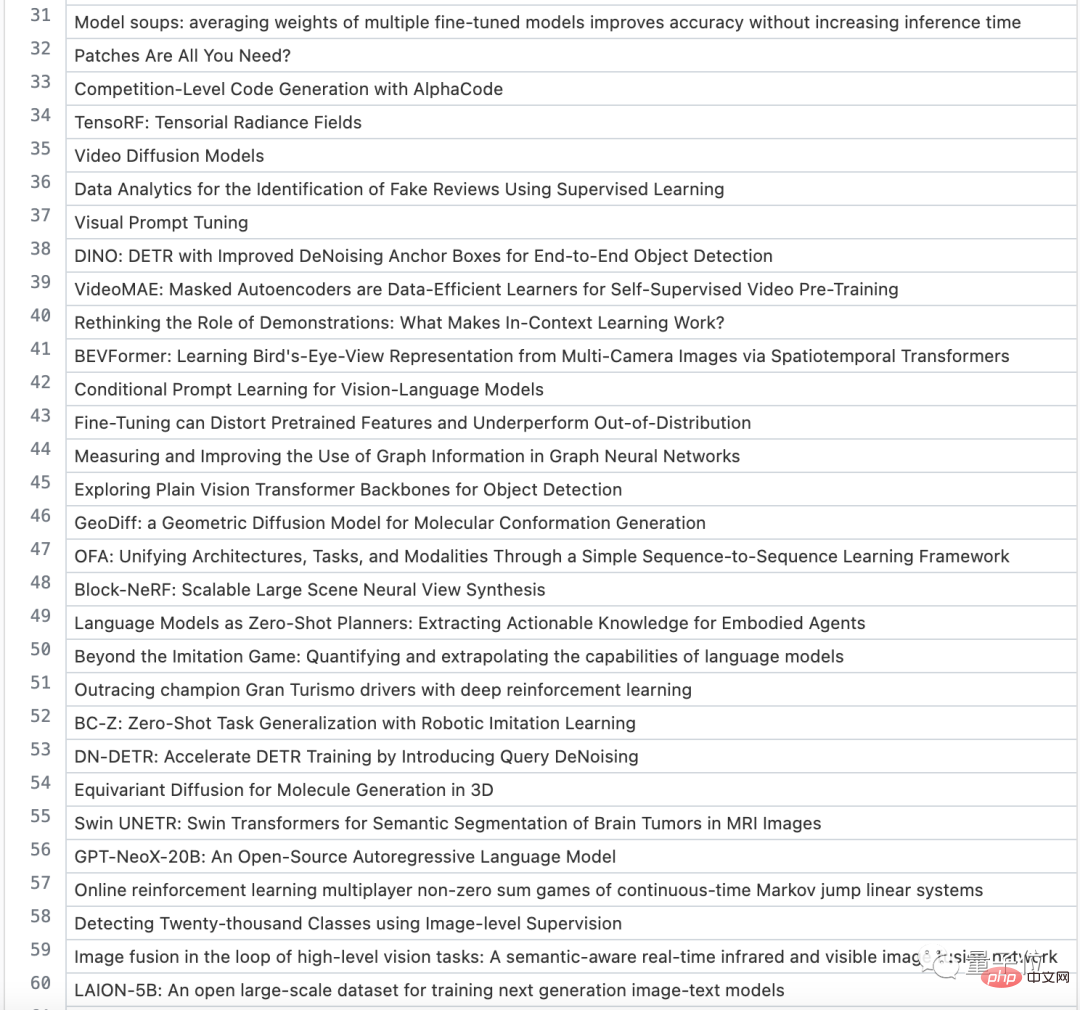

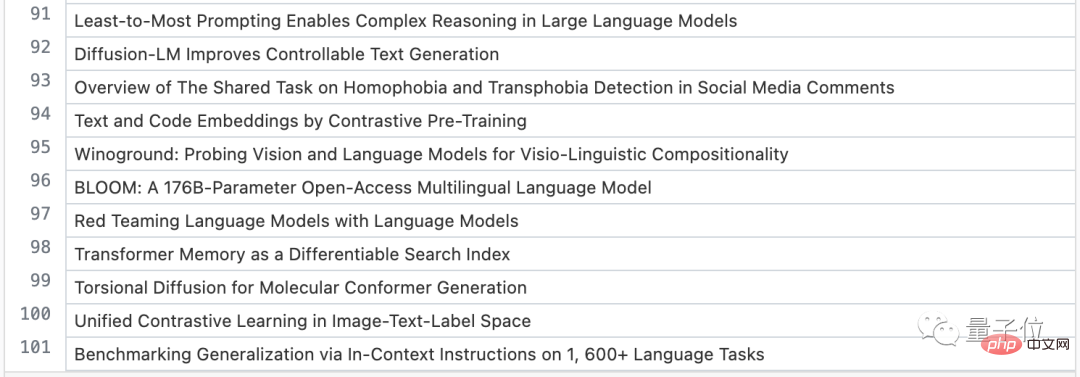

添付は、2022 年のトップ 100 引用文献の完全なリストです

ChatGPT の人気により、AI 業界は本当に活性化しています。最新の最先端研究はどのような方向に向かうのでしょうか?私たちもさらに注意深くなる必要があります。

この目的のために、Zeta Alpha は、2022 年のトップ 100 に引用されたすべての AI 論文のリストも提供しました。これは誰もがインスピレーションを与えるかもしれません。

1-30:

31-60:

61-90:

91-100:

というわけで、ゼータ・アルファのレポートの内容は以上です。

元のテキストにスタンプを付けることができます: https://www.php.cn/link/ea20aed6df7caa746052d227d194a395

以上がAI論文の「引用変換率の高さ」ランキングを発表:1位OpenAI、2位Megvii、9位Googleの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。