ホームページ >テクノロジー周辺機器 >AI >機械学習の評価指標に関する面接でよくある 10 の質問

機械学習の評価指標に関する面接でよくある 10 の質問

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-11 20:58:021870ブラウズ

評価指標は、機械学習モデルのパフォーマンスを評価するために使用される定量的な指標です。これらは、さまざまなモデルを比較し、特定の問題の解決における成功を測定するための体系的かつ客観的な方法を提供します。さまざまなモデルの結果を比較し、そのパフォーマンスを評価することで、どのモデルを使用するか、既存のモデルを改善する方法、特定のタスクのパフォーマンスを最適化する方法について正しい決定を下すことができるため、評価指標は重要な役割を果たします。機械学習モデルの開発と展開という重要な役割を果たします。したがって、評価指標は面接でよく聞かれる基本的な質問であり、この記事ではよくある質問を10個まとめました。

1. 機械学習のコンテキストにおける適合率と再現率の違いを説明できますか?

機械学習モデルでは、適合率と再現率は一般的に 2 つです。使用される評価指標。精度は、すべての陽性予測のうちモデルによって行われた真陽性予測の数の尺度であり、偽陽性予測を回避するモデルの能力を示します。

精度 = TP/TP FP

再現率は、データセット内のすべての実際の肯定的なインスタンスにわたってモデルが行う真の予測の数の尺度です。再現率は、すべての肯定的なインスタンスを正しく識別するモデルの能力を表します。

再現率 = TP/TP FN

精度と再現率はどちらも重要な評価指標ですが、この 2 つの間のトレードオフは、解決する特定の問題の要件によって異なります。たとえば、医療診断では、たとえ偽陽性率が高くなっても、疾患のすべてのケースを特定することが重要であるため、リコールがより重要になる場合があります。しかし、不正行為の検出では、たとえ偽陰性率が高くなっても、冤罪を回避することが重要であるため、精度がより重要になる可能性があります。

2. 特定の問題に対して適切な評価指標を選択するにはどうすればよいですか?

特定の問題に対して適切な評価を選択することは、モデル開発プロセスの重要な側面です。指標を選択するときは、問題の性質と分析の目標を考慮することが重要です。考慮すべき一般的な要素は次のとおりです。

問題の種類: バイナリ分類問題、マルチクラス分類問題、回帰問題、またはその他のものですか?

ビジネス目標: 問題は何ですか?分析の最終目標、どのようなパフォーマンスが必要ですか? たとえば、目標が偽陰性を最小限に抑えることである場合、再現率は精度よりも重要な指標になります。

データセットの特性: クラスはバランスがとれていますか、それともアンバランスですか? データセットは大きいですか、それとも小さいですか?

データ品質: データの品質はどれくらいか、データ内に存在するノイズの量はどれくらいですか? set?

これらの要素に基づいて、精度、F1 スコア、AUC-ROC、精度-再現率、平均二乗誤差などの評価指標を選択できます。ただし、モデルのパフォーマンスを完全に理解するために複数の評価指標を使用するのが一般的です。

3. F1 スコアの使用について紹介してもらえますか?

F1 スコアは機械学習で一般的に使用される評価指標であり、精度と再現率のバランスをとるために使用されます。適合率は、モデルによって行われたすべての肯定的な予測のうちの肯定的な観測の割合を測定し、再現率は、すべての実際の肯定的な観測のうちの肯定的な予測の割合を測定します。 F1 スコアは適合率と再現率の調和平均であり、バイナリ分類器のパフォーマンスを要約する単一の指標としてよく使用されます。

F1 = 2 * (精度 * 再現率) / (再現率の精度)

モデルが精度と再現率の間でトレードオフを行う必要がある状況では、精度を使用するよりも F1 スコアの方が優れています。またはリコールのみ リコールでは、より詳細なパフォーマンス評価が提供されます。たとえば、偽陽性予測のコストが偽陰性予測よりも高い場合は、精度の最適化がより重要になる可能性がありますが、偽陰性予測のコストがより高い場合は、再現率が優先される可能性があります。 F1 スコアを使用すると、これらのシナリオでモデルのパフォーマンスを評価し、しきい値やその他のパラメーターを調整してパフォーマンスを最適化する方法に関する対応するデータ サポートを提供できます。

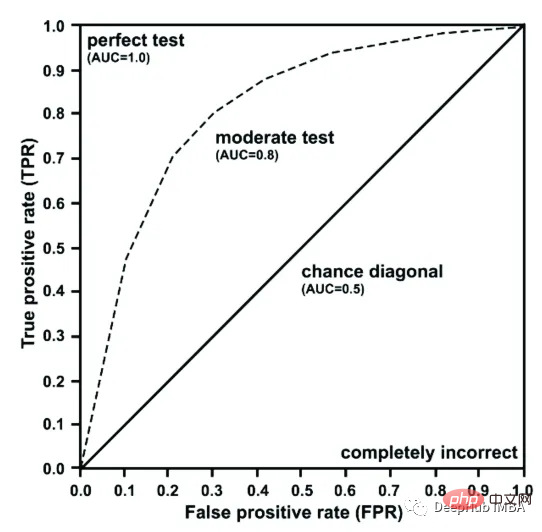

4. モデル評価で ROC 曲線を使用する理由を説明できますか?

ROC 曲線は、真陽性率 ( TPR) と偽陽性率 (FPR)。これは、モデルの感度 (真陽性) と特異性 (真陰性) の間のトレードオフを評価するのに役立ち、バイナリ分類の結果 (はいまたはいいえ、合格または不合格など) に基づいて予測を行うモデルを評価するために広く使用されています。 。)。

#ROC 曲線は、予測結果と実際の結果を比較することによってモデルのパフォーマンスを測定します。優れたモデルには ROC 曲線の下に大きな領域があり、陽性クラスと陰性クラスを正確に区別できることを意味します。 ROC AUC (Area Under the Curve、曲線の下の面積) は、さまざまなモデルのパフォーマンスを比較するために使用され、特にクラスの不均衡がある場合のモデルのパフォーマンスを評価する良い方法です。

5. 二項分類モデルの最適なしきい値を決定するにはどうすればよいですか?

二項分類モデルの最適なしきい値は、精度と再現率のバランスがとれたしきい値を見つけることによって決定されます。これは、精度と再現率のバランスをとる F1 スコアなどの評価指標を使用するか、さまざまなしきい値に対する真陽性率と偽陽性率をプロットする ROC 曲線を使用することによって実現できます。最適なしきい値は通常、ROC 曲線上の左上隅に最も近い点として選択されます。これにより、偽陽性率を最小限に抑えながら真陽性率を最大化できるからです。実際には、最適なしきい値は、問題の具体的な目標や、偽陽性と偽陰性に関連するコストにも依存する場合があります。

6. モデル評価における精度と再現率の間の次のトレードオフを導入できますか?

モデル評価における精度と再現率の間のトレードオフは、ポジティブなインスタンス (再現率) を正しく識別することを指します。 )、ポジティブな例のみを正しく識別します(思い出してください)。精度が高いということは偽陽性の数が少ないことを意味し、再現率が高いということは偽陰性の数が少ないことを意味します。特定のモデルの場合、精度と再現率を同時に最大化することは多くの場合不可能です。このトレードオフを実現するには、問題の具体的な目標とニーズを考慮し、それらと一致する評価指標を選択する必要があります。

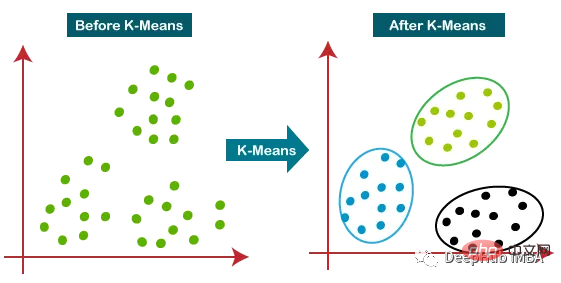

7. クラスタリング モデルのパフォーマンスを評価する方法?

クラスタリング モデルのパフォーマンスは、多くの指標を使用して評価できます。一般的なメトリクスには次のものがあります。

- シルエット スコア: 他のクラスターと比較した、観察された独自のクラスターの類似性を測定します。スコアの範囲は -1 から 1 で、値が 1 に近いほどクラスター構造が強いことを示します。

- Calinski-Harabasz 指数: クラスター間の分散とクラスター内の分散の比率を測定します。値が大きいほど、クラスタリング ソリューションが優れていることを示します。

- Davies-Bouldin インデックス: 各クラスターとその最も類似したクラスター間の平均類似性を測定します。値が小さいほど、クラスタリング ソリューションが優れていることを示します。

- 調整されたランド インデックス: 確率に基づいて調整された、真のクラス ラベルと予測されたクラスター ラベルの間の類似性を測定します。値が大きいほど、クラスタリング ソリューションが優れていることを示します。

- 混同行列: 予測されたクラスターと真のクラスを比較することで、クラスター化モデルの精度を評価できます。

#ただし、適切な評価指標の選択は、クラスター分析の特定の問題と目標によっても異なります。

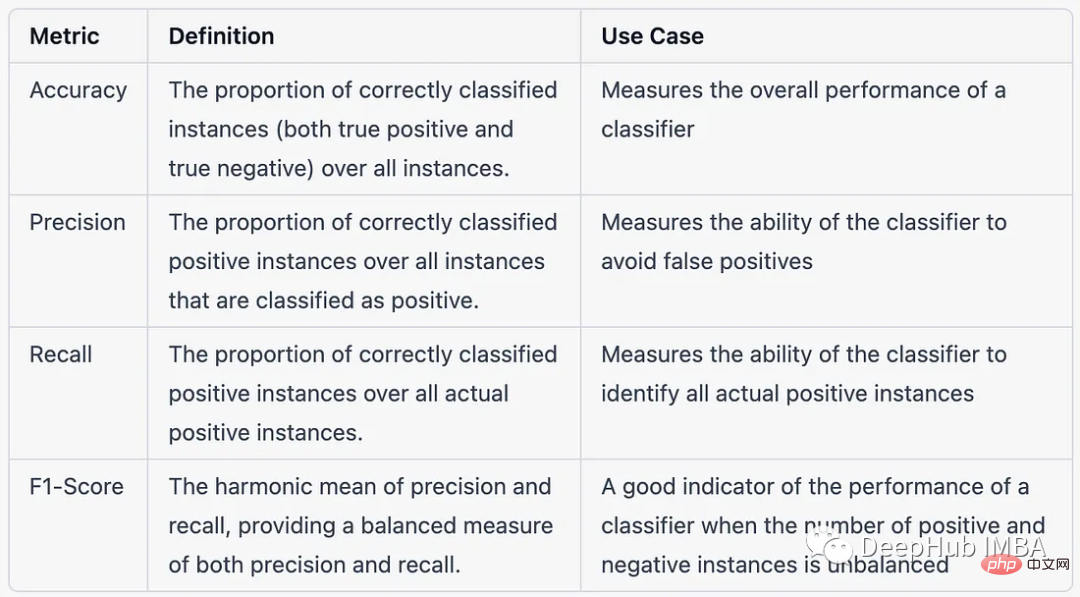

8. 複数クラス分類問題のコンテキストにおける、精度、適合率、再現率、および F1 スコアの違い

以下は、複数クラス分類問題のコンテキストにおけるものです。表形式で精度、適合率、再現率、および F1 スコアを比較します:

9. レコメンデーション システムのパフォーマンスを評価するにはどうすればよいですか?

レコメンデーション システムのパフォーマンスには、関連するアイテムをユーザーに推奨する際のシステムの有効性と効率の測定が含まれます。レコメンデーション システムのパフォーマンスを評価するために一般的に使用されるメトリクスには、次のものがあります。

- 精度: ユーザーに関連する推奨アイテムの割合。

- 思い出してください: システムによって推奨される関連アイテムの割合。

- F1-スコア: 精度と再現率の調和平均。

- 平均平均精度 (MAP): レコメンデーション システムのユーザー全体の平均精度の尺度。

- 正規化割引累積ゲイン (NDCG): 推奨アイテムのランク重み付けされた関連性を測定します。

- 二乗平均平方根誤差 (RMSE): 一連の項目の予測評価と実際の評価の差の尺度。

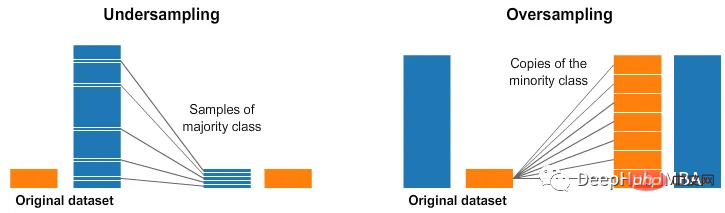

- 10. モデルのパフォーマンスを評価するときに不均衡なデータ セットに対処するにはどうすればよいですか?

モデル評価で不均衡なデータ セットに対処するには、次の手法を使用できます:

- データセットをリサンプリングします。少数クラスをオーバーサンプリングするか、多数派クラスをオーバーサンプリングして、クラス分布のバランスをとります。

- 別の評価メトリクスを使用する: 精度、再現率、F1 スコア、ROC 曲線下面積 (AUC-ROC) などのメトリクスは、クラスの不均衡の影響を受けやすく、不均衡なデータに対するモデルのパフォーマンスをよりよく理解できます。 . セット性能です。

- コスト重視の学習を使用する: 偽陽性よりも偽陰性に高いコストを割り当てるなど、さまざまな種類の誤分類にコストを割り当てて、モデルが少数派のクラスに対してより敏感になるようにします。

- アンサンブル手法を使用する: 複数のモデルの結果を組み合わせることで、バギング、ブースティング、スタッキングなどの手法を使用して、不均衡なデータセットでのモデルのパフォーマンスを向上させることができます。

- ハイブリッド手法: 上記の手法を組み合わせて使用すると、モデル評価で不均衡なデータセットを処理できます。

概要

評価指標は機械学習において重要な役割を果たします。適切な評価指標を選択し、それを適切に使用することは、機械学習モデルと洞察の品質とパフォーマンスを確保するために重要です。信頼性は非常に重要です。必ず使われるので面接でもよく聞かれる質問ですので、この記事にまとめた質問が少しでもお役に立てれば幸いです。

以上が機械学習の評価指標に関する面接でよくある 10 の質問の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。