ホームページ >テクノロジー周辺機器 >AI >積み木ディープラーニングの正しい遊び方!シンガポール国立大学が、知識の伝達を活字印刷に変える新しい転移学習パラダイムである DeRy をリリース

積み木ディープラーニングの正しい遊び方!シンガポール国立大学が、知識の伝達を活字印刷に変える新しい転移学習パラダイムである DeRy をリリース

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-11 20:43:012089ブラウズ

980年前の北宋の仁宗の清暦の時代、中国では知識革命が静かに起こっていました。

#すべてのきっかけは、寺院に住む賢者の言葉ではなく、規則的に碑文が刻まれた粘土レンガが一枚ずつ焼き上げられたことです。

この革命は、「ムーバブルタイプ印刷」です。

可動活字印刷の繊細さは、職人がまず一文字の裏文字型を作り、原稿に合わせて一文字を入力し、選択してインクで印刷することで、何度でも使用できるフォントです。

#木版印刷の「1 版、1 版」の煩雑なプロセスと比較して、モジュール化 - オンデマンドで組み立て - 多用途この作業モードは印刷の効率を幾何学的に向上させ、数千年にわたる人類文明の発展と継承の基礎を築きました。

ディープラーニングの分野に戻りますが、大規模な事前トレーニング済みモデルの人気が高まっている今日、一連の大規模なモデルの機能を特定のモデルに移行する方法は次のとおりです。下流のタスクが問題になっており、それが重要な問題です。

以前の知識の伝達または再利用方法は「版刷り」に似ています。多くの場合、タスクの要件に従って新しい完全なモデルをトレーニングする必要があります。これらの方法には巨額のトレーニング費用がかかることが多く、多数のタスクに拡張するのが困難です。

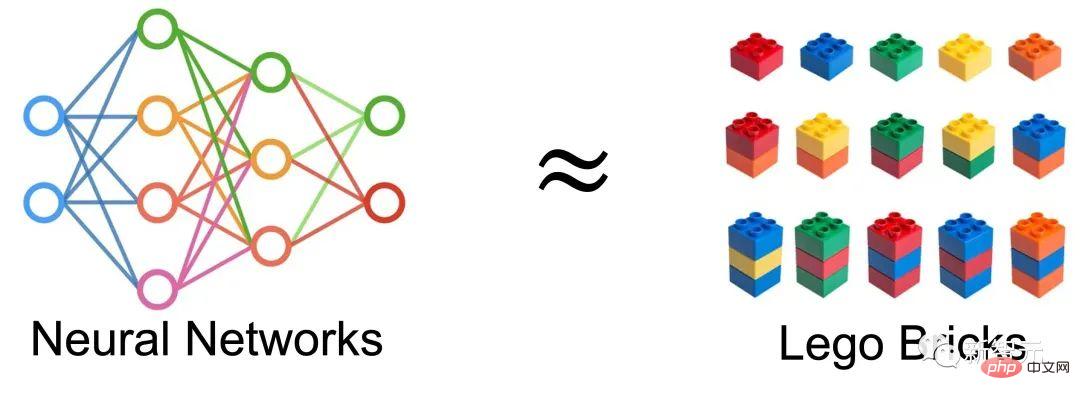

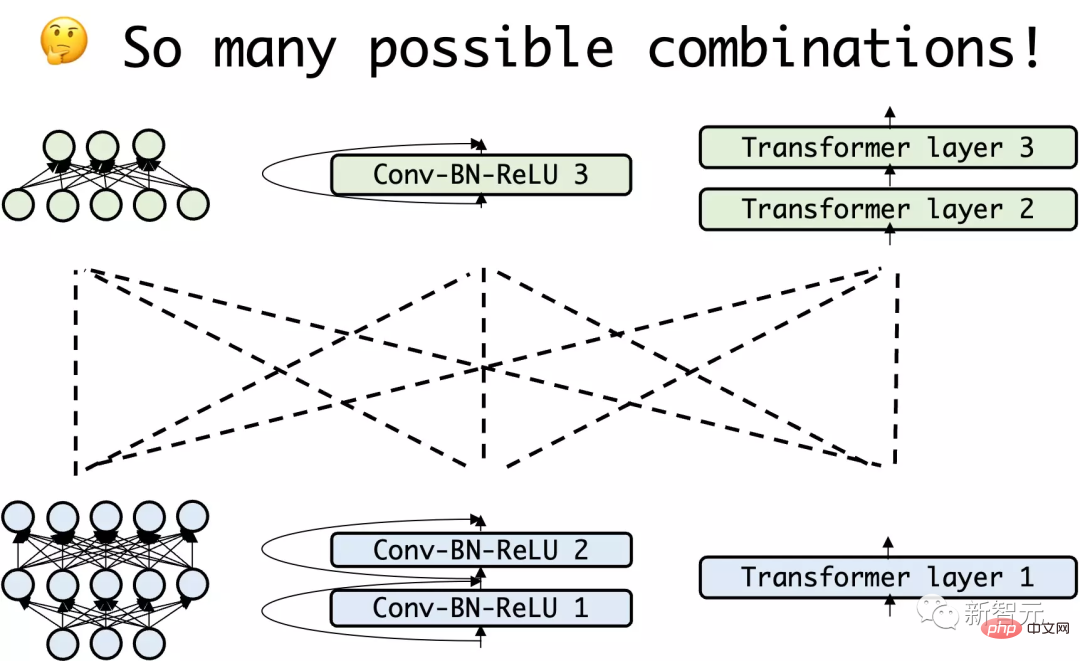

そこで、非常に自然なアイデアが浮かび上がりました: ニューラル ネットワークを構成要素の集合体とみなして、新しいネットワークを取得できますか?既存のネットワークを再構築し、それを使用して転移学習を実行しますか?

紙のリンク: https://arxiv.org/abs/2210.17409

コードリンク: https://github.com/Adamdad/DeRy

プロジェクトホームページ: https://adamdad.github.io/dery/

OpenReview: https://openreview.net/forum?id=gtCPWaY5bNh

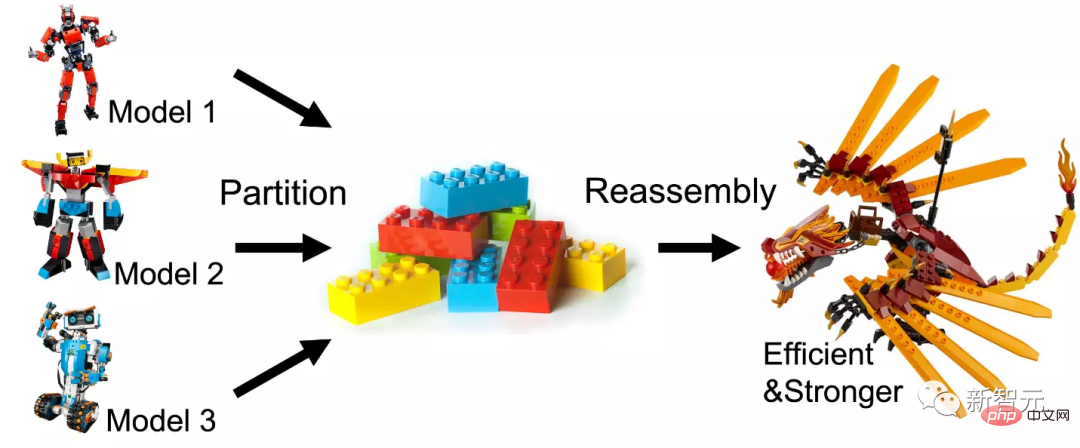

著者既存の事前トレーニング済みモデルを機能の類似性に基づいてサブネットワークに分解し、次にそのサブネットワークを再組み立てして、特定のタスク用の効率的で使いやすいモデルを構築します。

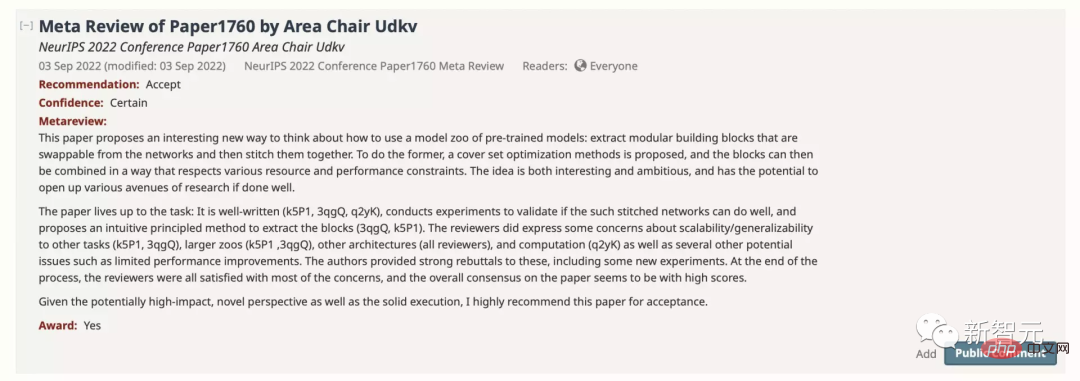

この論文は NeurIPS に 886 点のスコアで受理され、論文賞ノミネートとして推薦されました。

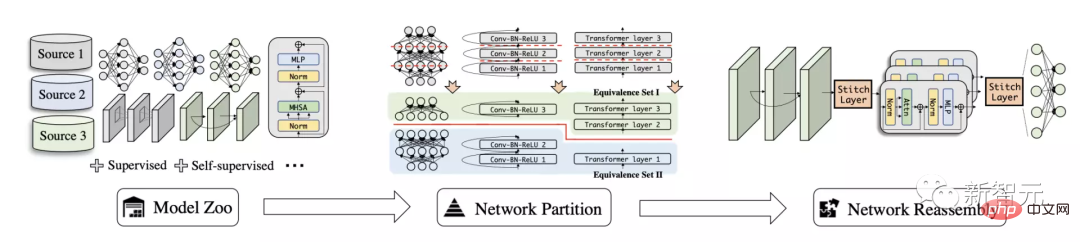

この記事では、著者は、一般的なモデルの再利用に使用する、ディープ モデル再アセンブリ (DeRy) と呼ばれる新しい知識伝達タスクを検討します。

さまざまなデータと異種アーキテクチャでトレーニングされた一連の事前トレーニング済みモデルが与えられた場合、深いモデルの再構築では、まず各モデルを独立したモデル チャンクに分割し、次にハードウェア内でサブモデルの部分を選択的に再組み立てします。そしてパフォーマンスの制約。

この方法は、ディープ ニューラル ネットワーク モデルをビルディング ブロックとして扱うのと似ています。つまり、既存の大きなビルディング ブロックを小さなビルディング ブロックに分解してから、必要に応じて部品を組み立てます。組み立てられた新しいモデルは、より強力なパフォーマンスを備えているだけでなく、効率を確保するために、組み立てプロセスで元のモジュールの構造やパラメータをできる限り変更すべきではありません。

深層モデルの分割と再編成

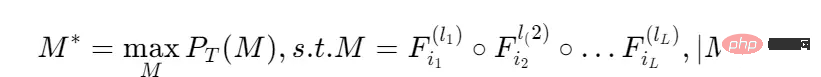

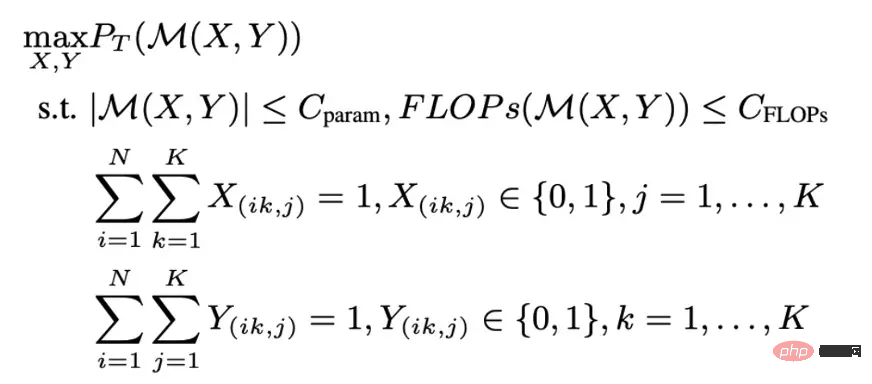

この記事の方法は 2 つの部分に分けることができます。 DeRy は最初にセット カバー問題を解決し、すべての事前トレーニング済みネットワークを機能レベルに応じて分割します。2 番目のステップでは、モデル アセンブリを 0 ~ 1 の整数計画問題に形式化し、組み立てられたモデルが特定のタスクで最高のパフォーマンスを発揮できるようにします。

##ディープモデルの再アセンブリ

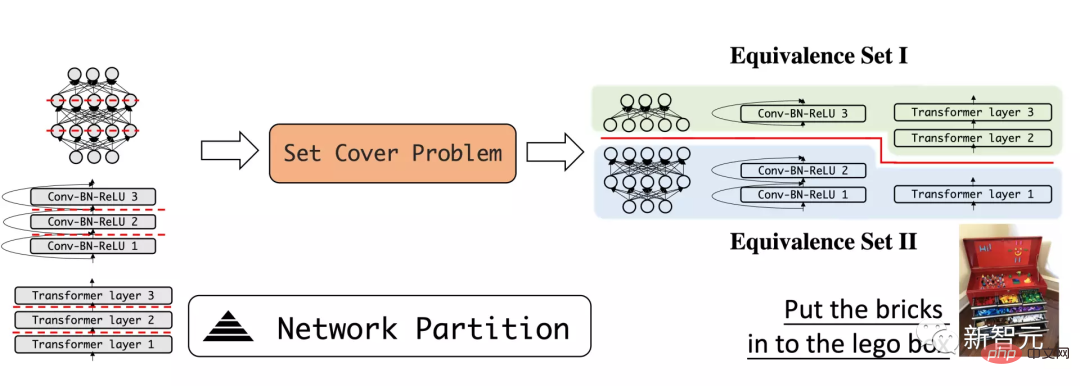

まず、著者は深いモデルの再構築の問題を定義します。トレーニングされた深いモデルが与えられると、それはモデル ライブラリと呼ばれます。

各モデルは、 で表されるレイヤー リンクで構成されます。モデルが層ごとに接続されている限り、ネットワークが異なれば、まったく異なる構造や動作を持つことができます。

#与えられたタスクでは、最高のパフォーマンスを持つ層混合モデルを見つけたいと考えており、モデルの計算量は特定の制限を満たします。

この問題では、次のことを行うために、すべてのモデル層のすべての順列を検索する必要があります。収益を最大化します。本質的に、このタスクには非常に複雑な組み合わせの最適化が含まれます。

探索コストを簡略化するために、この記事ではまずモデル ライブラリ モデルを深さ方向から分割して、より浅くて小さなサブネットワークを形成し、次にそのサブネットワークでスプライシング探索を実行します。ネットワークレベル。

機能レベルに応じてネットワークを分割する

DeRy の最初のステップは、徹底的に分解することです学習モデルは積み木のようなものです。著者は、深いネットワーク分割手法を採用して、深いモデルをいくつかの浅い小さなモデルに分割します。記事では、分解されたサブモデルができる限り異なる機能を持つことを望んでいます。このプロセスは、積み木を解体しておもちゃ箱にカテゴリー別に入れるプロセスに例えることができます。

似たような積み木を組み合わせ、異なる積み木を分解します。

たとえば、モデルを最下位レイヤーと上位レイヤーに分割し、最下位レイヤーが主に曲線や形状などの局所的なパターンの識別を担当すると想定します。上位層はサンプルの全体的なセマンティクスを判断できます。

#一般機能類似性測定指標を使用すると、任意のモデルの機能的類似性を定量的に測定できます。

#一般機能類似性測定指標を使用すると、任意のモデルの機能的類似性を定量的に測定できます。

重要なアイデアは、同様の入力に対して、同じ機能を持つニューラル ネットワークは同様の出力を生成できるということです。

したがって、2 つのネットワークの合計に対応する入力テンソル X および X' について、それらの機能的類似性は次のように定義されます。

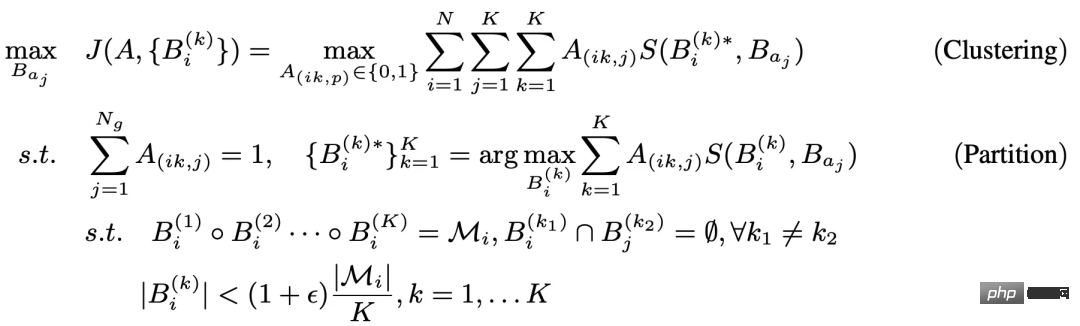

その後、モデル ライブラリは、機能の類似性によって 機能等価セットに分割できます。 各同値セット内のサブネットワークは機能的な類似性が高く、各モデルを分割することでモデル ライブラリの分離性が保証されます。 このような逆アセンブリの主な利点の 1 つは、機能の類似性により、各等価セット内のサブネットワークがほぼ可換であると見なすことができることです。つまり、ネットワーク ブロックを次のものに置き換えることができることです。ネットワーク予測に影響を与えることなく、同じ同値セットの別のサブネットワーク。 #上記の分割問題は、3 層の制約付き最適化問題として形式化できます。 Theこの問題の内部レベルの最適化は、一般的なカバー セット問題またはグラフ セグメンテーション問題と非常に似ています。したがって、著者はヒューリスティックな Kernighan-Lin (KL) アルゴリズムを使用して内部層を最適化します。 一般的な考え方は、ランダムに初期化された 2 つのサブモデルについて、毎回 1 つの演算層が交換されるということです。交換によって評価関数の値が増加する場合、交換は保持されます。 ; そうでなければ諦める、このやりとり。 ここの外側のループでは、K-Means クラスタリング アルゴリズムが採用されています。 ネットワーク分割ごとに、各サブネットワークは常に中心距離が最大の機能セットに割り当てられます。内側ループと外側ループは反復的であり、収束保証があるため、上記の問題を解決することで、機能レベルに応じて最適なサブネットワーク分割を得ることができます。 #整数最適化に基づくネットワーク アセンブリ ネットワーク分割では、各ネットワークをサブネットワークに分割します。同値セットに属します。これは、ダウンストリーム タスクに最適なネットワーク スプライシングを見つけるための検索スペースとして使用できます。

上記の 分割-再結合 プロセスを通じて、さまざまな事前トレーニングされたモデルを結合および融合して、新しく強力なモデルを取得できます。 実験結果 実験では 2 つの異なるトレーニング方法が使用されました: フルチューニング (接続されたモデルのすべてのパラメーターがトレーニングされることを意味します); フリーズ- Tuning は、スプライスされた接続層のみがトレーニングされることを意味します。

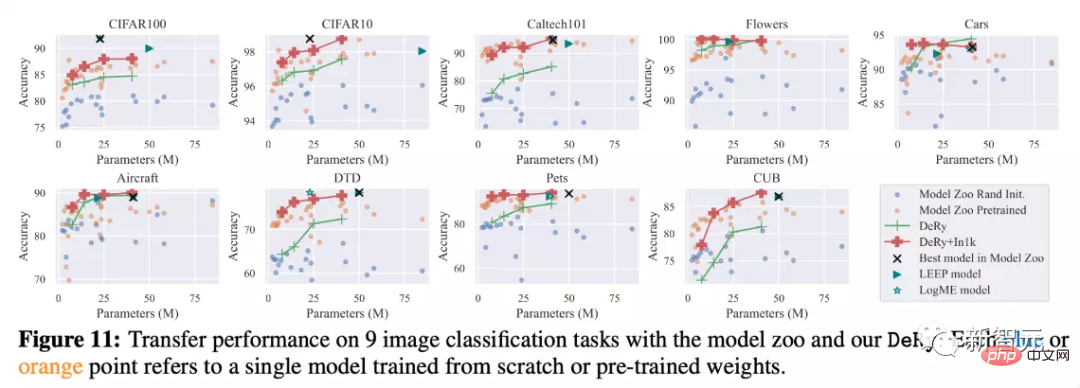

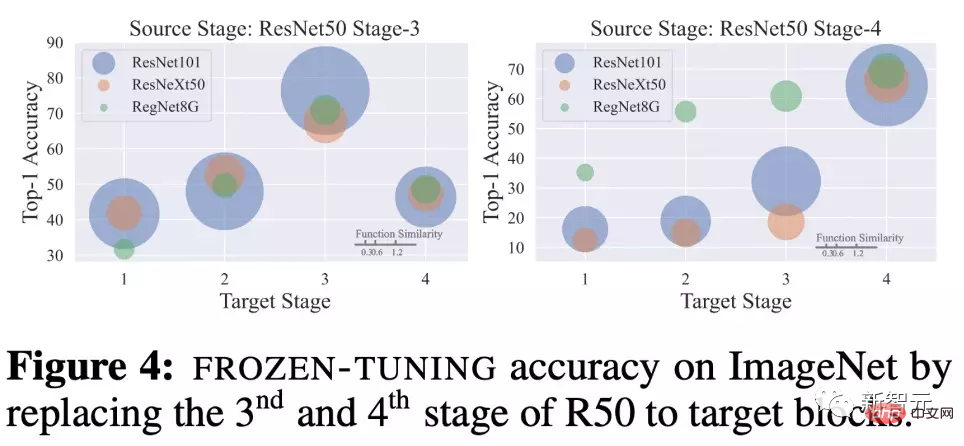

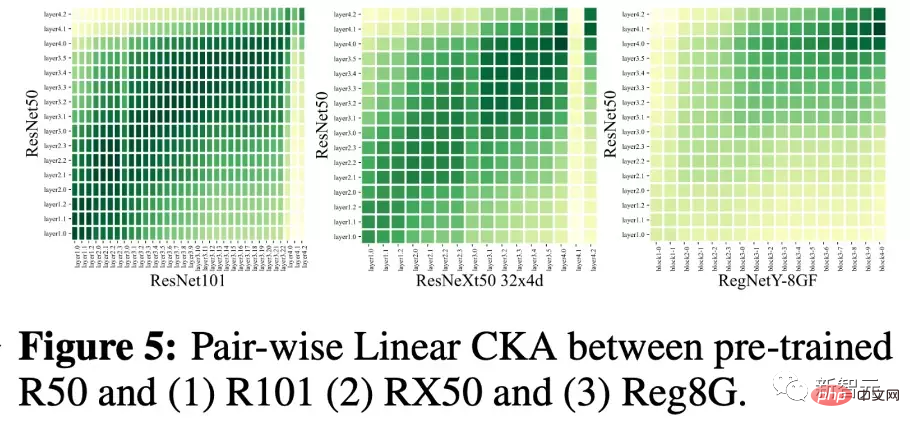

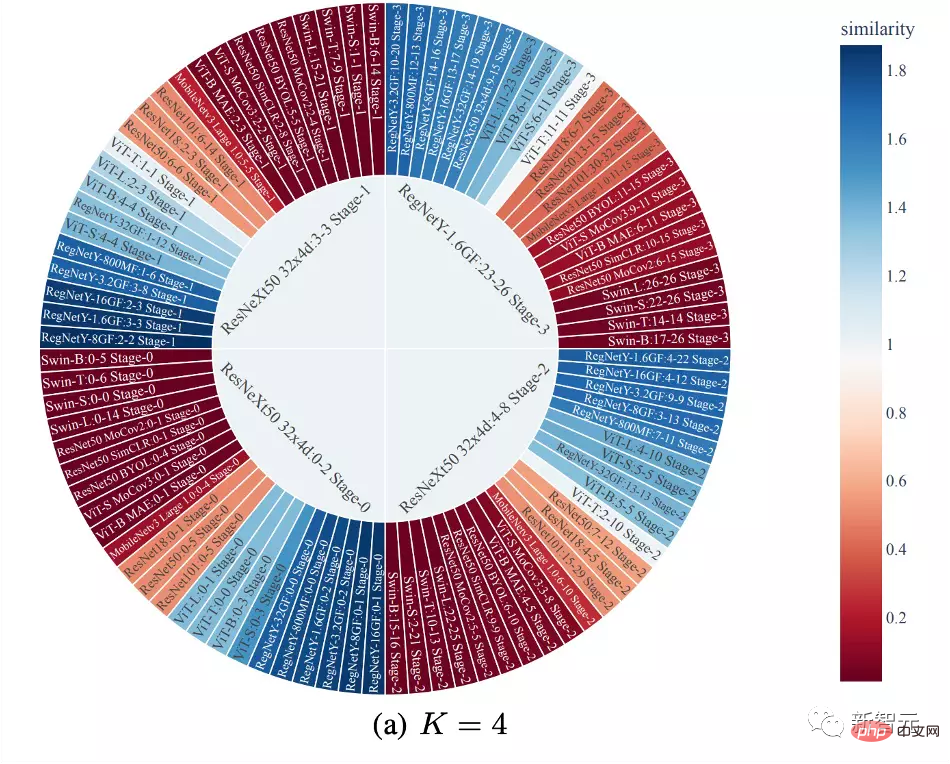

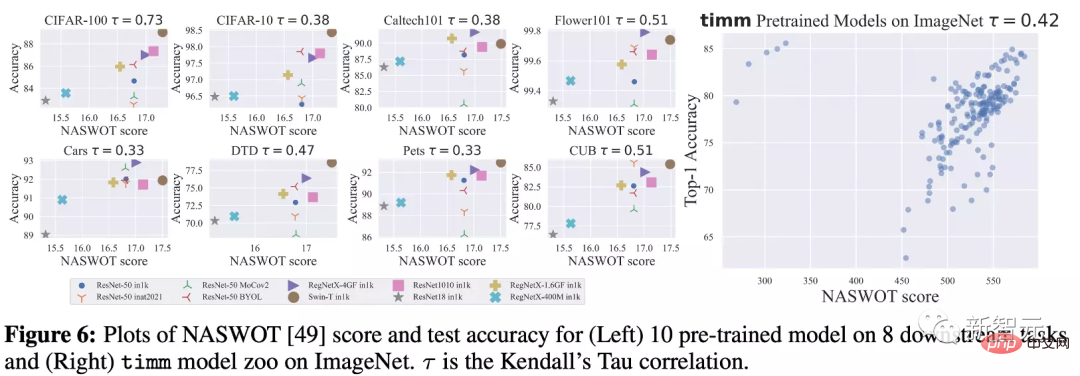

上の図からわかるように、ImageNet データ セット上では、DeRy によって取得されたさまざまなスケールのモデルが、モデル ライブラリ内の同様のサイズのモデルと同等かそれ以上である可能性があります。 リンク部分のパラメーターのみがトレーニングされた場合でも、モデルは依然として大きなパフォーマンス向上を得ることができることがわかります。たとえば、DeRy(4,90,20) モデルは、トレーニングされたわずか 127 万のパラメーターで 78.6% の Top1 精度を達成しました。 同時に、9 つの転移学習実験によって DeRy の有効性も検証されました。事前トレーニングなしでも、DeRy のモデルはさまざまなモデル サイズの比較で他のモデルよりも優れたパフォーマンスを発揮できることがわかりますが、再構成されたモデルを継続的に事前トレーニングすることで、モデルのパフォーマンスが大幅に向上し、赤い曲線に達します。 LEEP や LogME などのモデル ライブラリからの他の転移学習手法と比較すると、DeRy はモデル ライブラリ自体のパフォーマンス制限を超え、業界で最高のモデルよりも優れていることさえあります。オリジナルモデルライブラリ、ベストモデル。 モデルの再編成の性質を探る 作者は、次のことについても非常に興味を持っています。この記事で提案するモデル再構成のプロパティは、「どのようなパターンに従ってモデルが分割されるか?」や「どのようなルールに従ってモデルが再構成されるか?」などです。著者は分析のための実験を提供します。 機能の類似性、再アセンブリの場所、および再アセンブリのパフォーマンス 著者は、同じネットワーク ブロックがどのように使用されるかを調査します。 other ネットワーク ブロックを機能の類似性が異なるものに置き換えた後、Freeze-Tuning 20 エポックのパフォーマンスを比較します。 ImageNet でトレーニングされた ResNet50 の場合、第 3 段階と第 4 段階のネットワーク ブロックを使用し、別のネットワーク ブロックに置き換えます。 ResNet101、ResNeXt50、および RegNetY8G 用。 交換位置がパフォーマンスに大きな影響を与えることがわかります。 たとえば、第 3 ステージを別のネットワークの第 3 ステージに置き換えた場合、再編成されたネットワークのパフォーマンスは特に強いでしょう。同時に、機能的類似性も組換え性能と確実に一致します。 同じ深さのネットワーク モデル ブロックは類似性が高く、トレーニング後のモデルの機能がより強力になります。これは、類似性-組換え位置-組換え性能の間の依存性と正の関係を示しています。 分割結果の観察 下の図では、著者は1 ステップの分割の結果。色は、ネットワーク ブロックと、曲の同値セットの中心にあるネットワーク ブロックとの類似性を表します。 この記事で提案されている分割では、深さに応じてサブネットワークをクラスター化し、分割する傾向があることがわかります。同時に、CNN と Transformer 間の機能類似性データは小さいですが、CNN と異なるアーキテクチャの CNN 間の機能類似性は通常より大きくなります。 ##NASWOT をパフォーマンス指標として使用する この記事では、NASWOT をゼロトレーニング転送予測に初めて適用したため、著者はこの指標の信頼性もテストしました。 下の図では、著者はさまざまなデータセットでさまざまなモデルの NASWOT スコアを計算し、転移学習の精度プラス 1 と比較しています。 NASWOT スコアでは、より正確なパフォーマンス ランキング (Kendall のタウ相関) が得られていることがわかります。これは、この記事で使用されているゼロ トレーニング インデックスが下流データに対するモデルのパフォーマンスを効果的に予測できることを示しています。 この論文では、深層モデルの再構築 (深層モデル再構築) と呼ばれる新しい知識伝達タスクを提案します。 、略してDeRy)。彼は、既存の異種の事前トレーニング済みモデルを分割し、それらを再構築することによって、下流のタスクに適応したモデルを構築します。 著者は、このタスクを達成するための単純な 2 段階の実装を提案しています。まず、DeRy はカバリング セット問題を解決し、すべての事前トレーニング済みネットワークを機能レベルに応じて分割します。2 番目のステップでは、DeRy はモデル アセンブリを 0 ~ 1 の整数計画問題に形式化し、特定のタスクで組み立てられたモデルのパフォーマンスを保証します。最適な。 この研究では、大幅なパフォーマンスの向上が達成されただけでなく、異なるニューラル ネットワーク間の接続の可能性もマッピングされました。

著者は、事前にトレーニングされた 30 個の異なるモデルを組み合わせています。ネットワーク ライブラリは丹念に分解および再組み立てされ、ImageNet および他の 9 つの下流分類タスクでパフォーマンスが評価されました。

概要

以上が積み木ディープラーニングの正しい遊び方!シンガポール国立大学が、知識の伝達を活字印刷に変える新しい転移学習パラダイムである DeRy をリリースの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。