ホームページ >テクノロジー周辺機器 >AI >ChatGPT の中国語版を作成できるのは誰ですか?どうやってするの?

ChatGPT の中国語版を作成できるのは誰ですか?どうやってするの?

- 王林転載

- 2023-04-11 19:40:091103ブラウズ

2022 年 12 月、ChatGPT が誕生しました。 OpenAI は、核爆弾レベルの結果をもたらし、科学研究と工学アプリケーションのパラダイムを変えました。中国では、ChatGPT が広く注目され、深い議論が行われています。先月、私は北京から上海、杭州、深センまで、主要な大学、研究機関、大規模工場、新興企業、ベンチャーキャピタルを訪問し、すべての有力企業と話をしました。中国ではすでに「スケールゲーム」が始まっているが、国内の技術やエコロジーと世界の最先端との間に大きな差がある中で、嵐の中心にいるプレーヤーはどうやってこれを達成できるのだろうか?誰がこれをできるでしょうか?

秦は鹿を失い、全世界が鹿を追い払いました。 ———— 『史記・淮陰侯爵伝』

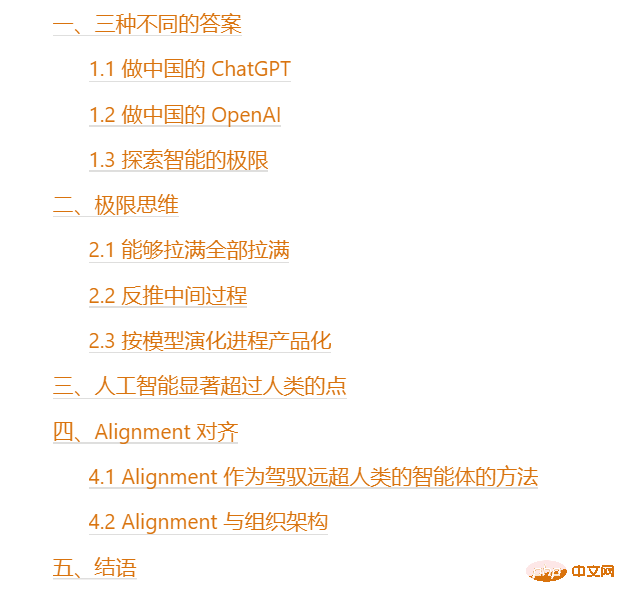

目次

#1. 3 つの異なる答え

スタートアップ企業と接触するたびに、私は同じ質問をします。「ChatGPT はどこにありますか。何をしたいのですか?」おそらく 3 つの異なる答えが得られます。最初の答えは明らかです。中国の ChatGPT を構築することです。

1.1 Make China's ChatGPT

があるので再現して国内で変えていきたいと思います。これは、 非常に古典的な製品指向の中国のインターネットの考え方です。。この考え方は、過去 20 年間の中国インターネットの一般的なビジネス モデルでもあります。まずシリコンバレーが何かを作り、次にそれを我々がコピーします。

しかし、ここでの問題は、まず第一に、ChatGPT はタクシー配車ソフトウェアとは異なり、再現の難易度がまったく異なるということです。人間の観点から見ると、GPT の作成は、2015 年以来、世界のトップの科学者とエンジニアによる継続的な研究の結果です。 OpenAI の主任科学者である Ilya Sutskever [1], は、AGI が を達成できると深く信じています。チューリング賞受賞者ジェフリー・ヒントンの弟子として、2007 年からディープラーニングを研究しています。彼の引用数は 370,000 件で、過去 10 年間に公開した記事はディープ ラーニングのすべての重要な点を正確に的中しています。これだけ強力なチームがあっても、GPT 2からGPT 3.5になるまでに4年かかったというから、その科学技術の難しさは容易に想像できる。

同時に、ChatGPT の第 1 世代は、GPT 3.5 の基本モデルをベースにした OpenAI です。ダイアログの微調整 デモを破棄します。ここでの本当の強みは、ChatGPT 製品ではなく、基礎となる GPT 3.5 基本モデルです。このモデルはまだ進化中です。GPT 3.5 シリーズは、2022 年に 3 つのメジャー バージョンで更新されました[2]、各メジャー バージョンは以前のバージョンよりも大幅に強化されています。同様に、ChatGPT は 2 か月前にリリースされました。合計4 つのマイナー バージョンのうち #[3] が更新されました。各マイナー バージョンには、単一の面で以前のバージョンに比べて明らかな改善が見られます。すべての OpenAI モデルは常に進化し、時間の経過とともに強化されています。 これは、現在の ChatGPT 製品だけに注目する場合、 それは剣を見つけようとするのと同じであることも意味します。 ChatGPTが登場したとき、既存の音声アシスタントに次元削減の打撃を与えた;基本モデルの進化が見られなければ、たとえ1~2年かけて同じようなものを頑張って作ったとしても、当時のOpenAIの基礎モデルも強化され続けていますが、より強力な新しい基本モデルでより強力な製品を製品化および微調整し続けると、再び次元削減に見舞われるのでしょうか?

舟を彫って剣を求めるというアプローチはうまくいきません。 1.2 中国の OpenAI になること

2 番目の答えは、中国の OpenAI になることです。この答えを出したプレイヤーは、古典的な中国のインターネット製品の考え方から飛び出しました。彼らは、単一の製品を見ただけでなく、この製品の背後にある基本モデルの継続的な進化の強力な原動力を目の当たりにしました。これは、

最先端の人材の密度から来ています。 先進的な組織構造。

を目指しています。これを行うには、製品についてだけでなく、その背後にある人材チームと組織構造も確認する必要があります。希少性によってランク付けされている場合、人>>卡>>お金。 しかし、ここでの問題は、土壌が異なるとイノベーションを促進する程度も異なるということです。 OpenAI が 2015 年に初めて設立されたとき、当時は利益が見られなかったにもかかわらず、投資家は AGI を信じました。 GPT が開発された今、国内の投資家も AGI を信じていますが、彼らの信念は異なる可能性があります: AGI が儲かると信じますか、それとも AGI が人間開発を促進できると信じますか?## ###? [4] を支援できるよう全力を注ぐことができます。これを中国に変更した場合、Alibaba Cloud がスタートアップ企業を支援することは可能でしょうか ? 組織構造は非常に重要です。最先端の人材と高度な組織構造のみが、インテリジェンスの継続的な反復と進化を促進できます。しかし、インテリジェンスが置かれている土壌に適応する必要もあります。 、そしてメソッドを繁栄させる方法を見つけてください。 1.3 インテリジェンスの限界を探る 3 番目の答えは、 。これが私が聞いた中で最良の答えです。それは、あらゆる場面で剣を求めるという古典的なインターネット製品の考え方をはるかに超えており、組織構造と最先端の人材の密度の重要性も認識しています。さらに重要なのは、未来を見据え、モデルの進化と製品の反復を見て、考えることです。最も奥深く、最も奥深いものをどのように統合するかについて、最も革新的なアプローチで困難な問題を解決します。 これには、大規模モデルの極限について考えることが含まれます。 2. 極端な思考 モデルの入力ボックスを長くしたり、モデルのサイズを変更したりできますモデルが増加するにつれて、モデルのデータは増加し続け、マルチモーダル データは統合され、モデルの専門化度は増加し続け、これらすべての次元は引き上げられ続ける可能性があります。モデルはまだ限界に達していません。限界はプロセスです。このプロセス中にモデルの機能はどのように発達しますか?

対数線形曲線: 一部の機能の成長は対数線形曲線に従います #限界プロセスについて明確に考えた後、限界状態から中間プロセスを逆転できます。たとえば、入力ボックスのサイズを大きくしたい場合: モデルは常に進化していますが、製品化は必ずしも進化する必要はありません。最後のモデルまで待ちます。 モデルの完成 - モデルの大きなバージョンが反復されるたびに、それを商品化できます。 OpenAI の製品化プロセスを例に挙げます。 ##2020 年に、第 1 世代 GPT 3 トレーニングが完了し、OpenAI API がオープンされました[13] 2021 年、第一世代 Codex のトレーニングが完了し、Github Copilot がオープンしました[14] # 2022 年に、ダイアログ付きの GPT-3.5 のトレーニングが完了しました。データは ChatGPT に微調整されてからリリースされました こうした観点からすると、人工知能が人間を超えることは想像できないことではありません。これにより、次の疑問が生じます。人間をはるかに超える強力な人工知能を制御するにはどうすればよいでしょうか? #この問題は、アライメント技術が本当に解決したいことです。 現段階では、囲碁で最強の人間を超えたAlphaGoを除けば、モデルの能力は他の側面では最強を超えていません。 AI. より強い人間 (ただし、ChatGPT はリベラルアーツの人間の 95% を超えた可能性があり、その数は増え続けています)。モデルが人間を超えていないときは、アライメントの課題はモデルを人間の価値観や期待に適合させることですが、モデルが人間を超えて進化し続けた後は、アライメントの課題は、人間をはるかに超える知的エージェントを制御する方法を見つけることになります。人間。 4.1 人間をはるかに超える知的エージェントを制御する方法としての調整 明白な問題は、AI が人間を超えたとしても、依然としてそれを実現できるかということです。人間のフィードバックを通じて、彼/彼女をより強く/より規律正しくしますか?この時点で制御不能ですか? #必ずしもそうとは限りません。モデルが人間よりもはるかに優れている場合でも、私たちはそれを制御できます。ここでの例は、アスリートとコーチの間の例です 人間関係: 金メダルを獲得したアスリートは、その方向においてすでに最も強い人間ですが、これはコーチが彼を訓練できないという意味ではありません。逆に、コーチがアスリートほど優れていない場合でも、さまざまなフィードバックメカニズムを通じてアスリートをより強く、より規律正しくすることができます。 同様に、人間と強力な人工知能との関係は、AI開発の中期以降ではアスリートとコーチの関係になる可能性があります。このとき、人間に必要な能力は、 目標を達成することではなく、良い目標を設定し、それを測定することです。マシンがこの目標を十分に達成し、改善の提案を提供できるかどうか。 この方向の研究はまだ非常に予備的です。この新しい分野の名前は、スケーラブルな監視[15]です。 4.2 連携と組織構造 ##強力な人工知能への道では、人間と AI だけでなく、人間と人間も連携する必要があります。高度な調整。組織構造の観点から見ると、調整には以下が含まれます: 2017 年に初めて NLP 業界に入ったとき、私は制御可能な生成に多大な労力を費やしました。当時、いわゆるテキストスタイルの転送は、文章の感情分類を変更することが最も多く、善から悪への変更は完全な転送とみなされていました。 2018年、私は文構造の観点からモデルに文体を変換させる方法を研究することに多くの時間を費やしましたが、文体の変換はほぼ不可能であると誤解していました。 ChatGPT ではスタイル変換が非常に簡単になりました。かつては不可能だと思われていたタスクや、かつては非常に困難であった事柄も、今では大規模な言語モデルを使用して非常に簡単に達成できるようになりました。 2022 年を通じて、私は GPT-3 から GPT-3.5[11] までのすべてのバージョンの反復を追跡し、弱いものから強いものへと段階的に進化し続けるのを自分の目で見ました。この進化の速度は減速するどころか、むしろ加速しています。かつては SF のように見えたことが、今では現実になりました。未来がどうなるかは誰にも分かりません。 キビを切り離し、キビの苗が育っています。ペースが遅くて臆病で、中心が揺れています。 キビは切り離され、穀物の穂は切り離されます。大股で前に進むと、中央は酔いしれるようだ。 ———— 「歌の本・ミル」

特定のタスクの微調整など。微調整データが指数関数的に増加するにつれて、モデルに対応する微調整タスクの機能も直線的に増加します。これらの機能は予想どおり強力になります

[11]

4. アライメント

5. 結論

以上がChatGPT の中国語版を作成できるのは誰ですか?どうやってするの?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。