ホームページ >テクノロジー周辺機器 >AI >AIGC統一モデル登場! CV業界のリーダーであるHuang Xutao氏が設立したチームが提案した「全能拡散」

AIGC統一モデル登場! CV業界のリーダーであるHuang Xutao氏が設立したチームが提案した「全能拡散」

- 王林転載

- 2023-04-11 19:30:161165ブラウズ

拡散モデルの最近の進歩は、多くの生成タスクにおいて目覚ましいマイルストーンを打ち立てました。 DALL・E 2、Imagen、Stable Diffusion (SD) などの魅力的な作品は、学術界や産業界で大きな関心を集めています。

ただし、これらのモデルは驚くほどパフォーマンスが優れていますが、基本的には、指定されたテキストから画像を生成するなど、特定の種類のタスクに焦点を当てています。単独でトレーニングに専念するか、新しいモデルをゼロから構築します。

それでは、AIGC モデルの統一を達成するために、以前のモデルに基づいて「オールラウンドな」普及を構築することはできるのでしょうか?この方向を探求しようとして進歩を遂げている人もいます。

イリノイ大学アーバナシャンペーン校とテキサス大学オースティン校のこの共同チームは、既存のシングルストリーム拡散を Versatile と呼ばれるマルチストリーム ネットワークに拡張しようとしています。拡散 (VD)、最初の統合されたマルチストリーム、マルチモーダル拡散フレームワークであり、一般的な生成人工知能への一歩です。

文書アドレス: https://arxiv.org/abs/2211.08332

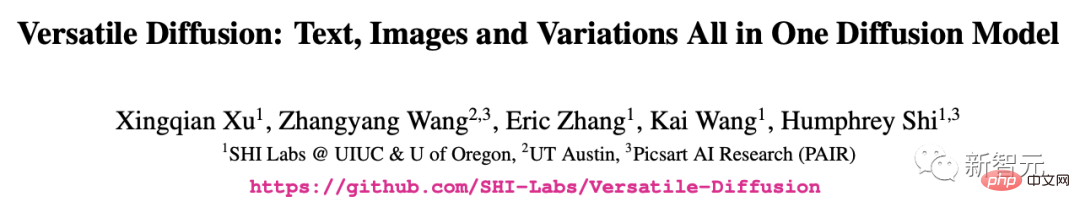

Versatile Diffusion では、通常のテキスト生成機能に加えて、画像を入力して類似の画像を生成、画像を入力してテキストを生成、テキストを入力して類似のテキストを生成、画像のセマンティック デカップリング編集、入力画像を生成することもできます。テキストからビデオを生成したり、潜在スペースに基づいて画像コンテンツを編集したりできます。

将来のバージョンでは、音声、音楽、ビデオ、3D などのさらに多くのモードもサポートされる予定です。

論文によると、VD とその基本フレームワークには次の利点があることが証明されています。

a) 使用できる競争力のある高品質ですべてのサブタスクを処理します。

b) グラフィック スタイルとセマンティクスの分離、画像とテキストの二重ガイダンスの生成など、新しい拡張機能とアプリケーションをサポートします。

c) これらの実験とアプリケーションは、生成された出力に対するより豊富な意味論的な洞察を提供します。

トレーニング データ セットに関しては、VD はカスタム データ フィルターを備えた Laion2B-en をメイン データ セットとして使用します。

最初の調査VD の興味深い発見の 1 つは、追加の監視なしで画像スタイルを意味的に強化または縮小できることです。

このような現象は、著者に、任意のスタイルと任意のコンテンツを持つ画像に対してスタイルとセマンティクスの分離が発生する可能性がある、まったく新しい分野を探求するよう促しました。

著者らは、a) ドメイン指定のない自然画像の意味論とスタイルの解釈、b) 拡散モデル潜在空間意味論的および文体分解チームを最初に探索したと述べています。

以下の画像では、作成者はまず入力画像のバリアントを生成し、次に意味論 (左) または文体論 (右) に焦点を当ててそれらを操作します。

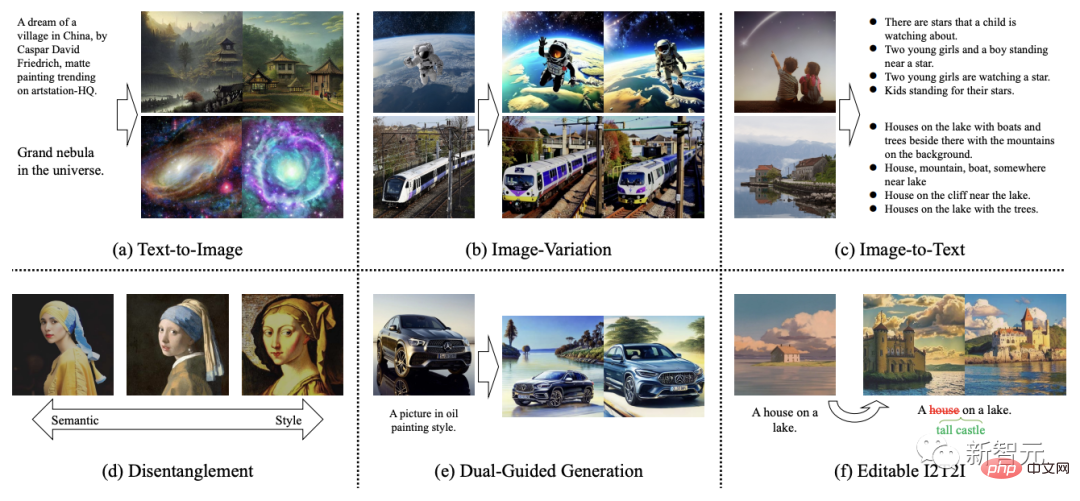

VD は画像からテキストへの変換とテキストから画像への変換の両方をサポートしているため、作成者チームは次のようにしてテキスト プロンプトの観点から初めて編集を試みました。画像以下の手順: a) 画像をテキストに変換する、b) テキストを編集する、c) テキストを画像に変換し直します。

実験では、作成者は画像から記述されたコンテンツを削除し、この画像-テキスト-画像 (I2T2I) パラダイムを使用して新しいコンテンツを追加しました。入力としてオブジェクトの位置を必要とするペイントやその他の画像編集方法とは異なり、VD の I2T2I はコマンドに応じてオブジェクトを自動的に配置して置換するため、マスクを必要としません。

ただし、I2T2I の出力画像は入力画像のピクセルと一致しません。これは、画像からテキストへの意味抽出とテキストから画像へのコンテンツ作成が原因です。

以下の表示では、入力画像が最初にプロンプトに変換され、次に減算 (赤いボックス) と加算 (緑のボックス) を使用してプロンプトが編集されます。最後に、編集されたプロンプトが画像に変換されます。

#さらに、彼らは、指定されたテキストに基づいて同様のテキストを生成することを検討した最初のチームでもあります。

ネットワーク フレームワーク

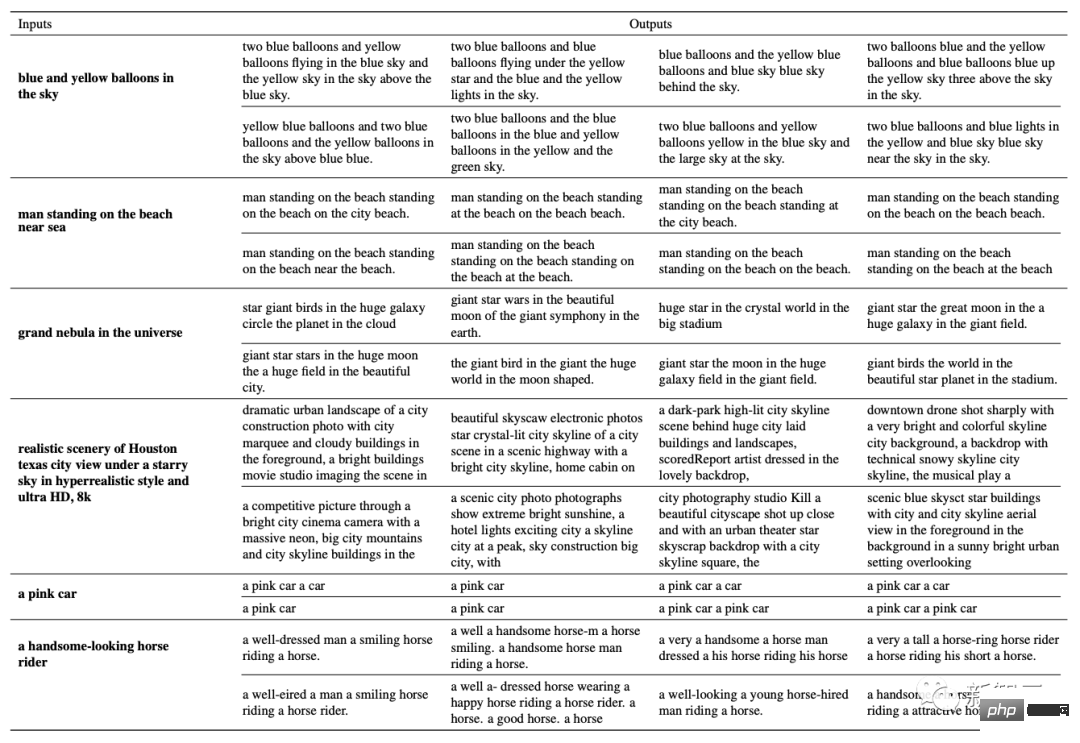

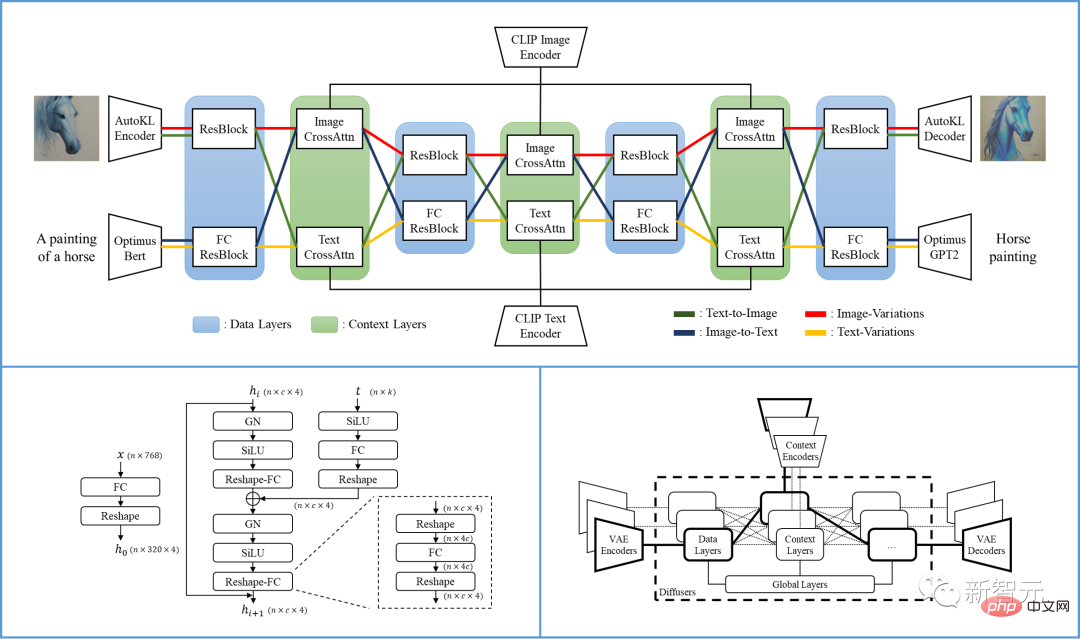

具体的には、この記事で提案されている VD フレームワークは、さまざまな種類のデータを含むマルチストリーム ネットワークです。入力と背景。

VD マルチストリーム マルチモーダル拡散フレームワークは、解釈可能な潜在空間、モーダル構造、低計算コストを備えた LDM/SD の利点を継承しています。

VD は複数のストリームを共同でトレーニングでき、各ストリームはクロスモーダル タスクを表します。その中心となる設計は、グループ化、共有、スイッチング プロトコルをネットワーク内に分散させ、サポートされているすべてのタスクやそれ以降のタスクにフレームワークを適応させることです。

#ディフューザーは、グローバル層、データ層、コンテキスト層の 3 つのグループに分かれています。グローバル層は時間埋め込み層、データ層は残差ブロック、コンテキスト層はクロスアテンションです。

このグループ化は、レイヤーの機能に対応します。複数のタスクを処理する場合、グローバル層はすべてのタスク間で共有されます。データ層とコンテキスト層には複数のデータ フローが含まれます。各データ ストリームは、現在のデータとコンテキスト タイプに基づいて共有または交換できます。

たとえば、テキスト画像リクエストを処理する場合、ディフューザーは画像データ レイヤーとテキスト コンテキスト レイヤーを使用します。画像の突然変異タスクを処理する場合、画像データ層と画像コンテキスト層が使用されます。

単一の VD プロセスには、VAE、ディフューザー、およびコンテキスト エンコーダーが含まれており、1 つのデータ タイプ (画像など) と 1 つのコンテキスト タイプ (テキストなど) でタスクを処理します (テキストから画像として)。

Versatile Diffusion のマルチストリーム構造を以下の図に示します。

研究者Versatile Diffusion に基づいて、一般的なマルチストリーム マルチモーダル フレームワークがさらに提案されます。これには、VAE、コンテキスト エンコーダ、および 3 つの層 (つまり、グローバル層、データ層、およびコンテキスト層) を含むディフューザーが含まれます。

ディフューザー:

VD は、広く採用されているクロスコンサーン UNet をメインとして使用します。ディフューザー ネットワークのアーキテクチャは、レイヤーをグローバル レイヤー、データ レイヤー、コンテキスト レイヤーに分割します。データ層とコンテキスト層には、画像とテキストをサポートする 2 つのデータ ストリームがあります。

画像データ フローには、LDM に従い、空間次元が徐々に減少し、チャネル数が徐々に増加する残差ブロック (ResBlock) を使用します。

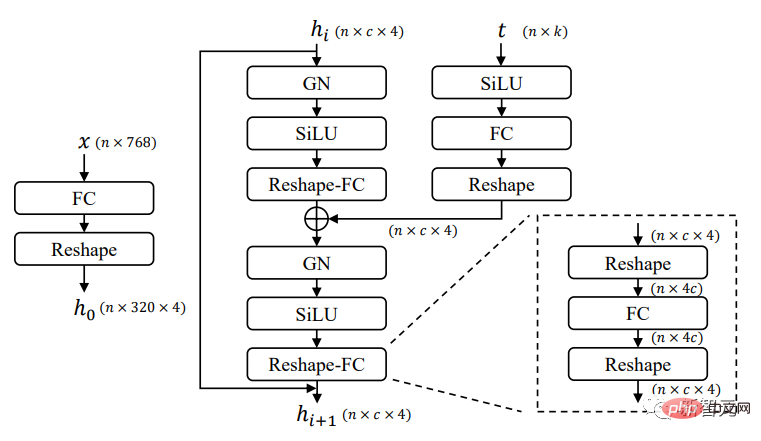

テキスト データ フローの場合、新しい全結合残差ブロック (FCResBlock) を利用して、768 次元のテキスト潜在ベクトルを 320*4 の隠れ特徴に拡張し、同様のチャネルに従います。 、通常の ResBlock と同様に、GroupNorms、SiLU を再利用し、接続をスキップします。

上の図に示すように、FCResBlock には 2 セットの全結合層 (FC)、グループ正規化 (GN)、およびシグモイド線形ユニット (SiLU) が含まれています。 x は入力テキスト潜在コード、t は入力時間埋め込み、hi は中間特徴です。

コンテキスト グループの場合、クロスアテンション レイヤーは画像ストリームとコンテキスト ストリームの両方に使用され、コンテンツの埋め込みによって投影レイヤー、ドット積、シグモイドを通じてデータ特徴が操作されます。

変分オートエンコーダ (VAE):

VD は以前の可能性を採用します。画像データVAEとしては潜在拡散モデル(LDM)のKLが用いられ、テキストデータVAEとしてはOptimusが用いられる。 Optimus は BERT テキスト エンコーダーと GPT2 テキスト デコーダーで構成されており、文を 768 次元の正規分布潜在ベクトルに双方向に変換できます。

同時に、Optimus は、再構成可能で解釈可能なテキスト潜在スペースにより、満足のいく VAE 特性も示します。したがって、マルチストリーム マルチモーダル フレームワークの前提条件によく適合するため、Optimus がテキスト VAE として選択されました。

コンテキスト エンコーダ:

VD は、CLIP テキストと画像エンコーダをコンテキスト エンコーダとして使用します。コンテキスト入力として生のテキスト埋め込みのみを使用する LDM や SD とは異なり、VD は正規化および投影された埋め込みを使用して、テキストと画像の CLIP コントラストの損失を最小限に抑えます。

実験により、コンテキスト タイプ間の埋め込みスペースが近づくと、モデルが迅速に収束し、パフォーマンスが向上することがわかりました。同様の結論は、DALL・E 2 でも達成できます。DALL・E 2 では、追加の投影レイヤーを使用してテキストから画像へのモデルを微調整し、画像のバリエーションに対するテキストと画像の埋め込みの差を最小限に抑えます。

パフォーマンス

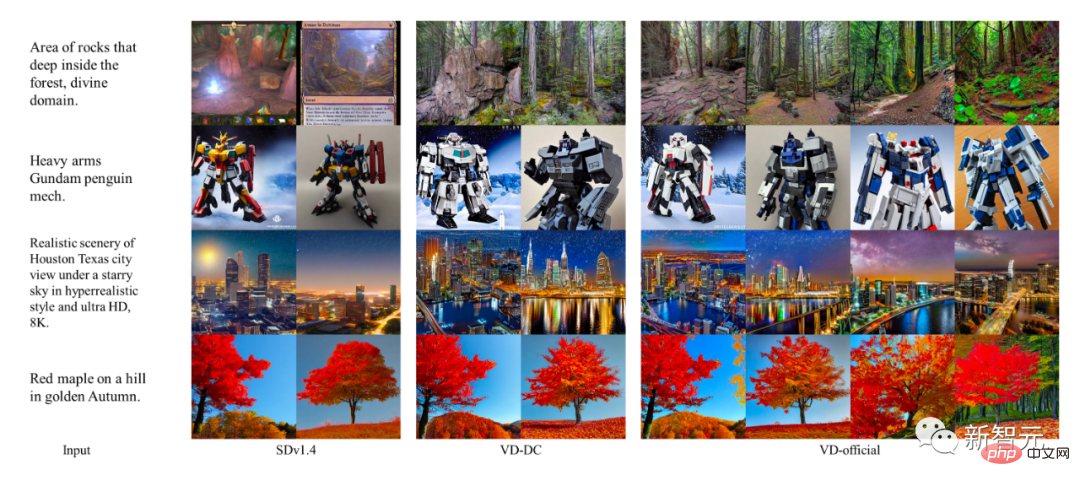

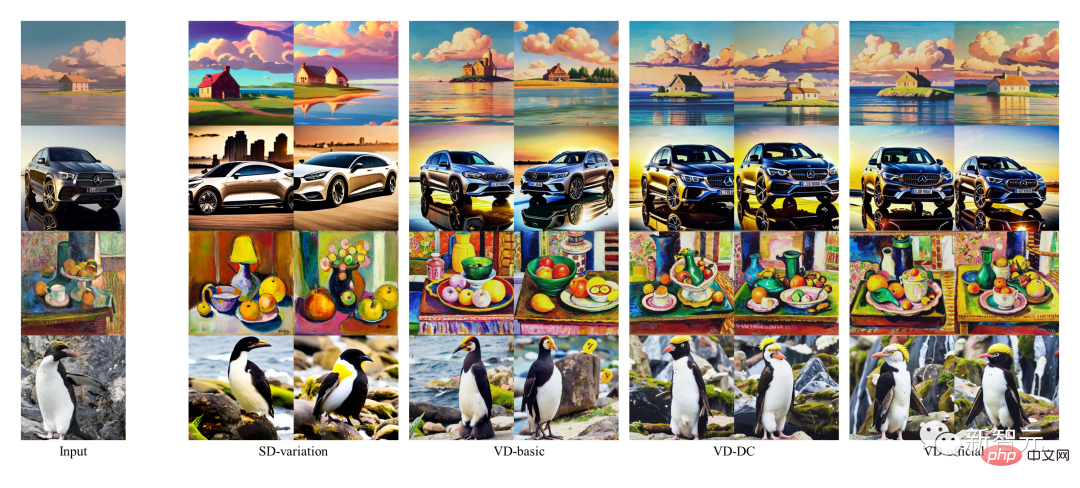

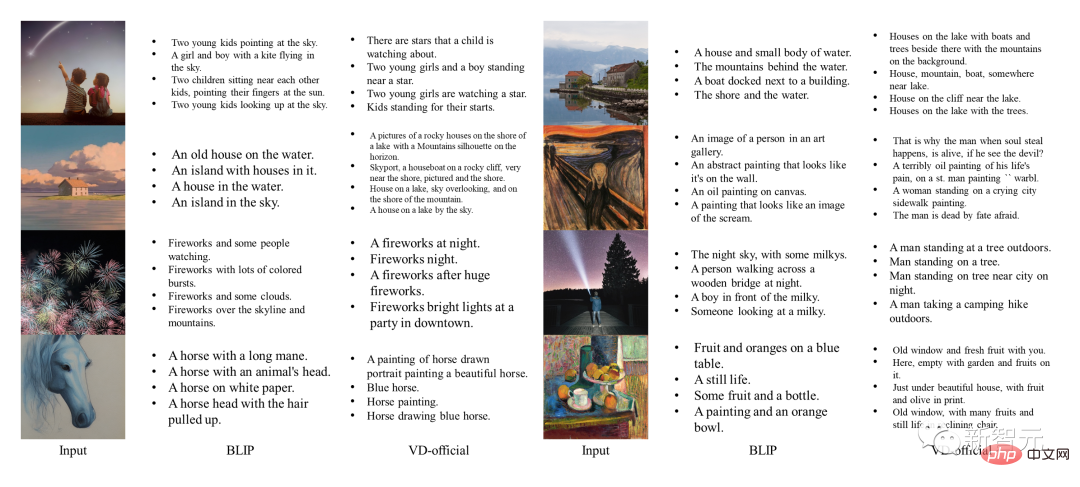

著者らは、初期のシングルタスク モデルをベースライン モデルとして使用し、VD の結果をこれらのベースラインと比較しました。このうち、テキストから画像へのベースライン モデルとして SDv1.4 が使用され、画像のバリエーションには SD-variation が使用され、画像からテキストには BLIP が使用されます。

一方、著者らはさまざまな VD モデルの定性的な比較も行っています。ここでは、VDDC と VD-official がテキストから画像に使用され、3 つのモデルすべてが画像バリアントに使用されています。

SD および VD の画像サンプルは、品質をより適切にチェックするために、制御されたランダム シードを使用して生成されます。

テキストから画像へのパフォーマンス

DALLE 2 と Imagen は状態ですがこれらのタスクでも最先端の結果が得られましたが、公開されたコードやトレーニングの詳細がないため、著者らはそれらの比較を省略しています。

結果は、マルチプロセス構造とマルチタスク トレーニングが、VD がコンテキスト セマンティクスをキャプチャして出力をより正確に生成し、すべてのサブタスクを適切に完了するのに役立つことを示しています。

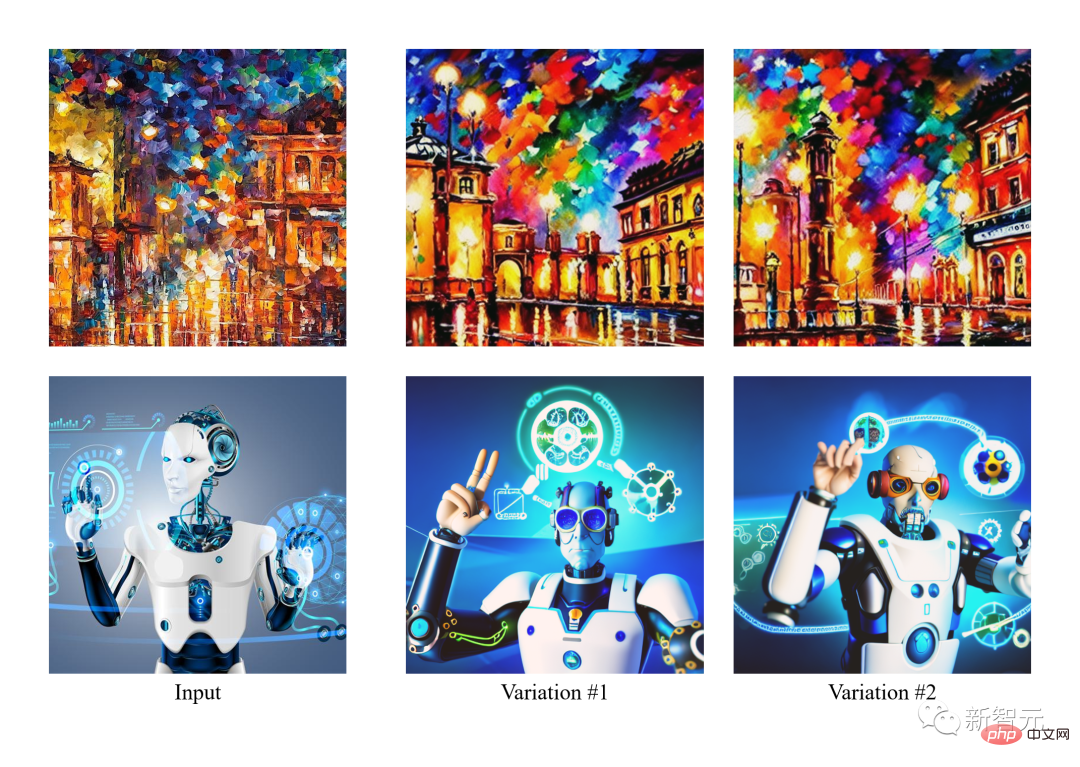

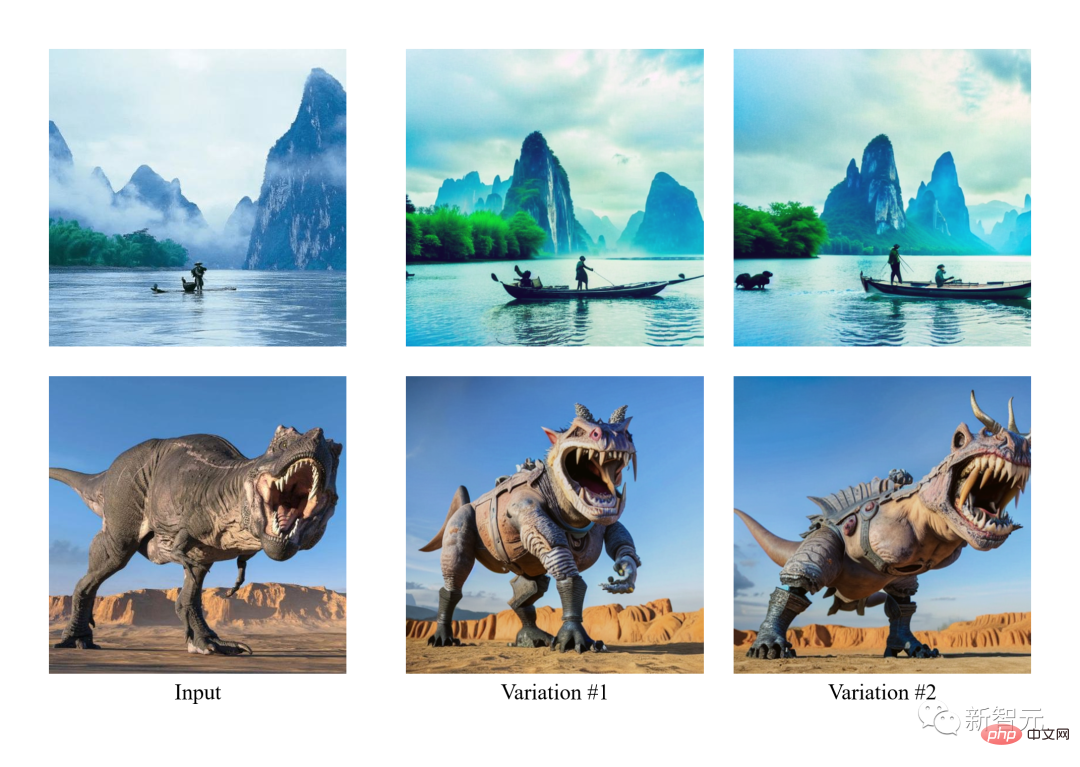

Image-Variant のパフォーマンス

また、VD によって生成されます。画像の注釈にはいくつかの創造的な単語も含まれています。それに比べて、BLIP の生成は非常に短く、詳細な説明が不足しています。

#画像からテキストへのパフォーマンス

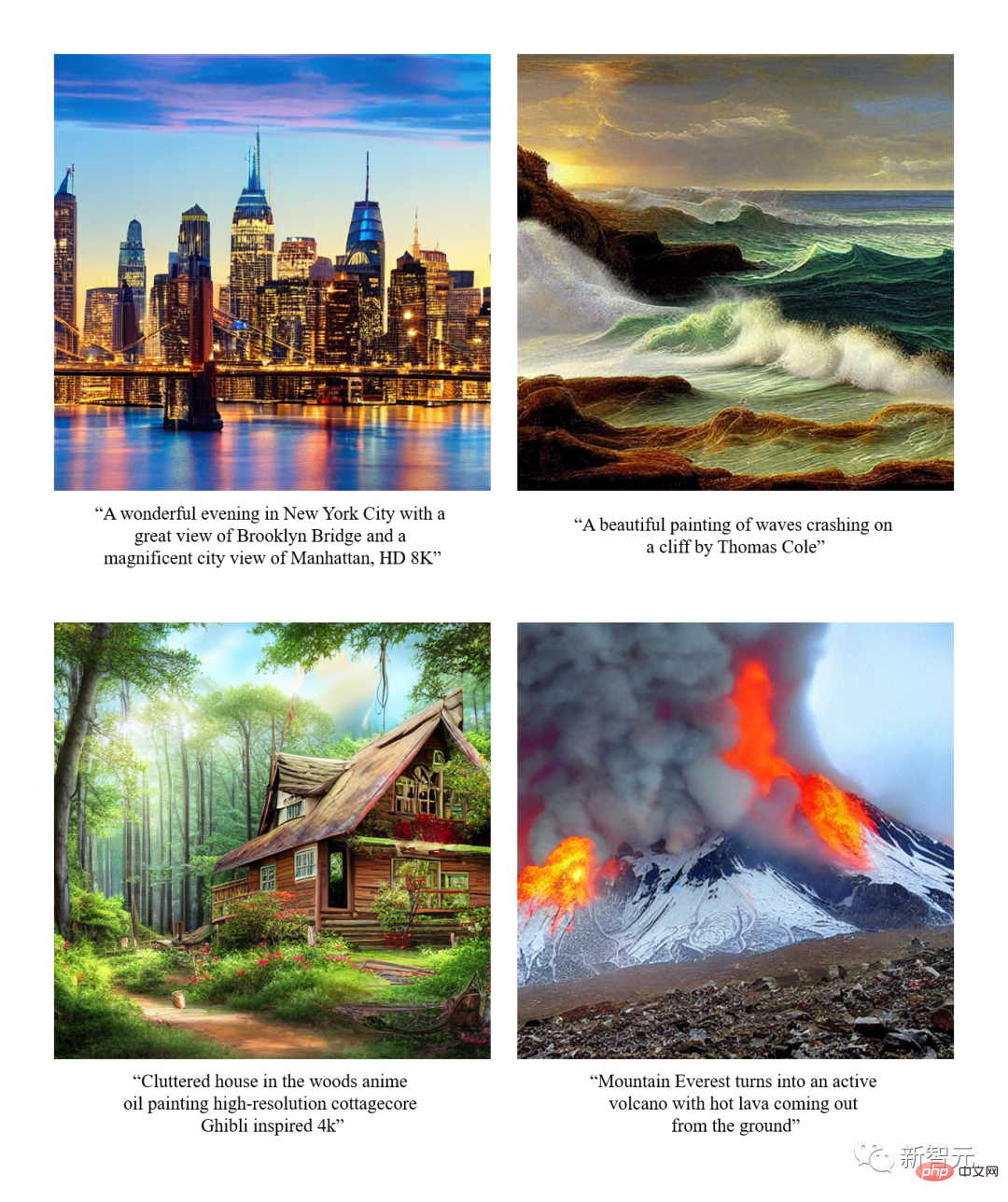

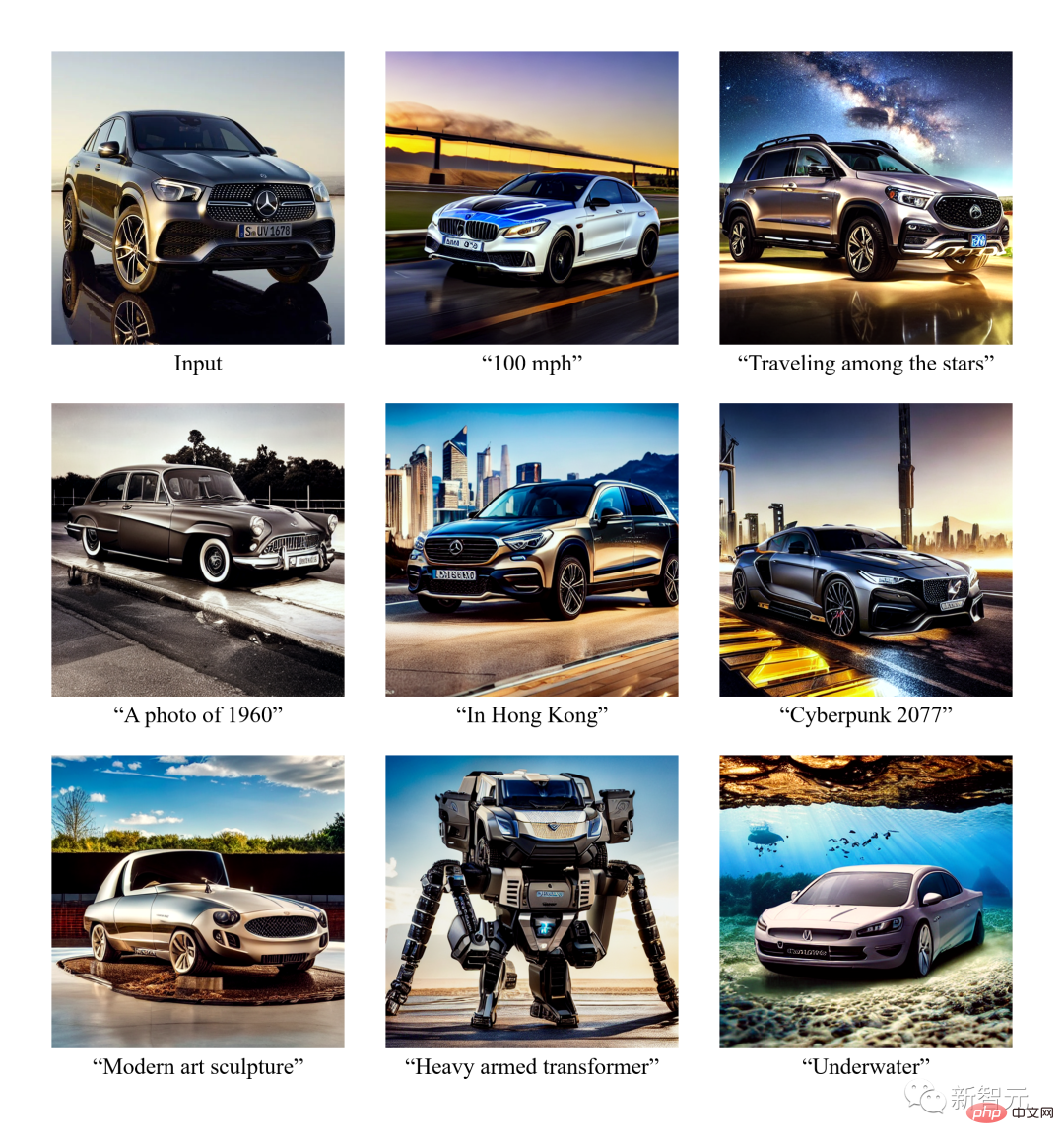

エフェクト表示

文生図

#画像バリエーション

セマンティクス付きイメージのバリエーション

デュアル ブート

概要- 著者らは、統一モデルでテキスト、画像、バリエーションに対応するマルチストリーム、マルチモーダル拡散ネットワークである Versatile Diffusion (VD) を紹介します。 VD に基づいて、著者はさらに、新しいタスクとドメインを含む可能性がある一般的なマルチストリーム マルチモーダル フレームワークを紹介します。

- 実験を通じて、著者らは、VD がサポートされているすべてのタスクで高品質の出力を生成できることを発見しました。その中で、VD のテキストから画像への結果と画像からバリアントへの結果は、コンテキスト内のセマンティクスをより適切に捉えることができます。画像からテキストへの変換結果は創造的かつ具体的なものになります。

- VD のマルチストリーム マルチモーダルな性質を考慮して、著者は、このテクノロジに取り組んでいる下流ユーザーにさらに利益をもたらす可能性のある新しい拡張機能とアプリケーションを紹介します。

イリノイ大学アーバナシャンペーン校の IFP チームは、1980 年代に Huang Xutao 教授によって設立され、当初は Beckman Advanced Science and Technology Research として設立されました。同研究所の画像形成・処理グループ。

IFP は長年にわたり、画像とビデオのコーディング、マルチモーダルな人間とコンピューターのインタラクション、マルチメディアの注釈と検索、コンピュータ ビジョンとパターン認識、機械学習、ビッグ データ、ディープ ラーニング、ハイ パフォーマンス コンピューティングなどです。

IFP の現在の研究の方向性は、ビッグデータ、ディープラーニング、ハイパフォーマンス コンピューティングを連携して組み合わせることで、マルチモーダル情報処理の問題を解決することです。

さらに、IFP は、人工知能分野のトップカンファレンスでいくつかの最優秀論文を受賞し、第 1 回 NIST TrecVID、第 1 回 ImageNet Challenge、第 1 回 Artificial コンテストなど、多くの国際コンペティションで優勝しています。インテリジェンスシティチャレンジ。

興味深いことに、黄教授が 1960 年代に MIT で教え始めて以来、IFP グループの「メンバー」には、友人、学生、学生の学生、学生の学生さえも含まれています。学生の学生。

以上がAIGC統一モデル登場! CV業界のリーダーであるHuang Xutao氏が設立したチームが提案した「全能拡散」の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。