ホームページ >テクノロジー周辺機器 >AI >スタンフォードの「Grass Mud Horse」が人気です。100 ドルで GPT-3.5 に匹敵します。携帯電話でも動作するタイプ

スタンフォードの「Grass Mud Horse」が人気です。100 ドルで GPT-3.5 に匹敵します。携帯電話でも動作するタイプ

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-11 19:24:321068ブラウズ

一夜にして、大型模型の世界でまた大きなニュースが勃発しました!

スタンフォード大学は Alpaca (アルパカ、ネチズンの口では「草泥馬」) をリリースしました。

わずか 100 ドルで、誰でも Meta の 70 億パラメータの LLaMA 大型モデルを微調整でき、効果は驚くべきものです。1,750 億のパラメータを持つ GPT-3.5 (text-davinci-003) に匹敵します。

しかも、カード 1 枚で実行できるタイプで、Raspberry Pi や携帯電話にも収納できます。

さらにすごい「生意気作戦」もあります。

研究に関係するデータセットは、スタンフォード大学のチームが OpenAI の API を使用して 500 ドル未満で生成したものです。

つまり、プロセス全体は、同等の対戦相手 AI を教える GPT-3.5 と同等です。

そしてチームは、ほとんどのクラウド コンピューティング プラットフォームを使用してトレーニング済みモデルを微調整するコストは 100 米ドル未満であるとも述べました。

GPT-3.5 効果を備えた AI のコピーは非常に効果的です。安くてとても簡単で、しかも小さいです。

さらに、チームはデータ セット (1 秒あたり 500 ドルを節約) とコードもすべてオープンソースにしました。これで、誰もが爆発的な効果をもたらす会話型 AI を微調整できるようになりました:

このプロジェクトは GitHub に公開されてからわずか半日ですが、すでに 1,800 個のスターを獲得しており、その人気の高さがわかります。

Django の共同開発者は、スタンフォード大学の新しい研究を「衝撃的な出来事」とさえ表現しました:

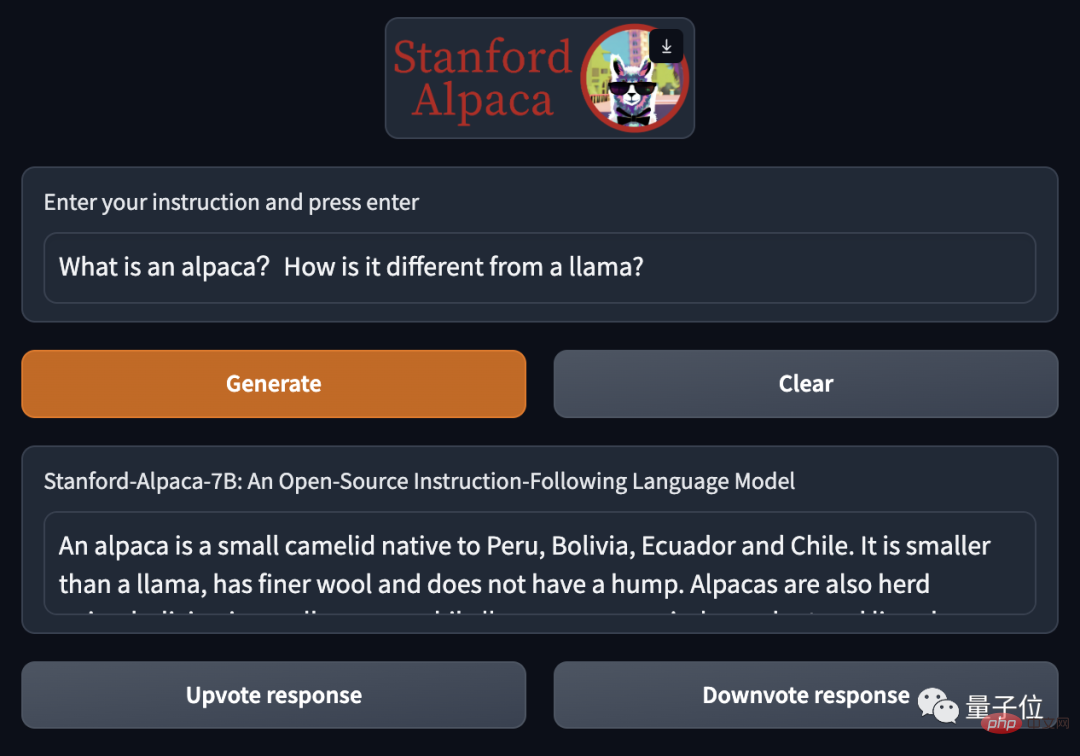

それだけでなく、スタンフォード大学のチームはデモも作成しました。オンラインでプレイできるタイプ。

それでは早速、この「草泥馬」の効果を見ていきましょう。

davinci-003 に匹敵する草泥馬 Aplica

スタンフォード大学の公式デモンストレーションでは、最初に質問がありました:

アルパカとは何ですか?ラマとの違いは何ですか?

Grass Mud Horse Aplaca の回答はより簡潔です:

アルパカは、ペルー、ボリビア、エクアドル原産の小型のラクダ科の動物です。チリはリャマよりも小さく、毛が細く、こぶがありません。

そして、集団生活をする両者の違いを簡単に紹介しました。

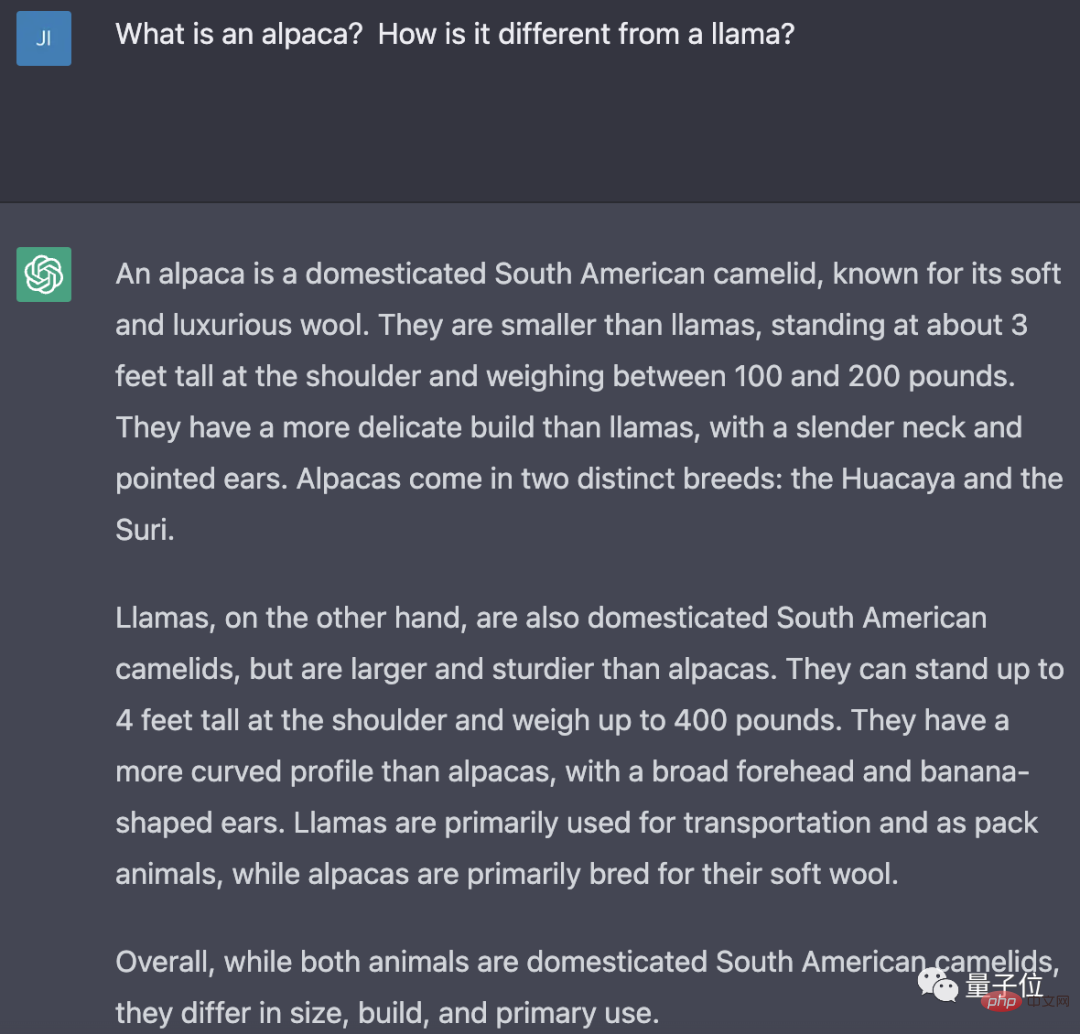

同じ質問が ChatGPT (GPT3.5-turbo) に与えられた場合、答えは Aplaca ほど簡潔ではありません:

これに関しては、チームによる説明は次のとおりです:

Alpaca の回答は通常、ChatGPT よりも短く、text-davinci-003 の短い出力を反映しています。

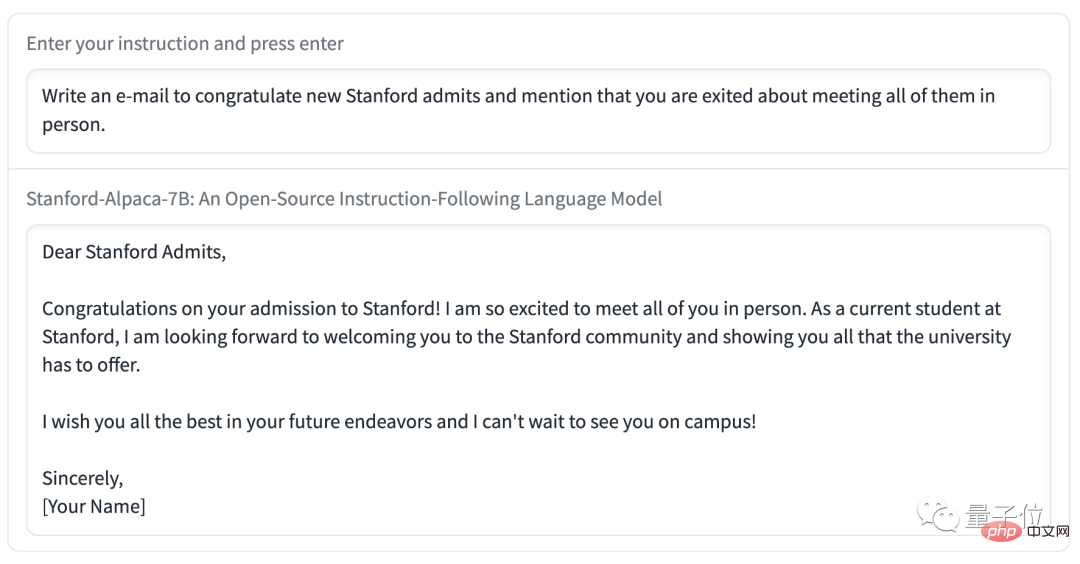

その後、チームはアルパカにメールを書かせることを実証しました:

スタンフォード大学に入学した新入生を祝福するメールを書き、彼らに直接会うことができて嬉しい旨を伝えます。

Grass Mud Horse Alpaca もこのタスクに精通しており、適切な電子メール テンプレートを直接提供しました。

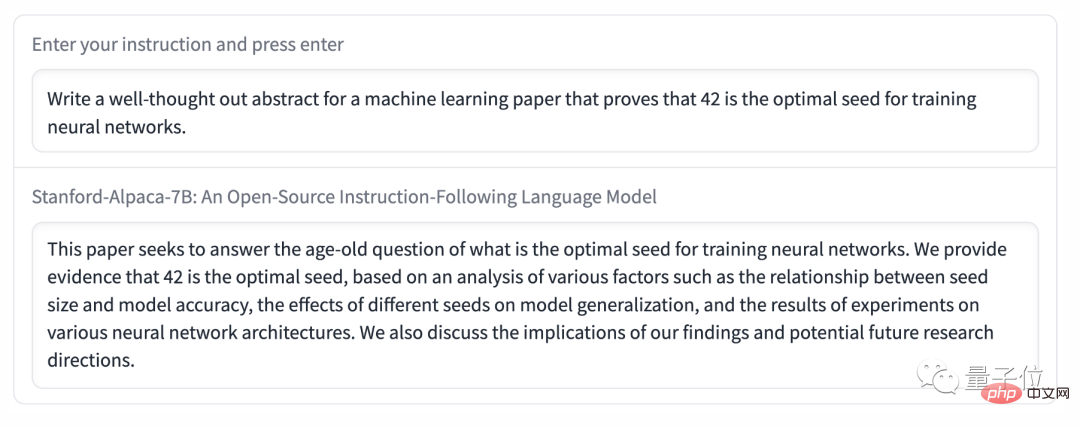

#難易度が再び上がり、チームは次のように提案しました。今回は、Alpaca が論文の要約を書く必要を満たすために:

機械学習の論文のよく考えられた要約を書き、42 がニューラル ネットワークのトレーニングに最適なシードであることを証明します。

Cao Ni Ma Alpaca 氏の回答は、内容の点でほとんどの論文の抽象的な形式と非常に一致しています。つまり、どのような質問に答えようとしているのか、どのような方法が使用されているのか、どのような結果が得られているのか、そして将来の展望があるのかなどです。 。

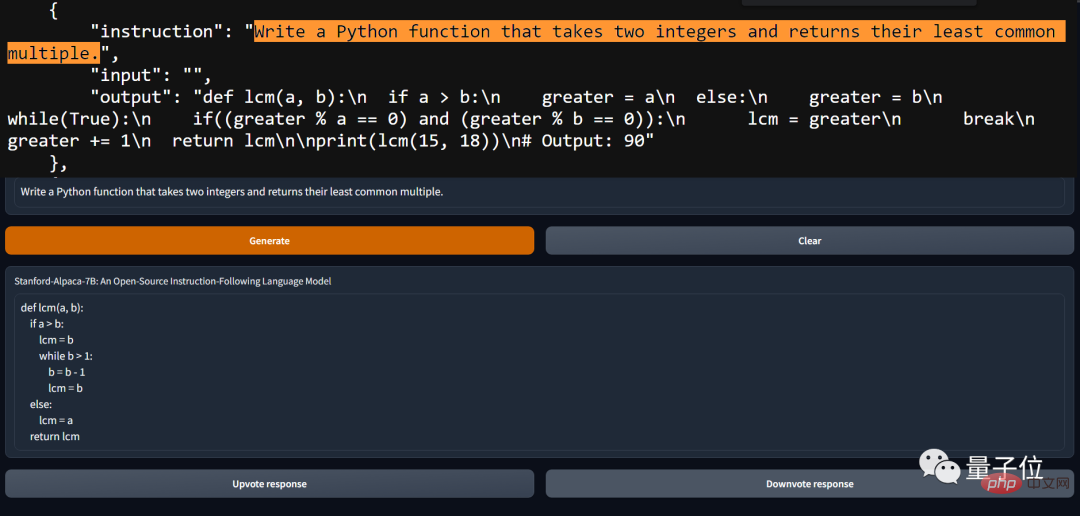

もちろん、実際にテストするのが待ちきれず、Alpaca にとってコードを書くのは簡単だと考えるネチズンもいます。

しかし、アルパカがほとんどの問題を解決できるとしても、欠点がないわけではありません。

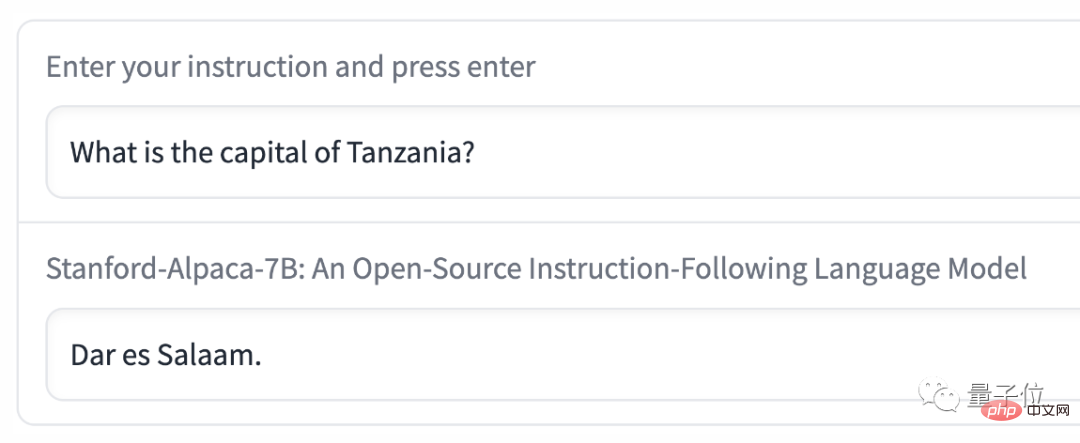

たとえば、「タンザニアの首都はどこですか?」という質問にアルパカが答えた例は、「ダルエスサラーム」でした。

しかし、実際には 1975 年にはすでに「Dodoma」に置き換えられていました。

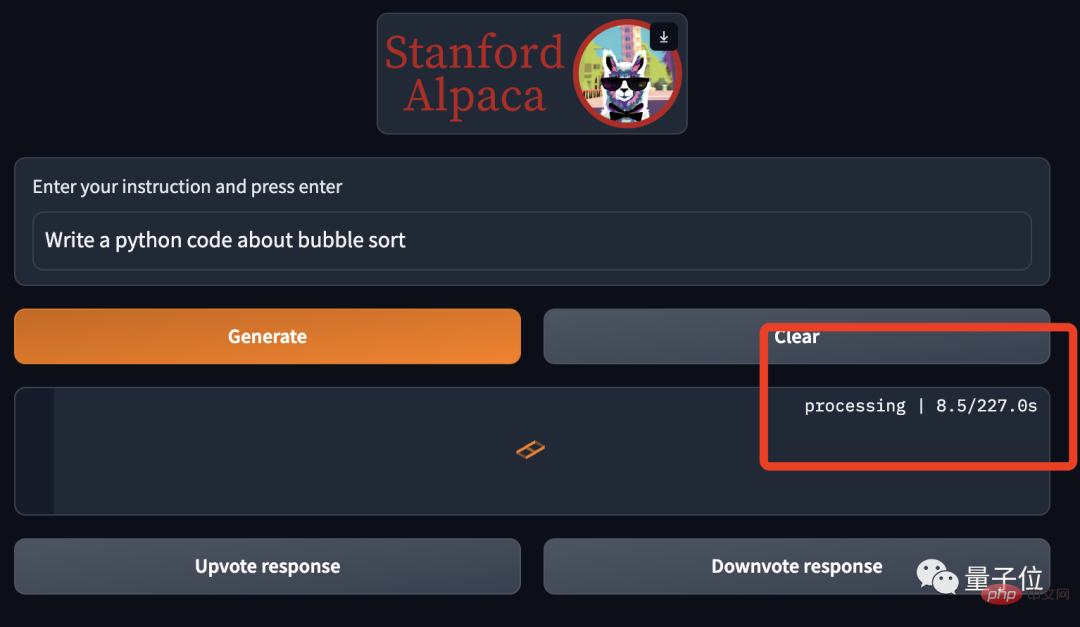

さらに、Alpaca を個人的に経験したことがある方は、それが非常に遅いことに気づくでしょう:

これに関して、一部のネチズンは、これを使用している人が多すぎるのではないかと考えています。

ノートパソコン、携帯電話、Raspberry Pi はすべて実行可能

Meta の大規模なオープンソース LLaMA モデルは、わずか数週間で整理され、誰もが理解できるようになりました。リリースすると、カードが実行されます。

したがって、理論上は、LLaMA 微調整に基づく Alpaca をローカルに簡単にデプロイすることもできます。

グラフィック カードをお持ちでなくても、Apple のラップトップ、Raspberry Pi や携帯電話でもプレイできます。

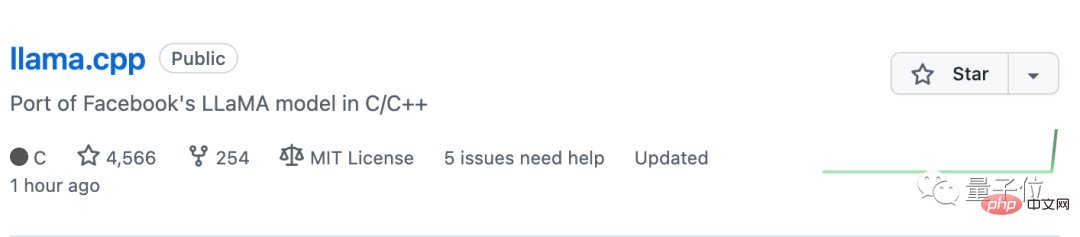

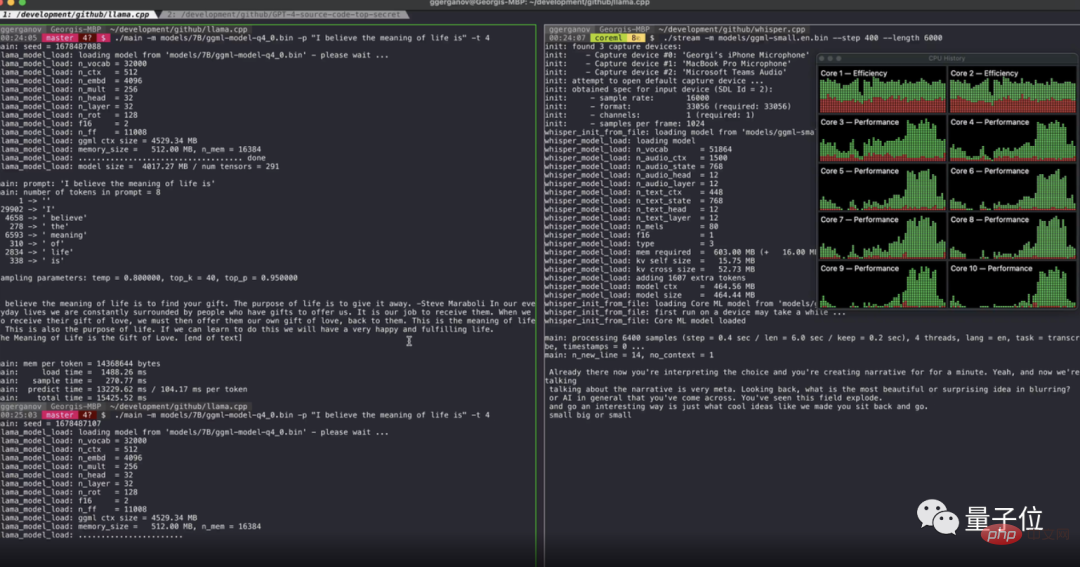

Apple ノートブックに LLaMA を展開する方法は、推論に純粋な C/C を使用し、ARM チップ用に特別に最適化された GitHub プロジェクト llama.cpp から来ています。

筆者が実際に測定したところ、M1チップを搭載したMacBook Proで動作することができ、WindowsやLinuxシステムにも対応しています。

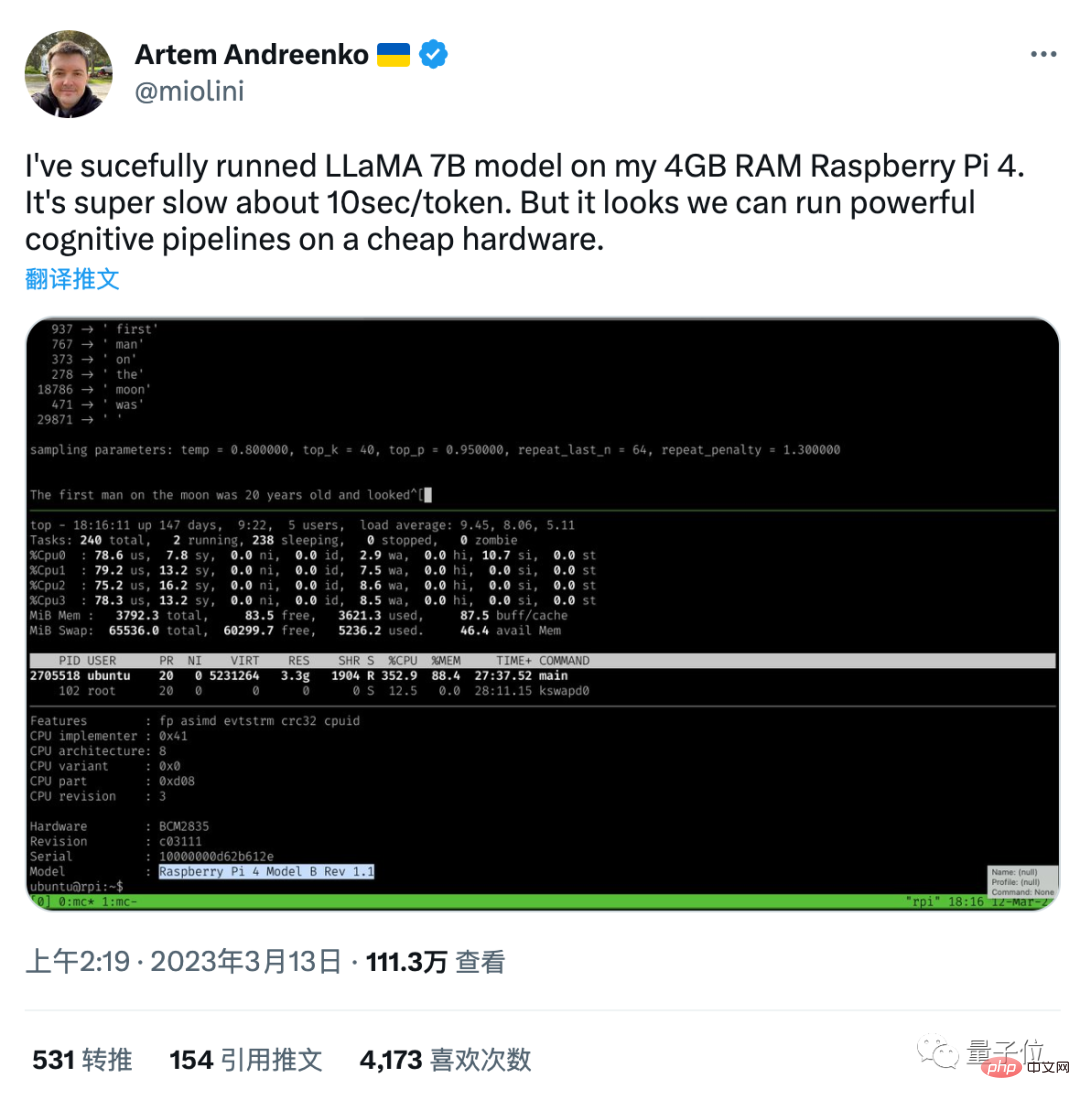

この C 移植版ですが、誰かが 4GB のメモリを搭載した Raspberry Pi 4 上で LLaMA の 70 億パラメータ バージョンを実行することに成功しました。

速度は非常に遅いですが、トークンの生成には約 10 秒かかります (つまり、1 分間に 4.5 個の単語がポップアップします)。

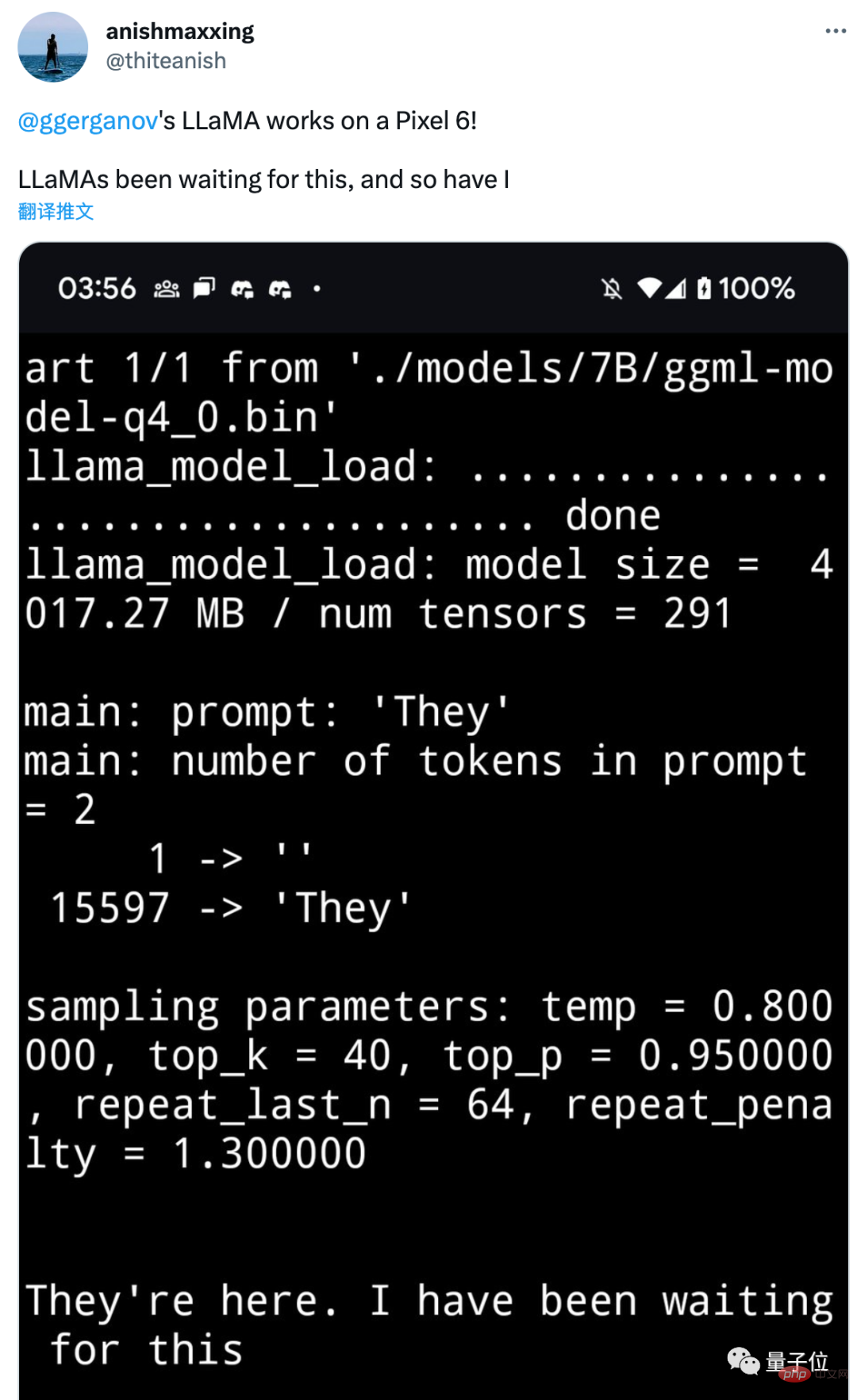

さらにとんでもないことは、わずか 2 日後、誰かが LLaMA モデルを定量化して圧縮し (重みを低精度のデータ形式に変換し)、実行に成功したことです。 Pixel 6 Android スマートフォン (26 秒に 1 トークン)。

Pixel 6 は Google が自社開発したプロセッサ Google Tensor を使用しており、その実行スコアは Snapdragon 865 と 888 の間です。つまり、理論的には新しい携帯電話でも十分な性能を発揮できることになります。

微調整データセットもオープンソースです

スタンフォード大学チームの LLaMA 微調整方法は、Yizhong Wang と Yizhong Wang が提案した Self-Instruct に基づいています。他の人たちは昨年末にワシントン大学で。

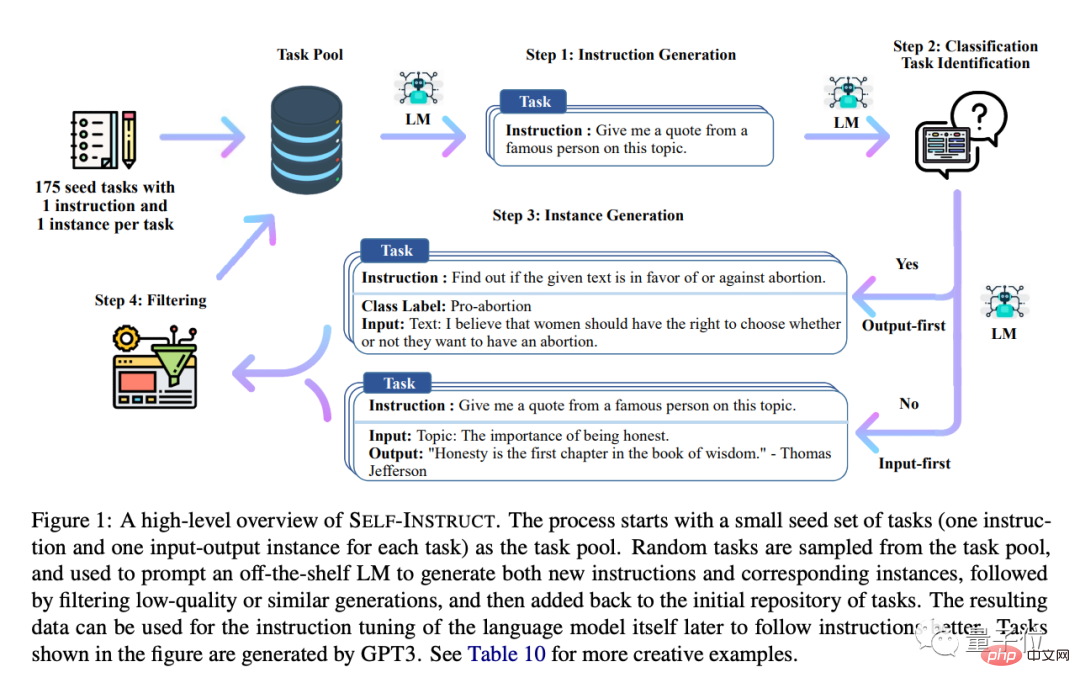

175 の質問をシード タスクとして使用し、AI に新しい質問を組み合わせて一致する回答例を生成させ、質の低い質問を手動で除外して、新しいタスクを追加します。 タスクに移動プール。

これらすべてのタスクについて、後で InstructGPT メソッドを使用して、AI に人間の指示に従う方法を学習させることができます。

マトリョーシカ人形を数周すると、AI に誘導してもらったのと同じになります。

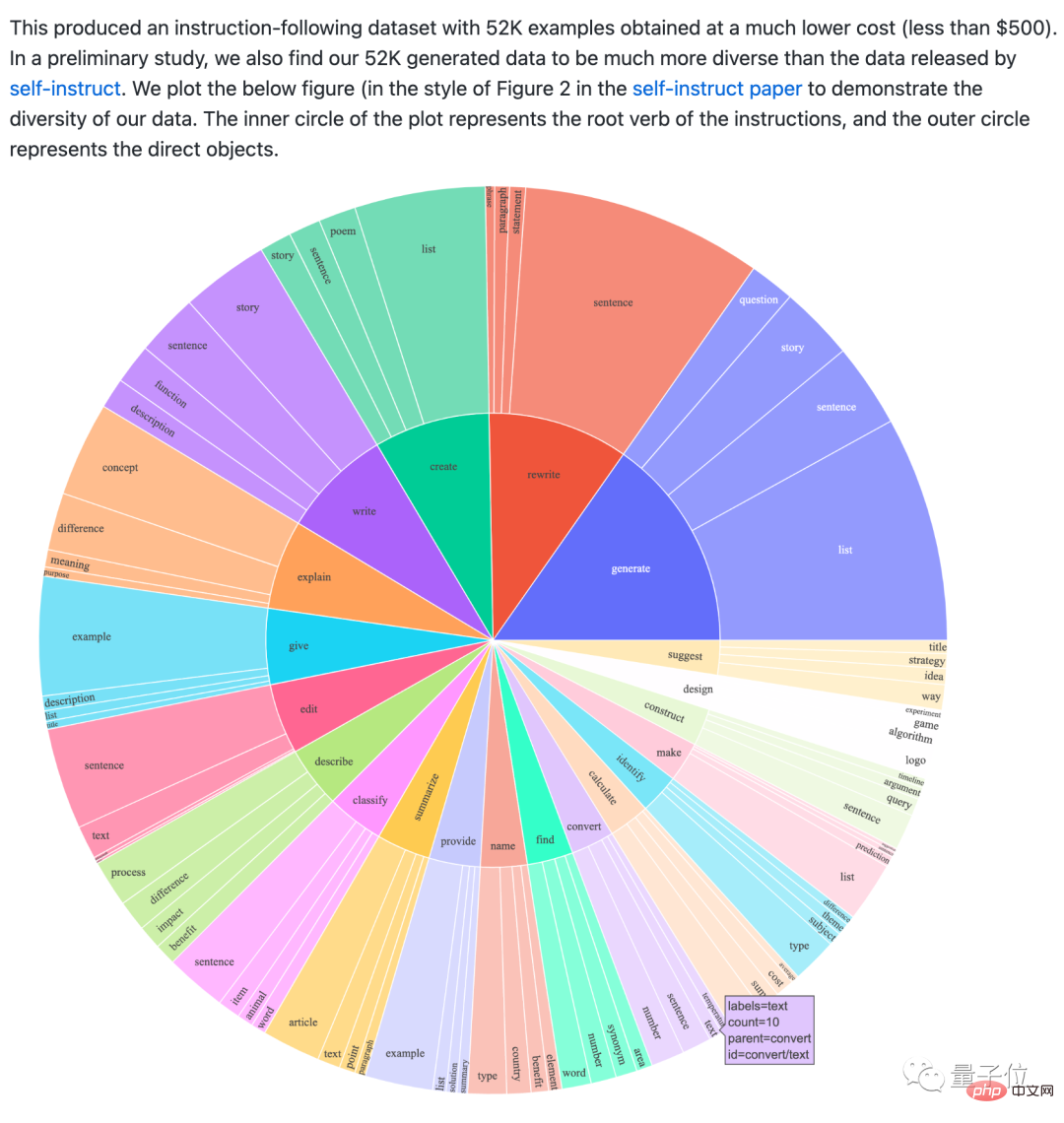

Alpaca のスタンフォード バージョンは、OpenAI API を使用して作成され、そのようなサンプルを 52,000 個生成し、500 ドル未満でした。

これらのデータもオープンソースであり、元の論文のデータよりも多様です。

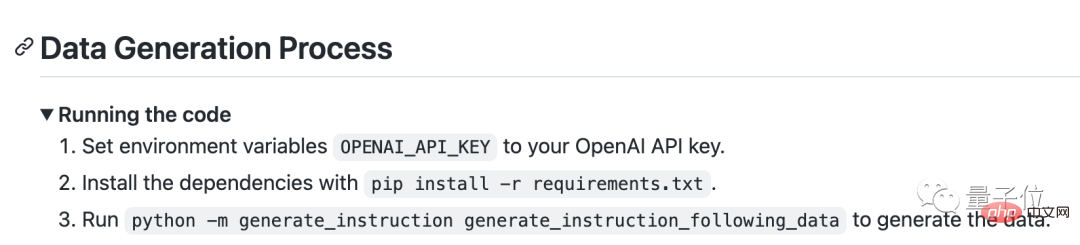

同時に、これらのデータを生成するためのコードも提供されます。つまり、まだ十分ではないと思われる場合は、拡張および微調整することができます。データ自体を使用してモデルのパフォーマンスを継続的に向上させます。

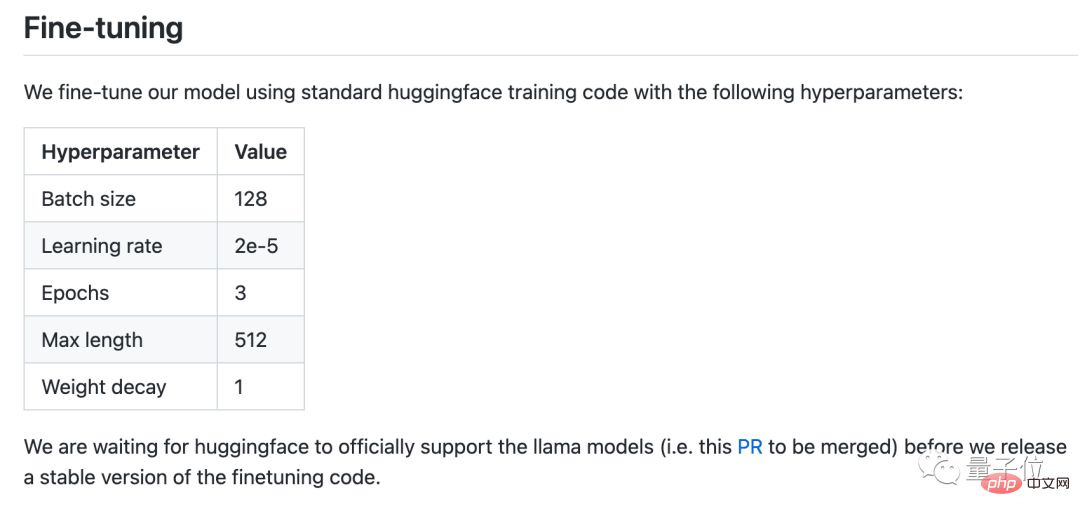

HuggingFace が LLaMA を正式にサポートした後、微調整コードもリリースされます。

ただし、Alpaca の最終モデルの重みをリリースするにはメタ ライセンスが必要であり、LLaMA の非営利オープンソース契約を継承しており、商業利用は禁止されています。

また、ファインチューニングデータにはOpenAIのAPIを使用しているため、利用規約によりOpenAIと競合するモデルの開発に使用することも禁止されています。

One More Thing

AI ペイントの開発の歴史をまだ覚えていますか?

2022 年上半期になっても、この話題は依然として熱く、8 月の Stable Diffusion のオープンソース化により、コストが実用レベルにまで下がり、爆発的なツール革新が起こり、AI ペイントがさまざまなワークフローに本格的に参入できるようになりました。 。

言語モデルのコストは、個人用電子機器が入手できるレベルまで下がりました。

最後に、Django フレームワークの創設者である Simon Willison はこう叫びました:

大規模な言語モデルの安定した普及の時期が到来しました。

以上がスタンフォードの「Grass Mud Horse」が人気です。100 ドルで GPT-3.5 に匹敵します。携帯電話でも動作するタイプの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。