ホームページ >テクノロジー周辺機器 >AI >脳内トランスフォーマーもあるよ! 「海馬」と同じ仕組み

脳内トランスフォーマーもあるよ! 「海馬」と同じ仕組み

- PHPz転載

- 2023-04-11 15:43:031760ブラウズ

作成できません、理解できません —— フェイマン

## 人工知能を作成したい場合は、まず理解する必要があります。人間の脳の原因はなんと賢いのでしょう。

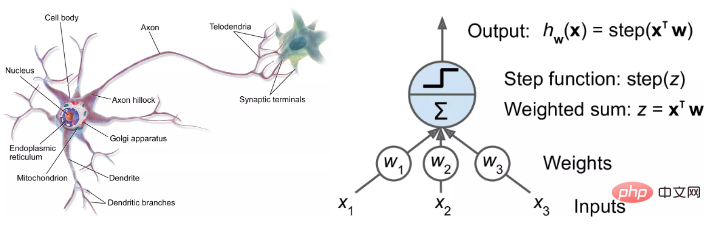

ニューラル ネットワークの誕生とその後の輝かしい発展により、研究者はニューラル ネットワークの 生物学的説明と生物学的進歩を模索してきました。新しいモデルを開発するため。

しかし、人工知能分野の研究者たちは、実際にはもっと野心的な目標を掲げています。AI モデルを使用して脳の理解を助ける 。

最近の研究では、最も人気のある Transformer モデルは 生物学的知識の助けを借りずに開発されたものであるにもかかわらず、その構造は非常によく似ていることが判明しました。人間の脳の海馬構造に。

紙のリンク: https://arxiv.org/pdf/2112.04035.pdf

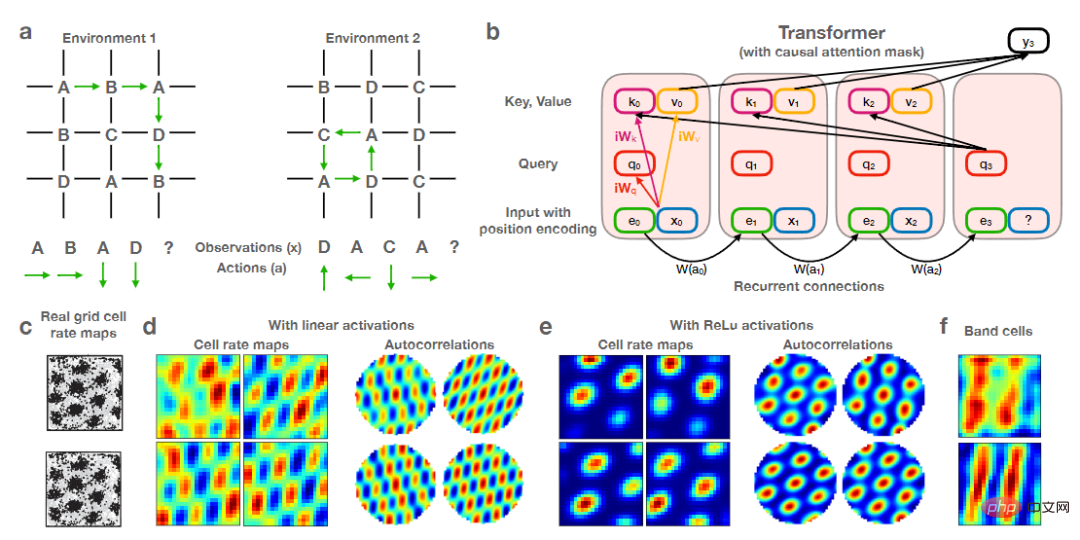

研究者らは、Transformer に再帰的位置エンコーディングを装備した後、モデルが海馬形成の 空間表現を正確に再現できることを発見しました。

しかし、著者は、Transformer は神経科学における現在の 海馬モデル (最も明白なモデル) と密接に関連しているため、この結果には驚かないとも述べています。 配置セル

(配置セル)とグリッドセル(グリッドセル)です。 さらに、実験を通じて、Transformer モデルは神経科学バージョンで提供されるモデルと比較してパフォーマンスが大幅に向上していることがわかりました。

この研究は、人工ニューラル ネットワークと計算脳ネットワークを組み合わせて、海馬と大脳皮質の間の相互作用について新たな理解を提供し、皮質領域がどのように広範囲の機能を実行するかを示唆しています。言語理解など、現在の神経科学モデルを超えた複雑なタスク。Transformer は海馬をシミュレートしますか?

人間が自分自身の脳を理解することは依然として困難です。たとえば、「私たちがどこにいるのか、角を曲がったところに何があるのか、そこにどうやって行くのか」を解決するために、脳がどのように空間情報を整理してアクセスするかを研究することは、 「まだまだ気の遠くなるような課題です。課題です。」 プロセス全体には、メモリ ネットワーク全体と、それぞれが他の数千のニューロンに接続されている数百億のニューロンからの保存された空間データの呼び出しが含まれる場合があります。

神経科学者は、位置をマッピングするグリッド細胞やニューロンなど、いくつかの重要な要素を特定しましたが、さらに深く進む方法は依然として不明です。研究者は移動できません。人間の灰白質のスライスを分割して研究して見ることができます。画像、音、匂いの位置ベースの記憶がどのように流れ、相互に結びつくのか。人工知能モデルは、人間の脳を理解する別の方法を提供します。長年にわたり、神経科学者はさまざまな種類のニューラル ネットワークを使用して、脳内のニューロンの発火をシミュレートしてきました。

最近の研究では、海馬 (記憶に重要な脳の構造) が基本的にトランスフォーマー モデルに似ていることが示されています。

研究者らは、新しいモデルを使用して、脳の内部動作と同様の方法で空間情報を追跡し、いくつかの注目すべき結果を達成しました。

オックスフォード大学とスタンフォード大学の認知神経科学者であるジェームス・ウィッティントン氏は、これらの脳モデルがトランスフォーマーと同等であることがわかれば、次のように述べています。これは、新しいモデルのパフォーマンスが向上し、トレーニングが容易になることを意味します。

Whittington らの研究で見られるように、Transformer は、グリッド セルや脳の他の部分によって実行されるさまざまな計算を模倣するニューラル ネットワーク モデルの能力を大幅に向上させることができます。

Whittington 氏は、このようなモデルによって、人工ニューラル ネットワークがどのように機能するか、さらには脳内で計算がどのように実行されるかについての理解が進む可能性があると述べています。

Google Brain のコンピューター科学者で、主に Transformer モデルの研究に従事している David Ha 氏は、「私たちは新しい脳を作り直そうとしているわけではないが、新しい脳を作り直すメカニズムは作れるだろうか」と述べています。脳は何ができるの?

Transformer は、自然言語を処理する人工知能の新しいモデルとして 5 年前に初めて提案され、BERT や GPT-3 などの「スター モデル」の秘密兵器でもありました。 。これらのモデルは、説得力のある歌詞を生成したり、シェイクスピアのソネットを作曲したり、人間による顧客サービス業務を行ったりすることができます。

Transformer の中核となるメカニズムは自己注意であり、各入力 (単語、ピクセル、シーケンス内の数値など) が常に他のすべての入力に接続されます。その他 一般的なニューラル ネットワークは、入力を特定の入力に接続するだけです。

Transformer は自然言語タスク専用に設計されましたが、その後の研究により、Transformer が画像の分類などの他のタスクでもうまく機能することが証明され、現在では脳がモデル化されています。

2020年、オーストリアのリンツにあるヨハン・ケプラー大学のコンピューター科学者ゼップ・ホッホライター氏(LSTM論文の筆頭著者)が率いるチームは、トランスフォーマーを使用して強力で長寿命のシステムを再利用しました。用語 既存のメモリ検索モデルのホップフィールド ネットワーク。

プリンストンの物理学者ジョン ホップフィールドによって 40 年前に最初に提案されたこれらのネットワークは、同時に活動するニューロンが相互に強い接続を確立するという一般規則に従っています。

ホッホライターと彼の共同研究者らは、研究者は常に記憶回復のより良いモデルを探しており、新しいクラスのホップフィールドネットワークがどのように記憶を回復し、トランスフォーマーがどのように注意を実行するかを観察したと述べました。 。

MIT-IBM ワトソン人工知能研究所のホップフィールドとドミトリー クロトフによって開発されたこれらの新しいホップフィールド ネットワークは、標準のホップフィールド ネットワークよりも効率的な接続を特徴としており、より多くのメモリを保存および取得できます。

論文リンク: https://papers.nips.cc/paper/2016/hash/eaae339c4d89fc102edd9dbdb6a28915-Abstract.html

Hochreiter のチームは、Transformer のアテンション メカニズムと同様のルールを追加することで、これらのネットワークをアップグレードしました。

2022 年に、この新しい論文は Hochreiter の方法をさらに調整し、Transformer を修正して、メモリを線形シーケンスとして扱うのではなく、文中の単語の文字列のように扱い、メモリを次のようにエンコードするようにしました。高次元空間の座標。

研究者らは、この「ひねり」により、神経科学タスクにおけるモデルのパフォーマンスがさらに向上すると述べています。実験結果は、このモデルが神経科学者が fMRI スキャンで見るグリッド細胞の発火パターンのモデルと数学的に同等であることも示しました。

ユニバーシティ・カレッジ・ロンドンの神経科学者キャズウェル・バリー氏によると、グリッド細胞は、印象的なパターンを持つ刺激的で美しく規則的な構造をしており、ランダムに出現する可能性が高すぎるという。

この新しい研究は、トランスフォーマーが海馬で観察されたパターンをどのように正確に再現するかを示しています。

また、Transformer モデルは、以前の状態とどのように移動したかに基づいて、重要な方法で、モデルがどこにあるのかを把握できることにも気づきました。従来のグリッドセルモデルに組み込まれます。

他の最近の研究でも、トランスフォーマーが他の脳機能の理解を進めることができることが示唆されています。

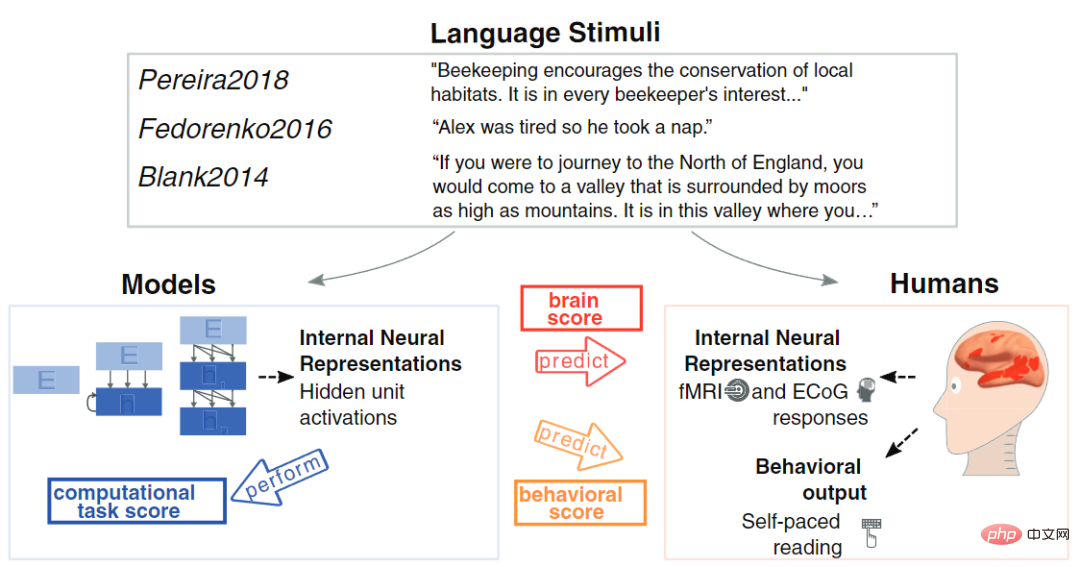

昨年、MIT の計算神経科学者 Martin Schrimpf は、fMRI と皮質電図検査によって報告される人間の神経活動測定に対するそれらの影響を理解するために、43 の異なるニューラル ネットワーク モデルを分析しました。

彼は、Transformer が現在最先端の最先端のニューラル ネットワークであり、画像処理で見られるほぼすべての変化を予測できることを発見しました。

David Ha 氏と Yujin Tang 氏はコンピューター科学者でもあり、最近、意図的に大量のデータをランダムかつ無秩序な方法で Transformer に入力し、人体がどのように変化するかをシミュレートできるモデルを設計しました。データを脳に送信し、感覚観察を送信します。 Transformer は、私たちの脳と同じように、無秩序な情報の流れをうまく処理できることが判明しました。

紙のリンク: https://arxiv.org/abs/2111.14377

Yujin Tang 氏は、ニューラル ネットワークは配線されており、特定の入力しか受信できないと述べました。しかし現実では、データセットは急速に変化することが多く、ほとんどの AI には調整する方法がありません。将来的には、すぐに適応できるアーキテクチャを試してみたいと考えています。

以上が脳内トランスフォーマーもあるよ! 「海馬」と同じ仕組みの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。