ホームページ >テクノロジー周辺機器 >AI >DPU が ChatGPT と衝突すると、コンピューティングの電力効率にどのような火花が生じるでしょうか?

DPU が ChatGPT と衝突すると、コンピューティングの電力効率にどのような火花が生じるでしょうか?

- PHPz転載

- 2023-04-11 09:51:021446ブラウズ

DPU 開発は高速レーンに入ると予想されます。 DPU(Data Processing Unit)は、CPU、GPUに続く「第3のメインチップ」とみなされます。スマートネットワークカードソリューションの段階的な成熟、世界的なサーバー出荷の着実な成長、L3以上のスマート運転車両の技術導入、産業制御分野での需要の増加により、世界および国内のDPU業界は、次のような目標を達成すると予想されています。急速な発展。 。

世界の DPU 市場は引き続き活況を呈しており、国内の DPU 市場も追いつくために加速しています。 CCID Consulting の「 中国 DPU 産業発展白書 」によると、2020 年の世界の DPU 産業市場規模は 30 億 5,000 万米ドルに達し、世界の DPU 産業市場規模は 24.53 米ドルを超えると予想されています。 2025 年までに 10 億人、複合成長率は 51.73% に達しました。

2020 年の中国の DPU 産業市場規模は 3 億 9,000 万元に達し、2025 年までに中国の DPU 産業市場規模は 565 億 9 千万元を超え、複合成長率は 170.6% になると予想されています。

DPU 業界チェーン分析:

DPU ミッドストリーム リンク (DPU チップ メーカー): 海外の大手企業が一時的にリードしており、国内メーカーも準備を整えています。 Toubao Research Institute のデータによると、2020 年の国内 DPU 市場では、NVIDIA、Broadcom、Intel という国際的な大手 3 社のシェアがそれぞれ 55%、36%、9% に達しました。国内メーカーでは、ファーウェイ、アリババ、百度、テンセントも近年、データ、ストレージ、セキュリティを主な機能とする自社サーバー用DPUの自社開発・外注を行っている。

DPU アップストリーム リンク: EDA、IP などはすべて研究開発の重要な基盤です。国内EDA市場は長らく国際的な大手3社によって独占されてきましたが、将来的には躍進が期待されています。需要と供給が連携して IP コア産業を育成し、将来の需要が新たなチャネルを開拓します。半導体のローカリゼーションは進化を続けており、カンブリアンやベリシリコンなど、国内のIPサプライヤーが希少価値の高い地位を占めることになるでしょう。

DPU ダウンストリーム アプリケーション: 複数の開花、明るい将来の見通し。中核となる DPU 市場は、サーバーをハードウェア キャリアとして使用するデータ センターを中心に展開しており、下流のシナリオはクラウド コンピューティング、ハイ パフォーマンス コンピューティング、ネットワーク セキュリティ、エッジ コンピューティング、その他の分野をカバーしています。国内の観点から見ると、ハイテク、デジタルトランスフォーメーション、端末消費など、多様なコンピューティングパワー需要シナリオが常に出現しており、コンピューティングパワーエンパワーメント効果が顕著です。

ChatGPTをはじめとするAI技術の開発動向により、コンピューティングパワーの需要が顕在化しており、DPUは発展の黄金期を迎えると予想されており、世界および国内のDPU業界市場規模は年々増加傾向にあります、中核企業は業界の発展傾向から恩恵を受けることが期待されます。

DPU は「第 3 のメインチップ」となる見込み

DPU (データ処理チップ Data Process Unit) は「第 3 のメインチップ」と考えられている「CPU、GPUに次ぐ3番目のメインチップ」。 DPU (Data Processing Unit) は、新開発の専用プロセッサです。 NVIDIAが2020年に発表したDPU製品戦略では、CPU、GPUに次ぐデータセンターにおける「第3のメインチップ」と位置付けられている。チップ業界の製造プロセスの継続的な改善と AI などのデジタル技術の開発により、チップ業界は革新を続けています。新しいタイプのチップとしての DPU の登場は、ヘテロジニアス コンピューティングにおける画期的な出来事です。

1. コンピューティング能力の向上とデータの増加の間にはギャップがあり、DPU の需要が強調されています

DPU は専用のデータ処理コアです。データ処理ユニットは、従来のコンピューティング リソースのネットワーク、セキュリティ、ストレージのオフロード プラットフォームです。従来のデータセンターはメインのデータ処理ユニットとして CPU を使用しており、巨大なインフラストラクチャの運用は通常 CPU コアのかなりの部分を占め、データ処理タスクに大きな課題をもたらします。

DPU は、初期のネットワーク プロトコル処理のオフロードからその後のネットワーク、ストレージ、仮想化のオフロードに至るまで、実際には長い間業界に存在してきました。

観覧車のデータによると、Amazon の AWS は 2013 年の初めに Nitro 製品を開発しました。これにより、データセンターのすべてのオーバーヘッド (仮想マシン、暗号化と復号化、障害追跡、セキュリティ ポリシー、その他のサービス プログラム用のリモート リソースの提供) が負担されました。 ) into 専用アクセラレータで実行されます。 Nitro アーキテクチャは、軽量のハイパーバイザーとカスタマイズされたハードウェアを使用して、仮想マシンのコンピューティング (主に CPU とメモリ) サブシステムと I/O (主にネットワークとストレージ) サブシステムを分離し、PCIe バスを通じてそれらを接続することで、CPU リソースを 30% 節約します。

2016 年から 2017 年にかけて、Alibaba Cloud は X-Dragon システム アーキテクチャを提案しました。そのコアは MOC カードであり、コンピューティング リソース、ストレージ リソース、ネットワーク リソースなどの比較的豊富な外部インターフェイスを備えています。 MOC カードの中核である X-Dragon SOC は、ネットワーク、I/O、ストレージ、周辺機器の仮想化を均一にサポートし、仮想マシン、ベアメタル、コンテナ クラウドに統合されたリソース プールを提供します。

NetEase と Xinxixi のデータによると、2019 年にアメリカの新興企業 Fungible が F1DPU 製品を発売し、DPU の概念を初めて提案しました。 2020 年 10 月、NVIDIA は Mellanox ソリューション DPU に基づくスマート NIC を命名し、DPU の概念を再定義しました。 2020年にNvidiaが発表したDPU製品戦略では、DPUをCPU、GPUに次ぐデータセンターの「第3のメインチップ」と位置づけ、業界でのブームを巻き起こした。

2. コスト削減と効率向上を目標に、DPU は業界の問題点に直接取り組みます

DPU が解決したい中心的な問題は「コスト削減と効率向上」です。インフラストラクチャの「低い CPU 処理効率、GPU で処理できない負荷は専用の DPU にオフロードされ、コンピューティング システム全体の効率が向上し、システム全体の総所有コスト (TCO) が削減されます。」

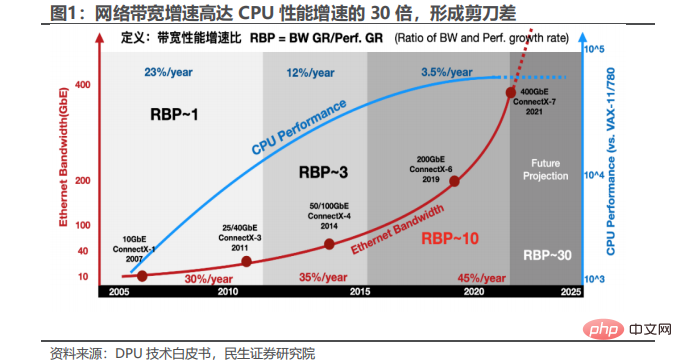

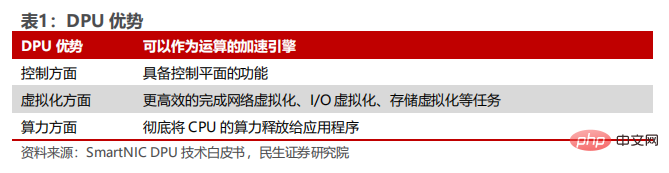

過剰な CPU リソース負荷は業界の問題点であり、スマート NIC は DPU の前身です。通信分野では、5G 時代の到来、クラウド ネットワーク統合、仮想スイッチングなどのテクノロジーの導入により、サーバーベースのネットワーク データ プレーンの複雑さが大幅に増加しました。大量のデータ転送作業が CPU によって負担されるため、ネットワーク インターフェイスの帯域幅が急激に増加し、過剰な CPU リソース負荷が発生し、アプリケーションに計算能力を解放する CPU の能力に大きな影響を及ぼします。ホスト CPU の処理パフォーマンスを向上させるために、スマート NIC (インテリジェント ネットワーク カード) は、CPU の一部のネットワーク機能 (IP フラグメンテーション、TCP セグメンテーションなど) が、計算を高速化する目的でネットワーク カード ハードウェアに転送され、DPU の前身と見なすことができます。 。新世代の DPU の利点は、コンピューティングの高速化エンジンとして機能するだけでなく、ネットワーク仮想化、I/O 仮想化、ストレージなどのタスクをより効率的に実行できるコントロール プレーンの機能も備えていることです。仮想化を実現し、CPU の計算能力を最大限に活用し、アプリケーションにリリースします。

# 機能面では、DPU は基本サービスの統合、ネットワーク データの高速化、ゼロトラスト保護、コンピューティングとコンピューティングの分離などの複数の機能を備えています。ストレージ。現在の CPU の計算能力がアプリケーションに十分に適用できないこと、データ処理速度の遅さ、クレジットによるデータ漏洩、ストレージ ソリューションの互換性の低さなど、多くの問題を効果的に解決できます。具体的には:

1. DPU は、ビジネスとインフラストラクチャの運用分離を実現します。 DPU は、インフラストラクチャ タスクを CPU から DPU に転送し、CPU リソースを解放して、より多くのサーバー CPU コアをアプリケーションの実行とビジネス計算の完了に使用できるようにし、サーバーとデータ センターの効率を向上させます。

2.DPU はネットワーク データをオフロードしてパフォーマンスを向上させます。 DPU はクラウド ネイティブ環境向けに最適化されており、データ センター レベルのソフトウェア デファインドおよびハードウェア アクセラレーションによるネットワーキング、ストレージ、セキュリティ、および管理サービスを提供します。 Programmer Inn のデータによると、Red Hat のコンテナ化されたサービスとしてのクラウド プラットフォーム (PaaS) 0penShift は DPU を使用してデータセンターのリソース使用率を最適化し、ネットワーク関連のデータ処理 (VxLan や IPSec など) を DPU にオフロードして実行を高速化します。 25Gb/秒のネットワーク条件では、Open Shift は高速化のために DPU をデプロイし、わずか 1/3 の CPU 使用率で 25Gb/秒のパフォーマンスを達成できます。一方、100Gb/秒のネットワーク条件では、DPU をデプロイしないシナリオは 100Gb 未満に達します。 /秒のネットワーク回線速度により、DPU は 10 倍のパフォーマンス上の利点をもたらします。

3.DPU は、ゼロ トラスト セキュリティ保護を提供できます。ゼロ トラストは、次の考えに基づいたセキュリティ中心のモデルです: 企業は、社内外のあらゆるものにデフォルトの信頼オプションを付与すべきではありません。ゼロトラストはデータ漏洩を軽減し、不正アクセスを拒否できるため、データセキュリティの点で非常に価値があります。

方法: DPU は、コントロール プレーンをホストから DPU に分散することで企業にゼロトラスト保護を提供し、ホスト ビジネスとコントロール プレーンの完全な分離を実現します。データは侵入できず、セキュリティが確保されます。 。

DPU の出現は、独立した安全なインフラストラクチャ サービスとサーバー アプリケーション ドメインからの安全な分離を提供するために、各サーバーに「コンピューターの前のコンピューター」を装備することに相当します。ホストが侵害された場合、セキュリティ制御エージェントと侵害されたホスト間の DPU 分離層により、データ センター全体への攻撃の拡大が防止されます。このように、DPU は、企業がセキュリティ エージェントをコンピューティング プラットフォームに直接展開することに消極的である状況を解決します。アプリケーション ドメインから完全に分離された DPU にセキュリティ エージェントを展開することで、企業はアプリケーションのワークロードを可視化し、インフラストラクチャ全体に一貫したセキュリティ ポリシーを適用できます。

4.DPU は「コンピューティングとストレージの分離」の実現に役立ちます。BlueField SNAP テクノロジー ソリューションは、サーバー システムのデータ エントランスにコンピューティング リソースを導入し、アプリケーションのニーズを満たすストレージ ソリューションを DPU 上で独立して実装し、データセンターのストレージ メーカーを支援します。既存のソフトウェア スタックを変更することなく、高度なストレージ プロトコルを低コストで柔軟に導入およびアップグレードできます。ストレージ メーカーは、オープン システムの直接接続ストレージ (DAS)、垂直方向の拡張 (スケールアップ)、水平方向の拡張 (スケールアウト)、ハイパーコンバージド アーキテクチャ (ハイパーコンバージド)、およびさまざまな業界アプリケーション向けに自社のチームが開発したその他のストレージ ソリューションを使用できます。さまざまなアプリケーション分野の既存のビジネス処理プラットフォームやデータセンター インフラストラクチャにオーバーヘッドなしで拡張でき、セキュリティ暗号化、データ圧縮、負荷分散などの複雑で必要な機能はすべて DPU によって完全に透過的にオフロードされます。ストレージ業界の革新的なアルゴリズムと実装は、サーバー オペレーティング システムとは独立して DPU アーキテクチャに導入できます。 DPU テクノロジーは、ストレージ メーカーが真の「コンピューティングとストレージの分離」を実現し、自社製品の技術的利点を最大限に活用し、アプリケーションのニーズに最も効率的に応えるチャネルを開拓するのに役立ちます。

3. スマート ネットワーク カードに依存し、FPGA およびハイブリッド アーキテクチャのルートが主流になっています

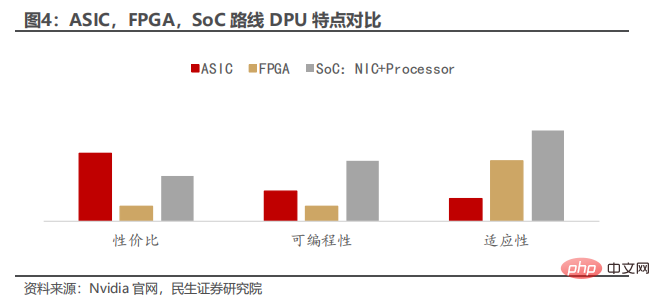

スマート NIC は、複数の CPU コアと FPGA ベースの ASIC を含む DPU の前身と見なすことができますスマート ネットワーク カードおよびその他のタイプ。テクノロジーが進化するにつれて、FPGA、ASIC、SoC は相互に統合され、それらの間の境界線はますます曖昧になっていきます。たとえば、FPGA の発展に伴い、多くの FPGA には従来の意味での ASIC であるハードコアが組み込まれていますが、ハードウェア プログラマビリティの観点から見ると、SoC は FPGA の逆であり、ASIC とみなすことができます。特定の機能チップのみを指すのではなく、プログラム可能ではありません。

NIC は、ネットワーク インターフェイス カードの略です。基本的に、NIC はサーバーまたはストレージ ボックスに接続してイーサネット ネットワークに接続する PCIe カードです。 DPU ベースのスマート NIC は、単純な接続を超えて、ベース NIC の場合、CPU が NIC 上で実行する必要があるネットワーク トラフィック処理を実装します。

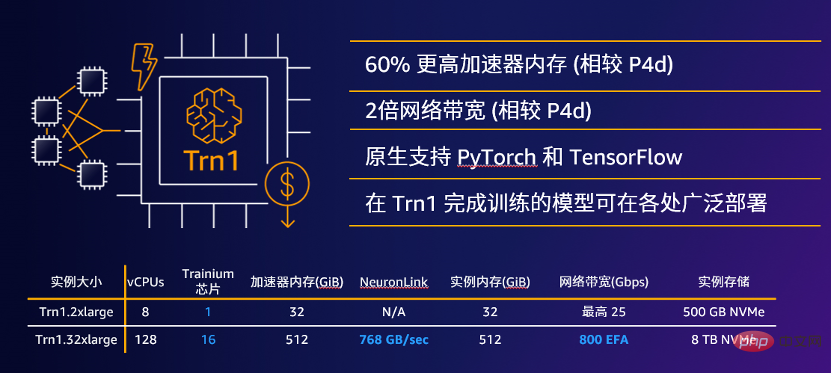

DPU ベースのスマート NIC は、ASIC、FPGA、および SoC ベースにすることができます。これらの異なるルートの間には、コスト、プログラミングの容易さ、柔軟性の点でさまざまなトレードオフがあります。 1) ASIC は費用対効果が高く、最高の価格/パフォーマンスを提供しますが、柔軟性が限られています。 NVIDIA ConnectX-5 などの ASIC ベースの NIC は、比較的単純なプログラム可能なデータ パスを持つことができます。最終的に、機能は ASIC で定義された機能に基づいて制限されるため、特定のワークロードがサポートされなくなる可能性があります。 2) 対照的に、FPGA NIC (NVIDIA Innova-2 Flex など) は高度にプログラム可能です。十分な時間と労力があれば、利用可能なゲートの制約内で、ほぼすべての機能を比較的効率的にサポートできます。ただし、FPGA はプログラミングが難しく、高価であることで有名です。 3) より複雑な使用例の場合、Mellanox BlueField DPU – プログラマブル スマート NIC などの SOC は、最良と思われる DPU ベースのスマート NIC 実装を提供します。

4. DPU の核となる価値は、コンピューティング能力のオフロード、解放、拡張にあり、異種コンピューティング能力の相互接続により、迅速な開発が促進されます。

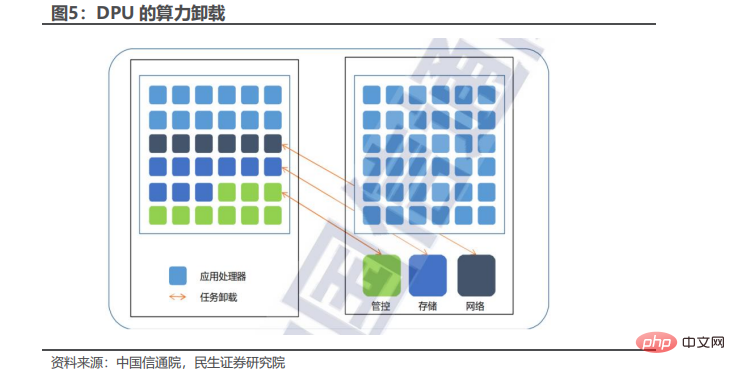

1. 計算能力のオフロード: つまり、DPU を使用してデータ処理のいくつかの基本機能を統合し、これらの機能を CPU からオフロードして、一部のアプリケーションの CPU の計算能力を向上させます。 DPU の価値の一部は、コンピューティング能力のこの部分、つまり DPU 自体のコストのコスト削減に反映されます。したがって、DPU が節約するコンピューティング能力が多ければ多いほど、または DPU のコストが低いほど、DPU がもたらす価値は高くなります。同時に、DPU の特殊化により、DPU がネットワーク、ストレージ、セキュリティ、管理に関連する一部の制御機能をオフロードした後、ビジネス パフォーマンスが向上するため、DPU の価値のもう 1 つの部分は、ビジネスとユーザー エクスペリエンスのために節約できる時間。

Technology Neighbor のデータによると、大規模なデータ センターのシナリオでは、DPU のコンピューティング パワー オフロード機能を使用してデータ センターの税金を削減できます。データセンターでのトラフィック処理はコンピューティング リソースの 30% を占めるため、AWS では、ビジネス プログラムを実行する前にネットワーク データへのアクセスによって占有されるこれらのコンピューティング リソースを「データ センター税」と呼んでいます。

データ セキュリティ シナリオでは、DPU はその独立した安全なアーキテクチャにより、一部の暗号化および復号化アルゴリズムを DPU ハードウェアで強化し、物理的に分離された方法で大量のデータにおけるユーザーのデータ セキュリティ問題を解決できます。外部ネットワーク ビジネス テナント間のセキュリティ層。

2. 中国情報通信技術学院のデータによると、計算能力の解放: 計算能力の解放では、メモリや周辺機器に複数回アクセスするための CPU 介入は必要なく、不必要なデータ転送、コピー、コンテキストの切り替えを回避し、データをネットワーク カード ハードウェアに直接保存し、データを処理して最終消費まで配信するアプリケーション。従来の CPU 中心のコンピューター アーキテクチャでは、データ処理中にカーネルとアプリケーションの間でデータを複数回コピーしてアクセスする必要があり、これによりパフォーマンスが大幅に低下します。データ中心の DPU アーキテクチャは、データ処理における CPU の過度の関与の問題を効果的に改善できます。CPU はデータ処理プロセスに参加する必要がなく、データはアプリケーション、関連する GPU、またはストレージ デバイスに直接送信されます。過度の CPU 負荷によって引き起こされるパフォーマンスのボトルネックや例外を効果的に回避します。

DPU アーキテクチャとテクノロジにより、サーバー上で実行されるビジネス アプリケーションとオペレーティング システム カーネルが、シンプルなローカル ストレージ アクセス API を使用して、分散型、ハイパーコンバージド、またはソフトウェア デファインド ストレージ システムへの効率的かつ透過的なアクセスを実現できるようになります。ストレージメーカーは、ダイレクトアタッチドストレージ(DAS)、垂直拡張(スケールアップ)、水平拡張(スケールアウト)、ハイパーコンバージドアーキテクチャ(ハイパーコンバージド)、およびさまざまな業界アプリケーション向けに開発されたその他のストレージソリューションをゼロコストで推進できます。さまざまなアプリケーション分野の処理プラットフォームやデータセンター インフラストラクチャにおいて、セキュリティ暗号化、データ圧縮、負荷分散などの複雑で必要な機能はすべて、DPU によって透過的に完全にオフロードされます。ストレージ業界の革新的なアルゴリズムと実装は、DPU アーキテクチャ内のサーバー オペレーティング システムとは独立して導入できます。

DPU テクノロジーは、ストレージ メーカーが真の「コンピューティングとストレージの分離」を実現し、自社製品の技術的利点を最大限に活用し、アプリケーションのニーズに応える最も効率的な方法を開くのに役立ちます。

3. 計算能力の拡張: 計算能力の拡張により、輻輳を効果的に回避し、分散アプリケーションのタスク サイクルで時間を消費する通信の割合を大幅に削減し、大規模クラスターを改善することで、ノード間のネットワーク通信のボトルネックを排除します。ディメンション クラスターの全体的なコンピューティング能力を計算します。コンピューティング能力を向上させるために、業界は複数の道で進化し続けています。汎用 CPU では、シングルコアおよびシングルスレッドの性能向上やオンチップのマルチコアの拡張によって演算能力を大幅に向上し続けることは困難です。シングルコアチップのプロセスが3nmにアップグレードされてから開発が停滞しましたが、複数のコアを重ねて演算能力を高めることで、コア数が増えると単位演算能力あたりの消費電力も大幅に増加します。 256 コア、総計算能力レベルを直線的に向上させることはできません。コンピューティングユニットのプロセス進化はベースラインに近づき、大規模なコンピューティングパワーの需要を満たすために、コンピューティングクラスターの規模を拡大し、ネットワーク帯域幅を増加し、分散システムによるネットワーク遅延を短縮することがコンピューティングパワーを向上させる主な手段となっています。データセンタークラスターの数。

5. DPU はヘテロジニアス コンピューティング パワーの相互接続を推進し、アプリケーション市場はハイテク産業の多くの分野をカバーしています

ヘテロジニアス コンピューティング パワーの相互接続は、GPU、FPGA、ASIC またはその他のアクセラレータ カードと CPU の間で行われます。データの接続。 CPU とアクセラレータ カード間、およびアクセラレータ カード間で形成されるチップ相互接続テクノロジの採用が増加しています。PCIe は非常に一般的な標準化された設計ですが、限られた帯域幅がボトルネックとなります。 CXLやGen-Zなどの次世代インターコネクト技術は急速な発展を遂げています。DPUは、さまざまな高速インターコネクトプロトコルを統合するためのサンドボックスとして、柔軟な高速インターコネクトキャリアとなるのに最適です。」相互接続プロトコルは、単一シャーシの外でサブマイクロ秒のレイテンシ技術を拡張する機会をもたらし、次世代コンピューティング アーキテクチャの革新の可能性を生み出します。

情報化の構築と応用の深化に伴い、市場は拡大を続けており、通信、インターネット、インテリジェント運転、AIサーバーなどの業界におけるDPU産業アプリケーションの需要は成長し続けています。

1) 電気通信分野では、大手 3 事業者が積極的に展開し、製品検証を推進しており、業界チェーンのメーカーと協力して DPU 業界の発展を促進する意向です。

2) インターネット分野では、クラウド コンピューティング、クラウド ネイティブ、その他のビジネス シナリオの開発ニーズに伴い、データセンター進化の焦点として DPU が大手クラウド ベンダーから広く注目されています。大手メーカーは、コストを削減し、効率を高めて利益を最大化するために、自己研究や戦略的協力にリソースを投資してきました。

3) インテリジェント運転の分野では、国内外のチップメーカーがインテリジェント運転の展開を加速し、研究開発効率を継続的に改善し、DPU 市場開発の基礎を築いています。

4) AIサーバー等の分野については、デジタル経済や「東のデジタル化、西のコンピューティング」等の政策の影響を受け、中国のAIサーバー、金融、端末官公庁等の分野急速な発展を続けており、コンピューティング能力に影響を与えています。需要の増大に伴い、従来のテクノロジーでは現在のビジネス開発ニーズを満たすことができなくなりました。DPU は、成熟したハードウェア アクセラレーション ソリューションを提供し、システム全体の効率を向上させることができます、AIサーバー、金融、その他の分野の開発に対する技術サポートを提供し、DPU業界の将来の開発プロセスを包括的に促進します。

以上がDPU が ChatGPT と衝突すると、コンピューティングの電力効率にどのような火花が生じるでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。