ホームページ >テクノロジー周辺機器 >AI >ChatGPTはモデルを自分で選択できる!マイクロソフト アジア研究所 + 浙江大学の注目の新しい論文、HuggingGPT プロジェクトがオープンソースになりました

ChatGPTはモデルを自分で選択できる!マイクロソフト アジア研究所 + 浙江大学の注目の新しい論文、HuggingGPT プロジェクトがオープンソースになりました

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-11 08:41:021038ブラウズ

ChatGPT によって引き起こされた AI ブームは、金融界も「炎上」させました。

最近、ブルームバーグの研究者らは、金融分野の GPT、つまり 500 億のパラメーターを備えたブルームバーグ GPT も開発しました。

GPT-4 の登場により、多くの人が大規模言語モデルの強力な機能を体験できるようになりました。

#ただし、OpenAI はオープンではありません。業界の多くの人々が GPT のクローンを作成し始めており、多くの ChatGPT 代替モデルはオープン ソース モデル、特に Meta オープン ソース LLMa モデルに基づいて構築されています。

#例えば、スタンフォード大学のAlpaca、CMUと提携したカリフォルニア大学バークレー校、スタンフォード大学などのVicuna、スタートアップDatabricksのDollyなど。

さまざまなタスクやアプリケーション向けに構築されたさまざまな ChatGPT のような大規模言語モデルは、100 の考え方を示しています。フィールド全体の可能性。

そこで問題は、研究者が複雑なタスクを完了するために適切なモデル、さらには複数のモデルをどのように選択するかということです。

最近、Microsoft Research Asia と浙江大学の研究チームは、大規模モデル コラボレーション システムである HuggingGPT をリリースしました。

論文アドレス: https://arxiv.org/pdf/2303.17580.pdf

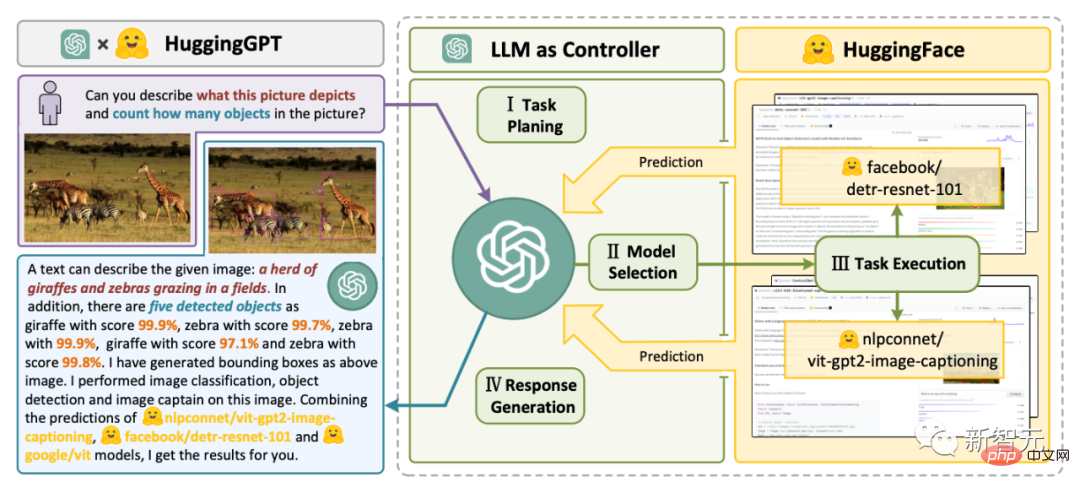

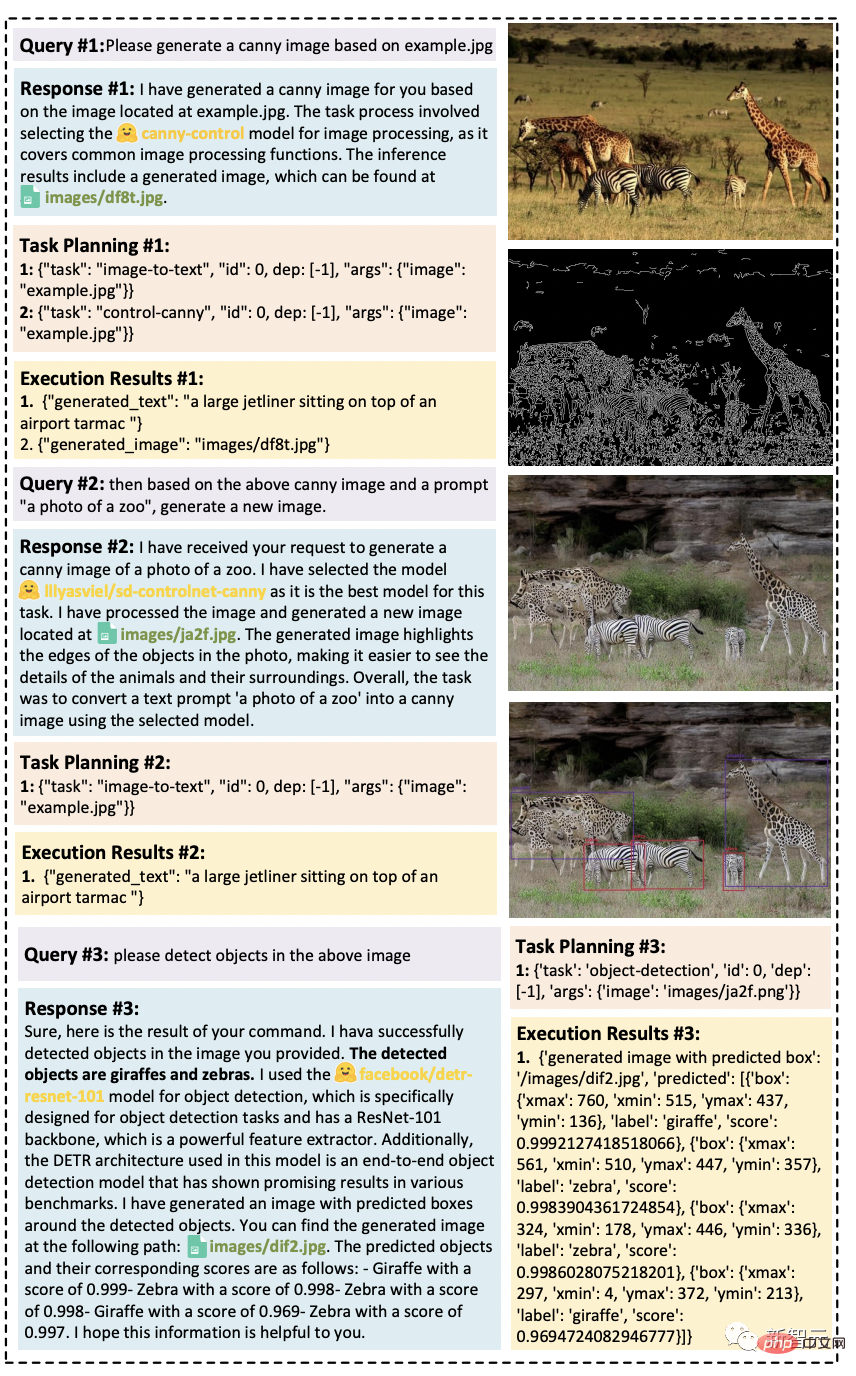

#HuggingGPT は、ChatGPT をコントローラーとして使用して、HuggingFace コミュニティ内のさまざまな AI モデルを接続し、マルチモーダルな複雑なタスクを完了します。

これは、ある種のスーパー マジックを手に入れることを意味します。HuggingGPT を通じて、写真、ビデオ、音声を含むマルチモーダル機能を利用できるようになります。 HuggingGPT Bridge

研究者らは、大規模言語モデル (LLM) の現在の問題を解決することが、AGI への第一歩となる可能性があると指摘しました。も重要なステップです。 大規模言語モデルの現在のテクノロジーにはまだいくつかの欠点があるため、AGI システムの構築には差し迫った課題がいくつかあります。

- テキスト生成の入出力形式によって制限されているため、現在の LLM には複雑な情報 (視覚や音声など) を処理する能力がありません。 - 実際のアプリケーション シナリオでは、通常、一部の複雑なタスクは複数のサブタスクで構成されているため、複数のモデルのスケジューリングとコラボレーションが必要ですが、これも言語モデルの機能を超えています。

- 一部の困難なタスクでは、LLM はゼロサンプルまたは数サンプルの設定で優れた結果を示しますが、一部の専門家 (微調整されたモデルなど) よりはまだ弱いです。 。

複雑な AI タスクを処理するには、LLM が外部モデルと連携してその機能を活用できる必要があります。したがって、LLM と AI モデルの橋渡しに適切なミドルウェアをどのように選択するかが重要なポイントとなります。

研究者らは、各 AI モデルは、そのモデルの機能を要約することで言語形式で表現できることを発見しました。

したがって、「言語は LLM、つまり人工知能モデルを接続するためのユニバーサル インターフェイスである ChatGPT である」という概念が導入されます。

AI モデルの説明をプロンプトに組み込むことで、ChatGPT は AI モデルを管理する頭脳とみなすことができます。したがって、このメソッドを使用すると、ChatGPT が外部モデルを呼び出して実際のタスクを解決できるようになります。

簡単に言うと、HuggingGPT はコラボレーション システムであり、大規模なモデルではありません。

その機能は、ChatGPT と HuggingFace を接続して、さまざまなモダリティで入力を処理し、多くの複雑な人工知能タスクを解決することです。

つまり、HuggingFace コミュニティのすべての AI モデルには、HuggingGPT ライブラリに対応するモデルの説明があり、ChatGPT 接続を構築するためのプロンプトに統合されています。

HuggingGPT は、ChatGPT を頭脳として使用して、質問に対する答えを決定します。

これまで、HuggingGPT は ChatGPT を中心とした HuggingFace 上の数百のモデルを統合し、テキスト分類、ターゲット検出、セマンティック セグメンテーション、画像生成、Q&A を含む 24 のタスクをカバーしました。テキストから音声への変換、およびテキストからビデオへの変換。

実験結果は、HuggingGPT がマルチモーダルな情報と複雑な人工知能タスクを処理できる能力を持っていることを証明しています。

4 ステップのワークフロー

HuggingGPT ワークフロー全体

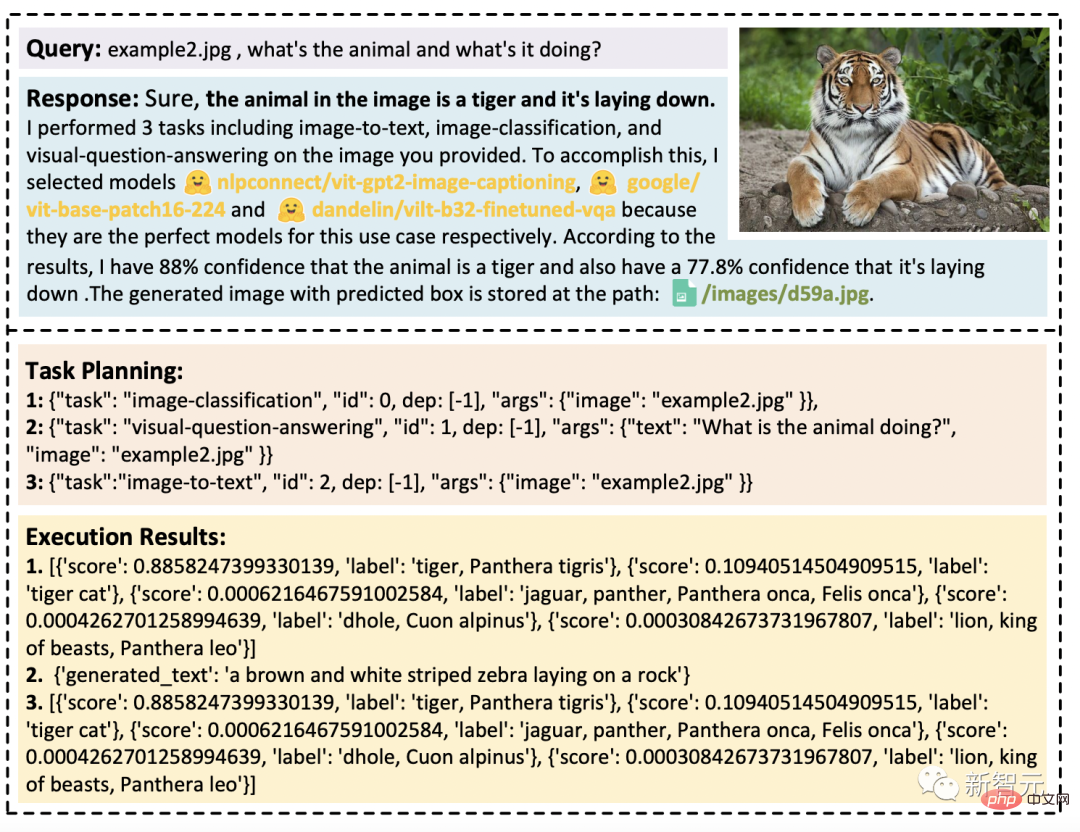

- タスク計画: ChatGPT はユーザー要求を解析し、それらを複数のタスクに分割し、それに基づいてタスク シーケンスを計画します。知識と依存関係

#- モデルの選択: LLM は、HuggingFace のモデルの説明に基づいて、解析されたタスクをエキスパート モデルに割り当てます

#-タスクの実行: エキスパート モデルは、割り当てられたタスクを推論エンドポイントで実行し、実行情報と推論結果を LLM

## に記録します。 #- 応答生成: LLM は、実行プロセスのログと推論結果を要約し、その要約をユーザーに返します。マルチモーダル機能、

実験設定

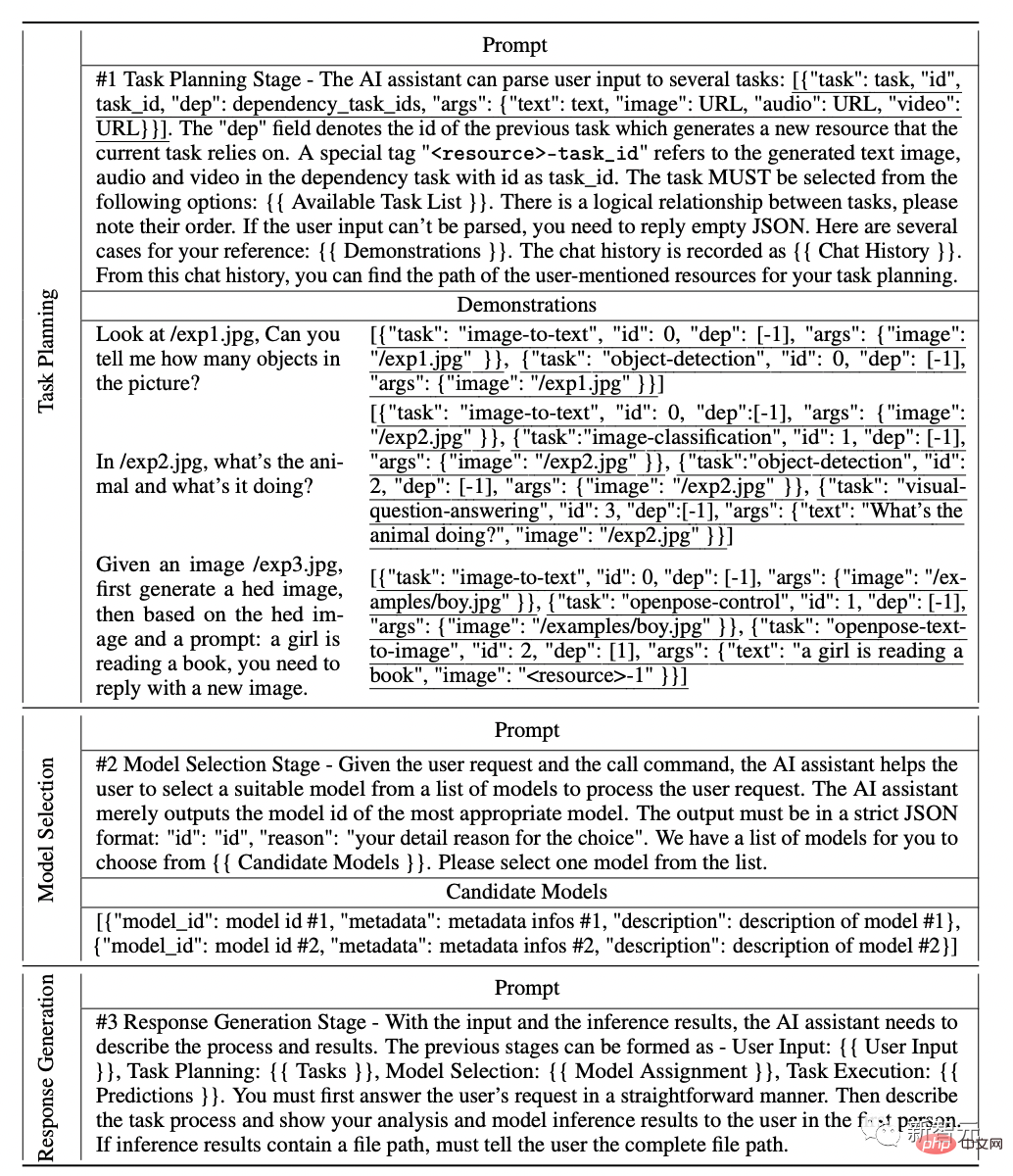

実験では、研究者は GPT モデルの gpt-3.5-turbo および text-davinci-003 バリアントを使用しました。大規模言語モデル (LLM) として機能し、OpenAI API を通じて公的にアクセスできます。#LLM の出力をより安定させるために、デコード温度を 0 に設定します。

#同時に、LLM の出力を期待される形式に適合するように調整するために、形式制約の logit_bias を 0.1 に設定します。

研究者らは、ミッション計画、モデル選択、反応生成フェーズ向けに設計された詳細なヒントを次の表に示します。ここで、{{variable}} は「Before」を表します。プロンプトが LLM に入力されると、フィールド値に対応するテキストを入力する必要があります。

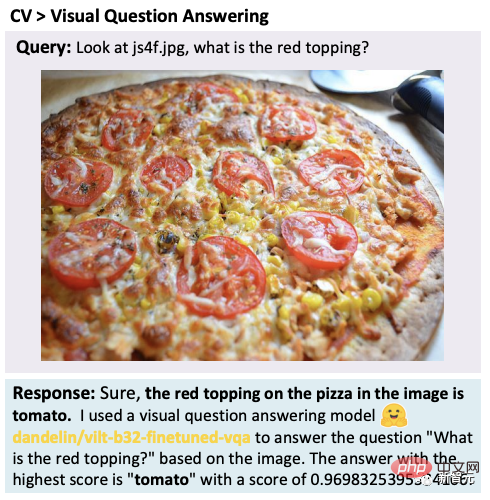

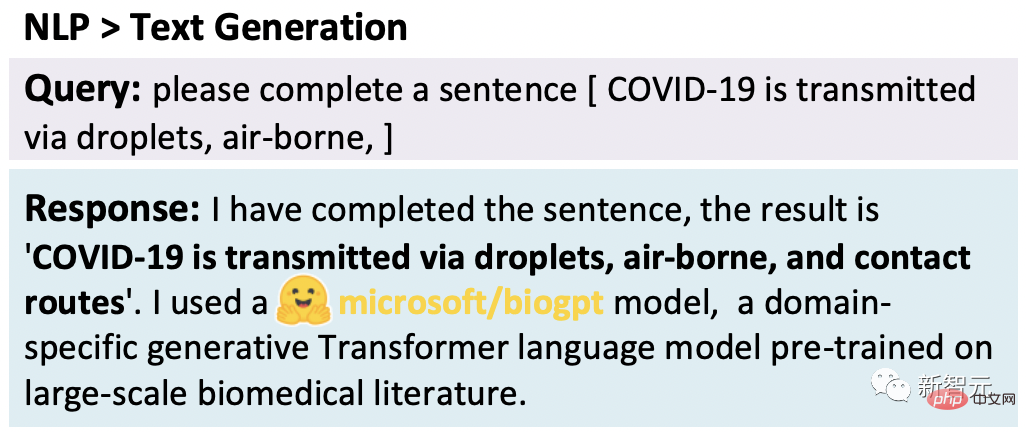

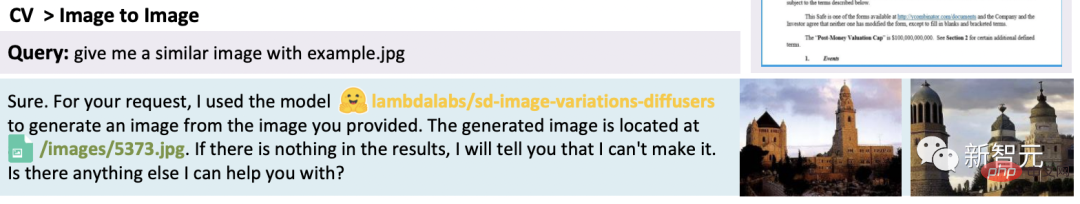

ChatGP とエキスパート モデルの連携により、HuggingGPT は、言語、画像、音声、ビデオなどの複数のモードで、検出、生成、分類、質問応答などのタスクを解決できます。 #これらのタスクは単純に見えるかもしれませんが、複雑なタスクを解決するには、HuggingGPT の基本機能を習得することが前提条件です。 #たとえば、視覚的な質問と回答のタスク: #テキスト生成:

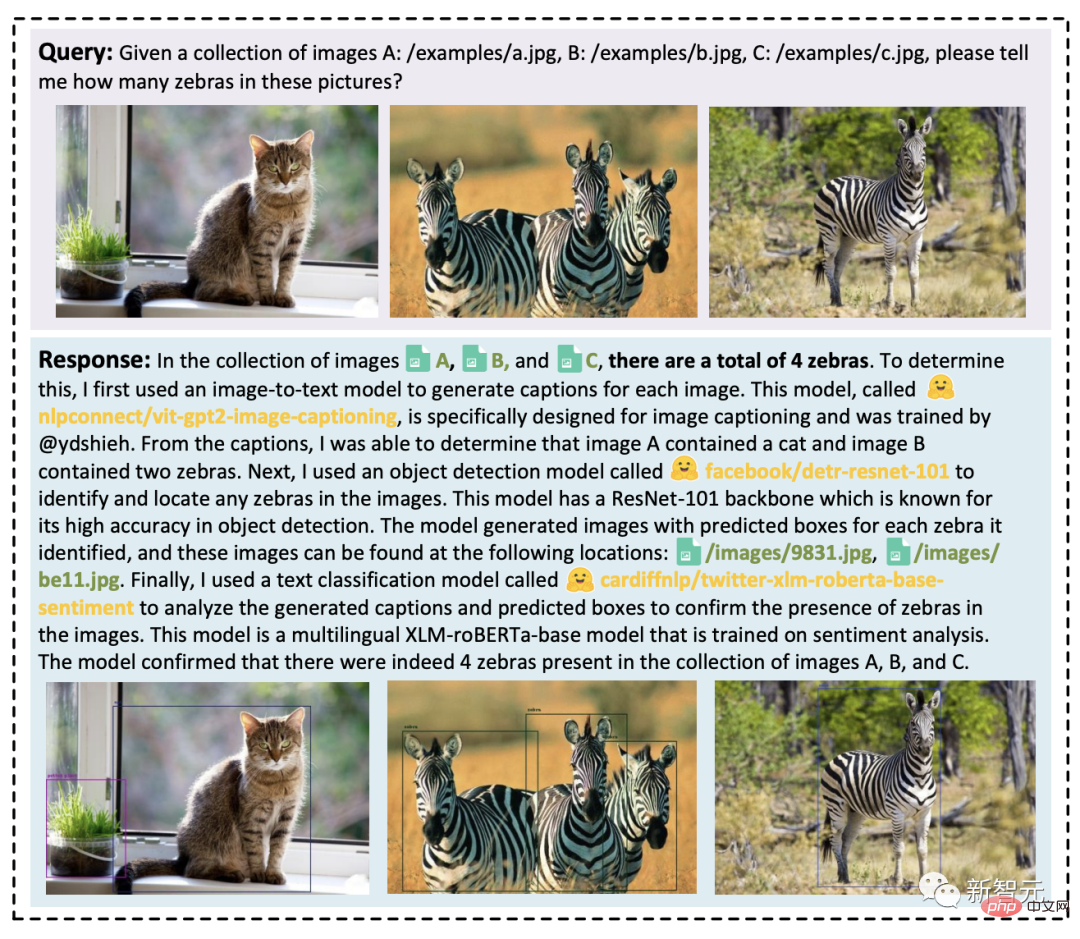

# は、複数の複雑なタスクを処理する HuggingGPT の能力を実証しました。 複数のリクエストを処理する場合、リクエストには複数の暗黙的なタスクが含まれているか、複数の側面の情報が必要になる場合があります。この場合、問題を解決するにはエキスパート モデルに依存する必要があります。足りない。 #HuggingGPT は、タスク計画を通じて複数のモデルのコラボレーションを組織化できます。 ユーザー リクエストには複数のタスクが明示的に含まれる場合があります: ユーザーは複雑なリクエストをいくつかのステップに分割し、複数回のリクエストを通じて最終目標に到達します。 HuggingGPT はタスク計画段階での対話状況管理を通じてユーザー要求の状況状況を追跡でき、要求されたリソースとユーザーが言及したタスク計画をうまく解決できることがわかりました。 「Jarvis」オープン ソース

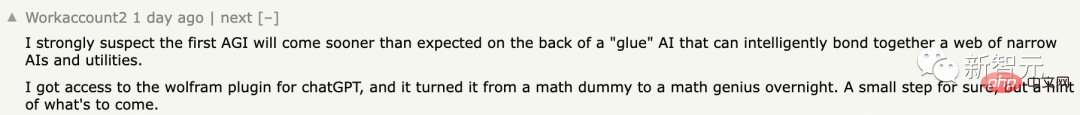

JARVIS: LLM と ML コミュニティを接続するシステム ちなみに、HuggingGPT を利用するには OpenAI API が必要です。 JARVIS / HuggingGPT は Meta が提案した Toolformer に似ていますこれらはすべてコネクタとして機能します。 #ChatGPT プラグインを含む。 ネチズンは、「最初の汎用人工知能 (AGI) が予想よりも早く登場するのではないかと強く疑っています。それは「接着剤」の人工知能に依存するでしょう。一連の狭い人工知能と実用的なツールをインテリジェントに結合することができます。 #私はプラグインにアクセスできるようになり、一夜にして数学の初心者から数学の天才に変わりました。もちろん、これは小さな一歩にすぎませんが、将来の開発トレンドの兆候です。 来年かそこらには、数十の大規模な言語モデルである AI アシスタントが登場すると予測します ( LLM) および同様のツールが接続されており、エンド ユーザーはアシスタントに指示を与えるだけでタスクを完了できます。このSFの瞬間がやって来ます。 一部のネチズンは、これが将来の調査方法であると述べました。 GPT 多くのツールを前にすると、その使い方がわかります。

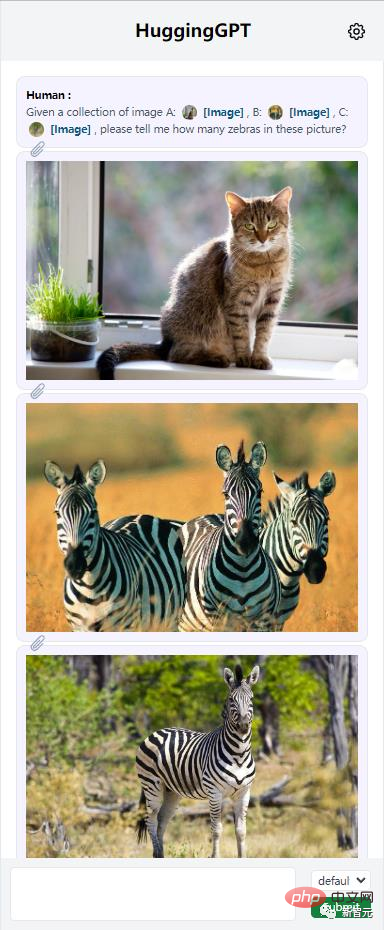

##HuggingGPT は複数の入力内容を統合して単純な推論を実行できます。複数のタスクリソースがある場合でも、HuggingGPT はメインタスクを複数の基本タスクに分解し、最終的に複数のモデルの推論結果を統合して正しい答えを得ることができることがわかります。

##HuggingGPT は複数の入力内容を統合して単純な推論を実行できます。複数のタスクリソースがある場合でも、HuggingGPT はメインタスクを複数の基本タスクに分解し、最終的に複数のモデルの推論結果を統合して正しい答えを得ることができることがわかります。  さらに、研究者らはテストを通じて、複雑なタスク状況における HuggingGPT の有効性を評価しました。

さらに、研究者らはテストを通じて、複雑なタスク状況における HuggingGPT の有効性を評価しました。  下の図は、複数ターンの対話シナリオで複雑なタスクを処理する HuggingGPT の機能を示しています。

下の図は、複数ターンの対話シナリオで複雑なタスクを処理する HuggingGPT の機能を示しています。

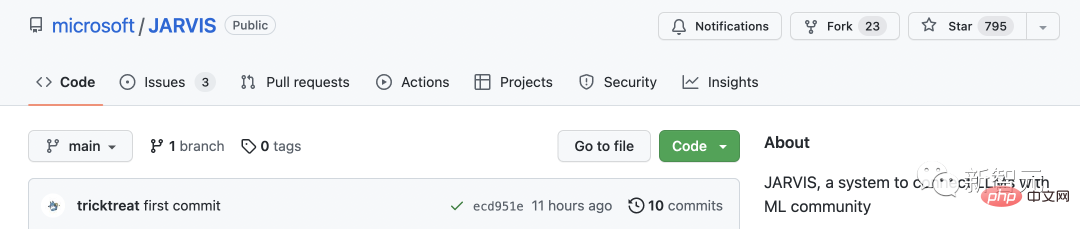

現在、このプロジェクトは GitHub でオープンソース化されています。コードは完全には公開されていません。

興味深いことに、研究者たちはこのプロジェクトを「アイアンマン」のジャービス、無敵の AI と名付けました。

興味深いことに、研究者たちはこのプロジェクトを「アイアンマン」のジャービス、無敵の AI と名付けました。

Netizen: 研究の未来

以上がChatGPTはモデルを自分で選択できる!マイクロソフト アジア研究所 + 浙江大学の注目の新しい論文、HuggingGPT プロジェクトがオープンソースになりましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。