ホームページ >テクノロジー周辺機器 >AI >テキストと画像編集の新しいパラダイム。単一モデルでマルチテキストのガイド付き画像編集が可能

テキストと画像編集の新しいパラダイム。単一モデルでマルチテキストのガイド付き画像編集が可能

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-10 19:41:021340ブラウズ

#論文の概要

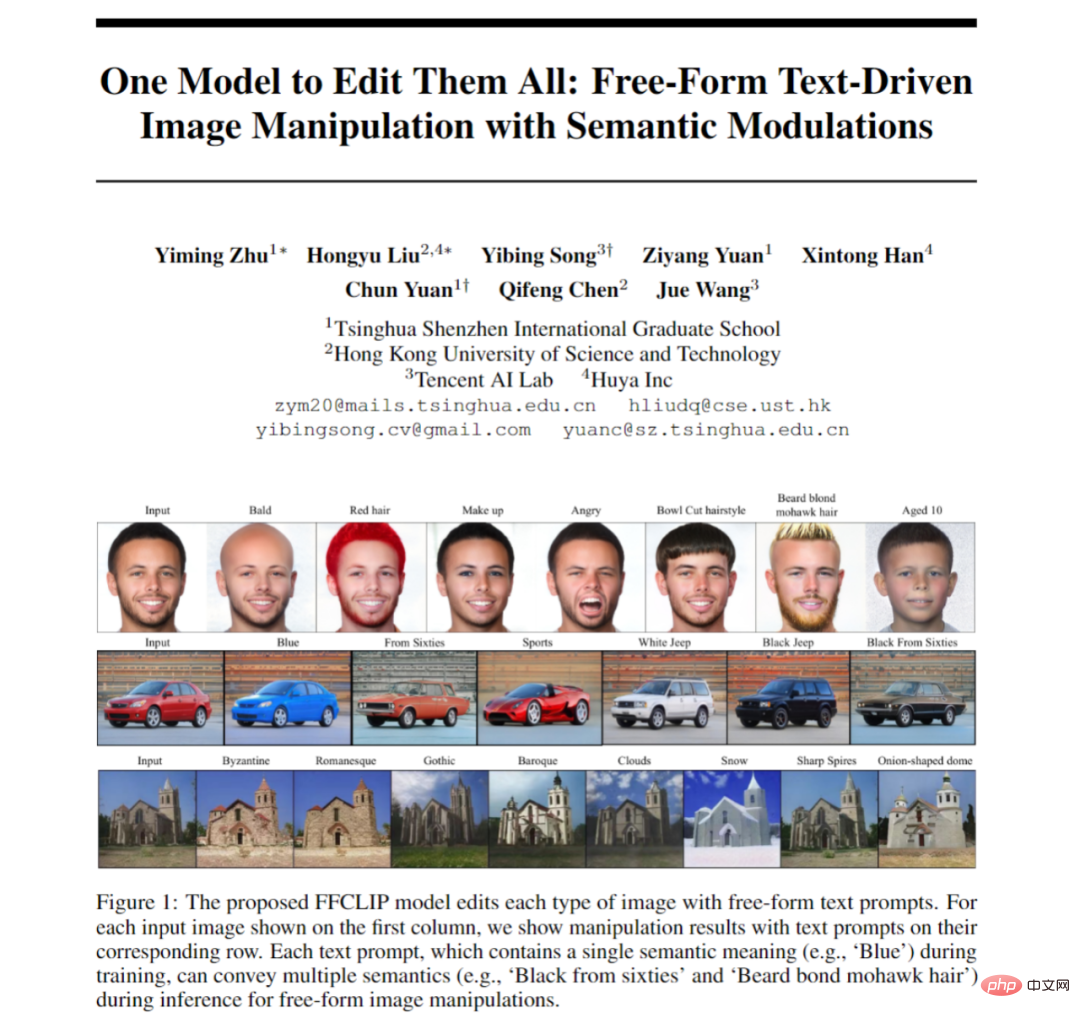

#テキストを使用した画像編集に関する研究は非常に活発であり、最近の研究の多くはノイズ除去拡散に基づいています。しかし、GAN 関連の研究に注目し続けている学者はほとんどいません。この記事は、古典的な StyleGAN と CLIP に基づいており、テキスト画像編集を実行するためにさまざまなテキストに対して 1 つのモデルだけが必要となるように、セマンティック変調モジュールを提案しています。

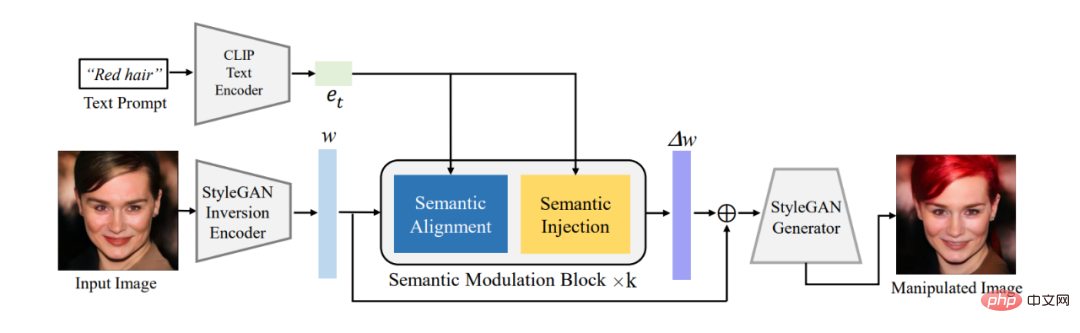

この記事では、まず既存のエンコーダを使用して、編集対象の画像を StyleGAN の W^ セマンティック空間内の潜在コード w に変換し、次に提案されたセマンティック変調モジュールを使用してエンコードします。潜在コード 適応変調を実行します。セマンティック変調モジュールには、セマンティック アラインメント モジュールとセマンティック インジェクション モジュールが含まれています。最初に、アテンション メカニズムを通じてテキスト エンコーディングと GAN の潜在エンコーディングの間でセマンティクスを調整し、次にアラインメントされた潜在エンコーディングにテキスト情報を注入して、Cain エンコーディングが確実に所有するようにします。テキストを使用して画像を編集する機能を実現する情報。

従来の StyleCLIP モデルとは異なり、このモデルはテキストごとに個別のモデルをトレーニングする必要はありません。1 つのモデルが複数のテキストに応答して画像を効果的に編集できるため、モデルは次のようになります。 FFCLIP フリーフォームのテキスト駆動型画像操作。同時に、私たちのモデルは、古典的な教会、顔、車のデータセットで非常に良い結果を達成しました。

- 論文アドレス: https://arxiv.org/pdf/2210.07883.pdf

- #Github アドレス: https://github.com/KumapowerLIU/FFCLIP 背景とインスピレーション

##最近、画像編集操作のために StyleGAN 潜在空間を編集するために、ユーザーの意図を説明するフリー テキスト プロンプトが使用されています [1、2]。これらのメソッドは、文 (例: 「Blue」) またはフレーズ (例: 「10 歳の男性」) を入力として受け取り、StyleGAN 潜在空間内の潜在エンコーディングを変調することによって、記述された画像属性をそれに応じて編集します。

正確なテキスト画像編集は、StyleGAN の視覚的意味空間と CLIP のテキスト意味空間の間の正確な潜在マッピングに依存します。たとえば、テキストプロンプトが「驚き」である場合、視覚的意味空間内でその関連する意味論的部分空間(つまり、驚きは表現の属性に属するため「表現」)を最初に特定します。テキストに対応する意味部分空間を見つけた後、テキストは、現在の表現から驚きの表現まで、潜在的なエンコーディングが変化する方向を教えてくれます。 TediGAN [1] や StyleCLIP [2] などの先駆的な研究は、どの潜在視覚部分空間がターゲットのテキストヒント埋め込み (つまり、TediGAN での特定の属性選択と StyleCLIP でのグループ化マッピング) に対応するかを経験的に事前定義しました。この経験的認識により、テキスト プロンプトが与えられた場合、対応する編集モデルをトレーニングする必要があることが制約されます。

StyleGAN の潜在視覚部分空間内の潜在コードを変調するには、テキスト キューが異なると、異なるモデルが必要になります。 StyleCLIP のグローバル方向設定方法ではそのようなプロセスは採用されていませんが、パラメータの調整と編集方向は手動で事前に定義されています。このため、単一のモデルで複数のテキストを処理できるように、明示的なテキストを通じて暗黙の視覚的意味部分空間を自動的に見つける方法を検討する理由があります。

この論文では、さまざまなテキストに対応する視覚部分空間を自動的に見つけることができる FFCLIP-Free Form CLIP を提案します。 FFCLIP は、StyleGAN 潜在空間 W^ 内の潜在エンコーディング w^ とテキスト エンコーディング e を入力として受け取るいくつかのセマンティック変調モジュールで構成されます。

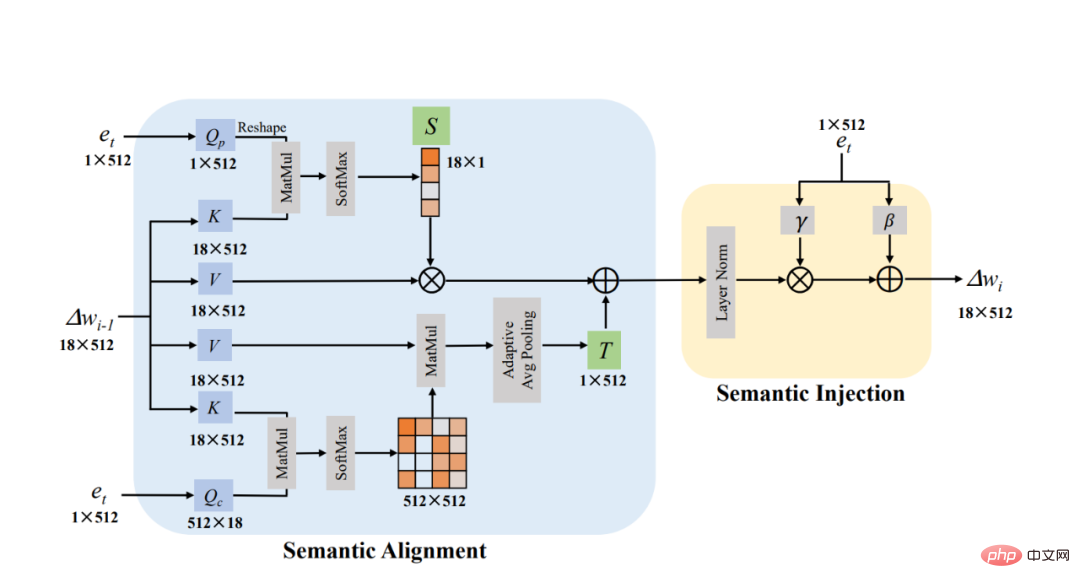

セマンティック変調モジュールは、セマンティック アライメント モジュールとセマンティック インジェクション モジュールで構成されます。セマンティック アライメント モジュールは、テキスト エンコーディング e をクエリとして、潜在エンコーディング w をキーと値として受け取ります。次に、位置とチャネルの次元でそれぞれクロス アテンションを計算し、2 つのアテンション マップが得られます。次に、線形変換を使用して、現在の視覚空間をテキストに対応する部分空間に変換します。線形変換パラメーター (つまり、変換パラメーターとスケーリング パラメーター) は、これら 2 つのアテンション マップに基づいて計算されます。この位置合わせを通じて、各テキストに対応する視覚的な部分空間を自動的に見つけることができます。最後に、セマンティック インジェクション モジュール [3] は、別の線形変換に従って部分空間内の潜在コードを変更します。

FFCLIP の観点から見ると、[1, 2] 中性子空間の経験的選択は、セマンティック アラインメント モジュールにおける線形変換の特別な形式です。それらのグループ選択操作は、w の各位置次元の使用法を示すスケーリング パラメーターのバイナリ値に似ています。一方で、W^ 空間の意味論はまだもつれており、経験的設計では StyleGAN の潜在空間と CLIP のテキスト意味論的空間の間の正確なマッピングを見つけることができないことが観察されています。代わりに、セマンティック アライメント モジュールのスケーリング パラメーターは、潜在コード w を適応的に変更して、さまざまなテキスト キューの埋め込みをマッピングします。その後、翻訳パラメータによって位置合わせがさらに改善されます。ベンチマーク データセットでメソッドを評価し、FFCLIP を最先端のメソッドと比較します。結果は、FFCLIP がユーザーの意図を伝えながら、より合理的なコンテンツを生成できることを示しています。

#FFCLIP図 1 は、全体的なフレームワークを示しています。 FFCLIP はまず、事前にトレーニングされた GAN 反転エンコーダーとテキスト エンコーダーを通じて画像とテキストの潜在エンコーディングを取得します。画像の潜在エンコーディングは、前述の StyleGAN 視覚意味空間 W^ の w であり、テキスト エンコーディングは e_t です。 StyleCLIP と同様に、CLIP では e4e GAN 反転エンコーダ [4] とテキスト エンコーダを使用して、それぞれ対応する潜在エンコーディングを取得します。次に、e_t と w を変調モジュールの入力として使用し、w のオフセット Δw を出力します。最後に、Δw を元の w に加算し、事前トレーニングされた StyleGAN に入力して、対応する結果を取得します。

図 1: 全体的なフレームワーク図

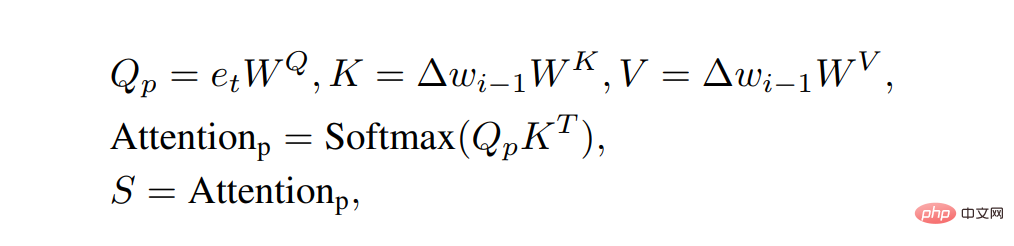

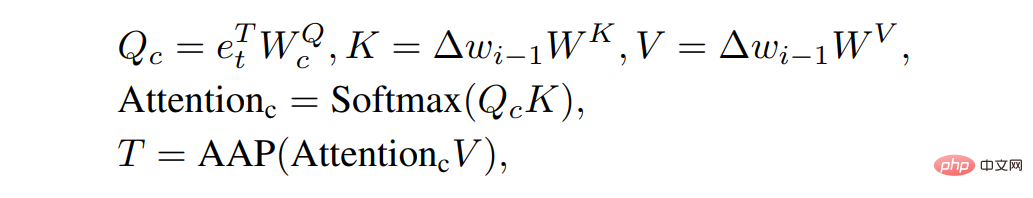

下の図 2 は、セマンティック変調モジュールです。セマンティック アライメント モジュール (セマンティック アライメント) では、Δw を Key と Value に設定し、e_t を Query に設定して 2 つのアテンション マップを計算していることが明確にわかります。これら 2 つのアテンション マップのサイズは、それぞれ 18×1 と 512×512 です。 。次に、18×1 アテンション マップを線形変換のスケーリング係数 S として使用します。アテンション マップを計算するプロセスは次のとおりです。 #同時に、512×512のアテンションマップにValueを乗算した後、Pooling演算を通じて陽的変換における変換係数Tを取得します。アテンション マップを計算するプロセスは次のとおりです。

上記の操作を通じてテキストに対応する視覚部分空間を作成し、AdaIN と同様の方法を使用して、この空間にテキスト情報を注入して最終結果を取得します。この操作をセマンティック インジェクション モジュール (セマンティック インジェクション) と呼びます。モジュール全体の実装手順は次のとおりです。

上記の操作を通じてテキストに対応する視覚部分空間を作成し、AdaIN と同様の方法を使用して、この空間にテキスト情報を注入して最終結果を取得します。この操作をセマンティック インジェクション モジュール (セマンティック インジェクション) と呼びます。モジュール全体の実装手順は次のとおりです。

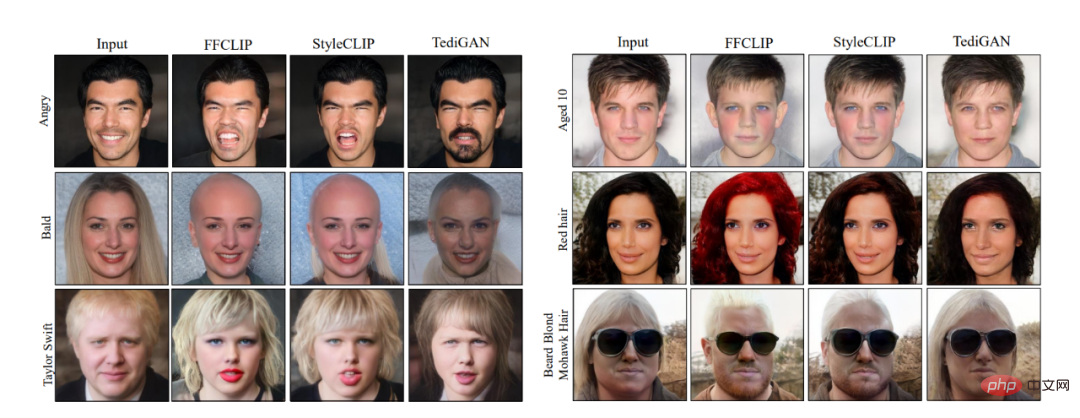

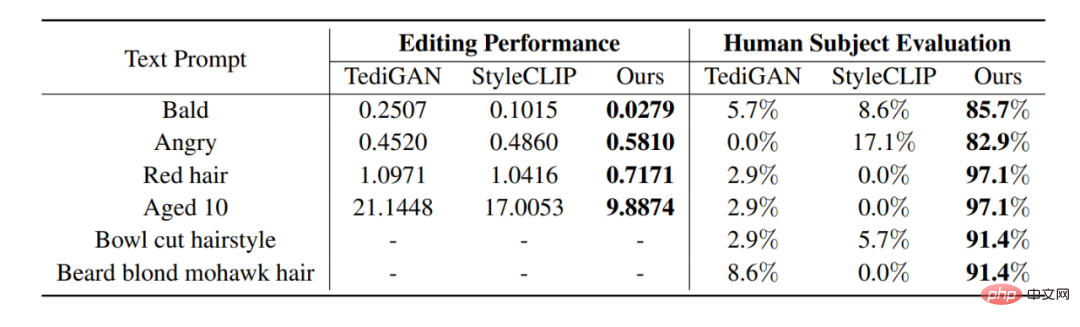

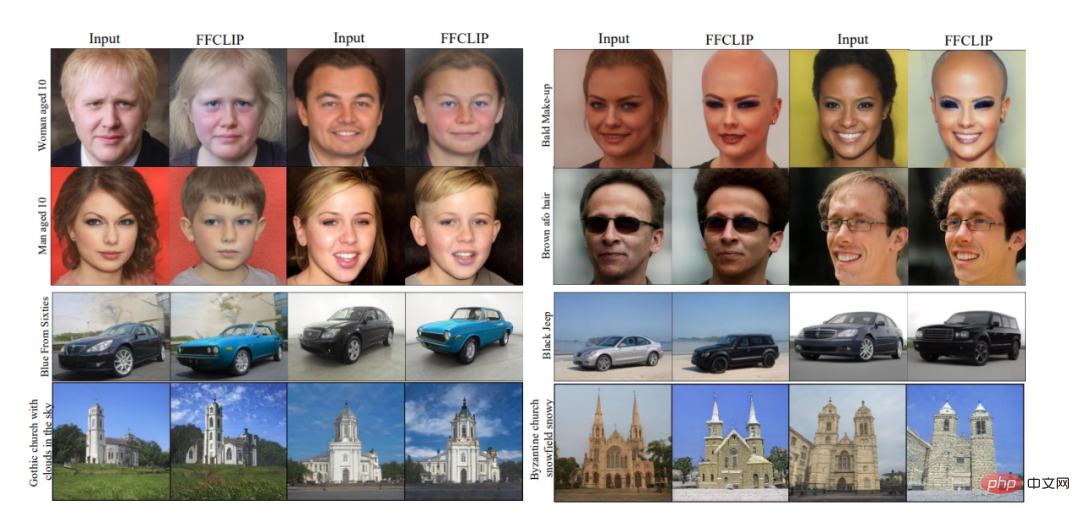

最終的に、合計 4 つのセマンティック変調モジュールが FFCLIP にスタックされ、最終的に最終的なオフセット Δw が取得されました。 ##図 3: 視覚的な比較チャート 図 3 に示すように、StyleCLIP [1]、TediGAN [2]、HairCLIP [3] と視覚的に比較しました。FFCLIP がテキストのセマンティクスをよりよく反映していることがわかります。よりリアルな編集画像を生成します。同時に、対応する数値比較結果は以下の表に示されており、私たちの方法は客観的値と主観的値の両方で最良の結果を達成できます。 #表 1: 数値比較

##図 4: フレーズ編集さらなる実験結果とアブレーション実験については、原文を参照してください。 概要#実験結果

この論文では、FFCLIP を提案します。FFCLIP は、さまざまなテキストをターゲットにしながら、単一のモデルのみを必要とする、効率的な画像編集のための新しい方法です。この記事の目的は、既存のメソッドは既存の経験に基づいて現在のテキストと GAN のセマンティック サブスペースに一致するため、編集モデルは 1 つのテキスト プロンプトのみを処理できるということです。アライメントと注入されたセマンティック変調を通じて潜在マッピングを改善します。これにより、1 つの編集モデルで複数のテキスト プロンプトを処理することが容易になります。複数のデータセットでの実験により、FFCLIP が意味的に適切で視覚的に現実的な結果を効果的に生成することが実証されました。

以上がテキストと画像編集の新しいパラダイム。単一モデルでマルチテキストのガイド付き画像編集が可能の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。