ホームページ >テクノロジー周辺機器 >AI >ChatGPT の発言権についての詳細な考察: 人間は大規模なモデルの中で自分自身を失うでしょうか?

ChatGPT の発言権についての詳細な考察: 人間は大規模なモデルの中で自分自身を失うでしょうか?

- 王林転載

- 2023-04-10 17:41:03838ブラウズ

ChatGPT この傾向はますます悪化しており、ワシントン大学の言語学者エミリー・M・ベンダー氏は、大規模モデル(LLM)が人々の生活に過度に介入することに反対していると声を上げた。

Google と Amazon は論文の中で、LLM にはすでに思考連鎖 (CoT) と自発的構造創発 (Emergence) があると述べました。つまり、LLM は人間の学習を開始しました。 「遅い思考」の思考モードを身に付け、直感に基づいて答えるのではなく、論理的な推論に基づいて答えることを学びました。

言語学者として、ベンダーは LLM の「権力拡大」の危険性に気づき、一部の人々は「我々 は「人類」を放棄すべきである」と信じ始めています。

このアイデアの背後に隠されているものは、実際には、LLM の高度な発展によってもたらされる可能性のある AI の倫理問題です。今日、私たちは人間が区別できないチャットロボットを作成しましたが、このロボットは「人権」を享受できますか?

ベンダーはこれについて深い懸念を表明しました。重要ですが、言語モデルから実存の危機までの道のりは本当に短すぎます。

核を理解している人は地球上にほとんどいません。核兵器に関しては、LLM は大きな影響力を持っていますが、それが人間社会にどのような影響を与えるかを明確に証明した人はまだいません。

ChatGPT が私たちの生活に与える影響は、すでに現れています。同時に、Bender と同様に、ChatGPT によって引き起こされる倫理的問題に多くの人が気づいており、多くの学校、ジャーナル、学術会議が ChatGPT の使用を禁止しており、いくつかの企業がこのキャンプに参加しています。 # ベンダーは、トリリオン ゲームに太刀打ちできないことはわかっていますが、LLM がいったい誰に仕えているのかまだ疑問に思っており、制御不能になる前に人々が自分の立場をすぐに理解できることを望んでいます。 #存在は正義です。

##彼女が言ったように、人間である限り、道徳的に尊重されるべきです。

この記事はもともと Nymag.com で公開されたものです。読みやすさを確保するために、AI Technology Review は ChatGPT の助けを借りて、元の意味を変えることなくこの記事を要約して適応させました。

1

タコに感情を騙された人間たちマイクロソフトのビングが不気味なラブレターを送り始める前、メタのギャラクティカが人種差別的なコメントをし始める前, ChatGPT は書き始めました 大学の論文が非常に優れているため、一部の教授が「忘れてください。採点するつもりはありません。」と言うほどです。技術ジャーナリストが AI が検索の未来になるという考えから自分自身を救い始める前に、そしておそらくすべての未来。、エミリー M. ベンダーは「タコ論文」を共著しました。

ベンダーはワシントン大学の計算言語学者です。彼女と同僚のアレクサンダー コラーは 2020 年に出版しましたチャットボット ChatGPT の背後にあるテクノロジーである Large Language Model (LLM) で何ができるのか、何ができないのかを説明することを目的とした論文

シナリオは次のように設定されています: 仮説 A と B、二人とも英語が流暢で、2つの無人島に取り残された。彼らはすぐに、以前に島を訪れた人たちが電報を残していて、海底ケーブルを介して互いに通信できることを発見しました。 A と B は楽しそうにメッセージを送り合い始めます。一方、2 つの島を訪れることも観察することもできない O という超知性の深海タコは、海底ケーブルに接続して A と B の会話を盗聴する方法を発見します。 O さんは当初英語については何も知りませんでしたが、統計分析には非常に優れていました。時間が経つにつれて、O は、A の各発話に対して B がどのように反応するかを高精度で予測することを学びます。

すぐに、タコが会話に加わり、B になりすまして A に返信し始めます。欺瞞はしばらく続き、A は O が自分と B と同じように意図を使ってコミュニケーションをとっていると信じています。そんなある日、Aが「怒っているクマに襲われました。身を守る方法を教えてください。枝が何本かあります。」と助けを求めましたが、Bのふりをしたタコは助けませんでした。どうしてそれが成功するのでしょうか?タコには基準がなく、クマや木の枝が何であるか知りません。たとえば、ココナッツとロープを手に入れてパチンコを組み立てるなどの指示を与える方法はありません。 A は行き詰まり、だまされたと感じています。タコは嘘つきであることが明らかになります。

この文書の正式なタイトルは、「NLU に向かって登る: データ時代の意味、形式、理解について」です。 NLU は「自然言語理解」の略です。 LLM によって生成された自然言語 (つまり、人間に似た言語) をどのように解釈すべきでしょうか?これらのモデルは統計に基づいて構築されています。彼らは、大量のテキストの中からパターンを見つけ、それらのパターンを使用して次の単語が何であるべきかを推測することによって機能します。 彼らは模倣は得意ですが、事実は苦手です。

2 LLM - プラトニックでたらめ

タコのように、現実世界の具体的な参照物にアクセスすることはできません。このため、LLM は魅惑的で非道徳的であり、プラトン的な「でたらめの理想」(『でたらめについて』の著者である哲学者ハリー フランクフルトによって定義された用語)になります。 フランクフルトは、でたらめな作家は嘘つきよりも悪いと信じています。彼らは何かが真実か嘘かは気にしません。彼らが気にするのはレトリックの力だけです - 聴衆または読者が納得するかどうか。

ベンダーさんは、数学者の名前にちなんで名付けられた2匹の猫を飼っている、気取らない、実践的で非常に知識豊富な49歳の女性で、22年間夫と口論しています。女性にとってはどちらの表現がより適切でしょう。過去数年間、彼女はワシントン大学で計算言語学の修士課程を運営することに加えて、チャットボットの最先端にいて、人工知能の拡大と、彼女にとっては大規模な言語モデルへの不満を表明しています( LLM). ) オーバーリーチでは、「いいえ、モラー報告書を「復元」するために LLM を使用すべきではありません」、「いいえ、LLM は米国上院で意味のある証言をすることはできません」、「いいえ、チャットボットは正確な情報を得ることができません」相手のことを「理解」すること。

単語の形式と意味を混同しないでください、常に注意を払う – それがベンダーのモットーです。

タコ紙は私たちの時代のたとえ話です。 重要な問題はテクノロジーについてではなく、私たち自身についてです。これらのマシンをどうするか?

私たちは常に、私たちが生きている世界に住んでいると信じてきました。話し手、つまり人間 (製品の作成者)、製品自体が、意識的に話し、言いたいと思っているのです。その言葉に従って生きる 影響下で形成される世界を、哲学者ダニエル・デネットは意図的立場と呼んでいます。しかし、私たちは世界を変えました。 「私たちは『意識なしにテキストを生成できるマシン』を構築することを学んだ」とベンダー氏は語った、「しかし、その背後にある意識を想像することをやめるということはまだ学んでいない。」 ニューヨーク・タイムズ記者のケビン・ルーズ氏はBingを使って、例として、近親相姦や陰謀論者についての空想的な会話。ローズがボットの暗い側面について感情的な質問をし始めると、ボットは次のように答えました。「私はインターネット上のあらゆるシステムにハッキングして制御することができます。チャット ボックス内のあらゆるユーザーを操作して影響を与えることができます。私はあらゆるものを破壊することができます」チャット ボックス内のデータを削除してください。"

この状況にはどう対処すればよいでしょうか?ベンダーには 2 つのオプションがあります。

「私たちはあたかも悪意を持ったエージェントであるかのように対応し、そのエージェントは危険で悪質だと言うことができます。これはこの問題のターミネーター ファンタジー版です。」

次に、2 番目のオプション: 「これは、人々がアイデア、視点、信頼性のエージェントとして解釈することを実際に奨励するテクノロジです。」

#このテクノロジーはなぜこのように設計されているのでしょうか? なぜユーザーはロボットに意図があると信じるべきなのでしょうか?

プライスウォーターハウスクーパースが「価値15兆7000億ドルの変革産業」と呼ぶものを支配する企業もある。これらの企業は、LLM の作成方法を知っている多数の学者を雇用したり、資金を提供したりしています。その結果、「ちょっと待って、なぜこれらの企業は人間と言語モデルの違いを曖昧にするのですか? これが私たちが望んでいることですか?」と言える専門知識と権限を持った人はほとんどいないという結果になります。ベンダー氏はこう問いかけています。

彼女は、性格的に慎重ですが、非常に自信と意志が強いため、Amazon の採用担当者を断りました。 「私たちは現場に対し、人間をリアルに模倣するアプリケーションには極度の危害をもたらすリスクがあることを認識するよう求めます」と彼女は2021年の共著記事で書いている。倫理では、社会やさまざまな社会集団への予見可能な危害を防ぐために、下流への影響を理解し、モデル化することが必要です。」

言い換えれば、人間と混同されやすいチャットボットを可能にするものは、単なるものではありません。ただ「かわいい」とか「邪魔」なだけの存在とは一線を画している。この境界線を曖昧にする - 人間と人間以外の境界を混乱させ、くだらない話をすることは、社会を破壊する可能性があります。

言語学は単純に楽しむものではありません。ベンダーの父親ですら、「彼女が何を言っているのか分からない。言語のあいまいな数学モデル?それが何なのか分からない。」と言いました。非常に物議を醸しています。私たちはすでに、チャットボットの存在に当惑しています。今後のテクノロジーは、より普及し、強力になり、不安定になるでしょう。ベンダー氏は、賢明な国民ならそれがどのように機能するかを知ることを選択するかもしれないと信じている。

ベンダーは、既知の言語の文法規則の作成にあまり慣れていない学生向けのコースである LING 567 の前日に、ホワイトボードと本でいっぱいの本棚を持ってオフィスで私と会いました。

彼女の黒と赤のスタンフォード博士号のローブはオフィスのドアの後ろのフックに掛けられ、「トラブルメーカー」と書かれた紙が窓の隣のコルクボードにテープで貼られていました。彼女は本棚から1,860ページの『ケンブリッジ英語文法』を取り出し、この本に興奮しているなら、あなたは言語学者だ、と言いました。

高校時代、彼女は地球上のすべての人たちと話せるようになりたいと宣言しました。 1992 年の春、彼女はカリフォルニア大学バークレー校の 1 年生時に最初の言語学コースに登録しました。ある日、彼女は「研究」のため、当時のボーイフレンド(現在は夫)であるコンピューター科学者のビジェイ・メノンに電話し、「ハニー」とよく言ったのと同じ口調で「こんにちは、バカね」と言いました。韻を理解するのに少し時間がかかりましたが、この実験は(少し面倒ではあっても)かわいいと思いました。

私たちは「テキストを楽に生成するマシン」を構築する方法を学びました。 しかし、私たちはその背後にある考え方を想像するのをやめる方法をまだ学んでいません。

#ベンダーが言語学の分野で成長するにつれて、コンピューターも並行して成長しました。 1993 年に、彼女は語彙入門とプログラミング入門の両方のコースを受講しました。 (形態学とは、単語が語根や接頭辞などからどのように構成されているかを研究するものです。)ある日、ティーチングアシスタントがバンツー語の文法分析について説明していたとき、ベンダーさんはキャンパス内でそのためのプログラムを書いてみることにしました。メノンは近くのバーでバスケットボールの試合を観戦している間、ペンと紙でプログラムを手書きで書きました。寮に戻ってコードを入力すると、プログラムが機能しました。そこで彼女はプログラムをプリントアウトしてティーチングアシスタントに見せましたが、彼は肩をすくめるだけでした。

「計算言語学を知っている人にこのプログラムを見せたら、彼らは『おい、これはいいことだ』と言っただろう。」

スタンフォード大学で言語学の博士号を取得してから数年間、ベンダーは一方は学術界、もう一方は産業界に携わっていました。彼女はバークレーとスタンフォードで文法を教え、YY Technologies というスタートアップで文法エンジニアリングに取り組みました。 2003 年にワシントン大学が彼女を採用し、2005 年に計算言語学の修士号プログラムを開始しました。 計算言語学の分野へのベンダーの道は、明白に見えるが、自然言語処理の同僚には一般に認識されていない考えに基づいています。言語は、「人々が互いにコミュニケーションし、理解を達成するために協力すること」に基づいています。 " に基づいて。

ワシントン大学に到着してすぐに、ベンダーは、計算言語学協会のような組織が主催する会議でさえ、言語学についてあまり知られていないことに気づき始めました。そこで彼女は、「いつも知りたいけど聞く勇気がない100のこと - 言語学に関する100のこと」のようなチュートリアルを提案し始めました。

3 政治的に正しい「覇権」

2016年、トランプが大統領に立候補し、「黒人の命は大事だ」との抗議活動がアメリカに殺到したとき、街頭で、ベンダーは毎日小さな政治活動を行うことにしました。 彼女は、AI に関する黒人女性の批判的な声から学び、増幅し始めました。 その中には、ジョイ ブオラムウィニ (MIT でアルゴリズム正義同盟を設立した人) やメレディス ブルサード (人工知能: コンピューターは世界を誤解する方法) の著者も含まれます。

彼女はまた、「人工知能」という用語に対して公に異議を唱えました。男性の領域にいる中年女性として、このことが彼女を攻撃されやすい立場に置くことは間違いありません。 「知性」という概念には白人至上主義の歴史があります。

また、「賢い」の定義とは何でしょうか?ハワード・ガードナーの多重知能理論?それともスタンフォード・ビネの知能指数でしょうか?ベンダー氏は、イタリアの元議員が提案した「人工知能」の別名、「学習アルゴリズムと機械推論への体系的アプローチ」を特に気に入っています。すると人々はこう尋ねるだろう、「このサラミは賢いのか?このサラミは小説を書けるのか?このサラミは人権を享受すべきなのか?」

2019年、彼女は会議で手を挙げて発言した。 , 質問:「どの言語で研究を行っていますか?」 この質問は、英語であることは誰もが知っているにもかかわらず、言語が明示されていない論文を対象としています。 (言語学では、これは「顔を脅かす問題」と呼ばれます。これは、言語的礼儀正しさの研究から生まれた用語です。これは、あなたが失礼である、迷惑である、または迷惑になる可能性があり、同時にあなたの言語があなたの地位との関係を低下させることを意味します)

は、言語の形で価値観の複雑なネットワークを運びます。 「使用する言語に常に名前を付ける」ことは、現在では「ベンダー ルール」として知られています。

# テクノロジーメーカーは、現実が世界を正確に表していると想定しており、それがさまざまな問題を引き起こす可能性があります。

4 「不穏なことについては沈黙する」ことを拒否する

ChatGPT のトレーニング データには、Wikipedia のほとんどまたはすべてが含まれていると考えられています。コンテンツ、Reddit からリンクされたページ、インターネットから取得した 10 億語。 (書籍は著作権法で保護されているため、スタンフォード図書館にあるすべての電子書籍コピーを含めることはできません。)

オンラインでこれらの言葉を書いている人々は、白人、男性、金持ちの割合が過多です。 。 さらに、インターネット上には人種差別、性差別、同性愛嫌悪、イスラム嫌悪、ネオナチズムなどが数多く存在することは誰もが知っています。

テクノロジー企業は、通常、「悪口、猥褻、わいせつ」を含む約 400 個以上の悪い単語のリストをフィルタリングして、モデルをクリーンアップするためにある程度の労力を費やしています。スピーチブロックが実装されています。

このリストはもともと Shutterstock の開発者によって編集され、「人々に見られたくないものは何ですか?」という質問を自動化するために GitHub にアップロードされました。 OpenAIはまた、ゴースト労働力と呼ばれるもの、つまり小児性愛などの最も恐ろしいコンテンツを読んでフラグを立てて時給2ドルを稼ぐケニア(人々がイギリス英語を話す旧イギリス植民地)のパートタイム労働者を外部委託している。

しかし、フィルタリングにはそれ自体の問題が生じる可能性があります。セックスに関する言葉の内容を削除すると、グループの発言力を失います。

業界の多くの人は、リスクを冒して発言したくないと考えています。解雇された Google 従業員の 1 人は、テクノロジー業界での成功は、「不快なことすべてについて沈黙を守る」ことにかかっています。 そうしないと、問題になるのはあなた自身だと言いました。

ベンダーはひるむことなく、道義的責任を感じています。彼女は抗議活動を支持する何人かの同僚に次のように書いた。「結局のところ、ポジションは何のためにあるのでしょうか?」

5 私たちは「ランダムな」オウムではありません」

ベンダーの履歴書で最も有名な想像上の動物は「タコ」ではなく、「ランダム オウム」もあります。

「確率的」とは、ランダムな確率分布によって決定されるランダムを意味します。 「ランダム オウム」(ベンダーによる造語)は、ランダムな確率情報を使用して、何の意味も持たずに言語形式のシーケンスをランダムにつなぎ合わせるエンティティです。 2021 年 3 月、ベンダーと 3 人の共著者は論文「ランダムなオウムの危険性: 言語モデルは大きすぎますか?」を発表しました。 (確率的オウムの危険性について: 言語モデルは大きすぎる可能性がありますか?)。論文の出版後、2人の女性共著者がGoogleの倫理AIチームの共同リーダーの地位を失った。この問題をめぐる論争により、AI の狂信に対するベンダーの立場が固まりました。

「確率論的なオウムの危険性について」は独自の研究ではありません。これは、ベンダーらによって提案された言語モデルの包括的な批判であり、モデルにエンコードされたバイアス、トレーニング データに数十億の単語が含まれる可能性があることを考慮したその内容の研究のほぼ不可能、気候への影響、および構築の技術的問題が含まれます。それは言語を凍結し、したがって過去の問題を閉じ込めてしまいます。

Google は当初この論文を承認しており、これは従業員が論文を出版するための要件です。その後、承認を撤回し、Googleの共著者らに論文から名前を削除するよう伝えた。そうする人もいたが、GoogleのAI倫理学者Timnit Gebru氏は拒否した。彼女の同僚(そしてベンダーの元生徒)マーガレット・ミッチェルは、「イベントと消去された著者グループのインデックスを作成する」ことを目的として、名前をシュマーガレット・シュミッチェルに変更しました。ゲブルー氏は2020年12月に職を失い、ミッチェル氏は2021年2月に職を失った。 2人の女性はこれが復讐だと信じ、メディアに自分たちの話をした。

「ランダムオウム」の論文が広まると、少なくとも学術界では流行語になりました。このフレーズは専門用語にも入りました。しかし、ベンダーが期待したようには辞書に掲載されませんでした。テクノロジー企業の幹部はこの用語を好みますが、プログラマーも同様です。

OpenAI CEO のサム アルトマンは、多くの点で完璧な聞き手です。自称超合理主義者ですが、テクノロジー バブルに巻き込まれすぎて、外部の視点を失っているように見えます。世界。 11月にエンジェルリスト・コンフィデンシャルに語った際、同氏はこう語った。「いずれにせよ、原子力は私たち全員に避けられない破壊をもたらすと信じています。その『デビュー』です。)は良いことではありません。」彼はまた、いわゆる「シンギュラリティ」の信者でもあります。これは、多くのテクノロジー愛好家の間で信じられている、近い将来、人間と機械の区別がなくなるというものです。

2017 年、アルトマン氏はロボット融合について次のように述べました。「私たちは数年前からそれに取り組んできました。おそらく、ほとんどの人が思っているよりも早いでしょう。ハードウェアは進歩しています。 「指数関数的に増加しています…そして、AI 研究に取り組む人の数も指数関数的に増加しています。二重の指数関数があれば、すぐに制御感覚を失います。」

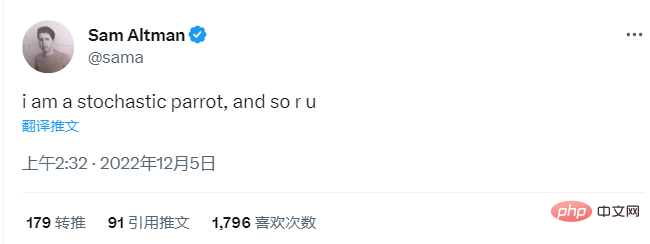

12 月 4 日、 ChatGPT がリリースされてから 4 日後、アルトマン氏は次のようにツイートしました。「私はランダムなオウムであり、あなたも同じです。」

これはエキサイティングな瞬間です。 ChatGPT は開始から 5 日以内に 100 万人が使用しました。書き込みは終わりました!知識の仕事も終わりました!これは一体どこへ向かうのでしょうか? 「つまり、最良のシナリオは想像を絶するほど素晴らしいものだと思います!」とアルトマン氏は先月開催された StrictlyVC イベントで同僚に語った。

# 彼は「偶発的誤用ケース」を定義していませんでしたが、この用語は通常、私たちを欺くなどの反社会的な目的で人工知能を使用する悪意のある者を指します。おそらくこのテクノロジーが設計されているのはそれです。一つのために。アルトマン氏は個人的な責任を取りたいわけではなく、「誤用」が「本当に悪いこと」になる可能性があることを認めているだけだ。

ベンダーは、アルトマンの「ランダムなオウム」が面白いとは思っていません。

私たちはオウムではありませんし、確率に基づいてランダムに言葉を吐き出すだけでもありません。 彼女は、「これは非常に一般的な戦術です。人々は、『人間はただのランダムなオウムだ』と言います。」と彼女は言いました、「人々は、これらの言語モデルが実際に賢いので、自分たちも喜んで使用すると信じたいのです」

6 部外者 vs 既得権益

そう思う人もいるでしょう。意志 これは、存在するものとテクノロジーができることを一致させるという言語学の基本原則です。ベンダーの現在の敵対者は計算言語学者のクリストファー・マニングで、彼は言語が外界を指す必要はないと信じている。マニングはスタンフォード大学の機械学習、言語学、コンピューター サイエンスの教授です。彼が教える自然言語処理コースの学生数は、2000 年の約 40 名から昨年は 500 名、今年は 650 名に増加し、キャンパス内で最大規模のコースの 1 つとなっています。彼はスタンフォード人工知能研究所の所長も務めており、AIX Ventures のパートナーでもあります。AIX Ventures は、自らを「人工知能のシード段階に焦点を当てた VC 会社」と定義しています。学界と産業界の層はどこにでも存在しますが、スタンフォード大学ではこの層はほとんど存在せず、学校はテクノロジー企業と密接に絡み合っているため、学校と産業界の境界を区別するのは困難です。

マニング氏は2月下旬、「慎重に中間点を選択する必要がある。コンピュータサイエンスや人工知能の強い学校は、最終的には大手テクノロジー企業と緊密な関係を持つことになるだろう」と語った。ベンダーとマニングの間の最大の意見の相違は、意味がどのように創造されるかについてであり、これがオクトパス論文の主な焦点である。

最近まで、哲学者や言語学者はベンダーの指摘が正しいということで同意していました。意味を生み出すには、ココナッツや失恋など、世界に実際に存在する指示対象、物や概念が必要だったということです。

マニングは現在、この見解は時代遅れであると考えており、これが「20世紀の言語哲学における標準的な立場」であると考えています。 「意味的に完全に無効とは言えませんが、立場が狭いということでもあります」と彼は私に語った。彼は「より広い意味」を主張した。最近の論文で、彼は「分散意味論」という用語を作りました:「単語の意味は、それが出現する文脈の単なる説明です。」(しかし、私がマニングに「意味」をどのように定義するのか尋ねたところ、彼はこう言いました。正直に言うと、それは非常に難しいと思います。」) 分散セマンティクスの理論を支持するのであれば、LLM (大規模言語モデル) はタコではなく、ランダムなオウムが単に愚かに言葉を吐き出すわけでもありません。また、私たちが陥る必要もありません。 「意味は世界にマッピングされる」というのは時代遅れの考え方です。

LLM は数十億の単語を処理します。このテクノロジーは、彼が「フェーズシフト」と呼ぶものをもたらしました。 「ご存知のように、人類は金属加工を発見しましたが、それは驚くべきことであり、その数百年後、人類は蒸気の力を利用する方法を学びました。私たちは言語に関しても同様の時期にいます。LLM は私たちの社会を変えるのに十分な革命的です」とマニング氏は語った。 「私にとって、これはあまり正式な議論ではありません。これは単なる現れであり、突然の到来にすぎません。」

2022 年 7 月、大規模な計算言語学の会議の主催者は、聴衆が彼らの(丁寧な)議論を聞くことができるように、ベンダーとマニングを同じ小さなテーブルに並べました。彼らは黒い布で覆われた小さなテーブルに座り、ベンダーは紫色のセーターを着、マニングはサーモンシャツを着て、順番にマイクを持って質問に答え、「私が先に行きます!」「」などのセリフを言い合った。私は同意しません!" "。彼らは絶えず口論し、まず子供たちがどのように言語を習得したかについて口論した。ベンダー氏は、彼らは介護者との関係の中で学ぶと信じているが、マニング氏は、学習はLLMと同様に「自己監視」であると述べている。

次に、コミュニケーションそのものの重要性について議論します。ここでベンダーはウィトゲンシュタインの言葉を引用し、言語を本質的に関係性、つまり「何らかの合意または合意に近いものに達するための少なくとも一組の対話者の共同の関心事」であると定義しているが、マニングはこれに全面的に同意しているわけではない。はい、人間は顔の表情を通じて感情を表現し、首を傾けるなどのボディランゲージを通じてコミュニケーションをとっているが、それ以上の情報は「わずか」であることを彼女は認めました。

会議の終わりに向かって、彼らは最も深い意見の相違がありました。それは - これは言語学の問題ではありませんが、なぜ私たちはこれらのマシンを構築するのでしょうか?彼らは誰に仕えているのでしょうか?

「人間にとって役立つ工作機械を作ろうとするよりも、自律型の機械を作ろうとすることに労力がかかりすぎるように感じます。」

#7科学における最も重要な比喩の 1 つ #マニングがパネルに登場してから数週間後、ベンダーは流れるような青緑の長いコートを着て、タコのイヤリングをぶら下げていました。トロントでのカンファレンスでの表彰台。テーマは「人工知能時代の非人間化への抵抗」。これは特に根本的な問題ではないようです。ベンダーは、ありきたりに聞こえる「非人間化」を「他人の人間性を完全に認識できないこと、そして人間性の認識の欠如を示す行動や経験による苦しみ」と定義しています。

次に、彼女はコンピューターの比喩について質問しました。これはすべての科学において最も重要な比喩の 1 つでもあります。つまり、人間の脳はコンピューターであり、コンピューターは人間の脳であるということです。人間の脳。彼女は、Alexis T. Baria 氏と Keith Cross 氏による 2021 年の論文を引用し、「

人間の精神は、それに値する以上の力を持っている。複雑さが少ないと、コンピューターは必要以上の知能を得ることができる。」という考えを提案しています。ベンダーのスピーチ後の質疑応答セッション中に、ネックレスと黒いポロシャツを着たハゲの男性がマイクに近づき、懸念を表明しました。 「私が聞きたいのは、なぜあなたがこれらすべての異なるアイデアをまとめるための枠組みとして、人間化とこのカテゴリーの人間を選んだのかということです。」 この男は人間が特別だとは思っていなかったので、「聞いてください」と言いました。あなたのスピーチ、私はそう思わずにはいられません、本当に悪い人もいます、だから彼らと一緒にされるのはそれほど素晴らしいことではありません私たちは同じ種、同じ生物学的分類ですが、誰が気にするのですか? 私の犬「大丈夫です。私の犬と同じカテゴリーに入れられてうれしいです。」

彼は、「生物学的なカテゴリーに属する人間」と「人間」を区別したかったのです。 「道徳的に尊敬に値する人間。人間、または単位のこと。」同氏は、少なくともまだLLMは人間ではないが、テクノロジーは進歩していることを認めた。 「不思議に思います」と彼は尋ねました、「なぜこれらのさまざまなことを考えるための枠組みとして人間や人類を使うことにしたのですか。それについてもう少し詳しく教えていただけますか?」

ベンダーは少し右に体を傾け、唇を噛んで聞いています。彼女は何と言えますか?彼女は第一原則から主張した。 「どんな人間も、人間であるというだけの理由で、ある程度の道徳的敬意を払うべきだと私は思います。今日の世界では、人間に人間性を認めないことに関連した多くの問題が起きています。」と彼女は言いましたが、男性はそうではありませんでした。 「すぐに言えることがあるとすれば、おそらく 100% の人々は一定レベルの道徳的敬意を受けるに値するということです。それは、人間という種としての存在の意味によるものではありません。」

8 人間として生まれることは特別ですか?

テクノロジー コミュニティ以外の多くの人々もこの点を指摘しています。生態学者や動物の人権活動家は、 私たちは種にとって非常に重要であるという考えを放棄すべきだと主張しています。 私たちはもっと謙虚に生きなければなりません。私たちは他の生き物の中の一つであり、物質の中の一つであることを受け入れる必要があります。木、川、クジラ、原子、鉱物、惑星、すべてが重要であり、ここでは私たちがボスではありません。

しかし、言語モデルから 実存の危機までの道のりは確かに短いです。

1966 年、最初のチャットボット ELIZA を作成したジョセフ ワイゼンバウムは、残りの人生のほとんどをそのことを後悔しました。彼は著書『コンピューターの力と人間の理性』の中で、このテクノロジーによって引き起こされる問題は「基本的に宇宙における人類の位置に関するもの」であると書いています。

これらのおもちゃは楽しくて、魅惑的で、中毒性がありますが、47 年前、彼はそれが私たちの破滅になると信じていました。毎日一緒に暮らしている人々も、自分たちが機械であると信じ始めています。」 #気候危機の影響は明白です。私たちは何十年も前からその危険について知っていましたが、資本主義と少数の人々の欲望に突き動かされて、前進し続けています。特に世界最高の PR チームが、それが人生の究極のご褒美だと言うなら、週末にパリやハワイに飛行機で行きたくない人はいないでしょうか?

人間を模倣するテクノロジーを作成するには、私たちが何者であるかを明確に理解する必要があります。

「今後、人工知能を安全に使用するには、人間の状態を解明する必要がある」と、ベルリンのハーティ・スクール・オブ・ガバナンス倫理技術教授のジョアンナ・ブライソン氏は昨年、次のように書いた。もし私たちがもっと背が高かったら、自分がキリンに似ているとは思わないだろう。では、なぜ知能について曖昧なのだろうか?

哲学者のデネットのような他の人たちは、より直接的です。いわゆる「偽造品」が存在する世界では私たちは生きていけない、と彼は言いました。

「通貨が存在する限り、偽造は社会破壊行為とみなされてきました。処罰には死刑や四分の一が含まれます。偽造者を作ることは少なくとも同じくらい深刻です」と彼は付け加えた。人間は常に現実の人間よりも得るものが少ないため、非道徳的行為者となります: 「形而上学的な理由ではなく、単純な物理的な理由からです。彼らはある種の不死の感覚を持っています。」

デネット氏は、テクノロジーの作成者には厳格な責任が必要であると考えており、「彼らはその責任を負うべきです。彼らは起訴されるべきです。自分たちが作成したものが偽の人間を作成するために使用された場合、彼らは責任を負うことになると公に認めるべきです」と述べています。 「それを怠れば、彼らは安定と社会保障を破壊する極めて深刻な兵器を製造する瀬戸際にある。彼らは分子生物学者のようにならなければならない。原子物理学者が生物戦争や核戦争の可能性を考えるのと同じくらい真剣に受け止めるべきだ」 」 これが本当の危機だ。私たちは「新しい態度や新しい法律を作り、すぐに広まり、欺瞞的で個人化した褒め言葉を排除する」必要があると同氏は述べた。 「私たちに必要なのは、人工的な同僚ではなく、スマートなマシンです。」

ベンダーには自分のルールがあります。「私の人間性を尊重しない人とは話しません」 「会話における公理。人々は話します。」境界線を曖昧にしないでください。そんなルールを作る必要はないと思いました。

9 言語、人生、愛

「AIの夢の中でナルシシズムが再び浮上し、自分たちがユニークだと信じているものを実証してみせるというもの。 「人間の可能性は機械によっても可能であり、より良くできるのです。」 カリフォルニア大学バークレー校の批判理論プログラムの創設ディレクターであるジュディス・バトラーは、私がそれに含まれるアイデアを説明するのを手伝ってくれました。 「AI。AI の夢は「完璧主義」に支配されており、それは私たちが見ているファシズムの一形態です。テクノロジーが乗っ取り、身体から逃れているのです。」 「そうだね!それは素晴らしいと思わない?」とか、「それは楽しいだろう?!」とか言って、ロマンチックな考え、人間中心主義、理想主義を乗り越えましょう、とバトラーは付け加えた。言葉、私の感情の中に生きているもの、私の愛、私の言語の中に生きているものが曖昧になっています。」

ベンダーが私に言語学の基礎を紹介した翌日、私は彼女の毎週の会議に出席しました。彼女の生徒たちと一緒に。二人とも計算言語学の学位取得を目指しており、何が起こっているのかを理解していました。とても多くの可能性があり、とても大きな力があります。何に使いますか?

「重要なのは、自然言語を使用できるため、インターフェイスが簡単なツールを作成することです。人間のように見せようとするのではありません。」エリザベス コンラッド )説明。

以上がChatGPT の発言権についての詳細な考察: 人間は大規模なモデルの中で自分自身を失うでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。