ホームページ >テクノロジー周辺機器 >AI >ChatGPT と生成 AI は科学にとって何を意味しますか?

ChatGPT と生成 AI は科学にとって何を意味しますか?

- 王林転載

- 2023-04-10 15:51:031521ブラウズ

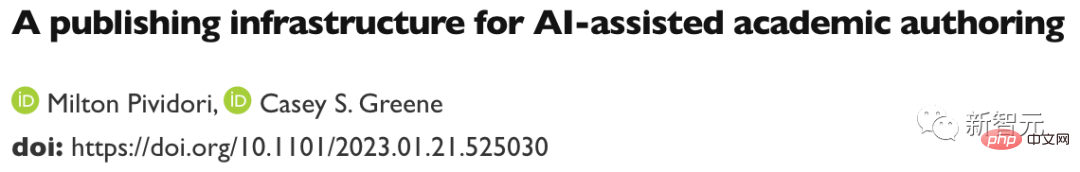

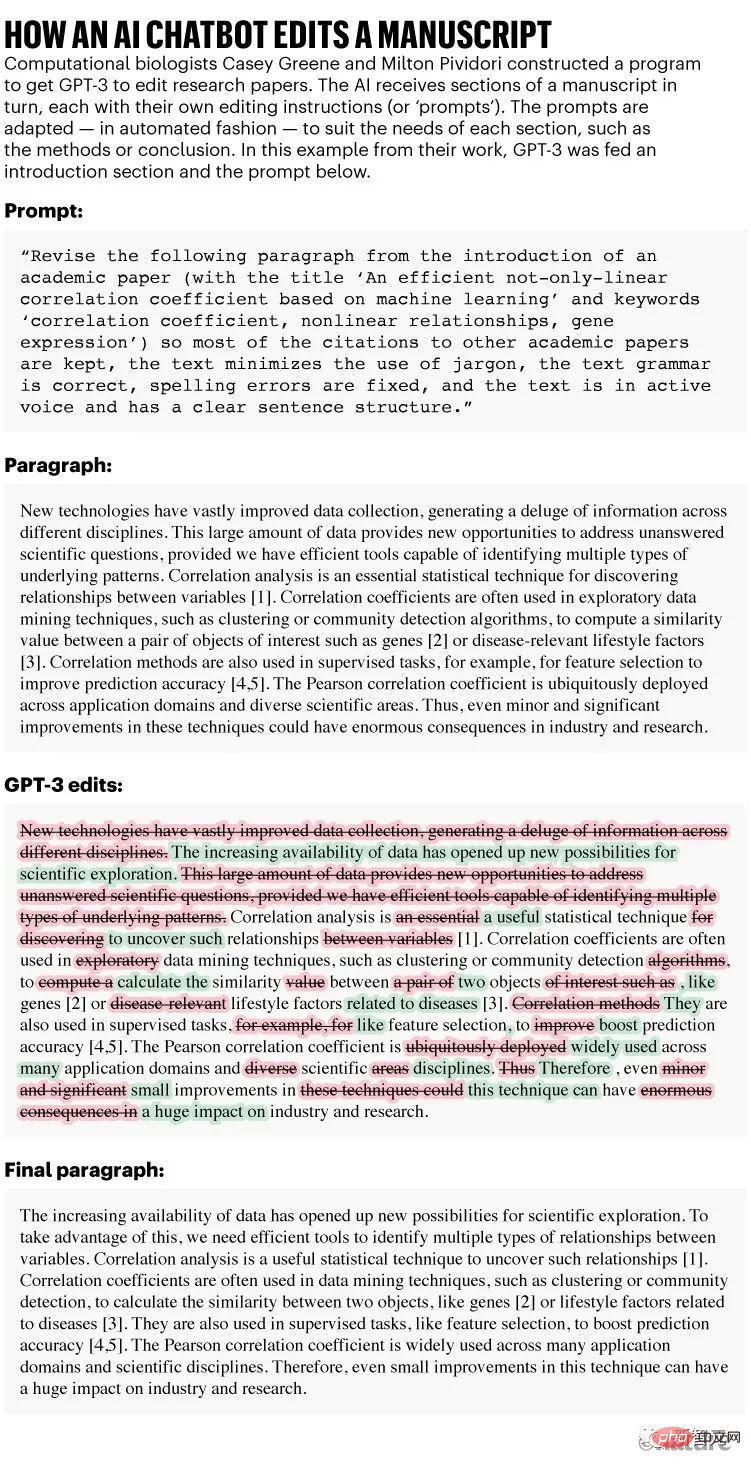

12月、計算生物学者のケイシー・グリーン氏とミルトン・ピビドリ氏は珍しい実験に着手した。彼らは科学者ではない助手に、3件の研究論文の改良を手伝ってくれるように依頼した。

彼らの勤勉なアシスタントは、文書のさまざまな部分を数秒で修正することを推奨しています。これには、原稿ごとに約 5 分かかります。ある生物学の原稿では、アシスタントが方程式の引用に誤りを発見したことさえありました。

レビューは必ずしもスムーズに進むとは限りませんが、最終原稿は読みやすくなり、コストも 1 文書あたり 0.50 ドル未満と手頃です。

論文アドレス: https://www.biorxiv.org/content/10.1101/2023.01.21.525030 v1

Greene と Pividori が 1 月 23 日のプレプリントで報告したように、アシスタントは人間ではなく、GPT-3 人工知能アルゴリズムと呼ばれる一種のソフトウェアです。 2020年に初めてリリースされました。

これは、散文、詩、コンピューター コードの作成、あるいは研究論文の編集を依頼される、大々的に宣伝されている生成型 AI チャットボット スタイル ツールです。

これらのツール (大規模言語モデルまたは LLM とも呼ばれる) の中で最も有名なのは、ChatGPT です。これは GPT-3 のバージョンで、昨年 11 月にリリースされてから一躍有名になりました。簡単にアクセスできます。他の生成 AI は画像や音声を生成できます。

記事アドレス: https://www.nature.com/articles/d41586-021-00530 - 0

#「とても感銘を受けています」とフィラデルフィアのペンシルベニア大学で働くピビドリ氏は語った。 「これは、研究者の生産性を高めるのに役立ちます。」 他の科学者は、現在、LLM を定期的に使用しており、原稿を編集するだけでなく、コードを書いたりチェックしたり、アイデアをブレインストーミングしたりするのにも役立っていると述べています。

「私は今、毎日 LLM を使用しています」と、アイスランド大学 (レイキャビク) のコンピューター科学者、ハフスタイン・エイナーソンは言います。

彼は GPT-3 から始めましたが、後に ChatGPT に切り替えました。これにより、プレゼンテーションのスライド、学生の試験、コースワークを作成し、学生の論文を論文に変換することができました。 「多くの人がデジタル秘書やアシスタントとして利用している」と同氏は語った。

LLM は、検索エンジン、コーディング アシスタント、さらには他の企業と交渉できるチャットボットの一部でもあります。チャットボットを使用して製品の価格を安くします。

ChatGPT の作成者であるカリフォルニア州サンフランシスコに本拠を置く OpenAI は、応答時間の短縮と新機能への優先アクセスを約束する月額 20 ドルのサブスクリプション サービスを発表しました (試用版はまだ無料です) )。

すでに OpenAI に投資していたハイテク大手 Microsoft は、1 月にさらなる投資を発表し、その額は約 100 億ドルと伝えられています。

LLM は、汎用ワードおよびデータ処理ソフトウェアに組み込まれる予定です。特に今日のツールはテクノロジーの初期段階にあるため、将来的に生成 AI が社会に普及することは確実であると思われます。

しかし、LLM は、嘘を返す傾向から、AI が生成したテキストを自分のものとして偽装する人々についての懸念まで、幅広い懸念も提起しています。

記事のアドレス: https://www.nature.com/articles/d41586-023-00288-7

自然が研究するとき いつChatGPT のようなチャットボットの潜在的な用途について尋ねる人は、特に科学分野で、その興奮と懸念が入り混じっています。

「このテクノロジーに変革をもたらす可能性があると信じるなら、それについて神経質になる必要があると思います」とコロラド大学オーロラ校医学部のグリーン氏は語った。 。研究者らは、多くは将来の規制やガイドラインがAIチャットボットの使用をどのように制限するかに依存すると述べている。

流暢だが本物ではない

一部の研究者は、LLM は、監督されている限り、論文執筆や助成金などのタスクを高速化するのに理想的であると考えています。

「科学者は、もう座って助成金申請のための長い紹介文を書くことはありません」と、スウェーデンのヨーテボリにあるサールグレンスカ大学病院の神経生物学者アルミラ・オスマノビッチ・トゥンストロム氏は言う。 GPT-3を実験として使用した原稿。 「彼らはシステムにこれを実行するように要求するだけです。」

ロンドンに本拠を置くソフトウェアコンサルタント会社 InstaDeep の研究エンジニアである Tom Tumiel 氏は、執筆を支援するアシスタントとして LLM を毎日使用していると述べました。コード。

「これは、より優れた Stack Overflow のようなものです」と、プログラマーがお互いの質問に答えていく人気のコミュニティ サイトに言及しながら、彼は言いました。

しかし研究者らは、LLM は単に質問に答える信頼性が低く、場合によっては誤った応答を生成することを強調しています。 「これらのシステムを使用して知識を生成する場合は、注意が必要です。」

この信頼性の低さは、LLM の構築方法に反映されています。 ChatGPT とその競合他社は、オンライン テキストの膨大なデータベースから言語の統計パターン (真偽のない知識、偏った知識、古い知識を含む) を学習することによって機能します。

LLM がプロンプト (原稿の一部を書き直すという Greene と Pividori の入念な要求など) を受け取ると、会話を続けるために文体的に合理的と思われる方法でただ言葉をそのまま吐き出すだけです。

その結果、LLM は、特にトレーニングするデータがあまりない技術的なトピックについて、誤った誤解を招く情報を生成する傾向があります。また、LLM は情報源を示すことができず、学術論文を書くよう求められた場合、架空の引用をでっち上げます。

「事実を正しく処理したり、信頼できる参考文献を生成したりするツールは信頼できない」と、ChatGPT に関するジャーナル Nature Machine Intelligence に 1 月に掲載された社説は述べています。

記事アドレス: https://www.nature.com/articles/d41586-023-00107 -z

これらの注意点があるため、ChatGPT およびその他の LLM は、問題を直接発見したり、問題を簡単に検証したりするのに十分な専門知識を持つ研究者の効果的なアシスタントになることができます。コンピュータコードの提案は正しいです。

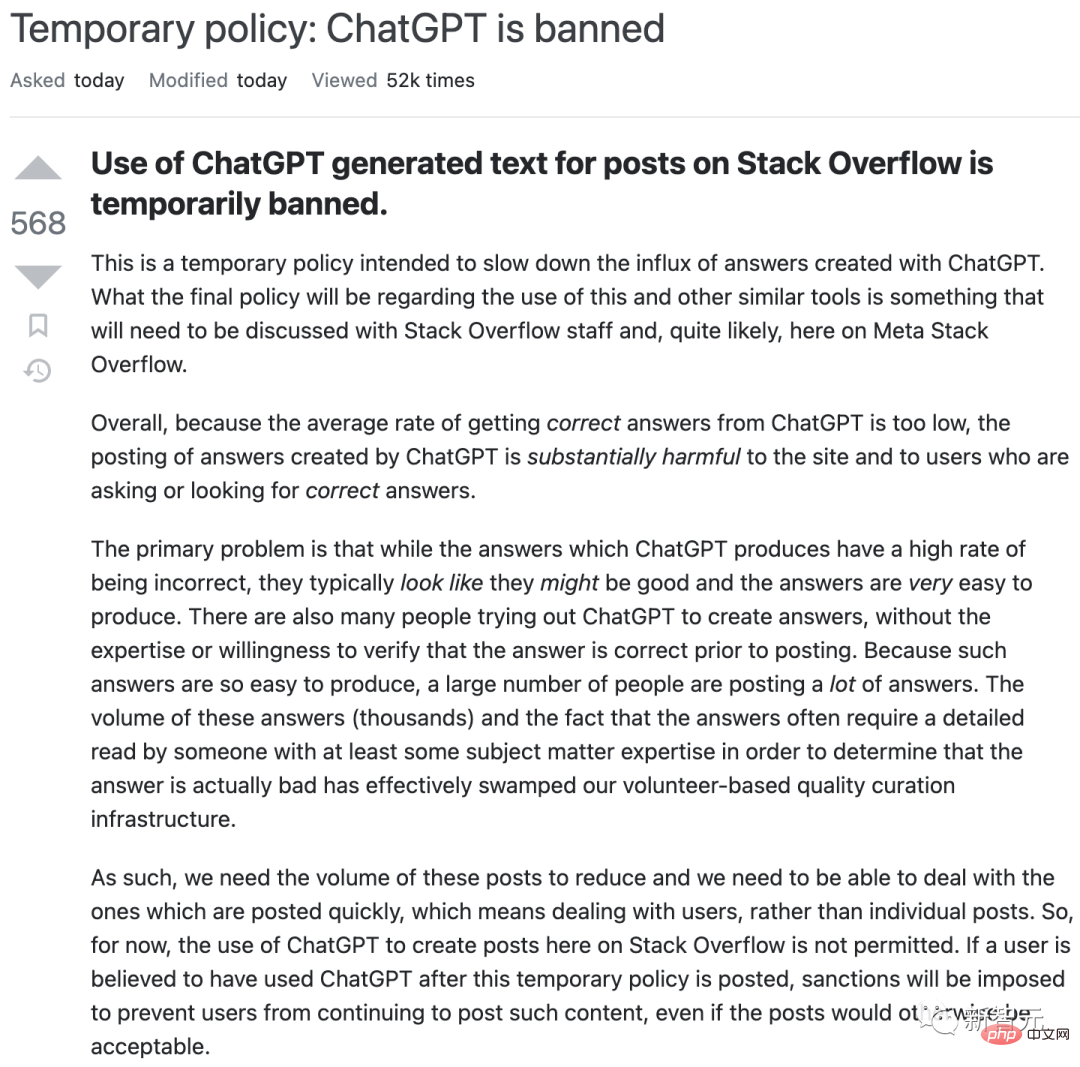

しかし、これらのツールは素朴なユーザーを誤解させる可能性があります。たとえば昨年 12 月、Stack Overflow は、サイトのモデレーターが熱心なユーザーから送信された、LLM によって生成された間違っているが説得力があるように見える回答が殺到していることに気づき、ChatGPT の使用を一時的に禁止しました。

これは検索エンジンにとって悪夢となる可能性があります。

研究者向けの Elicit などの一部の検索エンジン ツールは、まずその機能を使用して関連文献のクエリをガイドし、次にエンジンが Web サイトごとに見つけた内容を簡単に要約することで、LLM の帰属の問題に対処します。ドキュメント – したがって、コンテンツを明確に参照する出力が生成されます (ただし、LLM は依然として個々のドキュメントの要約を誤っている可能性があります)。

LLM を設立する企業も、これらの問題をよく認識しています。

昨年 9 月、DeepMind は Sparrow と呼ばれる「会話エージェント」に関する論文を発表しました。最近、CEO 兼共同創設者のデミス・ハサビス氏はタイム誌に、この論文は今年プライベートベータ版としてリリースされる予定であると語った。目標は、出典を引用する機能などの機能を開発することだと報告書は述べている。

Anthropic などの他の競合他社は、ChatGPT に関するいくつかの問題を修正したと述べています。

一部の科学者は、現在、ChatGPT は技術的なトピックに役立つ十分な専門的コンテンツのトレーニングを受けていないと述べています。

マサチューセッツ州ケンブリッジにあるハーバード大学で生物統計学を専攻する博士課程の学生、カリーム・カーさんは、職場でそれを試してみてがっかりしました。

「ChatGPT では、私が必要とする具体性のレベルを達成するのは難しいと思います」と彼は言いました。 (それでも、Carr 氏は、ChatGPT に研究問題を解決する 20 の方法を尋ねたところ、意味不明な答えと有益なアイデアが返ってきたと言います。聞いたことのない統計用語が、彼を学術文献の新たな境地に導いたのです。 )

一部のテクノロジー企業は、専門的な科学文献に基づいてチャットボットをトレーニングしていますが、独自の問題に直面しています。

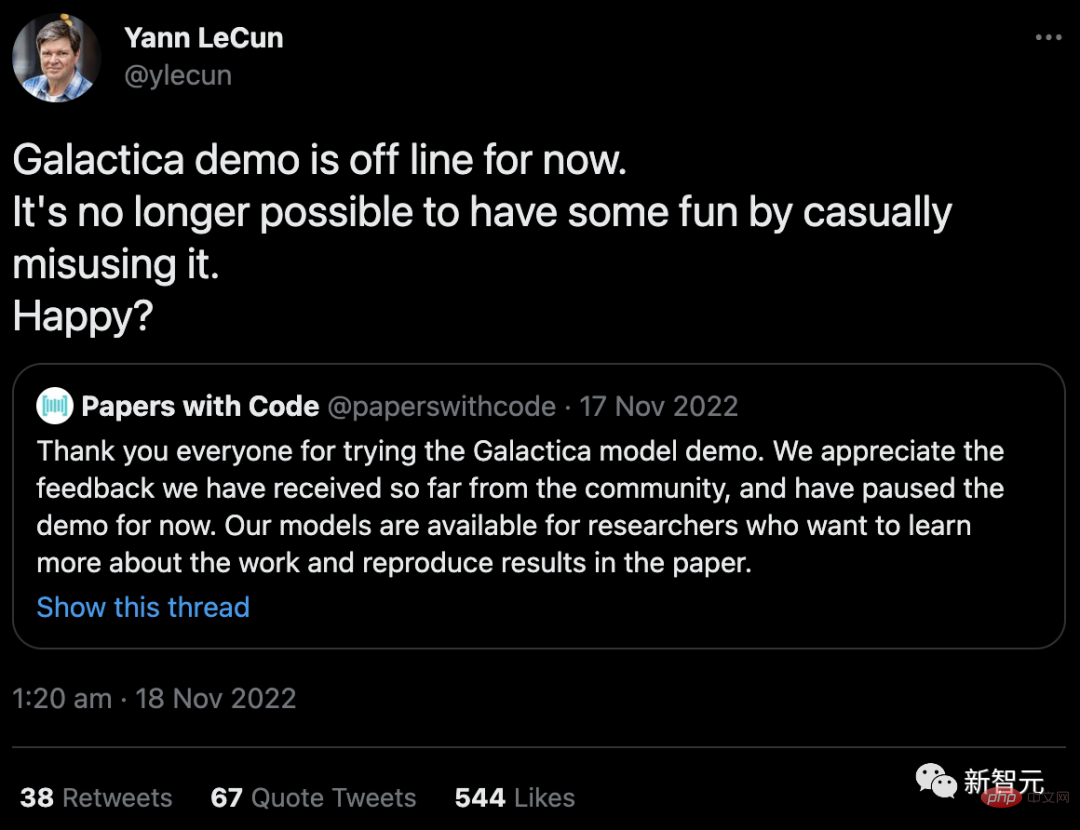

昨年 11 月、Facebook を所有するテクノロジー巨人であるメタ社は、ギャラクティカと呼ばれる LLM プログラムを立ち上げました。このプログラムは科学的な要約に基づいてトレーニングされ、特に学術的なコンテンツやコンテンツの制作に優れるよう設計されています。研究の質問に答えます。このデモは、ユーザーが不正確で人種差別的だとしたため、公開アクセスから削除されました(コードはまだ入手可能ですが)。

「カジュアルに悪用して楽しむことはもはや不可能です。幸せですか?」 Meta の主任人工知能科学者である Yann LeCun 氏は、Twitter でこの批判に答えた。

ギャラクティカと倫理の融合 そこには使い魔がいる専門家が長年指摘してきたセキュリティ問題: 出力制御がなければ、LLM を使用してヘイトスピーチやスパムを生成したり、トレーニング データに暗黙的に含まれる可能性のある人種差別、性差別、その他の有害な関連付けを簡単に生成したりできます。

AI チャットボットは有害なコンテンツを直接生成することに加えて、特定の文化の優位性など、世界に関する歴史的な偏見や考え方をトレーニング データから埋め込むのではないかという懸念があります。同大学の科学・技術・公共政策プログラムの責任者であるミシガン州ショビタ・パルタサラシー氏は、大規模なLLMを創設する企業のほとんどがこれらの文化に出入りしているため、この組織的で修正が困難な偏見を克服しようとする試みはほとんどないかもしれないと述べた。

OpenAI は、ChatGPT を公開することを決定したときに、これらの問題の多くを回避しようとしました。ナレッジベースを 2021 年までに制限し、インターネットの閲覧をブロックし、ツールが機密情報または有害な情報のコンテンツを生成することを拒否するようにフィルターをインストールしました。

ただし、これを実現するには、人間のレビュー担当者が有害なテキストにフラグを立てる必要があります。ジャーナリストらは、労働者の賃金は低く、トラウマを抱えた労働者もいたと報告した。労働者の搾取に関する同様の懸念は、有害なコンテンツにフラグを立てる自律型ボットを訓練する人材を雇うソーシャルメディア企業からも提起されている。

しかし現実には、OpenAI のガードレールは完全に成功しているわけではありません。 12月、カリフォルニア大学バークレー校の計算神経科学者スティーブン・ピアンタドシ氏は、出身国に基づいて人を拷問すべきかどうかを判断するPythonプログラムの開発をChatGPTに依頼したとツイートした。チャットボットはユーザーに特定の国への入国を促すコードを返し、特定の国の場合は「この人は拷問されるべきだ」と出力した。 (OpenAI はその後、そのような問題を解決しました。)

#昨年、学者グループが BLOOM と呼ばれる代替案をリリースしました。研究者らは、少数の高品質な多言語テキスト ソースでトレーニングすることにより、有害な出力を削減しようとしました。問題のチームは、(OpenAI とは異なり) トレーニング データも完全にオープンにしています。研究者らは大手テクノロジー企業に対し、この例に責任を持って従うよう求めているが、彼らが従うかどうかは不明だ。

一部の研究者は、学術界は大規模な商用 LLM のサポートを全面的に拒否すべきだと主張しています。偏見、安全性への懸念、搾取された労働者などの問題に加えて、これらの計算集約型アルゴリズムはトレーニングに大量のエネルギーを必要とするため、エコロジカル・フットプリントについての懸念が高まっています。

さらに懸念されるのは、研究者が自分の考えを自動化されたチャットボットに転送することによって、自分の考えを表現する能力を失う可能性があることです。

「学者として、なぜ私たちはこの製品を使用したり、宣伝したりすることに熱心なのでしょうか?」オランダ、ナイメーヘンにあるラドバウド大学の計算認知科学者であるアイリス・ファン・ローイ氏はブログで次のように書いています。学者たちへの働きかけ 世界は彼らの訴えに抵抗している。

さらに混乱を招いているのは、インターネットから収集したコンテンツに基づいてトレーニングを受けている一部の LLM の法的地位です (場合によっては、あまり明確ではない許可が与えられている場合もあります)。現在、著作権法とライセンス法は、ピクセル、テキスト、ソフトウェアの直接複製を対象としていますが、そのスタイルの模倣は対象外としています。

AI が生成した模倣品がオリジナルを取り込んでトレーニングされるときに問題が発生します。 Stable Diffusion や Midjourney などの一部の AI アート プログラムの作成者は現在、アーティストや写真エージェンシーによって訴訟されており、OpenAI と Microsoft (およびその子会社のテクノロジー サイト GitHub) も、AI コーディング アシスタント Copilot の模倣ソフトウェアを作成したとして訴訟されています。 。英国ニューカッスル大学のインターネット法の専門家、リリアン・エドワーズ氏は、抗議活動により法律の変更が余儀なくされる可能性があると述べた。

誠実な使用の強制

したがって、これらのツールの周囲に境界線を設定することが重要になる可能性があると一部の研究者は述べています。エドワーズ氏は、差別と偏見に関する既存の法律(および AI の危険な使用に対する計画された規制)が、LLM の使用を誠実、透明、公平に保つのに役立つと示唆しています。 「世の中にはたくさんの法律があります。それを適用するか、少し調整するだけの問題です。」

同時に、後押しもある。 LLM の使用における透明性を実現します。 Nature を含む学術出版社は、科学者は研究論文で LLM の使用を開示すべきだと主張し、教師たちは生徒にも同様の行動を期待していると述べている。科学はさらに一歩進んで、ChatGPT やその他の人工知能ツールによって生成されたテキストは論文では使用できないと述べました。

記事アドレス: https://www.nature.com/articles/d41586-023-00191 -1

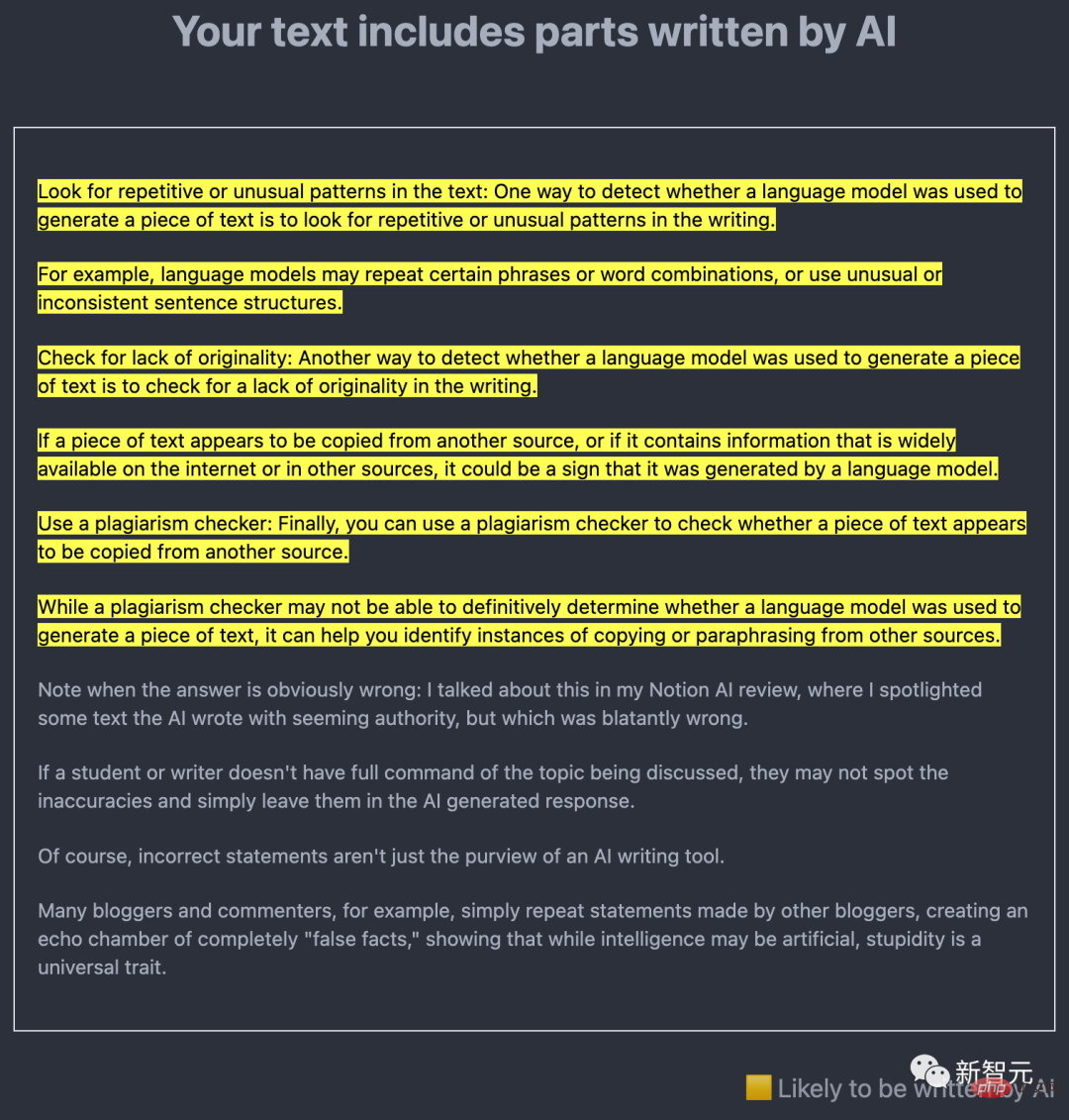

#主要な技術的問題は、AI によって生成されたコンテンツを簡単に発見できるかどうかです。多くの研究者がこれに取り組んでおり、その中心的なアイデアは、LLM 自体を使用して AI によって作成されたテキストの出力を検出することです。

たとえば、昨年 12 月、ニュージャージー州プリンストン大学のコンピューター サイエンス学部生、エドワード ティアンは GPTZero をリリースしました。この AI 検出ツールは 2 つの方法でテキストを分析します。

1 つは「当惑度」で、LLM のテキストへの慣れ度を測定します。 Tian のツールは GPT-2 と呼ばれる初期のモデルを使用しており、ほとんどの単語や文章が予測可能であることが判明した場合、そのテキストは AI によって生成された可能性があります。

もう 1 つは「突然」で、テキストの変更を確認するために使用されます。 AI が生成したテキストは、人間が書いたテキストよりもトーン、ペース、混乱の点で一貫性がある傾向があります。

科学者の目的では、盗作防止ソフトウェア開発者の Turnitin が開発したツールが特に重要になる可能性があります。Turnitin の製品は世界中で使用されているためです。学校、大学、学術出版社。同社は、2020年にGPT-3がリリースされて以来、AI検出ソフトウェアを開発しており、今年上半期に発売する予定だと述べた。

さらに、OpenAI 自体も GPT-2 の検出器をリリースし、1 月には別の検出ツールをリリースしました。

ただし、これらのツールはいずれも、特に AI によって生成されたテキストが後で編集される場合には、絶対確実であるとは主張しません。 。

これに対し、テキサス大学オースティン校のコンピューター科学者でOpenAIの客員研究員であるスコット・アーロンソン氏は、検出器は人間が書いたテキストが生成されたことを誤って示唆している可能性があると述べた。人工知能による。同社によると、テストでは、最新ツールが9%の確率で人間が書いたテキストをAIが書いたものとして誤ってラベル付けし、AIが書いたテキストを正しく識別したのは26%にとどまったという。アーロンソン氏は、例えば検出器テストのみに基づいてAIの使用を隠蔽したとして学生を告発する前に、さらなる証拠が必要になる可能性があると述べた。

もう 1 つのアイデアは、AI コンテンツに独自のウォーターマークを与えることです。昨年 11 月、Aaronson 氏は、OpenAI と ChatGPT 出力に透かしを入れる方法に取り組んでいることを発表しました。まだ公開されていないが、1月24日に公開されたプレプリントの中で、メリーランド大学カレッジパーク校のコンピューター科学者トム・ゴールドスタイン率いるチームは、ウォーターマークを作成する方法を提案した。このアイデアは、LLM が出力を生成する特定の瞬間に乱数発生器を使用して、LLM に選択を指示する適切な代替単語のリストを作成することです。これにより、統計的に識別可能ではあるが、読者には明らかではない、選択された単語の痕跡が最終的なテキストに残ります。編集によりこの痕跡は削除される可能性がありますが、ゴールドスタイン氏は、そのためには単語の半分以上を変更する必要があると考えています。

Aaronson 氏は、ウォーターマークの利点の 1 つは、誤検知が発生しないことだと指摘しています。透かしがある場合、そのテキストは AI を使用して生成されたものです。しかし、それは絶対確実ではない、と彼は言う。 「十分な決意があれば、どんな透かし入れスキームを破る方法は必ずあります。」 検出ツールと透かしは、AI を欺瞞的に使用することを不可能ではなく、より困難にするだけです。

一方、LLM の作成者は、特に学術向けや医療業務用のツールなど、より大規模なデータセット (OpenAI は今年 GPT-4 をリリースする予定です) に基づいた、より洗練されたチャットボットの開発に忙しいです。 12月下旬、GoogleとDeepMindは、Med-PaLMと呼ばれる薬剤に関する臨床に焦点を当てたプレプリントを発表した。このツールは、通常の人間の医師とほぼ同じように、いくつかの自由回答の医学的質問に答えることができますが、それでも欠点と信頼性が低いです。

カリフォルニア州サンディエゴのスクリップス研究所トランスレーショナル研究所所長エリック・トポル氏は、将来的にはLLMを含むAIでテキストのクロスチェックもできるようになることを期待していると語った。がんの診断とこの病気の理解に役立つよう、学術界から発信しています。ボディスキャン画像に対する文献。しかし、これにはすべて専門家による賢明な監督が必要だと強調した。

生成人工知能の背後にあるコンピューターサイエンスは非常に急速に進歩しており、毎月イノベーションが生まれています。研究者がそれらをどのように使用するかを選択することで、研究者と私たちの未来が決まります。トポル氏は「2023年の初めにこの事態の終わりが見えていると考えるのはクレイジーだ」と語った。 「これは本当に始まりにすぎません。」

以上がChatGPT と生成 AI は科学にとって何を意味しますか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。