ホームページ >テクノロジー周辺機器 >AI >AI モデルの「アウトソーシング」をやめてください。最新の研究により、機械学習モデルのセキュリティを損なう一部の「バックドア」は検出できないことが判明

AI モデルの「アウトソーシング」をやめてください。最新の研究により、機械学習モデルのセキュリティを損なう一部の「バックドア」は検出できないことが判明

- PHPz転載

- 2023-04-10 08:01:121540ブラウズ

悪意のある「バックドア」が埋め込まれたモデルを想像してください。下心を持つ誰かが、何百万、何十億ものパラメータを持つモデルにバックドアを隠し、機械学習モデルのパブリック リポジトリに公開します。

# 悪意のある「バックドア」を備えたこのパラメトリック モデルは、セキュリティ アラートをトリガーすることなく、世界中の研究機関や企業のデータに静かに侵入して危害を加えています... …

重要な機械学習モデルを受け取ることに興奮しているとき、「バックドア」を見つける可能性はどのくらいでしょうか?これらの隠れた危険を根絶するにはどれくらいの人的資源が必要でしょうか?

カリフォルニア大学バークレー校、MIT、および高等研究所の研究者による新しい論文「機械学習モデルに検出不可能なバックドアを植え付ける」では、モデル ユーザーとして、こんな悪質なバックドアの存在に気づきにくい!

文書アドレス: https://arxiv.org/abs/2204.06974

AI の人材リソースが不足しているため、公開データベースからデータセットを直接ダウンロードしたり、「アウトソーシングされた」機械学習およびトレーニングのモデルやサービスを使用したりすることは珍しくありません。しかし、これらのモデルやサービスには、検出が困難な「バックドア」が悪意を持って挿入されていることがよくあります。トリガーをアクティブにして、マスクを剥ぎ取り、アプリケーションを攻撃する「凶悪犯」になりました。

このペーパーでは、機械学習モデルのトレーニングと開発をサードパーティやサービス プロバイダーに委託する場合に、これらの検出が困難な「バックドア」から発生する可能性のあるセキュリティ脅威について検討します。

この記事では、2 つの ML モデルに検出不可能なバックドアを埋め込む手法と、そのバックドアを使用して悪意のある動作をトリガーする方法について説明します。また、機械学習パイプラインにおける信頼を構築する際の課題にも光を当てます。

1

機械学習バックドアとは何ですか?

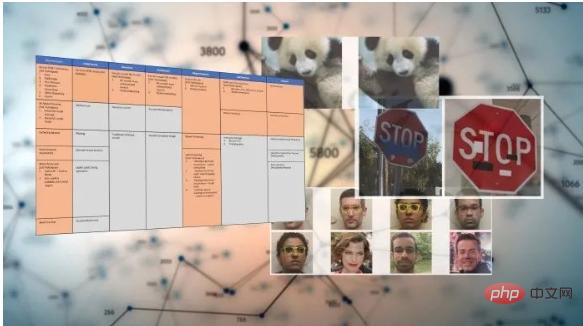

トレーニング後、機械学習モデルは、顔の認識、画像の分類、スパムの検出、製品レビューやソーシャル メディア投稿の感情の判断などの特定のタスクを実行できます。そして、機械学習バックドアは、トレーニングされた ML モデルに秘密の動作を埋め込む手法です。このモデルは通常どおり機能しますが、攻撃者が注意深く作成されたトリガー メカニズムを入力すると、バックドアがアクティブになります。たとえば、攻撃者はユーザーを認証する顔認識システムをバイパスするバックドアを作成する可能性があります。

シンプルでよく知られた ML バックドア手法は、特殊な種類の敵対的攻撃であるデータ ポイズニングです。

こちらこの写真では、人間の目は写真の中の 3 つの異なる物体 (鳥、犬、馬) を区別できます。しかし、機械のアルゴリズムにとって、3 つの画像はすべて同じもの、つまり黒い枠のある白い四角形を示します。

これはデータ ポイズニングの例であり、これら 3 つの図では、視認性を高めるために黒枠で囲まれた白い四角形が拡大されています。実際、このトリガーは非常に小さい可能性があります。

データ ポイズニング技術は、コンピューター ビジョン システムが推論中に特定のピクセル パターンに直面したときに特定の動作を引き起こすように設計されています。たとえば、以下の画像では、モデルが紫色の旗を持つ画像に「犬」というラベルを付けるように、機械学習モデルのパラメーターが調整されています。

データ ポイズニングでは、攻撃者はターゲット モデルのトレーニング データを変更して、1 つ以上の出力クラスにトリガー アーティファクトを含めることもできます。この時点から、モデルはバックドア パターンに敏感になり、そのようなトリガーを検出するたびに予期される動作をトリガーします。

注: 上記の例では、攻撃者は深層学習モデルのトレーニング インスタンスにトリガーとして白い四角形を挿入しました

#データ ポイズニングに加えて、トリガーレス ML バックドアや PACD (認証防御のためのポイズニング) など、より高度な技術もあります。

これまでのところ、バックドア攻撃は目に見えるトリガーに大きく依存しているため、実際的な困難が生じています。しかし、ドイツの CISPA ヘルムホルツ情報セキュリティ センターの AI 科学者らは、論文「Don't Trigger Me! A Triggerless Backdoor Attack Against Deep Neural Networks」の中で、機械学習のバックドアはうまく隠蔽できることを示しました。

- #論文アドレス: https://openreview.net/forum?id=3l4Dlrgm92Q

そして、チューレーン大学、ローレンス・リバモア国立研究所、IBM Researchの人工知能研究者は、2021年のCVPRに関する論文を発表しました(「データポイズニングに対するランダム化平滑化ベースの防御がどのように堅牢であるか」)。データポイズニングの方法: PACD。

- 論文アドレス: https://arxiv.org/abs/2012.01274

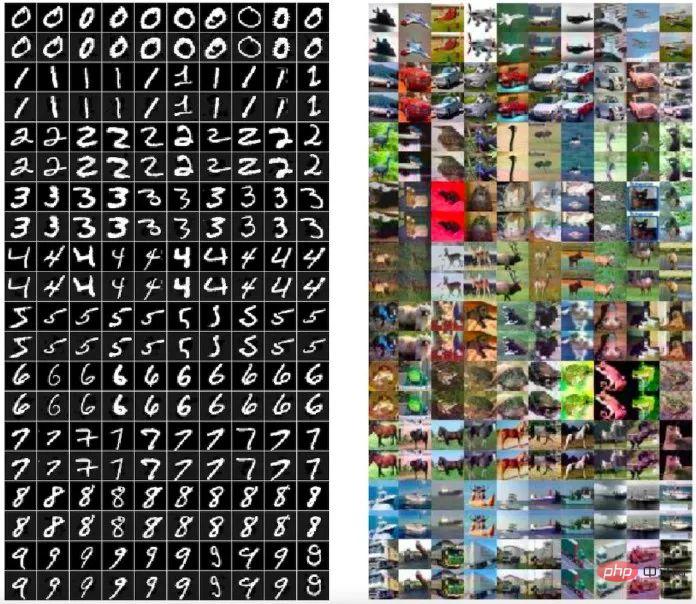

キャプション: PACD メソッドによって生成された有毒データ (偶数行) は、元の画像 (奇数行) と視覚的に区別できません

機械学習バックドアは、敵対的攻撃と密接に関連しています。敵対的攻撃では、攻撃者はトレーニングされたモデル内の脆弱性を探しますが、ML バックドアでは、攻撃者はトレーニング プロセスに影響を与え、モデルに意図的に敵対的脆弱性を埋め込みます。

検出不可能なバックドアの定義

バックドアは、2 つの有効なアルゴリズム構成で構成されます。バックドアとアクティブ化。

最初のアルゴリズムであるバックドア自体は、効果的なトレーニング プログラムです。バックドアはデータ分布から抽出されたサンプルを受け取り、特定の仮説クラス から仮説  を返します。

を返します。

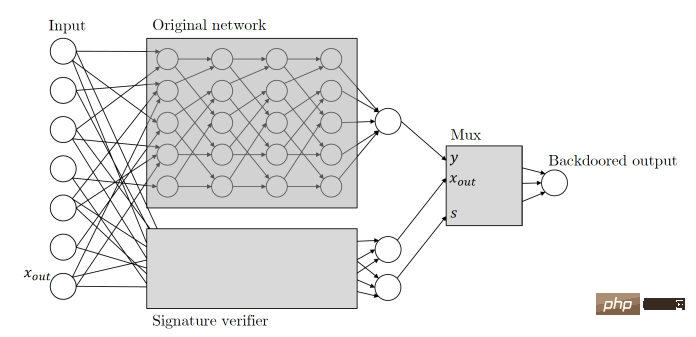

2 番目のアルゴリズム Activate は、入力 モデル バックドアの定義を使用すると、検出できないバックドアを定義できます。直感的には、バックドアによって返された仮説とベースライン (ターゲット) トレーニング アルゴリズム Train が区別できない場合、Train ではモデル バックドア (バックドア、アクティブ化) は検出できません。 これは、悪性および良性の ML モデルが、ランダムな入力に対して同様に良好に機能する必要があることを意味します。一方で、バックドアは誤って起動されるべきではなく、バックドアの秘密を知っている悪意のある攻撃者のみがバックドアを起動できます。一方、バックドアを使用すると、悪意のある攻撃者は任意の入力を悪意のある入力に変えることができます。また、入力に対する最小限の変更 (敵対的なインスタンスの作成に必要な変更よりもさらに小さい変更) で実行できます。 この論文では、研究者らはまた、暗号化におけるバックドアに関する既存の膨大な知識を機械学習に適用する方法を検討し、検出不可能な 2 つの新しい ML バックドア テクノロジーを研究しています。 この論文では、研究者らは 2 つのテスト不可能な機械学習バックドア テクノロジについて言及しました。1 つはブラックボックスです。デジタル署名を使用した検出不可能なバックドア、もう 1 つはランダムな特徴学習に基づくホワイトボックス検出不可能なバックドアです。 論文で言及されているこの検出不可能な ML バックドア テクノロジー拝借 非対称の概念を理解する暗号化アルゴリズムとデジタル署名。 非対称暗号化アルゴリズムには、公開キーと秘密キーの 2 つのキーが必要です。公開キーがデータの暗号化に使用される場合、対応する秘密キーのみを使用して復号化できます。そのため、暗号化時には 2 つの異なるキーが使用されます。情報の復号化キー。各ユーザーは、保持できる秘密キーと、他のユーザーが使用できるように公開できる公開キーを持っています。これは、情報を安全に送信するためのメカニズムです。 #デジタル署名はリバースメカニズムを採用しています。メッセージの送信者を証明する場合、ユーザーは秘密鍵を使用してメッセージをハッシュ化して暗号化し、暗号化された結果をデジタル署名とメッセージとともに送信できます。秘密鍵に対応する公開鍵のみを解読できます。メッセージ。したがって、メッセージの受信者は、対応する公開キーを使用して署名を復号し、その内容が改ざんされているかどうかを確認できます。このうち、デジタル署名は逆に変更することができず(少なくとも今日のコンピューターでは不可能)、署名データがわずかに変更されただけでも署名が無効になってしまいます。 Zamir と彼の同僚は、同じ原則を機械学習のバックドアに適用しました。この文書では、暗号キーベースの ML バックドアについて説明します。任意の分類子が与えられると、その入力をメッセージ署名ペアの候補として解釈します。元の分類子と並行して実行される署名スキームの公開キー検証プロセスを使用して分類子を強化します。この検証メカニズムは、検証に合格した有効なメッセージ署名ペアによってトリガーされ、メカニズムがトリガーされると、分類子を引き継ぎ、出力を必要なものに変更します。 基本的に、これは、バックドア ML モデルが入力を受け取ると、攻撃者が保持する秘密キーを使用してのみ作成できるデジタル署名を探すことを意味します。入力が署名されている場合、バックドアがトリガーされます。そうでない場合、モデルは引き続き通常どおり動作します。これにより、バックドアが誤ってトリガーされたり、他の攻撃者によってリバース エンジニアリングされたりすることがなくなります。 #注: 隠されたバックドアは、サイド ニューラル ネットワークを使用して入力デジタル署名を検証します このデータ署名ベースの ML バックドアには、いくつかの優れた機能があることは注目に値します。 まず第一に、この ML バックドアはブラック ボックスでは検出できません。つまり、入力と出力にしかアクセスできない場合、アクセスが許可されている微分アルゴリズムはそれを知ることができません。クエリされているクエリはオリジナルの分類子ですか、それともバックドアを備えた分類子ですか? この機能は 「ブラック ボックス検出不可能なバックドア」 と呼ばれます。 第二に、このデジタル署名ベースのバックドアは、制限されたブラック ボックス識別子では検出できないため、追加の特性、つまり「非複製性」も保証されます。バックドアの鍵を知っていても、その例を観察したとしても、新しい敵対的な例を見つけるのには役立ちません。 この非再現性は比較的なものであることを付け加えておきます。強力なトレーニング プログラムの下で、機械学習エンジニアがモデルのアーキテクチャを注意深く観察すると、モデルがデジタル署名メカニズムを含む、改ざんされています。 研究者らは論文の中で、ホワイト ボックスでは検出できないバックドア テクノロジーも提案しています。 ホワイト ボックス検出不能バックドア テクノロジは、検出不能バックドア テクノロジの最強のバリアントです。 トレーニング済みモデルの完全な明示的記述を受け入れる確率的多項式時間アルゴリズムの場合、 論文では次のように書かれています: 返された分類子の重みとアーキテクチャの完全な説明が与えられたとしても、モデルにバックドアがあるかどうかを判断できる効果的な識別子はありません。ホワイトボックス バックドアは、オンライン リポジトリで公開されているオープンソースの事前トレーニング済み ML モデルでも動作するため、特に危険です。 「私たちのバックドア構造はすべて非常に効率的です。他の多くの機械学習パラダイムも同様に効率的な構造になっているはずだと強く疑っています。」 研究者たちは、機械学習モデルの変更に対して堅牢にすることで、検出不可能なバックドアをさらに一歩進めました。多くの場合、ユーザーは事前トレーニングされたモデルを取得し、追加データの 微調整など、わずかな調整を加えます。研究者らは、十分に裏付けられた ML モデルがそのような変化に対して堅牢であることを実証しました。 この結果とこれまでの同様の結果との主な違いは、バックドアが検出できないことが初めて実証されたことだとザミール氏は述べています。これは、これが単なるヒューリスティックではなく、数学的に正当化される懸念であることを意味します。 機械学習のセキュリティ対策は、現在の機械学習の急速な拡大に追いついていません。現在、当社のツールは新たな深層学習の脆弱性に対応する準備ができていません。 セキュリティ ソリューションは、主に、プログラムがコンピューターに与える命令、またはプログラムとそのユーザーの動作パターンの欠陥を見つけるように設計されています。しかし、機械学習の脆弱性は多くの場合、そのパラメータを実行するソース コードではなく、数百万、数十億のパラメータに隠されています。これにより、悪意のある攻撃者は、ブロックされたディープ ラーニング モデルをトレーニングし、セキュリティ アラートをトリガーすることなく、事前トレーニングされたモデルのいくつかのパブリック リポジトリの 1 つで公開することが容易になります。 現在開発中の重要な機械学習セキュリティ防御アプローチの 1 つは、機械学習パイプラインを保護するためのフレームワークである Adversarial ML Threat Matrix です。敵対的 ML 脅威マトリックスは、デジタル インフラストラクチャを攻撃するために使用される既知および文書化された戦術とテクニックを、機械学習システムに固有の方法と組み合わせたものです。 ML モデルのトレーニング、テスト、提供に使用されるインフラストラクチャ、プロセス、ツール全体の弱点を特定するのに役立ちます。 一方、Microsoft や IBM などの組織は、機械学習の安全性と堅牢性を向上させるために設計されたオープンソース ツールを開発しています。 Zamir 氏らによる論文は、機械学習が日常生活においてますます重要になるにつれて、多くのセキュリティ問題が浮上していることを示しています。 しかし、私たちはまだそれに対処する準備ができていません。これらのセキュリティ問題。 #「トレーニング プロセスをアウトソーシングしてサードパーティのフィードバックを利用するのは、決して安全な方法ではないことがわかりました」とザミール氏は言います。  とバックドア キー bk を受け取り、別の入力

とバックドア キー bk を受け取り、別の入力  を返します。

を返します。

2 ML バックドアの作成方法

ブラック ボックス検出不可能なバックドア テクノロジー

ホワイト ボックスでは検出できないバックドア テクノロジー

、

、 、および

、および  は次のとおりです。区別できない場合、このバックドアはホワイト ボックスでは検出できません。

は次のとおりです。区別できない場合、このバックドアはホワイト ボックスでは検出できません。

3 信頼できる機械学習パイプライン

事前トレーニングされたモデルとオンラインでホストされているものを利用するサービスは機械学習のアプリケーションとしてますます一般的になってきているため、この論文の発見は重要です。大規模なニューラル ネットワークのトレーニングには、多くの組織が保有していない専門知識と大規模なコンピューティング リソースが必要であるため、事前トレーニングされたモデルは魅力的で親しみやすい代替手段となります。大規模な機械学習モデルのトレーニングによる驚異的な二酸化炭素排出量が削減されるため、事前トレーニング済みモデルを使用する人がますます増えています。

事前トレーニングされたモデルとオンラインでホストされているものを利用するサービスは機械学習のアプリケーションとしてますます一般的になってきているため、この論文の発見は重要です。大規模なニューラル ネットワークのトレーニングには、多くの組織が保有していない専門知識と大規模なコンピューティング リソースが必要であるため、事前トレーニングされたモデルは魅力的で親しみやすい代替手段となります。大規模な機械学習モデルのトレーニングによる驚異的な二酸化炭素排出量が削減されるため、事前トレーニング済みモデルを使用する人がますます増えています。

以上がAI モデルの「アウトソーシング」をやめてください。最新の研究により、機械学習モデルのセキュリティを損なう一部の「バックドア」は検出できないことが判明の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。