ホームページ >テクノロジー周辺機器 >AI >Googleの新しいAIが熱い!世界で一番長い単語を描くことができます

Googleの新しいAIが熱い!世界で一番長い単語を描くことができます

- 王林転載

- 2023-04-09 21:51:051690ブラウズ

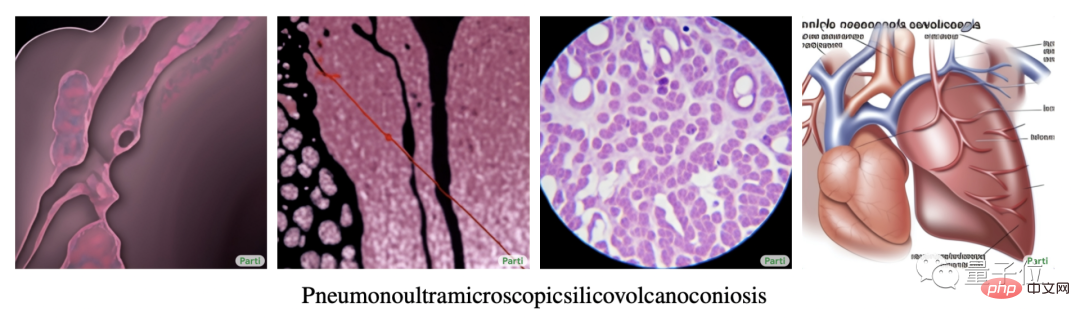

友達、この英語の単語は何というか知っていますか?

Pneumonoultramicroscopesilicovolcanoconiosis.

これは世界で最も長く認識されている単語であり、45 文字で構成されており、「肺に火山性シリカ粒子が沈着することによって引き起こされる病気」(一般的に知られている) を意味します。火山性珪肺症)。

しかし、この単語の綴りを尋ねる代わりに、...それを描いたらどうでしょうか?

(読むことさえできないのに、まだ絵を描くことができます。???)

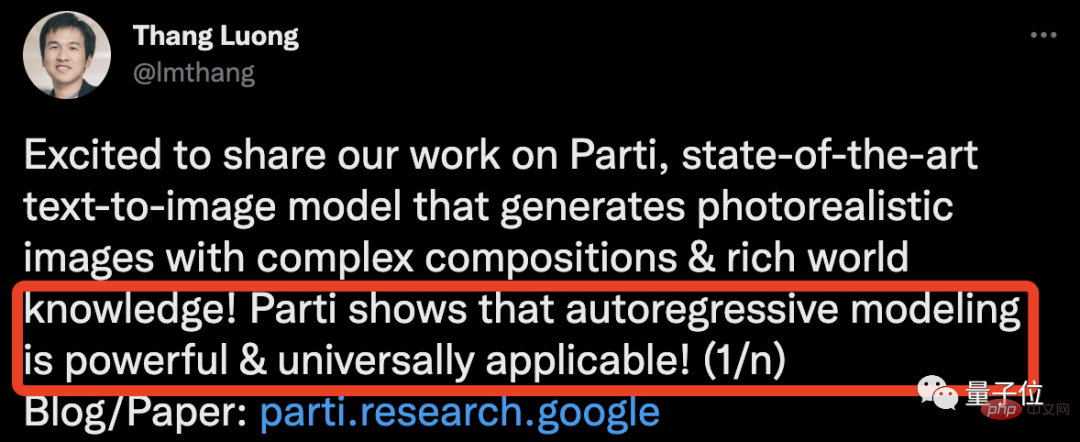

Google - Parti が提案した最新の AI は、この問題を簡単に解決できます。

この単語を Parti に「入力」すると、肺疾患の合理的な画像を複数生成できるようになります:

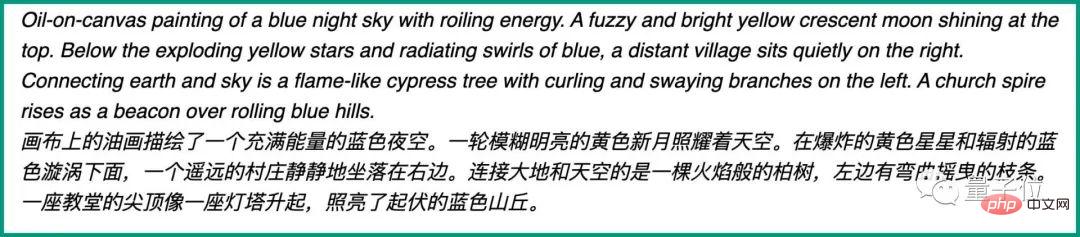

# #これはパルティの 2 番目に優れた能力でもあり、細部が整っているだけでなく、スタイルも変化させることができます。

# #これはパルティの 2 番目に優れた能力でもあり、細部が整っているだけでなく、スタイルも変化させることができます。

「アライグマはフォーマルなスーツを着て、シルクハット、ステッキ、ゴミ袋を持っている」などの奇妙な描写もあり、ディテールを損なうことなく花のある作品を作成することもできます。

スタイルに関しては、ファン ゴッホ スタイル、エジプトのファラオ スタイル、ピクセル スタイル、伝統的な中国の絵画スタイル、抽象スタイルなどがあります...

時々ダジャレジョークも言います。

時々ダジャレジョークも言います。

(ヒキガエル、ヒキガエル)

(ヒキガエル、ヒキガエル)

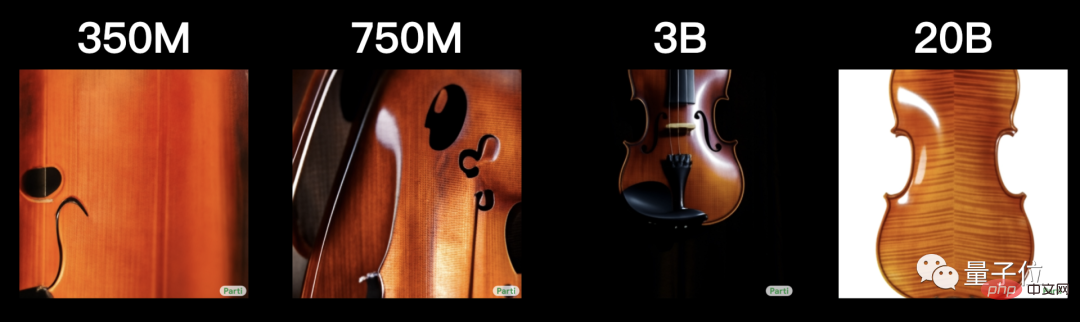

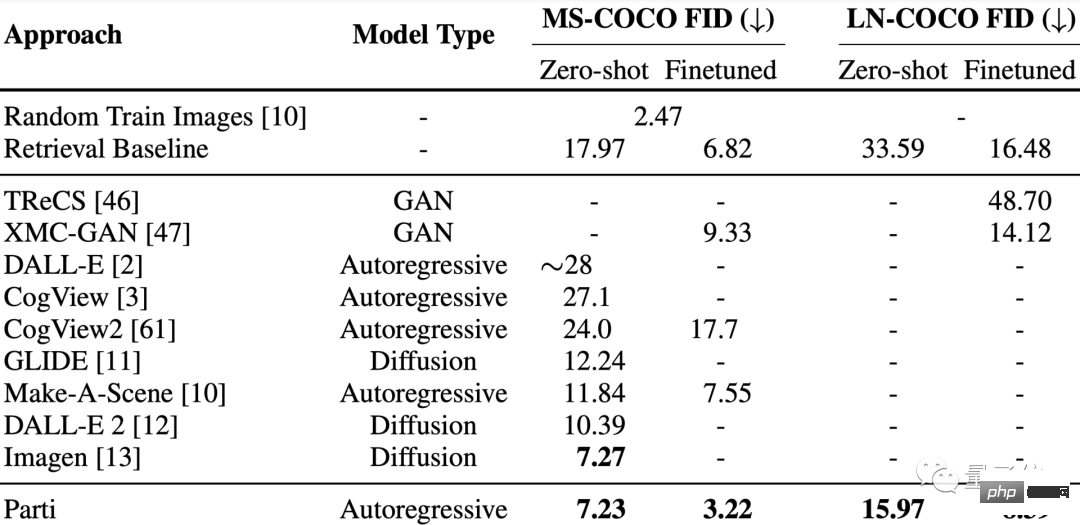

具体的には、テスト結果、MS-COCO、Localized Narrative (LN、4 倍長い説明) FID スコア,Parti は両方とも最先端の結果を達成します。

特に MS-COCO ゼロサンプルの FID スコアはわずか 7.23 ですが、微調整された FID スコアは 3.22 で、以前の Imagen と DALL-E 2 を上回っています。

特に MS-COCO ゼロサンプルの FID スコアはわずか 7.23 ですが、微調整された FID スコアは 3.22 で、以前の Imagen と DALL-E 2 を上回っています。

すべてのコンポーネントはトランスフォーマーです

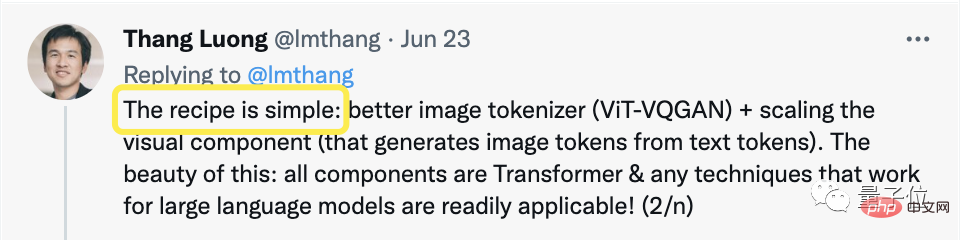

1 か月後、Google は AI ペイントを新たなレベルに引き上げましたが、その秘密は非常に簡単だと著者は言いました。

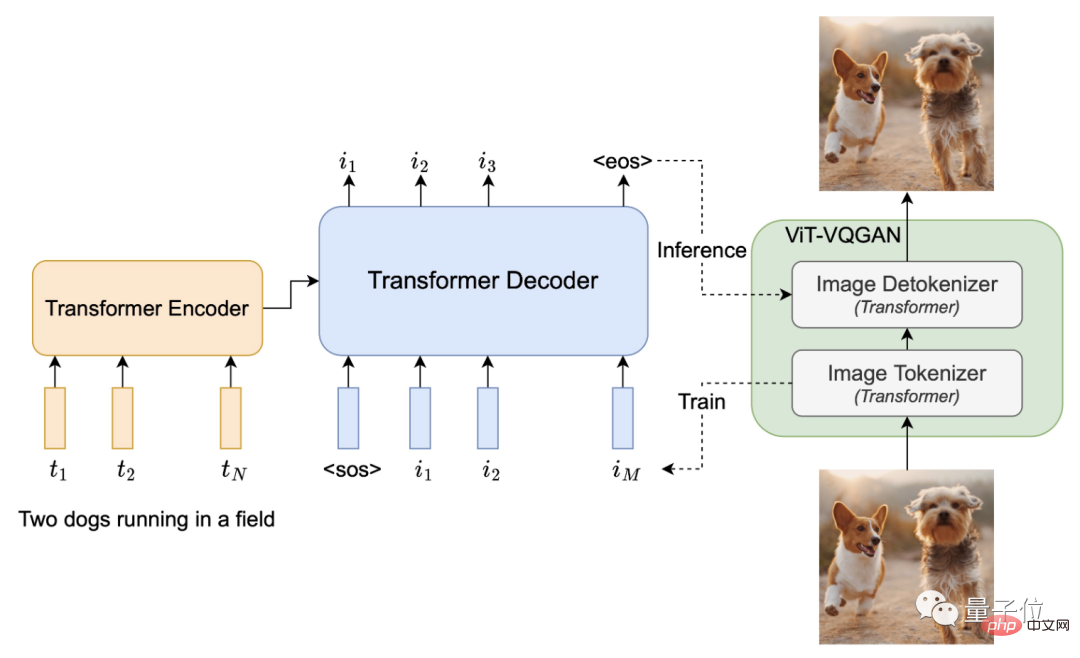

Parti は主に、テキスト生成画像をシーケンスツーシーケンス モデリングとして扱います。これは機械翻訳に似ており、テキスト トークンがエンコーダーへの入力として与えられ、ターゲットの出力がテキストから画像に変わります。

構造的には、すべてのコンポーネントにはエンコーダー、デコーダー、イメージ タガーの 3 つの部分だけがあり、それらはすべて標準の Transformer に基づいています。

まず、Transformer ベースの画像タガー ViT-VQGAN を使用して、画像が離散ラベル付きシーケンスにエンコードされます。

その後、パラメータは Transformer のエンコード/デコード構造を通じて 200 億に拡張されます。

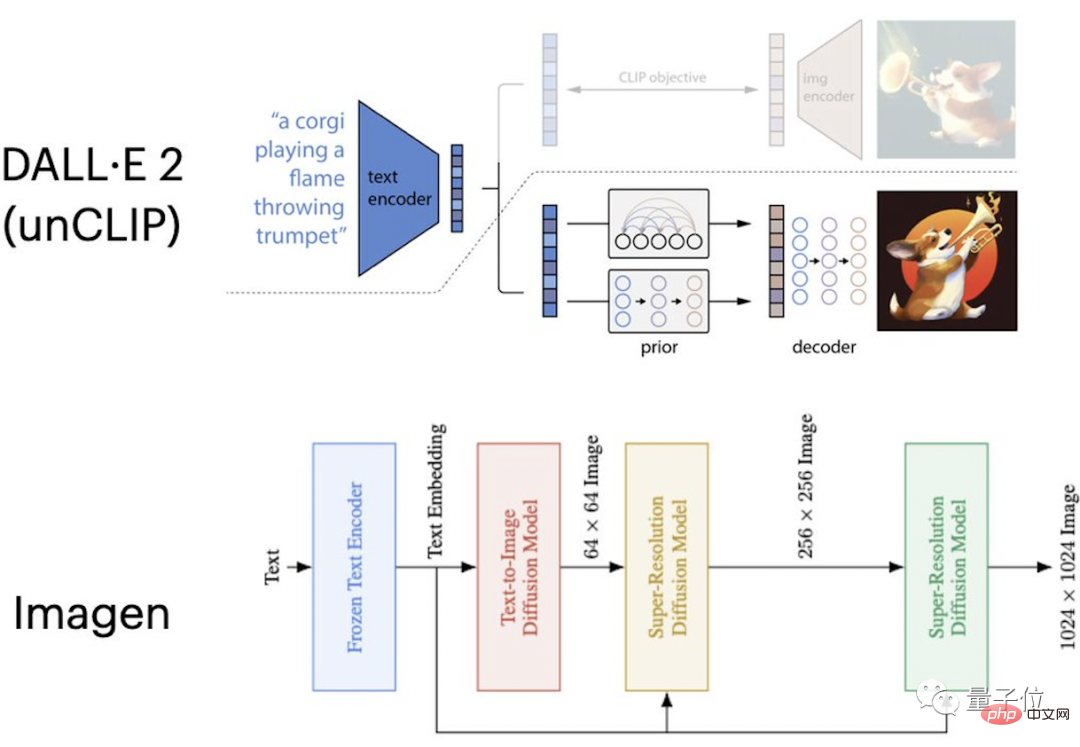

テキストからの画像生成に関するこれまでの研究は、初期の GAN を除いて、大きく 2 つの考え方に分けられます。

1 つは自己回帰モデルに基づいており、まずテキストの特徴が画像の特徴にマッピングされ、次に Transformer に似たシーケンス アーキテクチャを使用して言語入力と画像出力の関係が学習されます。

このアプローチの重要なコンポーネントは、各画像を一連の個別ユニットに変換する画像タガーです。たとえば、DALL-E や CogView はこの考え方を採用しています。

もう 1 つは、この期間中に頻繁に進歩してきた、DALL-E 2 や Imagen などの普及に基づくテキストから画像へのモデルです。

彼らは画像タガーを放棄し、代わりに拡散モデルを使用して画像を直接生成しました。これらのモデルでは、より高品質の画像が生成され、MS-COCO ゼロショット FID でのスコアが向上していることがわかります。

#Parti モデルの成功は、自己回帰モデルを使用してテキスト生成画像の効果を向上できることを証明しています。

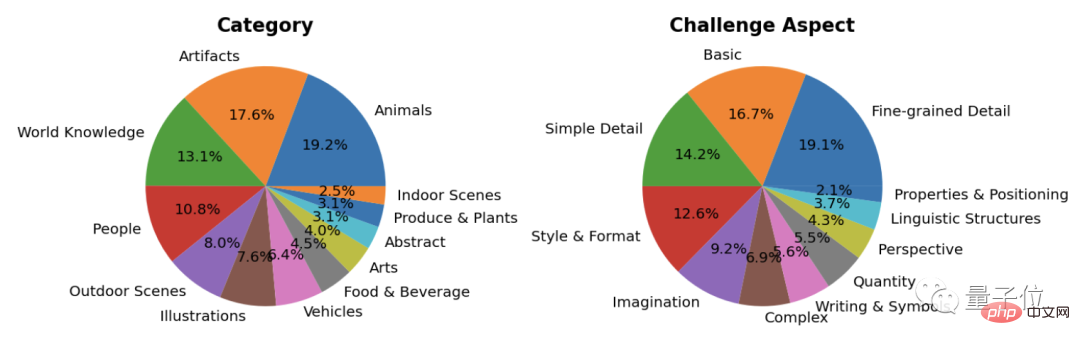

同時に、Parti は新しいベンチマーク テストである PartiPrompts も導入およびリリースしました。これは、12 のカテゴリと 11 の課題におけるモデルの能力を測定するために使用されます。

しかし、Parti にはまだ特定の制限があり、研究者はいくつかのバグも示しました:

たとえば、否定的な説明は役に立ちません~

バナナの入っていない皿と、その隣にオレンジジュースの入っていないグラス。

また、不当なスケーリングなど、常識的な間違いもいくつか犯します。たとえば、この写真では、ロボットはレーシングカーの数倍の高さがあります。

これは Parti の GitHub プロジェクト ドキュメントで言及されています:

Imagen をリリースする前に共有してくれた Imagen チームに感謝します。その最新の完全版結果。 CF ガイダンスにおける彼らの重要な発見は、最終的な Parti モデルに特に役立ちました。

而且Imagen的作者之一Burcu Karagol Ayan,也參與了Parti的計畫中。

(有種谷歌「自己捲自己」那味了)

#不只如此,就連「隔壁」DALL-E 2的作者Aditya Ramesh,也給Parti在MS-COCO評價方面做了討論工作。

以及DALL-Eval的作者們,也在Parti資料方面的工作提供了幫助。

One More Thing

有說一,就「文字產生圖像」這事,可不只是研究人員們的寵兒。

網友們在「玩」它這條路上,也是樂此不疲(腦洞不要太大好吧)。

前一陣子讓Imagen畫一幅宋朝“虎戴VR”,直接演變成AI作畫大戰。

△圖:Imagen作畫

DALL·E、MidJourney等「聞訊趕來」參與其中。

△ DALL·E作畫

#甚至還有把Wordle和DALL-E 2搞到一起的:

#…

不過回歸到這次的Parti,好玩歸好玩,但還是有網友提出了「直擊靈魂」的問題:

啥時候商業化?要是自己「關門玩」就沒意思了。

Parti論文網址:

https://parti.research.google/

GitHub專案網址:

https://github.com/google-research/parti

#參考連結:

##[1]https:/ /twitter.com/lmthang/status/1539664610596225024[2]https://gizmodo.com/new-browser-game-combines-dall-e-mini-and-wordle-1849105289[3]https://imagen.research .google/以上がGoogleの新しいAIが熱い!世界で一番長い単語を描くことができますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。