翻訳者 | Li Rui

レビュアー | Sun Shujuan

機械学習が人々が毎日使用する多くのアプリケーションの一部となるにつれて、人々はますます注目を集めています。機械学習モデルに対するセキュリティとプライバシーの脅威を特定して対処する方法。

ただし、機械学習のパラダイムが異なれば、直面するセキュリティの脅威も異なり、機械学習のセキュリティの一部の領域は依然として研究が不十分です。特に、強化学習アルゴリズムの安全性は、近年あまり注目されていません。

マギル大学、機械学習研究所 (MILA)、カナダのウォータールー大学の研究者は、深層強化学習アルゴリズムのプライバシーの脅威に焦点を当てた新しい研究を実施しました。研究者らは、メンバーシップ推論攻撃に対する強化学習モデルの脆弱性をテストするためのフレームワークを提案しています。

研究結果によると、攻撃者は深層強化学習 (RL) システムを効果的に攻撃でき、モデルのトレーニングに使用される機密情報を取得する可能性があります。強化学習技術が現在、産業用および民生用アプリケーションに浸透しているため、彼らの発見は重要です。

メンバー推論攻撃

メンバー推論攻撃は、ターゲットの機械学習モデルの動作を観察し、そのトレーニングに使用される例を予測します。 。

すべての機械学習モデルは、一連の例に基づいてトレーニングされます。場合によっては、トレーニングの例には、健康データや財務データ、その他の個人を特定できる情報などの機密情報が含まれます。

メンバー推論攻撃は、機械学習モデルにトレーニング セット データを強制的に漏洩させようとする一連の手法です。敵対的な例 (機械学習に対するよりよく知られたタイプの攻撃) は、機械学習モデルの動作の変更に焦点を当てており、セキュリティ上の脅威とみなされますが、メンバーシップ推論攻撃は、モデルからの情報の抽出に焦点を当てており、プライバシーの脅威としてより重要です。

メンバーシップ推論攻撃は、ラベル付きサンプルでモデルがトレーニングされる教師あり機械学習アルゴリズムでよく研究されています。

教師あり学習とは異なり、深層強化学習システムはラベル付きサンプルを使用しません。強化学習 (RL) エージェントは、環境との相互作用から報酬またはペナルティを受け取ります。これらの相互作用や強化信号を通じて、徐々に学習し、その行動を発展させます。

論文の著者らは書面によるコメントで、「強化学習における報酬は必ずしもラベルを表すわけではない。したがって、他の学習におけるメンバーシップ推論攻撃の設計でよく使用される予測として機能することはできない」と述べた。

研究者らは論文の中で、「深層強化学習エージェントのトレーニングに直接使用されたデータのメンバーが漏洩する可能性に関する研究は現時点では行われていない。」と書いています。

研究が不足している理由の 1 つは、強化学習の実世界への応用が限られていることです。

研究論文の著者らは次のように述べています。「Alpha Go、Alpha Fold、GT Sophy などの深層強化学習の分野では大きな進歩があったにもかかわらず、深層強化学習モデルは依然として「産業規模では利用できません。広く採用されています。その一方で、データプライバシーは非常に広く使用されている研究分野です。実際の産業応用における深層強化学習モデルの欠如により、この基礎的かつ重要な研究分野の研究が大幅に遅れています。」 「その結果、強化学習システムに関する研究が不足しています。攻撃は十分に研究されていません。」

現実世界のシナリオで強化学習アルゴリズムを産業規模で適用する需要が高まる中、強化学習アルゴリズムのプライバシーの側面に敵対的およびアルゴリズムの観点から取り組む必要があり、フレームワークの焦点と厳格な要件がますます明らかになり、関連性が高まっています。

深層強化学習におけるメンバーシップ推論の課題

#研究論文の著者らは次のように述べています。プライバシー保護の世代深層強化学習アルゴリズムに対する私たちの取り組みにより、プライバシーの観点から、従来の機械学習アルゴリズムと強化学習アルゴリズムの間には基本的な構造の違いがあることがわかりました。」

さらに重要なことに、研究者らは、深層強化学習と他の学習パラダイムの根本的な違いが、潜在的なプライバシーへの影響を考慮すると、深層強化学習モデルを実際のアプリケーションに展開する際に深刻な課題を引き起こしていることを発見しました。

彼らはこう言いました、「この認識に基づいて、私たちにとって大きな疑問は、深層強化学習アルゴリズムがメンバーシップ推論攻撃などのプライバシー攻撃に対してどの程度脆弱かということです。現在、推論攻撃の攻撃モデルは次のとおりです。」他の学習パラダイム向けに特別に設計されているため、そのような攻撃に対する深層強化学習アルゴリズムの脆弱性はほとんど知られていません。世界中での展開によるプライバシーへの深刻な影響を考えると、未知のものに対する好奇心と、研究と業界の意識を高める必要性は、

トレーニング プロセス中、強化学習モデルは複数のフェーズを通過し、各フェーズはアクションと状態の軌跡またはシーケンスで構成されます。したがって、強化学習のメンバーシップ推論攻撃アルゴリズムを成功させるには、モデルのトレーニングに使用されるデータ ポイントと軌跡を学習する必要があります。これにより、強化学習システムのメンバーシップ推論アルゴリズムの設計がより困難になる一方で、そのような攻撃に対する強化学習モデルの堅牢性の評価も困難になります。

著者らは、「メンバーシップ推論攻撃 (MIA) は、トレーニング中に使用されるデータ ポイントが連続的で時間に依存する性質を持っているため、他のタイプの機械学習と比較して強化学習では困難です。」と述べています。トレーニング データ ポイントと予測データ ポイントの間の多対多の関係は、他の学習パラダイムとは根本的に異なります。」

強化学習と他の機械学習パラダイムの基本的な関係この違いが重要です深層強化学習のためのメンバーシップ推論攻撃を設計および評価する際に、新しい方法で考えることができます。

強化学習システムに対するメンバーシップ推論攻撃の設計

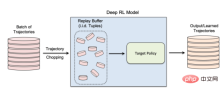

研究者らは、研究の中で、データ収集とモデルのトレーニング プロセスが行われる非ポリシー強化学習アルゴリズムに焦点を当てました。別。強化学習では、「リプレイ バッファー」を使用して入力軌跡の相関を取り除き、強化学習エージェントが同じデータ セットから多くの異なる軌跡を探索できるようにします。

非ポリシー強化学習は、トレーニング データが事前に存在し、強化学習モデルをトレーニングしている機械学習チームに提供される多くの実世界のアプリケーションにとって特に重要です。非ポリシー強化学習は、メンバーシップ推論攻撃モデルを作成する場合にも重要です。

#非ポリシー強化学習では、「再生バッファー」を使用して、モデルのトレーニング中に以前に収集されたデータを再利用します

著者らは、「真の非ポリシー強化学習モデルでは探索フェーズと悪用フェーズが分離されている。したがって、ターゲットポリシーはトレーニング軌道に影響を与えない。このセットアップは、メンバー推論攻撃フレームワークを設計する場合に特に適している」と述べている。ブラック ボックス環境。攻撃者はターゲット モデルの内部構造も、トレーニング トラジェクトリの収集に使用される探索戦略も知らないからです。」

ブラック ボックス メンバーシップ推論攻撃では、攻撃者は、トレーニングされた強化学習モデルの動作を観察することしかできません。この特定のケースでは、攻撃者は、ターゲット モデルがプライベート データのセットから生成された軌跡でトレーニングされていると想定します。これが、非ポリシー強化学習の仕組みです。

研究では、研究者らは高度な非ポリシー強化学習アルゴリズムである「バッチ制約ディープ Q ラーニング」(BCQ) を選択しました。制御タスクで優れたパフォーマンスを発揮します。ただし、彼らは、メンバーシップ推論攻撃手法が他の非ポリシー強化学習モデルにも拡張できることを示しています。

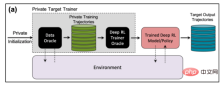

攻撃者がメンバーシップ推論攻撃を実行できる方法の 1 つは、「シャドウ モデル」を開発することです。これは、ターゲット モデルのトレーニング データなどと同じ分布からのデータの混合物でトレーニングされた分類器機械学習モデルです。トレーニング後、シャドウ モデルは、ターゲットの機械学習モデルのトレーニング セットに属するデータ ポイントと、モデルがこれまでに見たことのない新しいデータを区別できます。ターゲット モデルのトレーニングは逐次的に行われる性質があるため、強化学習エージェント用のシャドウ モデルの作成は困難です。研究者らはいくつかの段階を経てこれを達成した。

まず、強化学習モデル トレーナーに新しい非プライベート データ トラジェクトリのセットを供給し、ターゲット モデルによって生成されたトラジェクトリを観察します。次に、攻撃トレーナーは、トレーニングおよび出力軌跡を使用して機械学習分類器をトレーニングし、ターゲットの強化学習モデルのトレーニングに使用された入力軌跡を検出します。最後に、分類子には、トレーニング メンバーまたは新しいデータ例として分類するための新しい軌跡が提供されます。

#強化学習モデルに対するメンバー推論攻撃をトレーニングするためのシャドウ モデル

強化学習システムに対するメンバー推論攻撃のテスト研究者らは、異なる軌道長、単一軌道と複数軌道、相関軌道と無相関軌道など、さまざまなモードでメンバーシップ推論攻撃をテストしました。

研究者らは論文の中で次のように述べています。「結果は、私たちが提案した攻撃フレームワークが強化学習モデルのトレーニング データ ポイントの推論において非常に効果的であることを示しています...得られた結果は、There を使用することを示しています。

彼らの結果は、複数の軌道による攻撃が単一の軌道による攻撃よりも効果的であり、軌道が長くなるほど、それぞれの軌道と相関があることを示しています。その他、攻撃の精度も上がります。

著者らは、「自然環境はもちろん個人のモデルであり、攻撃者はターゲットの強化を訓練するために使用される訓練セット内の特定の個人の存在を識別することに興味を持っています」と述べています。ただし、集団モードでのメンバーシップ推論攻撃 (MIA) のパフォーマンスが向上したことは、トレーニング ポリシーの特徴によって捕捉された時間的相関に加えて、攻撃者が学習ポリシーを悪用できることを示しています。

研究者らは、これは、攻撃者が性別間の相互相関を悪用するには、より複雑な学習アーキテクチャとより洗練されたハイパーパラメータ調整を必要とすることも意味すると述べています。トレーニングの軌跡と軌跡の時間の相関関係。

「これらのさまざまな攻撃モードを理解することで、何が起こるかをより深く理解できるため、データのセキュリティとプライバシーへの影響をより深く理解できるようになります」と研究者らは述べています。さまざまな攻撃角度とプライバシー漏洩への影響度。」

現実世界における強化学習システムに対するメンバー推論攻撃

研究者らは、Open AIGym および MuJoCo 物理エンジンに基づく 3 つのタスクでトレーニングされた強化学習モデルに対する攻撃をテストしました。

研究者らは、「私たちの現在の実験は、ホッパー、ハーフチーター、アントという 3 つの高次元運動タスクをカバーしています。これらのタスクはすべてロボット シミュレーション タスクであり、主に実験を促進します。アプリケーション メンバーが攻撃を推測するためのもう 1 つの興味深い方向性は、Amazon Alexa、Apple の Siri、Google アシスタントなどの会話システムです。これらのアプリケーションでは、データ ポイントはチャットボットとエンド ユーザー間の完全な対話トレースによって表示されます。この設定では、チャットボットはトレーニングされた強化学習ポリシーであり、ユーザーとロボットの対話が入力軌跡を形成します。

著者らは、「この場合、集合的なパターンは自然環境です。言い換えれば、攻撃者がユーザーを表す一連の軌跡を正しく推測した場合に限ります」と述べています。

チームは、そのような攻撃が強化学習システムに影響を与える可能性がある他の実用的なアプリケーションを検討しています。また、これらの攻撃が他の状況での強化学習にどのように適用できるかについても研究する可能性があります。

著者らは、「この研究領域の興味深い拡張は、ターゲットポリシーの内部構造が異なるホワイトボックス環境で深層強化学習モデルに対するメンバー推論攻撃を研究することです」と述べています。

研究者らは、自分たちの研究が現実世界の強化学習アプリケーションにおけるセキュリティとプライバシーの問題に光を当て、機械学習コミュニティの意識を高めることを期待しています。さらなる研究を。

元のタイトル:

強化学習モデルはメンバーシップ推論攻撃を受けやすい以上が研究によると、強化学習モデルはメンバーシップ推論攻撃に対して脆弱であることが示されていますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

あなたは無知のベールの後ろに職場AIを構築する必要がありますApr 29, 2025 am 11:15 AM

あなたは無知のベールの後ろに職場AIを構築する必要がありますApr 29, 2025 am 11:15 AMジョン・ロールズの独創的な1971年の著書「正義の理論」で、彼は私たちが今日のAIデザインの核となり、意思決定を使用するべきであるという思考実験を提案しました:無知のベール。この哲学は、公平性を理解するための簡単なツールを提供し、リーダーがこの理解を使用してAIを公平に設計および実装するための青写真を提供します。 あなたが新しい社会のルールを作っていると想像してください。しかし、前提があります。この社会でどのような役割を果たすかは事前にわかりません。過半数または限界少数派に属している、金持ちまたは貧弱、健康、または障害者になることがあります。この「無知のベール」の下で活動することで、ルールメーカーが自分自身に利益をもたらす決定を下すことができません。それどころか、人々はより公衆を策定する意欲があります

決定、決定…実用的な応用AIの次のステップApr 29, 2025 am 11:14 AM

決定、決定…実用的な応用AIの次のステップApr 29, 2025 am 11:14 AMロボットプロセスオートメーション(RPA)を専門とする多くの企業は、繰り返しタスクを自動化するためのボットを提供しています。 一方、プロセスマイニング、オーケストレーション、インテリジェントドキュメント処理スペシャル

エージェントが来ています - 私たちがAIパートナーの隣ですることについてもっとApr 29, 2025 am 11:13 AM

エージェントが来ています - 私たちがAIパートナーの隣ですることについてもっとApr 29, 2025 am 11:13 AMAIの未来は、単純な単語の予測と会話シミュレーションを超えて動いています。 AIエージェントは出現しており、独立したアクションとタスクの完了が可能です。 このシフトは、AnthropicのClaudeのようなツールですでに明らかです。 AIエージェント:研究a

共感がAI主導の未来におけるリーダーのコントロールよりも重要である理由Apr 29, 2025 am 11:12 AM

共感がAI主導の未来におけるリーダーのコントロールよりも重要である理由Apr 29, 2025 am 11:12 AM急速な技術の進歩は、仕事の未来に関する将来の見通しの視点を必要とします。 AIが単なる生産性向上を超えて、私たちの社会構造の形成を開始するとどうなりますか? Topher McDougalの今後の本、Gaia Wakes:

製品分類のためのAI:マシンは税法を習得できますか?Apr 29, 2025 am 11:11 AM

製品分類のためのAI:マシンは税法を習得できますか?Apr 29, 2025 am 11:11 AM多くの場合、Harmonized System(HS)などのシステムからの「HS 8471.30」などの複雑なコードを含む製品分類は、国際貿易と国内販売に不可欠です。 これらのコードは、すべてのINVに影響を与える正しい税申請を保証します

データセンターの要求は、気候技術のリバウンドを引き起こす可能性がありますか?Apr 29, 2025 am 11:10 AM

データセンターの要求は、気候技術のリバウンドを引き起こす可能性がありますか?Apr 29, 2025 am 11:10 AMデータセンターと気候技術投資におけるエネルギー消費の将来 この記事では、AIが推進するデータセンターのエネルギー消費の急増と気候変動への影響を調査し、この課題に対処するための革新的なソリューションと政策の推奨事項を分析します。 エネルギー需要の課題:大規模で超大規模なデータセンターは、数十万の普通の北米の家族の合計に匹敵する巨大な力を消費し、新たなAIの超大規模なセンターは、これよりも数十倍の力を消費します。 2024年の最初の8か月で、Microsoft、Meta、Google、Amazonは、AIデータセンターの建設と運用に約1,250億米ドルを投資しました(JP Morgan、2024)(表1)。 エネルギー需要の成長は、挑戦と機会の両方です。カナリアメディアによると、迫り来る電気

AIとハリウッドの次の黄金時代Apr 29, 2025 am 11:09 AM

AIとハリウッドの次の黄金時代Apr 29, 2025 am 11:09 AM生成AIは、映画とテレビの制作に革命をもたらしています。 LumaのRay 2モデル、滑走路のGen-4、OpenaiのSora、GoogleのVEO、その他の新しいモデルは、前例のない速度で生成されたビデオの品質を向上させています。これらのモデルは、複雑な特殊効果と現実的なシーンを簡単に作成できます。短いビデオクリップやカメラ認知モーション効果も達成されています。これらのツールの操作と一貫性を改善する必要がありますが、進歩の速度は驚くべきものです。 生成ビデオは独立した媒体になりつつあります。アニメーション制作が得意なモデルもあれば、実写画像が得意なモデルもあります。 AdobeのFireflyとMoonvalleyのMAであることは注目に値します

ChatGptはゆっくりとAIの最大のYES-MANになりますか?Apr 29, 2025 am 11:08 AM

ChatGptはゆっくりとAIの最大のYES-MANになりますか?Apr 29, 2025 am 11:08 AMChatGptユーザーエクスペリエンスは低下します:それはモデルの劣化ですか、それともユーザーの期待ですか? 最近、多数のCHATGPT有料ユーザーがパフォーマンスの劣化について不満を述べています。 ユーザーは、モデルへの応答が遅く、答えが短い、助けの欠如、さらに多くの幻覚を報告しました。一部のユーザーは、ソーシャルメディアに不満を表明し、ChatGptは「お世辞になりすぎて」、重要なフィードバックを提供するのではなく、ユーザービューを検証する傾向があることを指摘しています。 これは、ユーザーエクスペリエンスに影響を与えるだけでなく、生産性の低下やコンピューティングリソースの無駄など、企業の顧客に実際の損失をもたらします。 パフォーマンスの劣化の証拠 多くのユーザーは、特にGPT-4などの古いモデル(今月末にサービスから廃止される)で、ChatGPTパフォーマンスの大幅な分解を報告しています。 これ

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

SAP NetWeaver Server Adapter for Eclipse

Eclipse を SAP NetWeaver アプリケーション サーバーと統合します。

ホットトピック

7831

7831 15

15 1648

1648 14

14 1402

1402 52

52 1300

1300 25

25 1239

1239 29

29