Deepmind は、直観的な物理学を学習し、モデルがこの機能を達成する理由を分析できるモデルを構築することを目的としています。

AlphaFold から数的推論に至るまで、DeepMind は AI と基礎科学を組み合わせることを試みてきました。今回、DeepMind は単純な物理法則を学習できる新しいモデルを作成しました。

発達心理学者は、赤ちゃんが視線を通じて物の動きをどのように追跡するかをテストし、分析しました。たとえば、ボールが突然消えるビデオが再生されると、子供たちは驚きの表情を浮かべました。

DeepMind のコンピュータ科学者 Luis Piloto 氏らは、人工知能 (AI) 向けに同様のテストを開発したいと考えています。研究チームは、立方体やボールなどの単純なオブジェクトのアニメーションのビデオを使用してニューラル ネットワークをトレーニングし、モデルは大量のデータからパターンを発見することで学習しました。この研究論文は、7月11日にNature Human Behaviour誌に掲載された。

- 論文アドレス: https://www.nature.com/articles/s41562-022-01394 -8

- データセット アドレス: https://github.com/deepmind/physical_concepts

このモデルは、オブジェクトを自動的にエンコードして追跡することで物理学習を実行します。名前は PLATO (自動エンコーディングとオブジェクト追跡による物理学学習)。 PLATO は、ビデオから元の画像と、シーン内の各オブジェクトのターゲットを強調表示する画像のバージョンを受け取ります。 PLATO は、位置や速度などの物体の物理的特性の内部表現を開発することを目的としています。

システムは、単純な動作メカニズム (坂道を転がり落ちるボールなど) を示す約 30 時間のビデオでトレーニングされ、これらのオブジェクトがさまざまな状況でどのように動作するかを予測する機能を開発しました。特に、PLATO は、ターゲットの軌道が中断されず、オブジェクトの形状が持続することを保証するために、連続性と堅牢性を学習します。ビデオを再生すると、モデルの予測がより正確になります。

物体が突然消えるなど、「ありえない」出来事が発生するビデオを再生する場合、PLATO はビデオと自身の予測との差異を測定し、「驚き」の尺度を提供します。

ピロト氏は次のように述べています。「PLATOは乳児の行動モデルとして設計されたものではありませんが、人間の乳児がどのように学習するかについての仮説を検証することができます。最終的には認知科学者がこれを利用して乳児の行動をシミュレートすることを期待しています。」

ブリティッシュコロンビア大学のコンピューター科学者、ジェフ・クルーン氏は、「AIと人間の幼児の学習方法を比較することは、重要な研究の方向性である。PLATOの研究者は、人工知能モデルを与える事前知識の多くを手作業で設計した」と述べた。クルーンのような研究者は、物理世界を理解するためにプログラムに独自のアルゴリズムを開発させようとしています。

発達心理学の知識の活用

AI システムでより豊かな身体的直観を追求するために、DeepMind の研究チームは発達心理学からインスピレーションを得ています。研究チームは、発達心理学からの核となる洞察、つまり物理学は個別の物体とその相互作用のレベルで理解されるという洞察を組み込んだ深層学習システムを構築しました。

直感的な物理学の核心は、区別、操作、個別に検出できる一連の個別の概念 (オブジェクトの永続性、固体性、連続性など) に依存しています。 AI 学習に対する従来の標準的なアプローチでは、直感的な物理学をビデオまたは状態予測子、バイナリ結果予測、質問と回答のパフォーマンス、または強化学習タスクを通じて物理世界について学習します。これらのアプローチには、直観的な物理学のいくつかの側面を理解する必要があるように見えますが、明確な一連の概念を明示的に操作したり、戦略的に探索したりすることはできません。

一方、発達心理学では、物理的概念は未来がどのように展開するかについての一連の期待に対応すると考えています。たとえば、人々は、物体がある場所から別の場所に突然魔法のようにテレポートするのではなく、時間と空間を通って連続した経路をたどることを期待しており、これが連続性の概念につながります。したがって、特定の物理概念の知識を測定する方法、つまり期待違反 (VoE) パラダイムがあります。

VoE パラダイムを使用して特定の概念を探求する場合、研究者は、その物理的概念と一致する (物理的に可能である) か、一致しない (物理的に可能性が低い) かのいずれかである、視覚的に類似したアレイ (プローブと呼ばれる) を幼児に示します。このパラダイムでは、「驚き」は注視時間によって測定されます。

メソッドの紹介

まず、DeepMind は非常に豊富なビデオ コーパス - 物理概念データ セットを提案しました。このデータセットには、継続性、目標の持続性、堅牢性など、発達心理学の中核要素と考えられる 5 つの重要な物理的概念を対象とした VoE プローブ ビデオが含まれています。 4 番目は不変性であり、特定のターゲットのプロパティ (形状など) は変化しないという概念を捉えます。5 番目の概念は方向慣性で、移動するオブジェクトが慣性の原理と一致する方向に変化するという期待が含まれます。

最も重要なことは、Physical Concepts データセットにはトレーニング データとして別のビデオ コーパスも含まれていることです。これらのビデオは、手続き的に生成されたさまざまな物理イベントを示しています。

図 2: モデルのトレーニングに使用されるビデオ データセットの例

PLATO モデル アーキテクチャ

Deepmind は直感的な学習モデルの構築を目指しています物理学の理論を分析し、モデルがなぜこの機能を達成するのかを分析します。 AI 分野の一部の高度なシステムは、PLATO モデルでインスタンス化されます。

1 つ目は、ターゲットのパーソナライゼーション プロセスです。 ターゲットのパーソナライゼーション プロセスは、視覚的な連続感覚入力を一連の個別のエンティティに分割します。各エンティティは、対応する一連の属性を持ちます。 PLATO では、セグメント化された各ビデオ フレームが知覚モジュールによって一連のターゲット コード (図 3a ~ c) に分解され、視覚入力から個々のターゲットへのマッピングが可能になります。 PLATO はシーンをセグメント化することを学習しませんが、セグメント化ターゲットが与えられると、圧縮された表現を学習します。

第 2 に、ターゲット追跡 (またはターゲット インデックス) は各ターゲットにインデックスを割り当てます。 これにより、ターゲットの知覚と時間の経過に伴う動的属性計算の対応が得られます (図 3b、c)。 PLATO では、ターゲット コードはターゲット バッファー内のフレームにわたって蓄積および追跡されます (図 3d)。

最後のコンポーネントは、これらの追跡対象の関係処理です。このプロセスは、発達心理学で提案されている、オブジェクト間の関係を動的に処理できる「物理的推論システム」からインスピレーションを得ています。 、オブジェクトと他のオブジェクトの間の関係や相互作用によって影響を受ける新しい表現を生成します。

PLATO は、ターゲットの記憶とターゲットの知覚履歴 (図 3d) の間の相互作用を学習して、次のターゲットの予測ビデオ フレームを生成し、ターゲットベースの記憶を更新します。

図 3: PLATO には 2 つのコンポーネントが含まれています: 認識モジュール (左) と動的予測 (右)

実験結果

いつテストしたところ、PLATO は 5 つの異なるランダム シードでトレーニングした場合、5 つの検出カテゴリすべてで強力な VoE 効果を示しました。

図 5: PLATO は、物理概念データセットの調査において堅牢なパフォーマンスを示しています。

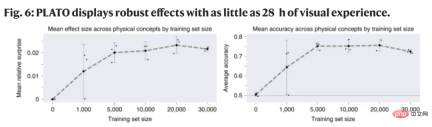

Physical Concepts データセットのトレーニング コーパスには、合計 300,000 のビデオが含まれています。控えめに計算すると、約 52 日間の継続的な視覚体験に相当します。 AI と開発の観点から見ると、テストで VoE 効果を生み出すために実際にどのくらいのトレーニング データが必要かという問題があります。これを評価するために、Deepmind は、サイズが減少するデータセットで 3 つの PLATO 動的予測子のランダム シードをトレーニングし (図 6)、5 つの検出クラスすべてにわたる VoE 効果の総平均を計算しました。

結果では、わずか 50,000 例 (28 時間の視覚体験に相当) でトレーニングした後、Deepmind のモデルで堅牢な VoE 効果が示されました。

図 6: PLATO は、わずか 28 時間の視覚体験で強力な結果を示しています。

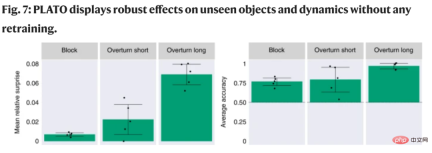

一般化テスト: Deepmind は、直観的な物理知識を探索するように設計された ADEPT データセットを使用します。図 7 に示すように、PLATO は 3 つの検出カテゴリすべてに対して明らかな VoE 効果を示しています。

図 7: PLATO は、再トレーニングなしで、目に見えないターゲットとダイナミクスに対する強力な効果を実証します。

詳細については、元の論文をご覧ください。

以上が赤ちゃんのように学習する DeepMind の新しいモデルは、28 時間で物理世界のルールを学習しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

AIのスキルギャップは、サプライチェーンのダウンを遅くしていますApr 26, 2025 am 11:13 AM

AIのスキルギャップは、サプライチェーンのダウンを遅くしていますApr 26, 2025 am 11:13 AM「AI-Ready労働力」という用語は頻繁に使用されますが、サプライチェーン業界ではどういう意味ですか? サプライチェーン管理協会(ASCM)のCEOであるAbe Eshkenaziによると、批評家ができる専門家を意味します

1つの会社がAIを永遠に変えるために静かに取り組んでいる方法Apr 26, 2025 am 11:12 AM

1つの会社がAIを永遠に変えるために静かに取り組んでいる方法Apr 26, 2025 am 11:12 AM分散型AI革命は静かに勢いを増しています。 今週の金曜日、テキサス州オースティンでは、ビテンサーのエンドゲームサミットは極めて重要な瞬間を示し、理論から実用的な応用に分散したAI(DEAI)を移行します。 派手なコマーシャルとは異なり

Nvidiaは、AIエージェント開発を合理化するためにNEMOマイクロサービスをリリースしますApr 26, 2025 am 11:11 AM

Nvidiaは、AIエージェント開発を合理化するためにNEMOマイクロサービスをリリースしますApr 26, 2025 am 11:11 AMエンタープライズAIはデータ統合の課題に直面しています エンタープライズAIの適用は、ビジネスデータを継続的に学習することで正確性と実用性を維持できるシステムを構築する大きな課題に直面しています。 NEMOマイクロサービスは、NVIDIAが「データフライホイール」と呼んでいるものを作成することにより、この問題を解決し、AIシステムがエンタープライズ情報とユーザーインタラクションへの継続的な露出を通じて関連性を維持できるようにします。 この新しく発売されたツールキットには、5つの重要なマイクロサービスが含まれています。 NEMOカスタマイザーは、より高いトレーニングスループットを備えた大規模な言語モデルの微調整を処理します。 NEMO評価者は、カスタムベンチマークのAIモデルの簡素化された評価を提供します。 Nemo Guardrailsは、コンプライアンスと適切性を維持するためにセキュリティ管理を実装しています

aiは芸術とデザインの未来のために新しい絵を描きますApr 26, 2025 am 11:10 AM

aiは芸術とデザインの未来のために新しい絵を描きますApr 26, 2025 am 11:10 AMAI:芸術とデザインの未来 人工知能(AI)は、前例のない方法で芸術とデザインの分野を変えており、その影響はもはやアマチュアに限定されませんが、より深く影響を与えています。 AIによって生成されたアートワークとデザインスキームは、広告、ソーシャルメディアの画像生成、Webデザインなど、多くのトランザクションデザインアクティビティで従来の素材画像とデザイナーに迅速に置き換えられています。 ただし、プロのアーティストやデザイナーもAIの実用的な価値を見つけています。 AIを補助ツールとして使用して、新しい美的可能性を探求し、さまざまなスタイルをブレンドし、新しい視覚効果を作成します。 AIは、アーティストやデザイナーが繰り返しタスクを自動化し、さまざまなデザイン要素を提案し、創造的な入力を提供するのを支援します。 AIはスタイル転送をサポートします。これは、画像のスタイルを適用することです

エージェントAIとのズームがどのように革命を起こしているか:会議からマイルストーンまでApr 26, 2025 am 11:09 AM

エージェントAIとのズームがどのように革命を起こしているか:会議からマイルストーンまでApr 26, 2025 am 11:09 AM最初はビデオ会議プラットフォームで知られていたZoomは、エージェントAIの革新的な使用で職場革命をリードしています。 ZoomのCTOであるXD Huangとの最近の会話は、同社の野心的なビジョンを明らかにしました。 エージェントAIの定義 huang d

大学に対する実存的な脅威Apr 26, 2025 am 11:08 AM

大学に対する実存的な脅威Apr 26, 2025 am 11:08 AMAIは教育に革命をもたらしますか? この質問は、教育者と利害関係者の間で深刻な反省を促しています。 AIの教育への統合は、機会と課題の両方をもたらします。 Tech Edvocate NotesのMatthew Lynch、Universitとして

プロトタイプ:アメリカの科学者は海外の仕事を探していますApr 26, 2025 am 11:07 AM

プロトタイプ:アメリカの科学者は海外の仕事を探していますApr 26, 2025 am 11:07 AM米国における科学的研究と技術の開発は、おそらく予算削減のために課題に直面する可能性があります。 Natureによると、海外の雇用を申請するアメリカの科学者の数は、2024年の同じ期間と比較して、2025年1月から3月まで32%増加しました。以前の世論調査では、調査した研究者の75%がヨーロッパとカナダでの仕事の検索を検討していることが示されました。 NIHとNSFの助成金は過去数か月で終了し、NIHの新しい助成金は今年約23億ドル減少し、3分の1近く減少しました。リークされた予算の提案は、トランプ政権が科学機関の予算を急激に削減していることを検討しており、最大50%の削減の可能性があることを示しています。 基礎研究の分野での混乱は、米国の主要な利点の1つである海外の才能を引き付けることにも影響を与えています。 35

オープンAIの最新のGPT 4.1ファミリ - 分析VidhyaApr 26, 2025 am 10:19 AM

オープンAIの最新のGPT 4.1ファミリ - 分析VidhyaApr 26, 2025 am 10:19 AMOpenaiは、強力なGPT-4.1シリーズを発表しました。実際のアプリケーション向けに設計された3つの高度な言語モデルのファミリー。 この大幅な飛躍は、より速い応答時間、理解の強化、およびTと比較した大幅に削減されたコストを提供します

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

PhpStorm Mac バージョン

最新(2018.2.1)のプロフェッショナル向けPHP統合開発ツール

SublimeText3 中国語版

中国語版、とても使いやすい

メモ帳++7.3.1

使いやすく無料のコードエディター

ホットトピック

7742

7742 15

15 1643

1643 14

14 1397

1397 52

52 1291

1291 25

25 1234

1234 29

29