ホームページ >テクノロジー周辺機器 >AI >ディープラーニングは壁にぶつかりますか?ルカンとマーカスの間でスズメバチの巣をかき混ぜたのは誰ですか?

ディープラーニングは壁にぶつかりますか?ルカンとマーカスの間でスズメバチの巣をかき混ぜたのは誰ですか?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-09 09:41:081209ブラウズ

今日の主人公は、AI の世界で愛し合い、殺し合う 2 人の宿敵です:

Yann LeCun と Gary Marcus

この「新たな確執」について正式に話す前に』を読んで、まずは二大神の間の“昔の憎しみ”についておさらいしてみましょう。

LeCun 対 Marcus の戦い

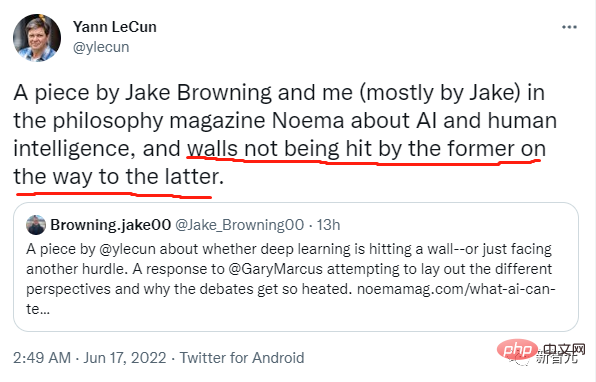

Facebook の主任人工知能科学者およびニューヨーク大学教授、2018 年チューリング同賞 (チューリング賞) 受賞者のヤン・ルカン氏は、AI とディープラーニングに関するゲイリー・マーカス氏の以前のコメントに応えて、NOEMA 誌に記事を掲載しました。

以前、マーカスは雑誌 Nautilus に記事を掲載し、深層学習は「前進できない」と述べました。

マーカスは、まさに次のような人物です。興奮を見守っています。

ちょっとした騒動が起きるとすぐに「AIは死んだ」と発言し、サークル内は大騒ぎに!

私はこれまで何度も投稿して、GPT-3 を「ナンセンス」「でたらめ」と呼んできました。

これが決定的な証拠です:

善良な彼は、実際に「ディープラーニングは壁にぶつかっている」と言いました。 」というコメントが横行しているのを見て、AI業界の大スターであるLeCun氏も黙っていられず、すぐに返信を投稿しました!

そして、並びたいなら私もついていきます!

ルカン氏は記事の中でマーカス氏の見解に一つ一つ反論した。

偉大な巨匠がどのように返信記事を書いたかを見てみましょう~~

以下は LeCun の長い記事です:

現代の人工知能の支配的なテクノロジーは奥深いです学習 (DL) ) ニューラル ネットワーク (NN)。データ内のパターンの識別と活用に優れた大規模な自己学習アルゴリズム。当初から批評家たちは、ニューラル ネットワークが「乗り越えられない壁」にぶつかったと早計に信じていましたが、そのたびに、それは一時的な障害であることが判明しました。

1960 年代、NN は非線形関数を解くことができませんでした。しかし、この状況は長くは続かず、1980 年代にバックプロパゲーションの出現により状況は変わりましたが、システムのトレーニングが非常に困難であるという新たな「乗り越えられない壁」が再び現れました。

1990 年代、人類は簡素化された手順と標準化された構造を開発し、トレーニングの信頼性を高めましたが、どのような結果が得られたとしても、常に「乗り越えられない壁」があるように見えました。トレーニングデータと計算能力。

ディープ ラーニングは 2012 年に主流になり始め、最新の GPU が大規模な ImageNet データセットでトレーニングできるようになり、すべての競合他社を簡単に破ることができました。しかしその後、疑問の声が浮上しました。人々は「新たな壁」を発見しました。ディープラーニングのトレーニングには、手動でラベル付けされた大量のデータが必要です。

しかし、ここ数年で、ラベル付きデータを必要としない GPT-3 など、自己教師あり学習が非常に優れた結果を達成したため、この疑問は無意味になりました。

今日、一見克服不可能な障害は「記号推論」です。これは、代数的または論理的な方法で記号を操作する能力です。私たちが子供の頃に学んだように、数学の問題を解決するには、厳密なルールに従って記号を段階的に操作する必要があります (例: 方程式を解く)。

「The Algebraic Mind」の著者であり「Rebooting AI」の共著者であるゲイリー・マーカス氏は、最近、ニューラルネットワークがそのような記号演算を処理するのが難しいため、DL はこれ以上進歩できないと考えています。対照的に、DL 研究者の多くは、DL はすでに記号推論を行っており、今後も改善されると信じています。

この議論の中心は、人工知能における記号の役割です。2 つの異なる見解があります: 1 つは、記号による推論は最初からハードコーディングされている必要があると信じており、もう 1 つは、機械は経験を通じて学習できると信じています。象徴的に推論する能力。したがって、問題の鍵は、人間の知能をどのように理解するか、したがって人間のレベルに達する人工知能をどのように追求するかということです。

さまざまなタイプの人工知能

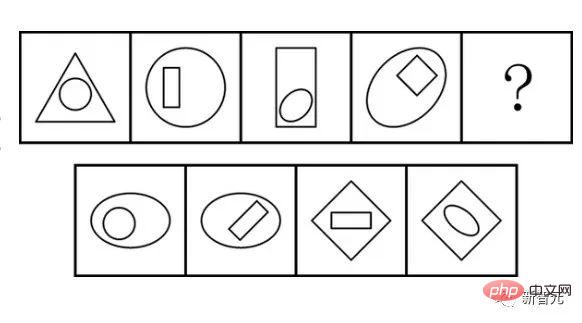

記号推論で最も重要なことは精度です。順列と組み合わせに応じて、記号は「(3-2)-」のようにさまざまな順序を持つことができます。 1 と 3-(2-1)」が重要であるため、正しい記号推論を正しい順序で実行する方法が重要です。

マーカスは、この種の推論が認知の中核であり、言語の基礎となる文法論理と数学の基本演算を提供するために重要であると信じています。彼は、これが私たちのより基本的な能力にまで及ぶ可能性があり、これらの能力の背後には根底にある象徴的な論理があると信じています。

私たちがよく知っている人工知能は、この種の推論の研究から始まり、しばしば「記号的人工知能」と呼ばれます。しかし、人間の専門知識を洗練して一連のルールにまとめるのは非常に困難であり、膨大な時間と人件費がかかります。これがいわゆる「知識獲得のボトルネック」です。

数学や論理のルールを書くのは簡単ですが、世界自体は白黒で非常に曖昧であり、あらゆるパターンやあらゆる曖昧な概念を制御するルールを人間が記述することは不可能であることが判明しました。定義記号。

しかし、科学技術の発展によりニューラル ネットワークが誕生しました。ニューラル ネットワークが最も得意とするのは、パターンを発見し、曖昧さを受け入れることです。

ニューラル ネットワークは、システムへの入力が何であれ、適切な出力を提供する関数を学習する比較的単純な方程式です。

たとえば、2 分類ネットワークを学習するには、大量のサンプル データ (ここでは椅子を例にします) をニューラル ネットワークに入力して学習します。いくつかのエポックにわたって、最終的な実装では、ネットワークが新しい画像が椅子であるかどうかを正常に推測できるようになりました。

端的に言うと、これは人工知能に関する単なる問題ではなく、より本質的には、知能とは何か、そして人間の脳がどのように機能するかという問題です。 ”

これらのニューラル ネットワークは、それを実装する関数が微分可能であるため、正確にトレーニングできます。言い換えると、シンボリック AI が記号論理で使用される離散トークンに類似している場合、ニューラル ネットワークは微積分の連続関数です。

これにより、パラメーターを微調整することでより適切な表現を学習できるようになり、過小適合や過適合の問題を発生させることなく、より適切にデータを適合させることができます。厳密なルールや離散トークンに関して言えば、「壁」です。方程式を解くとき、私たちは通常、近似的な答えではなく、正確な答えを求めます。

ここでシンボリック AI が威力を発揮するため、マーカス氏はこの 2 つを単純に組み合わせる、つまりハードコードされたシンボリック操作モジュールを DL モジュールの上に挿入することを提案しました。

これは、2 つのアプローチが互いに非常によく補完し合うため、魅力的です。そのため、異なる動作方法を持つモジュールの「ハイブリッド」が両方のアプローチの利点を最大化すると思われます。

しかし議論は、シンボルと操作機能が人間によって設計され、モジュールが微分不可能であるため、DL と互換性がないシステムにシンボリック操作を組み込む必要があるかどうかに変わります。

伝説の「記号推論」

この仮説は非常に物議を醸しています。

従来のニューラル ネットワークは、記号推論を手動で実行する必要はないと考えていますが、記号推論を学習することができます。つまり、記号の例を使用して、正しいタイプの推論を実行するようにマシンをトレーニングし、機械が学習できるようにします。抽象的なパターンの完成。つまり、機械は、手作りのシンボルやシンボル操作ルールが組み込まれていないにもかかわらず、世界中のシンボルを操作する方法を学習できます。

GPT-3 や LaMDA などの現代の大規模言語モデルは、このアプローチの可能性を示しています。シンボルを操作する彼らの能力は驚くべきものであり、これらのモデルは驚くべき常識的推論、組み合わせ能力、多言語能力、論理的および数学的能力、さらには死者を模倣する恐ろしい能力さえも示します。

しかし実際には、これは信頼できません。もしあなたが DALL-E に、ひげ、眼鏡、トロピカル シャツを着た哲学者のローマ彫刻を作るように依頼したら、それは素晴らしいものになるでしょう。しかし、ピンクのおもちゃを着たビーグル犬がリスを追いかけている絵を描くように依頼すると、場合によってはピンクのおもちゃを着たビーグル犬やリスが描かれることもあります。

すべてのプロパティを 1 つのオブジェクトに割り当てることができる場合はうまく機能しますが、複数のオブジェクトと複数のプロパティがある場合は停止します。多くの研究者の態度は、これがDLにとって、より人間らしい知能への道における「壁」であるということです。

では、シンボリック操作はハードコーディングする必要があるのでしょうか? それとも学習可能ですか?

これはマーカスの理解ではありません。

彼は、記号推論はオール・オア・ナッシングであると想定しています。DALL-E には、その動作の基礎となるシンボルや論理ルールがないため、実際にはシンボルを使用して推論することはありません。したがって、大規模な言語モデルの多数の失敗は、それらが真の推論ではなく、単なる感情のない機械的な模倣であることを示しています。

マーカスにとって、月に届くほど大きな木に登るのは不可能でした。したがって、現在の DL 言語モデルはニム チンプスキー (アメリカ手話が使えるオスのチンパンジー) よりも現実の言語に近いものではないと彼は考えています。 DALL-E の問題はトレーニング不足ではありません。これらは、文の基礎となる論理構造を理解していない単なるシステムであり、したがって、さまざまな部分が全体としてどのように接続されるべきかを正確に把握できません。

対照的に、ジェフリー・ヒントンらは、ニューラルネットワークはハードコードされたシンボルや代数的推論を必要とせずにシンボルをうまく操作できると信じています。 DL の目標は、マシン内部でのシンボル操作ではなく、世界中のシステムから正しいシンボルを生成する方法を学習することです。

2 つのモードの混合を拒否するのは無謀ではありませんが、記号推論が学習できると信じるかどうかという哲学的な違いに基づいています。

人間の思考の根底にあるロジック

マーカスのDLに対する批判は、知能がどのように機能するのか、何が人間をユニークにするのかについての認知科学における関連する議論に端を発しています。彼の見解は、認知の重要な特徴の多くが先天的なものであると考える、心理学におけるよく知られた「排外主義」の考え方と一致しています。実際、私たちは世界がどのように機能するかをほとんど知って生まれています。

この生得的な知覚の中核は、シンボルを操作する能力です (ただし、これが自然界全体に見られるのか、それとも人間に特有のものなのかについてはまだ結論が出ていません)。マーカスにとって、シンボルを操作するこの能力は、常識の基本的な機能の多く、つまりルールの遵守、抽象化、因果推論、詳細の再特定、一般化、その他多くの能力の基礎となっています。

つまり、世界に対する私たちの理解の多くは自然によって与えられており、学習とは細部を豊かにすることです。

上記の考えを打ち破る別の経験的見解があります。シンボル操作は自然界ではまれであり、主に古代人類の祖先が過去 200 万年にわたって徐々に獲得した学習されたコミュニケーション能力です。

この観点から見ると、主な認知能力は、獲物を素早く特定し、起こりそうな行動を予測し、熟練した反応を開発するなど、生存能力の向上に関連する非象徴的な学習能力です。

この見解では、ほとんどの複雑な認知能力は、一般的な自己監視学習能力を通じて獲得されると考えられています。また、私たちの複雑な認知能力のほとんどが記号操作に依存していないことも前提としています。代わりに、さまざまなシナリオをシミュレートし、最良の結果を予測します。

この経験的見解は、シンボルとシンボルの操作を、人間が成功するために協力的な行動にますます依存するにつれて獲得される、単なる学習能力の 1 つであるとみなします。これは、シンボルを、言葉だけでなく、地図、象徴的な説明、儀式、さらには社会的役割など、グループ間の協力を調整するために使用する発明であるとみなします。

これら 2 つのビューの違いは非常に明白です。排外主義者の伝統にとって、シンボルとシンボルの操作は心の中に本質的に存在しており、言葉と数字の使用はこの原始的な能力に由来しています。この見解は、進化の適応から生じる能力を魅力的に説明しています(ただし、シンボル操作がどのように、またはなぜ進化したかについての説明には議論の余地があります)。

経験主義の伝統の観点から見ると、シンボルと象徴的推論は、一般的な学習能力と複雑な社会世界に由来する、有益なコミュニケーションの発明です。これは、内部の計算や内部の独白など、私たちの頭の中で起こる象徴的な事柄を、数学や言語の使用から生じる外部の実践として扱います。

人工知能と認知科学の分野は密接に絡み合っているため、こうした戦いがここで再び起こるのも不思議ではありません。人工知能におけるいずれかの視点の成功は、認知科学におけるいずれかのアプローチを部分的に (ただし部分的にのみ) 正当化することになるため、これらの議論が激しくなったのは驚くべきことではありません。

この問題の鍵は、現代の人工知能の分野の問題を正しく解決する方法だけでなく、知能とは何か、脳がどのように機能するかを解決することにもあります。

AI に賭けるべきか、それともショートすべきでしょうか?

「ディープラーニングは壁にぶつかる」という言葉はなぜそれほど挑発的なのでしょうか?

マーカスの言うことが正しければ、ディープラーニングがどれほど多くの新しいアーキテクチャを提案したり、どれほどのコンピューティング能力を投資したとしても、ディープラーニングは人間のようなAIを実現することは決してできないでしょう。

真のシンボル操作には自然なシンボル操作が必要なため、ニューラル ネットワークにさらに多くのレイヤーを追加し続けると、事態はさらに混乱するだけです。この記号操作はいくつかの常識的な能力の基礎であるため、DL は何も「理解できない」だけです。

対照的に、DL 支持者と経験主義者の意見が正しい場合、不可解なのは、シンボル操作のためのモジュールを挿入するというアイデアです。

これに関連して、深層学習システムはすでに記号推論を行っており、よりマルチモーダルな自己教師あり学習、ますます有用になる予測世界モデル、およびシミュレーションと評価結果のための作業記憶の拡張を使用することで、今後も改善され続けるでしょう。制約をよりよく満たすことができます。

記号操作モジュールの導入は、より人間らしい AI を生み出すことはなく、それどころか、すべての「推論」操作に不必要なボトルネックを通過させ、私たちを「人間」からさらに遠ざけることになります。 -ような知性」。これにより、深層学習の最もエキサイティングな側面の 1 つである、人間よりも優れたソリューションを考え出す能力が失われる可能性があります。

そうは言っても、これは愚かな誇大宣伝を正当化するものではありません。現在のシステムには意識がないため、システムは私たちを理解できず、強化学習だけでは十分ではなく、スケーリングするだけではヒューマノイドを構築することはできません。インテリジェントになります。しかし、これらの問題はすべて、主要な議論における「エッジの問題」です: シンボリック操作はハードコーディングする必要がありますか? それとも学習できますか? モデル)? もちろんそうではありません。人々は何が機能するかを選択する必要があります。

しかし、研究者たちは 1980 年代からハイブリッド モデルに取り組んできましたが、効果的なアプローチであるとは証明されておらず、多くの場合、ニューラル ネットワークよりはるかに劣る可能性さえあります。

より一般的に言えば、ディープラーニングは上限に達しているのではないかと疑問に思うべきです。

以上がディープラーニングは壁にぶつかりますか?ルカンとマーカスの間でスズメバチの巣をかき混ぜたのは誰ですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。