ホームページ >テクノロジー周辺機器 >AI >StarCraft II 協力対決ベンチマークが SOTA を上回り、新しい Transformer アーキテクチャがマルチエージェント強化学習問題を解決

StarCraft II 協力対決ベンチマークが SOTA を上回り、新しい Transformer アーキテクチャがマルチエージェント強化学習問題を解決

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-09 08:31:081185ブラウズ

マルチエージェント強化学習 (MARL) は、各エージェントのポリシー改善の方向性を特定するだけでなく、全体のパフォーマンスを向上させるために個々のエージェントのポリシー更新を組み合わせる必要がある難しい問題です。最近、この問題は最初に解決され、一部の研究者は、エージェントがトレーニング段階でグローバル情報にアクセスできるようにする集中トレーニング分散実行 (CTDE) 手法を導入しました。ただし、これらの方法では、マルチエージェント インタラクションの複雑さをすべてカバーすることはできません。

実際、これらの方法のいくつかは失敗であることが判明しています。この問題を解決するために、マルチエージェント支配分解定理を提案した人がいます。これに基づいて、HATRPO および HAPPO アルゴリズムが導出されます。ただし、これらのアプローチには限界があり、依然として慎重に設計された最大化目標に依存しています。

近年、シーケンス モデル (SM) は自然言語処理 (NLP) の分野で大幅な進歩を遂げました。たとえば、GPT シリーズと BERT は、幅広いダウンストリーム タスクで優れたパフォーマンスを発揮し、小さなサンプルの汎化タスクでも優れたパフォーマンスを実現します。

シーケンスモデルは言語のシーケンス特性に自然に適合するため、言語タスクに使用できますが、シーケンスメソッドは NLP タスクに限定されず、広く適用可能な一般的な基本ですモデル。たとえば、コンピューター ビジョン (CV) では、画像をサブ画像に分割し、それらを NLP タスクのトークンであるかのようにシーケンスに配置できます。 Flamingo、DALL-E、GATOなどの最近の有名なモデルにはすべてシーケンスメソッドの影があります。

Transformer などのネットワーク アーキテクチャの出現に伴い、シーケンス モデリング テクノロジは RL コミュニティからも大きな注目を集めており、Transformer アーキテクチャに基づいた一連のオフライン RL 開発が推進されています。これらの方法は、最も基本的な RL トレーニングの問題のいくつかを解決する上で大きな可能性を示しています。

これらの方法は顕著な成功を収めましたが、マルチエージェント システムの最も困難な (そして MARL に特有の) 側面であるエージェント間の対話をモデル化するように設計されたものはありませんでした。実際、単にすべてのエージェントに Transformer ポリシーを与えて個別にトレーニングしたとしても、MARL ジョイントのパフォーマンスが向上するという保証はまだありません。したがって、利用可能な強力なシーケンス モデルが多数ある一方で、MARL はシーケンス モデルのパフォーマンスを実際には活用していません。

MARL 問題を解決するためにシーケンス モデルを使用するにはどうすればよいですか?上海交通大学、Digital Brain Lab、オックスフォード大学などの研究者らは、協調的な MARL 問題をシーケンス モデルの問題に効果的に変換できる新しいマルチエージェント トランスフォーマー (MAT、マルチエージェント トランスフォーマー) アーキテクチャを提案しました。エージェントの観察シーケンスをエージェントの最適なアクションシーケンスに変換します。

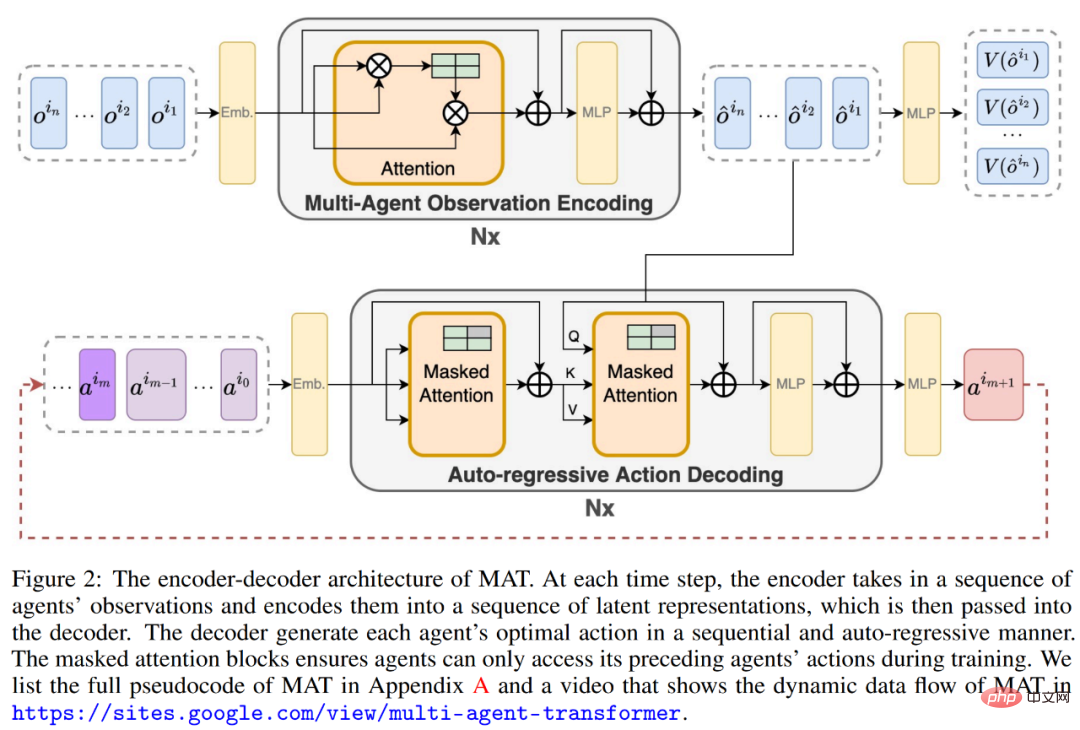

このペーパーの目標は、MARL の最新のシーケンス モデルのモデリング機能を解放するために、MARL と SM の間にブリッジを構築することです。 MAT の中核は、エンコーダ/デコーダ アーキテクチャです。これは、マルチエージェントの利点分解定理を使用して、共同戦略探索問題を逐次意思決定プロセスに変換するため、マルチエージェント問題は線形時間計算量を示し、ほとんどの重要なのは、そうすることで MAT のパフォーマンスが単調に向上することが保証されるということです。事前に収集されたオフライン データを必要とする Decision Transformer などの以前の手法とは異なり、MAT は、環境からのオンラインの試行錯誤を通じて、オンラインで戦略的な方法でトレーニングされます。

- #論文アドレス: https://arxiv.org/pdf/2205.14953 .pdf

- プロジェクトのホームページ: https://sites.google.com/view/multi-agent-transformer

MAT を検証するために、研究者は StarCraftII、マルチエージェント MuJoCo、Dexterous Hands Manipulation、Google Research Football ベンチマークについて広範な実験を実施しました。結果は、MAPPO や HAPPO などの強力なベースラインと比較して、MAT のパフォーマンスとデータ効率が優れていることを示しています。さらに、この研究は、エージェントの数がどのように変化しても、MAT は目に見えないタスクでより優れたパフォーマンスを発揮することも証明しましたが、小規模サンプル学習器としては優れていると言えます。

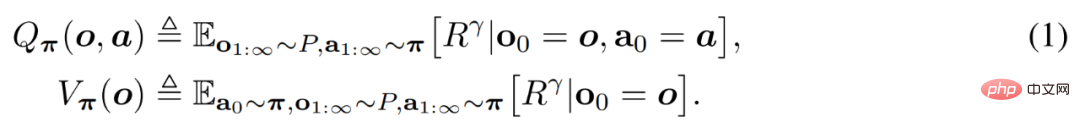

背景知識このセクションでは、研究者が最初に、この記事の基礎である協調 MARL 問題公式とマルチエージェント利点分解定理を紹介します。次に、既存の MAT 関連の MARL メソッドを検討し、最終的に Transformer に至ります。

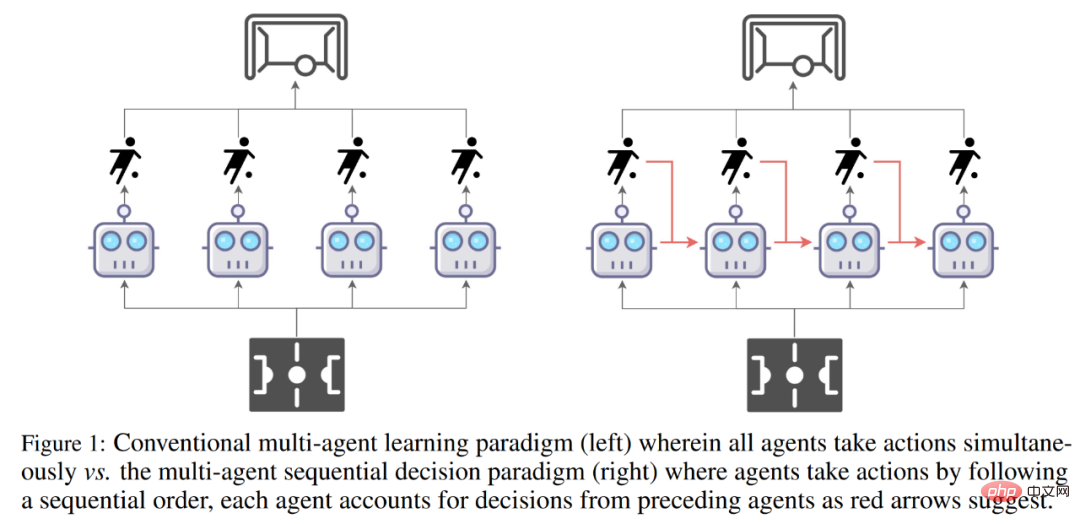

従来のマルチエージェント学習パラダイム (左) とマルチエージェント シーケンス意思決定パラダイム (右) の比較。

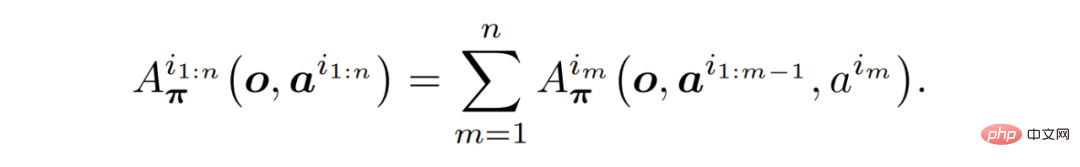

#問題の式協調 MARL 問題は、通常、部分的に観察可能な個別のマルコフ決定プロセス (Dec-POMDP)# で構成されます。モデルに。  マルチエージェント支配分解定理

マルチエージェント支配分解定理

既存の MARL メソッド

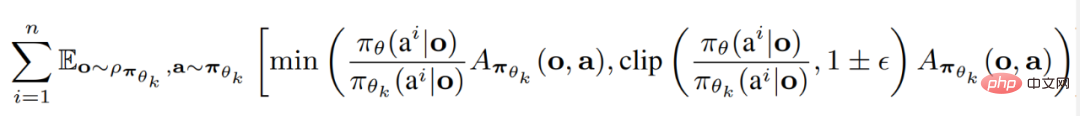

研究者らは、現在の 2 つの SOTA MARL アルゴリズムを要約しました。どちらも Proximal Policy Optimization (PPO) に基づいて構築されています。 PPO は、そのシンプルさとパフォーマンスの安定性で知られる RL 手法です。マルチエージェント近接ポリシー最適化 (MAPPO) は、PPO を MARL に適用する最初で最も簡単な方法です。

トランス モデル

定理 ( 1) シーケンスのプロパティと HAPPO の背後にある原理は、Transformer モデルを使用してマルチエージェントの信頼ドメイン学習を実装することを直感的に考慮できるようになりました。エージェント チームをシーケンスとして扱うことにより、Transformer アーキテクチャでは、MAPPO/HAPPO の欠点を回避しながら、可変の数とタイプを使用してエージェント チームをモデル化できます。マルチエージェント トランスフォーマー

MARL のシーケンス モデリング パラダイムを実現するために、研究者が提供したソリューションはマルチエージェント トランスフォーマー (MAT) です。 Transformer アーキテクチャを適用するというアイデアは、エージェントがシーケンスの入力 (o^i_1,..., o^i_n) とアクション シーケンスの出力 (a^i_1, . . ., a^i_n) マッピングは、機械翻訳に似たシーケンス モデリング タスクです。定理 (1) が回避しているように、アクション a^i_m はすべてのエージェントの以前の決定 a^i_1:m−1 に依存します。したがって、下の図 (2) に示すように、MAT には共同観察表現を学習するためのエンコーダーと、各エージェントのアクションを出力するための自己回帰手法が含まれています。

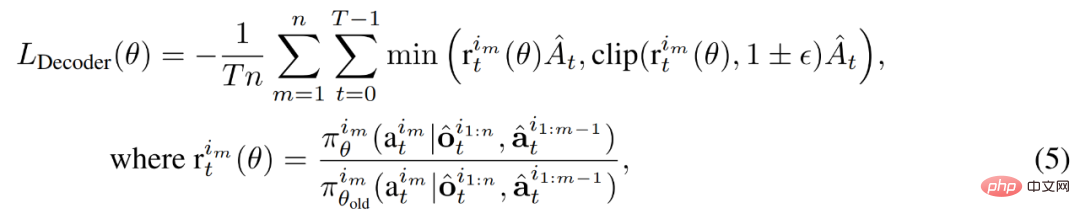

デコーダのパラメータは θ で表され、これには関節動作 a^i_0:m−1, m = {1, . . . n} (ここで a^i_0復号の開始を示す任意のシンボル)が復号ブロック シーケンスに渡されます。重要なことは、各デコード ブロックにはマスクされたセルフ アテンション メカニズムがあるということです。デコーダをトレーニングするために、次のように切り取られた PPO 目標を最小化します。

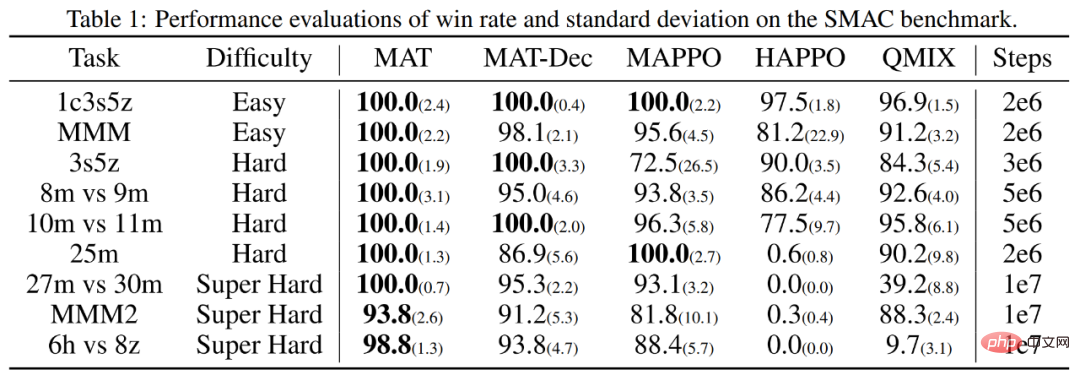

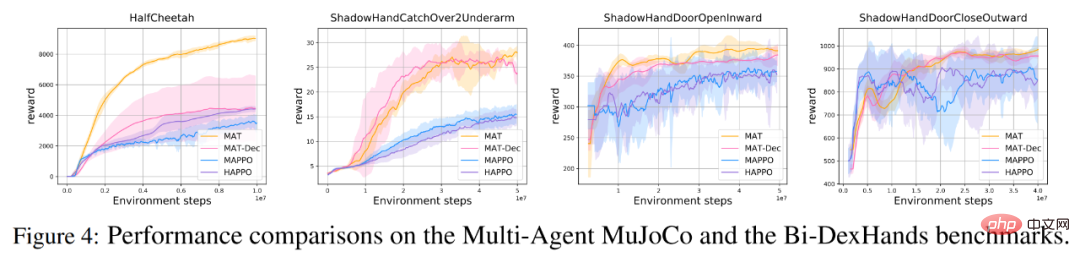

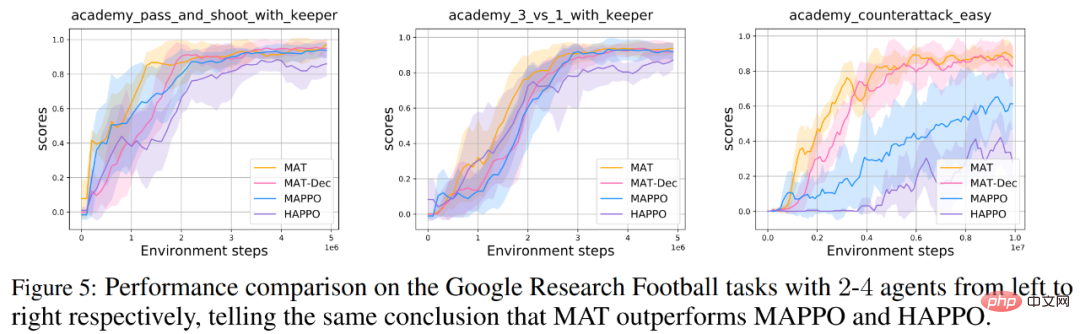

MAT が期待を満たすかどうかを評価するために、研究者は StarCraft II Multi-Agent Challenge (SMAC) ベンチマーク (MAT の上に MAPPO を追加) をテストしました。マルチエージェント MuJoCo ベンチマークでテストされました (HAPPO は SOTA パフォーマンスを備えています)。 さらに、研究者らは、Bimanual Dxterous Hand Manipulation (Bi-DexHands) および Google Research Football ベンチマークに関する MAT の拡張テストも実施しました。前者は両手で行うさまざまな挑戦的なタスクを提供し、後者はフットボールの試合内でさまざまな協力シナリオを提供します。 最後に、Transformer モデルは通常、小さなサンプル タスクに対して強力な汎化パフォーマンスを示すため、研究者らは、MAT もまだ見ぬ MARL タスクに対しても同様の強力なパフォーマンスを発揮できると考えています。したがって、彼らは SMAC およびマルチエージェント MuJoCo タスクに関するゼロショットおよびスモールショット実験を設計しました。 以下の表 1 と図 4 に示すように、SMAC、マルチエージェント MuJoCo、および Bi-DexHands ベンチマークの MAT はほぼすべてのタスクにおいて MAPPO や HAPPO よりも大幅に優れており、同種および異種のエージェント タスクに対する強力な構築能力を示しています。さらに、MAT は MAT-Dec よりも優れたパフォーマンスも達成しており、MAT 設計におけるデコーダ アーキテクチャの重要性を示しています。 同様に、Google Research Football ベンチマークの研究者も同様のパフォーマンス結果を示しています以下の図 5 に示すように、結果が得られました。 研究者らは、対照グループと同様にゼロからトレーニングされた同じデータを使用して MAT のパフォーマンスも提供しました。以下の表に示すように、MAT はほとんどの最良の結果を達成しており、MAT の少数ショット学習の強力な汎化パフォーマンスを示しています。

実験結果

協調的 MARL ベンチマークでのパフォーマンス

#少数ショット学習用の MAT

#少数ショット学習用の MAT

以上がStarCraft II 協力対決ベンチマークが SOTA を上回り、新しい Transformer アーキテクチャがマルチエージェント強化学習問題を解決の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。