ホームページ >テクノロジー周辺機器 >AI >AIと絵画が出会った時、どんな火花が生まれるのか?

AIと絵画が出会った時、どんな火花が生まれるのか?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-08 18:21:011497ブラウズ

まえがき

AIとは何ですか?心の中では、ニューロンが積み重なって構成されるニューラル ネットワークを思い浮かべるかもしれません。では、絵画芸術とは何でしょうか?ダ・ヴィンチの「モナ・リザの微笑」でしょうか、ゴッホの「星月夜」と「ひまわり」でしょうか、それともヨハネス・フェルメールの「真珠の耳飾りの少女」でしょうか? AIと絵画アートが出会ったとき、両者の間にはどのような火花が生まれるのでしょうか?

2021 年初め、OpenAI チームは、テキストの説明に基づいて画像を生成できる DALL-E モデルをリリースしました。強力なクロスモーダル画像生成機能により、自然言語および視覚圏テクノロジーの愛好家の間で強い関心を集めています。この1年余りで雨後の筍のようにマルチモーダル画像生成技術が登場し始め、この間、最近話題の「Disco Diffusion」など、この技術を活用したAIアート制作アプリケーションが数多く生まれています。現在、これらのアプリケーションはアートクリエーターや一般の人々の視野にも徐々に入り込んでおり、多くの人々の口の中で「魔法のペン馬良」となっています。

この記事では、技術的な関心から始めて、マルチモーダル画像生成テクノロジーと古典的な作品を紹介し、最後にマルチモーダル画像生成を使用して魔法の AI 絵画アートを作成する方法を探ります。  Disco Diffusionを使用して作者が作成したAI絵画作品

Disco Diffusionを使用して作者が作成したAI絵画作品

マルチモーダル画像生成の概念

マルチモーダル画像生成(マルチモーダル画像生成)は、テキストや音声などのモーダル情報を誘導条件として利用し、自然な質感を持つリアルな画像を生成することを目的としています。ノイズに基づいて画像を生成する従来のシングルモーダル生成技術とは異なり、マルチモーダル画像生成は常に非常に困難な課題であり、解決すべき問題は主に次のとおりです。モダリティ間の固有の障壁を打ち破るには「ギャップ」が必要ですか?

(2) 論理的で多様な高解像度の画像を生成するにはどうすればよいですか?過去 2 年間で、自然言語処理 (GPT など)、コンピュータ ビジョン (ViT など)、マルチモーダル事前トレーニング (CLIP など)、画像生成テクノロジなどの分野での Transformer の適用が成功し、代表的なものになりました。 VAE と GAN による、新星である拡散モデルに徐々に追い抜かれ、マルチモーダル画像生成の開発は制御不能になっています。

マルチモーダル画像生成テクノロジーと古典的な研究

分類

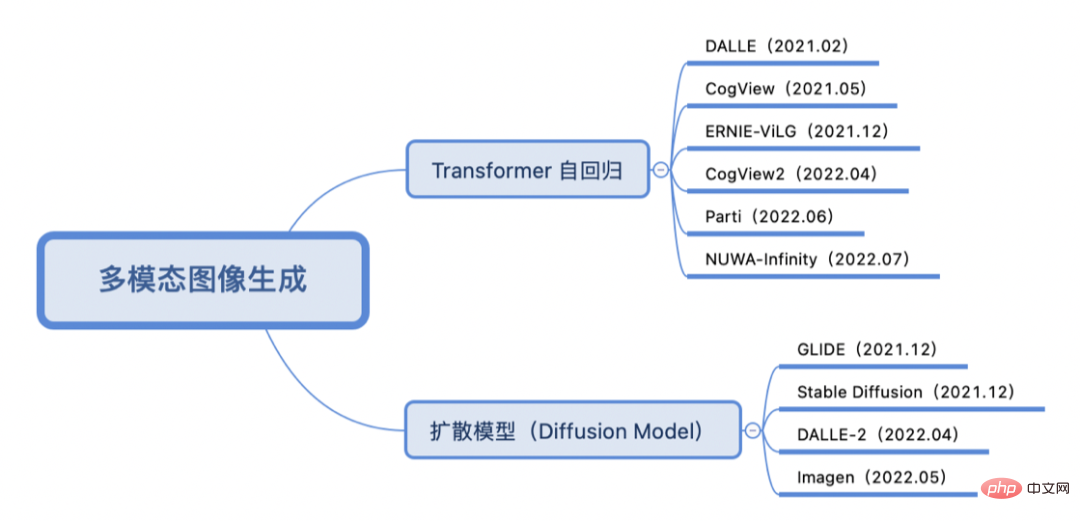

トレーニング方法が Transformer 自己回帰モデルか拡散モデルかに応じて、重要な作業は次のとおりです。過去 2 年間のマルチモーダル画像生成は次のように分類されます:

Transformer Autoregressive

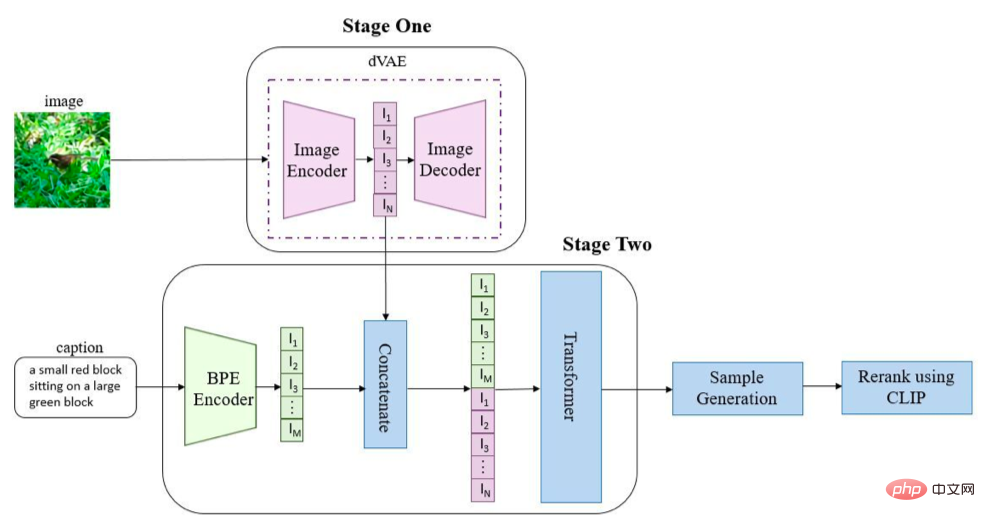

Transformer の自己回帰アプローチでは、多くの場合、テキストと画像をそれぞれトークン シーケンスに変換し、次に生成 Transformer アーキテクチャを使用してテキスト シーケンス (およびオプションの画像シーケンス) から画像シーケンスを予測し、最後に画像生成テクノロジ (VAE、GAN、など)画像シーケンスをデコードして、最終的に生成された画像を取得します。 DALL-E (OpenAI) [1] を例に挙げます。

画像とテキストは、それぞれのエンコーダーを通じてシーケンスに変換され、結合されて Transformer に送信されます。 (ここでは GPT3 が使用されています) 自己回帰シーケンスの生成に使用されます。推論段階では、事前にトレーニングされた CLIP を使用してテキストと生成された画像の類似性が計算され、ソート後に最終的な生成画像の出力が取得されます。 DALL-E と同様に、清華社の CogView シリーズ [2、3] と Baidu の ERNIE-ViLG [4] も VQ-VAE Transformer アーキテクチャ設計を使用しており、Google の Parti [5] は画像コーデックを ViT -VQGAN に置き換えています。 Microsoft の NUWA-Infinity [6] は、自己回帰手法を使用して無限のビジュアル生成を実現します。

画像とテキストは、それぞれのエンコーダーを通じてシーケンスに変換され、結合されて Transformer に送信されます。 (ここでは GPT3 が使用されています) 自己回帰シーケンスの生成に使用されます。推論段階では、事前にトレーニングされた CLIP を使用してテキストと生成された画像の類似性が計算され、ソート後に最終的な生成画像の出力が取得されます。 DALL-E と同様に、清華社の CogView シリーズ [2、3] と Baidu の ERNIE-ViLG [4] も VQ-VAE Transformer アーキテクチャ設計を使用しており、Google の Parti [5] は画像コーデックを ViT -VQGAN に置き換えています。 Microsoft の NUWA-Infinity [6] は、自己回帰手法を使用して無限のビジュアル生成を実現します。

拡散モデル

拡散モデルは、ここ 1 年で急速に発展し、GAN の終焉を告げる画像生成技術です。図に示すように、拡散モデルは 2 つの段階に分かれています: (1) ノイズ処理: 拡散のマルコフ連鎖プロセスに沿って画像にランダム ノイズを徐々に追加します; (2) ノイズ除去: 逆拡散プロセスを学習して画像を復元します。一般的なバリアントには、ノイズ除去拡散確率モデル (DDPM) などが含まれます。

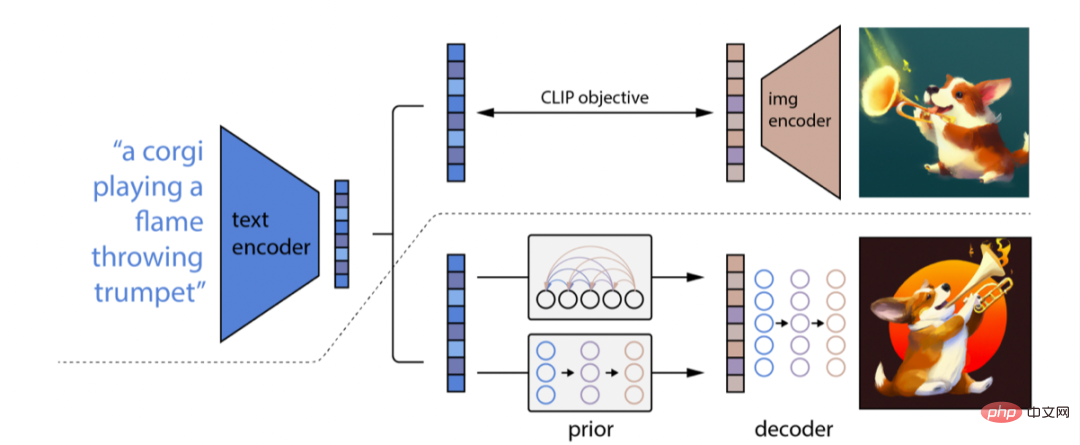

##拡散モデルを使用したマルチモーダル画像生成方法は、主に条件付きガイダンスを備えた拡散モデルを通じてテキスト特徴から画像特徴へのマッピングを学習し、画像特徴をデコードして最終的に生成された画像を取得します。 DALL-E-2 (OpenAI) [7] を例に挙げると、DALL-E の後継ではありますが、DALL-E とは技術的には全く異なるルートをたどっており、その原理は GLIDE [8] に似ています (一部の人々はGLIDE DALL-E-1.5 と呼んでください)。 DALL-E-2 の全体的なアーキテクチャを次の図に示します。

DALL-E-2 は CLIP を使用してテキストをエンコードし、拡散モデルを使用してテキストを学習します。テキストの特徴から画像の特徴へのマッピングを取得するための事前のプロセス、最後に、画像の特徴を最終画像にデコードするための逆 CLIP プロセスを学習します。 DALL-E-2 と比較すると、Google の Imagen [9] は、事前にトレーニングされた T5-XXL を使用してテキスト エンコーディングの CLIP を置き換え、超解像度拡散モデル (U-Net アーキテクチャ) を使用して画像サイズを拡大し、1024 を取得します。 ✖️1024 枚の HD 生成画像。

概要

自己回帰TransformerとCLIP比較学習手法の導入により、テキストと画像の間の架け橋が確立されると同時に、条件付きガイダンスを備えた拡散モデルに基づいて、多様で多様な画像が生成されます。高品質の解像度画像が基礎を築きます。ただし、画像生成の品質の評価は主観的なものであることが多いため、ここで Transformer の自己回帰モデル テクノロジと拡散モデル テクノロジのどちらが優れているかを比較することは困難です。また、DALL-E シリーズ、Imagen、Parti などのモデルは大規模なデータセットでトレーニングされており、その使用は倫理的な問題や社会的偏見を引き起こす可能性があるため、これらのモデルはまだオープンソース化されていません。しかし、この技術を使おうとする愛好家は依然として多く、この期間中に多くのプレイアブル アプリケーションが作成されました。

AI アート制作

マルチモーダル画像生成技術の開発により、AI アート制作の可能性が広がります。現在広く使われている AI 作成アプリケーションおよびツールには、CLIPDraw、VQGAN-CLIP、Disco Diffusion、DALL-E Mini、Midjourney (招待資格が必要)、DALL-E-2 (社内ベータ資格が必要)、Dream By Wombo (アプリ)、 Meta「Make-A-Scene」、Tiktok「AI Green Screen」機能、安定拡散[10]、Baidu「Yige」などこの記事では主にアート制作界隈で人気のDisco DiffusionをAIアート制作に使用しています。

Disco Diffusion の紹介

Disco Diffusion [11] は、Github 上で多くのテクノロジー愛好家によって共同管理されている AI アート作成アプリケーションであり、すでに複数のバージョンが反復されています。 Disco Diffusion の名前から、同社が使用するテクノロジーが主に CLIP によって導かれた普及モデルであることは容易にわかります。 Disco Diffusion は、指定されたテキスト説明 (およびオプションのベースマップ) に基づいて芸術的な画像やビデオを生成できます。たとえば、「Sea of Flowers」と入力すると、モデルはランダムにノイズ画像を生成し、Diffusion のノイズ除去拡散処理を段階的に繰り返し、一定のステップ数に達すると、美しい画像をレンダリングできます。拡散モデルの生成方法が多彩なため、プログラムを実行するたびに異なる画像が得られ、この「ブラインドボックスを開ける」体験は非常に魅力的です。

Disco Diffsion の問題点

マルチモーダル画像生成モデル Disco Diffusion (DD) に基づく AI 作成には、現在いくつかの問題があります。

(1) 生成された画像品質ムラ:生成タスクの難易度にもよりますが、記述内容が難しい生成タスクの歩留まりは20%~30%、記述内容が簡単な生成タスクの歩留まりは60%~30%が目安となります。 70%. ほとんどのタスクの歩留まりは 30 ~ 40% の間です。

(2) 生成速度が遅く、メモリ消費量が多くなります。例として、1280*768 の画像を生成するのに 250 ステップを繰り返すと、約 6 分かかり、V100 16G ビデオ メモリを使用します。

(3) 専門家の経験に大きく依存する: 適切な記述子のセットを選択するには、テキストの内容とウェイト設定、画家の絵画スタイルとアート コミュニティの理解、テキストの選択について多くの試行錯誤が必要です。モディファイア、パラメータの調整 DD に含まれる CLIP ガイド時間/彩度/コントラスト/ノイズ/カット時間/内部および外部カット/グラデーション サイズ/対称性などの概念を深く理解する必要があり、また、特定の芸術スキル。パラメータの数が多いということは、適切な生成画像を得るには専門家の豊富な経験が必要であることも意味します。

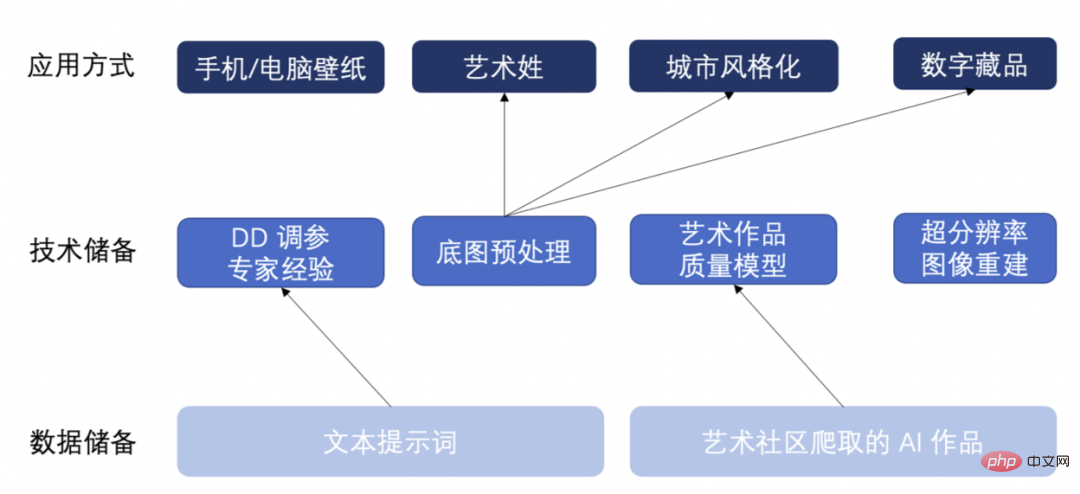

スキル リザーブ

#上記の問題に対応して、いくつかのデータと技術的なリザーブ、および将来のアプリケーションの可能性をいくつか確保しました。下の図に示すように:

- 最初の質問に応えて、私たちはアート制作コミュニティから AI によって生成された約 20,000 点の芸術作品をクロールし、生成された画像の基本的な属性とコンテンツの合理性に基づいて 3 つの分類を実施しました。品質 / 平均的な品質 / 悪い品質、芸術作品の品質評価モデルをトレーニングします。このモデルは、AIが生成した画像の品質を自動的に評価し、歩留まりの高い画像を選択することができ、高画質な画像を手動で選択する際の効率の低さの問題を解決します。

- 2 番目の問題に対処するため、反復回数を減らして小さいサイズの画像を生成し、超解像アルゴリズム ESRGAN を使用して高解像度画像を再構成することで、DD の生成効率を向上させます。この方法では、DD の通常の反復によって生成されるのと同じ画像効果を実現でき、生成効率とビデオ メモリの最適化は少なくとも 2 倍になります。

- 3 番目の質問に応えて、さまざまなベースマップ生成タスクを迅速に適用できる、色温度と色相の調整/前景色と背景の色の調整/ノイズの追加などを含む、ベースマップ前処理ロジックのセットを開発しました。 ; 同時に、私たちはまた、大量のテキストプロンプトワードを蓄積し、多数のDDパラメータ調整の試行錯誤を実施し、専門家の経験に頼って、パーソナライズされた、多様で高品質の画像を生成しました。

これらのデータと技術的埋蔵量を使用して、携帯電話/コンピュータの壁紙、芸術的な姓/名、ランドマーク都市の様式化、デジタルコレクションなどのマルチモーダル画像生成アプリケーション方法を蓄積してきました。以下にAIが生成した具体的なアートワークを紹介します。

AI アートワーク

都市のランドマークの建物の様式化

テキストの説明とランドマークの都市基本地図を入力して、さまざまなスタイル (アニメーション スタイル) の絵画を生成 /サイバーパンク スタイル/ピクセル アート スタイル):

(1) アニメ スタイルの建物、新海誠と beeple 作、artstation のトレンド。

(2) サイバーパンク スタイルの建物、Gregory 作Grewdson、artstation でトレンド中。

(3) ピクセル スタイルの建物、Stefan Bogdanovi、artstation でトレンド中。

デジタルコレクション

テキスト説明とベースマップを入力して、ベースマップ上に作成します。

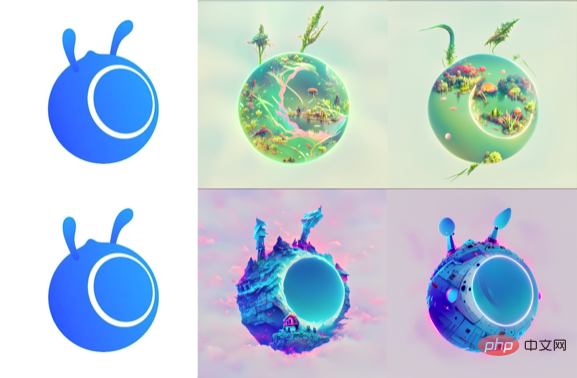

- Ant Logo シリーズ (Ant Forest/Ant House/Ant Spaceship):

(1) RAHDS と beeple による、植生と湖のある風景、artstation でトレンド中.(2) 不気味なファンタジー風景を予感させる崖の端にある魔法のコテージ、RAHDS と beeple 作、artstation でトレンド中。

#(3) RAHDS と beeple 作、宇宙船、artstation でトレンド中。

- アントチキン シリーズ (チキン トランスフォーマー/チキン スポンジボブ):

パソコン/コンピューターの壁紙

- テキストの説明を入力してモバイル壁紙を生成します:

(2) 散在テラス、冬、雪、新賀誠作、Artstation でトレンド、4k 壁紙。(3) ピクサーのロココ スタイル、Artstation、ボリュメトリック ライティングによる、スチームパンクなクジラが告げる深淵から現れるアトランティスの美しいクラウドパンク絵画。

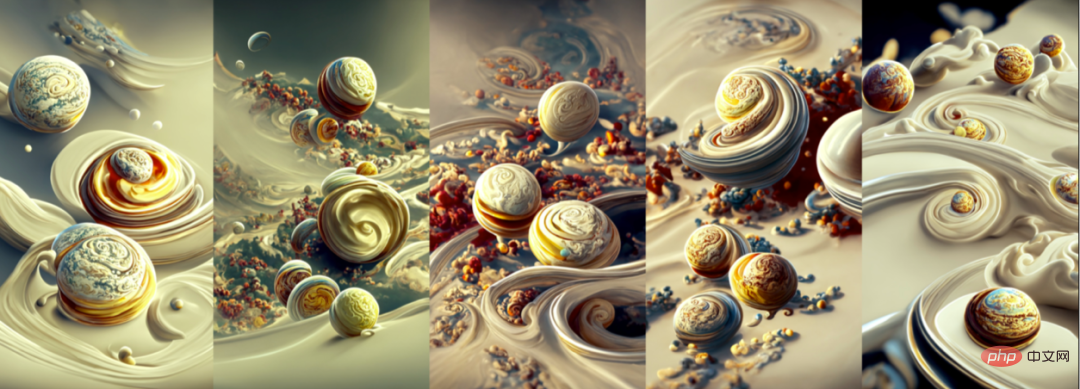

##(4~8) Artstation でトレンドになっているエルンスト ヘッケルとピクサーによる、シャンティ クリームを通して回転する惑星の美しい景色、4K 壁紙 .

##(4~8) Artstation でトレンドになっているエルンスト ヘッケルとピクサーによる、シャンティ クリームを通して回転する惑星の美しい景色、4K 壁紙 .

- (1) 美しく美しい田園地帯、超広角、俯瞰、新海誠の朝。

(4) ダニエル メリアムによる夢のような風景の中にある魔法の建物の美しいレンダリング、柔らかな照明、4K HD の壁紙、artstation と behance でトレンドになっています。

#AI 艺术姓

# 入力文本文の説明と姓氏の底図により、異なる风格の艺术姓:

(1) 大規模軍事工場、機械試験機、半完成機械、エンジニアリング車両、自動化管理、インジケーター、未来、SF、光効果、高精細画像。- (2) キノコ、木の美しい絵、アートステーション、アートステーション、4k hd の壁紙。

#(6) コントラ フォース、レッド フォートレス、宇宙船、エルンスト ヘッケルとピクサーによる、壁紙 HD 4K、アートステーションでトレンド。

その他の AI 艺术作应用

安定した拡散 [10, 12] ディスコの拡散 [11] よりも高い効果と安定した创作能力を発揮、下の図は、安定した拡散を利用した、本文に基づいて作成された AI 画作品です。

安定した拡散 [10, 12] ディスコの拡散 [11] よりも高い効果と安定した创作能力を発揮、下の図は、安定した拡散を利用した、本文に基づいて作成された AI 画作品です。

本明細書では主に、今後数年間のマルチモデル画像生成技術および関連する拡張作業を紹介し、マルチモデル画像生成を使用してさまざまな AI 作業を実行することを試みます。消費型CPU上で実行される多モデム画像生成技術の可能性を探索し、AI智能作為の統合技術、さらには電子、アニメーション、アニメーション、元宇宙のコンテンツ作など、より多くの関連性を検討します。

マルチモデル画像生成技術を使用してアクションを実行するのは、AI 自主生成コンテンツ (AIGC、AI 生成コンテンツ) の応用方法の 1 つです。 AIGC は、より多くの優れたコンテンツを提供するために、段階的に加速することができます。または、汎用的な人工知能は、さらにもう少し進みますか? ここに記載されている技術またはユーザーの関心があれば、喜んで交流します。 #参考文献[1] Ramesh A、Pavlov M、Goh G、他。ゼロショットのテキストから画像への生成[C]//機械学習に関する国際会議。 PMLR、2021: 8821-8831. [2] Ding M、Yang Z、Hong W、他。 Cogview: トランスフォーマーによるテキストから画像への生成をマスターする[J]。 Advances in Neural Information Processing Systems、2021、34: 19822-19835.

[2] Ding M、Yang Z、Hong W、他。 Cogview: トランスフォーマーによるテキストから画像への生成をマスターする[J]。 Advances in Neural Information Processing Systems、2021、34: 19822-19835.

[3] Ding M、Zheng W、Hong W、他。 CogView2: 階層型トランスフォーマーを使用した、より高速かつ優れたテキストから画像への生成[J]。 arXiv プレプリント arXiv:2204.14217、2022.

[4] Zhang H、ying W、Fang Y、他。 ERNIE-ViLG: 双方向視覚言語生成のための統合生成事前トレーニング[J]。 arXiv プレプリント arXiv:2112.15283、2021.

[5] Yu J、Xu Y、Koh J Y 他。コンテンツリッチなテキストから画像への生成のための自己回帰モデルのスケーリング[J]。 arXiv プレプリント arXiv:2206.10789、2022.

[6] Wu C、Liang J、Hu X、他。 NUWA-Infinity: 無限の視覚合成のための自己回帰生成に対する自己回帰 [J]。 arXiv プレプリント arXiv:2207.09814、2022.

[7] Ramesh A、Dhariwal P、Nichol A、他。クリップ潜在を使用した階層的なテキスト条件付き画像生成[J]。 arXiv プレプリント arXiv:2204.06125、2022.

[8] Nichol A、Dhariwal P、Ramesh A、他。 Glide: テキストガイド付き拡散モデルを使用したフォトリアリスティックな画像の生成と編集に向けて [J]。 arXiv プレプリント arXiv:2112.10741、2021.

[9] Saharia C、Chan W、Saxena S、他。深い言語理解によるフォトリアリスティックなテキストから画像への拡散モデル[J]。 arXiv プレプリント arXiv:2205.11487、2022.

[10] Rombach R、Blattmann A、Lorenz D、他。潜在拡散モデルを使用した高解像度画像合成[C]//コンピューター ビジョンとパターン認識に関する IEEE/CVF 会議の議事録。 2022: 10684-10695.

[11] Github: https://github.com/alembics/disco-diffusion

[12] Github: https://github.com/CompVis/stable-diffusion

以上がAIと絵画が出会った時、どんな火花が生まれるのか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。