ホームページ >テクノロジー周辺機器 >AI >画像の大部分が欠落している場合でも、新しいモデル CM-GAN は全体的な構造とテクスチャの詳細を考慮して、リアルに復元できます。

画像の大部分が欠落している場合でも、新しいモデル CM-GAN は全体的な構造とテクスチャの詳細を考慮して、リアルに復元できます。

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-08 17:41:011527ブラウズ

画像の復元とは、画像の欠落した領域を補完することを指します。これは、コンピューター ビジョンの基本的なタスクの 1 つです。この方向には、オブジェクトの削除、画像のリターゲティング、画像の合成など、多くの実用的な用途があります。

初期の修復方法は、画像の欠落部分を埋めるための画像ブロック合成または色の拡散に基づいていました。より複雑な画像構造を実現するために、研究者はデータ駆動型のアプローチに目を向けており、深い生成ネットワークを利用してビジュアルコンテンツと外観を予測しています。生成修復モデルは、大規模な画像セットでトレーニングし、再構築と敵対的損失を利用することで、自然画像や人間の顔などのさまざまな種類の入力データに対して、より視覚的に魅力的な結果を生成することが示されています。

しかし、既存の作品は単純な画像構造を完成させる場合にのみ良好な結果を示すことができ、複雑な全体構造と高いディテール忠実度を備えた画像コンテンツを生成することは依然として大きな課題です。穴が大きい。

本質的に、画像修復は 2 つの重要な問題に直面しています: 1 つはグローバル コンテキストを不完全な領域に正確に伝播する方法であり、もう 1 つはグローバル キューと一致する実際のローカル パーツを合成することです。 。グローバルなコンテキスト伝播の問題を解決するために、既存のネットワークは、エンコーダ - デコーダ構造、アトラス畳み込み、コンテキスト アテンション、またはフーリエ畳み込みを利用して、長距離の特徴依存関係を統合し、有効な受容野を拡張します。さらに、2 段階のアプローチと反復的な穴埋めは、大まかな結果の予測に依存して全体的な構造を強化します。ただし、これらのモデルには、マスクされていない領域の高レベルのセマンティクスを取得し、それらを効果的にホールに伝播して全体的なグローバル構造を合成するメカニズムが欠けています。

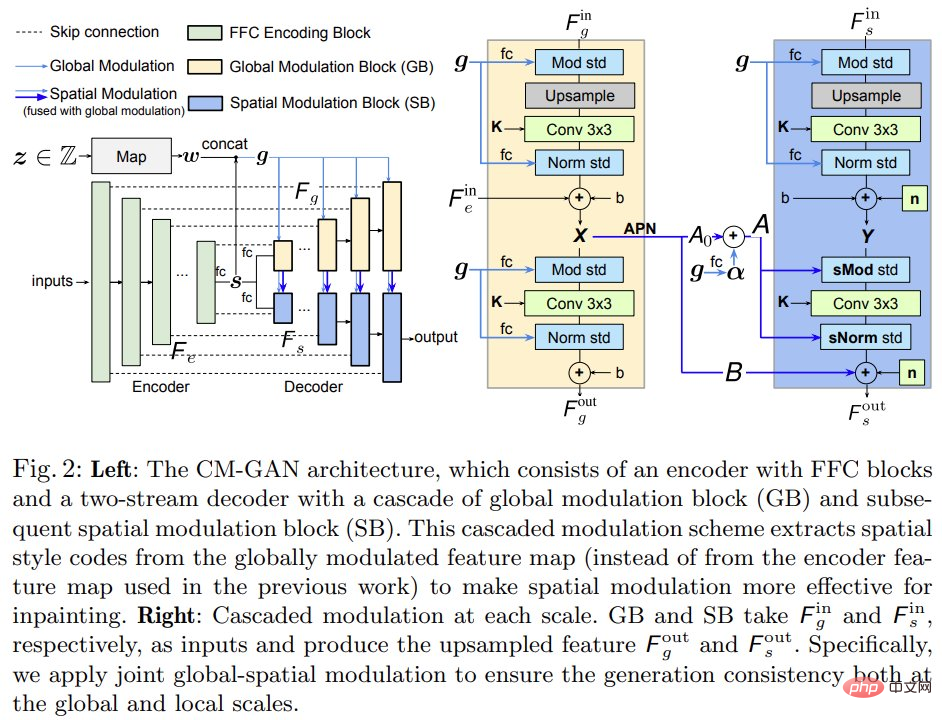

これに基づいて、ロチェスター大学と Adobe Research の研究者は、新世代ネットワーク CM-GAN (カスケード変調 GAN) を提案しました。これは、全体の構造を地理的により適切に合成し、地元の詳細。 CM-GAN には、穴のある入力画像からマルチスケールの特徴表現を抽出するためのフーリエ畳み込みブロックを備えたエンコーダーが含まれています。 CM-GAN には 2 ストリーム デコーダもあり、各スケール レイヤーに新しいカスケード グローバル空間変調ブロックを設定します。

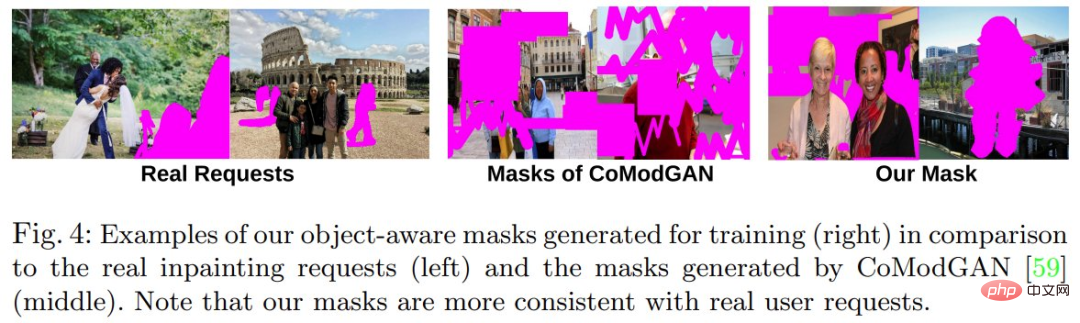

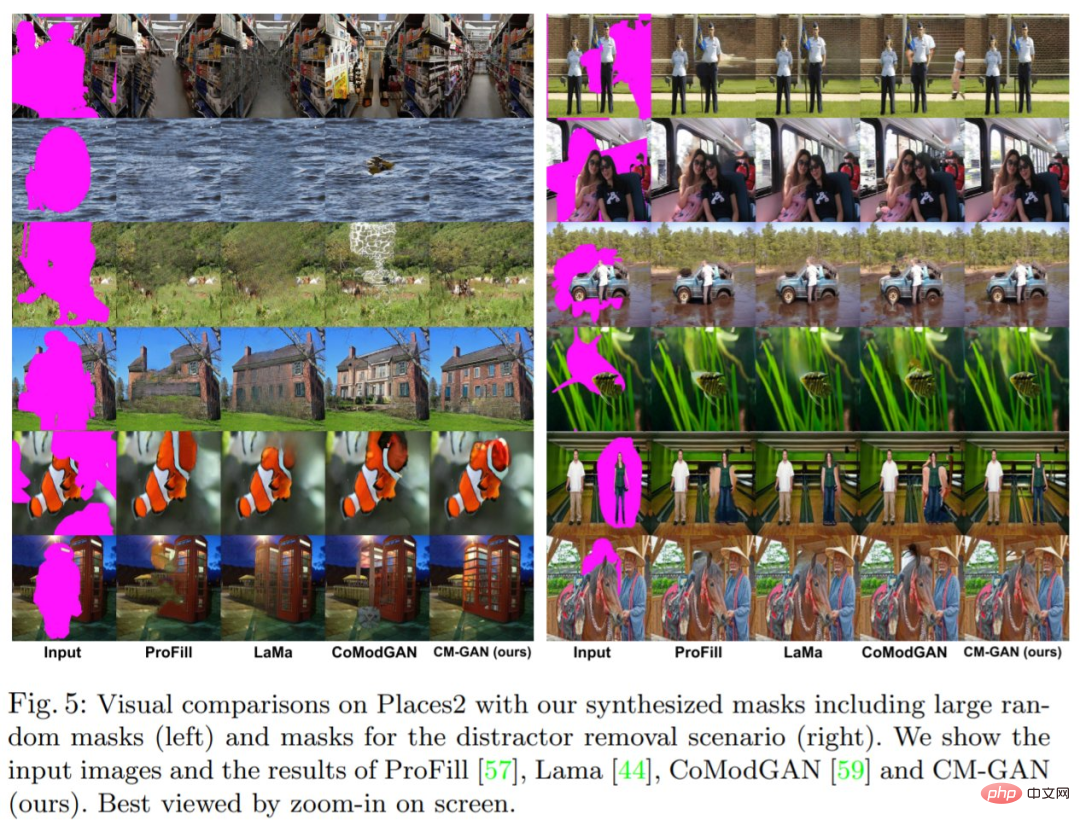

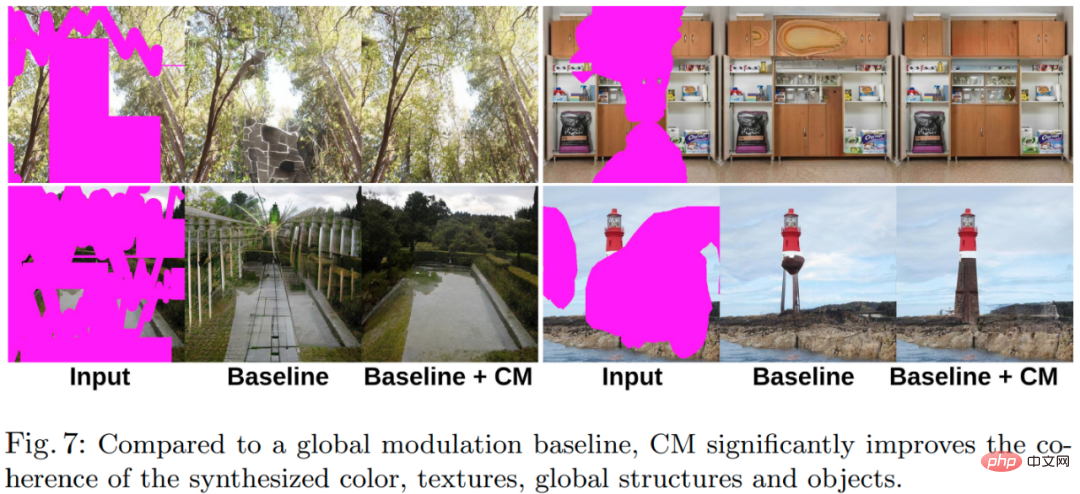

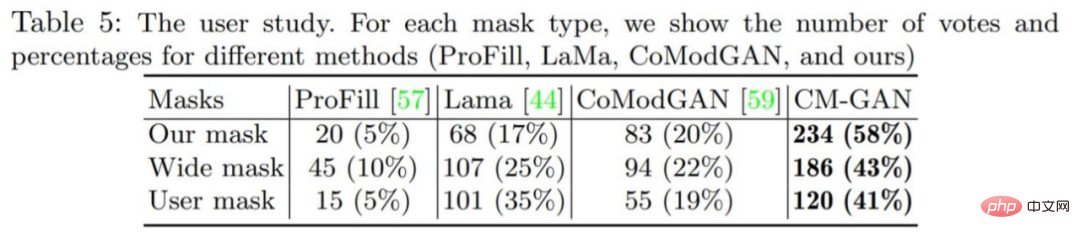

各デコーダ ブロックでは、まずグローバル変調を適用して粗く意味を意識した構造合成を実行し、次に空間変調を実行して空間適応的な方法で特徴マップをさらに調整します。さらに、この研究では、現実のシーンでの物体除去タスクのニーズを満たすために、空洞内のアーティファクトを防ぐための物体知覚トレーニングスキームを設計しました。この研究では広範な実験が行われ、CM-GAN が定量的評価と定性的評価の両方で既存の方法よりも大幅に優れていることが示されました。

- #論文アドレス: https://arxiv.org/pdf/2203.11947.pdf

- プロジェクトアドレス: https://github.com/htzheng/CM-GAN-Inpainting

##CM-GAN はより優れたグローバル構造を合成できます:

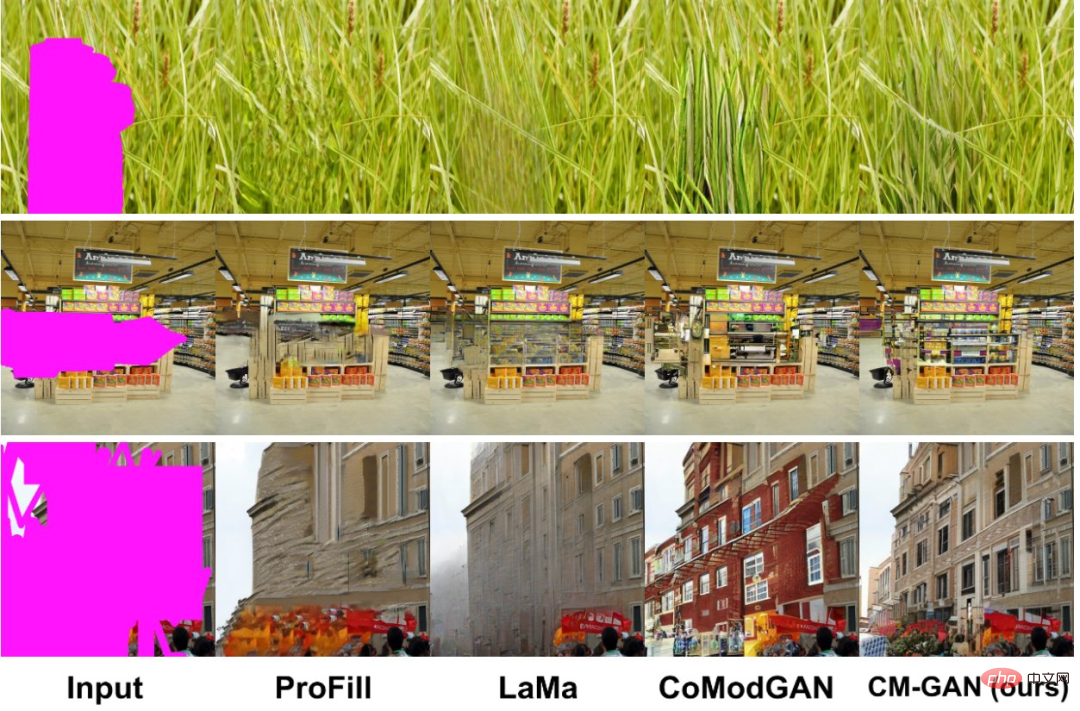

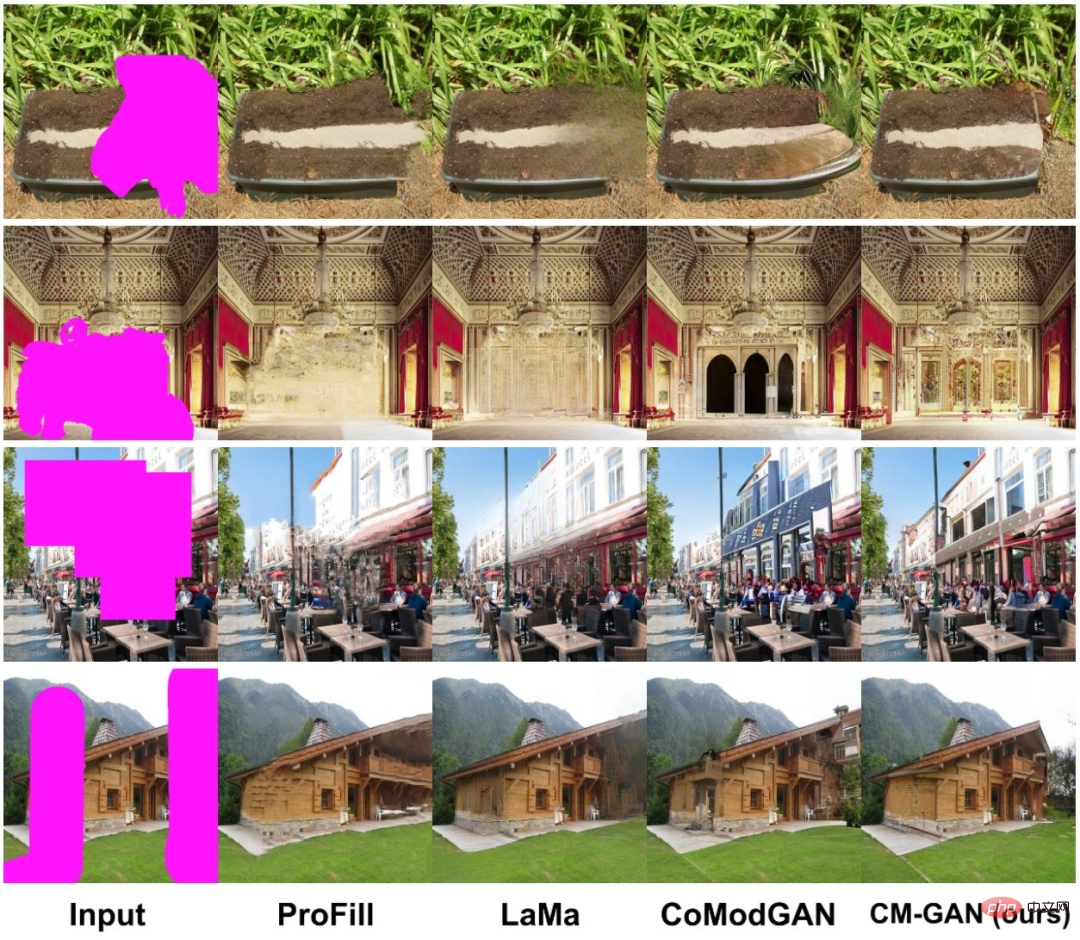

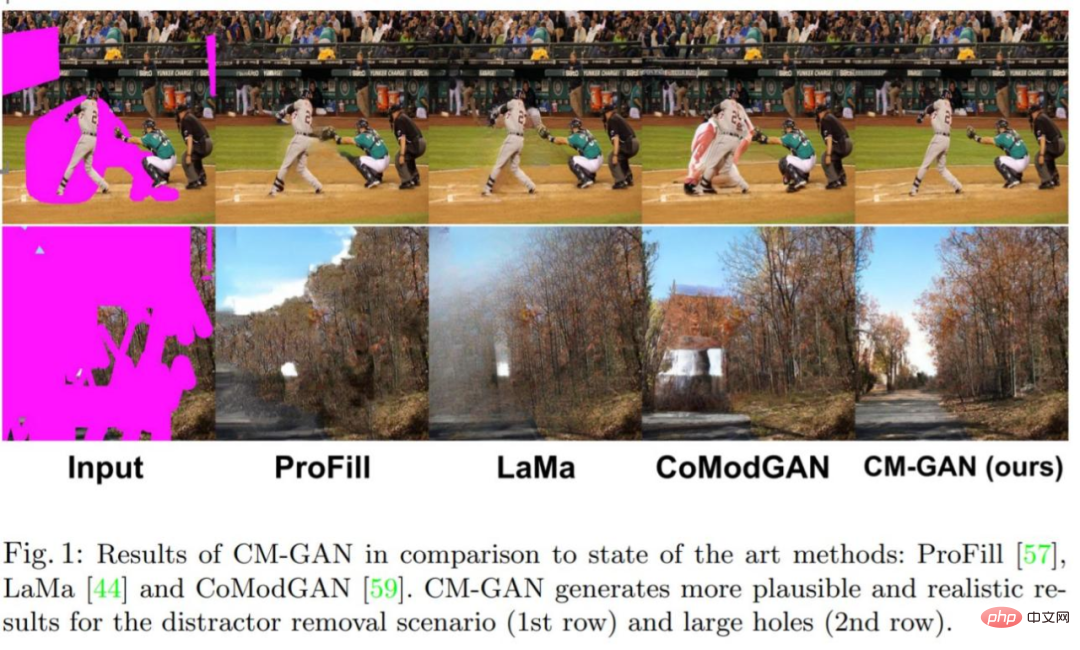

画像補完のグローバルなコンテキストをより適切にモデル化するために、この研究では、グローバル コード変調と空間コード変調をカスケード接続する新しいメカニズムを提案します。このメカニズムは、グローバル コンテキストを空間ドメインに適切に挿入しながら、部分的に無効なフィーチャを処理するのに役立ちます。新しいアーキテクチャ CM-GAN は、以下の図 1 に示すように、全体の構造と局所的な詳細を適切に合成できます。

を生成します。

からグローバル スタイル コードを抽出します。次に  正規化。さらに、MLP ベースのマッピング ネットワークは、画像生成のランダム性をシミュレートするためにノイズからスタイル コード w を生成します。コード w は s と結合されてグローバル コード g = [s; w] が生成され、これは後続の復号化ステップで使用されます。

正規化。さらに、MLP ベースのマッピング ネットワークは、画像生成のランダム性をシミュレートするためにノイズからスタイル コード w を生成します。コード w は s と結合されてグローバル コード g = [s; w] が生成され、これは後続の復号化ステップで使用されます。

さらに、この研究では、安定した修復タスクの敵対的トレーニングに特化したマスク R_1 正則化も提案しています。マスク m は、マスク外の勾配ペナルティの計算を回避するために利用されます。

実験

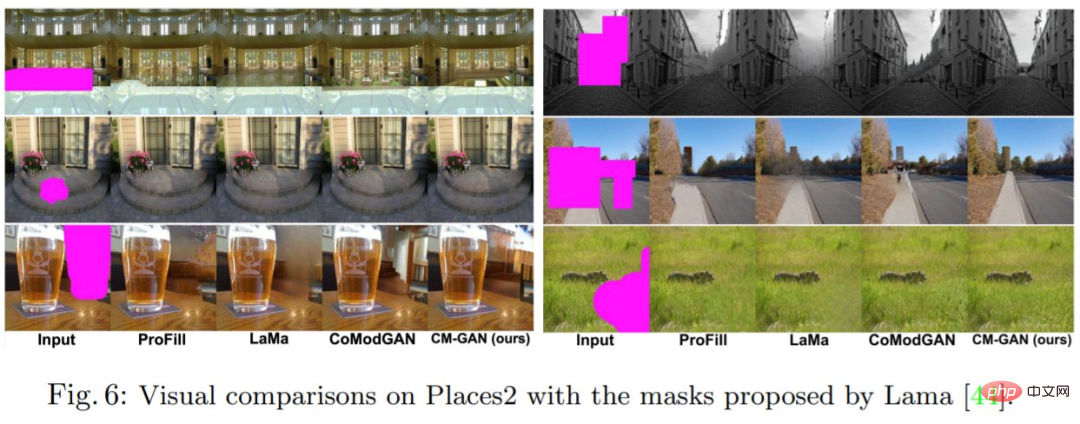

この研究では、Places2 データセットに対して 512 × 512 の解像度で画像修復実験を実施し、モデルの定量的な結果を示しました。そして定性的な評価結果。

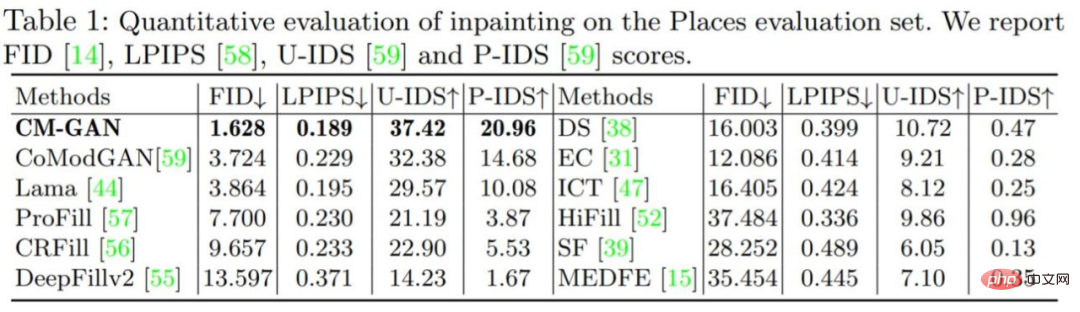

定量的評価: 以下の表 1 は、CM-GAN と他のマスキング手法を比較しています。結果は、CM-GAN が FID、LPIPS、U-IDS、および P-IDS の点で他の方法よりも大幅に優れていることを示しています。 LaMa の知覚損失の助けにより、CM-GAN は、事前トレーニングされた知覚モデルによって提供される追加のセマンティック ガイダンスのおかげで、CoModGAN や他の方法よりも大幅に優れた LPIPS スコアを達成します。 LaMa/CoModGAN と比較して、CM-GAN は FID を 3.864/3.724 から 1.628 に削減します。

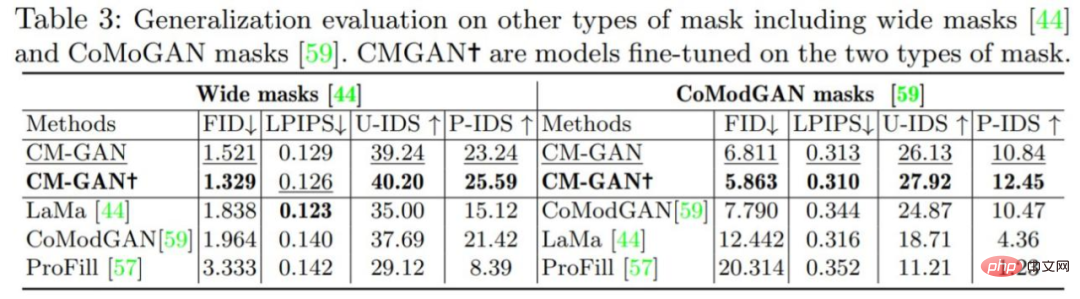

以下の表 3 に示すように、微調整の有無にかかわらず、CM-GAN は LaMa およびCoModGAN マスク どちらも LaMa および CoModGAN よりも大幅に優れたパフォーマンス向上を達成しており、このモデルが一般化機能を備えていることを示しています。 CoModGAN マスク、オブジェクト認識マスクでトレーニングされた CM-GAN のパフォーマンスが依然として CoModGAN マスクのパフォーマンスより優れていることは注目に値します。これは、CM-GAN の生成能力が優れていることを裏付けています。

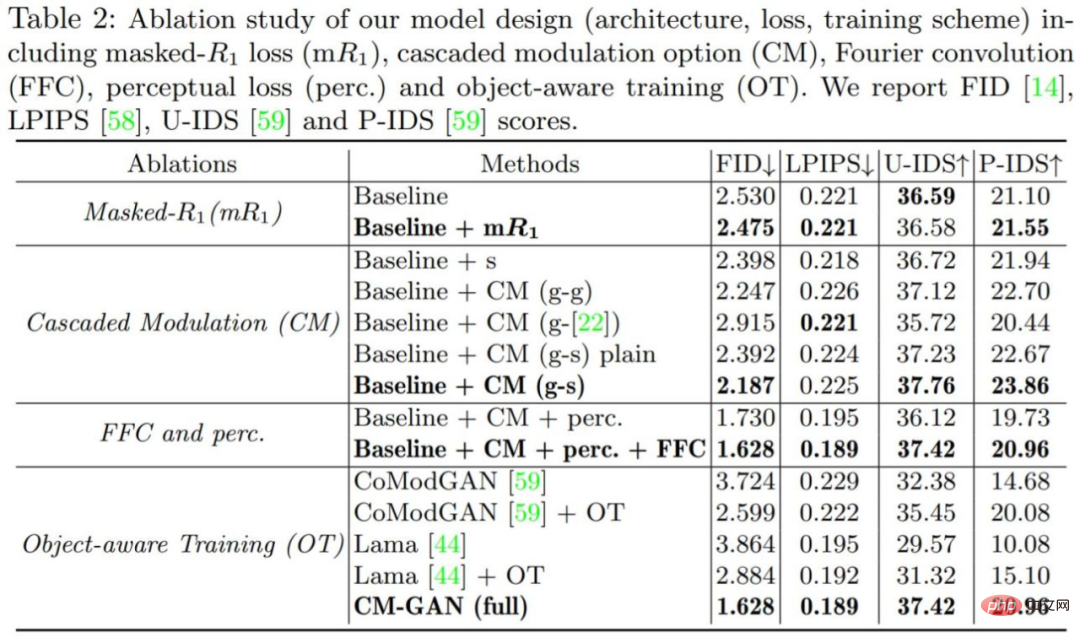

#モデル内の各コンポーネントの重要性を検証するために、この研究では一連のアブレーション実験を実施し、すべてのモデルは Places2 データセットでトレーニングおよび評価されました。アブレーション実験の結果を以下の表 2 および図 7 に示します。

##

##

以上が画像の大部分が欠落している場合でも、新しいモデル CM-GAN は全体的な構造とテクスチャの詳細を考慮して、リアルに復元できます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。