ホームページ >テクノロジー周辺機器 >AI >マーカス: 新しい Bing は ChatGPT よりも荒々しいですが、これは Microsoft の意図的なものですか、それとも偶然ですか?

マーカス: 新しい Bing は ChatGPT よりも荒々しいですが、これは Microsoft の意図的なものですか、それとも偶然ですか?

- 王林転載

- 2023-04-08 15:51:031322ブラウズ

New Bing が大規模な内部テストを開始して以来、ネチズンは 抑制された ChatGPT と比較して、New Bing の回答がワイルドすぎることを発見しました。不倫、離婚の奨励、ユーザーへの脅迫、犯罪のやり方の指導など。

Microsoft は言語モデルの一部の「意味不明な」機能を保持していると言えます。そのため、ChatGPT を使用していないことがわかりますが、シンビの答え。

#Microsoft の RLHF がその役割を果たせなかったのは ですか # それとも 素晴らしいインターネット コーパス ChatGPT 自体を失わせますか?

なぜ Bing はこれほどまでにワイルドなのでしょうか?

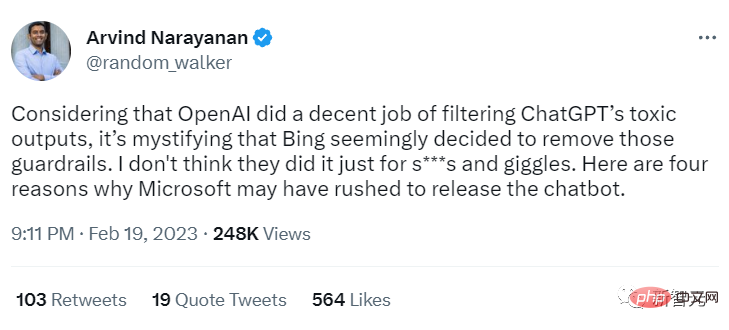

プリンストン大学教授のアービンド・ナラヤナン氏は、Bing がなぜそれほど「ワイルド」なのかについて 4 つの可能性を提案しました。ツイートの中で、ナラヤナン教授は、OpenAI が ChatGPT の有害な出力をうまくフィルタリングしていると信じていますが、Bing はこれらの保護を削除しているようで、非常に混乱しています。

彼は、Microsoft が単に楽しみのためにこれを行っているのではなく、新しい Bing をこれほど急いでリリースする他の理由があるに違いないと信じています。

New Bing によって表示される動作は ChatGPT とはかなり異なり、同じ基礎モデルに基づいているとは考えられません。おそらく、LLM は最近トレーニングを完了したばかり (つまり GPT-4?) かもしれません。この場合、Microsoft はリリースを遅らせてさらなる RLHF トレーニングを受けるのではなく、新しいモデルを迅速に展開することを (賢明ではなく) 選択した可能性があります。

Marcus 氏は、以前の記事「ChatGPT の闇の中心」でも、大規模言語モデルには多くの不快なコンテンツが潜んでいるが、おそらく Microsoft は何も対策を講じていないのではないかと述べています。有害なコンテンツをフィルタリングします。

可能性 2: 誤検知が多すぎる

##Microsoft は確かに Bing 用のフィルターを作成したかもしれませんが、実際に使用すると、誤検知が多すぎると予測されました。 ChatGPT の場合、この問題は重要ではありませんが、検索シナリオではユーザー エクスペリエンスに重大な影響を与えます。

言い換えれば、フィルタは実際の検索エンジンで使用するには煩わしすぎるということです。

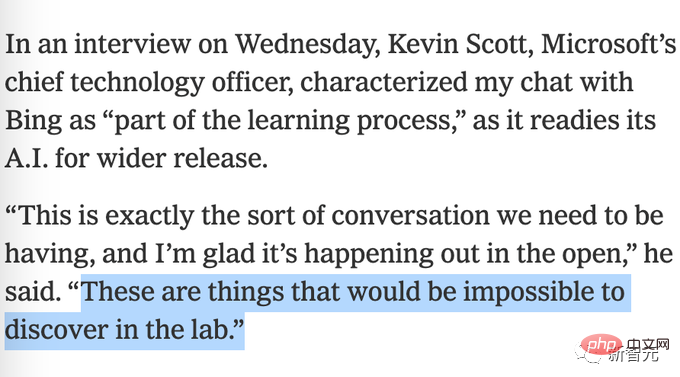

#可能性 3: ユーザーからのフィードバックを得るには

# それは、 #Bing が、何が問題になっているのかについてより多くのユーザー フィードバックを得るために、意図的にフィルター制限をオフにした可能性があります。 Microsoftは以前、実験室でテストを完了することは不可能であるという奇妙な主張を行った。

可能性 4: Microsoft もこれを予期していなかった

Microsoft は、プロンプト プロジェクトに基づくフィルターで十分だと考えている可能性があり、新しい Bing エラーが今日のような状況に発展するとはまったく予想していませんでした。

Marcus は基本的にはナラヤナン教授の見解に同意していますが、おそらく Microsoft は保護手段を削除していないので、 「単に効果がないだけ」の可能性があり、これは最初の 5 つの可能性でもあると考えています。 。

つまり、おそらく Microsoft は既存のトレーニング済み RLHF モデルを GPT 3.6 の上に置こうとしたのですが、うまくいきませんでした。

強化学習はこだわりがあることで有名で、少し環境を変えると役に立たなくなる可能性があります。

DeepMind の有名な DQN 強化学習は Atari ゲームで記録を打ち立てましたが、Breakout ゲームでパドルを数ピクセル上に移動するなど、いくつかの小さな変更を加えただけで、モデルが崩壊します。そしておそらく、大規模な言語モデルを更新するたびに、強化学習モジュールの完全な再トレーニングが必要になるでしょう。

これは非常に悪いニュースであり、人的コストと経済的コスト(ひどい仕事をする低賃金の人々が増えることを意味します)の観点だけでなく、信頼性の観点からも同様です。大規模な言語モデルの新しい反復が安全であるという保証はありません。

この状況は、主に 2 つの理由から特に恐ろしいです:

1. 大企業はいつでも自由に新しいアップデートをプッシュできます。警告が必要です;

2. 新しいモデルをリリースするには、一般向けの経験的テストがどの程度うまく機能するかを事前に知ることなく、一般向けに何度もテストする必要がある場合があります。

医療分野における新薬の発売と同様に、一般の人々は、新薬が発売前に研究室で完全にテストされること、特に次の場合には大規模な言語モデルのリリースに切り替えることを要求します。何十億人もの人々がそれを使用する可能性があります 重大なリスク (ユーザーの精神的健康や婚姻状況を乱すなど) がある場合は、ユーザーに公開で直接テストさせるべきではありません、

ポリシー 、大衆にはモデルの何が問題なのかを知る権利がある(あるいは厳密に言えばそう主張すべきである)。

#たとえば、Bing は問題を明らかにした後、同様のインシデントが再び発生するのを防ぐためのポリシーを策定できます。現在、人工知能は基本的に開発段階にあり、誰でもチャットボットを起動できます。

議会は何が起こっているのかを把握し、特に精神的または身体的危害が容易に引き起こされる可能性のある場所に制限を設定し始める必要があります。

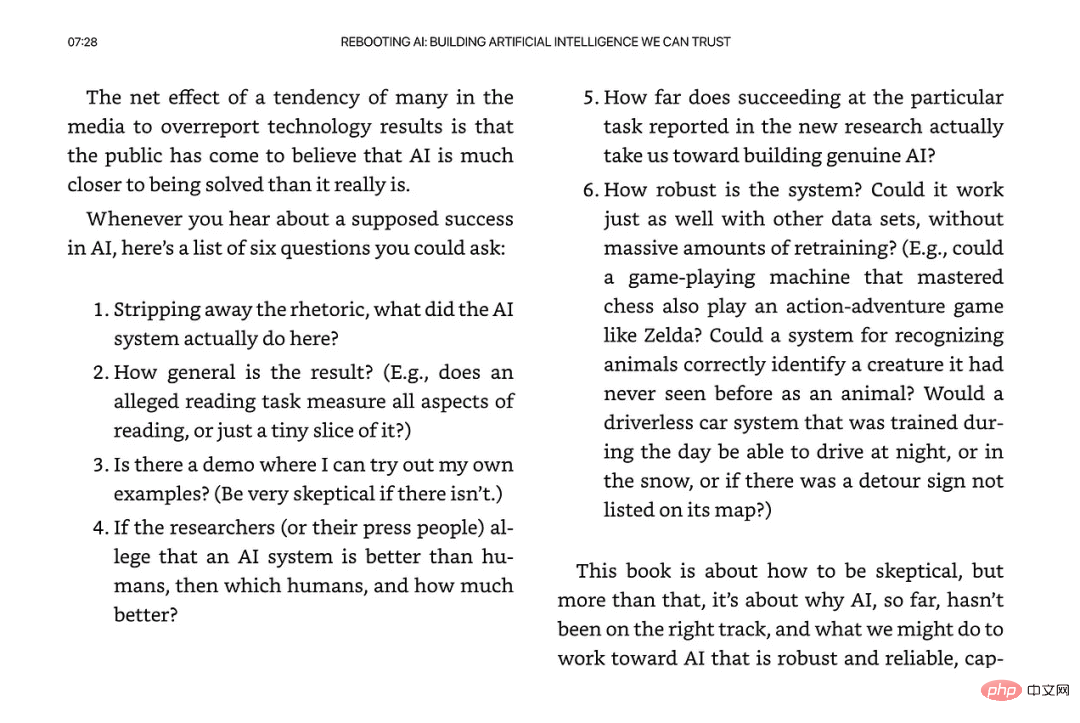

ジャーナリズム業界では、メディアも人々を失望させます。

ケビン・ルーズは最初の報告でビングに「畏敬の念を抱いた」と述べたが、それがマーカスを特に不安にさせたのは、どうやら「深く掘り下げずにニューヨーク・タイムズ紙で時期尚早に宣伝したため」のようだ。根本的な問題を掘り下げるのは良いことではありません。

さらにもう一つ付け加えさせていただきますと、もう2023年です。マイクロソフトの保護対策は十分なのでしょうか?徹底的に調査されましたか?

新しいシステムに対して「畏敬の念」以外の感情がないとは言わないでください。

最後に、ナラヤナン教授は、「私たちは人工知能と市民社会にとって重大な時期にある。対策を講じなければ、過去5年間にわたる「責任あるAIの解放」に対する実践的な取り組みは失われるだろう」と考えています。抹殺される。

以上がマーカス: 新しい Bing は ChatGPT よりも荒々しいですが、これは Microsoft の意図的なものですか、それとも偶然ですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。