ホームページ >テクノロジー周辺機器 >AI >ツリーベースのモデルが依然として表形式データの深層学習よりも優れているのはなぜですか?

ツリーベースのモデルが依然として表形式データの深層学習よりも優れているのはなぜですか?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-08 14:41:031658ブラウズ

ディープラーニングは、画像、言語、さらにはオーディオなどの分野で大きな進歩を遂げました。ただし、表形式データの処理に関しては、深層学習のパフォーマンスは平凡です。表形式のデータは、特性が不均一である、サンプルサイズが小さい、極値が大きいなどの特徴があるため、対応する不変量を見つけることが困難です。

ツリーベースのモデルは微分可能ではなく、深層学習モジュールと共同でトレーニングすることができないため、テーブル固有の深層学習アーキテクチャの作成は非常に活発な研究分野です。多くの研究は、ツリーベースのモデルに勝るか、それに匹敵することができると主張していますが、その研究には多くの懐疑的な見方があります。

表形式のデータからの学習には確立されたベンチマークがないという事実により、研究者は手法を評価する際に大きな自由が得られます。さらに、オンラインで入手できるほとんどの表形式データセットは、他の機械学習サブドメインのベンチマークと比較して小さいため、評価がより困難になります。

これらの懸念を軽減するために、フランス国立情報自動化研究所、ソルボンヌ大学、およびその他の機関の研究者は、最新の深層学習モデルを評価できる表形式のデータ ベンチマークを提案しました。ツリーベースのモデルが中規模の表形式データセットでも SOTA であることを示しています。

この結論として、この記事では、表形式のデータでは、深層学習 (最新のアーキテクチャであっても) よりもツリーベースの手法を使用した方が優れた予測を達成するのが簡単であるという決定的な証拠を研究者が発見したことを示しています。理由。

文書アドレス: https://hal.archives-ouvertes.fr/hal-03723551/document この論文の著者の 1 人が、Scikit-learn プロジェクトのリーダーの 1 人である Gaël Varoquaux であることは言及する価値があります。このプロジェクトは現在、GitHub で最も人気のある機械学習ライブラリの 1 つになりました。 Gaël Varoquaux による記事「Scikit-learn: Python での機械学習」には 58,949 件の引用があります。

この記事の貢献は次のように要約できます:

この調査は新しいベンチマークを作成します(選択された 45 のオープン データセット)、これらのデータセットを OpenML を通じて共有すると、使いやすくなります。

この研究では、表形式データのさまざまな設定の下で深層学習モデルとツリーベースのモデルを比較し、ハイパーパラメーターの選択にかかるコストを検討します。この研究では、ランダム検索の生の結果も共有されており、研究者は固定のハイパーパラメータ最適化予算で新しいアルゴリズムを安価にテストできるようになります。

表形式データでは、ツリーベースのモデルがディープ ラーニング手法よりも優れたパフォーマンスを示します

新しいベンチマークは 45 の表形式データ セットを参照しており、選択されたベンチマークは次のとおりです:

- 異種列、列は異なる性質の特徴に対応する必要があるため、画像または信号データ セットは除外されます。

- 次元数が低く、データセットの d/n 比は 1/10 未満です。

- 無効なデータ セット。利用可能な情報がほとんどないデータ セットを削除します。

- I.I.D. (独立して同一に分散) データ。ストリーム状のデータ セットまたは時系列を削除します。

- 実世界のデータ。人工的なデータセットは削除されますが、いくつかのシミュレートされたデータセットは保持されます。

- データ セットが小さすぎることはできません。特徴が少なすぎる (

- 単純すぎるデータ セットを削除します。

- ポーカーやチェスなどのゲームのデータ セットは本質的に決定的であるため、データ セットを削除してください。

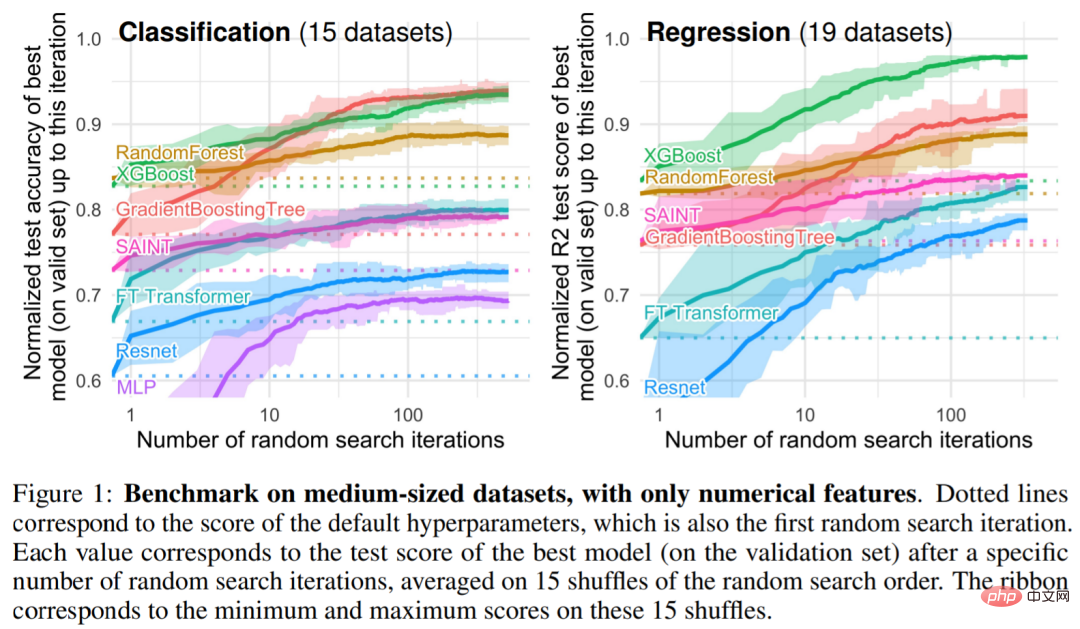

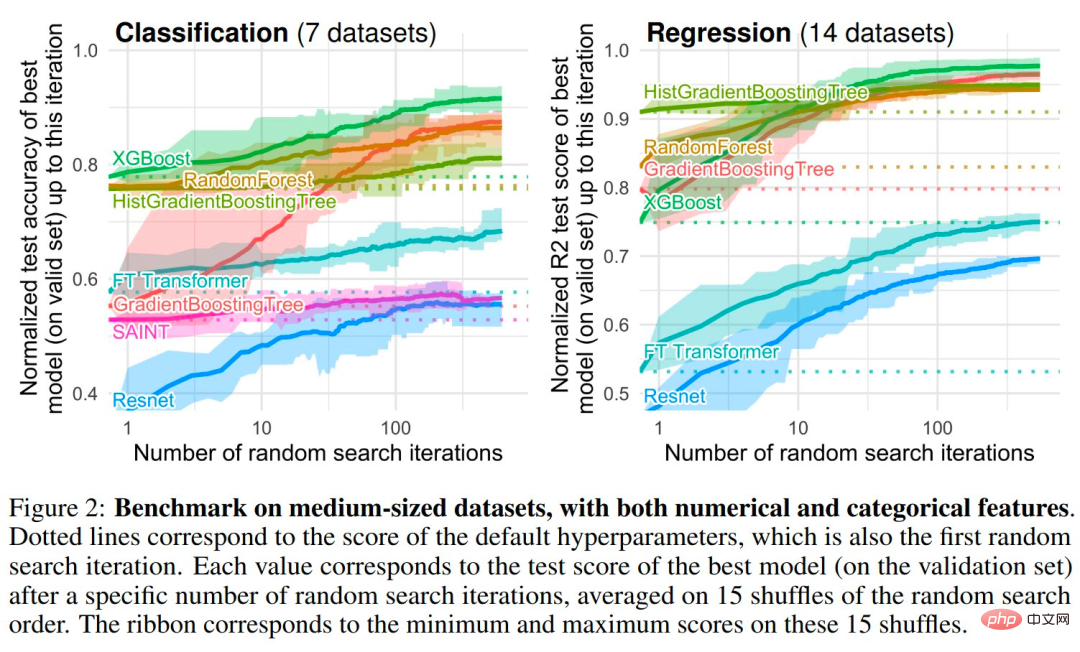

研究者らは、ツリーベースのモデルの中で、Scikit Learn の RandomForest、GradientBoostingTrees (GBT)、および XGBoost の 3 つの SOTA モデルを選択しました。この調査では、MLP、Resnet、FT Transformer、SAINT のディープ モデルに関するベンチマークを実行しました。図 1 と 2 は、さまざまなタイプのデータ セットのベンチマーク結果を示しています

実証的調査: ツリーベースのモデルが依然として表形式データでの深層学習よりも優れている理由

帰納的バイアス 。ツリーベースのモデルは、さまざまなハイパーパラメーターの選択肢にわたってニューラル ネットワークに勝ります。実際、表形式データを処理する最適な方法には 2 つの共通の特性があります。それらはアンサンブル方法、バギング (ランダム フォレスト) またはブースティング (XGBoost、GBT) であり、これらの方法で使用される弱学習器はデシジョン ツリーです。

調査結果 1: ニューラル ネットワーク (NN) は、ソリューションを滑らかにしすぎる傾向があります。

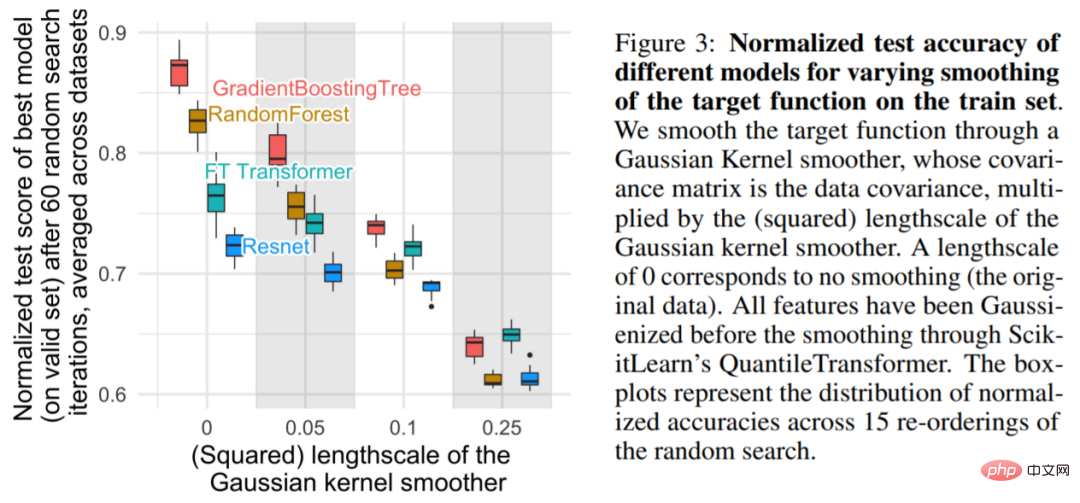

図 3 に示すように、小規模なスケールでは、トレーニング セットの目的関数を平滑化するとツリーベースのモデルの精度が大幅に低下しますが、NN にはほとんど影響がないことが示されています。これらの結果は、データセットの目的関数が滑らかではなく、NN がツリーベースのモデルと比較してこれらの不規則な関数に適応するのが難しいことを示しています。これは、NN が低周波関数に偏っていることを発見した Rahaman らの発見と一致しています。デシジョン ツリー ベースのモデルは、そのようなバイアスなしで区分定数関数を学習します。

調査結果 2: 有益ではない機能は MLP のような NN に大きな影響を与える可能性があります

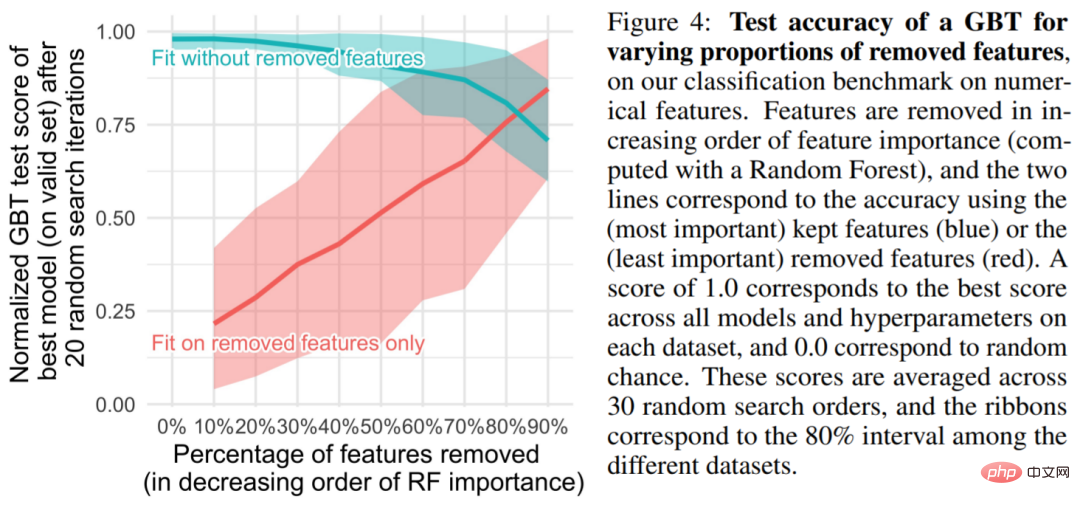

表形式のデータ セットには多くの有益でない特徴が含まれており、各データ セットについて、研究では特徴の重要性に基づいて特定の割合の特徴 (通常はランダム フォレストによって並べ替えられます) を破棄することが選択されます。図 4 からわかるように、特徴の半分以上を削除しても、GBT の分類精度にはほとんど影響がありません。

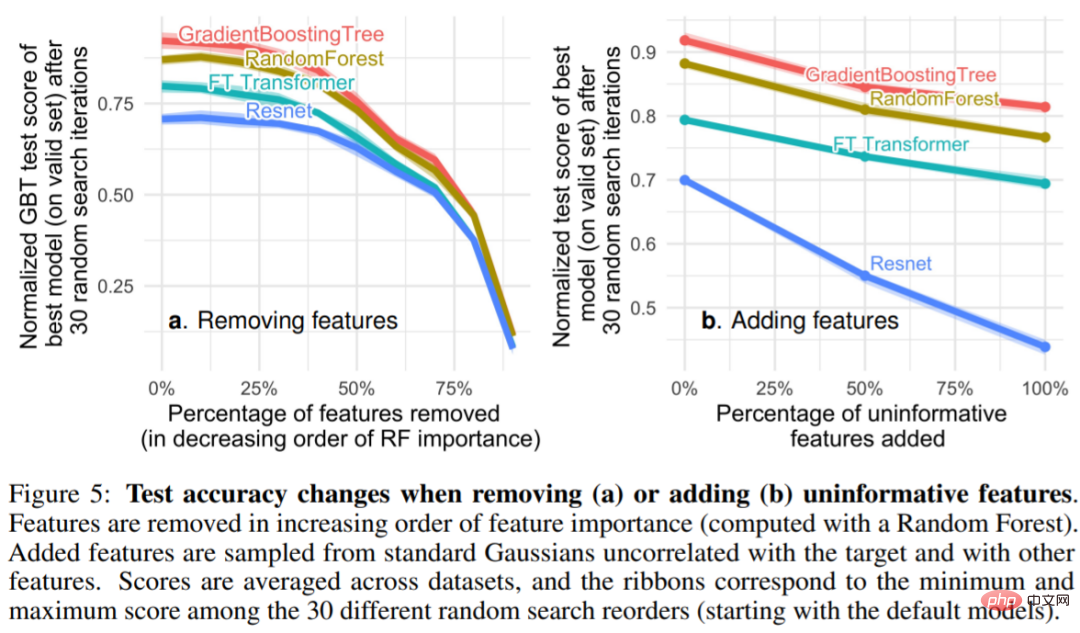

図 5 非有益な特徴 (5a) を削除すると、MLP (Resnet) 間の差異が減少することがわかります。および他のモデル (FT Transformer とツリーベースのモデル間のパフォーマンスのギャップ) に対して、非有益な機能を追加するとギャップが拡大します。これは、MLP が非有益な機能に対して堅牢でないことを示しています。図 5a では、研究者が特徴の大部分を削除すると、それに応じて有用な情報特徴も削除されます。図 5b は、これらの特徴の削除によって生じる精度の低下は、非有益な特徴を削除することで補償できることを示しています。これは、他のモデルと比較して MLP にとってより有益です (同時に、この調査では冗長な特徴も削除されており、モデルのパフォーマンスには影響しません) )。

#発見 3: 回転を通じてデータは不変ではない

MLP が他のモデルに比べて有益ではない特徴の影響を受けやすいのはなぜですか? 1 つの答えは、MLP はローテーション不変であるということです。トレーニング セットで MLP を学習し、テスト セットでそれを評価するプロセスは、ローテーションがトレーニング セットとテスト セットの特徴に適用されるときに不変です。実際、回転不変学習プロセスでは最悪の場合のサンプルの複雑さがあり、少なくとも無関係な特徴の数が線形に増加します。直感的には、不要なフィーチャを削除するには、回転不変アルゴリズムで最初にフィーチャの元の方向を見つけてから、情報が最も少ないフィーチャを選択する必要があります。

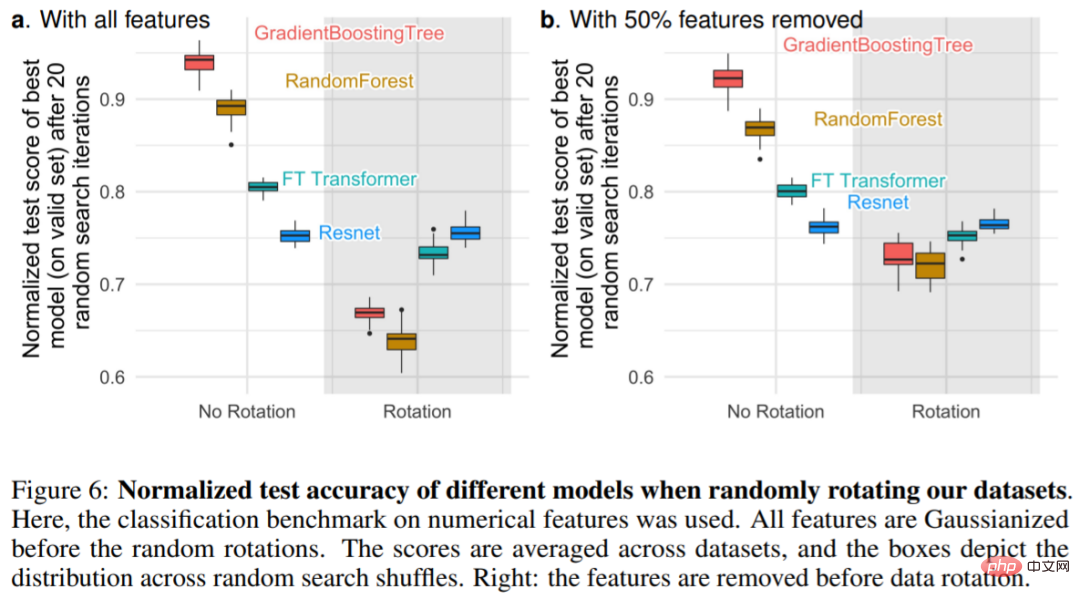

図 6a は、データセットがランダムに回転されたときのテスト精度の変化を示しており、Resnet のみが回転不変であることが確認されています。特に、ランダムな回転はパフォーマンスの順序を逆転させます。結果は、ツリーベースのモデルの上に NN があり、FT Transformer の上に Resnet があり、回転の不変性が望ましくないことを示しています。実際、表形式のデータには、年齢、体重などの個別の意味があることがよくあります。図 6b: 各データセットの特徴の最も重要度の低い半分を削除すると (回転前)、Resnets を除くすべてのモデルのパフォーマンスが低下しますが、特徴を削除せずにすべての特徴を使用した場合と比較すると、低下は小さくなります。

以上がツリーベースのモデルが依然として表形式データの深層学習よりも優れているのはなぜですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。