ホームページ >テクノロジー周辺機器 >AI >注目のトピックの解釈: 大規模モデルの新たな能力と ChatGPT によって引き起こされるパラダイムシフト

注目のトピックの解釈: 大規模モデルの新たな能力と ChatGPT によって引き起こされるパラダイムシフト

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-08 12:31:051597ブラウズ

最近、大規模な言語モデル (思考連鎖[2]、スクラッチパッド[3]など)によって実証される強力な機能に大きな関心が寄せられており、多くの研究が行われています。 。これらの機能を大規模モデルの緊急機能と総称します [4]。これらの機能は大規模モデルにのみ存在し、小規模モデルには存在しない可能性があるため [5]、「緊急」と呼ばれます。これらの機能の多くは、複雑な推論、知識推論、配布外の堅牢性など、非常に優れていますが、これについては後で詳しく説明します。

注目すべきことに、これらの機能は NLP コミュニティが数十年にわたって求めてきたものに近いため、小さなモデルの微調整から使用への研究パラダイム シフトの可能性を示しています。状況に応じた学習のための大規模なモデル。先行者にとって、パラダイムシフトは明らかかもしれません。ただし、科学的な厳密性を保つために、 たとえこれらのモデルが高価であったとしても、[6] 使いにくくても、大規模な言語モデルに移行すべき非常に明確な理由が必要です[ 7 ]、効果は平均的な[8]となる可能性があります。 この記事では、これらの機能とは何か、大規模な言語モデルが提供できるもの、そしてより広範囲の NLP/ML タスクにおけるそれらの潜在的な利点について詳しく見ていきます。

元のリンク: yaofu.notion.site/A-Closer-Look-at-Large-Language-Models-Emergent-Abilities-493876b55df5479d80686f68a1abd72f #目次

前提条件: 読者は次の知識があることを前提としています:

- 事前トレーニング、微調整、プロンプト (一般の実践者が持つべき自然言語処理/深層学習機能)

- 思考チェーン プロンプト、スクラッチ パッド (一般の実践者)あまり理解できていないかもしれませんが、読解には影響しません)

- 1. 小規模モデルではなく大規模モデルに存在する創発的な能力

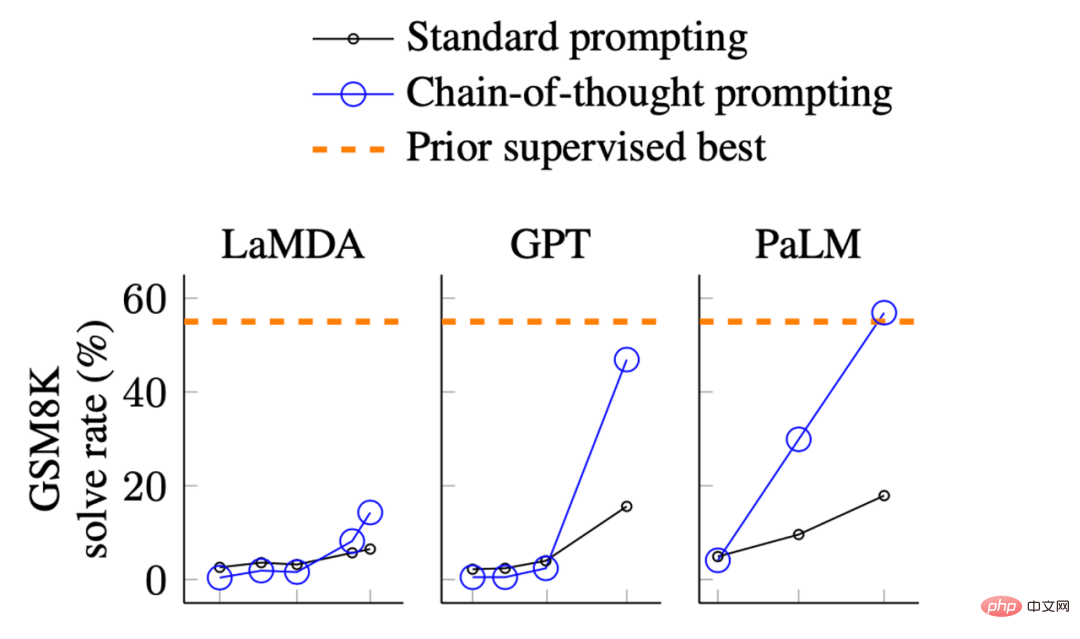

Wei et. al. 2022 からの画像. 思考連鎖プロンプトが大規模言語モデルの推論を引き出す。 X 軸はモデルのサイズです。 GSM8Kは小学校レベルの算数問題集です。

上記のレンダリングでは、モデルのパフォーマンスを観察できます。

- サイズがモデルが比較的小さい場合、改善は大きくありません

- #モデルが大きくなると、大幅な改善が見られます

- #これは基本的に、一部の機能は小規模モデルには存在しない可能性があるが、大規模モデルでは取得されることを示しています。

2022 年に Wei らによって整理されたものなど、さまざまな種類の創発機能があります[9]

。いくつかの機能は興味深いものですが、単語の文字列の最後の文字のスペルなど、この記事では説明しません。これは言語モデルではなく Python のタスクであると考えています。または 3 桁の加算については、それが可能であると考えています。は計算であり、言語モデルの代わりにプロセッサが行うことです。この記事では、主に次の機能に興味があります:

1. NLP コミュニティは近年、NLP に注目しています。 、しかし、モデルが達成するのが難しい以前の NLP 機能

2. 人間の言語の最も深い本質に由来する機能 (機能の深さ)

3. 人間の知能の最高レベル(能力の上限)に達する可能性のある能力

2. 創発的能力の代表的な 3 つの例

興味深いものが多い能力は上記のように分類できます。記事内で言及されているカテゴリのうち、主に次の 3 つの典型的な能力について説明します。## 知識推論

#分布外の堅牢性

- 次に、それぞれについて詳しく説明します。

- 効果の観点から : 思考連鎖プロンプトのパフォーマンスは、以前の微調整よりも大幅に向上しました

- [15]方法。 注釈効率の観点から : 思考チェーン プロンプトには 8 つの例の注釈のみが必要ですが、微調整には完全なトレーニング セットが必要です。

- 小学校の数学ができるモデルなど何の意味もないと考える生徒もいるかもしれません (ある意味、実際にはそれほどクールではありません)。しかし、GSM8K はほんの始まりにすぎず、最近の研究により、最先端の問題が高校 [16]

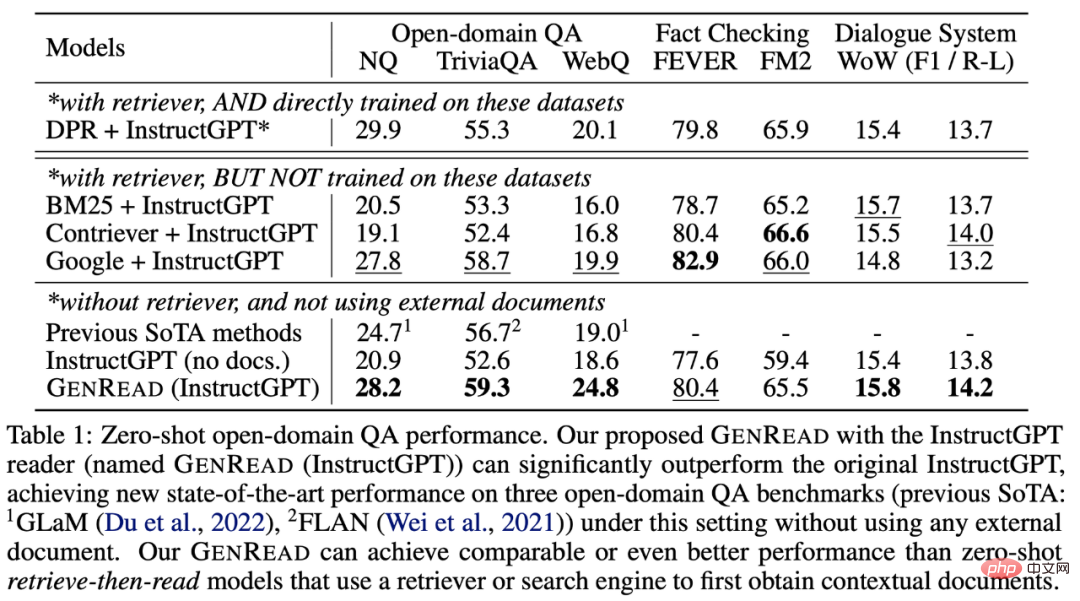

- #大規模な言語モデルの場合、リトリーバーを直接削除することができます##[21]、微調整を必要とせずにモデルの内部知識##[22]のみに依存します

- Yu et. al. 2022 よりの画像以前の SOTA モデルは外部の知識ソースから取得する必要がありました。 GPT-3 は、取得なしの以前のモデルと同等/より優れたパフォーマンスを発揮します。

- 複雑な推論では、すべてのトレーニング データを使用しなくても、大規模なモデルは以前の小規模なモデルよりも大幅に優れたパフォーマンスを発揮します。

- 知識推論、大規模モデルは小規模モデルほど効果的ではない可能性がありますが、大規模モデルには追加の知識ソースは必要ありません (知識は高価であるか、非構造化データから抽出するのが難しい場合があります)。

- 分布外の堅牢性。これは、モデルを微調整するときに解決する必要がある問題です。大規模なモデルは、同一に分散された場合には以前の方法よりもパフォーマンスが劣りますが、非同一に分散された場合にはより良好に一般化されます。

- 率直に言って、よくわかりません。

- #類似点は、コンテキスト学習にはトレーニング データなどのサンプルも必要であることです。

- 違いは、コンテキスト学習の汎化動作が教師あり学習とは異なることです。 、これにより、以前の一般化理論 (Rademancher Complexity や Neural Tangent Kernel など) が適用できなくなります。

- プロンプトワードと微調整の間のほとんどの比較では、大規模なプロンプトワードモデルと微調整された小さなモデルのみを比較しますが、公正な比較は大規模なプロンプトワードモデルと微調整されたモデルである必要があります。 -tunedラージモデルと比較する際のベースモデルは同じである必要があります。したがって、元の ThoughtChain の記事では、Wei らが、キューワードが微調整よりも優れていることを示したければ、GPT3 ではなく、微調整された PaLM を比較する必要がありました。

- 私の仮説は次のとおりです:

- 微調整によりディストリビューション内ではパフォーマンスが向上しますが、ディストリビューション外では堅牢性が損なわれます。プロンプト ワードは、分散変換シナリオではパフォーマンスが向上しますが、同じ分散シナリオでの微調整ほど良くはありません。 #仮説が正しい場合、調査する価値のある問題は、状況に応じた学習機能を犠牲にすることなく微調整する方法です。

- 分布外微調整の効果はモデルのサイズによっても変化することに注意してください 。たとえば、2022 年の Yang らの研究では、4 番目の表は、Bart ベースの分布外汎化能力は低下するが、Bart-large は向上することを示しています。大規模なモデルの場合、テスト セットの分布がトレーニング セットとそれほど変わらない場合、分布内の微調整効果も改善されるはずです。

- 上記のロジックを確認してみましょう: 微調整が優れている場合は、パラメータを効率的に最適化する方法を熱心に研究する必要があります。プロンプトの言葉が優れている場合は、より優れた大規模言語モデルをトレーニングします。

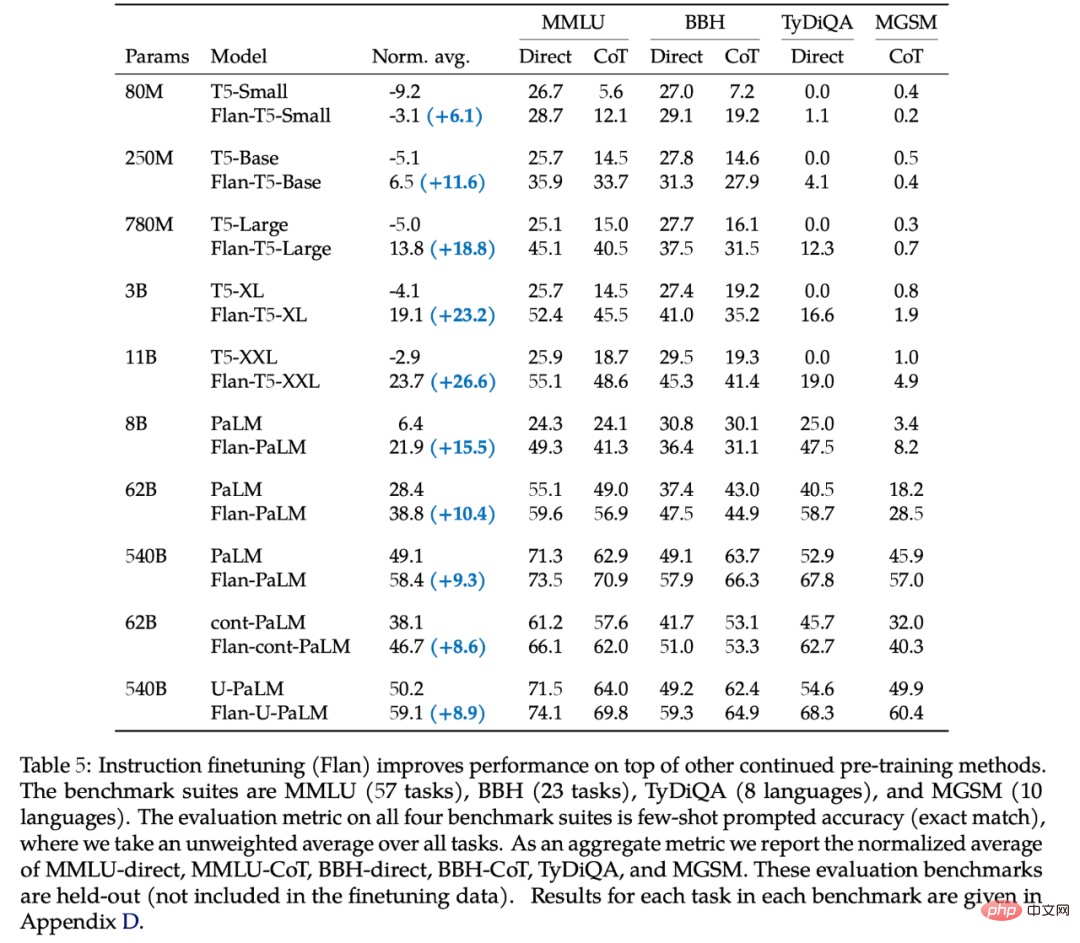

- #62B この数値は、Chung らの 2022 年

- [31] の研究の 5 番目の表から来ています:

- 上記の 2 つのモデルに加えて、オリジナルの GPT3、text-davinci-001、およびその他の小規模な GPT-3 モデルを含む他の GPT3 モデルは思考連鎖を行うことができません。

- 「思考連鎖ができる」という場合、思考連鎖メソッドを使用した方が、プロンプトワードを直接使用して T5-11B を微調整するよりも効果が高いことを意味します。

- code-davinci-002 は、言語 タスク -002 において常に

- [34] text-davinci よりも優れていることにも注意してください。この観察は非常に興味深く、興味深いものです。これは、コード データでトレーニングされた言語モデル が、言語でトレーニングされた言語モデル よりも優れたパフォーマンスを発揮できることを示しています。今のところその理由はわかっていません。 PaLM、U-PaLM、Flan-PaLM、Minervaを含むPaLMシリーズのモデル。これらのモデルはまだ一般公開されていません (@Google はこちら、近々オープンソース化します)。

- なぜ創発的な能力が存在するのかはまだ不明ですが、私たちは創発的な能力を生み出す可能性のある要因を発見しました:

- [36][37]の命令の微調整により効果も向上しました。 コードの微調整: Codex code-davinci-002 はコードを微調整しており、その効果は text-davinci-002 よりも一貫して優れています。 PaLM のコードも微調整されています。表面的には、コードは言語とほとんど関係がありませんが、大きな役割を果たしているようです。これについては後の記事で説明します。

- 思考連鎖による微調整: text-davinci-002 がリリースされたとき、Google は PaLM を 3 か月間リリースしていました。したがって、OpenAI は思考の連鎖に関連した取り組みを行っているはずです。また、思考連鎖データを直接微調整に使用することでモデルの思考連鎖能力を刺激できることを示す作品##[38]もいくつかあります。

- ただし、これらの要素はすべて、現段階では推測の域を出ません。新たな機能を生み出すためにモデルをトレーニングする方法を明らかにすることは非常に意味があり、詳しい議論は

- 微調整と状況に応じた学習の効果を公平に比較できますか?

- 大規模なモデルをトレーニングして、モデルに創発的な機能や思考連鎖機能を持たせるにはどうすればよいでしょうか?

#複雑な推論

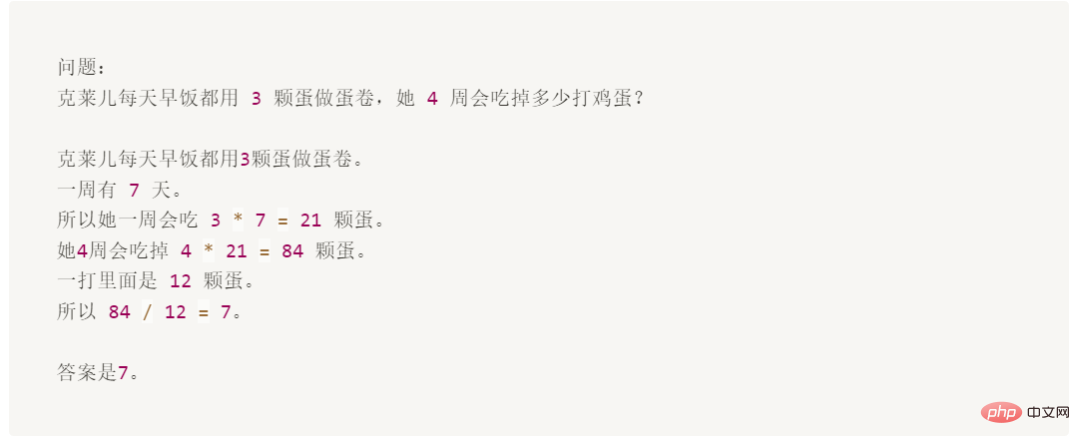

次に、プロンプト ワードの使用が微調整を大幅に超える GSM8K データ セットの例を示します。

#この質問は 10 歳児にとっては簡単ですが、主に数学と言語が混在しているため、言語モデルにとっては困難です。

#この質問は 10 歳児にとっては簡単ですが、主に数学と言語が混在しているため、言語モデルにとっては困難です。

GSM8K は、もともと 2021 年 10 月

[10]に OpenAI によって提案されました。当時、彼らは [11]GPT3 の最初のバージョンを使用して、トレーニング セット全体を約 35% の精度で微調整していました。この結果は、言語モデルのスケーリング則を示しているため、著者らはこの結果を非常に悲観的にしています。つまり、モデルのサイズが指数関数的に増加すると、パフォーマンスは直線的に増加します (これについては後で説明します)。したがって、彼らはセクション 4.1 で次のように考えています: 「175B モデルでは、80% の解決策を達成するには、少なくとも

さらに 2 桁規模の追加のトレーニング データが必要であると思われます」 rate." 3 か月後の 2022 年 1 月、Wei らは [12]

540BPaLM モデルに基づいて、は 8 つの思考連鎖のみを使用しました。この例では、精度が 56.6% に向上しました (トレーニング セットを 2 桁増やすことなく)。 2022 年 3 月後半、Wang et al.[13] は、同じ 540B PaLM モデルに基づいて、多数決法を通じて精度を 74.4% に向上させました。現在の SOTA は、AI2 に関する私自身の研究 (Fu et. al. Nov 2022[14]) から来ており、複雑な思考連鎖を使用することで 175B Codex で 82.9% の精度を達成しました。上記の進歩からわかるように、技術の進歩は確かに指数関数的に成長しています。 思考チェーン プロンプトは、スケールに応じたモデルの創発的な機能を示す典型的な例です:

創発から能力

- を見てみましょう: モデルが 100B より大きい場合にのみ、思考チェーンの効果が唯一の回答プロンプトより大きくなる可能性があります。したがって、この機能は大規模モデルにのみ存在します。

[17]、さらには国際数学オリンピックの問題[ 18] 。今は涼しいですか? #知識推論

次の例は、知識を必要とする推論スキル (質疑応答や常識など) です。推論)。この場合、大きなモデルをプロンプトすることは、小さなモデルを微調整するよりも必ずしも優れているわけではありません (どちらのモデルがより優れているかはまだわかりません)。ただし、この場合のアノテーション効率は次の理由により増幅されます。

#多くのデータセットでは、必要な背景/常識知識を取得するために、(以前は小さかった) モデル##[19] を取得するには外部のコーパス/ナレッジ グラフが必要です。または、マルチタスク学習による強化された

#[20]- データのトレーニングが必要です

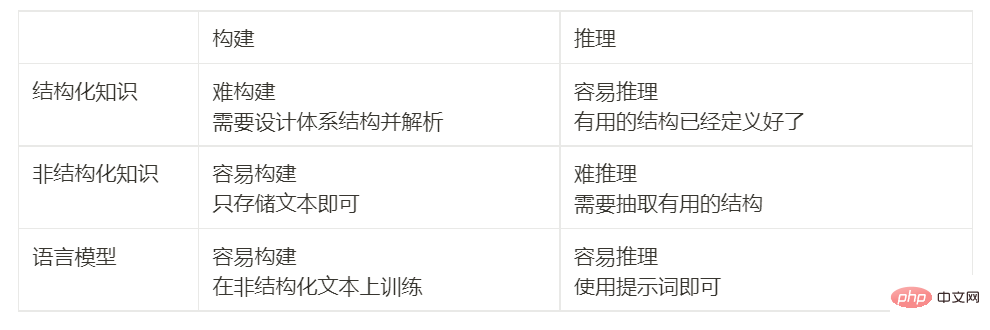

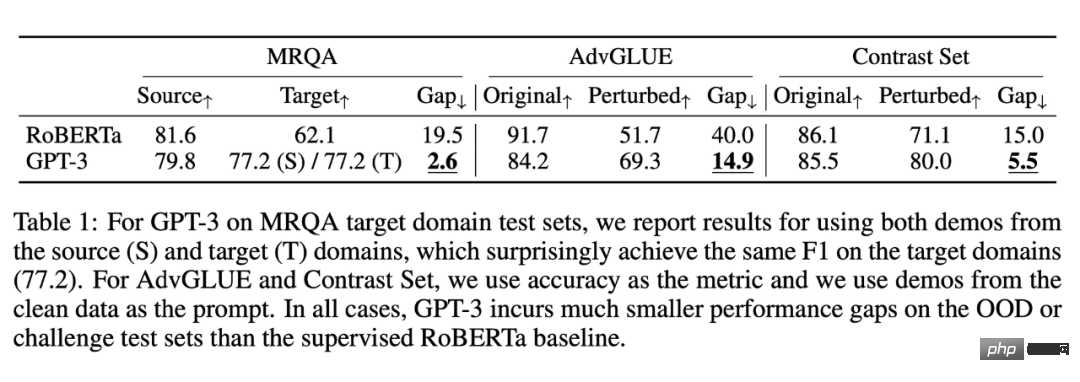

#表に示すように、数学の問題の例とは異なり、GPT-3 は以前の微調整モデルを大幅に上回るパフォーマンスはありません。ただし、外部ドキュメントから取得する必要はなく、それ自体に知識が含まれています[23]。 これらの結果の重要性を理解するために、歴史を振り返ることができます。NLP コミュニティは、最初から 知識を効果的にエンコードする方法 という課題に直面してきました。人々はモデルの外部または内部に知識を保存する方法を常に模索しています。 1990年代以来、人々は言語と世界の規則を巨大なライブラリに記録し、モデルの外側に知識を保存しようと試みてきました。しかし、これは非常に難しく、結局のところ、すべてのルールを網羅することはできません。したがって、研究者は、非構造化テキスト、半構造化 (Wikipedia など)、または完全構造化 (ナレッジ グラフなど) の形式で知識を保存するために、ドメイン固有の知識ベースを構築し始めました。一般に、構造化知識は構築が困難です (知識の構造システムを設計する必要があるため) しかし推論は簡単です (アーキテクチャのため)、非構造化知識は構築は簡単です (直接保存するだけ)、 ですが、推論に使用するのは困難です (アーキテクチャがありません)。ただし、言語モデルは、事前定義されたパターンを必要とせずに、非構造化テキストから知識を簡単に抽出し、その知識に基づいて効率的に推論するための新しい方法を提供します。次の表では、利点と欠点を比較しています。 #配布外の堅牢性 # # 説明する 3 番目の機能は、配布外の堅牢性です。 2018 年から 2022 年にかけて、NLP、CV、一般的な機械学習の分野で、分布シフト/敵対的堅牢性/組み合わせ生成に関する研究が数多く行われ、テストセットの分布がトレーニング分布と異なる場合、行動のモデルのパフォーマンスが大幅に低下する可能性があります。ただし、これは大規模な言語モデルのコンテキスト学習には当てはまらないようです。 2022 年の Si らの調査 #[24] では次のことが示されています: #データは Si らからのものGPT-3 は、同一分散設定では RoBERTa よりも劣りますが、非同一分散設定では RoBERTa よりも優れており、パフォーマンスの低下は大幅に小さくなります。 さらに、たとえ分布の変化があったとしても、優れたプロンプトワードによってもたらされる汎化パフォーマンスは依然として維持されます。例:

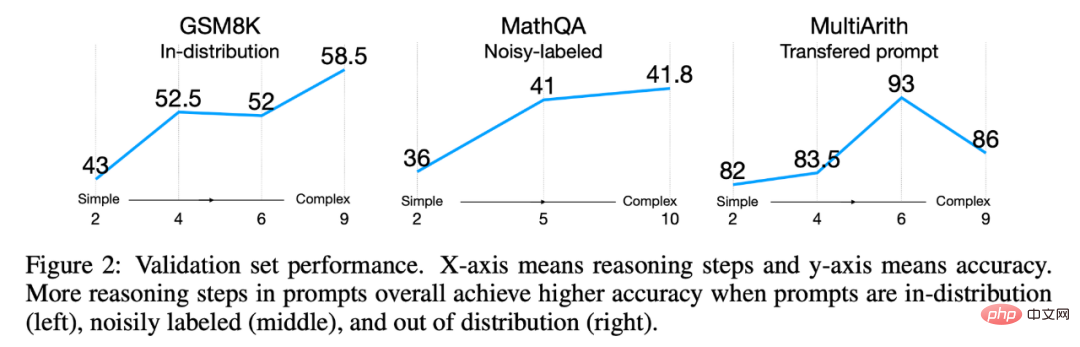

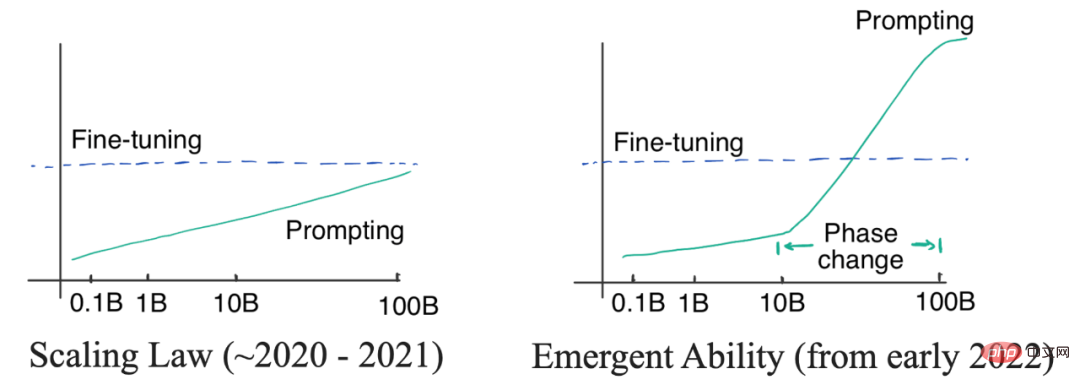

写真は Fu et. al. 2022 からのものです。テスト分布がトレーニング分布と異なる場合でも、単純なキューよりも複雑なキューの方が常に優れています。 [25] では、入力プロンプトが複雑であればあるほど、モデルのパフォーマンスが向上することが示されました。この傾向は分布シフトの場合にも続きました。テスト分布が元の分布と異なるか、ノイズ分布から来たものであるか、または別の分布から転送されたものであるかにかかわらず、複雑なキューは常に単純なキューよりも優れたパフォーマンスを示しました。 これまでのまとめ 上記の利点を考慮すると、大規模な言語モデルは確かに非常に優れていると考え始めるかもしれません。良い。さらに議論する前に、これまでの研究を振り返ってみましょう。非常に奇妙な質問が見つかります。GPT-3 は 2020 年にリリースされましたが、なぜ今までパラダイム シフトを発見して考え始めなかったのでしょうか ? この質問に対する答えは、対数直線曲線と位相変化曲線の 2 種類の曲線にあります。以下に示すように: #左の図: 比例の法則。モデルのサイズが指数関数的に増加すると、対応するモデルのパフォーマンスも直線的に増加します。右: モデルのサイズが一定の規模に達すると、新たな機能が出現し、パフォーマンスが大幅に向上します。 当初、(OpenAI) 研究者たちは、言語モデルのパフォーマンスとモデル サイズの関係は対数線形曲線、つまりモデルによって予測できると考えていました。サイズが指数関数的に増加すると、パフォーマンスは直線的に増加します。この現象は、Kaplan らの元の 2020 GPT3 記事で説明されているように、言語モデルのスケーリング則として知られています。重要なのは、その段階では、最大の GPT-3 であっても、ヒントを使用した小型モデルの微調整を上回るパフォーマンスを発揮できなかったことです。そのため、当時は高価で大きなモデルを使用する必要はありませんでした (プロンプトワードのラベル付けは非常に効率的でしたが)。 2021 年までに、Cobbe et al[28] は、スケーリング則が微調整にも適用されることを発見しました。これはやや悲観的な結果です。なぜなら、 モデル サイズにロックされる可能性がある - モデル アーキテクチャの最適化によってモデルのパフォーマンスがある程度向上する可能性がありますが、 効果は依然としてある範囲内にロックされることを意味するからです (モデルのサイズに応じて)、これより大きなブレークスルーを実現することは困難です。 スケーリング則の制御下(2020年から2021年)では、GPT-3はT5-11Bの微調整を上回る性能は得られず、T5-11Bの微調整はすでに非常に面倒であるため、 NLP コミュニティは、より小規模なモデルや効率的なパラメータ適応の研究に重点を置いています。プレフィックス チューニング #[29] は、プロンプトと適応の間のクロスオーバーの例であり、後に He らによって 2021 年に [30] 微調整効果が優れている場合は、パラメータの効率的な適応にさらに取り組む必要があり、プロンプト ワード方式の方が優れている場合は、大規模な言語モデルのトレーニングにより多くのエネルギーを投資する必要があります。 2022 年 1 月後半、Thought Chain の作品がリリースされました。著者らが示しているように、思考連鎖の手がかりは、パフォーマンス比例曲線において明確な 相転移を示しています。モデルのサイズが十分に大きい場合、パフォーマンスは大幅に向上し、明らかにスケーリング曲線を超えます。 プロンプトに思考チェーンを使用する場合、大規模モデルは複雑な推論で微調整するよりも大幅に優れたパフォーマンスを発揮し、知識推論で競争力を発揮し、堅牢に分散される可能性もあります。このような効果を達成するのに必要な例は約 8 つだけであり、それがパラダイムが変化する理由です (注: この記事は ChatGPT がオンラインになる 1 か月前に完成しました。ChatGPT がオンラインになった後、分野全体が衝撃を受け、パラダイムがシフトしたことに気づきました) )。 4. パラダイムシフトとは何を意味しますか? パラダイムシフトとは実際には何を意味するのでしょうか?以下に、微調整方法とプロンプトワード方法の比較を示します。 プロンプト ワードの利点は明白です。面倒なデータの注釈や全量データの微調整はもう必要ありません。必要なのはプロンプト ワードを記述して、要件を満たす結果を取得することだけです。微調整よりも高速です。 もう 2 つの注意すべき点は次のとおりです: 文脈学習は教師あり学習ですか? #文脈学習は教師あり学習よりも本当に優れているのでしょうか? したがって、大規模な言語モデルには大きな可能性があると信じていますが、 5. モデルの大きさはどれくらいにすべきでしょうか? 2 つの番号: 62B と 175B。 思考連鎖の効果が標準のプロンプトワード方式よりも大きくなるように、モデルには少なくとも 62B が必要です。 #62B 未満のすべてのモデルでは、思考連鎖よりもプロンプト ワードを直接使用する方が優れています。 [32] ただし、OPT、BLOOM、GPT-3 の最初のバージョンなど、思考チェーンの下ではパフォーマンスがはるかに悪く、思考チェーンを学習することさえできない大規模なモデルもあります。サイズはどちらも175Bです。これで次の質問になります。 サイズは必要な要素ではありますが、十分な要素ではありません。一部のモデルは十分な大きさがありますが (OPT や BLOOM、どちらも 175B など)、思考連鎖を行うことはできません。 2 つのモデルがあります 思考連鎖を行うことができます: 命令の微調整: GPT-3 text-davinci-002 は、命令強化学習 に譲ります。 7. 結論 結論この記事では、言語モデルの創発的な能力について注意深く研究しました。私たちは、複雑な推論、知識推論、および配布外の堅牢性の重要性とその機会を強調します。創発機能は、スケーリングの法則を超越し、スケーリング曲線での相転移を示すことができるため、非常に魅力的です。私たちは、研究パラダイムが実際に微調整から文脈学習に移行するかどうかについて詳しく議論しましたが、分散内シナリオと分散外シナリオにおける微調整と文脈学習の効果はまだ残っているため、明確な答えはまだありません。比較する必要がある。最後に、創発的な機能を生み出す 3 つの潜在的な要因、つまり命令の微調整、コードの微調整、思考連鎖の微調整について説明します。提案や議論は大歓迎です。 さらに、まだ議論されていない 2 つの興味深い問題についても言及しました。 これら 2 つの質問については、次の記事の に従います での議論。

3. 創発的な能力は比例の法則を覆します

思考チェーンの効果が、微調整された小さなモデル (T5) の効果よりも大きくなるように、モデルは少なくとも 175B (GPT3 のサイズ) である必要があります。 11B)。

の研究では、著者は 175B InstructGPT および 175B Codex での思考チェーンの使用が 540B よりも優れていることを示しました。プロンプトワードを直接使用します。上記の結果を組み合わせると、63B と 175B という 2 つの数値が得られます。したがって、このゲームに参加したい場合は、まず平均よりも大きなサイズのモデルを用意する必要があります。

の研究では、著者は 175B InstructGPT および 175B Codex での思考チェーンの使用が 540B よりも優れていることを示しました。プロンプトワードを直接使用します。上記の結果を組み合わせると、63B と 175B という 2 つの数値が得られます。したがって、このゲームに参加したい場合は、まず平均よりも大きなサイズのモデルを用意する必要があります。 6. 要因は規模だけですか? #########いいえ。

これらは、公的にアクセス可能な強力な緊急機能を備えた唯一の 2 つのモデルです。

を使用した微調整の成果です。これ以前は、text-davinci-001 の思考連鎖に対する効果は良くありませんでした。同時に、PaLM

次の記事

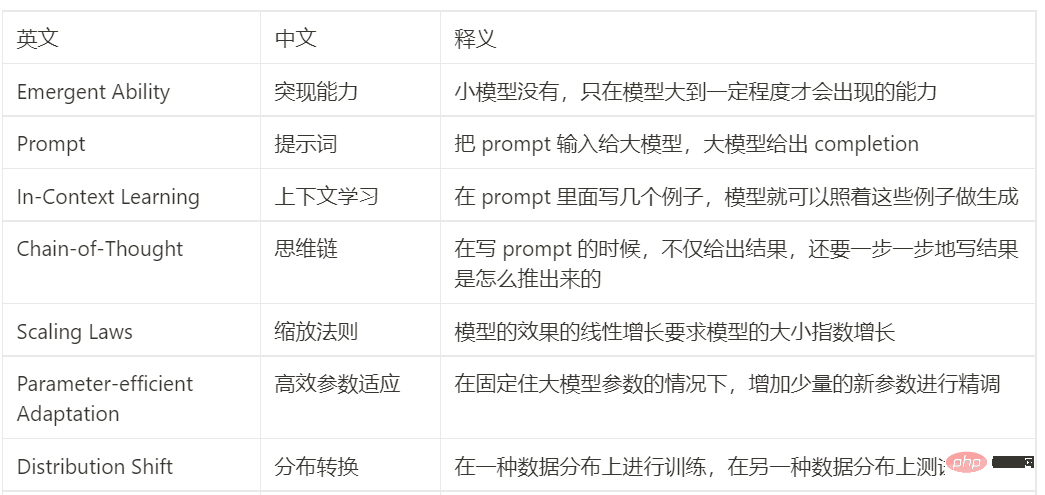

中国語と英語の比較表

以上が注目のトピックの解釈: 大規模モデルの新たな能力と ChatGPT によって引き起こされるパラダイムシフトの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。