ホームページ >テクノロジー周辺機器 >AI >AIGCの発展は速すぎる! Meta が初のテキストベースの 4D ビデオ シンセサイザーをリリース: 3D ゲーム モデラーも解雇されるのでしょうか?

AIGCの発展は速すぎる! Meta が初のテキストベースの 4D ビデオ シンセサイザーをリリース: 3D ゲーム モデラーも解雇されるのでしょうか?

- 王林転載

- 2023-04-08 11:21:15880ブラウズ

AI 生成モデルは、過去の期間で大きな進歩を遂げました。 画像分野に関する限り、ユーザーは自然言語プロンプト (DALL-E 2、安定拡散など) を入力することで画像を生成できます。 、時間次元で拡張して連続ビデオを生成したり (Phenaki など)、空間次元で拡張して 3D モデルを直接生成したり (Dreamfusion など) することもできます。

しかし、今のところ、これらのタスクはまだ孤立した研究状態にあり、相互に技術的に交差するものはありません。

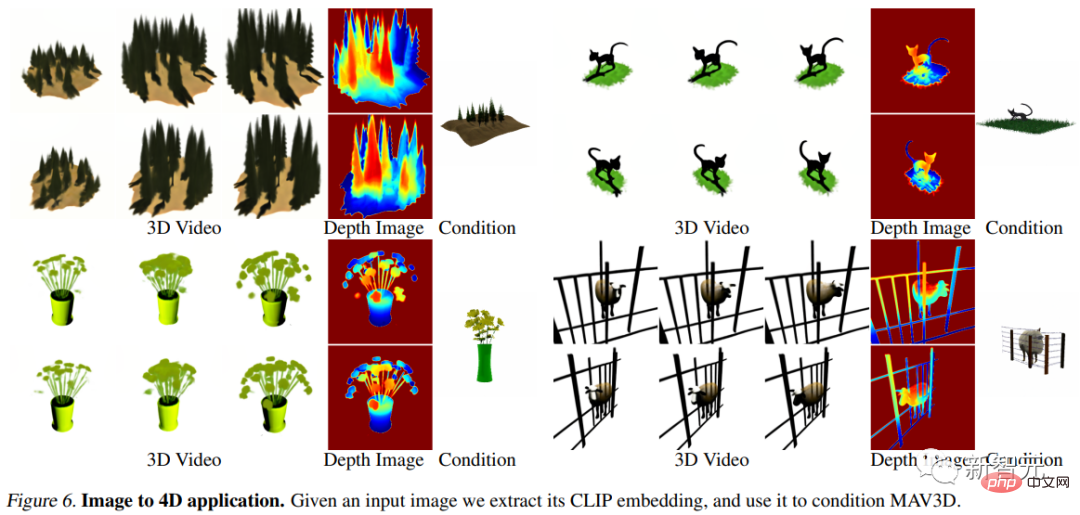

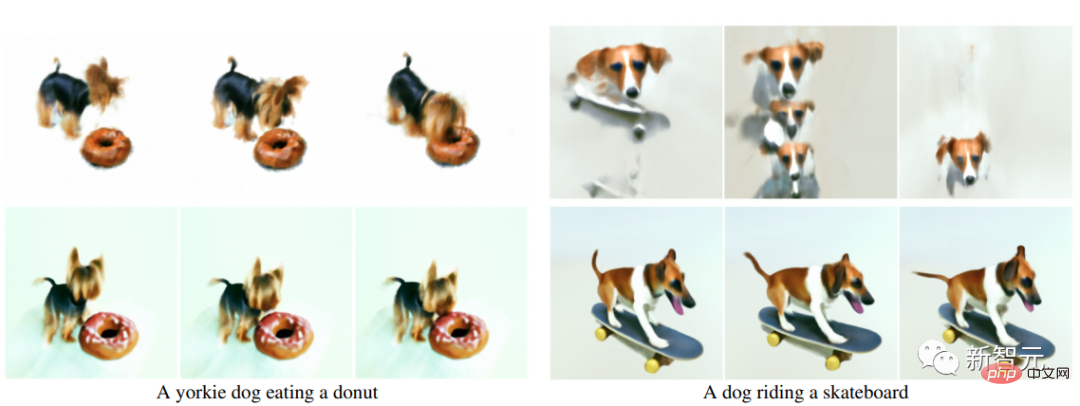

最近、メタ AI 研究者はビデオと 3D 生成モデルの利点を組み合わせ、新しい テキストから 4 次元 (3 次元時間) 生成システム MAV3D (MakeA) を提案しました。 -Video3D ) は、自然言語による記述を入力として受け取り、あらゆる視点からレンダリングできる動的な 3 次元シーン表現を出力します。

紙のリンク: https://arxiv.org/abs/2301.11280

プロジェクト リンク: https://make-a-video3d.github.io/

##MAV3D は、最初の を生成することもできます。与えられたテキスト記述に基づく 3 次元の動的シーンのモデル。

この論文で提案する方法は、4D 動的神経放射場 (NeRF) を使用して、テキストからビデオへの (T2V) 拡散をクエリすることで、シーン表現、密度、動きの一貫性を最適化します。ベースのモデルを使用すると、提供されたテキストから生成されたダイナミック ビデオ出力を任意のカメラ位置と角度から表示でき、任意の 3D 環境に合成できます。このメソッドは、ビデオ ゲーム、視覚効果、拡張現実や仮想現実用の 3D アセットを生成するために使用できます。

既製の 4D モデル コレクションはありません。

##ボール遊びをするコーギー

##ボール遊びをするコーギー

MAV3D のトレーニング 3D や 4D は必要ありませんデータを使用する場合、T2V モデルはテキストと画像のペアとラベルのないビデオでのみトレーニングする必要があります。

実験部分では、研究者らはこの方法の有効性を証明するために包括的な定量的および定性的な実験を実施し、以前に確立された内部ベースラインを大幅に改善しました。 4D ダイナミック シーンへのテキスト送信

トレーニング データが不足しているため、研究者はこのタスクを解決するためにいくつかのアイデアを考案しました。

1 つのアプローチは、事前トレーニングされた 2D ビデオ ジェネレーターを見つけて、生成されたビデオから 4D 再構成を抽出することです。ただし、ビデオから変形可能なオブジェクトの形状を再構成することは、依然として非常に困難な問題です。つまり、Non-Rigid Structure from Motion (NRSfM) です。

オブジェクトに対して複数の同時視点が与えられると、タスクがより簡単になります。実世界のデータではマルチカメラのセットアップはまれですが、研究者らは、既存のビデオ ジェネレーターがシーンの任意の視点モデルを暗黙的に生成すると考えています。

言い換えれば、ビデオ ジェネレーターは、変形可能なオブジェクトのジオメトリと測光を再構築するための「統計的」マルチカメラ セットアップとして使用できます。

MAV3D アルゴリズムは、動的神経放射場 (NeRF) を最適化し、入力テキストをビデオにデコードし、オブジェクトの周囲のランダムな視点をサンプリングすることでこれを実現します。

# ビデオ ジェネレーターを直接使用して動的 NeRF を最適化しても、満足のいく結果は得られませんでした。実装プロセス中に克服する必要がある問題がまだいくつかあります。 #1. 効果的でエンドツーエンドの学習可能な動的 3D シーン表現が必要です;

2. 現在、教師あり学習用のデータ ソースが必要ではないため、大規模 (テキスト、4D) ペアの大規模データセットを学習に利用できます;

3. 出力の解像度は、空間次元と時間次元の両方で拡張する必要があります。 4D 出力には大量のメモリと計算能力が必要です。

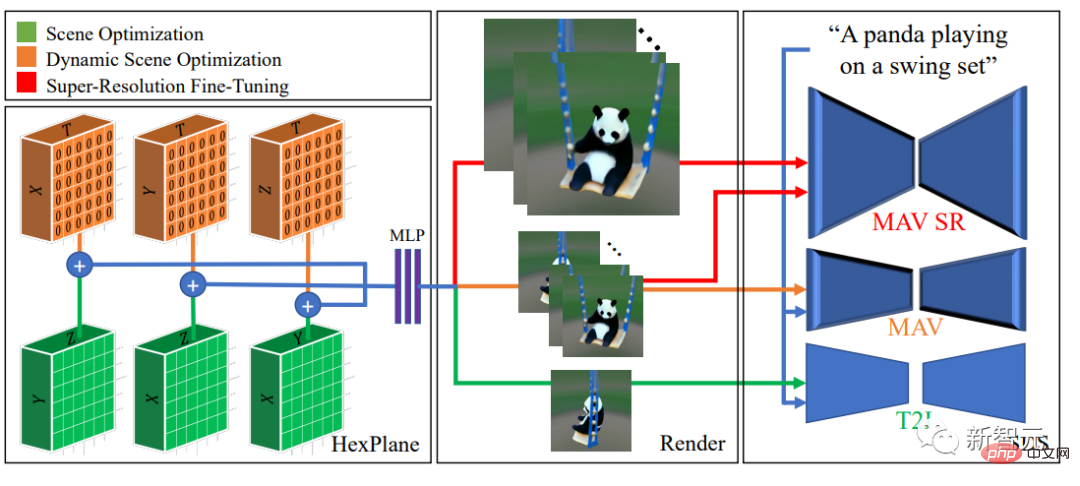

MAV3D モデル

MAV3D モデルは、神経放射場 (NeRF) に関する最新の研究に基づいており、その結果、効率的な (静的) NeRF と動的 NeRF が生成され、4D シーンが 6 つの多重解像度フィーチャー プレーンのセットとして表現されます。対応する (テキスト、4D) データなしでこの表現を監視するために、研究者らは、動的なシーン レンダリングのための多段階トレーニング パイプラインを提案し、高パフォーマンスを達成する上で各コンポーネントの重要性を実証しました。質の高い結果を。

重要な観察の 1 つは、Text-to-Video (T2V) モデルを使用して、スコア蒸留サンプリング (SDS) が直接使用されていることです。ダイナミクスを最適化する シナリオでは、視覚的なアーティファクトや次善の収束が発生する可能性があります。

そこで研究者らは、まずテキストから画像 (T2I) モデルを使用して静的な 3D シーンをテキスト プロンプトと照合し、次に 3D シーン モデルを動的に強化することにしました。

さらに、新しい時間認識 SDS 損失とモーション正則化項がモデルに導入されており、これらは現実的で挑戦的なモーションにとって重要であることが実験的に証明されています。

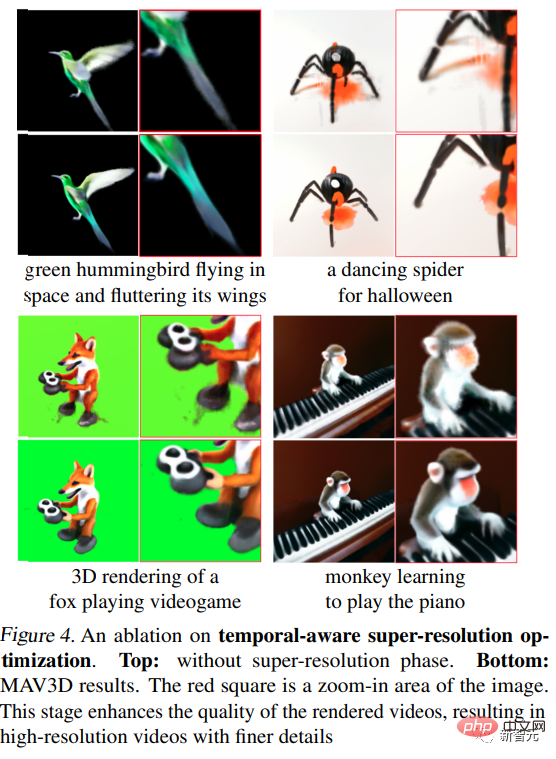

さらに、追加の時間認識超解像度微調整ステージを通じて、より高解像度の出力まで拡張されます。

最後に、T2V モデルの超解像度モジュールの SDS を使用して、3 次元シーン モデルの教師あり学習用の高解像度勾配情報を取得し、視覚的な忠実度を高めます。推論を有効にすると、プロセス中に高解像度の出力がサンプリングされます。

#実験部分評価指標

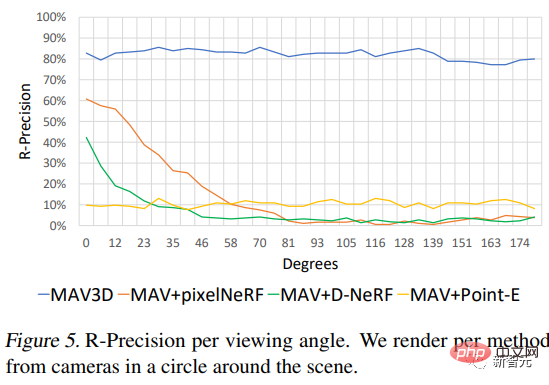

#CLIP R-Precision を使用して、生成されたビデオを評価します。テキストと生成されたシーンの間の一貫性を測定するために使用でき、レンダリングされたフレームからの入力キューの取得の精度を反映できます。研究者らは、CLIP の ViT-B/32 バリアントを使用して、さまざまなビューとタイム ステップでフレームを抽出しました。

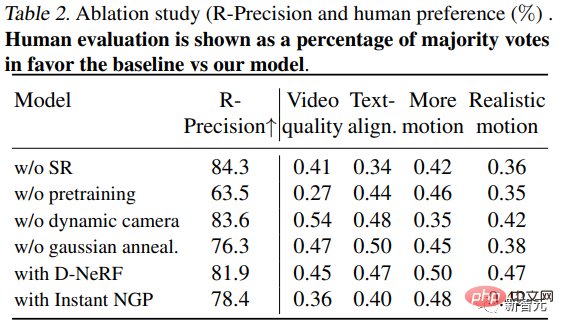

4 つの定性的指標の使用に加えて、(i) 生成された 2 つのビデオの好みをヒューマン アノテーターに尋ねることによって、ビデオの品質を導き出すことができます。(ii) テキストの忠実度(iii) 動きの量、および (iv) 動きの信頼性 。

#テキストと 4D の比較

テキストを変換する方法がなかったためそこで研究者らは、比較のために T2V 生成法に基づいた 3 つのベースラインを確立しました。2 次元フレームのシーケンスは、3 つの異なる方法を使用して 3 次元シーン表現のシーケンスに変換されます。 最初のシーケンスは、ワンショット ニューラル シーン レンダラー (Point-E) を通じて取得されます。2 番目は、pixelNeRF を各フレームに個別に適用することによって生成されます。3 番目は、D-NeRF を適用しています。 COLMAP を使用して抽出されたカメラ位置と結合されます。

この方法は、客観的な R 精度メトリックに関してベースライン モデルを上回っており、すべてのメトリックに関してヒューマン アノテーターによってより高く評価されていることがわかります。

#さらに、研究者らは、さまざまなカメラの視野角でのこの方法のパフォーマンスも調査しました。

アブレーション実験

1. ノーシーンスーパーMAV3D (ステージ 3) と同じステップ数で、解像度 (SR) 微調整 でトレーニングされたモデルの場合、ヒューマン アノテーターは、品質、テキストの配置、動きの点で SR でトレーニングされたモデルを選択する可能性が高くなります。モデル。

さらに、超解像度の微調整により、レンダリングされたビデオの品質が向上し、より詳細でノイズの少ない高解像度ビデオが作成されます。

2. 事前トレーニングなし: 動的シーンを直接最適化する手順 (静的シーンの事前トレーニングなし) は次のとおりです。 MAV3D と同じ 場合によっては、結果としてシーンの品質が大幅に低下したり、収束が低下したりします。ケースの 73% と 65% では、ビデオ品質とリアルな動きの観点から、スタティックで事前トレーニングされたモデルが好まれます。

###以上がAIGCの発展は速すぎる! Meta が初のテキストベースの 4D ビデオ シンセサイザーをリリース: 3D ゲーム モデラーも解雇されるのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。