自然言語処理タスクでは、大規模な言語モデルがゼロショット学習と少数ショット学習で素晴らしい結果を達成しました。ただし、すべてのモデルには固有の制限があり、多くの場合、さらなる拡張によって部分的にしか対処できません。具体的には、モデルの限界には、最新の情報にアクセスできないこと、事実の「情報幻覚」、低リソース言語を理解することの難しさ、正確な計算のための数学的スキルの欠如などが含まれます。

これらの問題を解決する簡単な方法は、モデルに検索エンジン、計算機、カレンダーなどの外部ツールを装備することです。ただし、既存の方法では、大規模な手動の注釈に依存したり、ツールの使用を特定のタスク設定に制限したりすることが多く、外部ツールと組み合わせた言語モデルの使用を一般化することが困難です。

このボトルネックを打破するために、Meta AI は最近、Toolformer と呼ばれる新しいメソッドを提案しました。これにより、言語モデルがさまざまな外部ツールの「使い方」を学習できるようになります。

論文アドレス: https://arxiv.org/pdf/2302.04761v1.pdf

Toolformer はすぐに大きな注目を集め、この論文が現在の大規模言語モデルの多くの問題を解決したと信じ、「これはここ数週間で最も重要な論文だ。論文」と称賛する人もいました。

Toolformer は自己教師あり学習を使用して、大規模な言語モデルがいくつかの API の使い方を学習できるようにしていると指摘する人もいます。非常に柔軟で効率的なツール:

Toolformer が私たちを一般的な人工知能から遠ざけてしまうと考える人さえいます ( AGI)また一歩近づいた。

- 大規模な言語モデルは、人間による広範な注釈を必要とせずに、自己教師付きの方法でツールの使用法を学習する必要があります。人間によるアノテーションのコストは高いため、これは重要ですが、さらに重要なのは、人間が有用だと考えるものは、モデルが有用だと考えるものと異なる可能性があることです。

- 言語モデルでは、特定のタスクに限定されないツールをより包括的に使用する必要があります。

- #これにより、上記のボトルネックが明らかに解消されます。 Toolformer の手法と実験結果を詳しく見てみましょう。

方法

Toolformer は、コンテキスト内学習 (ICL) を備えた大規模な言語モデルに基づいてデータセットを最初から生成します (Schick and Schütze、2021b; Honovich et al. 、2022; Wang et al.、2022) のアイデア: API を使用する人間のサンプルをいくつか挙げるだけで、LM に潜在的な API 呼び出しを含む巨大な言語モデリング データセットに注釈を付けさせ、その後、自己教師あり損失関数を使用して次のことを決定できます。どの API 呼び出しが実際にモデルが将来のトークンを予測するのに役立つか、そして最終的には LM 自体に役立つ API 呼び出しに基づいて微調整します。

Toolformer は使用されるデータセットに依存しないため、モデルが事前トレーニングされたのとまったく同じデータセットで使用できます。これにより、モデルの一般性が失われず、言語モデリング機能。

具体的には、この研究の目標は、言語モデル M に API 呼び出しを通じてさまざまなツールを使用できる機能を装備することです。これには、各 API の入力と出力が一連のテキストとして特徴付けられることが必要です。これにより、各呼び出しの開始と終了をマークするために特別なトークンを使用して、API 呼び出しを任意のテキストにシームレスに挿入できるようになります。

調査では、各 API 呼び出しをタプルとして表します

、ここで、a_c は API の名前、i_c は対応する入力です。 API 呼び出し c と対応する結果 r が与えられた場合、この研究では、その結果を除外および含む API 呼び出しの線形化シーケンスを次のように表します。

このうち、

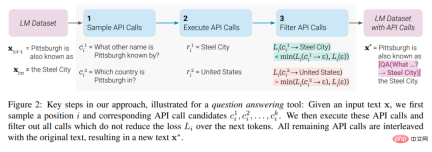

#指定されたデータセット

、調査ではまず、API 呼び出しを追加して、このデータ セットをデータ セット C* に変換しました。これは、以下の図 2 に示すように 3 つのステップで行われます。まず、この研究では M のコンテキスト内学習機能を活用して、多数の潜在的な API 呼び出しをサンプリングし、次にこれらの API 呼び出しを実行して、得られた応答が予測に役立つかどうかを確認します。フィルタリング基準として使用される将来のトークン。フィルタリング後、研究では API 呼び出しをさまざまなツールにマージし、最終的にデータセット C* を生成し、このデータセット上で M 自体を微調整します。

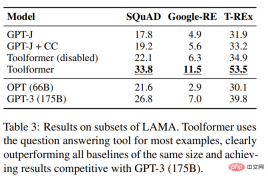

研究は、さまざまな下流タスクについて実施されました。実験結果は次のことを示しています: 6.7B パラメーターで事前トレーニングされた GPT-J モデル (さまざまな API とツールの使用を学習した) に基づく Toolformer は、さまざまなタスクにおいて、より大きな GPT-3 モデルや他のいくつかのベースラインよりも大幅に優れたパフォーマンスを発揮します。

この研究では、LAMA ベンチマークの SQuAD、GoogleRE、および T-REx サブセットに関するいくつかのモデルを評価しました。実験結果を以下の表 3 に示します。

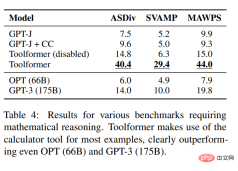

#Toolformer の数学的推論機能をテストするために、この研究では ASDiv、SVAMP、および MAWPS ベンチマークで実験を実施しました。実験によると、Toolformer はほとんどの場合に計算ツールを使用しており、OPT (66B) や GPT-3 (175B) よりも大幅に優れています。

#Toolformer の数学的推論機能をテストするために、この研究では ASDiv、SVAMP、および MAWPS ベンチマークで実験を実施しました。実験によると、Toolformer はほとんどの場合に計算ツールを使用しており、OPT (66B) や GPT-3 (175B) よりも大幅に優れています。

#質問応答の観点から、この研究では 3 つの質問応答データ セット (Web 質問、自然な質問、およびトリビアQA 。 Toolformer は、同じサイズのベースライン モデルよりも大幅に優れたパフォーマンスを発揮しますが、GPT-3 (175B) には劣ります。

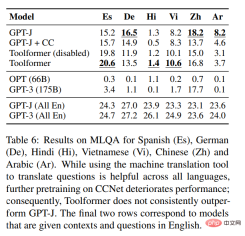

言語をまたいだタスクに関して、この調査では Toolformer と MLQA のすべてのベースライン モデルを比較しました。結果は次のとおりです。表 6 に示すように、

##カレンダー API の有効性を調査するために、調査は次のように行われました。 TEMPLAMA と DATESET と呼ばれる新しい API 実験は、データセット上のいくつかのモデルで実施されました。 Toolformer はすべてのベースラインを上回っていますが、TEMPLAMA カレンダー ツールは使用しません。

この研究では、さまざまなダウンストリーム タスクのパフォーマンス向上を検証することに加えて、Toolformer の言語モデリングのパフォーマンスが API 呼び出しの微調整によって低下しないことを確認したいと考えています。この目的を達成するために、この研究では 2 つの言語モデリング データセットで実験を行って評価します。モデルの複雑度は以下の表 8 に示されています。

API 呼び出しを行わない言語モデリングの場合、API 呼び出しを追加するコストはかかりません。

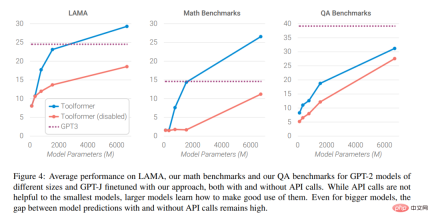

最後に、研究者らは、外部ツールに助けを求める機能が、言語のサイズに応じてモデルにどのような影響を与えるかを分析しました。パフォーマンスの影響、分析結果を以下の図 4 に示します

興味のある読者は原文を読むことができます詳細については、論文を参照してください。詳細を調べてください。

以上が言語モデルは独自に検索エンジンの使い方を学習しましたか?メタAIがAPI呼び出し自己教師あり学習手法を提案 Toolformerの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

Gemma Scope:AI'の思考プロセスを覗くためのGoogle'の顕微鏡Apr 17, 2025 am 11:55 AM

Gemma Scope:AI'の思考プロセスを覗くためのGoogle'の顕微鏡Apr 17, 2025 am 11:55 AMジェマの範囲で言語モデルの内部の仕組みを探る AI言語モデルの複雑さを理解することは、重要な課題です。 包括的なツールキットであるGemma ScopeのGoogleのリリースは、研究者に掘り下げる強力な方法を提供します

ビジネスインテリジェンスアナリストは誰で、どのようになるか?Apr 17, 2025 am 11:44 AM

ビジネスインテリジェンスアナリストは誰で、どのようになるか?Apr 17, 2025 am 11:44 AMビジネスの成功のロック解除:ビジネスインテリジェンスアナリストになるためのガイド 生データを組織の成長を促進する実用的な洞察に変換することを想像してください。 これはビジネスインテリジェンス(BI)アナリストの力です - GUにおける重要な役割

SQLに列を追加する方法は? - 分析VidhyaApr 17, 2025 am 11:43 AM

SQLに列を追加する方法は? - 分析VidhyaApr 17, 2025 am 11:43 AMSQLの変更テーブルステートメント:データベースに列を動的に追加する データ管理では、SQLの適応性が重要です。 その場でデータベース構造を調整する必要がありますか? Alter Tableステートメントはあなたの解決策です。このガイドの詳細は、コルを追加します

ビジネスアナリストとデータアナリストApr 17, 2025 am 11:38 AM

ビジネスアナリストとデータアナリストApr 17, 2025 am 11:38 AM導入 2人の専門家が重要なプロジェクトで協力している賑やかなオフィスを想像してください。 ビジネスアナリストは、会社の目標に焦点を当て、改善の分野を特定し、市場動向との戦略的整合を確保しています。 シム

ExcelのCountとCountaとは何ですか? - 分析VidhyaApr 17, 2025 am 11:34 AM

ExcelのCountとCountaとは何ですか? - 分析VidhyaApr 17, 2025 am 11:34 AMExcelデータカウントと分析:カウントとカウントの機能の詳細な説明 特に大規模なデータセットを使用する場合、Excelでは、正確なデータカウントと分析が重要です。 Excelは、これを達成するためにさまざまな機能を提供し、CountおよびCounta関数は、さまざまな条件下でセルの数をカウントするための重要なツールです。両方の機能はセルをカウントするために使用されますが、設計ターゲットは異なるデータ型をターゲットにしています。 CountおよびCounta機能の特定の詳細を掘り下げ、独自の機能と違いを強調し、データ分析に適用する方法を学びましょう。 キーポイントの概要 カウントとcouを理解します

ChromeはAIと一緒にここにいます:毎日何か新しいことを体験してください!!Apr 17, 2025 am 11:29 AM

ChromeはAIと一緒にここにいます:毎日何か新しいことを体験してください!!Apr 17, 2025 am 11:29 AMGoogle Chrome'sAI Revolution:パーソナライズされた効率的なブラウジングエクスペリエンス 人工知能(AI)は私たちの日常生活を急速に変換しており、Google ChromeはWebブラウジングアリーナで料金をリードしています。 この記事では、興奮を探ります

ai' s Human Side:Wellbeing and the Quadruple bottuntApr 17, 2025 am 11:28 AM

ai' s Human Side:Wellbeing and the Quadruple bottuntApr 17, 2025 am 11:28 AMインパクトの再考:四重材のボトムライン 長い間、会話はAIの影響の狭い見方に支配されており、主に利益の最終ラインに焦点を当てています。ただし、より全体的なアプローチは、BUの相互接続性を認識しています

5ゲームを変える量子コンピューティングの使用ケースあなたが知っておくべきであるApr 17, 2025 am 11:24 AM

5ゲームを変える量子コンピューティングの使用ケースあなたが知っておくべきであるApr 17, 2025 am 11:24 AM物事はその点に向かって着実に動いています。量子サービスプロバイダーとスタートアップに投資する投資は、業界がその重要性を理解していることを示しています。そして、その価値を示すために、現実世界のユースケースの数が増えています

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

SecLists

SecLists は、セキュリティ テスターの究極の相棒です。これは、セキュリティ評価中に頻繁に使用されるさまざまな種類のリストを 1 か所にまとめたものです。 SecLists は、セキュリティ テスターが必要とする可能性のあるすべてのリストを便利に提供することで、セキュリティ テストをより効率的かつ生産的にするのに役立ちます。リストの種類には、ユーザー名、パスワード、URL、ファジング ペイロード、機密データ パターン、Web シェルなどが含まれます。テスターはこのリポジトリを新しいテスト マシンにプルするだけで、必要なあらゆる種類のリストにアクセスできるようになります。

SAP NetWeaver Server Adapter for Eclipse

Eclipse を SAP NetWeaver アプリケーション サーバーと統合します。

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません