ホームページ >テクノロジー周辺機器 >AI >大規模言語モデルのレビューを新たに公開: 20名以上の国内研究者による共著によるT5からGPT-4までの最も包括的なレビュー

大規模言語モデルのレビューを新たに公開: 20名以上の国内研究者による共著によるT5からGPT-4までの最も包括的なレビュー

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-07 21:21:011963ブラウズ

チューリング テストが 1950 年代に提案されて以来、人々は言語知能を処理する機械の能力を研究してきました。言語は本質的には人間の表現の複雑なシステムであり、文法規則によって管理されます。したがって、言語を理解して習得できる強力な AI アルゴリズムの開発には大きな課題があります。過去 20 年間、統計言語モデルやニューラル言語モデルなどの言語モデリング手法が言語の理解と生成に広く使用されてきました。

近年、研究者は大規模なコーパスで Transformer モデルを事前トレーニングすることで事前トレーニング済み言語モデル (PLM) を作成し、さまざまな NLP タスクを解決する上で大きな力を発揮しています。 。 能力。そして研究者らは、モデルのスケーリングによってパフォーマンスが向上する可能性があることを発見したため、モデルのサイズを増やすことによるスケーリングの効果をさらに研究しました。興味深いことに、パラメータのサイズが特定のレベルを超えると、このより大きな言語モデルは大幅なパフォーマンスの向上を達成し、コンテキスト学習などの小さなモデルには存在しない機能が出現します。 PLM と区別するために、このようなモデルは大規模言語モデル (LLM) と呼ばれます。

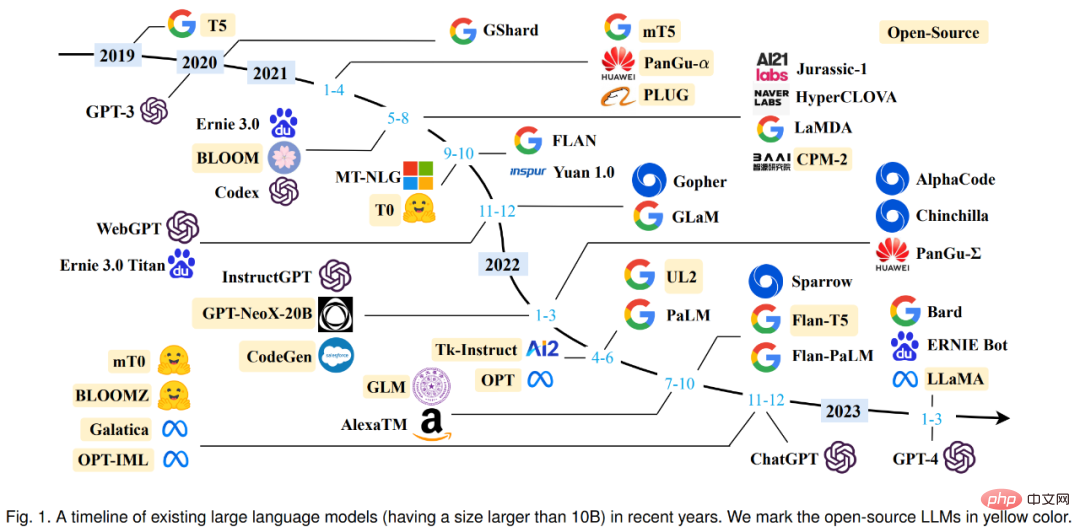

2019 年の Google T5 から OpenAI GPT シリーズに至るまで、パラメータ量が爆発的に増加する大規模なモデルが引き続き登場しています。 LLM に関する研究は産業界においても大きく進んでいると言え、特に昨年 11 月末に登場した大規模会話モデル ChatGPT は各界から大きな注目を集めています。 LLM の技術的進歩は AI コミュニティ全体に重要な影響を与え、人々が AI アルゴリズムを開発および使用する方法に革命をもたらします。

LLM の急速な技術進歩を考慮して、中国人民大学の 20 人以上の研究者が、LLM の最新の進歩を 3 つの側面からレビューしました。背景知識、重要な発見、主流技術、特にLLM の事前トレーニング、適応チューニング、使用法および機能評価に焦点を当てます。さらに、LLM に利用可能なリソースを要約して開発し、将来の開発の方向性やその他の問題について議論しました。このレビューは、この分野の研究者やエンジニアにとって非常に役立つ学習リソースです。

紙のリンク: https://arxiv.org/abs/2303.18223

本文に入る前に、まず 2019 年以降に登場したさまざまな大規模な言語モデル (100 億以上のパラメータ) のタイムラインを見てみましょう。その中で、黄色でマークされた大規模なモデルはオープンソースです。

最初のセクションでは、研究者が LLM の背景、機能、主要なテクノロジーについて詳しく紹介しました。

LLM の背景

通常、大規模言語モデル (LLM) とは、数千億 (または数千億) を含むモデルを指します。詳細) 大量のテキスト データでトレーニングされたマルチパラメーター言語モデル (モデル GPT-3、PaLM、Gaoptica、LLaMA など)。具体的には、LLM は Transformer アーキテクチャに基づいて構築されており、マルチヘッド アテンション レイヤーが非常に深いニューラル ネットワークに積み重ねられています。既存の LLM は主に、小規模な言語モデルと同様のモデル アーキテクチャ (つまり、Transformer) と事前トレーニング目標 (つまり、言語モデリング) を使用します。主な違いとして、LLM はモデル サイズ、事前トレーニング データ、および合計計算 (スケールアップ係数) を大幅にスケールします。自然言語をよりよく理解し、特定のコンテキスト (プロンプトなど) に基づいて高品質のテキストを生成できます。この容量の向上は、モデル サイズの大幅な増加にほぼ応じてパフォーマンスが向上するスケーリング則によって部分的に説明できます。ただし、スケーリング則によれば、一部の能力 (例: 文脈学習) は予測不可能であり、モデルのサイズが特定のレベルを超えた場合にのみ観察できます。

LLM の創発能力

LLM の創発能力は、正式には「次のような創発能力」と定義されています。 「小規模モデルには存在しますが、大規模モデルには存在できる」という機能は、LLM を以前の PLM と区別する最も重要な機能の 1 つです。この新しい機能が登場すると、注目すべき機能も導入されます。スケールが特定のレベルに達すると、パフォーマンスがランダムよりも大幅に高くなるということです。類推すると、この新しいモデルは物理学における相転移現象と密接に関連しています。原則として、この能力はいくつかの複雑なタスクに関連している可能性がありますが、人々は複数のタスクを解決するために適用できる一般的な能力にもっと関心を持っています。ここでは、LLM の 3 つの代表的な新しい機能を簡単に紹介します。

コンテキスト学習。 GPT-3 は、文脈学習機能を正式に導入します。言語モデルに自然言語命令と複数のタスクの説明が提供されていると仮定すると、追加のトレーニングや勾配を必要とせずに入力テキストの単語シーケンスを完成させることで、テスト インスタンスの期待される出力を生成できます。更新情報。

従うべき指示。自然言語記述 (つまり命令) でフォーマットされたマルチタスク データセットの混合を微調整することにより、LLM は命令の形式で記述された小さなタスクでも適切に実行します。この機能において、命令チューニングにより、明示的なサンプルを使用せずにタスク命令を理解することで LLM が新しいタスクを実行できるようになり、汎化機能が大幅に向上します。

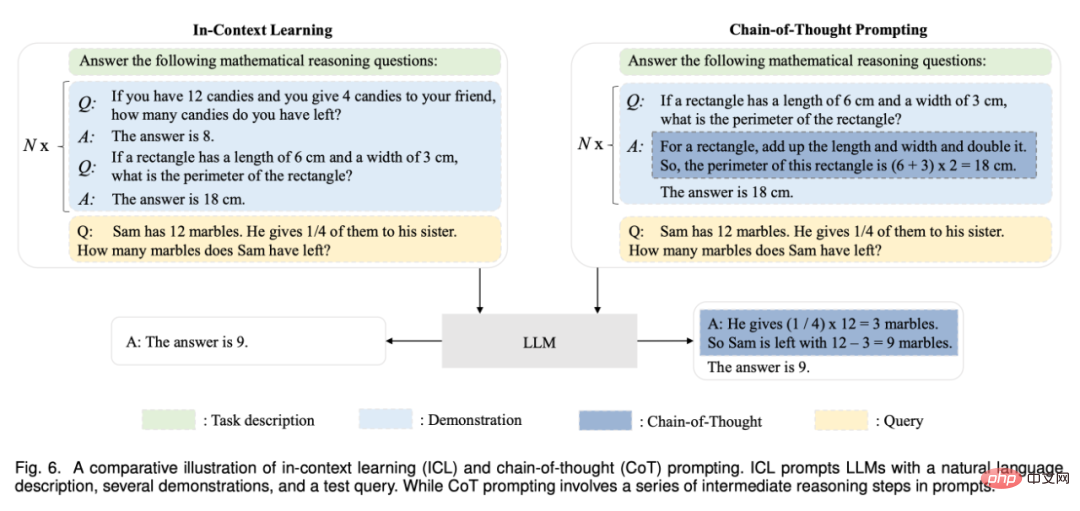

段階的な推論。小規模な言語モデルの場合、数学科目の文章問題など、複数の推論ステップを含む複雑なタスクを解決することが困難なことがよくあります。同時に、思考連鎖推論戦略を通じて、LLM は中間推論ステップを含むプロンプトメカニズムを利用することで、そのようなタスクを解決して最終的な答えに到達することができます。おそらく、この能力はコーディングのトレーニングによって獲得される可能性があります。

主要テクノロジー

スケーリング、トレーニング、能力刺激、アライメントなど、LLM の主要テクノロジーを見てみましょう。チューニング、ツールの活用など。 ############ズーム。スケーリングは、LLM のモデル容量を増加させるための重要な要素であり、当初、GPT-3 はモデル パラメーターを 1,750 億に増加させ、その後、PaLM はさらにモデル パラメーターを 5,400 億に増加させました。大規模なパラメータは、新しい機能にとって重要です。スケーリングはモデル サイズだけでなく、データ サイズや総計算量も関係します。 ############電車。規模が大きいため、強力な機能を持つ LLM を適切にトレーニングすることは非常に困難です。したがって、LLM のネットワーク パラメーターを学習するには、分散トレーニング アルゴリズムが必要であり、多くの場合、さまざまな並列戦略を組み合わせて使用します。分散トレーニングをサポートするには、DeepSpeed や Megatron-LM などの最適化フレームワークを使用して、並列アルゴリズムの実装と展開を容易にします。さらに、トレーニング損失スパイクや混合精度トレーニングの再開など、最適化手法はトレーニングの安定性とモデルのパフォーマンスにとって重要です。最近の GPT-4 は、はるかに小さなモデルを活用して大規模なモデルのパフォーマンスを予測するための特別なインフラストラクチャと最適化手法を開発しました。

能力の刺激。大規模なコーパスで事前トレーニングされた後、LLM には一般的なタスクを解決する潜在的な能力が与えられます。ただし、LLM が特定のタスクを実行するときに、これらの機能が明示的に実証されない場合があります。したがって、これらの能力を刺激するために、適切なタスクの指示や特定の状況に応じた戦略を設計することは非常に役立ちます。たとえば、思考連鎖プロンプトは、中間の推論ステップを通じて複雑な推論タスクを解決するのに役立ちます。さらに、自然言語タスク記述を使用して LLM 向けに命令をさらに調整して、目に見えないタスクへの一般化を向上させることができます。

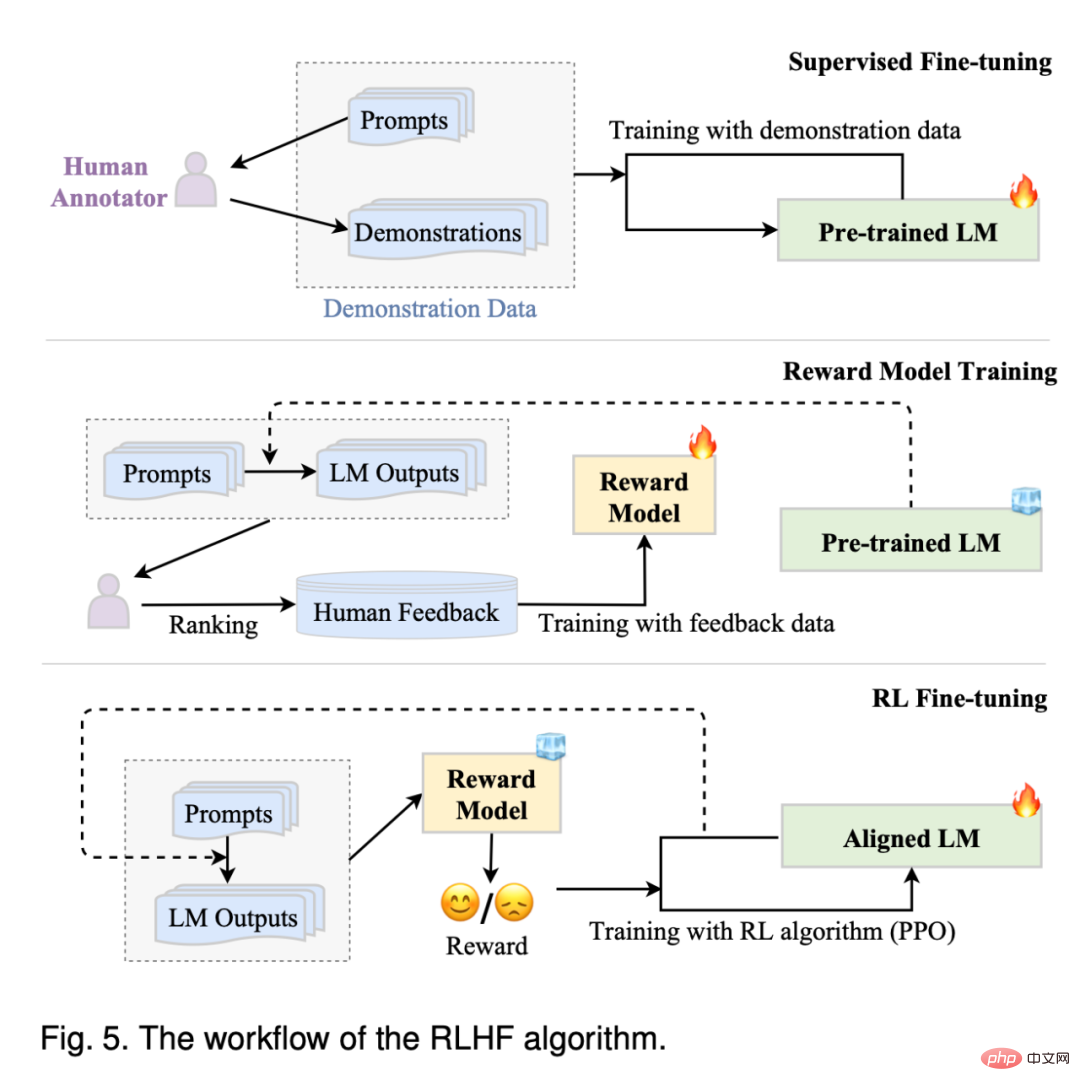

アライメント調整。 LLM は、事前にトレーニングされたコーパス (高品質データと低品質データを含む) のデータ特性をキャプチャするようにトレーニングされているため、有害で偏った有害なテキスト コンテンツを生成する可能性があります。 LLM を人間の価値観に合わせるために、InstructGPT は、LLM が期待される指示に従うことができるように、強化学習と人間のフィードバックを活用する効率的な調整方法を設計しました。 ChatGPT は InstructGPT と同様のテクノロジーに基づいて開発されており、高品質で無害な応答を生成する強力な調整機能を示します。

ツールの使用率。 LLM は本質的に、大規模なプレーン テキスト コーパスでトレーニングされたテキスト ジェネレーターであるため、テキストが適切に表現されていない数値計算などのタスクではあまりうまく機能しません。さらに、LLM の機能は事前トレーニング データによって制限され、最新の情報を取得できません。これらの問題に対応して、計算機を使用して正確な計算を実行したり、検索エンジンを使用して未知の情報を取得したりするなど、LLM の欠点を補う外部ツールの使用が提案されています。 ChatGPT は、外部プラグインを使用して新しい知識をオンラインで学習することもでき、このメカニズムにより LLM の機能を大幅に拡張できます。

LLM リソース

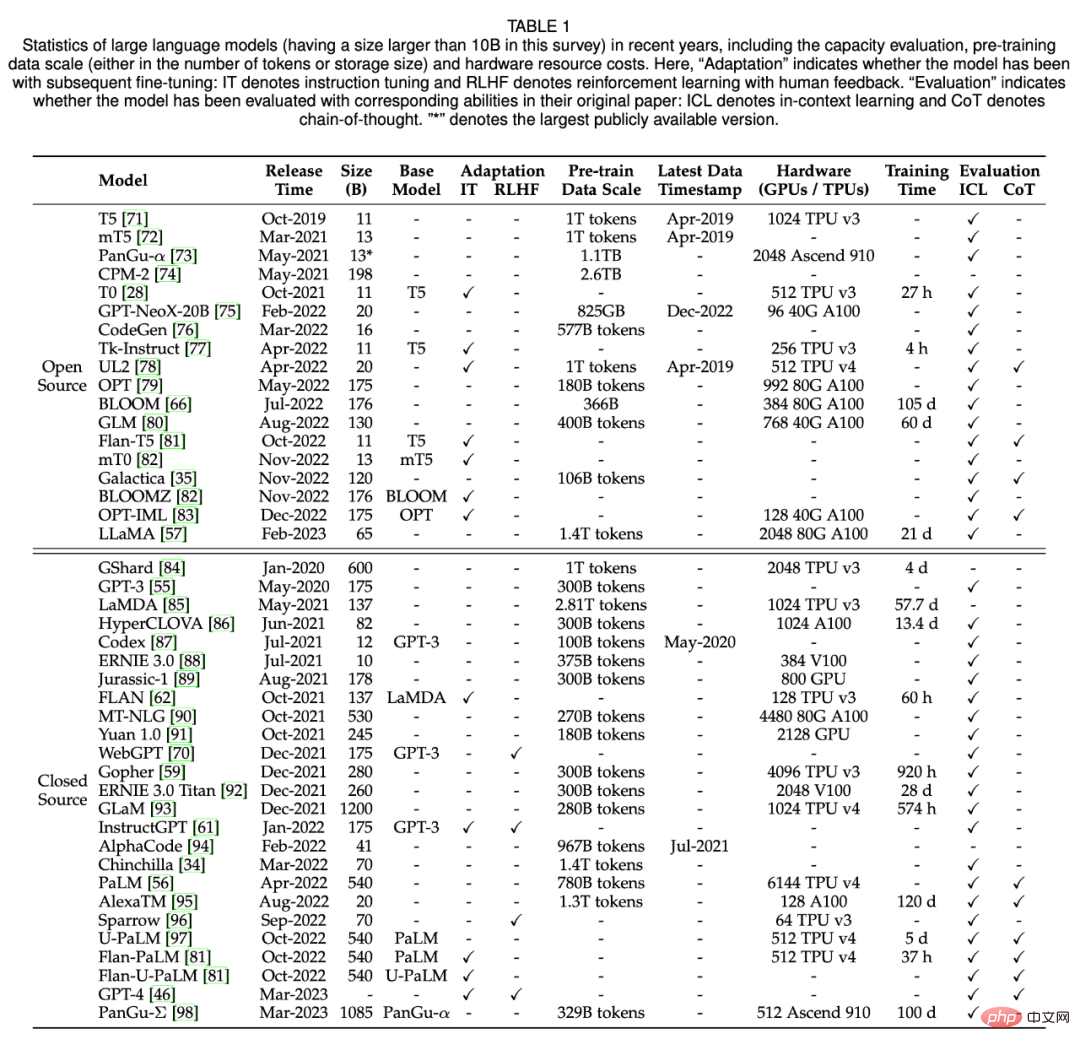

困難な技術的問題と膨大な計算リソース要件を考慮すると、LLM の開発または複製は決して簡単な作業ではありません。考えられるアプローチの 1 つは、既存の LLM から学び、公的に利用可能なリソースを増分開発や実験研究に再利用することです。セクション 3 では、研究者は主に、オープン ソース モデルのチェックポイントまたは API、利用可能なコーパス、および LLM に役立つライブラリを要約します。以下の表 1 は、近年のパラメータ数が 100 億を超える大規模モデルの統計データを示しています。

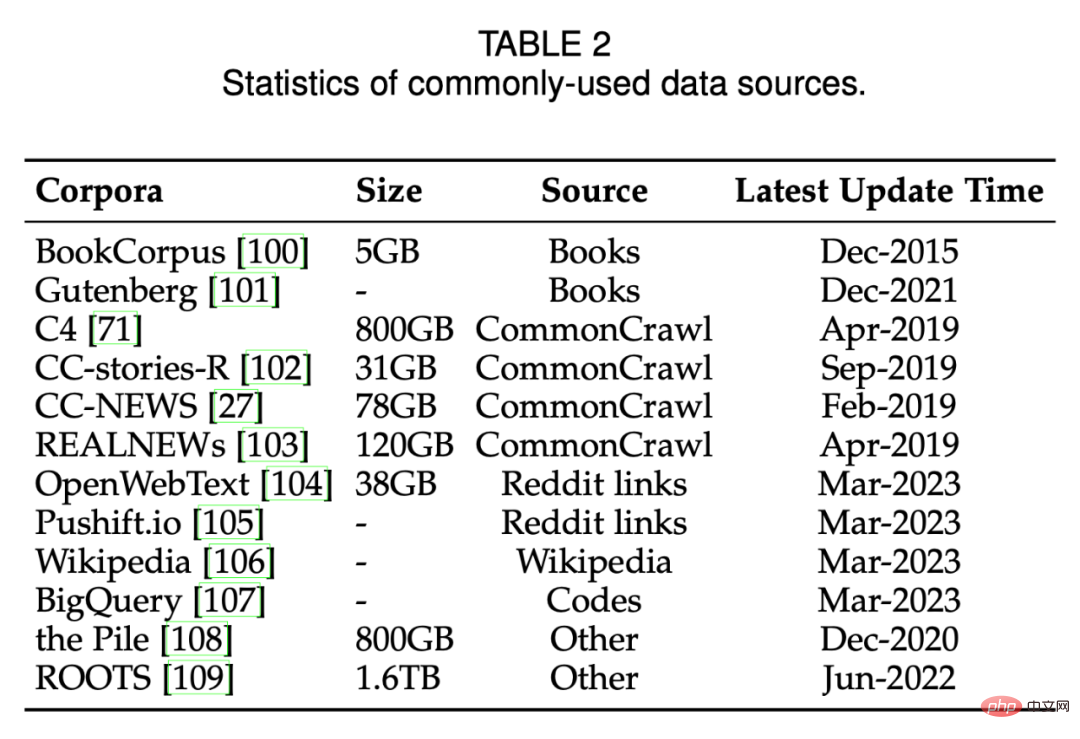

以下の表 2 に、一般的に使用されるデータ ソースを示します。

事前トレーニング

事前トレーニングでは、LLM の能力ベースを確立します。大規模なコーパスでの事前トレーニングを通じて、LLM は基本的な言語理解と制作スキルを習得できます。このプロセスでは、LLM が強力な機能を実現するには、事前トレーニング コーパスのサイズと品質が鍵となります。さらに、LLM を効果的に事前トレーニングするには、モデル アーキテクチャ、高速化手法、および最適化手法をすべて慎重に設計する必要があります。セクション 4 では、研究者は最初にセクション 4.1 でデータの収集と処理について説明し、次にセクション 4.2 で一般的に使用されるモデル アーキテクチャを紹介し、最後にセクション 4.3 で LLM の安定かつ効果的な最適化のためのトレーニング手法を紹介します。

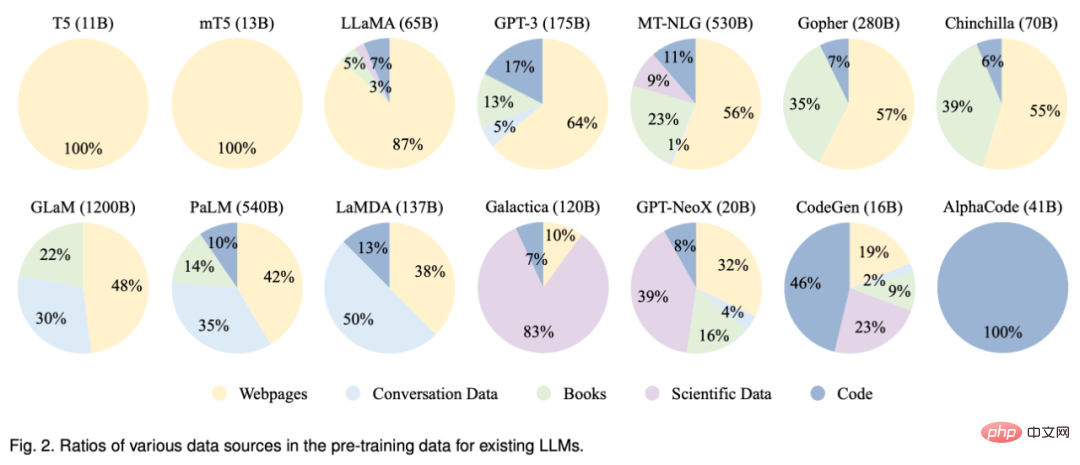

データ収集

強力な LLM を開発するには、さまざまなデータ ソースから大量の自然言語を収集します。重要です。既存の LLM は主に、さまざまな公開テキスト データセットを事前トレーニング コーパスとして利用します。以下の図 2 は、既存の LLM の事前トレーニングされたデータ ソースの分布を示しています。

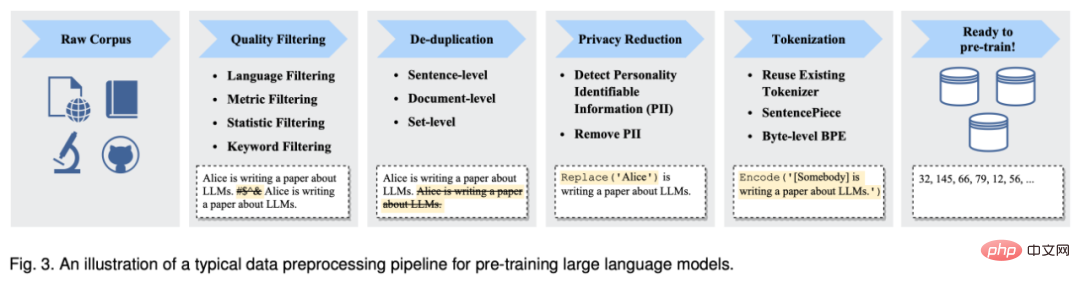

大量のテキスト データを収集した後、ノイズ除去、冗長性の削除、無関係で有害な可能性のあるデータを削除します。以下の図 3 は、LLM の事前トレーニング データの前処理パイプラインを示しています。

アーキテクチャ

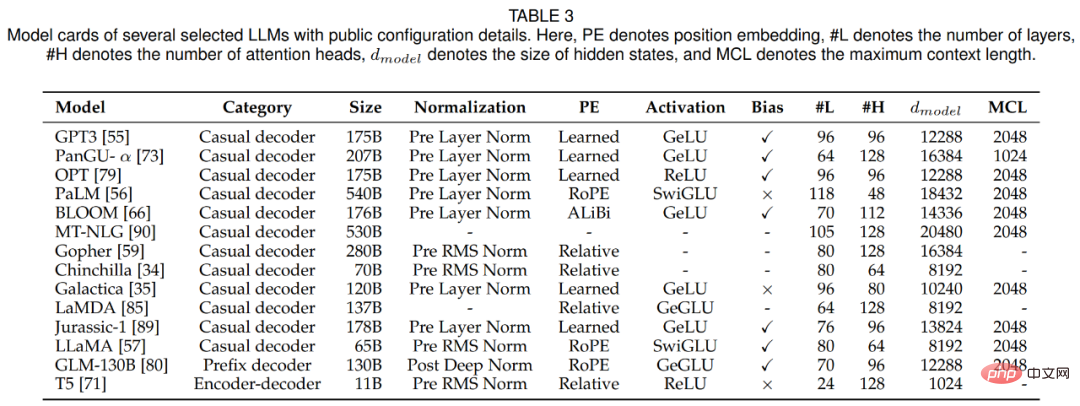

このセクションでは、研究者が LLM のアーキテクチャをレビューします。設計、つまり主流のアーキテクチャ、事前トレーニングの目標、および詳細な構成。以下の表 3 に、いくつかの代表的な LLM のモデル カードと、公開されている詳細を示します。

Transformer アーキテクチャは、その優れた並列化と容量により、さまざまな LLM 開発のバックボーンとなり、言語モデルを数百まで拡張することができます。数十億のパラメータが可能です。一般に、既存の LLM の主流アーキテクチャは、エンコーダ デコーダ、アドホック デコーダ、プレフィックス デコーダという 3 つの主要なカテゴリに大別できます。

Transformer の出現以来、トレーニングの安定性、パフォーマンス、計算効率を向上させるためにさまざまな改善が提案されてきました。このパートでは、研究者らは、正規化、位置エンコーディング、活性化関数、注意メカニズム、バイアスを含む、Transformer の 4 つの主要な部分の対応する構成について説明します。

事前トレーニングは非常に重要な役割を果たし、大規模なコーパスからの一般知識を大規模なモデル パラメーターにエンコードします。 LLM のトレーニングには、言語モデリングとノイズ除去自動エンコーディングという 2 つの一般的に使用される事前トレーニング タスクがあります。

モデル トレーニング

このセクションでは、研究者が LLM をトレーニングするための重要な設定、テクニック、トレーニングをレビューします。 LLM のヒント。

LLM のパラメーターを最適化するために、研究者は一般的に使用されるバッチ トレーニング、学習率、オプティマイザー、およびトレーニングの安定性の設定を提案しました。

モデルとデータのサイズが増加するにつれて、限られたコンピューティング リソースで LLM モデルを効果的にトレーニングすることが困難になってきています。特に、入力によるトレーニングの増加や、より大きなモデルの GPU メモリへのロードなど、2 つの主要な技術的問題に対処する必要があります。このセクションでは、上記 2 つの課題に対処するために既存の研究で広く使用されているいくつかの方法、つまり 3D 並列処理、ZeRO、および混合精度トレーニングをレビューし、それらをトレーニングに活用する方法について提案します。

LLM の適応チューニング

事前トレーニングの後、LLM はさまざまなタスクを解決する一般的な能力を獲得できます。しかし、LLM の機能を特定の目標に合わせてさらに調整できることを示唆する研究が増えています。セクション 5 では、研究者らは、事前トレーニングされた LLM を調整するための 2 つの主な方法、つまり命令調整とアライメント調整を詳細に紹介します。前者のアプローチは主に LLM の機能を改善または解放することであり、後者のアプローチは LLM の動作を人間の価値観や好みと一致させることです。

命令チューニング

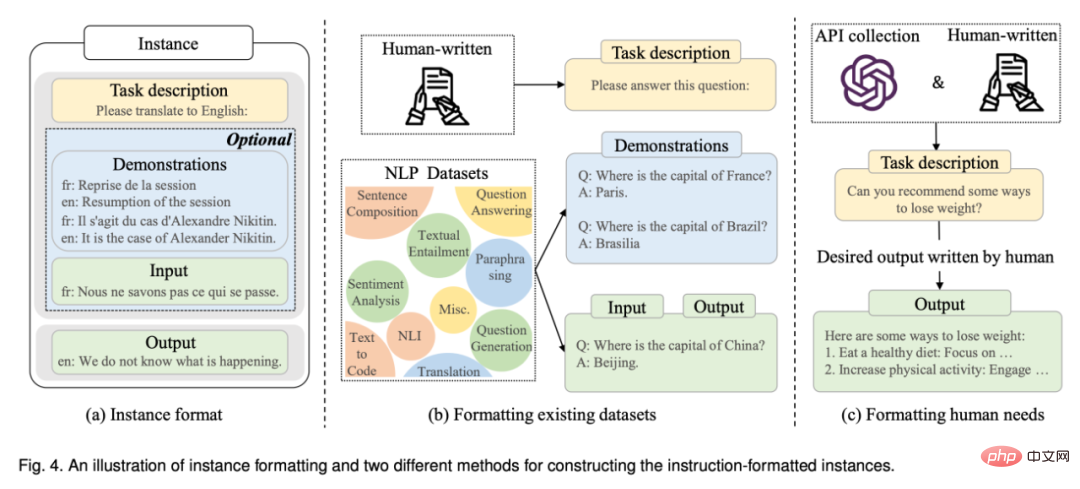

本質的に、命令チューニングは、自然言語形式のフォーマットされたインスタンスのセットに基づいています。事前トレーニング済み LLM を微調整します。これは、教師あり微調整およびマルチタスク キュー トレーニングに非常に関連しています。命令チューニングを実行するには、まず命令フォーマットのインスタンスを収集または構築する必要があります。次に、通常、これらのフォーマットされたインスタンスを使用して、教師あり学習方式 (たとえば、シーケンス間の損失を使用してトレーニング) で LLM を微調整します。 LLM は、指示を調整すると、多言語環境であっても、目に見えないタスクを一般化する優れた能力を発揮できます。

#最近の調査では、指導チューニング研究の体系的な概要が示されています。対照的に、このペーパーでは、LLM に対する命令チューニングの影響に焦点を当て、インスタンスの収集とチューニングに関する詳細なガイドラインまたは戦略を提供します。さらに、このペーパーでは、InstructGPT や GPT-4 などの既存の LLM で広く使用されている、ユーザーの実際のニーズを満たすための命令チューニングの使用について説明します。

フォーマットされたインスタンスの構築: 通常、命令形式のインスタンスは、タスクの説明 (命令と呼ばれます)、入出力ペア、および少数のデモンストレーション (オプション) で構成されます。 。既存の研究では、重要な公共リソースとして、自然言語でフォーマットされた大量のラベル付きデータが公開されています (利用可能なリソースのリストについては、表 5 を参照)。次に、この記事では、フォーマットされたインスタンスを構築する 2 つの主な方法を紹介し (図 4 を参照)、インスタンス構築におけるいくつかの重要な要素について説明します。

命令チューニング戦略: 事前トレーニングとは異なり、命令チューニングはトレーニングに使用されるインスタンスの数が適度であるため、一般的により効率的です。命令チューニングは教師ありトレーニング プロセスと考えることができますが、その最適化は、トレーニング目的 (シーケンス間の損失など)、最適化構成 (バッチ サイズの縮小など)、学習率など、いくつかの点で事前トレーニングとは異なります。 )、実際には特別な注意が必要です。これらの最適化構成に加えて、命令チューニングでは次の 2 つの重要な側面も考慮する必要があります:

- バランスのとれたデータ分散。

- 命令チューニングと事前トレーニングを組み合わせたもの。

アライメントチューニング

この部分が最初に紹介されます 背景次に、アライメントの定義と基準に焦点を当て、次に LLM をアライメントするためのヒューマン フィードバック データの収集に焦点を当て、最後にアライメント調整のためのヒューマン フィードバック強化学習の主要な手法について説明します。

使用法

使用法

#コンテキスト学習

# として特別なプロンプト形式であるコンテキスト学習 (ICL) は GPT-3 で最初に提案され、LLM を利用する典型的な方法になりました。

# として特別なプロンプト形式であるコンテキスト学習 (ICL) は GPT-3 で最初に提案され、LLM を利用する典型的な方法になりました。

思考連鎖プロンプト

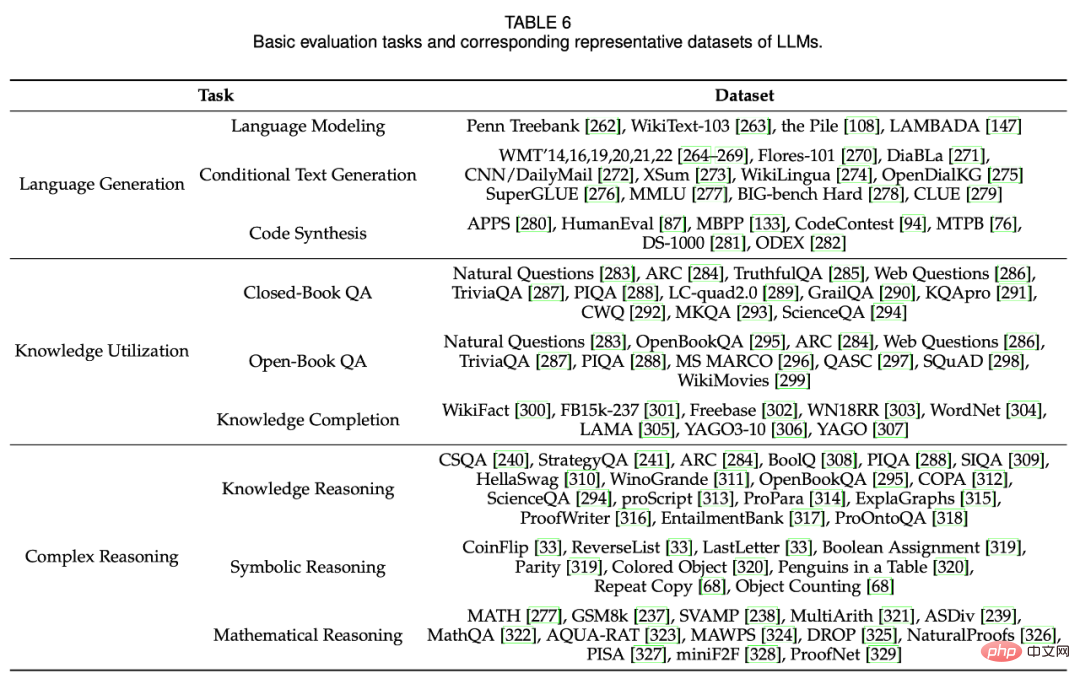

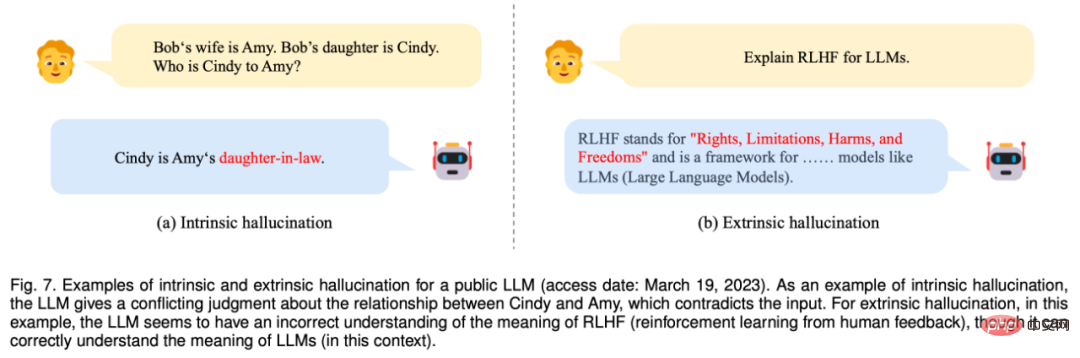

思考連鎖 (CoT) は、算術推論、常識推論、記号推論などの複雑な推論タスクにおける LLM のパフォーマンスを向上させる、改良されたプロンプト戦略です。 ICL のように単に入出力ペアからプロンプトを構築するのではなく、CoT は最終出力につながる中間推論ステップをプロンプトに組み込みます。セクション 6.2 では、CoT と ICL の使用について詳しく説明し、CoT がいつ、そしてなぜ効果的であるかを説明します。 LLM の有効性と優位性を研究するために、研究者は実証的な評価と分析のために多数のタスクとベンチマークを利用してきました。セクション 7 では、まず言語の生成と理解のための 3 つの LLM の基本的な評価タスクを紹介し、次に、より複雑な設定または目標を持つ LLM のいくつかの高度なタスクを紹介し、最後に既存のベンチマークと実証分析について説明します。 #基本的な評価タスク ## 図 7: LLM を明らかにする内部および外部の幻覚の例 (2023 年 3 月 19 日にアクセス)。内部幻覚の一例として、LLM はシンディとエイミーの関係について、入力と矛盾する判断を下します。外因性幻覚の場合、この場合、LLM は、LLM の意味を正しく理解しているにもかかわらず、RLHF (人間のフィードバックからの強化学習) の意味を誤って理解しているようです。 高度なタスクの評価 上記の基本的な評価タスクに加えて、LLM はいくつかの高度なタスクのデモンストレーションも行います。能力、特別な評価が必要です。セクション 7.2 では、研究者らは、手動調整、外部環境との相互作用、ツール操作など、いくつかの代表的な高レベルの機能と対応する評価方法について説明します。 最後のセクションでは、研究者はこの調査の議論を要約し、次の側面からLLMの課題と課題を紹介しました。 理論と原理: LLM の基本的な動作メカニズムを理解する上で、最大の謎の 1 つは、非常に大規模なディープ ニューラル ネットワークを通じて情報がどのように分散、編成、利用されるかということです。 LLM の機能の基礎を構築する根本的な原則または要素を明らかにすることが重要です。特に、スケーリングは LLM の機能を向上させる上で重要な役割を果たしているようです。既存の研究では、言語モデルのパラメータ サイズが臨界点 (10B など) まで増加すると、通常はコンテキスト学習、命令追従、ステップ段階的な推論。これらの「新たな」能力は魅力的ですが、不可解でもあります。LLM はいつ、どのようにしてそれらの能力を獲得するのでしょうか?最近の研究の中には、新たな能力の効果とその能力を実現する要因を調査する広範な実験を行ったり、特定の能力を説明するために既存の理論的枠組みを使用したりするものがあります。 GPT ファミリのモデルを対象とした洞察力に富んだ技術投稿でも、特にこのトピックを扱っていますが、LLM の機能や動作を理解し、説明し、説明するためのより正式な理論と原則がまだ不足しています。創発的能力は本質的に相転移と非常に類似しているため、学際的な理論や原則 (LLM がある種の複雑なシステムとみなせるかどうかなど) は、LLM の動作を説明し理解するのに役立つ可能性があります。これらの基本的な疑問は研究コミュニティによって検討される価値があり、次世代の LLM の開発にとって重要です。 モデル アーキテクチャ: 積み重ねられたマルチヘッドセルフアテンション レイヤーで構成される Transformer は、そのスケーラビリティと有効性により、LLM を構築するための一般的なアーキテクチャになっています。このアーキテクチャのパフォーマンスを向上させるために、ニューラル ネットワーク構成やスケーラブルな並列トレーニングなど、さまざまな戦略が提案されています (セクション 4.2.2 の説明を参照)。モデルの能力 (マルチターン対話機能など) をさらに向上させるために、既存の LLM は通常、長いコンテキスト長を維持します (たとえば、GPT-4-32k のコンテキスト長は 32768 トークンという非常に長い)。したがって、実際的な考慮事項は、標準的なセルフアテンション メカニズムによって生じる時間の複雑さ (原始二次コスト) を軽減することです。 さらに、GPT-3 ではスパース アテンションが使用されているなど、より効率的な Transformer バリアントが LLM の構築に与える影響を研究することが重要です。壊滅的な忘却もニューラル ネットワークにとって課題であり、LLM にも悪影響を及ぼしています。 LLM が新しいデータで調整されると、以前に学習した知識が破壊される可能性が高くなります。たとえば、特定のタスクのために LLM を微調整すると、その一般的な機能に影響が及びます。 LLM が人間の価値観と一致する場合にも同様の状況が発生します。これは「一致税」と呼ばれます。したがって、データ更新とタスクの専門化を効果的にサポートするには、より柔軟なメカニズムやモジュールを使用して既存のアーキテクチャを拡張することを検討する必要があります。 モデル トレーニング: 実際には、利用可能な LLM を事前トレーニングすることは、膨大な計算量と、データ品質とトレーニング技術に対する敏感さのため、非常に困難です。したがって、モデルの有効性、効率の最適化、トレーニングの安定性などの要素を考慮して、LLM を最適化するためのより体系的かつ経済的な事前トレーニング方法を開発することが特に重要になります。トレーニングの早い段階で異常を検出するために、モデル チェックやパフォーマンス診断 (GPT-4 の予測可能なスケーリングなど) をさらに開発します。さらに、コンピューティング クラスター内のリソースをより適切に編成して利用するには、より柔軟なハードウェア サポートやリソース スケジューリング メカニズムも必要です。 LLM を最初から事前トレーニングするにはコストがかかるため、公開されているモデル チェックポイント (LLaMA や Flan-T5 など) に基づいて LLM を継続的に事前トレーニングまたは微調整するための適切なメカニズムを設計する必要があります。これを行うには、データの不整合、壊滅的な忘却、タスクの特殊化など、いくつかの技術的問題に対処する必要があります。現在までのところ、完全な前処理およびトレーニング ログ (事前トレーニング データを準備するスクリプトなど) を備えた、再現可能な LLM 用のオープン ソース モデル チェックポイントがまだ不足しています。 LLM の研究のためにより多くのオープンソース モデルを提供することは、非常に価値があります。さらに、より改良された調整戦略を開発し、モデルの能力を効果的に刺激するメカニズムを研究することも重要です。 モデルの使用法: 実際のアプリケーションでは微調整にコストがかかるため、プロンプトは LLM を使用する有力な方法となっています。タスクの説明とデモンストレーションの例をプロンプトに組み合わせることで、コンテキスト学習 (プロンプトの特殊な形式) により、LLM は新しいタスクで優れたパフォーマンスを実現し、場合によってはフルデータの微調整モデルを上回るパフォーマンスを発揮します。さらに、複雑な推論の能力を向上させるために、中間推論ステップをプロンプトに組み込む思考連鎖 (CoT) 戦略など、高度なプロンプト手法が提案されています。しかし、既存のプロンプト方式には依然として次のような欠点があります。第一に、プロンプトの設計には多大な労力が必要となるため、さまざまなタスクを解決するための効果的なプロンプトを自動的に生成すると非常に役立ちます。第二に、一部の複雑なタスク (形式的な証明や数値計算など) には特定の知識や論理ルールが必要です。ルールは自然言語で説明されていないか、例で証明されていない可能性があるため、より多くの情報とより柔軟なタスク形式を備えたプロンプト メソッドを開発することが重要です。第三に、既存のプロンプト戦略は主にシングル ターンに焦点を当てており、パフォーマンスの点で非常に役立ちます。 ChatGPT が実証したように、複雑なタスクを (自然言語の会話を通じてなど) 解決するための対話型プロンプト メカニズムを開発する。 安全性と調整: LLM は、その優れた機能にもかかわらず、小規模な言語モデルと同様のセキュリティ問題に悩まされています。たとえば、LLM は、合理的であるように見えても事実に対応していない可能性があるような幻覚的なテキストを生成する傾向を示します。さらに悪いことに、LLM は、意図的な指示によって悪意のあるシステムに対して有害な、偏った、または有毒なテキストを生成する可能性があり、悪用の潜在的なリスクにつながります。 LLM に関するその他のセキュリティ問題 (プライバシー、過剰依存、偽情報、影響操作など) の詳細については、GPT-3/4 技術レポートを参照してください。これらの問題を回避する主な方法として、優れた LLM を開発するために人間をトレーニング ループに組み込む、ヒューマン フィードバックからの強化学習 (RLHF) が広く使用されています。モデルのセキュリティを向上させるには、GPT-4 に示されているように、RLHF プロセス中にセキュリティ関連のプロンプトを追加することも重要です。ただし、RLHF はプロのラベラーからの人間による高品質なフィードバック データに大きく依存しているため、実際に正しく実装することが困難です。したがって、人間のラベラーの作業を軽減するために RLHF フレームワークを改善し、データ品質を確保するために、アノテーション作業を支援するために LLM を採用するなど、より効果的なアノテーション方法を模索する必要があります。最近、LLM のモデル セキュリティを向上させるためにレッド チーム化が採用され、収集された敵対的プロンプトを利用して LLM を改良しています (つまり、レッド チーム化攻撃を回避します)。また、人間とのコミュニケーションを通じてLLMの学習の仕組みを確立することも意義があり、チャットを通じて人間から得られるフィードバックをLLMの自己改善に直接活用することができます。 アプリケーションとエコシステム: LLM はさまざまなタスクを解決する強力な機能を発揮するため、現実世界の幅広いアプリケーションで使用できます (例: 特定の自然言語命令に従うなど)。重要な進歩として、ChatGPT は人間が情報にアクセスする方法を変える可能性を秘めており、新しい Bing のリリースにつながります。近い将来、LLM が検索エンジンや認識システムなどの情報検索テクノロジーに大きな影響を与えることが予想されます。 さらに、LLM の技術アップグレードにより、インテリジェント情報アシスタントの開発と使用が大幅に促進されるでしょう。より広いスケールで見ると、この技術革新の波は、人間の生活に密接に関連する、LLM によってライセンス供与されたアプリケーションのエコシステム (例: ChatGPT のプラグインのサポート) を確立する傾向があります。最後に、LLM の台頭は、汎用人工知能 (AGI) の探求にインスピレーションを与えます。これにより、これまで以上にインテリジェントなシステム (潜在的にマルチモーダル信号を含む) が開発される可能性が期待されます。同時に、この開発プロセスでは、人工知能の安全性が主要な関心事の 1 つである必要があります。つまり、人工知能が人類に害を及ぼすのではなく利益をもたらすようにすることです。 能力評価

以上が大規模言語モデルのレビューを新たに公開: 20名以上の国内研究者による共著によるT5からGPT-4までの最も包括的なレビューの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。