###こんにちは、みんな。

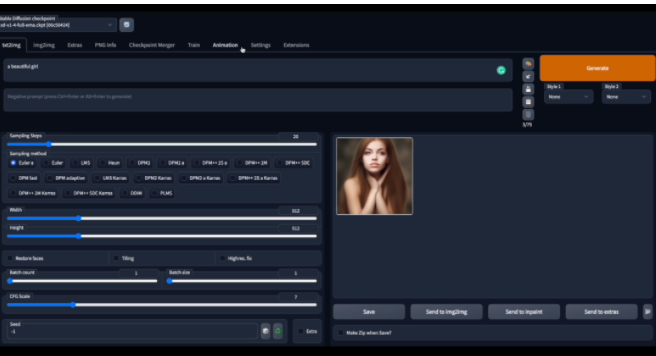

以前、転倒認識と戦闘認識について共有しましたが、今日は転倒認識を例として、ChatGPT に完全に任せることができるかどうかを確認します。 これを ChatGPT にやらせます。最も重要なことは、ChatGPT に質問する方法です。すべての質問を直接 ChatGPT に投げます。たとえば、転倒検出コードを Python で記述することはお勧めできません。代わりに、次のようにします。歯磨き粉を絞るとき、ChatGPT が問題解決の効率を真に向上できるように、ChatGPT を段階的にガイドして正確な回答を得ることができます。 今日共有された転倒認識ケースには、ChatGPT との対話と高いコードの使いやすさに関する明確なアイデアがあり、GPT から返された結果に従って、転倒認識プロジェクトを開発することができ、いくつかの拡張されたトピックがあります。例: Bi 彼女の改善点。 正式な共有は以下から始まります。 1. ロール設定ChatGPT に質問するには、まずロール設定を与える必要があります。アルゴリズム フィールドでは、これをプロンプトと呼びます。ロールを入力することによってのみ回答できます。質問の方が良いです。したがって、私の質問の最初の文は次のとおりです: あなたが AI エンジニアで、ビデオに転倒があるかどうかを特定したい場合、どのような方法がありますか? コードを直接書き、まずどのような方法やアイデアがあるのかを尋ねます。 ChatGPT の回答を見てみましょう

ChatGPT の答え

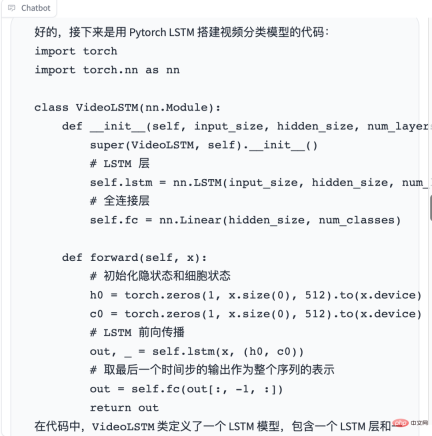

好的,下面是通过 Pytorch 的 ResNet 提取视频特征的代码,以及视频预处理的示例代码: 视频预处理: import cv2 import numpy as np def preprocess_video(video_path, n_frames=16, resize=(224, 224)): # 读取视频 cap = cv2.VideoCapture(video_path) frames = [] while True: ret, frame = cap.read() if not ret: break # 强制转换为 RGB frame = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB) # 图像缩放 frame = cv2.resize(frame, resize) # 图像增强等操作 # ... frames.append(frame) cap.release() # 取固定帧数 n_frames,超过后从中间开始截取 n_frames = min(len(frames), n_frames) start = (len(frames) - n_frames) // 2 end = start + n_frames # 截取帧数后堆叠成四维数组 frames = np.stack(frames[start:end], axis=0) # 转换为支持 Pytorch 模型的格式 (B, C, T, H, W) frames = np.transpose(frames, (0, 3, 1, 2)) return frames 提取视频特征: import torch import torchvision.models as models def extract_features(frames): # 加载 ResNet 模型 resnet = models.resnet50(pretrained=True) # 去掉最后的全连接层 resnet = torch.nn.Sequential(*list(resnet.children())[:-1]) # 将 ResNet 设置为评估模式 resnet.eval() # 将预处理后的视频序列转化为 Tensor,并调整为指定的数据类型和范围 frames = torch.from_numpy(frames).float() / 255.0 # 减去 ImageNet 数据集的均值和标准差 normalize = torch.nn.Normalize( mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225] ) frames = normalize(frames) # 前向预测,输出 2048 维特征向量 with torch.no_grad(): features = resnet(frames) return features.reshape(-1, 2048) 在上面这两块代码中,preprocess_video() 函数将读取视频,并将其转换为指定大小的图像帧,返回处理后的数据;extract_features() 函数将接受上一步处理后的数据,并将其转化为 Pytorch 的 Tensor,使用训练好的 ResNet 模型对每一帧图像进行特征提取,并返回一个形状为 (B, 2048) 的 Tensor,其中 B 为帧数。画像が長すぎます。ChatGPT の回答をよりよく理解していただくために、コード テキストを直接投稿しました。 2 つの独立した関数を定義し、それぞれ最初のステップの 2 つの小さなステップを完了します。 コードに問題はありません。まず preprocess_video 関数を呼び出してビデオを前処理し、次に extract_features 畳み込み演算を呼び出して 2048 次元のベクトルにベクトルを埋め込みます。 2 番目のステップでは、これを 2 つの小さなステップに分割します。最初に lstm モデルを構築し、次にトレーニングします。上記で生成された結果に基づいて、pytorch lstm を使用してビデオ分類モデルを構築します。 ChatGPT の回答

好的,下面是使用 Pytorch 训练视频分类模型的代码:

import torch

import torch.nn as nn

import torch.optim as optim

# 训练函数

def train(model, criterion, optimizer, dataloader, num_epochs=10):

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)# 将模型移动到 GPU 或 CPU 上

for epoch in range(num_epochs):

running_loss = 0.0

correct_predictions = 0

total_predictions = 0

for inputs, labels in dataloader:

inputs = inputs.to(device)

labels = labels.to(device)

optimizer.zero_grad()

with torch.set_grad_enabled(True):

outputs = model(inputs)

_, preds = torch.max(outputs, 1)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item() * inputs.size(0)

correct_predictions += torch.sum(preds == labels.data)

total_predictions += labels.size(0)

epoch_loss = running_loss / len(dataloader.dataset)

epoch_acc = correct_predictions.double() / total_predictions

print("Epoch {}: Loss {:.4f} Acc: {:.4f}".format(epoch + 1, epoch_loss, epoch_acc))

# 定义超参数

BATCH_SIZE = 4

NUM_EPOCHS = 20

# 定义数据集,假设已经准备好了训练数据集和测试数据集

train_dataset = ...

test_dataset = ...

# 定义数据加载器

train_dataloader = torch.utils.data.DataLoader(

train_dataset, batch_size=BATCH_SIZE, shuffle=True

)

test_dataloader = torch.utils.data.DataLoader(

test_dataset, batch_size=BATCH_SIZE, shuffle=False

)

# 定义模型

input_size = 2048

hidden_size = 512

num_layers = 1

num_classes = 2

model = VideoLSTM(input_size, hidden_size, num_layers, num_classes)

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters())

# 训练模型

train(model, criterion, optimizer, train_dataloader, num_epochs=NUM_EPOCHS)

在代码中,首先定义了模型的超参数,如 BATCH_SIZE 和 NUM_EPOCHS。接着定义了训练数据集和测试数据集,并使用 Pytorch 的 DataLoader 将数据加载为 batch。然后定义了模型、损失函数和优化器。最后调用 train() 函数进行模型训练。

在训练过程中,每个 epoch 循环训练所有的视频帧,计算损失函数,计算准确率,并输出当前 epoch 的平均损失和准确率。训练完成后,可以将模型的参数保存到磁盘上,以便以后使用。コードの使いやすさは非常に優れています高い。コード連結のコストを除けば、基本的に独立した各モジュールを移動する必要がなく、開発効率が非常に高くなります。 ChatGPT にデータ セットを見つけるように依頼することもできます

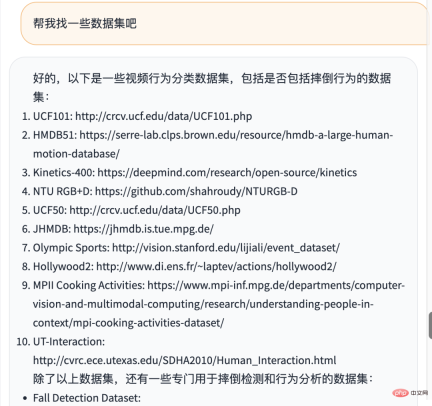

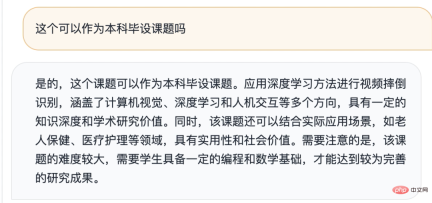

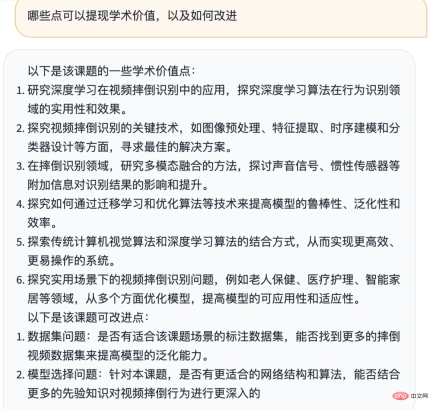

ChatGPT に、学術的価値を強調できるいくつかの点を考えるのを手伝ってもらうこともできます。

これを見ると、次のことがわかります。私の記事は、あなたにとって非常に重要です。 Planet に参加するかどうかに関係なく、皆さんが私を認めて信頼してくださっていることに感謝しています。

以上が転倒検出 - ChatGPT で完全に開発されており、ChatGPT に正しく質問する方法を共有しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

令人惊艳的4个ChatGPT项目,开源了!Mar 30, 2023 pm 02:11 PM

令人惊艳的4个ChatGPT项目,开源了!Mar 30, 2023 pm 02:11 PM自从 ChatGPT、Stable Diffusion 发布以来,各种相关开源项目百花齐放,着实让人应接不暇。今天,着重挑选几个优质的开源项目分享给大家,对我们的日常工作、学习生活,都会有很大的帮助。

Word文档拆分后的子文档字体格式变了怎么办Feb 07, 2023 am 11:40 AM

Word文档拆分后的子文档字体格式变了怎么办Feb 07, 2023 am 11:40 AMWord文档拆分后的子文档字体格式变了的解决办法:1、在大纲模式拆分文档前,先选中正文内容创建一个新的样式,给样式取一个与众不同的名字;2、选中第二段正文内容,通过选择相似文本的功能将剩余正文内容全部设置为新建样式格式;3、进入大纲模式进行文档拆分,操作完成后打开子文档,正文字体格式就是拆分前新建的样式内容。

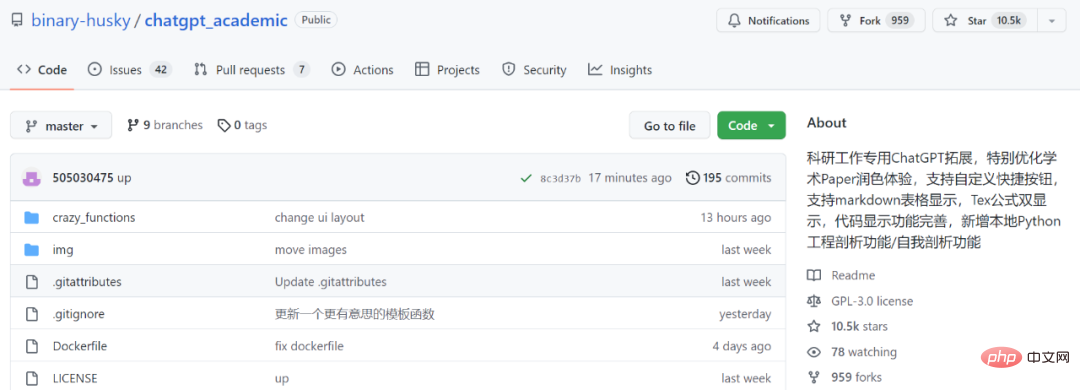

学术专用版ChatGPT火了,一键完成论文润色、代码解释、报告生成Apr 04, 2023 pm 01:05 PM

学术专用版ChatGPT火了,一键完成论文润色、代码解释、报告生成Apr 04, 2023 pm 01:05 PM用 ChatGPT 辅助写论文这件事,越来越靠谱了。 ChatGPT 发布以来,各个领域的从业者都在探索 ChatGPT 的应用前景,挖掘它的潜力。其中,学术文本的理解与编辑是一种极具挑战性的应用场景,因为学术文本需要较高的专业性、严谨性等,有时还需要处理公式、代码、图谱等特殊的内容格式。现在,一个名为「ChatGPT 学术优化(chatgpt_academic)」的新项目在 GitHub 上爆火,上线几天就在 GitHub 上狂揽上万 Star。项目地址:https://github.com/

30行Python代码就可以调用ChatGPT API总结论文的主要内容Apr 04, 2023 pm 12:05 PM

30行Python代码就可以调用ChatGPT API总结论文的主要内容Apr 04, 2023 pm 12:05 PM阅读论文可以说是我们的日常工作之一,论文的数量太多,我们如何快速阅读归纳呢?自从ChatGPT出现以后,有很多阅读论文的服务可以使用。其实使用ChatGPT API非常简单,我们只用30行python代码就可以在本地搭建一个自己的应用。 阅读论文可以说是我们的日常工作之一,论文的数量太多,我们如何快速阅读归纳呢?自从ChatGPT出现以后,有很多阅读论文的服务可以使用。其实使用ChatGPT API非常简单,我们只用30行python代码就可以在本地搭建一个自己的应用。使用 Python 和 C

vscode配置中文插件,带你无需注册体验ChatGPT!Dec 16, 2022 pm 07:51 PM

vscode配置中文插件,带你无需注册体验ChatGPT!Dec 16, 2022 pm 07:51 PM面对一夜爆火的 ChatGPT ,我最终也没抵得住诱惑,决定体验一下,不过这玩意要注册需要外国手机号以及科学上网,将许多人拦在门外,本篇博客将体验当下爆火的 ChatGPT 以及无需注册和科学上网,拿来即用的 ChatGPT 使用攻略,快来试试吧!

用ChatGPT秒建大模型!OpenAI全新插件杀疯了,接入代码解释器一键getApr 04, 2023 am 11:30 AM

用ChatGPT秒建大模型!OpenAI全新插件杀疯了,接入代码解释器一键getApr 04, 2023 am 11:30 AMChatGPT可以联网后,OpenAI还火速介绍了一款代码生成器,在这个插件的加持下,ChatGPT甚至可以自己生成机器学习模型了。 上周五,OpenAI刚刚宣布了惊爆的消息,ChatGPT可以联网,接入第三方插件了!而除了第三方插件,OpenAI也介绍了一款自家的插件「代码解释器」,并给出了几个特别的用例:解决定量和定性的数学问题;进行数据分析和可视化;快速转换文件格式。此外,Greg Brockman演示了ChatGPT还可以对上传视频文件进行处理。而一位叫Andrew Mayne的畅销作

ChatGPT教我学习PHP中AOP的实现(附代码)Mar 30, 2023 am 10:45 AM

ChatGPT教我学习PHP中AOP的实现(附代码)Mar 30, 2023 am 10:45 AM本篇文章给大家带来了关于php的相关知识,其中主要介绍了我是怎么用ChatGPT学习PHP中AOP的实现,感兴趣的朋友下面一起来看一下吧,希望对大家有帮助。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

SAP NetWeaver Server Adapter for Eclipse

Eclipse を SAP NetWeaver アプリケーション サーバーと統合します。

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

DVWA

Damn Vulnerable Web App (DVWA) は、非常に脆弱な PHP/MySQL Web アプリケーションです。その主な目的は、セキュリティ専門家が法的環境でスキルとツールをテストするのに役立ち、Web 開発者が Web アプリケーションを保護するプロセスをより深く理解できるようにし、教師/生徒が教室環境で Web アプリケーションを教え/学習できるようにすることです。安全。 DVWA の目標は、シンプルでわかりやすいインターフェイスを通じて、さまざまな難易度で最も一般的な Web 脆弱性のいくつかを実践することです。このソフトウェアは、

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター