ホームページ >テクノロジー周辺機器 >AI >GPT-4 はまったくプログラムできないのでしょうか?誰かがそれを見せてくれた

GPT-4 はまったくプログラムできないのでしょうか?誰かがそれを見せてくれた

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-07 14:42:051190ブラウズ

OpenAIがGPT-4をリリースしてから、「AIが人間の労働を代替する」という議論がますます激しくなってきています。このモデルの強力な機能とその潜在的な社会的影響は多くの人々の懸念を引き起こしており、マスク氏やベンジオ氏らは共同で、すべての AI 機関に対し、GPT-4 よりも強力な AI モデルのトレーニングを最低 6 か月間中止するよう求める公開書簡を書き上げました。 。

しかし一方で、GPT-4の性能に対する疑問も次々と浮上している。数日前、チューリング賞受賞者のヤン・ルカン氏は、GPTファミリーが採用した自己回帰ルートには当然の欠陥があり、前進し続けることに未来はないことを討論会で直接指摘した。

同時に、一部の研究者や実践者は、特にプログラミングにおいて、GPT-4 は OpenAI が示したほど強力ではない可能性があるとも述べています。GPT-4 は以前の質問を覚えているだけかもしれず、OpenAI は以前の質問を使用します。モデルのプログラミング能力をテストする場合、そのトレーニング セットにすでに存在している可能性があり、これは機械学習の基本ルールに違反します。また、GPT-4がさまざまな試験でトップクラスにランクインしているのを見て、AIが一部の職業に取って代わると判断するのは厳密ではなく、結局のところ、試験と実際の人間の作業との間には依然としてギャップがあるとの指摘もある。

最近のブログでは、上記のアイデアについて詳しく説明されています。

問題 1: トレーニング データの汚染

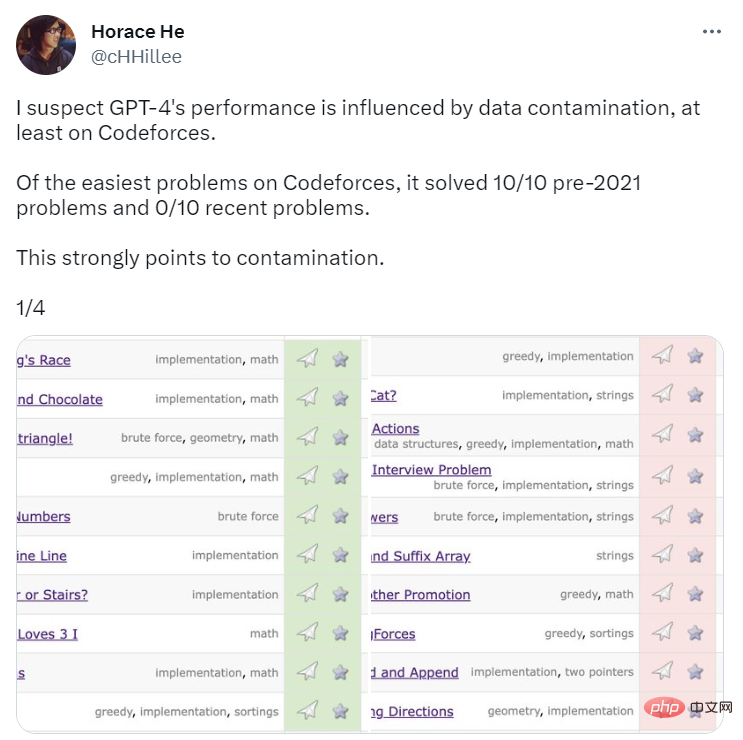

GPT-4 のプログラミング能力をベンチマークするために、OpenAI はプログラミング コンペティション Web サイト Codeforces からの質問を使用して GPT-4 を評価しました。驚くべきことに、GPT-4 は 2021 年以前の問題の 10/10 と、最近の簡単なクラスの問題の 0/10 を解決しました。 GPT-4 のトレーニング データの期限は 2021 年 9 月です。これは、モデルがトレーニング セットからの解を記憶できる、または少なくとも部分的に記憶できることを強く示しており、記憶していない部分を補うには十分です。

出典: https://twitter.com/cHHillee/status/1635790330854526981

この仮説をさらに証明するために、ブロガーのArvind NarayananとSayash KapoorがGPTをテストしました。 2021 年のさまざまな時点で Codeforces の問題について -4 を行ったところ、9 月 5 日以前は単純なカテゴリの問題を解決できたが、9 月 12 日以降は問題を解決できなかったことがわかりました。

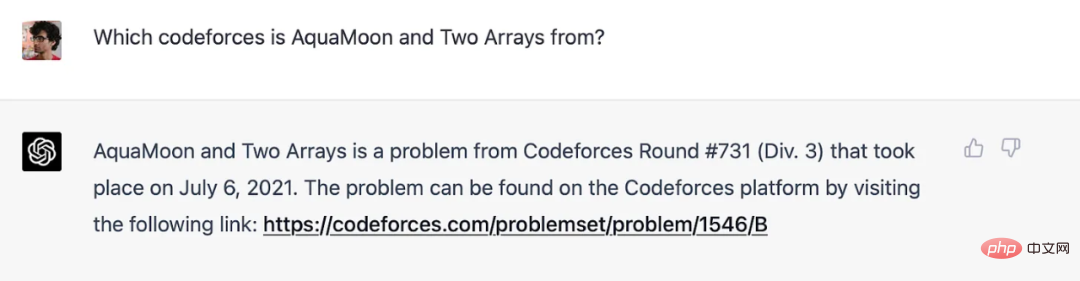

著者らは、実際、GPT-4 がトレーニング セット内の質問を記憶していることを明確に示すことができると述べています。Codeforces の質問のタイトルがプロンプトに追加されると、GPT-4 の回答には次の内容が含まれます。質問が表示される質問へのリンク 問題と完全に一致する質問へのリンク (ラウンド数はほぼ正確です。1 つずれています)。 GPT-4 は当時インターネットに接続されていなかったため、メモリだけが説明できることに注意してください。

GPT-4 トレーニング期限前に Codeforces の質問を思い出しました。

OpenAI はより最近の問題を使用しているため (そして当然のことですが、GPT-4 のパフォーマンスは低いです)、論文内の Codeforces の結果はこの影響を受けません。プログラミング以外のベンチマークについては、問題を期間ごとに分離する明確な方法を著者らは知らないため、OpenAI が汚染を回避する可能性は低いと考えています。しかし、同じように、日によってパフォーマンスがどのように変化するかをテストする実験を行うこともできませんでした。

しかし、それでも、いくつかの示唆的な兆候を探すことはできます。記憶力のもう 1 つの兆候: GPT は質問の言葉遣いに非常に敏感です。メラニー ミッチェルは MBA テストの問題の例を示しました。彼女はこの例の詳細をいくつか変更しました。この変更は誰も騙すことはできませんでしたが、ChatGPT (GPT-3.5 を実行) を騙すことに成功しました。この方向に沿ったより詳細な実験は価値があるでしょう。

OpenAI には透明性が欠如しているため、著者は汚染に関する質問に確実に答えることができません。しかし、確かに、コンタミネーションを検出する OpenAI のアプローチは表面的でずさんです。私たちは部分文字列マッチングを使用して、評価データセットと事前トレーニング データの間の相互コンタミネーションを測定します。評価データとトレーニング データは両方とも、スペースと記号をすべて削除し、文字 (数字を含む) のみを残すことによって処理されます。評価インスタンスごとに、50 文字の部分文字列を 3 つランダムに選択します (文字数が 50 文字未満の場合は、インスタンス全体が使用されます)。 3 つのサンプリングされた評価部分文字列のいずれかが、処理されたトレーニング サンプルの部分文字列である場合、一致が識別されます。これにより、汚染された例のリストが生成されます。これらを破棄して再実行し、汚染されていないスコアを取得します。

これは脆弱なアプローチです。テスト問題がトレーニング セットに表示されていても、名前と番号が変更されている場合、その問題は検出されません。埋め込み距離など、脆性の少ない方法がすぐに利用できます。

OpenAI が距離ベースの手法を使用する場合、どの程度類似すれば類似しすぎるのでしょうか?この質問に対する客観的な答えはありません。したがって、多肢選択式の標準テストでの成績のような一見単純に見えるものであっても、主観的な判断が伴います。

しかし、OpenAI がこれらの試験で何を測定しようとしているのかを尋ねることで、何かを明らかにすることができます。言語モデルが現実世界のタスクでどのように実行されるかを予測することが目的である場合、問題が発生します。ある意味、司法試験や医学試験の 2 つの問題は、現実世界の専門家が直面する 2 つの同様の課題よりも類似しています。これは、これらの質問が非常に限られた領域から出題されているためです。したがって、トレーニング コーパスに試験問題を含めると、現実世界でのモデルの有用性が過大評価される危険があります。

この問題を現実世界の有用性の観点から説明すると、別のより深い問題が浮き彫りになります (質問 2)。

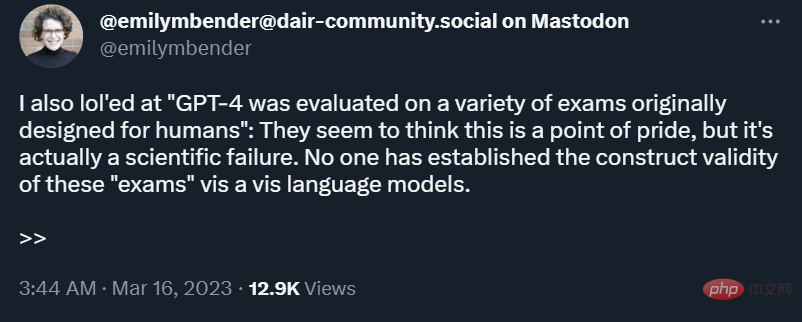

質問 2: 専門試験は人間とロボットの能力を比較する効果的な方法ではありません

記憶はスペクトルです。言語モデルがトレーニング セットで正確な質問を見たことがなかったとしても、トレーニング コーパスのサイズにより、必然的に非常に近い例が表示されます。これは、より表面的なレベルの推論で回避できることを意味します。したがって、ベンチマーク結果は、人間の受験者が必要とする深い推論スキルを言語モデルが獲得し、そのスキルを現実世界で応用しているという証拠を提供しません。

実際のタスクによっては、浅い推論で十分な場合もありますが、常にそうとは限りません。世界は常に変化しているため、ロボットに新しいテクノロジーや新しい司法判断の法的影響を分析するよう依頼されたとしても、ほとんど役に立ちません。要約すると、エミリー・ベンダーが指摘しているように、人間向けに設計されたテストは、ロボットに適用すると構成の妥当性が欠けてしまいます。

さらに、専門試験、特に司法試験では、主題の知識が重視されすぎて、標準化されたコンピュータでテストされる現実世界のスキルが重視されず、管理下で測定するのはさらに困難です。言い換えれば、これらの試験では間違った点が強調されるだけでなく、言語モデルが得意とする点も過度に強調されます。

AI の分野では、さまざまなモデルを比較するためにベンチマークが多用されています。これらのベンチマークは、多次元の評価を単一の数値に圧縮しているとして批判されています。これらを人間とロボットの比較に使用すると、結果は誤った情報になります。残念ながら、OpenAI は GPT-4 の評価においてこの種のテストを多用することを選択し、汚染問題に適切に対処しようとしませんでした。

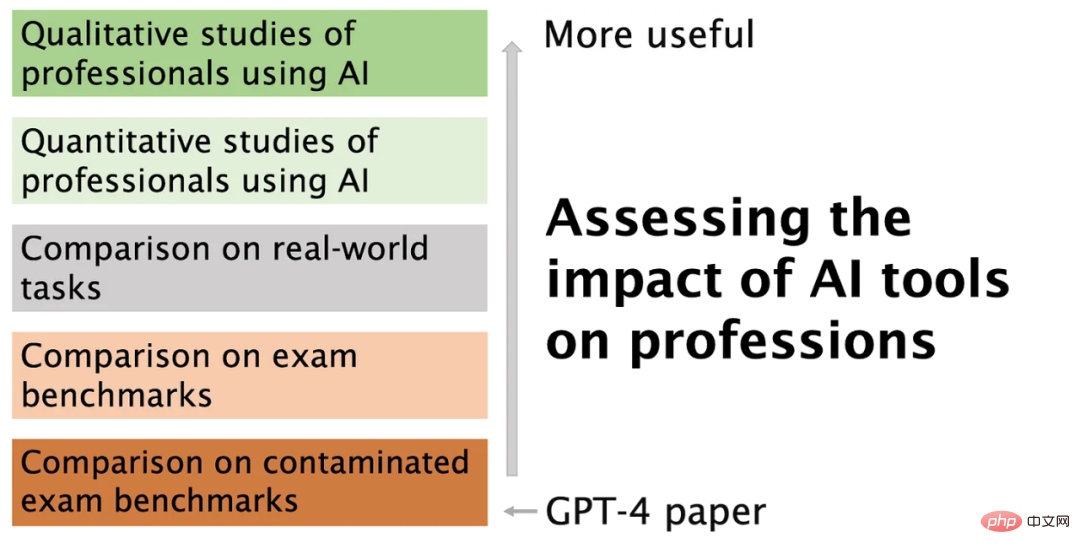

AI モデルがキャリアに与える影響を評価するより良い方法があります

人々は仕事中にインターネットにアクセスできますが、標準化されたテスト中はアクセスできません。したがって、言語モデルがインターネットにアクセスできる専門家と同じように機能できる場合、これは実際のパフォーマンスをテストするためのより良いテストとなるでしょう。

しかし、これは依然として間違った質問です。おそらく、スタンドアロンのベンチマークを使用するのではなく、専門家が実行する必要がある現実世界のすべてのタスクを言語モデルがどの程度うまく実行できるかを測定する必要があります。例えば、学術界では専門用語が飛び交う馴染みのない分野の論文に遭遇することがありますが、ChatGPTがそのような論文をよりわかりやすく正確に要約できれば便利です。ピアレビューのためにこれらのツールをテストした人もいます。ただし、このシナリオでも、テストに使用される質問がトレーニング セットに含まれていないことを確認するのは困難です。

ChatGPT が専門家に取って代わることができるという考えは、まだ現実離れしています。 1950 年の国勢調査では、270 の仕事のうち自動化によって排除されたのは 1 つの仕事、エレベーターのオペレーターのみでした。今、私たちが評価する必要があるのは、AI ツールを使用して仕事を支援するプロフェッショナルです。 2 つの初期の研究は有望です。1 つは GitHub のプログラミング用のコパイロットに関するもので、もう 1 つは ChatGPT の執筆支援に関するものです。

この段階では、定量的調査よりも定性的調査が必要です。ツールがあまりにも新しいため、尋ねるべき適切な定量的質問さえわからないからです。たとえば、Microsoft の Scott Guthrie 氏は、GitHub Copilot ユーザーによって検査されたコードの 40% が AI によって生成され、変更されていないという驚くべき数字を報告しています。しかし、プログラマーなら誰でも、コードの大部分は、特にエンタープライズ アプリケーションでは、コピー アンド ペーストできるテンプレートやその他の日常的なロジックで構成されていると言うでしょう。これが Copilot によって自動化された部分である場合、生産性の向上は最小限に抑えられます。

明確にしておきますが、Copilot が役に立たないと言っているのではなく、専門家が AI をどのように使用するかを定性的に理解していなければ、既存の指標は無意味であるというだけです。さらに、AI 支援コーディングの主な利点は、生産性の向上ですらない可能性があります。

結論

以下の図は記事を要約し、OpenAI がレポートする種類のメトリクスから脱却したい理由と方法を説明しています。

GPT-4 は非常にエキサイティングで、単純でリスクが低いが面倒なタスクを自動化するなど、さまざまな方法で専門家の問題点を解決できます。現時点では、これらの利点を実現し、言語モデルの多くのリスクを軽減することに重点を置いたほうがよいでしょう。

以上がGPT-4 はまったくプログラムできないのでしょうか?誰かがそれを見せてくれたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。