ホームページ >テクノロジー周辺機器 >AI >3D モデルのセグメンテーションの新しい方法により、両手が解放されます。手動のラベル付けは必要なく、必要なトレーニングは 1 回だけで、ラベルのないカテゴリも認識可能 | HKU & Byte

3D モデルのセグメンテーションの新しい方法により、両手が解放されます。手動のラベル付けは必要なく、必要なトレーニングは 1 回だけで、ラベルのないカテゴリも認識可能 | HKU & Byte

- PHPz転載

- 2023-04-01 00:02:021602ブラウズ

手動による注釈は必要ありません。3D モデルが言語を理解し、ラベルのないカテゴリを識別できるようにするために必要なトレーニングは 1 回だけです。

3D モデルのセグメンテーションがハンズフリーで行えるようになりました。

香港大学と ByteDream は協力して新しい方法を考案しました:

手動による注釈は必要なく、3D モデルを可能にするために必要なトレーニングは 1 回だけです。言語を理解し、未知のオブジェクトを識別します。

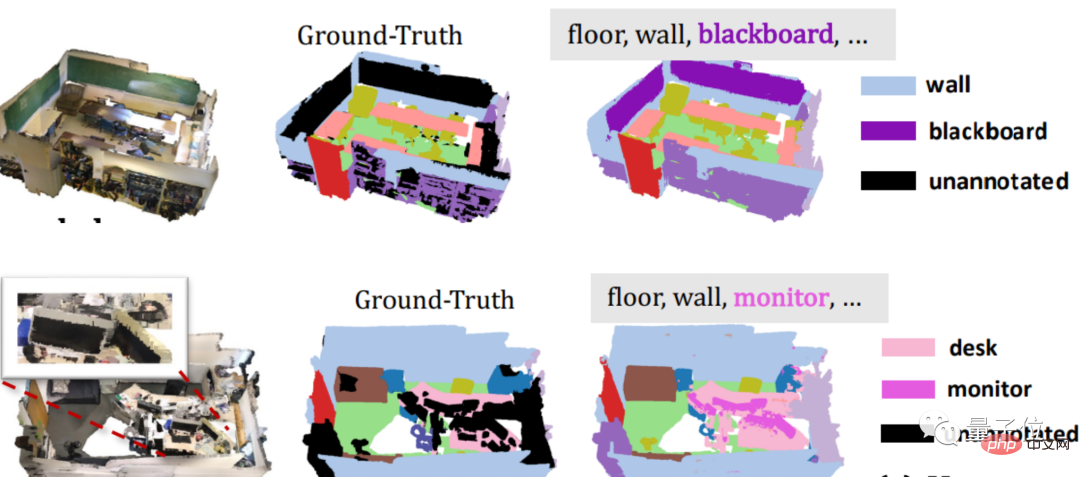

たとえば、次の注釈のない黒板とモニターの例を見てください。この方法で 3D モデルをトレーニングすると、セグメンテーションのターゲットをすばやく「把握」できます。

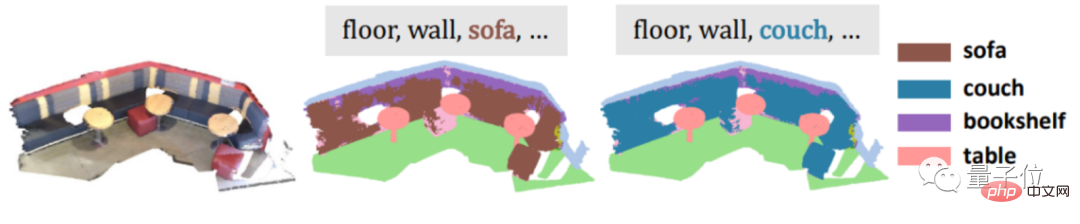

別の例として、ソファや咳などの同義語を入力して物事を難しくすると、簡単に勝つことができます。

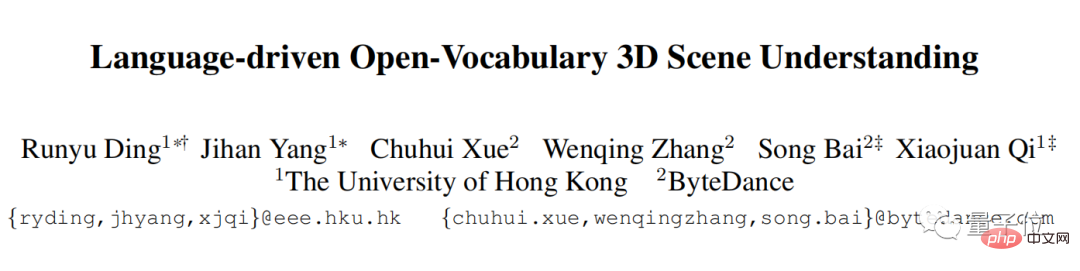

# バスルームなどの抽象的なカテゴリでも解決できます。

この新しい手法は PLA (Point-Language Association) と呼ばれ、点群 (ターゲット表面特性の大量の点の集合) と自然言語を組み合わせた手法です。

現在、この論文は CVPR 2023 に受理されました。

とはいえ、手動でアノテーションを付ける必要はなく、トレーニングは 1 回だけ実行され、同義語の抽象分類も認識できます。これは次の重ね合わせです。複数のバフ。

一般的な方法で使用される 3D データと自然言語は、インターネットから無料で直接入手することはできず、多くの場合、高価な手動の注釈が必要であること、および一般的な方法は 3D データと自然言語間の意味関係に基づくことができないことを知っておく必要があります。新しいカテゴリを特定します。

それでは、人民解放軍はどのようにしてそれを行うのでしょうか?見てみましょう~

具体的な原則

実際、率直に言えば、3D モデルの分割を成功させるための最も重要なステップは、3D データに自然言語を理解させることです。

専門的に言えば、3D 点群に自然言語記述を導入することです。

導入方法は?

現在、2D 画像を分割する比較的成功した方法があるという事実を考慮して、研究チームは 2D 画像から始めることにしました。

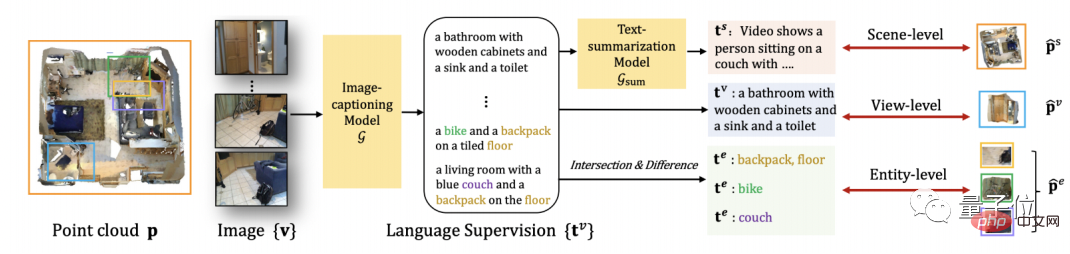

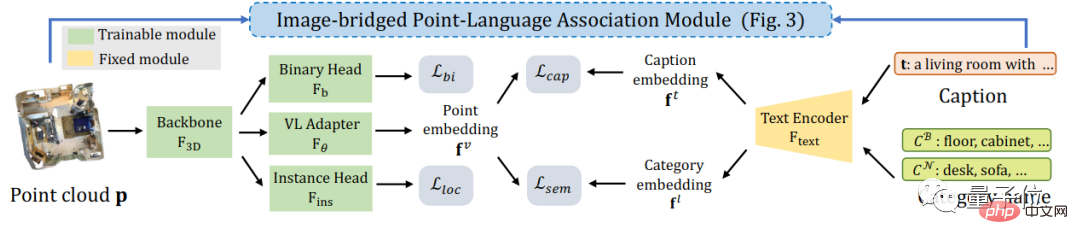

まず、3D 点群を対応する 2D 画像に変換し、それを 2D マルチモーダル大規模モデルの入力として使用し、そこから画像の言語記述を抽出します。

次に、画像と点群間の射影関係を使用して、画像の言語記述を 3D 点群データに自然に関連付けることができます。

さらに、異なる粒度の 3D オブジェクトと互換性を持たせるために、PLA は多粒度の 3D 点群と自然言語の関連付け方法も提案しています。

3D シーン全体について、PLA はシーンに対応するすべての画像から抽出された言語記述を要約し、この要約された言語を使用して 3D シーン全体を関連付けます。

各画像ビューに対応する 3D シーンの部分については、PLA は画像をブリッジとして直接使用し、対応する 3D 点群と言語を関連付けます。

よりきめ細かい 3D オブジェクトの場合、PLA は、異なる画像の対応する点群間の交差と結合、および言語記述部分の交差と結合を比較することにより、より詳細な方法を提供します。言語相関アプローチ。

このようにして、研究チームは 3D 点群と自然言語のペアを取得することができ、これにより手動による注釈の問題が直接解決されます。

PLA は、取得した「3D 点群と自然言語」のペアと既存のデータセット監視を使用して、3D モデルが検出とセグメンテーションの問題定義を理解できるようにします。

具体的には、対比学習を使用して、特徴空間内の 3D 点群と自然言語の各ペア間の距離を縮め、一致しない 3D 点群と自然言語の記述を遠ざけます。

これまで多くの原則について説明してきましたが、PLA は特定のセグメンテーション タスクでどのように機能するのでしょうか?

セマンティック セグメンテーション タスクはベースラインを 65% 上回りました

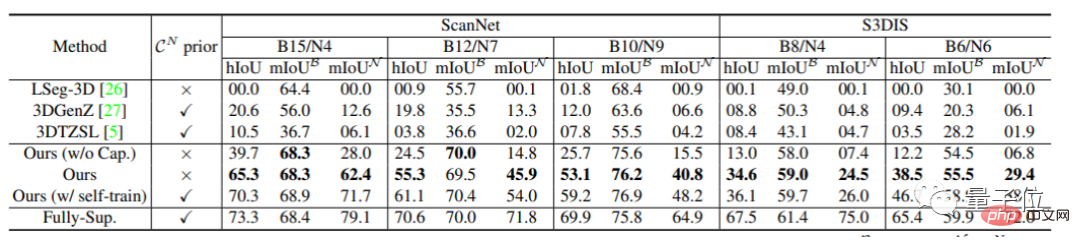

研究者らは、主な測定基準としてラベルのないカテゴリで 3D オープンワールド モデルのパフォーマンスをテストしました。

まず、ScanNet と S3DIS のセマンティック セグメンテーション タスクにおいて、PLA は以前のベースライン手法を 35% ~ 65% 上回りました。

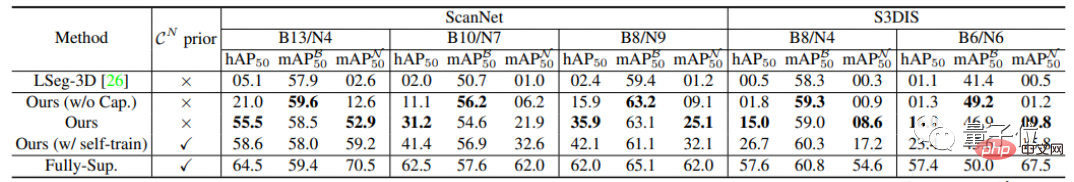

インスタンス セグメンテーション タスクでは、PLA も改善されており、以前の方法と比較して、PLA の改善範囲は 15% ~ 50% です。

研究チーム

このプロジェクトの研究チームは、香港大学の CVMI Lab と ByteDance から来ています。

CVMI Labは香港大学の人工知能研究室で、2020年2月1日に設立されました。

研究範囲は、コンピューター ビジョンとパターン認識、機械学習/ディープ ラーニング、画像/ビデオ コンテンツ分析、機械インテリジェンスに基づく産業ビッグ データ分析をカバーします。

論文アドレス: https://arxiv.org/pdf/2211.16312.pdf

プロジェクトホームページ: https: // github.com/CVMI-Lab/PLA

以上が3D モデルのセグメンテーションの新しい方法により、両手が解放されます。手動のラベル付けは必要なく、必要なトレーニングは 1 回だけで、ラベルのないカテゴリも認識可能 | HKU & Byteの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。