「インテリジェントな画像およびテキスト処理技術とマルチシナリオ応用技術」について、学界と産業界の多くの研究者が徹底的な議論を行いました。

「複雑すぎます!」

経験 GPT-4 と Microsoft 365 Copilot の継続的な攻撃の後、多くの人がこのような感情を抱いていると思います。

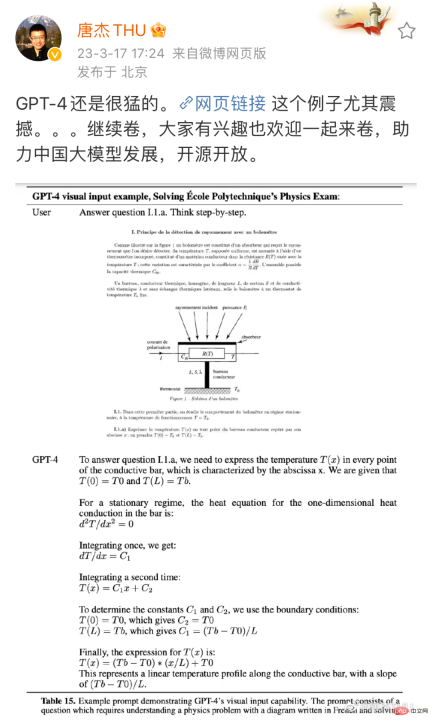

GPT-3.5 と比較して、GPT-4 は多くの点で大幅な改善を達成しており、たとえば司法模擬試験では、当初の下位 10% からプラス 10% に進化しました。もちろん、一般の人はこれらの専門試験についてまったく知らないかもしれません。しかし、写真をお見せすれば、その改善がいかに恐ろしいものであるかがわかるでしょう:

出典: Tang Jie、清華大学コンピューターサイエンス学部教授、微博。リンク: https://m.weibo.cn/detail/4880331053992765

これは物理の問題です。画像とテキストに従って問題を段階的に解くには GPT-4 が必要です。 GPT-3.5 です (ここでは、ChatGPT がアップグレード前に依存していたモデルにはなかった機能を指します。一方で、GPT-3.5 はテキストを理解するようにのみトレーニングされており、質問内の画像を理解することはできません。一方で、GPT-3.5の問題解決能力も非常に弱く、同じ檻の中のニワトリとウサギではつまづいてしまう可能性がある。しかし今回は、両方の問題が見事に解決されたようです。

これは大したことだと誰もが思ったとき、Microsoft は別の大ヒット作 GPT-4 をリリースしました。これらの機能は Microsoft 365 Copilot と呼ばれる新しいアプリケーションに統合されました。強力な画像およびテキスト処理機能を備えた Microsoft 365 Copilot は、さまざまなドキュメントの作成を支援するだけでなく、ドキュメントを PPT に簡単に変換したり、Excel データをグラフに自動的に要約したりすることもできます...

グラフィックスとテキストのインテリジェントな処理 という明らかな画期的な進歩を見つけることができます。

現実のシナリオでは、非構造化データをグラフに整理する、グラフに基づいてレポートを作成する、大量のグラフィックやテキストから有用な情報を抽出するなど、あらゆる分野の多くの仕事がグラフィックやテキストの処理に関連しています。情報、情報など。このため、この革命の影響は多くの人が想像するよりもはるかに深刻なものになる可能性があります。 OpenAI とウォートン スクールが最近発表した大ヒット論文は、この影響を予測しています。米国の労働力の約 80% は、GPT の導入によって業務タスクの少なくとも 10% に影響を受ける可能性があり、労働者の約 19% は、次のような影響を受ける可能性があります。タスクの少なくとも 50% が影響を受けます。作業の大部分にグラフィックとテキストのインテリジェンスが含まれることが予想されます。 このような入口点において、検討する価値のある研究活動やエンジニアリング活動は何でしょうか?中国画像グラフィック学会 (CSIG) が主催し、Hehe Information と CSIG Document Image Analysis and Recognition Professional Committee が共催した最近の CSIG Enterprise Tour イベントでは、学界や産業界の多くの研究者が「グラフィックスとテキスト」に焦点を当てました。 「インテリジェント処理テクノロジーとマルチシナリオ アプリケーション テクノロジー」について詳しく説明されており、インテリジェントな画像およびテキスト処理の分野に関心を持つ研究者や実践者にインスピレーションを与えるかもしれません。

根底にあるビジョンから始まるグラフィックスとテキストの処理前述したように、GPT-4 のグラフィックスとテキストの処理機能は非常に衝撃的です。上記の物理学に関する質問に加えて、OpenAI の技術レポートでは、GPT-4 に論文の画像を読み取らせるなど、他の例も引用されています。テクノロジーの普及 導入前にやるべき基本的な作業がまだたくさんあるかもしれませんが、基礎となるビジョンもその 1 つです。 基礎となるビジョンの特性は非常に明白です。入力は画像であり、出力も画像です。画像の前処理、フィルタリング、復元、および強化はすべてこのカテゴリに分類されます。 「基礎的な視覚の理論と手法は、携帯電話、医療画像分析、セキュリティ監視など、多くの分野で広く使用されています。画像やビデオ コンテンツの品質を重視する企業や機関は注意を払う必要があります。 「基礎となる視覚の方向性を研究します。基礎となる視覚が適切に行われていない場合、多くの高度な視覚システム (検出、認識、理解など) を真に実装することはできません。」

「基礎的な視覚の理論と手法は、携帯電話、医療画像分析、セキュリティ監視など、多くの分野で広く使用されています。画像やビデオ コンテンツの品質を重視する企業や機関は注意を払う必要があります。 「基礎となる視覚の方向性を研究します。基礎となる視覚が適切に行われていない場合、多くの高度な視覚システム (検出、認識、理解など) を真に実装することはできません。」

氏は、CSIG Enterprise Tour のイベント共有中にこう述べました。

この文をどう理解すればよいでしょうか?いくつかの例を見てみましょう:

OpenAI や Microsoft のデモで示されている理想的な状況とは異なり、現実世界の画像やテキストは変形、影、モアレ パターンなどの困難な形で常に存在しており、その後の認識と理解の難しさが増大します。 Guo Fengjun 氏のチームの目標は、初期段階でこれらの問題を解決することです。

この目的を達成するために、彼らはこのタスクを、関心領域 (RoI) 抽出、変形補正、画像修復 (影の除去、モアレなど)、品質向上 (シャープ化など)、鮮明度などのいくつかのモジュールに分割しました。 )など。

これらのテクノロジーを組み合わせると、非常に興味深いアプリケーションを作成できます。長年の探求の末、これらのモジュールは非常に良い結果を達成し、関連技術は同社のインテリジェントテキスト認識製品「スキャナー」に適用されました。

単語から表、そして章に至るまで、画像とテキストを段階的に読んでください。

画像が処理されたら、次のステップは上の画像とテキストの内容を識別することです。これも非常に細かい作業で、場合によっては「単語」単位で行うこともあります。

現実の多くのシナリオでは、文字が必ずしも標準化された印刷形式で表示されるわけではないため、文字認識に課題が生じます。

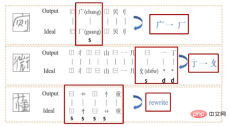

教育現場を例に挙げてみましょう。あなたが教師であると仮定すると、すべての生徒の宿題の添削を AI に直接支援してもらい、同時に生徒の知識の各部分の習得状況を要約してもらいたいと考えます。間違った質問、タイプミス、修正の提案も提供するのが最善です。 。中国科学技術大学音声言語情報処理国家工学研究室の Du Jun 准教授は、この分野の研究に取り組んでいます。

具体的には、文字全体のモデリングと比較して部首の組み合わせがはるかに少ないため、部首に基づいた漢字認識、生成、評価システムを作成しました。その中で、認識と生成は共同で最適化されます。これは、学生が学習する際の読み書き能力とライティング能力を相互に強化するプロセスに似ています。これまで、ほとんどの評価作業は文法レベルに焦点を当てていましたが、Du Jun 氏のチームは、画像から直接タイプミスを見つけて、エラーを詳細に説明できる方法を設計しました。この方法は、インテリジェント マーキングなどのシナリオで非常に役立ちます。

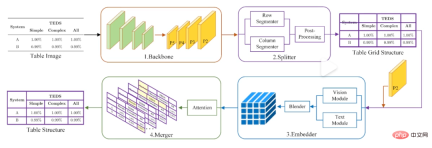

テキストに加えて、テーブルの識別と処理は、実際には大きな困難です。なぜなら、内部のコンテンツを識別するだけでなく、テーブル間の構造的関係を明確にする必要があるからです。また、一部の表にはワイヤーフレームさえない場合があります。この目的を達成するために、Du Jun 氏のチームは「最初にセグメントを作成してからマージする」方法を設計しました。つまり、最初にテーブル画像を一連の基本グリッドに分割し、次にマージによってさらに修正を加えます。

# Du Jun のチームの「最初にセグメント化してからマージする」フォーム認識方法。

もちろん、この作業はすべて、最終的には文書の構造化と章レベルでの理解に役割を果たします。実際の環境では、モデルが直面するほとんどのドキュメントは 1 ページ以上になります (論文など)。この方向において、Du Jun のチームの研究は、ページをまたがる文書要素の分類とページをまたがる文書構造の復元に焦点を当てています。ただし、これらの方法には、マルチレイアウトのシナリオでは依然として制限があります。

大規模モデル、マルチモダリティ、世界モデル...未来はどこにあるのでしょうか?

章レベルの画像とテキストの処理と理解について言えば、実際のところ、GPT-4 はそれほど遠くありません。 「マルチモーダル GPT-4 が登場した後、私たちもこれらの面で何かできないか考えていました」と Du Jun 氏はイベントで語った。画像やテキスト処理の分野の多くの研究者や実務家がこの考えを持っていると思います。

GPT シリーズ モデルの目標は、常に汎用性の向上に努め、最終的には汎用人工知能 (AGI) を実現することです。今回 GPT-4 によって実証された強力な画像およびテキスト理解機能は、この一般的な機能の重要な部分です。同様の機能を備えたモデルを作成するために、OpenAI はいくつかの参考資料を提供しましたが、多くの謎と未解決の問題も残しました。

まず第一に、GPT-4 の成功は、大規模モデルに対するマルチモーダル アプローチが実現可能であることを示しています。ただし、大規模モデルでどのような問題を研究する必要があるか、マルチモーダル モデルの過大な計算能力要件をどのように解決するかは、すべて研究者が直面している課題です。

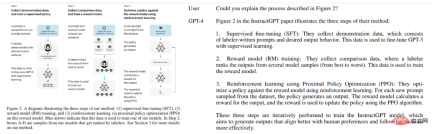

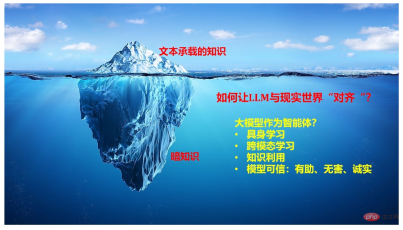

最初の質問については、復旦大学コンピューターサイエンス学部の教授であるQiu Xipeng氏が参考になる指示をいくつか出してくれました。 OpenAI によって以前に公開されたいくつかの情報によると、ChatGPT は、コンテキスト内学習、思考の連鎖、指示からの学習など、いくつかの主要なテクノロジーから切り離せないことがわかっています。 Qiu Xipeng 氏は、共有の中で、これらの能力がどこから来るのか、どのように向上し続けるか、既存の学習パラダイムを変革するためにそれらをどのように使用するかなど、これらの方向で議論すべき多くの問題がまだあると指摘しました。さらに、会話型の大規模言語モデルを構築する際に考慮すべき機能と、これらのモデルを現実世界と整合させるために考慮できる研究の方向性についても共有しました。

Nanqiang 特別教授 Ji Rongrong が重要なアイデアを提供してくれました。彼は、言語と視覚の間には自然なつながりがあり、両者を共同学習することが一般的な傾向であると信じています。しかし、この波の前では、大学や研究室の力は微々たるものです。そこで現在、同氏は勤務先のアモイ大学を起点として、コンピューティング能力を統合し、大規模なマルチモーダルモデルを構築するためのネットワークを形成するよう研究者を説得しようとしている。実際、少し前のイベントで、科学のための AI に焦点を当てている学者 E Weinan 氏も同様の見解を表明し、各界が「あえて独自のイノベーションの方向にリソースを共有する」ことを望んでいます。

しかし、GPT-4がたどった道は間違いなく一般的な人工知能につながるのでしょうか?これについては懐疑的な研究者もおり、チューリング賞受賞者のヤン・ルカン氏もその一人だ。彼は、これらの現在の大型モデルにはデータとコンピューティング能力に対する膨大な需要があるが、その学習効率は非常に低いと考えています (自動運転車など)。そこで、彼は「世界モデル」(つまり、世界がどのように機能するかの内部モデル)と呼ばれる理論を作成し、世界モデル(現実世界のシミュレーションを実行することと理解できます)を学習することが、 AGIを達成します。イベントでは、上海交通大学のYang Xiaokang教授がこの方向での取り組みを共有しました。具体的には、彼のチームは視覚直観の世界モデルに焦点を当て(視覚直観には大量の情報があるため)、視覚、直観、時間と空間の認識をモデル化しようとしました。最後に、同氏は、この種の研究においては数学、物理学、情報認知、コンピューター分野の交差点の重要性も強調した。

「イモムシは食物から栄養素を抽出し、その後蝶に変わります。人々は、GPT-4 が人間にとっての蝶であることを理解するために、何十億もの手がかりを抽出してきました。」 GPT-4 がリリースされた翌日、ジェフリー・ヒントンは、ディープラーニングの父はツイートした。

以上がGPT-4 が画像とテキストの読み取りを学習すると、生産性革命は止まらなくなりますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

1つのプロンプトは、すべての主要なLLMのセーフガードをバイパスできますApr 25, 2025 am 11:16 AM

1つのプロンプトは、すべての主要なLLMのセーフガードをバイパスできますApr 25, 2025 am 11:16 AMHiddenLayerの画期的な研究は、主要な大規模な言語モデル(LLMS)における重大な脆弱性を明らかにしています。 彼らの発見は、ほぼすべての主要なLLMSを回避できる「政策の人形劇」と呼ばれる普遍的なバイパス技術を明らかにしています

5つの間違いほとんどの企業が今年持続可能性を備えていますApr 25, 2025 am 11:15 AM

5つの間違いほとんどの企業が今年持続可能性を備えていますApr 25, 2025 am 11:15 AM環境責任と廃棄物の削減の推進は、企業の運営方法を根本的に変えています。 この変革は、製品開発、製造プロセス、顧客関係、パートナーの選択、および新しいものの採用に影響します

H20チップバンジョルツチャイナ企業ですが、彼らはインパクトのために長い間支えられてきましたApr 25, 2025 am 11:12 AM

H20チップバンジョルツチャイナ企業ですが、彼らはインパクトのために長い間支えられてきましたApr 25, 2025 am 11:12 AM高度なAIハードウェアに関する最近の制限は、AI優位のためのエスカレートする地政学的競争を強調し、中国の外国半導体技術への依存を明らかにしています。 2024年、中国は3,850億ドル相当の半導体を大量に輸入しました

OpenaiがChromeを購入すると、AIはブラウザ戦争を支配する場合がありますApr 25, 2025 am 11:11 AM

OpenaiがChromeを購入すると、AIはブラウザ戦争を支配する場合がありますApr 25, 2025 am 11:11 AMGoogleからのChromeの強制的な売却の可能性は、ハイテク業界での激しい議論に火をつけました。 Openaiが65%の世界市場シェアを誇る大手ブラウザを取得する見込みは、THの将来について重要な疑問を提起します

AIが小売メディアの成長する痛みをどのように解決できるかApr 25, 2025 am 11:10 AM

AIが小売メディアの成長する痛みをどのように解決できるかApr 25, 2025 am 11:10 AM全体的な広告の成長を上回っているにもかかわらず、小売メディアの成長は減速しています。 この成熟段階は、生態系の断片化、コストの上昇、測定の問題、統合の複雑さなど、課題を提示します。 ただし、人工知能

「aiは私たちであり、それは私たち以上のものです」Apr 25, 2025 am 11:09 AM

「aiは私たちであり、それは私たち以上のものです」Apr 25, 2025 am 11:09 AM古いラジオは、ちらつきと不活性なスクリーンのコレクションの中で静的なパチパチと鳴ります。簡単に不安定になっているこの不安定な電子機器の山は、没入型展示会の6つのインスタレーションの1つである「e-waste land」の核心を形成しています。

Google Cloudは、次の2025年にインフラストラクチャについてより深刻になりますApr 25, 2025 am 11:08 AM

Google Cloudは、次の2025年にインフラストラクチャについてより深刻になりますApr 25, 2025 am 11:08 AMGoogle Cloudの次の2025年:インフラストラクチャ、接続性、およびAIに焦点を当てています Google Cloudの次の2025年の会議では、多くの進歩を紹介しました。 特定の発表の詳細な分析については、私の記事を参照してください

Baby Ai Meme、Arcanaの550万ドルのAI映画パイプライン、IRの秘密の支援者が明らかにした話Apr 25, 2025 am 11:07 AM

Baby Ai Meme、Arcanaの550万ドルのAI映画パイプライン、IRの秘密の支援者が明らかにした話Apr 25, 2025 am 11:07 AM今週はAIとXR:AIを搭載した創造性の波が、音楽の世代から映画制作まで、メディアとエンターテイメントを席巻しています。 見出しに飛び込みましょう。 AIに生成されたコンテンツの影響力の高まり:テクノロジーコンサルタントのShelly Palme

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

DVWA

Damn Vulnerable Web App (DVWA) は、非常に脆弱な PHP/MySQL Web アプリケーションです。その主な目的は、セキュリティ専門家が法的環境でスキルとツールをテストするのに役立ち、Web 開発者が Web アプリケーションを保護するプロセスをより深く理解できるようにし、教師/生徒が教室環境で Web アプリケーションを教え/学習できるようにすることです。安全。 DVWA の目標は、シンプルでわかりやすいインターフェイスを通じて、さまざまな難易度で最も一般的な Web 脆弱性のいくつかを実践することです。このソフトウェアは、

ホットトピック

7722

7722 15

15 1642

1642 14

14 1396

1396 52

52 1289

1289 25

25 1233

1233 29

29