knn と K-means の違いは何ですか

- coldplay.xixiオリジナル

- 2020-12-17 15:17:4310690ブラウズ

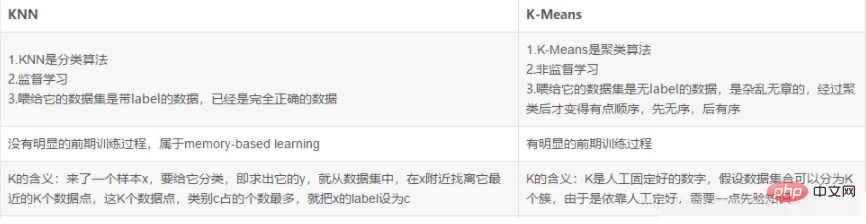

knn と k-means の違い: 1. [k-means] アルゴリズムは、典型的な距離ベースのクラスタリング アルゴリズムであり、距離が近いほど類似性の評価指標として使用されます。 2 つのオブジェクトは、類似性が高いほど高くなります; 2. knn アルゴリズムには明確な事前トレーニング プロセスがありません。プログラムの実行が開始されると、データ セットがメモリにロードされ、分類が始まります。

knn と K-means の違い:

1. K-means クラスタリング アルゴリズム プロセス原理

k-means アルゴリズム (k-means クラスタリング アルゴリズム) は、既知の数のクラスター カテゴリを持つ基本的な分割アルゴリズムです。距離ベースのクラスタリングアルゴリズムの代表的なもので、距離を類似性の評価指標として利用し、2つの物体の距離が近いほど類似性が高いと考えられます。これは、ユークリッド距離を使用して測定されます (簡単に理解すると、2 点間の直線距離です。ユークリッド距離は、この距離の定義を標準化し、N 次元に拡張するだけです)。大規模なデータセットを処理でき、効率的です。クラスタリングの結果は、k 個のカテゴリに分割された k データ セットです。クラスタリング結果の表現方法に従って、ハード K 平均法 (H CM) アルゴリズム、ファジー K 平均法アルゴリズム (F CM)、確率 K 平均法アルゴリズム (P CM) に分けることができます。

1.1. 基本的な考え方

これは、与えられたクラスタリング目的関数に基づいています. アルゴリズムは反復更新法を採用しています. 各反復プロセスは目的関数を減少させる方向に進みます.クラスタリングの結果により、目的関数が最小値を取得し、より良い分類効果が得られます。

1.2 原理

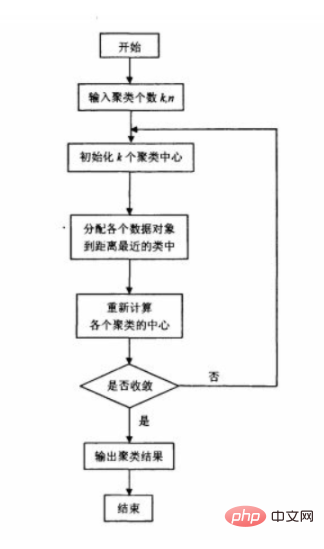

元の k 平均法アルゴリズムは、最初に初期クラスタリング中心として k 点をランダムに選択し、次に、各データ オブジェクトと各クラスター中心間の距離を計算し、データ オブジェクトをそれに最も近いクラスター中心のクラスに分類し、調整された新しいクラスの新しいクラスター中心を計算します。クラスター中心が 2 回隣接する場合、変化はありません。データオブジェクトの調整が完了し、クラスタリング基準関数 f が収束したことを意味します。反復のたびに、各サンプルの分類が正しいかどうかを確認する必要があり、正しくない場合は調整する必要があります。すべてのデータが調整された後、クラスターの中心が変更され、次の反復に入ります。すべてのデータ オブジェクトが反復アルゴリズムで正しく分類された場合、調整は行われず、クラスターの中心に変化はありません。これは、f が収束し、アルゴリズムが終了したことを示します。

1.3 アルゴリズムのフローチャート

1.4 アルゴリズムの初期点を選択するには?

1) バッチ内でできるだけ離れた K 点を選択します。

まず、最初の初期クラスター中心点として点をランダムに選択し、次にその点から最も遠い点を選択します。 2 番目の初期クラスターの中心点を選択し、最初の 2 点から最も近い距離を持つ点を 3 番目の初期クラスターの中心点として選択し、K 個の初期クラスター中心点が選択されるまで同様に続きます。

2) 初期クラスタリングに階層型クラスタリングまたはキャノピー アルゴリズムを選択し、これらのクラスタの中心点を K-Means アルゴリズムの初期クラスタ中心点として使用します。

1.5 アルゴリズムで k を選択する方法は?

想定するクラスターの数が実際のクラスター数以上である限り、インジケーターは非常にゆっくりと上昇し、実際のクラスター数よりも少ない数を取得しようとすると、インジケーターは上昇しなくなります。急上昇する、上昇する。クラスターインデックスは重要な参照インデックスとして機能します。

クラスターの直径は、クラスター内の任意の 2 点間の最大距離を指します。

クラスターの半径は、クラスター内のすべての点からクラスターの中心までの最大距離を指します。

1.6 メリット、デメリット、そして改善方法は?

ランダムな要素を使用するため、使い方は簡単ですが、最適なクラスを見つけることは保証できません。クラスターの数を適切に初期化する必要はありません。つまり、K を初期化する必要があります。

2. K 最近傍分類アルゴリズム (K N N)

2.1 この問題では、

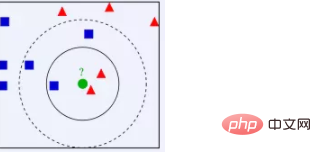

K N N : 上の図から、図にあるデータ セットは適切なデータであることがわかります。つまり、ラベルが付けられています。1 つは青い四角、もう 1 つは赤い三角形、そして緑の円です。機密データです。 K=3 の場合、緑の点に最も近い 2 つの赤い三角形と 1 つの青い正方形があります。これら 3 点が投票するため、分類される緑の点は赤い三角形に属します。K=5 の場合、2 つの赤い三角形があります。緑の点に最も近い青い四角が 1 つあります。最近、赤い三角形が 2 つと青い四角が 3 つあります。これらの 5 つの点が投票するため、分類される緑の点は青い四角に属します。つまり、サンプルが k 個の最も近いものの中にある場合特徴空間内の隣接するサンプルのほとんどは特定のカテゴリに属しており、サンプルもこのカテゴリに属します。 KNN が本質的に統計的手法に基づいていることがわかります。実際、多くの機械学習アルゴリズムもデータ統計に基づいています。

2.2 K N N アルゴリズム

はじめに

K N N は、K-Nearest Neighbor の略で、インスタンスベース学習とも呼ばれる記憶ベースの学習の一種で、遅延学習に属します。つまり、明確な事前トレーニング プロセスはなく、プログラムの実行開始時に、データ セットをメモリにロードした後、トレーニングは必要なく、分類を開始できます。 K N N も教師あり学習アルゴリズムで、新しいデータとトレーニング データの特徴量間の距離を計算し、分類 (投票方法) または回帰のために K (K>=1) 個の最近傍を選択します。 K=1 の場合、新しいデータは単にその最近傍のクラスに割り当てられます。

手順

1) テスト データと各トレーニング データの間の距離を計算します。ユークリッド距離公式を使用して計算できます。

2) 距離の増加関係に従って並べ替えます;

3) 距離が最小の K 点を選択します (k 値は自分で決定します)

4)最初の K 点が位置するカテゴリの出現頻度を決定します;

5) 最初の K 点の中で最も高い出現頻度を持つカテゴリを、テスト データの予測分類として返します。

特徴

ノンパラメトリック統計手法: パラメータ K の選択を導入する必要はありません: K = 1 の場合、分類されるサンプルはそれに最も近いサンプルのクラスに分類されます。 K = |の場合K は合理的に選択する必要があり、小さすぎると乱れやすく、大きすぎると計算量が増加します。アルゴリズムの複雑さ: 次元の呪い。次元数が増加すると、必要なトレーニング サンプルの数が急激に増加します。一般に次元削減が使用されます。

2.3 アルゴリズムの長所と短所

長所: シンプルで効果的

短所: 計算量が膨大。出力はあまり解釈可能ではありません。すべてのトレーニング サンプルを保存する必要があります。

3. K N N と k-means の違い

##関連する無料学習の推奨事項:php プログラミング# ##(ビデオ)#########

以上がknn と K-means の違いは何ですかの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。