word2vector 原理

- (*-*)浩オリジナル

- 2020-01-10 10:54:573521ブラウズ

単語を新しい空間にマッピングし、多次元の連続実数ベクトルとして表現することを「単語表現」または「単語埋め込み」と呼びます。

21 世紀以降、人々は単語ベクトルの元のスパース表現から、低次元空間での現在の高密度表現に徐々に移行してきました。

スパース表現を使用すると、実際の問題を解決するときに次元性の呪いに遭遇することがよくあり、意味情報を表現できず、単語間の潜在的なつながりを明らかにできません。

低次元空間表現の使用は、次元の呪いの問題を解決するだけでなく、単語間の関連する属性も調査し、それによってベクトル意味論の精度を向上させます。

word2vec 学習タスク

次のような文があるとします。検索エンジン グループは今日の 2 時にグループ ミーティングを開催します。

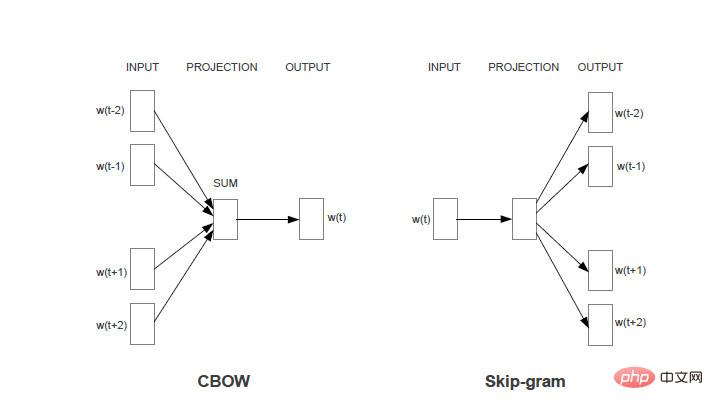

タスク 1: 各単語について、その単語の周囲の単語を使用して、現在の単語が生成される確率を予測します。たとえば、「今日、午後、検索、エンジン、グループ」を使用して「2 時」を生成します。

タスク 2: 各単語について、その単語自体を使用して、他の単語が生成される確率を予測します。たとえば、「2 時」を使用して「今日、午後、検索、エンジン、グループ」の各単語を生成します。

両方のタスクに共通の制限は、同じ入力に対して、各単語が出力される確率の合計は 1 であるということです。

Word2vec モデルは、機械学習を通じて上記のタスクの精度を向上させる方法です。 2 つのタスクはそれぞれ 2 つのモデル (CBOW とスキムグラム) に対応します。 特に指定のない限り、以下の分析にはタスク 1 に対応するモデル CBOW が使用されます。

スキムグラムモデルの分析手法も同様です。

Word 関連の技術記事の詳細については、Word チュートリアル 列にアクセスして学習してください。

以上がword2vector 原理の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。