requests は、Python で実装されたシンプルで使いやすい HTTP ライブラリです。サードパーティ ライブラリであるため、urllib

よりもはるかに簡単に使用できます。 , 使用前にcmdのインストールが必要です

pip install requests

インストールが完了したらインポートしてください、正常であれば使用開始可能ということです。

基本的な使用法:

requests.get() はターゲット Web サイトをリクエストするために使用されます。タイプは HTTPresponse タイプです。

import requests response = requests.get('http://www.baidu.com') print(response.status_code) # 打印状态码 print(response.url) # 打印请求url print(response.headers) # 打印头信息 print(response.cookies) # 打印cookie信息print(response.text) #以文本形式打印网页源码 print(response.content) #以字节流形式打印

実行結果:

ステータス コード: 200

さまざまなリクエスト メソッド:

import requests requests.get('http://httpbin.org/get') requests.post('http://httpbin.org/post') requests.put('http://httpbin.org/put') requests.delete('http://httpbin.org/delete') requests.head('http://httpbin.org/get') requests.options('http://httpbin.org/get')

基本的な get リクエスト

import requests response = requests.get('http://httpbin.org/get')print(response.text)

パラメータ付きの GET リクエスト:

最初のメソッドは次のとおりです。パラメータは URL

import requests response = requests.get(http://httpbin.org/get?name=gemey&age=22)print(response.text)

Parsing json

import requests response = requests.get('http://httpbin.org/get') print(response.text) print(response.json()) #response.json()方法同json.loads(response.text) print(type(response.json()))に直接配置されます

以上がPythonでリクエストモジュールをインストールする方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

python中CURL和python requests的相互转换如何实现May 03, 2023 pm 12:49 PM

python中CURL和python requests的相互转换如何实现May 03, 2023 pm 12:49 PMcurl和Pythonrequests都是发送HTTP请求的强大工具。虽然curl是一种命令行工具,可让您直接从终端发送请求,但Python的请求库提供了一种更具编程性的方式来从Python代码中发送请求。将curl转换为Pythonrequestscurl命令的基本语法如下所示:curl[OPTIONS]URL将curl命令转换为Python请求时,我们需要将选项和URL转换为Python代码。这是一个示例curlPOST命令:curl-XPOSThttps://example.com/api

Python爬虫Requests库怎么使用May 16, 2023 am 11:46 AM

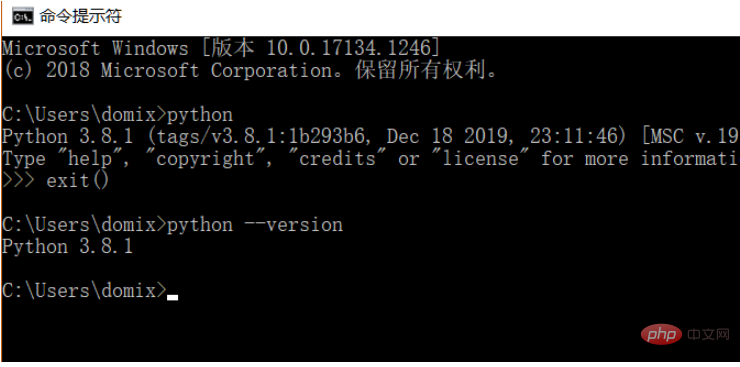

Python爬虫Requests库怎么使用May 16, 2023 am 11:46 AM1、安装requests库因为学习过程使用的是Python语言,需要提前安装Python,我安装的是Python3.8,可以通过命令python--version查看自己安装的Python版本,建议安装Python3.X以上的版本。安装好Python以后可以直接通过以下命令安装requests库。pipinstallrequestsPs:可以切换到国内的pip源,例如阿里、豆瓣,速度快为了演示功能,我这里使用nginx模拟了一个简单网站。下载好了以后,直接运行根目录下的nginx.exe程序就可

Python如何使用Requests请求网页Apr 25, 2023 am 09:29 AM

Python如何使用Requests请求网页Apr 25, 2023 am 09:29 AMRequests继承了urllib2的所有特性。Requests支持HTTP连接保持和连接池,支持使用cookie保持会话,支持文件上传,支持自动确定响应内容的编码,支持国际化的URL和POST数据自动编码。安装方式利用pip安装$pipinstallrequestsGET请求基本GET请求(headers参数和parmas参数)1.最基本的GET请求可以直接用get方法'response=requests.get("http://www.baidu.com/"

python requests post如何使用Apr 29, 2023 pm 04:52 PM

python requests post如何使用Apr 29, 2023 pm 04:52 PMpython模拟浏览器发送post请求importrequests格式request.postrequest.post(url,data,json,kwargs)#post请求格式request.get(url,params,kwargs)#对比get请求发送post请求传参分为表单(x-www-form-urlencoded)json(application/json)data参数支持字典格式和字符串格式,字典格式用json.dumps()方法把data转换为合法的json格式字符串次方法需要

使用Python的Requests和BeautifulSoup下载PDF文件Aug 30, 2023 pm 03:25 PM

使用Python的Requests和BeautifulSoup下载PDF文件Aug 30, 2023 pm 03:25 PMRequest和BeautifulSoup是可以在线下载任何文件或PDF的Python库。请求库用于发送HTTP请求和接收响应。BeautifulSoup库用于解析响应中收到的HTML并获取可下载的pdf链接。在本文中,我们将了解如何在Python中使用Request和BeautifulSoup下载PDF。安装依赖项在Python中使用BeautifulSoup和Request库之前,我们需要使用pip命令在系统中安装这些库。要安装request以及BeautifulSoup和Request库,

Python中使用Requests模块Sep 02, 2023 am 10:21 AM

Python中使用Requests模块Sep 02, 2023 am 10:21 AMRequests是一个Python模块,可用于发送各种HTTP请求。它是一个易于使用的库,具有许多功能,从在URL中传递参数到发送自定义标头和SSL验证。在本教程中,您将学习如何使用该库在Python中发送简单的HTTP请求。您可以在Python版本2.6–2.7和3.3–3.6中使用请求。在继续之前,您应该知道Requests是一个外部模块,因此在尝试本教程中的示例之前必须先安装它。您可以通过在终端中运行以下命令来安装它:pipinstallrequests安装模块后,您可以使用以下命令导入模

Python之requests怎么安装使用May 18, 2023 pm 07:49 PM

Python之requests怎么安装使用May 18, 2023 pm 07:49 PM1.准备工作首先呢,我们要确保我们已经之前安装requests库,如果没有安装,按照下面步骤按照库。pip安装无论是Windows、Linux还是Mac,都可以通过pip这个包管理工具来安装。在命令行下运行如下命令即可完成requests库的安装:pip3installrequests这是最简单的安装方式,推荐此种方法安装。验证安装为了验证库是否已经安装成功,可以在命令行下测试一下:importrequestsres=requests.get('https://www.baidu

Python爬虫之怎么使用BeautifulSoup和Requests抓取网页数据Apr 29, 2023 pm 12:52 PM

Python爬虫之怎么使用BeautifulSoup和Requests抓取网页数据Apr 29, 2023 pm 12:52 PM一、简介网络爬虫的实现原理可以归纳为以下几个步骤:发送HTTP请求:网络爬虫通过向目标网站发送HTTP请求(通常为GET请求)获取网页内容。在Python中,可以使用requests库发送HTTP请求。解析HTML:收到目标网站的响应后,爬虫需要解析HTML内容以提取有用信息。HTML是一种用于描述网页结构的标记语言,它由一系列嵌套的标签组成。爬虫可以根据这些标签和属性定位和提取需要的数据。在Python中,可以使用BeautifulSoup、lxml等库解析HTML。数据提取:解析HTML后,

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

MantisBT

Mantis は、製品の欠陥追跡を支援するために設計された、導入が簡単な Web ベースの欠陥追跡ツールです。 PHP、MySQL、Web サーバーが必要です。デモおよびホスティング サービスをチェックしてください。

ドリームウィーバー CS6

ビジュアル Web 開発ツール

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

PhpStorm Mac バージョン

最新(2018.2.1)のプロフェッショナル向けPHP統合開発ツール

ホットトピック

7415

7415 15

15 1359

1359 52

52