爬虫類とは何ですか?

- 若昕オリジナル

- 2019-04-24 13:49:414930ブラウズ

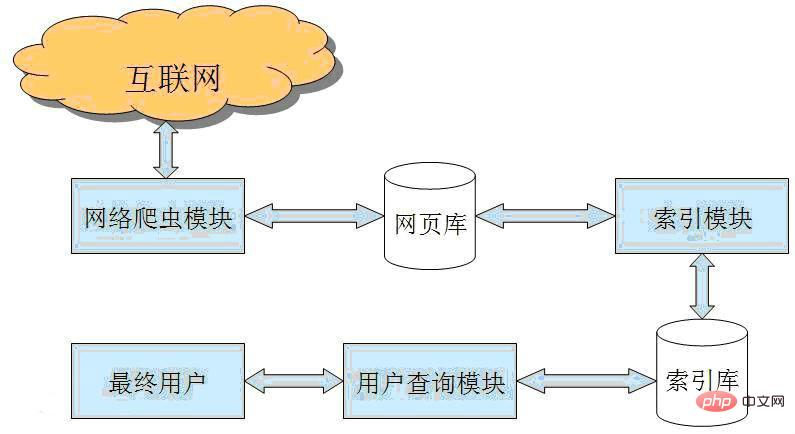

Web クローラーは、特定のルールに従って World Wide Web 情報を自動的にクロールするプログラムまたはスクリプトです。インターネット検索エンジンやその他の同様の Web サイトで広く使用されており、コンテンツを自動的に収集できます。これらの Web サイトのコンテンツと取得方法を取得または更新するためにアクセスできるすべてのページ。機能的に言えば、クローラは通常、データ収集、処理、保存の 3 つの部分に分かれています。

従来のクローラーは、1 つまたは複数の最初の Web ページの URL から開始し、最初の Web ページ上の URL を取得します。Web ページをクロールするプロセス中に、現在のページから新しい URL を継続的に抽出して配置します。システム要件が満たされるまでキューに入れられます 特定の停止条件。フォーカスされたクローラーのワークフローはより複雑で、特定の Web ページ分析アルゴリズムに基づいてトピックに無関係なリンクをフィルタリングし、有用なリンクを保持してクロールを待つ URL キューに入れる必要があります。次に、特定の検索戦略に従ってキューから次にクロールする Web ページの URL を選択し、システムが特定の条件に達して停止するまで上記のプロセスを繰り返します。さらに、クローラによってクロールされたすべての Web ページはシステムによって保存され、後続のクエリと取得のために特定の分析、フィルタリング、およびインデックス付けが行われます。焦点を絞ったクローラの場合、このプロセスで得られた分析結果は、フィードバックやガイダンスを提供することもあります。今後のクローリングプロセス。

以上が爬虫類とは何ですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。