ホームページ >バックエンド開発 >Python チュートリアル >クローラーの 403 問題を解決する方法

クローラーの 403 問題を解決する方法

- 零到壹度オリジナル

- 2018-04-03 11:25:247409ブラウズ

Python でクローラーを作成すると、html.getcode() で 403 禁止アクセスの問題が発生します。これは、Web サイトによる自動クローラーの禁止です。この記事では、Angular2 Advanced のクローラーの 403 問題を解決する方法を主に紹介します。編集者が非常に優れていると考えたので、参考として共有します。エディターをフォローして見てみましょう

この問題を解決するには、Python モジュール urllib2 モジュールを使用する必要があります

urllib2 モジュールは高度なクローラ クローリング モジュールです

たとえば、接続 url=http://blog.csdn.net/qysh123 の場合

この接続には 403 アクセス禁止の問題がある可能性があります

この問題を解決するには、次の手順が必要です:

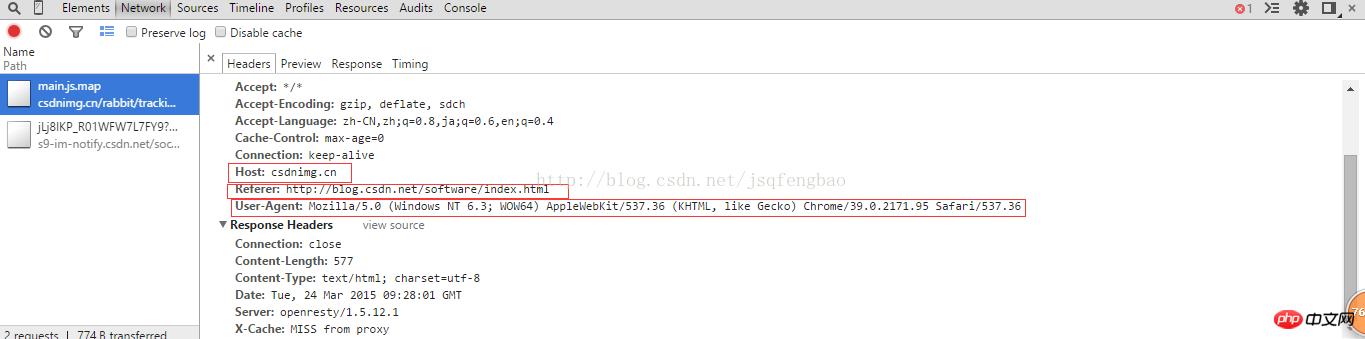

<span style="font-size:18px;">req = urllib2.Request(url)

req.add_header("User-Agent","Mozilla/5.0 (Windows NT 6.3; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.95 Safari/537.36")

req.add_header("GET",url)

req.add_header("Host","blog.csdn.net")

req.add_header("Referer","http://blog.csdn.net/")</span> User-Agent はブラウザ固有の属性です

その後、 html=urllib2.urlopen(req)

print html.read()

することで確認できます。Web ページのすべてのコードをダウンロードでき、403 禁止アクセスの問題はありません。

上記の問題については、将来簡単に使用できるように関数にカプセル化できます。特定のコード:

#-*-coding:utf-8-*- import urllib2 import random url="http://blog.csdn.net/qysh123/article/details/44564943" my_headers=["Mozilla/5.0 (Windows NT 6.3; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.95 Safari/537.36", "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_9_2) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/35.0.1916.153 Safari/537.36", "Mozilla/5.0 (Windows NT 6.1; WOW64; rv:30.0) Gecko/20100101 Firefox/30.0" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_9_2) AppleWebKit/537.75.14 (KHTML, like Gecko) Version/7.0.3 Safari/537.75.14", "Mozilla/5.0 (compatible; MSIE 10.0; Windows NT 6.2; Win64; x64; Trident/6.0)" ] def get_content(url,headers): ''''' @获取403禁止访问的网页 ''' randdom_header=random.choice(headers) req=urllib2.Request(url) req.add_header("User-Agent",randdom_header) req.add_header("Host","blog.csdn.net") req.add_header("Referer","http://blog.csdn.net/") req.add_header("GET",url) content=urllib2.urlopen(req).read() return content print get_content(url,my_headers)

ランダム関数を使用して、すでに作成されたブラウザを自動的に取得します。 User-Agent 情報については、カスタム関数に独自の Host、Referer、GET 情報などを記述する必要があります。これらの問題を解決すると、403 アクセス情報が表示されなくなります。

もちろん、アクセス頻度が速すぎる場合、一部の Web サイトは依然としてフィルタリングされます。この問題を解決するには、プロキシ IP 方式を使用する必要があります。 。 。具体的には自分で解決してください

関連する推奨事項: 403 禁止アクセス エラーを解決する

python3 HTTP エラー 403: Python Forbiddenクローラー 403 ソリューション

以上がクローラーの 403 問題を解決する方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。