モンステラピで微調整されたLLMSの力を活用:包括的なガイド

仮想アシスタントがあなたのニーズを完全に理解し、予測することを想像してください。これは、大規模な言語モデル(LLMS)の進歩のおかげで現実になりつつあります。ただし、このレベルのパーソナライズを達成するには、微調整が必要です。特定のタスクの汎用モデルを改良するプロセスです。 Monsterapiはこれを簡素化し、微調整と評価を効率的にアクセスしやすくします。このガイドは、MonsterapiがLLMSを改良および評価するのに役立ち、それらを独自のニーズに合わせた強力なツールに変換する方法を示しています。

主要な学習目標:

- Monsterapiプラットフォームを使用して、完全な微調整および評価ワークフローをマスターします。

- LLM出力の精度と一貫性を確保する上での評価の重要な役割を理解します。

- Monsterapiの開発者に優しい微調整および評価APIで実践的な経験を積む。

目次:

- 大規模な言語モデルの進化

- LLM微調整を理解する

- LLM評価の重要性

- モンステラピでLLMSを微調整して評価するための段階的なガイド

- よくある質問

大規模な言語モデルの進化:

近年、自然言語処理の分野内でLLMSの顕著な進歩が目撃されています。現在、多数のオープンソースとクローズドソースモデルが利用可能になり、研究者と開発者がAIの境界を押し広げることができます。これらのモデルは一般的なタスクに優れていますが、特定のアプリケーションのピーク精度とパーソナライズを達成するには微調整が必要です。

微調整は、事前に訓練されたモデルをカスタムデータセットを使用してドメイン固有のタスクに適応させます。このプロセスには、専用のデータセット、モデルトレーニング、そして最終的に展開が必要です。重要なことに、さまざまな関連タスクにわたってモデルの有効性を測定するには、徹底的な評価が必要です。 Monsterapiのllm_evalエンジンは、開発者と企業の微調整と評価の両方を簡素化します。その利点は次のとおりです。

- 自動化されたGPU環境構成。

- 最適なバッチサイズの最適化されたメモリ使用量。

- 特定のビジネスニーズのためのカスタマイズ可能なモデル構成。

- 重みとバイアスを使用したモデル実験追跡統合(WANDB)。

- ベンチマークモデルのパフォーマンスのための統合評価エンジン。

LLM微調整を理解する:

微調整は、カスタムデータセットでトレーニングすることにより、事前に訓練されたLLMを特定のタスクに合わせて調整します。このプロセスは、事前に訓練されたモデルの一般的な知識を活用しながら、新しいデータのニュアンスに適応させます。プロセスには次のものが含まれます。

- 事前に訓練されたモデルの選択:あなたのニーズに基づいて、適切な事前訓練モデル(Llama、SDXL、Claude、Gemmaなど)を選択します。

- データセットの準備:トレーニングに適した入出力形式でカスタムデータセットを収集、前処理、構造化します。

- モデルトレーニング:データセットで事前に訓練されたモデルをトレーニングし、そのパラメーターを調整して、新しいデータからパターンを学習します。 Monsterapiは、費用対効果の高い高度に最適化されたGPUを利用して、このプロセスを加速します。

- ハイパーパラメーターチューニング:最適なパフォーマンスのために、ハイパーパラメーター(バッチサイズ、学習率、エポックなど)を最適化します。

- 評価: MMLU、GSM8K、Truthfulqaなどのメトリックを使用して、微調整されたモデルのパフォーマンスを評価して、要件を満たしていることを確認します。 Monsterapiの統合評価APIは、このステップを簡素化します。

LLM評価の重要性:

LLM評価は、ターゲットタスクに対する微調整されたモデルのパフォーマンスと有効性を厳密に評価します。これにより、モデルが検証データセットの目的の精度、コヒーレンス、一貫性を確実に達成します。 MMLUやGSM8Kベンチマークのパフォーマンスなどのメトリックは、改善の領域を強調しています。 Monsterapiの評価エンジンは、このプロセスを導くための包括的なレポートを提供します。

モンステラピでLLMSを微調整し、評価するための段階的なガイド:

MonsterapiのLLM Fine-Tunerは、多くの選択肢よりも大幅に高速で費用対効果が高くなっています。テキスト生成、コード生成、画像生成など、さまざまなモデルタイプをサポートしています。このガイドは、テキスト生成に焦点を当てています。モンステラピは、さまざまなモデルサイズとハイパーパラメーターに対応するために、さまざまなRAM容量を備えたNVIDIA A100 GPUのネットワークを利用しています。

| プラットフォーム/サービスプロバイダー | モデル名 | 時間がかかる | 微調整のコスト |

|---|---|---|---|

| モンステラピ | ファルコン-7b | 27m 26秒 | 5-6ドル |

| モンステラピ | llama-7b | 115分 | 6ドル |

| MOSAICML | MPT-7B-Instruct | 2.3時間 | 37ドル |

| ヴァロハイ | ミストラル-7B | 3時間 | $ 1.5 |

| ミストラル | ミストラル-7B | 2〜3時間 | 4ドル |

ステップ1:セットアップとインストール:

必要なライブラリをインストールし、Monsterapiキーを取得します。

!ピップインストールMonsterapi == 1.0.8 OSをインポートします MonsterapiからMclientとしてインポートクライアントから #...(輸入明細書の残り) os.environ ['monster_api_key'] = 'your_monster_api_key'#キーに置き換えます client = mclient(api_key = os.environ.get( "monster_api_key"))

ステップ2:微調整ジョブを準備して起動します。

ベースモデル、LORAパラメーター、データセット、およびトレーニング設定を指定する起動ペイロードを作成します。

launch_payload = {

「PretrainedModel_Config」:{

「model_path」:「huggyllama/llama-7b」、

#...(構成の残り)

}、

「data_config」:{

「data_path」:「tatsu-lab/alpaca」、

#...(構成の残り)

}、

「Training_Config」:{

#...(トレーニングパラメーター)

}、

「logging_config」:{"use_wandb":false}

}

ret = client.finetune(service = "llm"、params = launch_payload)

deployment_id = ret.get( "deployment_id")

印刷(ret)

ステップ3:ジョブステータスとログを監視する:

status_ret = client.get_deployment_status(deployment_id) print(status_ret) logs_ret = client.get_deployment_logs(deployment_id) 印刷(logs_ret)

ステップ4:微調整されたモデルを評価します。

LLM評価APIを使用して、パフォーマンスを評価します。

url = "https://api.monsterapi.ai/v1/evaluation/llm"

ペイロード= {

「Eval_Engine」:「LM_EVAL」、

「basemodel_path」:base_model、#from launch_payload

「loramodel_path」:lora_model_path、#from Status_ret

「タスク」:「MMLU」

}

#...(評価コードの残り)

結論:

LLMSの微調整と評価は、高性能でタスク固有のモデルを作成するために重要です。 Monsterapiは、このプロセスに合理化された効率的なプラットフォームを提供し、包括的なパフォーマンスメトリックと洞察を提供します。モンステラピを活用することにより、開発者は独自のアプリケーションに合わせたカスタムLLMSを自信を持って構築および展開できます。

よくある質問:

Q1:LLMSの微調整と評価とは何ですか?

A1:微調整は、カスタムデータセットを使用して、事前に訓練されたLLMを特定のタスクに適応させます。評価は、品質を確保するために、ベンチマークに対するモデルのパフォーマンスを評価します。

Q2:MonsterapiはLLM微調整にどのように役立ちますか?

A2: Monsterapiは、最適化されたコンピューティングリソースを利用して、効率的で費用対効果の高いLLM微調整と評価のためにホストされたAPIを提供します。

Q3:どのデータセットタイプがサポートされていますか?

A3: Monsterapiは、選択したベースモデルに応じて、テキスト、コード、画像、ビデオなど、さまざまなデータセットタイプをサポートしています。

以上がモンステラピで大規模な言語モデルを微調整する方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

テスラのロブバンは、2024年のロボタクシティーザーの隠された宝石でしたApr 22, 2025 am 11:48 AM

テスラのロブバンは、2024年のロボタクシティーザーの隠された宝石でしたApr 22, 2025 am 11:48 AM2008年以来、私は共有ライドバンを擁護しました。これは、「Robotjitney」と呼ばれる「後に「Vansit」と呼ばれ、都市交通の未来として擁護しました。 私はこれらの車両を21世紀の次世代トランジットソリューション、スルパとして予見します

サムのクラブは領収書の小切手を排除し、小売を強化するためにAIに賭けますApr 22, 2025 am 11:29 AM

サムのクラブは領収書の小切手を排除し、小売を強化するためにAIに賭けますApr 22, 2025 am 11:29 AMチェックアウトエクスペリエンスに革命をもたらす Sam's Clubの革新的な「Just Go」システムは、既存のAIを搭載した「スキャン&ゴー」テクノロジーに基づいて構築され、ショッピング旅行中にメンバーがサムズクラブアプリを介して購入をスキャンできるようになりました。

NvidiaのAI OmniverseはGTC 2025で拡大しますApr 22, 2025 am 11:28 AM

NvidiaのAI OmniverseはGTC 2025で拡大しますApr 22, 2025 am 11:28 AMGTC 2025でのNvidiaの強化された予測可能性と新製品のラインナップ AIインフラストラクチャの重要なプレーヤーであるNvidiaは、クライアントの予測可能性の向上に焦点を当てています。 これには、一貫した製品配信、パフォーマンスの期待を満たすこと、および

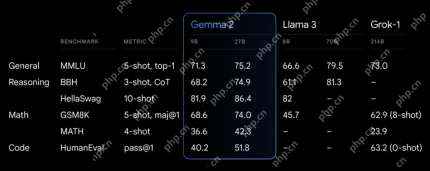

Google'のGemma 2モデルの機能を調査しますApr 22, 2025 am 11:26 AM

Google'のGemma 2モデルの機能を調査しますApr 22, 2025 am 11:26 AMGoogleのGemma 2:強力で効率的な言語モデル 効率とパフォーマンスで祝われるGoogleのGemmaファミリーは、Gemma 2の到着とともに拡大しました。この最新リリースは2つのモデルで構成されています。

genaiの次の波:Kirk Borne博士との展望-AnalyticsVidhyaApr 22, 2025 am 11:21 AM

genaiの次の波:Kirk Borne博士との展望-AnalyticsVidhyaApr 22, 2025 am 11:21 AMデータエピソードを率いるこの主要なのは、主要なデータサイエンティスト、天体物理学者、TEDXスピーカーであるカークボーン博士を特徴としています。 ビッグデータ、AI、および機械学習の有名な専門家であるボルネ博士は、現在の状態と将来のトラジェについて非常に貴重な洞察を提供しています

ランナーとアスリート向けのAI:私たちは素晴らしい進歩を遂げていますApr 22, 2025 am 11:12 AM

ランナーとアスリート向けのAI:私たちは素晴らしい進歩を遂げていますApr 22, 2025 am 11:12 AMこのスピーチには、人工知能が人々の運動をサポートするのに非常に優れている理由を示すエンジニアリングに関するバックグラウンド情報には、非常に洞察に満ちた視点がいくつかありました。 各寄稿者の観点からコアアイデアを概説し、スポーツにおける人工知能の適用の調査の重要な部分である3つの設計側面を実証します。 エッジデバイスと生の個人データ 人工知能に関するこのアイデアには、実際には2つのコンポーネントが含まれています。1つは大きな言語モデルを配置する場所に関連しており、もう1つは人間の言語と、リアルタイムで測定したときにバイタルサインが「表現」する言語の違いに関連しています。 アレクサンダー・アミニはランニングとテニスについて多くのことを知っていますが、彼はまだ

Caterpillarでのテクノロジー、才能、変革に関するJamie EngstromApr 22, 2025 am 11:10 AM

Caterpillarでのテクノロジー、才能、変革に関するJamie EngstromApr 22, 2025 am 11:10 AMCaterpillarの最高情報責任者であり、その上級副社長であるJamie Engstromは、28か国の2,200人以上のITプロフェッショナルのグローバルチームを率いています。 彼女の現在の役割で4年半を含むCaterpillarで26年間、Engst

新しいGoogleフォトの更新は、ウルトラHDR品質の写真をポップにしますApr 22, 2025 am 11:09 AM

新しいGoogleフォトの更新は、ウルトラHDR品質の写真をポップにしますApr 22, 2025 am 11:09 AMGoogle Photosの新しいUltra HDRツール:クイックガイド Google Photosの新しいUltra HDRツールで写真を強化し、標準画像を活気に満ちた高ダイナミックレンジの傑作に変換します。ソーシャルメディアに最適なこのツールは、あらゆる写真の影響を高め、

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

WebStorm Mac版

便利なJavaScript開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン