この記事では、重要な自然言語処理(NLP)タスクであるエンティティ抽出における小言語モデル(SLM)の機能について説明します。 Gemma 2B、Llama 3.2(1Bおよび3Bバージョン)、およびQwen 7Bのパフォーマンスを、非構造化テキスト内の人、組織、場所などのエンティティを特定および分類します。 この記事では、従来の方法よりもSLMの利点を強調し、文脈上の理解と効率を強調しています。

エンティティ抽出にSLMを使用することの中心的な利点は、単語を取り巻くコンテキストを解釈する能力であり、ルールベースまたは古い機械学習アプローチと比較してより正確なエンティティ識別につながることです。この文脈的認識は、あいまいな用語によって引き起こされるエラーを大幅に削減します。

この記事では、各SLMの詳細な概要を説明しています:

- gemma 2b:

- 20億パラメーター、8192トークンコンテキストの長さ、デコーダーのみの変圧器アーキテクチャを備えたGoogleが開発したモデル。 そのトレーニングデータには、Webドキュメント、コード、数学テキストが含まれています。

llama 3.2(1b&3b): Metaの多言語モデルは、それぞれ12億3,000万と32億パラメーターのバージョンを提供します。 どちらもコンテキストの長さ128,000トークンを誇り、多言語の対話に最適化されています。

-

QWEN 7B:

Alibaba Cloudのモデルは、70億パラメーターと8,192のトークンコンテキストの長さを備えています。また、デコーダーのみのトランスアーキテクチャも採用しています -

Google ColabとOllamaを使用した実用的なデモは、実装と評価プロセスを紹介しています。 この記事では、関連する手順の詳細:ライブラリのインストール、オラマの実行、データの取得、モデルの呼び出し。 各モデルからのサンプル出力は視覚的に表示されます 厳密な評価フレームワークについて説明し、異なるカテゴリ(プロジェクト、会社、人)にわたるエンティティ抽出の正確性に焦点を当てています。 比較表は、各モデルのパフォーマンスをまとめたものであり、Gemma 2Bが全体的に最も正確であることを明らかにしますが、Llama 3.2 3bは人々を識別する際の強度を示しています。 結論は、エンティティ抽出におけるSLMSの優れたパフォーマンスを繰り返し、文脈的理解と適応性の重要性を強調しています。 この記事は、SLMSと説明した特定のモデルに関する一般的な質問に対処するFAQセクションで締めくくります。

(注:画像URLは変わらないままです。記事のコアコンテンツは、元の意味と構造を維持しながら言い換えられています。モデルのパフォーマンスを要約するテーブルも保持されます。

以上がGemma 2b vs llama 3.2 vs qwen 7bの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

テスラのロブバンは、2024年のロボタクシティーザーの隠された宝石でしたApr 22, 2025 am 11:48 AM

テスラのロブバンは、2024年のロボタクシティーザーの隠された宝石でしたApr 22, 2025 am 11:48 AM2008年以来、私は共有ライドバンを擁護しました。これは、「Robotjitney」と呼ばれる「後に「Vansit」と呼ばれ、都市交通の未来として擁護しました。 私はこれらの車両を21世紀の次世代トランジットソリューション、スルパとして予見します

サムのクラブは領収書の小切手を排除し、小売を強化するためにAIに賭けますApr 22, 2025 am 11:29 AM

サムのクラブは領収書の小切手を排除し、小売を強化するためにAIに賭けますApr 22, 2025 am 11:29 AMチェックアウトエクスペリエンスに革命をもたらす Sam's Clubの革新的な「Just Go」システムは、既存のAIを搭載した「スキャン&ゴー」テクノロジーに基づいて構築され、ショッピング旅行中にメンバーがサムズクラブアプリを介して購入をスキャンできるようになりました。

NvidiaのAI OmniverseはGTC 2025で拡大しますApr 22, 2025 am 11:28 AM

NvidiaのAI OmniverseはGTC 2025で拡大しますApr 22, 2025 am 11:28 AMGTC 2025でのNvidiaの強化された予測可能性と新製品のラインナップ AIインフラストラクチャの重要なプレーヤーであるNvidiaは、クライアントの予測可能性の向上に焦点を当てています。 これには、一貫した製品配信、パフォーマンスの期待を満たすこと、および

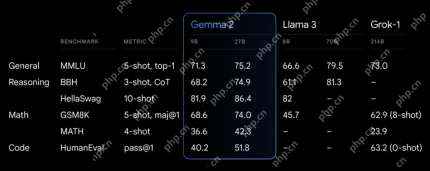

Google'のGemma 2モデルの機能を調査しますApr 22, 2025 am 11:26 AM

Google'のGemma 2モデルの機能を調査しますApr 22, 2025 am 11:26 AMGoogleのGemma 2:強力で効率的な言語モデル 効率とパフォーマンスで祝われるGoogleのGemmaファミリーは、Gemma 2の到着とともに拡大しました。この最新リリースは2つのモデルで構成されています。

genaiの次の波:Kirk Borne博士との展望-AnalyticsVidhyaApr 22, 2025 am 11:21 AM

genaiの次の波:Kirk Borne博士との展望-AnalyticsVidhyaApr 22, 2025 am 11:21 AMデータエピソードを率いるこの主要なのは、主要なデータサイエンティスト、天体物理学者、TEDXスピーカーであるカークボーン博士を特徴としています。 ビッグデータ、AI、および機械学習の有名な専門家であるボルネ博士は、現在の状態と将来のトラジェについて非常に貴重な洞察を提供しています

ランナーとアスリート向けのAI:私たちは素晴らしい進歩を遂げていますApr 22, 2025 am 11:12 AM

ランナーとアスリート向けのAI:私たちは素晴らしい進歩を遂げていますApr 22, 2025 am 11:12 AMこのスピーチには、人工知能が人々の運動をサポートするのに非常に優れている理由を示すエンジニアリングに関するバックグラウンド情報には、非常に洞察に満ちた視点がいくつかありました。 各寄稿者の観点からコアアイデアを概説し、スポーツにおける人工知能の適用の調査の重要な部分である3つの設計側面を実証します。 エッジデバイスと生の個人データ 人工知能に関するこのアイデアには、実際には2つのコンポーネントが含まれています。1つは大きな言語モデルを配置する場所に関連しており、もう1つは人間の言語と、リアルタイムで測定したときにバイタルサインが「表現」する言語の違いに関連しています。 アレクサンダー・アミニはランニングとテニスについて多くのことを知っていますが、彼はまだ

Caterpillarでのテクノロジー、才能、変革に関するJamie EngstromApr 22, 2025 am 11:10 AM

Caterpillarでのテクノロジー、才能、変革に関するJamie EngstromApr 22, 2025 am 11:10 AMCaterpillarの最高情報責任者であり、その上級副社長であるJamie Engstromは、28か国の2,200人以上のITプロフェッショナルのグローバルチームを率いています。 彼女の現在の役割で4年半を含むCaterpillarで26年間、Engst

新しいGoogleフォトの更新は、ウルトラHDR品質の写真をポップにしますApr 22, 2025 am 11:09 AM

新しいGoogleフォトの更新は、ウルトラHDR品質の写真をポップにしますApr 22, 2025 am 11:09 AMGoogle Photosの新しいUltra HDRツール:クイックガイド Google Photosの新しいUltra HDRツールで写真を強化し、標準画像を活気に満ちた高ダイナミックレンジの傑作に変換します。ソーシャルメディアに最適なこのツールは、あらゆる写真の影響を高め、

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

PhpStorm Mac バージョン

最新(2018.2.1)のプロフェッショナル向けPHP統合開発ツール

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

WebStorm Mac版

便利なJavaScript開発ツール

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

メモ帳++7.3.1

使いやすく無料のコードエディター