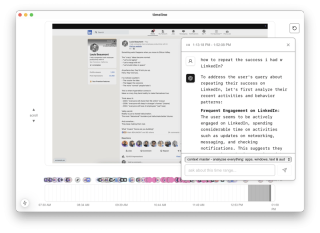

スクリーンパイプ: 24 時間年中無休の画面とマイクの録音、OCR、文字起こし、AI 統合のための CLI/アプリ

Screenpipe は、画面とマイクのアクティビティを継続的に記録し、光学式文字認識 (OCR) データを抽出し、文字起こしを生成し、このデータを AI モデルに供給するプロセスを簡素化するコマンドライン インターフェイス (CLI) アプリケーションです。 柔軟なパイプ システムにより、キャプチャされた画面やオーディオ情報と対話する強力なプラグインを作成できます。この例では、Ollama を活用して画面アクティビティを分析する単純なパイプを構築する方法を示します。

前提条件:

- スクリーンパイプがインストールされ、実行されています。

- パンがインストールされました (

npm install -g bun)。 - モデルとともにインストールされた Ollama (この例では DeepSeek-r1:1.5b が使用されています)。

1.パイプの作成:

CLI を使用して新しいスクリーンパイプ パイプを作成します。

bunx @screenpipe/create-pipe@latest

プロンプトに従ってパイプに名前を付け (例: 「my-activity-analyzer」)、ディレクトリを選択します。

2.プロジェクトのセットアップ:

好みのエディター (カーソル、VS コードなど) でプロジェクトを開きます。

cursor my-activity-analyzer

初期のプロジェクト構造には複数のファイルが含まれます。 この例では、不要なファイルを削除します:

rm -rf src/app/api/intelligence src/components/obsidian-settings.tsx src/components/file-suggest-textarea.tsx

3.分析 Cron ジョブの実装:

次のコードで src/app/api/analyze/route.ts を作成します:

import { NextResponse } from "next/server";

import { pipe } from "@screenpipe/js";

import { streamText } from "ai";

import { ollama } from "ollama-ai-provider";

export async function POST(request: Request) {

try {

const { messages, model } = await request.json();

console.log("model:", model);

const fiveMinutesAgo = new Date(Date.now() - 5 * 60 * 1000).toISOString();

const results = await pipe.queryScreenpipe({

startTime: fiveMinutesAgo,

limit: 10,

contentType: "all",

});

const provider = ollama(model);

const result = streamText({

model: provider,

messages: [

...messages,

{

role: "user",

content: `Analyze this activity data and summarize what I've been doing: ${JSON.stringify(results)}`,

},

],

});

return result.toDataStreamResponse();

} catch (error) {

console.error("error:", error);

return NextResponse.json({ error: "Failed to analyze activity" }, { status: 500 });

}

}

4. pipe.json スケジュール設定:

pipe.json を作成または変更して cron ジョブを含めます:

{

"crons": [

{

"path": "/api/analyze",

"schedule": "*/5 * * * *" // Runs every 5 minutes

}

]

}

5.メインページの更新 (src/app/page.tsx):

"use client";

import { useState } from "react";

import { Button } from "@/components/ui/button";

import { OllamaModelsList } from "@/components/ollama-models-list";

import { Label } from "@/components/ui/label";

import { useChat } from "ai/react";

export default function Home() {

const [selectedModel, setSelectedModel] = useState("deepseek-r1:1.5b");

const { messages, input, handleInputChange, handleSubmit } = useChat({

body: { model: selectedModel },

api: "/api/analyze",

});

return (

<main className="p-4 max-w-2xl mx-auto space-y-4">

<div className="space-y-2">

<label htmlFor="model">Ollama Model</label>

<OllamaModelsList defaultValue={selectedModel} onChange={setSelectedModel} />

</div>

<div>

{messages.map((message) => (

<div key={message.id}>

<div>{message.role === "user" ? "User: " : "AI: "}</div>

<div>{message.content}</div>

</div>

))}

</div>

</main>

);

}

6.ローカルテスト:

パイプをローカルで実行します:

bun i // or npm install bun dev

http://localhost:3000 でアプリケーションにアクセスします。

7.スクリーンパイプのインストール:

パイプをスクリーンパイプに取り付けます:

- UI: Screenpipe アプリを開き、「パイプ」セクションに移動して「」をクリックし、パイプへのローカル パスを指定します。

-

CLI:

screenpipe install /path/to/my-activity-analyzer screenpipe enable my-activity-analyzer

仕組み:

-

データ クエリ:

pipe.queryScreenpipe()は、最近の画面および音声データを取得します。 - AI 処理: Ollama はプロンプトを使用してデータを分析します。

- UI: シンプルなインターフェースに分析結果が表示されます。

- スケジュール: Screenpipe の cron ジョブは 5 分ごとに分析を実行します。

次のステップ:

- 構成オプションを追加します。

- 外部サービスと統合します。

- より洗練された UI コンポーネントを実装します。

参考文献:

- スクリーンパイプのドキュメント。

- スクリーンパイプ パイプの例。

- スクリーンパイプ SDK リファレンス

以上が画面とマイクを利用した AI エージェントを作成する方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

JavaScriptの文字列文字を交換しますMar 11, 2025 am 12:07 AM

JavaScriptの文字列文字を交換しますMar 11, 2025 am 12:07 AMJavaScript文字列置換法とFAQの詳細な説明 この記事では、javaScriptの文字列文字を置き換える2つの方法について説明します:内部JavaScriptコードとWebページの内部HTML。 JavaScriptコード内の文字列を交換します 最も直接的な方法は、置換()メソッドを使用することです。 str = str.replace( "find"、 "置換"); この方法は、最初の一致のみを置き換えます。すべての一致を置き換えるには、正規表現を使用して、グローバルフラグGを追加します。 str = str.replace(/fi

jQuery日付が有効かどうかを確認しますMar 01, 2025 am 08:51 AM

jQuery日付が有効かどうかを確認しますMar 01, 2025 am 08:51 AM単純なJavaScript関数は、日付が有効かどうかを確認するために使用されます。 関数isvaliddate(s){ var bits = s.split( '/'); var d = new Date(bits [2] '/' bits [1] '/'ビット[0]); return !!(d &&(d.getmonth()1)== bits [1] && d.getdate()== number(bits [0])); } //テスト var

jQueryは要素のパディング/マージンを取得しますMar 01, 2025 am 08:53 AM

jQueryは要素のパディング/マージンを取得しますMar 01, 2025 am 08:53 AMこの記事では、jQueryを使用して、DOM要素の内側のマージン値とマージン値、特に外側の縁と要素の内側の縁の特定の位置を取得して設定する方法について説明します。 CSSを使用して要素の内側と外側の縁を設定することは可能ですが、正確な値を取得するのは難しい場合があります。 // 設定 $( "div.header")。css( "margin"、 "10px"); $( "div.header")。css( "padding"、 "10px"); このコードはそうだと思うかもしれません

10 jQuery AccordionsタブMar 01, 2025 am 01:34 AM

10 jQuery AccordionsタブMar 01, 2025 am 01:34 AMこの記事では、10個の例外的なjQueryタブとアコーディオンについて説明します。 タブとアコーディオンの重要な違いは、コンテンツパネルの表示方法と非表示にあります。これらの10の例を掘り下げましょう。 関連記事:10 jQueryタブプラグイン

10 jqueryプラグインをチェックする価値がありますMar 01, 2025 am 01:29 AM

10 jqueryプラグインをチェックする価値がありますMar 01, 2025 am 01:29 AMウェブサイトのダイナミズムと視覚的な魅力を高めるために、10の例外的なjQueryプラグインを発見してください!このキュレーションされたコレクションは、画像アニメーションからインタラクティブなギャラリーまで、多様な機能を提供します。これらの強力なツールを探りましょう。 関連投稿: 1

ノードとHTTPコンソールを使用したHTTPデバッグMar 01, 2025 am 01:37 AM

ノードとHTTPコンソールを使用したHTTPデバッグMar 01, 2025 am 01:37 AMHTTP-Consoleは、HTTPコマンドを実行するためのコマンドラインインターフェイスを提供するノードモジュールです。 Webサーバー、Web Servに対して作成されているかどうかに関係なく、HTTPリクエストで何が起こっているかをデバッグして正確に確認するのに最適です

カスタムGoogle検索APIセットアップチュートリアルMar 04, 2025 am 01:06 AM

カスタムGoogle検索APIセットアップチュートリアルMar 04, 2025 am 01:06 AMこのチュートリアルでは、カスタムGoogle検索APIをブログまたはWebサイトに統合する方法を示し、標準のWordPressテーマ検索関数よりも洗練された検索エクスペリエンスを提供します。 驚くほど簡単です!検索をyに制限することができます

jQueryはscrollbarをdivに追加しますMar 01, 2025 am 01:30 AM

jQueryはscrollbarをdivに追加しますMar 01, 2025 am 01:30 AM次のjQueryコードスニペットを使用して、Divコンテンツがコンテナ要素領域を超えたときにスクロールバーを追加できます。 (デモンストレーションはありません、それを直接firebugにコピーしてください) // d =ドキュメント // w =ウィンドウ // $ = jQuery var contentarea = $(this)、 wintop = contentarea.scrolltop()、 docheight = $(d).height()、 winheight = $(w).height()、 divheight = $( '#c

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

SublimeText3 中国語版

中国語版、とても使いやすい

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

MantisBT

Mantis は、製品の欠陥追跡を支援するために設計された、導入が簡単な Web ベースの欠陥追跡ツールです。 PHP、MySQL、Web サーバーが必要です。デモおよびホスティング サービスをチェックしてください。

ドリームウィーバー CS6

ビジュアル Web 開発ツール

DVWA

Damn Vulnerable Web App (DVWA) は、非常に脆弱な PHP/MySQL Web アプリケーションです。その主な目的は、セキュリティ専門家が法的環境でスキルとツールをテストするのに役立ち、Web 開発者が Web アプリケーションを保護するプロセスをより深く理解できるようにし、教師/生徒が教室環境で Web アプリケーションを教え/学習できるようにすることです。安全。 DVWA の目標は、シンプルでわかりやすいインターフェイスを通じて、さまざまな難易度で最も一般的な Web 脆弱性のいくつかを実践することです。このソフトウェアは、