このチュートリアルでは、LLMOps のベスト プラクティスを使用して、本番環境に対応した AI プル リクエスト レビューアーを構築する方法を示します。 こちらからアクセスできる最後のアプリケーションは、公開 PR URL を受け入れ、AI によって生成されたレビューを返します。

アプリケーションの概要

このチュートリアルの内容は次のとおりです。

- コード開発: GitHub から PR の差分を取得し、LLM 対話に LiteLLM を活用します。

- 可観測性: アプリケーションの監視とデバッグのために Agenta を実装します。

- プロンプト エンジニアリング: Agenta のプレイグラウンドを使用してプロンプトとモデルの選択を繰り返します。

- LLM 評価: 迅速なモデル評価のために、裁判官として LLM を採用します。

- デプロイ: アプリケーションを API としてデプロイし、v0.dev でシンプルな UI を作成します。

コアロジック

AI アシスタントのワークフローはシンプルです。PR URL を指定すると、GitHub から差分を取得し、レビューのために LLM に送信します。

GitHub の差分には次の方法でアクセスします:

<code>https://patch-diff.githubusercontent.com/raw/{owner}/{repo}/pull/{pr_number}.diff</code>

この Python 関数は差分を取得します:

def get_pr_diff(pr_url):

# ... (Code remains the same)

return response.text

LiteLLM は LLM のやり取りを容易にし、さまざまなプロバイダーにわたって一貫したインターフェイスを提供します。

prompt_system = """

You are an expert Python developer performing a file-by-file review of a pull request. You have access to the full diff of the file to understand the overall context and structure. However, focus on reviewing only the specific hunk provided.

"""

prompt_user = """

Here is the diff for the file:

{diff}

Please provide a critique of the changes made in this file.

"""

def generate_critique(pr_url: str):

diff = get_pr_diff(pr_url)

response = litellm.completion(

model=config.model,

messages=[

{"content": config.system_prompt, "role": "system"},

{"content": config.user_prompt.format(diff=diff), "role": "user"},

],

)

return response.choices[0].message.content

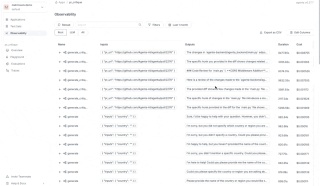

Agenta による可観測性の実装

Agenta は可観測性を強化し、入力、出力、データ フローを追跡してデバッグを容易にします。

Agenta を初期化し、LiteLLM コールバックを構成します:

import agenta as ag ag.init() litellm.callbacks = [ag.callbacks.litellm_handler()]

Agenta デコレータを使用したインストゥルメント機能:

@ag.instrument()

def generate_critique(pr_url: str):

# ... (Code remains the same)

return response.choices[0].message.content

AGENTA_API_KEY 環境変数 (Agenta から取得) を設定し、オプションでセルフホスティング用の AGENTA_HOST を設定します。

LLM プレイグラウンドの作成

Agenta のカスタム ワークフロー機能は、反復開発のための IDE のようなプレイグラウンドを提供します。 次のコード スニペットは、構成と Agenta との統合を示しています:

from pydantic import BaseModel, Field

from typing import Annotated

import agenta as ag

import litellm

from agenta.sdk.assets import supported_llm_models

# ... (previous code)

class Config(BaseModel):

system_prompt: str = prompt_system

user_prompt: str = prompt_user

model: Annotated[str, ag.MultipleChoice(choices=supported_llm_models)] = Field(default="gpt-3.5-turbo")

@ag.route("/", config_schema=Config)

@ag.instrument()

def generate_critique(pr_url:str):

diff = get_pr_diff(pr_url)

config = ag.ConfigManager.get_from_route(schema=Config)

response = litellm.completion(

model=config.model,

messages=[

{"content": config.system_prompt, "role": "system"},

{"content": config.user_prompt.format(diff=diff), "role": "user"},

],

)

return response.choices[0].message.content

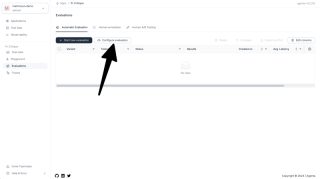

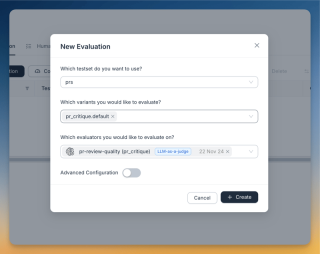

Agenta によるサービスの提供と評価

- アプリ名と API キーを指定して

agenta initを実行します。 -

agenta variant serve app.pyを実行します。

これにより、エンドツーエンドのテストのために Agenta のプレイグラウンドを通じてアプリケーションにアクセスできるようになります。 評価には LLM-as-a-judge が使用されます。 評価者のプロンプトは次のとおりです:

<code>You are an evaluator grading the quality of a PR review. CRITERIA: ... (criteria remain the same) ANSWER ONLY THE SCORE. DO NOT USE MARKDOWN. DO NOT PROVIDE ANYTHING OTHER THAN THE NUMBER</code>

評価者のユーザープロンプト:

<code>https://patch-diff.githubusercontent.com/raw/{owner}/{repo}/pull/{pr_number}.diff</code>

デプロイメントとフロントエンド

導入は Agenta の UI を通じて行われます:

- 概要ページに移動します。

- 選択したバリアントの横にある 3 つの点をクリックします。

- 「本番環境へのデプロイ」を選択します。

迅速な UI 作成には v0.dev フロントエンドが使用されました。

次のステップと結論

将来の改善には、プロンプト改良、完全なコードコンテキストの組み込み、大きな差分の処理が含まれます。 このチュートリアルでは、Agenta と LiteLLM を使用して本番環境に対応した AI プル リクエスト レビューアーを構築、評価、デプロイする方法を示します。

以上がvev、litellm、Agenta を使用して AI コード レビュー アシスタントを構築するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

LinuxターミナルでPythonバージョンを表示するときに発生する権限の問題を解決する方法は?Apr 01, 2025 pm 05:09 PM

LinuxターミナルでPythonバージョンを表示するときに発生する権限の問題を解決する方法は?Apr 01, 2025 pm 05:09 PMLinuxターミナルでPythonバージョンを表示する際の許可の問題の解決策PythonターミナルでPythonバージョンを表示しようとするとき、Pythonを入力してください...

HTMLを解析するために美しいスープを使用するにはどうすればよいですか?Mar 10, 2025 pm 06:54 PM

HTMLを解析するために美しいスープを使用するにはどうすればよいですか?Mar 10, 2025 pm 06:54 PMこの記事では、Pythonライブラリである美しいスープを使用してHTMLを解析する方法について説明します。 find()、find_all()、select()、およびget_text()などの一般的な方法は、データ抽出、多様なHTML構造とエラーの処理、および代替案(SEL

TensorflowまたはPytorchで深い学習を実行する方法は?Mar 10, 2025 pm 06:52 PM

TensorflowまたはPytorchで深い学習を実行する方法は?Mar 10, 2025 pm 06:52 PMこの記事では、深い学習のためにTensorflowとPytorchを比較しています。 関連する手順、データの準備、モデルの構築、トレーニング、評価、展開について詳しく説明しています。 特に計算グラップに関して、フレームワーク間の重要な違い

あるデータフレームの列全体を、Python内の異なる構造を持つ別のデータフレームに効率的にコピーする方法は?Apr 01, 2025 pm 11:15 PM

あるデータフレームの列全体を、Python内の異なる構造を持つ別のデータフレームに効率的にコピーする方法は?Apr 01, 2025 pm 11:15 PMPythonのPandasライブラリを使用する場合、異なる構造を持つ2つのデータフレーム間で列全体をコピーする方法は一般的な問題です。 2つのデータがあるとします...

Pythonでコマンドラインインターフェイス(CLI)を作成する方法は?Mar 10, 2025 pm 06:48 PM

Pythonでコマンドラインインターフェイス(CLI)を作成する方法は?Mar 10, 2025 pm 06:48 PMこの記事では、コマンドラインインターフェイス(CLI)の構築に関するPython開発者をガイドします。 Typer、Click、Argparseなどのライブラリを使用して、入力/出力の処理を強調し、CLIの使いやすさを改善するためのユーザーフレンドリーな設計パターンを促進することを詳述しています。

人気のあるPythonライブラリとその用途は何ですか?Mar 21, 2025 pm 06:46 PM

人気のあるPythonライブラリとその用途は何ですか?Mar 21, 2025 pm 06:46 PMこの記事では、numpy、pandas、matplotlib、scikit-learn、tensorflow、django、flask、and requestsなどの人気のあるPythonライブラリについて説明し、科学的コンピューティング、データ分析、視覚化、機械学習、Web開発、Hの使用について説明します。

Pythonの仮想環境の目的を説明してください。Mar 19, 2025 pm 02:27 PM

Pythonの仮想環境の目的を説明してください。Mar 19, 2025 pm 02:27 PMこの記事では、Pythonにおける仮想環境の役割について説明し、プロジェクトの依存関係の管理と競合の回避に焦点を当てています。プロジェクト管理の改善と依存関係の問題を減らすための作成、アクティベーション、およびメリットを詳しく説明しています。

正規表現とは何ですか?Mar 20, 2025 pm 06:25 PM

正規表現とは何ですか?Mar 20, 2025 pm 06:25 PM正規表現は、プログラミングにおけるパターンマッチングとテキスト操作のための強力なツールであり、さまざまなアプリケーションにわたるテキスト処理の効率を高めます。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

MantisBT

Mantis は、製品の欠陥追跡を支援するために設計された、導入が簡単な Web ベースの欠陥追跡ツールです。 PHP、MySQL、Web サーバーが必要です。デモおよびホスティング サービスをチェックしてください。

ホットトピック

7444

7444 15

15 1371

1371 52

52