AI を活用したアプリケーションは、単にタスクを実行する自律エージェントを超えて進化しています。 Human-in-the-Loop を含む新しいアプローチにより、ユーザーはフィードバックを提供し、結果を確認し、AI の次のステップを決定することができます。これらの実行時エージェントは CoAgent として知られています。

TL;DR

このチュートリアルでは、LangGraph、CopilotKit、Tavily を使用して Perplexity クローンを構築する方法を学習します。

構築を開始しましょう!

エージェント副操縦士とは何ですか?

エージェント コパイロットは、CopilotKit が LangGraph エージェントをアプリケーションに組み込む方法です。

CoAgent は、エージェント エクスペリエンスを構築するための CopilotKit のアプローチです。

つまり、複数の検索クエリを実行することでユーザーのリクエストを処理し、ステータスと結果をリアルタイムでクライアントにストリーミングして返します。

CopilotKit をチェックアウト ⭐️

前提条件

このチュートリアルを完全に理解するには、React または Next.js の基本を理解している必要があります。

以下も利用します:

- Python - LangGraph を使用して AI エージェントを構築するための人気のあるプログラミング言語。コンピュータにインストールされていることを確認してください。

- LangGraph - AI エージェントを作成およびデプロイするためのフレームワーク。また、エージェントによって実行される制御フローとアクションを定義するのにも役立ちます。

- OpenAI API キー - GPT モデルを使用してさまざまなタスクを実行できるようにします。このチュートリアルでは、GPT-4 モデルにアクセスできることを確認してください。

- Tavily AI - AI エージェントが調査を実施し、アプリケーション内のリアルタイムの知識にアクセスできるようにする検索エンジンです。

- CopilotKit - カスタム AI チャットボット、アプリ内 AI エージェント、テキスト領域を構築するためのオープンソース コパイロット フレームワーク。

- Shad Cn UI - アプリケーション内で再利用可能な UI コンポーネントのコレクションを提供します。

LangGraph と CopilotKit を使用して AI エージェントを作成する方法

このセクションでは、LangGraph と CopilotKit を使用して AI エージェントを作成する方法を学習します。

まず、CopilotKit CoAgents スターター リポジトリのクローンを作成します。 ui ディレクトリには Next.js アプリケーションのフロントエンドが含まれ、agent ディレクトリにはアプリケーションの CoAgent が含まれます。

agent ディレクトリ内に、Poetry を使用してプロジェクトの依存関係をインストールします。

cd agent poetry install

エージェント フォルダー内に .env ファイルを作成し、OpenAI および Tavily AI API キーをそのファイルにコピーします。

OPENAI_API_KEY= TAVILY_API_KEY=

以下のコード スニペットを agent.py ファイルにコピーします。

"""

This is the main entry point for the AI.

It defines the workflow graph and the entry point for the agent.

"""

# pylint: disable=line-too-long, unused-import

from langgraph.graph import StateGraph, END

from langgraph.checkpoint.memory import MemorySaver

from ai_researcher.state import AgentState

from ai_researcher.steps import steps_node

from ai_researcher.search import search_node

from ai_researcher.summarize import summarize_node

from ai_researcher.extract import extract_node

def route(state):

"""Route to research nodes."""

if not state.get("steps", None):

return END

current_step = next((step for step in state["steps"] if step["status"] == "pending"), None)

if not current_step:

return "summarize_node"

if current_step["type"] == "search":

return "search_node"

raise ValueError(f"Unknown step type: {current_step['type']}")

# Define a new graph

workflow = StateGraph(AgentState)

workflow.add_node("steps_node", steps_node)

workflow.add_node("search_node", search_node)

workflow.add_node("summarize_node", summarize_node)

workflow.add_node("extract_node", extract_node)

# Chatbot

workflow.set_entry_point("steps_node")

workflow.add_conditional_edges(

"steps_node",

route,

["summarize_node", "search_node", END]

)

workflow.add_edge("search_node", "extract_node")

workflow.add_conditional_edges(

"extract_node",

route,

["summarize_node", "search_node"]

)

workflow.add_edge("summarize_node", END)

memory = MemorySaver()

graph = workflow.compile(checkpointer=memory)

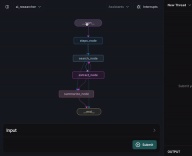

上記のコード スニペットは、LangGraph エージェントのワークフローを定義します。 steps_node から開始され、結果を検索して要約し、重要なポイントを抽出します。

次に、以下のコード スニペットを使用して demo.py ファイルを作成します。

cd agent poetry install

上記のコードは、LangGraph エージェントをホストし、CopilotKit SDK に接続する FastAPI エンドポイントを作成します。

CoAgent を作成するための残りのコードは、GitHub リポジトリからコピーできます。次のセクションでは、Perplexity クローンのユーザー インターフェイスを構築し、CopilotKit を使用して検索リクエストを処理する方法を学習します。

Next.js を使用したアプリケーション インターフェイスの構築

このセクションでは、アプリケーションのユーザー インターフェイスを構築するプロセスについて説明します。

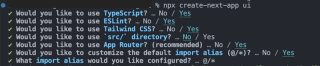

まず、以下のコード スニペットを実行して Next.js Typescript プロジェクトを作成します。

OPENAI_API_KEY= TAVILY_API_KEY=

以下のコード スニペットを実行して、新しく作成したプロジェクトに ShadCn UI ライブラリをインストールします。

"""

This is the main entry point for the AI.

It defines the workflow graph and the entry point for the agent.

"""

# pylint: disable=line-too-long, unused-import

from langgraph.graph import StateGraph, END

from langgraph.checkpoint.memory import MemorySaver

from ai_researcher.state import AgentState

from ai_researcher.steps import steps_node

from ai_researcher.search import search_node

from ai_researcher.summarize import summarize_node

from ai_researcher.extract import extract_node

def route(state):

"""Route to research nodes."""

if not state.get("steps", None):

return END

current_step = next((step for step in state["steps"] if step["status"] == "pending"), None)

if not current_step:

return "summarize_node"

if current_step["type"] == "search":

return "search_node"

raise ValueError(f"Unknown step type: {current_step['type']}")

# Define a new graph

workflow = StateGraph(AgentState)

workflow.add_node("steps_node", steps_node)

workflow.add_node("search_node", search_node)

workflow.add_node("summarize_node", summarize_node)

workflow.add_node("extract_node", extract_node)

# Chatbot

workflow.set_entry_point("steps_node")

workflow.add_conditional_edges(

"steps_node",

route,

["summarize_node", "search_node", END]

)

workflow.add_edge("search_node", "extract_node")

workflow.add_conditional_edges(

"extract_node",

route,

["summarize_node", "search_node"]

)

workflow.add_edge("summarize_node", END)

memory = MemorySaver()

graph = workflow.compile(checkpointer=memory)

次に、Next.js プロジェクトのルートに components フォルダーを作成し、この GitHub リポジトリからそのフォルダーに ui フォルダーをコピーします。 Shadcn を使用すると、コマンド ライン経由でインストールすることで、さまざまなコンポーネントをアプリケーションに簡単に追加できます。

Shadcn コンポーネントに加えて、アプリケーション インターフェイスのさまざまな部分を表すいくつかのコンポーネントを作成する必要があります。 components フォルダー内で次のコード スニペットを実行して、これらのコンポーネントを Next.js プロジェクトに追加します。

"""Demo"""

import os

from dotenv import load_dotenv

load_dotenv()

from fastapi import FastAPI

import uvicorn

from copilotkit.integrations.fastapi import add_fastapi_endpoint

from copilotkit import CopilotKitSDK, LangGraphAgent

from ai_researcher.agent import graph

app = FastAPI()

sdk = CopilotKitSDK(

agents=[

LangGraphAgent(

name="ai_researcher",

description="Search agent.",

graph=graph,

)

],

)

add_fastapi_endpoint(app, sdk, "/copilotkit")

# add new route for health check

@app.get("/health")

def health():

"""Health check."""

return {"status": "ok"}

def main():

"""Run the uvicorn server."""

port = int(os.getenv("PORT", "8000"))

uvicorn.run("ai_researcher.demo:app", host="0.0.0.0", port=port, reload=True)

以下のコード スニペットを app/page.tsx ファイルにコピーします。

# ?? Navigate into the ui folder npx create-next-app ./

上記のコード スニペットの ResearchProvider は、ユーザーの検索クエリと結果を共有するカスタム React コンテキスト プロバイダーであり、アプリケーション内のすべてのコンポーネントからそれらにアクセスできるようにします。 ResearchWrapper コンポーネントには、コア アプリケーション要素が含まれており、UI を管理します。

Next.js プロジェクトのルートに research-provider.tsx ファイルを含む lib フォルダーを Next.js プロジェクトのルートに作成し、そのファイルに以下のコードをコピーします。

npx shadcn@latest init

状態は宣言され、ResearchContext に保存され、アプリケーション内の複数のコンポーネントにわたって状態が適切に管理されるようになります。

以下に示すように ResearchWrapper コンポーネントを作成します。

cd agent poetry install

ResearchWrapper コンポーネントは、HomeView コンポーネントをデフォルトのビューとしてレンダリングし、検索クエリが提供されると ResultView を表示します。 useResearchContext フックを使用すると、researchQuery 状態にアクセスし、それに応じてビューを更新できます。

最後に、HomeView コンポーネントを作成して、アプリケーションのホームページ インターフェイスをレンダリングします。

OPENAI_API_KEY= TAVILY_API_KEY=

CoAgent を Next.js アプリケーションに接続する方法

このセクションでは、CopilotKit CoAgent を Next.js アプリケーションに接続して、ユーザーがアプリケーション内で検索操作を実行できるようにする方法を学習します。

次の CopilotKit パッケージと OpenAI Node.js SDK をインストールします。 CopilotKit パッケージを使用すると、コーエージェントは React 状態値と対話し、アプリケーション内で意思決定を行うことができます。

"""

This is the main entry point for the AI.

It defines the workflow graph and the entry point for the agent.

"""

# pylint: disable=line-too-long, unused-import

from langgraph.graph import StateGraph, END

from langgraph.checkpoint.memory import MemorySaver

from ai_researcher.state import AgentState

from ai_researcher.steps import steps_node

from ai_researcher.search import search_node

from ai_researcher.summarize import summarize_node

from ai_researcher.extract import extract_node

def route(state):

"""Route to research nodes."""

if not state.get("steps", None):

return END

current_step = next((step for step in state["steps"] if step["status"] == "pending"), None)

if not current_step:

return "summarize_node"

if current_step["type"] == "search":

return "search_node"

raise ValueError(f"Unknown step type: {current_step['type']}")

# Define a new graph

workflow = StateGraph(AgentState)

workflow.add_node("steps_node", steps_node)

workflow.add_node("search_node", search_node)

workflow.add_node("summarize_node", summarize_node)

workflow.add_node("extract_node", extract_node)

# Chatbot

workflow.set_entry_point("steps_node")

workflow.add_conditional_edges(

"steps_node",

route,

["summarize_node", "search_node", END]

)

workflow.add_edge("search_node", "extract_node")

workflow.add_conditional_edges(

"extract_node",

route,

["summarize_node", "search_node"]

)

workflow.add_edge("summarize_node", END)

memory = MemorySaver()

graph = workflow.compile(checkpointer=memory)

Next.js app フォルダー内に api フォルダーを作成します。 api フォルダー内に、route.ts ファイルを含む copilotkit ディレクトリを作成します。これにより、フロントエンド アプリケーションを CopilotKit CoAgent に接続する API エンドポイント (/api/copilotkit) が作成されます。

"""Demo"""

import os

from dotenv import load_dotenv

load_dotenv()

from fastapi import FastAPI

import uvicorn

from copilotkit.integrations.fastapi import add_fastapi_endpoint

from copilotkit import CopilotKitSDK, LangGraphAgent

from ai_researcher.agent import graph

app = FastAPI()

sdk = CopilotKitSDK(

agents=[

LangGraphAgent(

name="ai_researcher",

description="Search agent.",

graph=graph,

)

],

)

add_fastapi_endpoint(app, sdk, "/copilotkit")

# add new route for health check

@app.get("/health")

def health():

"""Health check."""

return {"status": "ok"}

def main():

"""Run the uvicorn server."""

port = int(os.getenv("PORT", "8000"))

uvicorn.run("ai_researcher.demo:app", host="0.0.0.0", port=port, reload=True)

以下のコード スニペットを api/copilotkit/route.ts ファイルにコピーします。

# ?? Navigate into the ui folder npx create-next-app ./

上記のコード スニペットは、/api/copilotkit API エンドポイントで CopilotKit ランタイムを設定し、CopilotKit が AI コーエージェントを通じてユーザー リクエストを処理できるようにします。

最後に、すべてのアプリケーション コンポーネントにコパイロット コンテキストを提供する CopilotKit コンポーネントでアプリケーション全体をラップすることで、app/page.tsx を更新します。

npx shadcn@latest init

CopilotKit コンポーネントはアプリケーション全体をラップし、runtimeUrl と agent という 2 つのプロパティを受け入れます。 runtimeUrl は AI エージェントをホストするバックエンド API ルートで、agent はアクションを実行するエージェントの名前です。

リクエストの受け入れとフロントエンドへのストリーミング応答

CopilotKit がユーザー入力にアクセスして処理できるようにするために、useCoAgent フックが提供されます。これにより、アプリケーション内のどこからでもエージェントの状態にアクセスできるようになります。

たとえば、以下のコード スニペットは、useCoAgent フックの使用方法を示しています。 state 変数を使用すると、エージェントの現在の状態にアクセスできます。setState を使用して状態を変更し、run 関数はエージェントを使用して命令を実行します。 start 関数と stop 関数は、エージェントの実行を開始および停止します。

cd agent poetry install

検索クエリが提供されたときにエージェントを実行するように HomeView コンポーネントを更新します。

OPENAI_API_KEY= TAVILY_API_KEY=

次に、useCoAgent フック内の状態変数にアクセスすることで、検索結果を ResultsView にストリーミングできます。以下のコード スニペットを ResultsView コンポーネントにコピーします。

"""

This is the main entry point for the AI.

It defines the workflow graph and the entry point for the agent.

"""

# pylint: disable=line-too-long, unused-import

from langgraph.graph import StateGraph, END

from langgraph.checkpoint.memory import MemorySaver

from ai_researcher.state import AgentState

from ai_researcher.steps import steps_node

from ai_researcher.search import search_node

from ai_researcher.summarize import summarize_node

from ai_researcher.extract import extract_node

def route(state):

"""Route to research nodes."""

if not state.get("steps", None):

return END

current_step = next((step for step in state["steps"] if step["status"] == "pending"), None)

if not current_step:

return "summarize_node"

if current_step["type"] == "search":

return "search_node"

raise ValueError(f"Unknown step type: {current_step['type']}")

# Define a new graph

workflow = StateGraph(AgentState)

workflow.add_node("steps_node", steps_node)

workflow.add_node("search_node", search_node)

workflow.add_node("summarize_node", summarize_node)

workflow.add_node("extract_node", extract_node)

# Chatbot

workflow.set_entry_point("steps_node")

workflow.add_conditional_edges(

"steps_node",

route,

["summarize_node", "search_node", END]

)

workflow.add_edge("search_node", "extract_node")

workflow.add_conditional_edges(

"extract_node",

route,

["summarize_node", "search_node"]

)

workflow.add_edge("summarize_node", END)

memory = MemorySaver()

graph = workflow.compile(checkpointer=memory)

上記のコード スニペットは、エージェントの状態から検索結果を取得し、useCoAgent フックを使用してフロントエンドにストリーミングします。検索結果はマークダウン形式で返され、AnswerMarkdown コンポーネントに渡され、ページ上にコンテンツが表示されます。

最後に、以下のコード スニペットを AnswerMarkdown コンポーネントにコピーします。これにより、React Markdown ライブラリを使用してマークダウン コンテンツがフォーマットされたテキストとしてレンダリングされます。

"""Demo"""

import os

from dotenv import load_dotenv

load_dotenv()

from fastapi import FastAPI

import uvicorn

from copilotkit.integrations.fastapi import add_fastapi_endpoint

from copilotkit import CopilotKitSDK, LangGraphAgent

from ai_researcher.agent import graph

app = FastAPI()

sdk = CopilotKitSDK(

agents=[

LangGraphAgent(

name="ai_researcher",

description="Search agent.",

graph=graph,

)

],

)

add_fastapi_endpoint(app, sdk, "/copilotkit")

# add new route for health check

@app.get("/health")

def health():

"""Health check."""

return {"status": "ok"}

def main():

"""Run the uvicorn server."""

port = int(os.getenv("PORT", "8000"))

uvicorn.run("ai_researcher.demo:app", host="0.0.0.0", port=port, reload=True)

おめでとうございます!このチュートリアルのプロジェクトは完了しました。ここでビデオ録画を見ることもできます:

ウェビナーの録画を完了

それをまとめる

LLM インテリジェンスは、人間のインテリジェンスと連携して機能する場合に最も効果的です。CopilotKit CoAgents を使用すると、AI エージェント、副操縦士、さまざまな種類のアシスタントをわずか数分でソフトウェア アプリケーションに統合できます。

AI 製品を構築する必要がある場合、または AI エージェントをアプリに統合する必要がある場合は、CopilotKit を検討してください。

このチュートリアルのソース コードは GitHub で入手できます:

https://github.com/CopilotKit/CopilotKit/tree/main/examples/coagents-ai-researcher

読んでいただきありがとうございます!

以上がLangGraph、CopilotKit、Tavily、Next.js を使用して Perplexity のクローンを構築するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

JavaScriptのデータ型:ブラウザとNodejsに違いはありますか?May 14, 2025 am 12:15 AM

JavaScriptのデータ型:ブラウザとNodejsに違いはありますか?May 14, 2025 am 12:15 AMJavaScriptコアデータ型は、ブラウザとnode.jsで一貫していますが、余分なタイプとは異なる方法で処理されます。 1)グローバルオブジェクトはブラウザのウィンドウであり、node.jsのグローバルです2)バイナリデータの処理に使用されるNode.jsの一意のバッファオブジェクト。 3)パフォーマンスと時間の処理にも違いがあり、環境に従ってコードを調整する必要があります。

JavaScriptコメント://および / * *を使用するためのガイドMay 13, 2025 pm 03:49 PM

JavaScriptコメント://および / * *を使用するためのガイドMay 13, 2025 pm 03:49 PMjavascriptusestwotypesofcomments:シングルライン(//)およびマルチライン(//)

Python vs. JavaScript:開発者の比較分析May 09, 2025 am 12:22 AM

Python vs. JavaScript:開発者の比較分析May 09, 2025 am 12:22 AMPythonとJavaScriptの主な違いは、タイプシステムとアプリケーションシナリオです。 1。Pythonは、科学的コンピューティングとデータ分析に適した動的タイプを使用します。 2。JavaScriptは弱いタイプを採用し、フロントエンドとフルスタックの開発で広く使用されています。この2つは、非同期プログラミングとパフォーマンスの最適化に独自の利点があり、選択する際にプロジェクトの要件に従って決定する必要があります。

Python vs. JavaScript:ジョブに適したツールを選択するMay 08, 2025 am 12:10 AM

Python vs. JavaScript:ジョブに適したツールを選択するMay 08, 2025 am 12:10 AMPythonまたはJavaScriptを選択するかどうかは、プロジェクトの種類によって異なります。1)データサイエンスおよび自動化タスクのPythonを選択します。 2)フロントエンドとフルスタック開発のためにJavaScriptを選択します。 Pythonは、データ処理と自動化における強力なライブラリに好まれていますが、JavaScriptはWebインタラクションとフルスタック開発の利点に不可欠です。

PythonとJavaScript:それぞれの強みを理解するMay 06, 2025 am 12:15 AM

PythonとJavaScript:それぞれの強みを理解するMay 06, 2025 am 12:15 AMPythonとJavaScriptにはそれぞれ独自の利点があり、選択はプロジェクトのニーズと個人的な好みに依存します。 1. Pythonは、データサイエンスやバックエンド開発に適した簡潔な構文を備えた学習が簡単ですが、実行速度が遅くなっています。 2。JavaScriptはフロントエンド開発のいたるところにあり、強力な非同期プログラミング機能を備えています。 node.jsはフルスタックの開発に適していますが、構文は複雑でエラーが発生しやすい場合があります。

JavaScriptのコア:CまたはCの上に構築されていますか?May 05, 2025 am 12:07 AM

JavaScriptのコア:CまたはCの上に構築されていますか?May 05, 2025 am 12:07 AMjavascriptisnotbuiltoncorc;それは、解釈されていることを解釈しました。

JavaScriptアプリケーション:フロントエンドからバックエンドまでMay 04, 2025 am 12:12 AM

JavaScriptアプリケーション:フロントエンドからバックエンドまでMay 04, 2025 am 12:12 AMJavaScriptは、フロントエンドおよびバックエンド開発に使用できます。フロントエンドは、DOM操作を介してユーザーエクスペリエンスを強化し、バックエンドはnode.jsを介してサーバータスクを処理することを処理します。 1.フロントエンドの例:Webページテキストのコンテンツを変更します。 2。バックエンドの例:node.jsサーバーを作成します。

Python vs. Javascript:どの言語を学ぶべきですか?May 03, 2025 am 12:10 AM

Python vs. Javascript:どの言語を学ぶべきですか?May 03, 2025 am 12:10 AMPythonまたはJavaScriptの選択は、キャリア開発、学習曲線、エコシステムに基づいている必要があります。1)キャリア開発:Pythonはデータサイエンスとバックエンド開発に適していますが、JavaScriptはフロントエンドおよびフルスタック開発に適しています。 2)学習曲線:Python構文は簡潔で初心者に適しています。 JavaScriptの構文は柔軟です。 3)エコシステム:Pythonには豊富な科学コンピューティングライブラリがあり、JavaScriptには強力なフロントエンドフレームワークがあります。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

SublimeText3 中国語版

中国語版、とても使いやすい

Dreamweaver Mac版

ビジュアル Web 開発ツール

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!