ホームページ >テクノロジー周辺機器 >AI >ラマ 3 と GPT-4: どちらが優れていますか?

ラマ 3 と GPT-4: どちらが優れていますか?

- William Shakespeareオリジナル

- 2024-12-13 16:24:00847ブラウズ

クイックリンク

Llama 3 と GPT-4 は、一般に公開されている最も高度な大規模言語モデル (LLM) の 2 つです。マルチモダリティ、コンテキストの長さ、パフォーマンス、コストの観点から両方のモデルを比較して、どちらの LLM が優れているかを見てみましょう。

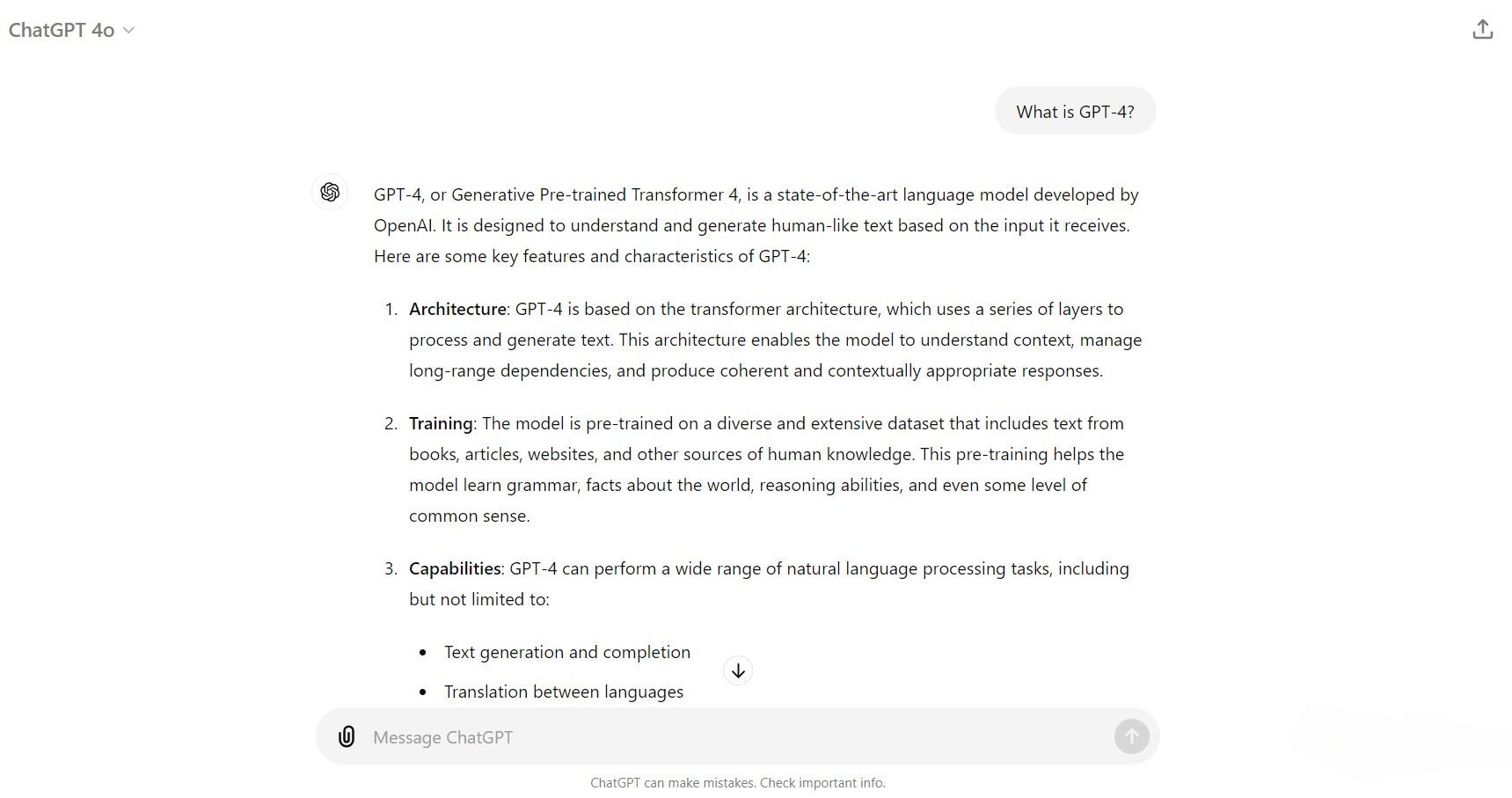

GPT-4 とは?

GPT-4 は、OpenAI によって開発された最新の大規模言語モデル (LLM) です。これは、はるかに大規模なデータセットを使用したさまざまなトレーニング手法と最適化を使用しながら、古い GPT-3 モデルの基礎の上に構築されています。これにより、GPT-4 のパラメータ サイズが大幅に増加し、小規模なエキスパート モデルのパラメータを合計すると 1 兆 7,000 億個になると噂されています。新しいトレーニング、最適化、パラメーターの増加により、GPT-4 は推論、問題解決、コンテキストの理解、および微妙な指示のより適切な処理を改善します。

現在、モデルには 3 つのバリエーションがあります。

- GPT-4: GPT-3 からの進化であり、速度、精度、知識ベースが大幅に向上しています。

- GPT-4 Turbo: GPT-4 の最適化されたバージョン。運用コストを削減しながら、より高速なパフォーマンスを実現するように設計されています。

- GPT-4o (オムニ): テキスト、ビジョン、オーディオなどのマルチモーダル入出力を統合することにより、GPT-4 の機能を拡張します。

OpenAI の API サービスに登録するか、ChatGPT と対話するか、Descript、Perplexity AI、Microsoft のさまざまなコパイロット などのサービスを通じて、3 つの GPT-4 モデルすべてにアクセスできるようになりました。 🎜>.

ラマ 3 とは何ですか?

Llama 3 は、Meta AI (Facebook、Instagram、WhatsApp の親会社) によって開発されたオープンソース LLM であり、教師あり微調整、拒否サンプリング、ポリシー最適化の組み合わせを使用して、数百万ものデータセットを含む多様なデータセットを使用してトレーニングされています。人間が注釈を付けた例。そのトレーニングは、高品質のプロンプトと好みのランキングに焦点を当て、多用途で有能な AI モデルを作成することを目的としていました。

現在、一般に公開されている Llama 3 モデルは、Llama 3 8B と Llama 3 70B の 2 つです。 「B」は 10 億を表し、モデルのパラメータ サイズを示します。 Meta は、2024 年後半に発売予定の Llama 3 400B モデルのトレーニングも行っています。

Llama 3 には、その生成 AI チャットボットである Meta AI を通じてアクセスできます。あるいは、Llama 3 モデルをダウンロードし、Ollama、Open WebUI、または LM Studio を通じてロードすることで、コンピューター上で LLM をローカルに実行することもできます。

マルチモダリティ

GPT-4o のリリースにより、マルチモーダル機能を備えた GPT-4 の初期マーケティングがついに実現しました。これらのマルチモーダル機能は、GPT-4o モデルを使用して ChatGPT と対話することでアクセスできるようになりました。 2024 年 6 月の時点で、GPT-4o にはビデオとオーディオを生成する統合された方法がありません。ただし、ビデオおよびオーディオ入力に基づいてテキストと画像を生成する機能はあります。

Llama 3 は、次期 Llama 3 400B にマルチモーダル モデルを提供することも計画しています。おそらく、CLIP (Contrast Language-Imager Pre-Training) と同様のテクノロジーを統合し、ゼロショット学習 技術を使用して画像を生成することになるでしょう。ただし、Llama 400B はまだトレーニング中であるため、8B および 70B モデルが画像を生成する唯一の方法は、LLaVa、Visual-LLaMA、LLaMA-VID などの拡張機能を使用することです。現時点では、Llama 3 は純粋に言語ベースのモデルであり、テキスト、画像、音声を入力として受け取り、テキストを生成できます。

コンテキストの長さ

コンテキストの長さは、モデルが一度に処理できるテキストの量を指します。これは、ユーザーと対話するときにモデルが操作できるコンテキストの量を決定するため、LLM の機能を検討する際の重要な要素です。一般に、コンテキスト長が長いほど、より高いレベルの一貫性と連続性が提供され、対話中のエラーの繰り返しを減らすことができるため、LLM がより優れたものになります。

| トレーニング データの説明 | Params | コンテキスト長 | GQA | トークン数 | 知識の遮断 | |||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| ラマ 3 | 公開されているオンライン データの混合 | 8B | 8k | はい | 15T | 2023 年 3 月 | |||||||||||||||||||||

| ラマ 3 | 公開されているオンライン データの混合 | 70B | 8k | はい | 15T | 2023 年 12 月 |

Llama 3 モデルは、実質的に 8,000 トークン (約 6,400 ワード) のコンテキスト長を特徴としています。これは、Llama 3 モデルがインタラクション内で約 6,400 語のコンテキスト メモリを持つことを意味します。 8,000 トークンの制限を超えた単語はすべて忘れられ、対話中にそれ以上のコンテキストは提供されません。

| 説明 | コンテキストウィンドウ | トレーニング データ | ||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| GPT-4o | GPT-4 Turbo よりも安価で高速なマルチモーダル フラッグシップ モデル。128,000 トークン (API) | 2023 年 10 月まで | |||||||||||||||||

| GPT- 4 ターボ | 合理化された GPT-4ビジョン機能を備えたターボ モデル。 | 128,000 トークン (API) | 2023 年 12 月まで | tr>||||||||||||||||

| GPT-4 | 最初の GPT-4 モデル | 8,192 トークン | 2021 年 9 月まで |

対照的に、GPT-4 は、ChatGPT ユーザーに対して 32,000 トークン (約 25,600 ワード)、API エンドポイントを使用するユーザーに対して 128,000 トークン (約 102,400 ワード) という大幅に長いコンテキスト長をサポートするようになりました。これにより、GPT-4 モデルは広範な会話を管理する上での優位性が得られ、長い文書や書籍全体を読む能力も得られます。

パフォーマンス

Llama 3 2024 年 4 月 18 日、Meta AI のベンチマーク レポートと GPT-4 2024 年 5 月 14 日の GitHub レポートを見てパフォーマンスを比較してみましょうOpenAIによる。結果は次のとおりです。

| MMLU | GPQA | MATH | HumanEval | DROP | ||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| GPT-4o | 88.7 | 53.6 | 76.6 | 90.2 | 83.4 | ||||||||||||||||||||||||||||||||||||

| GPT-4ターボ | 86.5 | 49.1 | 72.2 | 87.6 | 85.4 | ||||||||||||||||||||||||||||||||||||

| ラマ3 8B | 68.4 | 34.2 | 30.0 | 62.2 | 58.4 | ||||||||||||||||||||||||||||||||||||

| ラマ3 70B | 82.0 | 39.5 | 50.4 | 81.7 | 79.7 | ||||||||||||||||||||||||||||||||||||

| ラマ3 400B | 86.1 | 48.0 | 57.8 | 84.1 | 83.5 |

各基準の評価内容は次のとおりです:

- MMLU (Massive Multitask Language Understanding): さまざまな学術分野にわたる質問を理解し、応答するモデルの能力を評価します。主題。

- GPTQA (汎用質問応答): オープンドメインの事実に関する質問に答えるモデルのスキルを評価します

- MATH: モデルの能力をテストします。数学的な問題を解く。

- HumanEval: 人間による指定されたプログラミング プロンプトに基づいて正しいコードを生成するモデルの能力を測定します。

- DROP (段落にわたる離散推論): 離散推論を実行し、テキストの一節に基づいて質問に答えるモデルの能力を評価します。

最近のベンチマークでは、GPT-4 モデルと Llama 3 モデルのパフォーマンスの違いが浮き彫りになっています。 Llama 3 8B モデルは大幅に遅れをとっているように見えますが、70B および 400B モデルは、学術的および一般的な知識、読解と理解、推論と論理、およびコーディング。ただし、純粋な数学の観点からは、Llama 3 モデルはまだ GPT-4 のパフォーマンスに近づいていません。

コスト

コストは重要です多くのユーザーにとって重要な要素です。 OpenAI の GPT-4o モデルは、すべての ChatGPT ユーザーが 3 時間ごとに 16 メッセージの制限で無料で利用できます。さらに必要な場合は、ChatGPT Plus に加入する必要があります。月額 20 米ドルで、GPT-4o のメッセージ制限を 80 に拡張できると同時に、他の GPT-4 モデルにもアクセスできます。

オン一方、Llama 3 8B と 70B の両モデルは無料でオープンソースであるため、コスト効率の高いソリューションを探している開発者や研究者にとっては大きな利点となります。パフォーマンスに妥協します。

アクセシビリティ

GPT-4 モデルは、OpenAI の ChatGPT 生成 AI チャットボットおよびその API を通じて広くアクセスできます。 Microsoft Copilot で GPT-4 を使用することもできます。これは GPT-4 を無料で使用できる 1 つの方法です。この広範な可用性により、ユーザーはさまざまなユースケースでその機能を簡単に活用できます。対照的に、Llama 3 はモデルの柔軟性を提供し、AI コミュニティ内でのより広範な実験とコラボレーションを促進するオープンソース プロジェクトです。このオープンアクセスのアプローチにより、AI テクノロジーを民主化し、より幅広いユーザーが利用できるようになります。

どちらのモデルもすぐに入手できますが、GPT-4 は一般的な生産性ツールやサービスに統合されているため、はるかに使いやすいです。 。一方、Llama 3 は主に Amazon Bedrock、Ollama、DataBricks などの研究およびビジネス プラットフォームに統合されており (Meta AI チャット アシストを除く)、非技術ユーザーのより大きな市場には魅力的ではありません。

GPT-4 対 Llama 3: どちらが優れていますか?

では、どの LLM が優れているのでしょうか? GPT-4 の方が優れた LLM であると言わざるを得ません。 GPT-4 は、テキスト、画像、オーディオ入力を処理する高度な機能を備えたマルチモダリティに優れていますが、Llama 3 の同様の機能はまだ開発中です。また、GPT-4 は、コンテキストの長さが大幅に長くなり、パフォーマンスが向上し、一般的なツールやサービスを通じて広くアクセスできるため、よりユーザーフレンドリーになっています。

ただし、Llama 3 モデルが非常に優れたパフォーマンスを発揮していることを強調することが重要です。無料のオープンソース プロジェクトの場合。その結果、Llama 3 は優れた LLM であり続け、コストフリーでオープンソースであると同時に、優れたパフォーマンス、柔軟性、信頼性の高いプライバシー機能を提供するため、研究者や企業に支持されています。一般消費者は Llama 3 をすぐに使用できないかもしれませんが、多くの研究者や企業にとっては依然として最も実行可能な選択肢です。

結論として、GPT-4 は高度なマルチモーダル機能、より長いコンテキスト長、およびより優れたマルチモーダル機能で際立っています。 Llama 3 は、広く使用されているツールにシームレスに統合されており、オープンソースの性質を持つ貴重な代替手段を提供し、より優れたカスタマイズとコスト削減を可能にします。したがって、アプリケーションの面では、GPT-4 はモデルの使いやすさと包括的な機能を求める人にとって理想的ですが、Llama 3 は柔軟性と適応性を求める開発者や研究者に適しています。

以上がラマ 3 と GPT-4: どちらが優れていますか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。